基于多模特征深度学习的机器人抓取判别方法

仲训杲 徐敏 仲训昱 彭侠夫

基于多模特征深度学习的机器人抓取判别方法

仲训杲1徐敏1仲训昱2彭侠夫2

针对智能机器人抓取判别问题,研究多模特征深度学习与融合方法.该方法将测试特征分布偏离训练特征视为一类噪化,引入带稀疏约束的降噪自动编码(Denoising auto-encoding,DAE),实现网络权值学习;并以叠层融合策略,获取初始多模特征的深层抽象表达,两种手段相结合旨在提高深度网络的鲁棒性和抓取判别精确性.实验采用深度摄像机与6自由度工业机器人组建测试平台,对不同类别目标进行在线对比实验.结果表明,设计的多模特征深度学习依据人的抓取习惯,实现最优抓取判别,并且机器人成功实施抓取定位,研究方法对新目标具备良好的抓取判别能力.

机器人抓取判别,降噪自动编码,叠层深度学习,多模特征

引用格式仲训杲,徐敏,仲训昱,彭侠夫.基于多模特征深度学习的机器人抓取判别方法.自动化学报,2016,42(7): 1022-1029

机器人学习抓取是智能机器人研究的重要内容,涉及到智能学习、抓取位姿判别、机器人运动规划与控制等问题的研究[1[3].近年出现的深度学习算法,在无监督特征学习中取得了显着效果,深度学习的优越性在于:1)不需要介入人为的干预;2)该方法提高了网络的深层学习能力,是一种充满前景的学习算法[4-5].

深度学习首次由Hinton等[6]提出,其基本观点是采用神经网络模拟人类大脑特征学习过程.这种无监督特性学习方法借鉴大脑多层抽象表达机制,实现初始特征深层抽象表达,因此避免了特征抽取过程中人为的干预,同时深度学习在一定程度上解决了传统人工神经网络局部收敛和过适性问题,受到业内广泛关注[7[6]、深度波尔曼兹机(Deep Boltzmann machine,DBM)[10]、深度能量模型(Deep energy model,DEM)[11]、自动编码器(Auto encoder,AE)[12].鉴于深度网络的强大学习能力,能够直接从标记或非标记数据集中抽取深层抽象特征,该技术已成功用于图像识别与检索[13[15]、自然语言处理[16-17]等领域,而在机器人学习抓取领域还处在起步阶段[18-20].

机器人学习抓取判别研究中,基于模型的方法保持着较高热度,如文献[21]对目标3D点云进行分割,每个分割部分由一个超二次曲面(Superquadrics,SQ)近似表示,然后用训练好的人工神经网络,区分每个部分是否为适合的抓取位置.文献[22]同样采用SQ近似表示目标模型,然后用支持向量机(Support vector machine,SVM)对SQ参数和抓取标记进行离线学习.在线测试中,SVM算法给定SQ参数后,将自动搜索有效的抓取位置.文献[23]采用马尔科夫场(Markov random field,MRF)对抓取物体进行3D点云建模,MRF的每个节点携带最优和次优两个抓取标记,该方法通过点云标记的最大后验概率,实现抓取位置识别.文献[24]研究一种基于局部随机采样鲁棒几何描述的3D匹配与位姿估计方法,该方法在噪声、遮挡测试环境中取得良好的抓取效果.以上方法依赖于物体3D几何信息,一方面目标几何模型精度难以保证;另一方面目标模型计算复杂,使得整个系统不显优势.与上述基于模型的方法不同,本文研究多模特征深度学习,直接从2D图像平面判别抓取位姿,不失为一种直观简洁的方法.

本文研究多模特征深度学习构建叠层深度网络,实现机器人抓取位姿最优判别.从问题本质出发,机器人对目标抓取位置的判别属于机器学习目标识别范畴,因此本文提出深度学习解决机器人抓取判别问题,是一种可行有效的方法,而且避免了传统学习方法耗时、需人工设计特征等缺点.本文研究目标为:给定抓取目标场景图,机器人视觉系统通过多模特征深度学习推断出最优抓取位姿,为此,本文主要研究内容及贡献包括:1)采用堆叠降噪自动编码(Denoising auto-encoding,DAE)建立深度网络模型.在网络建模中,把测试特征分布偏离训练特征视为一类噪化,通过引入降噪自动编码和稀疏约束条件实现网络权值学习;在网络学习中,先对训练数据进行噪化,再对其进行降噪编码,提高深度网络对新目标抓取判别的鲁棒性能.2)采用Kinect体感传感器获取目标RGB及深度多模数据,以融合策略处理多模特征的深层抽象表达.实验表明,与单模相比,多模特征融合学习大大改善了机器人抓取判别的精确性.3)论文研究的多模特征深度学习模型与6自由度机器人相结合,机器人实现了对不同形状、不同摆放方向物体的抓取判别与定位,不同情形下的实验结果验证了本文研究方法的实用性.

1 机器人抓取判别问题描述

给定抓取目标视觉场景图(RGB和深度图),机器人首先对目标进行感知识别(目标分割、提取有效的初始特征),然后推断出对其实施抓取的最优位姿(抓取位置和方向),针对上述研究目标,机器人抓取判别问题可描述如下:

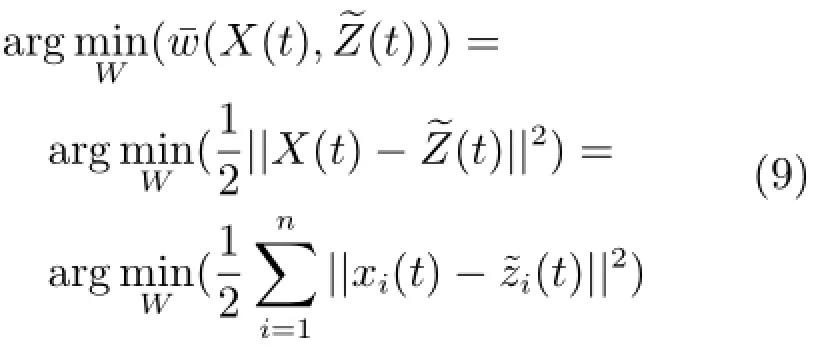

t时刻机器人获取抓取目标n维特征序列X(t)=(x1(t),x2(t),···,xn(t)),假设该目标存在τ个可能的抓取G(t)=(g1(t),g2(t),···,gτ(t)),令 “位姿—特征”集 Ωi=(gi(t),X(t)),其中gi(t),i=1,2,···,τ表示第i个特定的抓取位姿,给定二值变量有

式(1)指明,在给定目标特征X(t)条件下,gi(t)是否为最优抓取位姿.此时,机器人最优抓取判别问题即转化为以下概率模型的最大化:

本文采用L层深度学习网络,构建机器人最优抓取判别模型,其中输入层的输出量为:

式中δ(a)=1/(1+exp(-a)).网络的第l-1层输出h[l-1](t)作为第l层的输入,以此类推,各隐含层输入输出之间关系为:

式中,上标表示网络层数,下标表示网络节点,k[l-1]为第l-1层的节点数.网络的最后一层(第L层)为逻辑输出层:

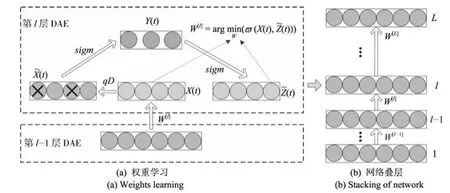

2 基于叠层DAE的多模特征深度参数学习

传统人工神经网络面临一个固有问题,即测试样本取值分布越接近训练样本,网络的重建输出效果越好,而当测试样本分布远离训练样本时,网络的重建输出效果则不然[25].若一个训练好的网络即便测试样本远离训练样本,网络的重建误差依然能够保持在较低水平,那么该网络具备良好的鲁棒性或泛化能力.为了提升网络的鲁棒性能,实现对新目标的抓取判别,本文把测试样本异于训练样本看作是被噪声污染后的结果,在网络训练前对训练特征进行随机噪化,再对噪化后的特征数据进行降噪编码,其目的是重建特征的精确复原体.网络的每一层由一个降噪自动编码器组成,原理如图1(a)所示,假设初始特征集X(t)∈Rn被随机噪声污染后变为噪化过程可看作一种随机映射,即:

式Rm中,为W编码∈偏Rm置×向n为量,n s 个igm特(征a)的为权S值型矩函阵数,b,1即∈sig m(a)=(1+exp(-a))-1.降噪自动编码器再对进行解码,得到初始特征集X(t)的重建e,即:

式中,V∈Rm×n为解码矩阵,b2∈Rn为解码偏置向量.

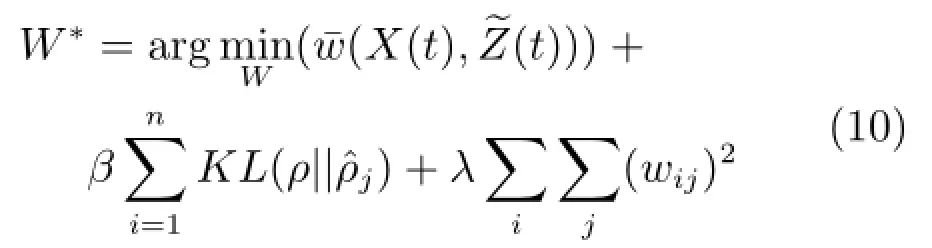

为了进一步提升网络的学习效率,更好地模拟神经元的激活机制,即神经元只能被感兴趣的视觉特征激活,本文在权值学习中引入稀疏约束条件,使得:

KL方差实现了稀疏约束,当ρ很小时,即可得到初始特征的无冗余完备深层抽象特征集.

图1叠层DAE深度学习过程Fig.1 The processing of stacked DAE deep learning

本文采用叠层DAE构建L层深度网络,其中每一层由一个DAE组成.在叠层学习中,首先采用DAE学习算法,根据式(10)初始化输入层权值矩阵W[1],从而重建初始特征向量X(t),然后固定W[1],再次采用DAE学习算法初始化W[2],重建第一层输出向量h[1].依次类推,得到网络权值变量Θ=(W[1],W[2],···,W[L]).网络的堆叠学习过程如图1(b)所示,L个DAE由下往上堆叠构成一个深度网络,实现从初始输入数据,逐渐抽取出深层抽象特征.

在堆叠学习中,我们得到一个单模结构的深度网络,网络的输入为单模特征.考虑到多模深度网络能够更好地处理多模特征学习问题[11,27],本文采用多模视觉特征,进一步构建多模深度网络.假设Xi(t)∈Rn为第i个单模深度网络的输入特征,表示第i个单模深度网络输出,多模深度学习就是要获取λ个单模深度网络输出的有效融合,从而有效提高机器人抓取判别精度,融合方式表示为:

式中,θi∈[0,1]为第i个单模深度网络输出融合权值,满足

3 机器人抓取位姿搜索与判别

为了搜索一个有效的抓取位姿,使得式(2)最优,首先需要确定抓取目标所有可能的抓取,然后利用深度网络对它们各自可能成为最优抓取的概率进行排序,概率值最大者获胜.文献[28]给出了一种增量快速搜索方法,认为抓取位姿搜索其本质是像素概率分类问题,即把概率模型分解成每个像素点属于最优抓取位姿的概率之和,通过分解计算提高算法的搜索效率.

假设某一已知的抓取位姿g(t)对应的概率模型为P(g(t)),我们把增量△g(t)合并到g(t)中,得到扩展抓取位姿g′(t)=g(t)∪△g(t),与此抓取位姿对应的图像特征可表示为:

扩展抓取位姿g′(t)的最优判别式,如下:

不失一般性,图像特征满足:

式中,φi(I(u,v))表示像素点(u,v)的第i个特征值,通过式(15)可计算出抓取位姿g(t)区域内所有像素点的k个特征之和,于是P(g(t))的计算公式可表示为:

综上所述,首先定义一个大小与图像I相同的矩阵F(u,v)∈Rr×c,F(u,v),元素代表图像I中各像素属于最优抓取区域的概率矩阵F称为像素概率矩阵.此时可把最优抓取判别描述为,给定大小为r×c的像素概率矩阵F,在F内部查找一个抓取位姿g(t),使得g(t)区域内包含F子元素之和最大,其本质是在F中查找一个最大和子矩阵F′.本文采用递增查找算法,使得F′所有元素之和最大,算法实现如下:

算法1.抓取位姿搜索算法

初始化F中子区域F′的大小,即rG和nG固定

初始化当前值sy=f(G)=0,最大s∗=f(G∗)= 0,i=1

4 实验结果分析

为了测试本文多模特征深度学习方法在机器人抓取判别中的有效性,首先采用抓取样本数据,离线训练所构建的网络模型.网络的输入为多模特征数据集,输出为目标的最优抓取区域.训练数据集包含日常生活中的180个物体,总共935幅样本场景图,每幅图像中的抓取目标都标记了3~5个抓取位置.多模特征包括RGB、YUV以及深度特征D三类特征,总共7个通道,我们把标记区域规范化为一个30像素×30像素的图像块,所以总的多模特征数为30×30×7=6300.在深度网络学习过程中,网络包括2个隐含层,每个隐含层包含300个节点,网络训练选用Intel Core i5 1.8GHz处理器,8GB RAM,安装Windows 8操作系统的个人计算机,在Matlab 2011b环境中训练时间近1.5小时.

在线抓取判别测试中,采用微软Kinect体感摄像机,在VS与Matlab交叉编译环境下,获取抓取目标RGB图像和深度图像,采集到的部分测试数据如图2所示,代表四类目标物:杯子、盘子、矩形盒、工具.针对不同形状、大小、摆放方向的测试目标,抓取判别试验结果如图3所示,从结果中可看出判别模型参照人的抓取习惯,即矩形盒抓中间、杯子抓杯柄、盘子抓边缘、工具抓把柄,表明本文研究的多模特征深度学习抓取判别方法具备以下两个特性:1)针对不同类别的抓取目标,学习算法依据人的抓取习惯,实现抓取位置的最优判别,说明该方法具有一定的智能学习判别特性.2)试验中部分测试目标不同于网络训练样本,这说明本文构建的多模特征深度学习网具有较好的鲁棒特性,即机器人在面临新的抓取目标时,同样能够实现抓取判别.

图2 抓取判别测试数据Fig.2 Test dataset for potential grasp recognition

为了进一步验证本文方法的鲁棒性能与特性,我们进行以下两种情形的比较试验:

情形1.相同训练特征,不同训练方法试验比较,网络输入为相同的RGB-YUV-D多模特征,分别采用自动编码(AE)和本文降噪自动编码(DAE)方法训练网络.在网络权值学习中忽略式(6),即初始多模特征不进行噪化处理,从而式(7)退化为常规AE编码,然后用AE方法训练网络.这种训练模式下,网络在线测试结果如图4所示,其中图4(a)测试目标“杯子”、“盘子”、“工具”包含在训练样本集中,此时AE和本文DAE方法的试验结果比较接近,二者抓取判别效果令人满意.图4(b)测试目标“接线导轨”、“订书机”、“测量仪”不包含在训练样本中,此时本文DAE方法测试结果明显优越于AE方法,说明当面临新目标时,AE网络的判别效果变差,不能满足工程要求,而本文DAE网络依然能够保持良好的判别效果.试验结果表明,本文把测试特征偏离训练特征视为一类噪化,通过引入带约束的降噪自动编码方法对目标特征进行学习是一种有效举措,训练样本先噪化再降噪编码,有效提高了网络的鲁棒性能.

图3 不同类别目标抓取判别结果Fig.3 Grasp recognition results for variety of targets

图4AE和本文DAE训练方法结果比较Fig.4 Results comparison between AE and our DAE training methods

情形2.相同DAE训练方法,不同训练特征试验比较.分别采用RGB-YUV、RGB-D、RGBYUV-D三种特征训练网络.首先通过设定某个特征的融合权值θi为0,实现从RGB-YUV-D中剔除某一特征数据,即网络退化为单模深度网络,再与本文的多模深度网络进行比较.试验结果如图5所示,可看出RGB-YUV网络判别效果最差,其次为RGB-D网络,而本文RGB-YUV-D多模特征网络判别结果最优,表明本文采取的多模特征融合策略,处理多模特征深层抽象表达真实有效,从而大大改善了网络的判别精度.

图5 不同特征融合结果比较Fig.5 Results comparison between different features

本文研究方法与6自由度工业机器人相结合,构建机器人视觉伺服抓取定位试验平台,验证本文方法的实际应用效果.在机器人抓取定位实验中,深度摄像机安放在机器人的基坐标系中,位置大致为x =200mm,y=150mm,z=680mm,相机成像平面尽量与机器人坐标系Y-轴平行.相机通过USB接口与PC相连,PC通过RS232串口与机器人控制器相连接,构成机器人视觉伺服闭环系统.PC作为上位机主要完成图像采集、图像处理及执行抓取判别算法,机器人控制器作为下位机完成机器人运动学运算,同时驱动机器人各个关节.

首先,机器人对不同物体实施抓取判别与定位实验,结果如图6所示,机器人根据深度网络输出的抓取位姿判别结果(图6(a)),再实施对其目标抓取定位(图6(b)),可看出机器人成功实现了对矩形盒和杯子的抓取判别与定位.其次,为了进一步验证研究方法的可靠性,我们对相同物体、不同摆放方向进行测试,结果如图7所示,机器人对摆放方向大致为—5◦、35◦、270◦的同一物体成功实施抓取判别与定位.从以上结果可直观看出,本文研究方法适用于不同形状、不同摆放姿态物体的抓取判别与定位.值得一提的是,我们沿用了目标识别一贯表示方式,用一个矩形框来表示抓取位姿,同时考虑目标物为刚性物体,在抓取定位精确情况下机器人即可进行简单的两指挟持操作,后续工作也将进一步研究机器人多指抓取操作问题.

最后,我们对图2中四类不同物体、不同摆放方向进行总计96次机器人抓取定位实验,结果统计如表1所示,从有限代表性实验中得出机器人抓取定位平均成功率为91.7%,综上得证本文研究方法的实用性.

图6 机器人对不同物体实施抓取判别与定位Fig.6 Robot executing grasp recognition and positioning for different targets

图7 机器人对不同摆放方向物体实施抓取判别与定位Fig.7 Robot executing grasp recognition and positioning for targets with different poses

表1 机器人对不同物体、不同摆放方向抓取定位统计结果Table 1 Results of robot grasp positioning for different targets with different poses

5 结论

本文针对机器人抓取判别与定位问题,给出了叠层多模特征深度学习与融合抓取判别方法.本文把测试特征偏离训练特征视为一类噪化,通过引入降噪自动编码和稀疏约束条件实现网络权值学习,提高了叠层DAE网对新目标抓取判别的鲁棒性能.考虑多模视觉特征,采取多模特征融合策略处理多模特征的深层抽象表达,有效改善了网络的判别精度.试验表明判别模型依据人的抓取习惯,实现了不同摆放姿态、不同形状物体的抓取判别,6自由度工业机器人抓取定位实验验证了方法的实用性.

References

1 Paolini R,Rodriguez A,Srinivasa S S,Mason M T.A data-driven statistical framework for post-grasp manipulation.The International Journal of Robotics Research,2014,33(4):600-615

2 Jia Bing-Xi,Liu Shan,Zhang Kai-Xiang,Chen Jian.Survey on robot visual servo control:vision system and control strategies.Acta Automatica Sinica,2015,41(5):861-873(贾丙西,刘山,张凯祥,陈剑.机器人视觉伺服研究进展:视觉系统与控制策略.自动化学报,2015,41(5):861-873)

3 Droniou A,Ivaldi S,Sigaud O.Deep unsupervised network for multimodal perception,representation and classification. Robotics and Autonomous Systems,2015,71(9):83-98

4 Gao Ying-Ying,Zhu Wei-Bin.Deep neural networks with visible intermediate layers.Acta Automatica Sinica,2015,41(9):1627-1637(高莹莹,朱维彬.深层神经网络中间层可见化建模.自动化学报,2015,41(9):1627-1637)

5 Qiao Jun-Fei,Pan Guang-Yuan,Han Hong-Gui.Design and application of continuous deep belief network.Acta Automatica Sinica,2015,41(12):2138-2146(乔俊飞,潘广源,韩红桂.一种连续型深度信念网的设计与应用.自动化学报,2015,41(12):2138-2146)

6 Hinton G E,Salakhutdinov R R.Reducing the dimensionality of data with neural networks.Science,2006,313(5786):504-507

7 Bengio Y.Learning deep architectures for AI.Foundations and Trends®in Machine Learning,2009,2(1):1-127

8 L¨angkvist M,Karlsson L,Loutfi A.A review of unsupervised feature learning and deep learning for time-series modeling. Pattern Recognition Letters,2014,42:11-24

9 Erhan D,Bengio Y,Courville A,Manzagol P A,Vincent P,Bengio S.Why does unsupervised pre-training help deep learning?Journal of Machine Learning Research,2010,11:625-660

10 Salakhutdinov R,Hinton G.Deep Boltzmann machines.In:Proceedings of the 12th International Conference on Artificial Intelligence and Statistics(AISTATS)2009.Florid,USA,2009.448-455

11 Ngiam J,Khosla A,Kim M,Nam J,Lee H,Ng A Y.Multimodal deep learning.In:Proceedings of the 28th International Conference on Machine Learning.Bellevue,USA,2011.689-696

12 Baldi P,Lu Z Q.Complex-valued autoencoders.Neural Networks,2012,33:136-147

13 Wu P C,Hoi S C H,Xia H,Zhao P L,Wang D Y,Miao C Y.Online multimodal deep similarity learning with application to image retrieval.In:Proceedings of the 21st ACM International Conference on Multimedia.Barcelona,Spain:ACM,2013.153-162

14 Geng Jie,Fan Jian-Chao,Chu Jia-Lan,Wang Hong-Yu.Research on marine floating raft aquaculture SAR image target recognition based on deep collaborative sparse coding network.Acta Automatica Sinica,2016,42(4):593-604(耿杰,范剑超,初佳兰,王洪玉.基于深度协同稀疏编码网络的海洋浮筏SAR图像目标识别.自动化学报,2016,42(4):593-604)

15 Mohamed A R,Dahl G E,Hinton G.Acoustic modeling using deep belief networks.IEEE Transactions on Audio,Speech,and Language Processing,2012,20(1):14-22

16 Sarikaya R,Hinton G E,Deoras A.Application of deep belief networks for natural language understanding.IEEE/ACM Transactions on Audio,Speech,and Language Processing,2014,22(4):778-784

17 Humphrey E J,Bello J P,LeCun Y.Feature learning and deep architectures:new directions for music informatics. Journal of Intelligent Information Systems,2013,41(3):461-481

18 Yu J C,Weng K J,Liang G Y,Xie G H.A vision-based robotic grasping system using deep learning for 3D object recognition and pose estimation.In:Proceedings of the 2013 IEEE International Conference on Robotics and Biomimetics.Shenzhen,China:IEEE,2013.1175-1180

19 Noda K,Arie H,Suga Y,Ogata T.Multimodal integration learning of object manipulation behaviors using deep neural networks.In:Proceedings of the 2013 IEEE/RSJ International Conference on Intelligent Robots and Systems.Tokyo,Japan:IEEE,2013.1728-1733

20 Lenz I,Lee H,Saxena A.Deep learning for detecting robotic grasps.The International Journal of Robotics Research,2015,34(4-5):705-724

21 El-Khoury S,Sahbani A.A new strategy combining empirical and analytical approaches for grasping unknown 3D objects.Robotics and Autonomous Systems,2010,58(5):497-507

22 Pelossof R,Miller A,Allen P,Jebara T.An SVM learning approach to robotic grasping.In:Proceedings of the 2004 IEEE International Conference on Robotics and Automation.New Orleans,USA:IEEE,2004.3512-3518

23 Boularias A,Kroemer O,Peters J.Learning robot grasping from 3-D images with Markov random fields.In:Proceedings of the 2011 IEEE/RSJ International Conference on Intelligent Robots and Systems.San Francisco,USA:IEEE,2011.1548-1553

24 Papazov C,Haddadin S,Parusel S,Krieger K,Burschka D. Rigid 3D geometry matching for grasping of known objects in cluttered scenes.The International Journal of Robotics Research,2012,31(4):538-553

25 Liu Jian-Wei,Sun Zheng-Kang,Luo Xiong-Lin.Review and research development on domain adaptation learning.Acta Automatica Sinica,2014,40(8):1576-1600(刘建伟,孙正康,罗雄麟.域自适应学习研究进展.自动化学报,2014,40(8):1576-1600)

26 Shin H C,Orton M R,Collins D J,Doran S J,Leach M O. Stacked autoencoders for unsupervised feature learning and multiple organ detection in a pilot study using 4D patient data.IEEE Transactions on Pattern Analysis and Machine Intelligence,2013,35(8):1930-1943

27 Vincent P,Larochelle H,Bengio Y,Manzagol P A.Extracting and composing robust features with denoising autoencoders.In:Proceedings of the 25th International Conference on Machine Learning.Helsinki,Finland:ACM,2008. 1096-1103

28 Jiang Y,Moseson,Saxena A.Efficient grasping from RGBD images:learning using a new rectangle representation.In:Proceedings of the 2011 IEEE International Conference on Robotics and Automation.Shanghai,China:IEEE,2011. 3304-3311

仲训杲博士,厦门理工学院电气工程与自动化学院讲师.主要研究方向为机器学习和机器人视觉伺服.

E-mail:zhongxungao@163.com

(ZHONGXun-GaoPh.D.,lecturer at the School of Electrical Engineering and Automation,Xiamen University of Technology.His research interest covers machine learning and robotic visual servoing.)

徐敏厦门理工学院电气工程与自动化学院教授.主要研究方向为模式识别和机器人智能控制.

E-mail:xumin@xmut.edu.cn

(XU MinProfessor at the School of Electrical Engineering and Automation,Xiamen University of Technology.His research interest covers pattern identification and intelligent control of robotic.)

仲训昱博士,厦门大学自动化系副教授.主要研究方向为机器视觉,机器人运动规划,遥自主机器人.本文通信作者. E-mail:zhongxunyu@xmu.edu.cn

(ZHONG Xun-YuPh.D.,associate professor in the Department of Automation,Xiamen University.His research interest covers machine vision, robot motion planning,mobile and autonomous robotics. Corresponding author of this paper.)

彭侠夫博士,厦门大学自动化系教授.主要研究方向为机器人导航与运动控制,机器学习.

E-mail:xfpeng@xmu.edu.cn

(PENG Xia-FuPh.D.,professor in the Department of Automation,Xiamen University.His research interest covers navigation and motion control of robotic,machine learning.)

Multimodal Features Deep Learning for Robotic Potential Grasp Recognition

ZHONG Xun-Gao1XU Min1ZHONG Xun-Yu2PENG Xia-Fu2

In this paper,a multimodal features deep learning and a fusion approach are proposed to address the problem of robotic potential grasp recognition.In our thinking,the test features which diverge from training are presented as noise-processing,then the denoising auto-encoding(DAE)and sparse constraint conditions are introduced to realize the network′s weights training.Furthermore,a stacked DAE with fusion method is adopted to deal with the multimodal vision dataset for its high-level abstract expression.These two strategies aim at improving the network′s robustness and the precision of grasp recognition.A six-degree-of-freedom robotic manipulator with a stereo camera configuration is used to demonstrate the robotic potential grasp recognition.Experimental results show that the robot can optimally localizate the target by simulating human grasps,and that the proposed method is robust to a variety of new target grasp recognition.

Robot grasping recognition,denoising auto-encoding(DAE),stacked deep learning,multimodal features

10.16383/j.aas.2016.c150661

Zhong Xun-Gao,Xu Min,Zhong Xun-Yu,Peng Xia-Fu.Multimodal features deep learning for robotic potential grasp recognition.Acta Automatica Sinica,2016,42(7):1022-1029

2015-10-16录用日期2016-05-03

Manuscript received October 16,2015;accepted May 3,2016国家自然科学基金 (61305117),福建省科技计划重点项目(2014H0047),厦门市科技计划项目(3502Z20143034),厦门理工学院高层次人才项目(YKJ15020R)资助

Supported by National Natural Science Foundation of China (61305117),theKeyScienceProjectofFujianProvince (2014H0047),theSciencePlanProjectofXiamenCity (3502Z20143034),and the High-level Talent Fund of Xiamen University of Technology(YKJ15020R)

本文责任编委贾珈

Recommended by Associate Editor JIA Jia

1.厦门理工学院电气工程与自动化学院厦门3610242.厦门大学自动化系厦门361005

1.School of Electrical Engineering and Automation,Xiamen University of Technology,Xiamen 3610242.Department of Automation,Xiamen University,Xiamen 361005