基于颜色与面积特征的方格蔟蚕茧分割定位算法与试验

刘莫尘 许荣浩 李法德 宋占华 闫银发 韩守强

(1.山东农业大学机械与电子工程学院, 泰安 271018; 2.山东省园艺机械与装备重点实验室,泰安 271018)

0 引言

为提高蚕茧质量,我国推广使用方格蔟用于蚕虫上蔟,方格蔟具有孔格数目多、结构合理、吸水性好、保存方便等特点,但我国的方格蔟多为纸板方格蔟,并且纸质质量良莠不齐,方格蔟在使用过程中极易发生扭曲变形,造成方格分布不规则,当采茧机械对变形的方格蔟进行蚕茧采摘时,由于挤压会直接导致方格蔟破损,因此我国对蚕茧的采摘主要以人工为主,效率低下。我国虽然已有多款蚕茧采摘设备,但是,这些蚕茧采摘设备智能化水平较低,采茧过程中,对变形的方格蔟会造成二次损害[1],使其失去使用价值。

国外蚕茧采茧机报道较少,只有日本一直推行着省力化蚕茧技术,其采茧机的研制也由来已久,并发展了多种类型的采茧机[2]。日本的方格蔟均为竹制方格蔟和硬纸板方格蔟,框架比较坚固,不易发生变形,利于机构采收。而我国方格蔟多为纸板,且质量差,易发生变形损坏,日本的采茧机械并不适用于我国方格蔟。为改善我国蚕茧采摘设备落后,易损伤方格蔟的现状,研制一种适用于我国纸制方格蔟的蚕茧采摘设备极为重要。

机器视觉作为农业机器人外部传感器最大信息源,是农业机器人研究领域的关键技术之一。但由于农业对象的多样性及作业环境的复杂性,尚未有一种通用的目标识别算法[3]。近年来,国内学者通过机器视觉对采摘后的蚕茧进行分类,金航峰[4]通过光谱和高光谱图像技术对蚕茧品质的无损检测进行了研究。宋亚杰等[5]通过采集单个蚕茧图像并对其进行处理,根据数学形态学的方法,判断蚕茧的质量。周志宇等[6]对单个蚕茧图像进行采集处理,将蚕茧看成椭圆形从而求其表面积。甘勇[7]利用光电技术和图像处理技术计算蚕茧干茧茧壳厚度。乔乐领[8]通过图像处理技术提出了一种对采摘后的蚕茧进行筛选计数的系统。陈浩等[9]通过图像处理对蚕茧表面污斑面积进行自动检测,得到了一种智能化的选茧辅助检验方法。

综上所述,目前并未有将机器视觉应用于蚕茧采摘机械中的相关研究。

为提高蚕茧采摘设备的智能化水平,减少采茧设备对方格蔟的损伤,探索将机器视觉直接应用于蚕茧采摘中,对方格蔟中的蚕茧进行精确定位采摘,解决变形方格蔟蚕茧无法使用机械采茧的难题,本文提出一种基于颜色与面积特征的方格蔟蚕茧分割定位算法,直接对方格蔟与其中的蚕茧进行分割,并进行视觉测量和蚕茧定位,消除方格蔟变形对蚕茧定位的影响。

1 试验工具与图像采集装置

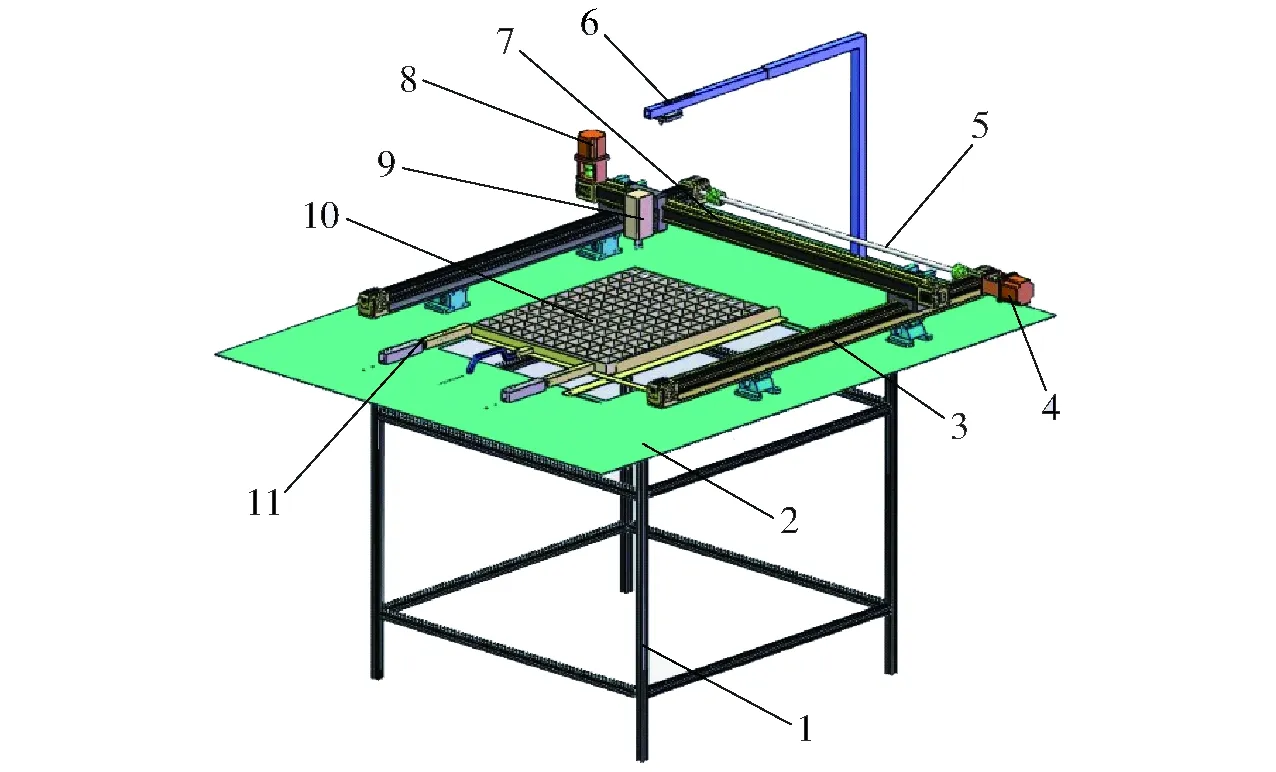

方格蔟由山东农业大学马庄蚕桑实验站提供,尺寸为540 mm×390 mm,采用Omnivision 公司的ov5647型摄像头,视场角为160°。在室内自然光下拍摄整张方格蔟图像时,摄像头位于方格蔟中心上方75 cm处,图像分辨率为640像素×320像素。用于图像处理的硬件平台为Raspberry Pi 3b,Raspbian操作系统,ARM Cortex-A53 1.2 GHz处理器,软件为Python2.7和OpenCV3.2机器视觉库。蚕茧采摘设备为直角坐标式方格蔟自动采茧机,如图1所示。X轴导轨为2个由传动轴连接的同步导轨,长1 m;Y轴导轨带有电磁采摘器,长1 m,于X轴导轨上运动。电磁采摘器由一个行程60 mm、单次往返时间0.5 s的电磁铁和一个采茧头组成,用于采摘蚕茧。X轴导轨、Y轴导轨和电磁采摘器共同组成直角坐标式蚕茧采摘机构。

图1 直角坐标式自动采茧机Fig.1 Cartesian coordinate automatic cocoon harvestor1.机架 2.工作台 3.X轴导轨 4.X轴步进电动机 5.传动轴6.摄像头 7.Y轴导轨 8.Y轴步进电动机 9.电磁采摘器 10.蚕茧方格蔟 11.方格蔟夹持装置

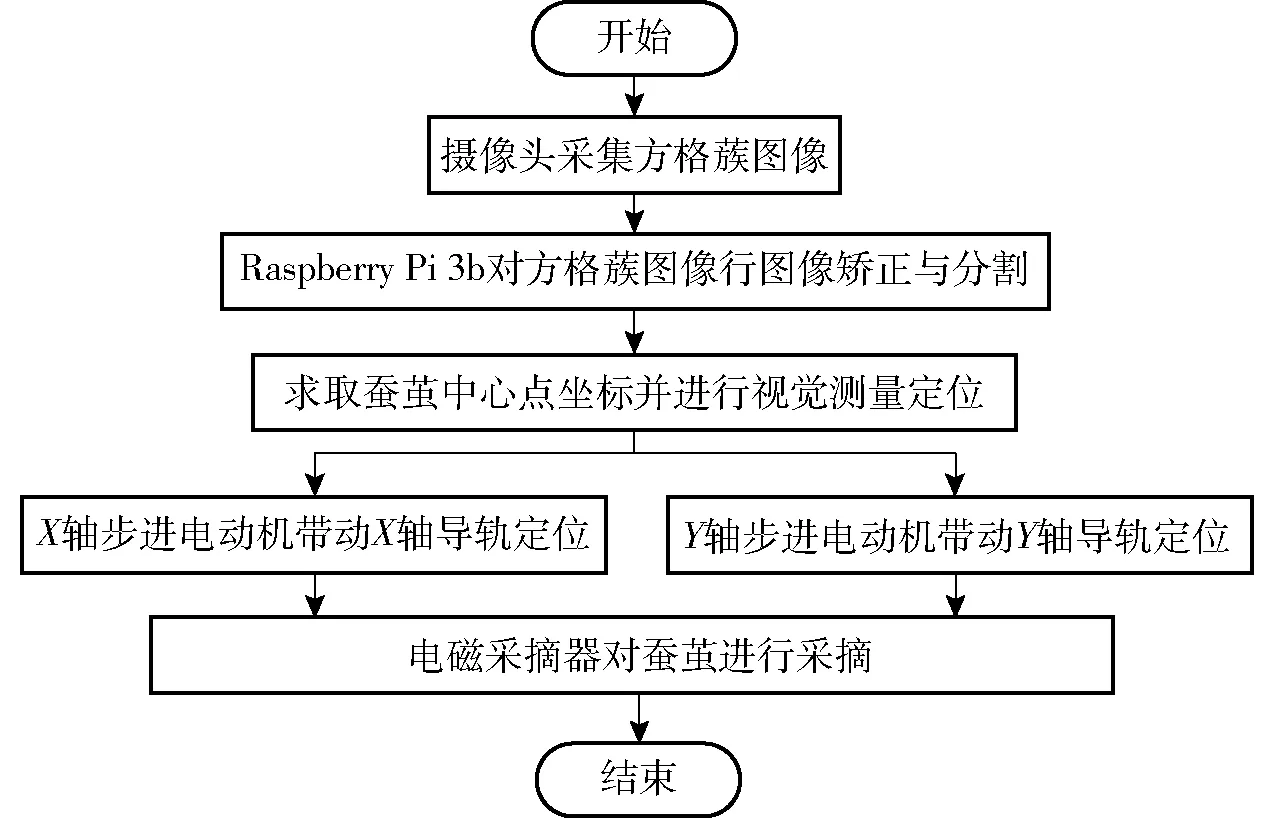

Raspberry Pi 3b控制摄像头采集方格蔟图像,并对图像中方格蔟蚕茧进行分割和视觉测量定位,生成方格蔟中蚕茧中心点坐标,进而控制X轴、Y轴步进电动机将电磁采摘器定位到蚕茧位置,控制电磁采摘器接通电源,实现电磁采摘器对蚕茧的定位采摘,然后切断电磁采摘器电源,释放电磁采摘器准备下一个蚕茧的采摘。其工作流程图如图2所示。

图2 直角坐标式自动采茧机工作流程图Fig.2 Flow chart of Cartesian coordinate automatic cocoon harvestor

2 图像畸变矫正方法

因为需要对蚕茧进行视觉测量定位,而蚕茧在图像上的坐标与蚕茧在笛卡尔空间的三维坐标关系由摄像机成像几何模型决定,该几何模型的参数称为摄像机参数,求取这些几何参数需要通过摄像机标定实现[10]。摄像机相对于世界坐标系的位置及标定精度直接影响着机器视觉的定位精度。

由于摄像机实际拍摄的图像会存在畸变[11],而在摄像机镜头具有大畸变时,如果忽略畸变而求取摄像机的内外参数,必然会因为引入畸变系数而使求得的参数存在很大误差。因此可以先进行畸变矫正再标定其他参数。利用图像空间的Brown畸变模型的畸变矫正方法[12]对图像进行矫正,再在无畸变的图像上进行摄像机其他线性参数的标定,这样的标定不需要在线性参数与畸变参数之间进行反复标记,计算量较小,效率较高[13]。

摄像机镜头的畸变包括径向畸变和切向畸变,Brown畸变模型考虑了径向畸变和切向畸变。图像空间下的Brown畸变模型为

(1)

其中

(ud,vd)=(u,v)-(u0,v0)

(u′d,v′d)=(u′,v′)-(u0,v0)

式中(u′d,v′d)——消除畸变后相对参考点的图像坐标

(ud,vd)——畸变图像相对参考点的图像坐标

k1——2阶径向畸变系数

k2——4阶径向畸变系数

k3——6阶径向畸变系数

p1、p2——切向畸变系数

r——图像到参考点的距离

(u,v)——实际图像坐标

(u0,v0)——光轴中心点图像坐标

(u′,v′)——消除畸变后的图像坐标

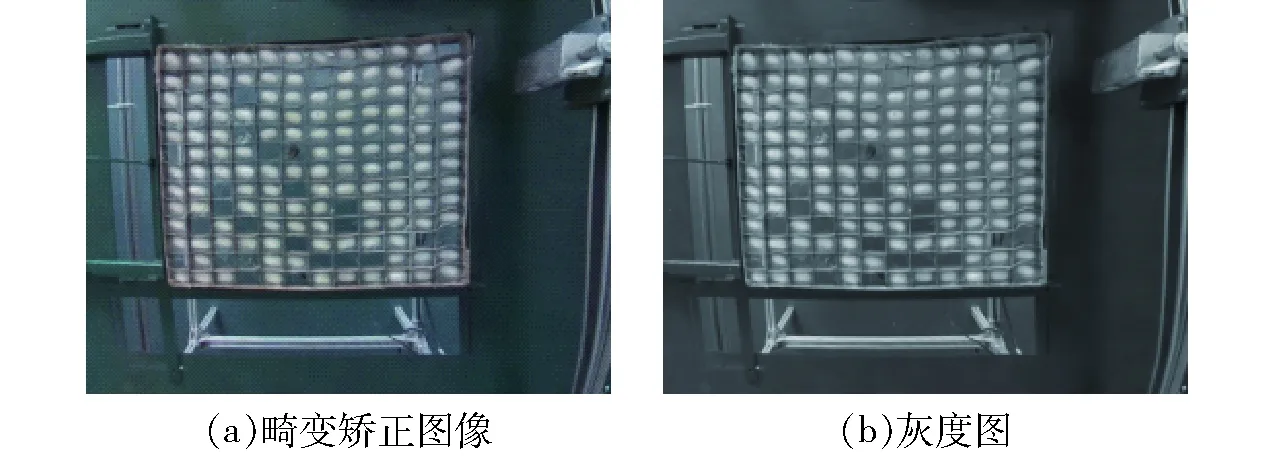

图3a为摄像机采集的原始图像,经过矫正后的图像如图3b所示,减小了径向畸变对视觉测量的影响。

图3 畸变矫正Fig.3 Distortion rectifying

3 蚕茧分割及蚕茧视觉测量定位算法

3.1 复杂背景下蚕茧图像分割算法

3.1.1图像预处理

图像预处理将畸变矫正后的图像灰度化。在数字图像处理中一般先将各种格式的图像转换成灰度图像,以减少处理图像的数据量[14]。灰度图像的描述与彩色图像一样仍然反映了整幅图像的整体和局部的色度和亮度等级的分布和特征。假设f(x,y)代表一幅图像,Y(x,y)表示点(x,y)处的灰度,R(x,y)表示点(x,y)处的R分量值,G(x,y)表示点(x,y)处的G分量值,B(x,y)表示点(x,y)处的B分量值,则点(x,y)处的灰度为

Y(x,y)=0.299R(x,y)+0.587G(x,y)+0.114B(x,y)

(2)

畸变矫正后的图像如图4a所示,经过灰度变换后的图像如图4b所示。

图4 图像预处理Fig.4 Images preprocessing

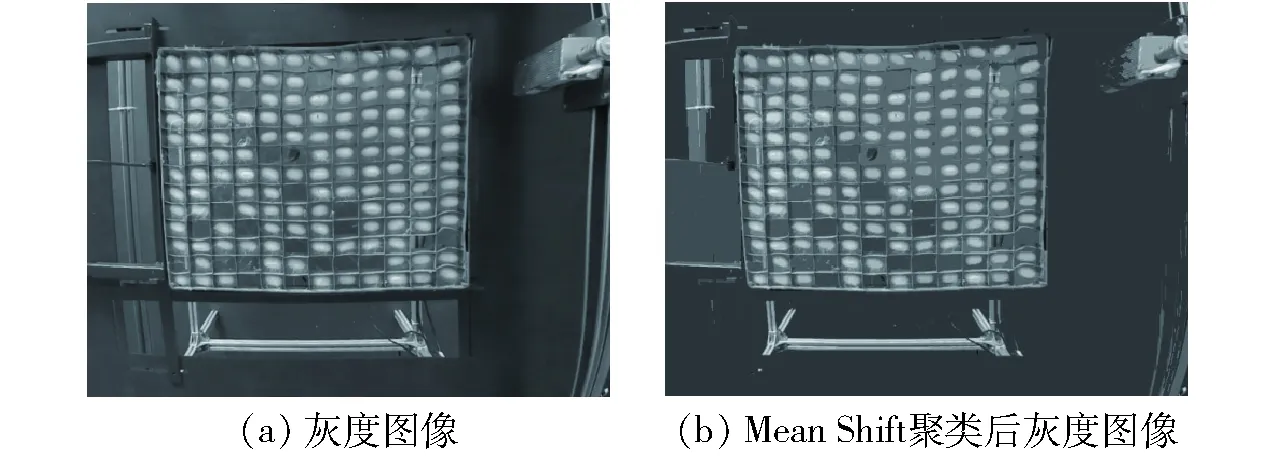

3.1.2图像Mean Shift聚类

Mean Shift是一种基于非参数核函数的密度估计算法[15],将Mean Shift算法应用于图像分割时,灰度图像如图5a所示,Mean Shift聚类后图像如图5b所示。

图5 Mean Shift聚类Fig.5 Mean Shift clustering

假设图像由像素x组成,取核函数为K(s),定义Mean Shift偏移向量为

(3)

式中w(s)——权值函数

S——x的子集

对图5a灰度图像进行Mean Shift聚类后,结果如图5b所示,可以看出Mean Shift聚类突出了蚕茧区域,保留了蚕茧的基本特征,并消除了光照及图像背景对蚕茧图像的影响。

3.1.3蚕茧与方格蔟阈值分割和形态学处理

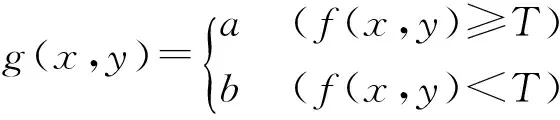

对于暗背景上由亮物体组成的图像f(x,y),从背景提取目标的方法是选取阈值T来分离这2类图像[16]。满足f(x,y)≥T的任何图像点被称为物体点,其他的点称为背景点(在亮背景上的暗物体也一样)。阈值处理后的图像被定义为

(4)

式中a——目标像素值

b——背景像素值

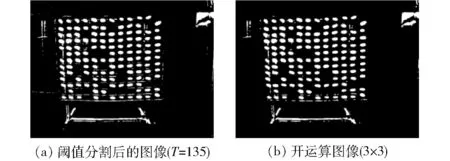

为了便于处理,使分割后的图像以白色为目标,黑色为背景,故令a=1(白),b=0(黑),T为常数[17]。选取T=135,对Mean Shift聚类后的灰度图像进行阈值分割,结果如图6a所示。

图6 图像阈值分割及开运算结果Fig.6 Threshold segmentation and opening operation

对蚕茧图像进行初步阈值分割后,删除了方格蔟边框及对蚕茧产生影响的其他区域,只保留了蚕茧区域。因蚕茧区域灰度存在不同,容易对灰度较小的区域造成过分割,故对分割后的二值图像进行一系列形态学操作修饰,以删除过分割的部分,保持蚕茧的基本形状。图像的形态学操作是由一组形态学的代数运算子组成的[18],基本操作包括膨胀、腐蚀、开运算和闭运算,其中腐蚀和膨胀是两种最基本也是最重要的形态学运算,开运算与闭运算都是由膨胀和腐蚀复合而成[19]。本文中,首先对图像进行阈值分割,然后对分割后的二值图像进行开运算,去除噪点并使分割后的蚕茧保持它们的基本形状[20]。

开运算是先腐蚀后膨胀,使用结构元素S对A进行开运算,记作A∘S,可表示为

A∘S=(A⊖S)⊕S

(5)

式中A——待处理的图像区域

开运算先用S对A进行简单的腐蚀操作,然后用S对得到的结果进行膨胀操作。

将像素在图像中的整型位置坐标用z=(z1,z2)表示,z∈Z,其中Z为二元整数有序偶集合。将一幅图像或者图像中1个感兴趣的区域称为集合,用大写字母A、B、C等表示。

对于Z上的集合A和S,使用S对A进行膨胀,记作

A⊕S={()z∩A≠∅}

(6)

对于Z2上的集合A和S,使用S对A进行腐蚀,记作

A⊖S={z|(S)z⊆A}

(7)

开运算后的图像如图6b所示。

图7 图像面积特征提取结果Fig.7 Feature extraction of image area

3.1.4基于面积阈值的蚕茧提取

对图像进行开运算处理后,仍有许多像素以噪声的形式存在,主要是目标对象或蚕茧部分被误判为背景而形成的[22],如图7a所示。选择面积法滤波[23]提取蚕茧,一个连通域的面积定义为连通域中像素的数目,设定面积阈值(m1,m2),m2>m1,计算蚕茧区所有白色连通域的面积M,则蚕茧面积与噪点面积关系为

(8)

为了更好地消除噪点对蚕茧的影响,经过多次试验,面积阈值选取(100,600)时,对蚕茧提取效果最好,经过面积法的提取,可以得到提取后的蚕茧图像及各蚕茧连通域的中心点如图7b所示。

3.2 摄像机标定及蚕茧定位算法

3.2.1摄像机标定方法

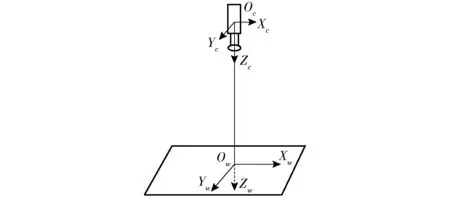

视觉系统涉及3个坐标系:世界坐标系(Xw,Yw,Zw),摄像机坐标系(Xc,Yc,Zc),图像坐标系(u,v)[24]。方格蔟固定在工作台上,方格蔟垂直方向Z的值固定不变,因此蚕茧在方格蔟内水平面的位置只由X、Y坐标决定,可采用单目二维视觉系统。对于单目二维视距测量,其摄像机垂直于工作台平面安装,摄像机的位置和内外参数[25]固定。采集原理如图8所示。

图8 单目二维视觉测量坐标系Fig.8 Monocular two-dimensional vision measurement coordinate system

世界坐标到图像坐标的转换关系[26]为

(9)

其中

式中n——Xw轴在摄像机坐标系OcXcYcZc的方向向量

o——Yw轴在摄像机坐标系OcXcYcZc的方向向量

a——Zw轴在摄像机坐标系OcXcYcZc的方向向量

t——OwXwYwZw的坐标原点在摄像机坐标系OcXcYcZc中的位置

对于图8所示的单目二维视觉测量系统,有

式中d——光轴中心点Oc到景物中心点Ow距离

将R、t代入式(9),化简后得

(10)

式中f——摄像机焦距

内参数采用四参数摄像机模型,对于工作平面上的两点P1(xw1,yw1,0)和P2(xw2,yw2,0),由式(10)可得P1与P2两点图像坐标之间的关系为

(11)

式中kx——X轴方向的放大系数

ky——Y轴方向的放大系数

(u1,v1)——点P1的图像坐标

(u2,v2)——点P2的图像坐标

kxd与kyd的计算公式为

(12)

其中

式中kxd、kyd——标定的摄像机参数

因此理论上只需确定两点在世界坐标中的距离和在图像坐标中对应的距离,就可以通过式(12)计算摄像机参数。

为了减小摄像机标定参数的误差,得到更加精确的摄像机参数,可采用取多个点求平均值的方法,来确定摄像机标定参数。方法如下:采集i组点,每组点包含2个坐标点Pi1和Pi2,其世界坐标为(xi1,yi1,0)和(xi2,yi2,0),对应的图像坐标为(ui1,vi1)和(ui2,vi2),则可由式(12)得到i个kxd和i个kyd,则第i个kxd记作kxdi,第i个kyd记作kydi。则kxd、kyd的平均值计算公式为

(13)

3.2.2蚕茧视觉测量与定位算法

设第k个蚕茧中心点图像坐标为Cck(uk,vk),世界坐标原点所对应的图像坐标为Oc(u0,v0),则第k个蚕茧的世界坐标Cwk(xwk,ywk)为

(14)

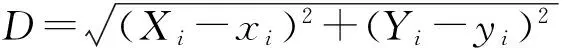

采用特征点的实际坐标与标定坐标之间的欧氏距离作为标定偏差D[27]。则标定偏差D为

(15)

式中(Xi,Yi)——实际坐标值

(xi,yi)——标定坐标值

图像坐标系以图像左上角第一个像素点作为原点,世界坐标系则以图像左上角第一个蚕茧的中心点为原点,在方格蔟上寻找10个蚕茧中心点作为已知点,使用游标卡尺分别测出10个已知蚕茧中心点的空间坐标(Xi,Yi)(i=1,2,…,10)。已知10个蚕茧中心点在图像上的坐标(ui,vi),通过式(14)分别计算得到10个已知点的标定坐标(xi,yi),通过式(15)分别计算10个蚕茧中心点标定坐标与世界坐标的标定偏差。得到的蚕茧质心位置坐标信息如表1所示。由表1可知,蚕茧质心位置坐标标定偏差最大为6.0 mm。

表1 蚕茧质心的位置坐标信息Tab.1 Location information of centroid of cocoon

4 算法性能测试与试验结果分析

通过基于机器视觉的直角坐标式方格蔟自动采茧机对算法进行试验测试,采茧机如图9所示。

图9 基于机器视觉的直角坐标式方格蔟自动采茧机样机Fig.9 Mock-up of Cartesian coordinate automatic cocoon harvestor based on machine vision

随机选取10张方格蔟,使用基于颜色与面积特征的方格蔟蚕茧分割算法对方格蔟内的蚕茧进行识别、定位和采摘试验,并对试验数据进行整理。

4.1 方格蔟蚕茧检测正确率

使用检测正确率[28]衡量蚕茧被识别的程度。检测正确率为单张方格蔟中被识别蚕茧数与总蚕茧数之比,计算公式为

(16)

式中Rs——检测正确率

Ns——单张方格蔟中被识别的蚕茧数

Nc——单张方格蔟中的总蚕茧数

检测统计结果如表2所示,蚕茧检测正确率为96.88%,满足蚕茧采摘对蚕茧检测正确率的要求。

表2 蚕茧检测正确率Tab.2 Correct ratio of cocoon detection

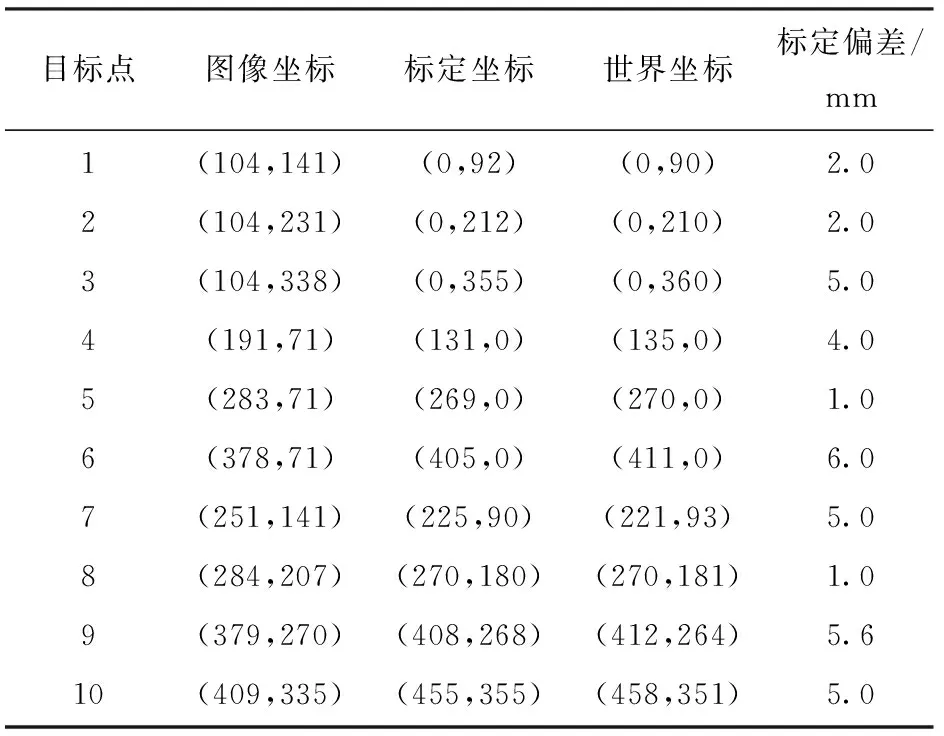

4.2 蚕茧定位精度

使用整体最大偏差衡量定位精度,整体最大偏差定义为所有方格蔟标定偏差的最大值

Er=max(er1,er2,…,erN)

(17)

式中Er——整体最大偏差

N——方格蔟个数

er——某张方格蔟的最大定位偏差

本文随机选取10张方格蔟,故N=10。计算统计结果如表3所示,10张方格蔟中蚕茧定位坐标的最大偏差为6.0 mm,满足蚕茧采摘定位精度的要求。

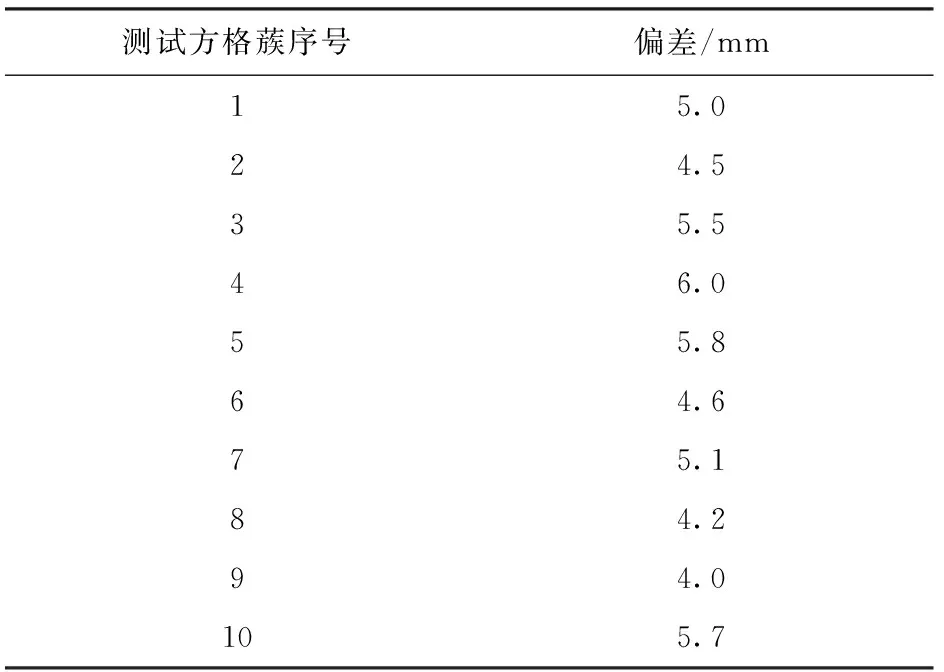

4.3 蚕茧采摘结果分析

对选取的10张方格蔟蚕茧进行采摘试验,试验过程中,样机运行平稳,能够有效地完成蚕茧定位采摘。试验结果如表4所示,效果如图10所示。

表3 整体最大偏差Tab.3 Overall maximum deviation

在蚕茧采摘过程中,对蚕茧检测正确率可达96.88%,蚕茧位置坐标最大定位误差为6.0 mm,满足蚕茧采摘精度要求。采摘一张方格蔟所需时间小于等于50 s,比人工采茧效率提高4~5倍。

图10 蚕茧采摘效果图Fig.10 Picking effect images

5 结论

(1) 提出的基于颜色与面积特征的方格蔟蚕茧分割算法,消除方格蔟变形对蚕茧定位的影响。通过Brown畸变模型对采集到的原始图像进行畸变矫正,然后采用Mean Shift聚类、阈值分割、形态学处理及面积阈值法对矫正后的图像进行处理,对复杂背景下的方格蔟和蚕茧进行有效分割,满足将蚕茧从变形方格蔟中分割的要求。

(2) 提出的蚕茧视觉测量及定位算法,通过摄像机标定及取多个点求平均值方法,对蚕茧进行定位,定位准确,定位误差小于6.0 mm,可用于蚕茧采摘机械对蚕茧进行定点采摘。

(3) 随机选取 10张方格蔟,通过基于机器视觉的直角坐标式方格蔟自动采茧机对方格蔟中的蚕茧进行分割与定位试验,蚕茧分割检测正确率为96.88%,蚕茧位置坐标最大定位误差为6.0 mm,满足蚕茧采摘机械对蚕茧进行定位采摘的精度要求。

1陈超科. 方格蔟自动采茧机的研制[D]. 泰安:山东农业大学,2017.

2川名茂, 沈云岳. 全自动选茧机的开发[J]. 丝绸,1988(11): 44-45.

3蔡健荣,周小军,李玉良,等. 基于机器视觉自然场景下成熟柑橘识别[J]. 农业工程学报,2008, 24(1): 175-178.

CAI Jianrong, ZHOU Xiaojun, LI Yuliang, et al. Recognition of mature orange in natural scene based on machine vision[J]. Transactions of the CSAE, 2008, 24(1): 175-178.(in Chinese)

4金航峰. 基于光谱和高光谱图像技术的蚕茧品质无损检测研究[D]. 杭州:浙江大学,2013.

5宋亚杰,谢守勇,冉瑞龙. 机器视觉技术在蚕茧无损检测中的应用研究[J]. 现代农业装备,2006(9):48-51.

SONG Yajie, XIE Shouyong, RAN Ruilong. Applied research on machine vision technology in non-destructive test of cocoon [J]. Modern Agricultural Equipments, 2006(9): 48-51. (in Chinese)

6周志宇,刘喜昂,杨东鹤. 机器视觉在蚕茧表面积测量中的应用[J]. 纺织学报,2006, 27(12): 29-31.

ZHOU Zhiyu, LIU Xi’ang, YANG Donghe. Application of machine vision in measurement of cocoon superficial area[J]. Journal of Textile Research, 2006, 27(12): 29-31. (in Chinese)

7甘勇.基于图像处理技术的干茧茧壳厚度计算方法[J]. 丝绸,2006(11):46-48.

GAN Yong. Calculation method for shell thickness of dried cocoon based on image processing[J]. Journal of Silk, 2006(11): 46-48. (in Chinese)

8乔乐领. 基于图像处理的蚕茧自动计数系统的研究[D]. 杭州:浙江理工大学,2013.

9陈浩,杨峥,刘霞,等. 基于MATLAB的桑蚕茧选茧辅助检验方法的研究[J]. 丝绸,2016(3): 32-36.

CHEN Hao, YANG Zheng, LIU Xia, et al. Study on auxiliary testing method for mulberry silkworm cocoon sorting based on MATLAB[J]. Journal of Silk, 2016(3): 32-36. (in Chinese)

10马颂德,张正友. 计算机视觉——计算理论与算法基础[M]. 北京:科学出版社,1998:52.

11CHATTERJEE C, ROYCHOWDHURY V P. Algorithms for coplanar camera calibration[J]. Machine Vision and Applications, 2000, 12(2): 84-97.

12高瞻宇,顾营迎,刘宇航,等. 采用简化Brown模型及改进BFGS法的相机自标定[J]. 光学精密工程,2017, 25(9):2532-2540.

GAO Zhanyu, GU Yingying, LIU Yuhang,et al. Self-calibration based on simplified Brown non-linear camera model and modified BFGS algorithm[J]. Optics and Precision Engineering, 2017,25(9): 2532-2540. (in Chinese)

13XU D, LI Y F, TAN M. A method for calibration cameras with large distortion in lens[J]. Optical Engineering, 2006, 45(4): 0436021-0436028.

14吕朝辉,陈晓光,吴文福,等.基于双目立体视觉的秧苗直立度自动测定系统[J]. 农业机械学报,2002, 33(1): 60-62.

LÜ Chaohui, CHEN Xiaoguang, WU Wenfu, et al. Automatic measuring system of seeding perpendicularity based on bonocular stereo vision[J]. Transactions of the Chinese Society for Agricultural Machinery, 2002, 33(1): 60-62. (in Chinese)

15CONMANICIU D, MEER P. Mean shift: a robust approach toward feature space analysis[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(5): 603-619.

16胡炼,罗锡文,曾山,等. 基于机器视觉的株间机械除草装置的作物是别与定位方法[J]. 农业工程学报,2013,29(10): 12-18.

HU Lian, LUO Xiwen, ZENG Shan, et al. Plant recongnition and localization for intra-row mechanical weeding device based on machine vision[J]. Transactions of the CSAE, 2013, 29(10): 12-18. (in Chinese)

17丁为民,赵思琪,赵三秦,等. 基于机器视觉的果树树冠体积测量方法研究[J/OL]. 农业机械学报,2016, 47(6): 1-10. http:∥www.j-csam.org/jcsam/ch/reader/view_abstract.aspx?flag=1&file_no=20160601&journal_id=jcsam. DIO:10.6041/j.issn.1000-1298.2016.06.001.

DING Weimin, ZHAO Siqi, ZHAO Sanqin, et all. Measurement methods of fruit tree canopy volume based on machine vision[J/OL]. Transactions of the Chinese Society for Agricultural Machinery, 2016, 47(6): 1-10. (in Chinese)

18MARAGOS P. Differential morphology and image processing[J]. IEEE Transactions on Image Processing, 1996, 5(6): 922-937.

19李冠林,马占鸿,王海光. 基于支持向量机的小麦条锈病和叶锈病图像识别[J]. 中国农业大学学报,2012,17(2): 72-79.

LI Guanlin, MA Zhanhong, WANG Haiguang. Image recognition of wheat stripe rust and wheat leaf rust based on support vector machine[J]. Journal of China Agricultural University, 2012,17(2): 72-79. (in Chinese)

20宋宇,刘永博,刘路,等. 基于机器视觉的玉米根茎导航基准线提取方法[J/OL]. 农业机械学报,2017,48(2): 38-44.http:∥www.j-csam.org/jcsam/ch/reader/view_abstract.aspx?flag=1&file_no=20170205&journal_id=jcsam. DOI:10.6041/j.issn.1000-1298.2017.02.005.

SONG Yu, LIU Yongbo, LIU Lu, et al. Extraction method of vavigation baseline of corn roots based on machine vision[J/OL]. Transactions of the Chinese Society for Agricultural Machinery, 2017, 48(2): 38-44. (in Chinese)

21GONZALEZ R C, WOODS R E. 数字图像处理[M]. 阮秋琦, 阮宇智,译. 2版. 北京: 电子工业出版社, 2003: 423-424.

22蒋焕煜,彭永石,申川,等. 基于双目立体视觉技术的成熟番茄识别与定位[J]. 农业工程学报,2008, 24(8): 279-283.

JIANG Huanyu, PENG Yongshi, SHEN Chuan, et al. Recognizing and locating ripe tomatoes based on binocular stereo vision technology[J]. Transactions of the CSAE, 2008, 24(8): 279-283. (in Chinese)

23沈宝国,陈树人,尹建军,等. 基于颜色特征的棉田绿色杂草图像识别方法[J]. 农业工程学报,2009, 25(6): 163-167.

SHEN Baoguo, CHEN Shuren, YIN Jianjun, et al. Image recognition of green weeds in cotton fields based on color feature[J]. Transactions of the CSAE, 2009, 25(6): 163-167. (in Chinese)

24SUN Qiucheng,HOU Yueqian,TAN Qingchang. A new method of camera calibration based on segmentation model[J]. Optik, 2013, 124(24): 6991-6995.

25汤一平,王伟羊,朱威,等. 基于机器视觉的茶陇识别与采茶机导航方法[J/OL]. 农业机械学报,2016, 47(1): 45-50.http:∥www.j-csam.org/jcsam/ch/reader/view_abstract.aspx?flag=1&file_no=20160107&journal_id=jcsam. DOI:10.6041/j.issn.1000-1298.2016.01.007.

TANG Yiping, WANG Weiyang, ZHU Wei, et al. Tea ridge identification and navigation method for tea-plucking machine based on machine vision[J/OL]. Transactions of the Chinese Society for Agricultural Machinery, 2016, 47(1): 45-50. (in Chinese)

26王跃勇,于海业,刘媛媛. 基于双目立体视觉的机械手移栽穴盘定位方法[J]. 农业工程学报,2016, 32(5): 43-49.

WANG Yueyong, YU Haiye, LIU Yuanyuan. Mechanical transplanting plug tray localization method based on binocular stereo vision[J]. Transactions of the CSAE, 2016, 32(5): 43-49. (in Chinese)

27尹建军,沈宝国,陈树人,等. 基于机器视觉的田间杂草定位技术[J]. 农业机械学报, 2010,41(6): 163-166.

YIN Jianjun, SHEN Baoguo, CHEN Shuren, et al. Position technology of filed weed based on machine vision[J]. Transactions of the Chinese Society for Agricultural Machinery, 2010, 41(6): 163-166. (in Chinese)

28黄福珍,苏剑波. 人脸检测[M]. 上海:上海交通大学出版社,2006:12.