基于word embedding和CNN的维吾尔语情感分类

艾力·海如拉 吾守尔·斯拉木

摘 要:基于卷积神经网络(CNN)情感分类模型中引入Word embedding语义特征来解决维吾尔语文本情感分类问题。首先,从大量生语料中利用Skip-Gram模型训练出能够表现出句型和词义特征,然后将文本中的每个词跟特征向量组合取出作为卷积神经网络的输入;此外,对不同维度的Word embedding 进行迭代训练获取情感特性参数。其次,跟卷积神经网络模型和引入Word embedding特征向量神经网络模型进行比较。所提出的基于word embedding和CNN的维吾尔文情感分类模型成功将分类正确率提升了5.3%。

关键词: 卷积神经网络; 词嵌入;深度学习; 情感分类;

中图分类号:TP391 文献标识码:A 文章编号:1009-3044(2018)10-0180-02

Abstract:The semantic feature of Word embedding is introduced into the classification model of the convolution neural network (CNN) to solve the problem of the Uyghur text sentiment classification. First of all, using the Skip-Gram model trained to show the patterns and semantic features from a large number of students in the corpus, and then the text in each word with the feature vector combination is selected as convolutional neural network input; in addition, on different dimensions of Word embedding iterative training obtain parameters of emotion. Secondly, it is compared with the convolution neural network model and the Word embedding eigenvector neural network model. The Uyghur sentiment classification model based on CNN and word embedding will enhance the success rate of correct classification 5.3%.

Key words:convolutional neural network; word embedding; deep learning; sentiment classification;

1 引言

隨着互联网日益普及,越来越多的人在社交网络和电子商务者评论网站上发表他们自制内容或主观评价网上内容和商品。自制内容能否吸引更多读者,在线购物产品是否被欢迎都取之于参与者和使用时主观评价来确定。问题在于,这种自以为是的评论的维吾尔语文本语料数量可能会达到成千上万,而目前维吾尔文自然语言处理以及应用方面还没具备总结所有评论中表达的情感所需的能力。这里需要一个情感分析系统,它可以读取大量这样的评论并进行有意义的总结。目前研究学者已经对维吾尔语情感分类做出了一些分析与研究,使用的方法主要包括词典规则法和传统机器学习算法。

2 相关工作

2.1 Word embedding

Word embedding是自然语言处理中一组语言模型和特征学习技术的总称。一个典型的词向量表示法是One-hot Representation,One-hot Representation是传统的普遍使用的文本表示方法,这种方法首先创建一个词表,文本中出现的每一个词对应一个索引号,然后根据词是否在文本中出现,将索引号对应的值设为1或者0,这样一条句子对应一个向量,向量的长度是文本中出现的所有词的数目,这会导致向量的维度异常的大,可能引起维数灾难,这样很难推出词与词之间的语义关系。因此,Hinton推出一个word embedding的低位空间词向量表示法。将词分布式的映射低位空间中,解决向量稀疏问题同时很好地反映词和次之间的语义层次联系。Mikolov 等人利用Skip-gram 模型快速高效的训练出word embedding。Skip-gram模型根据当前词来预测上下文。

2.2 卷积神经网络(CNN)

卷积神经网络(Convolutional Neural Networks, CNN),是一种前馈神经网络。研究者们使用CNN在图像处理、语音识别等领域取得了令人瞩目的成就,比如,谷歌的GoogleNet、微软的ResNet等。近年来,有越来越多的NLP应用也开始尝试用CNN来解决。CNN主要包括卷积层和池化层,卷积层由许多神经元组成,用来特征提取,神经元之间互相共享权值,这使得参数数量大大减少,模型更加容易训练。池化层主要时对特征进行筛选,用来降低特征维度。图1为一个卷积模型的示意图,实际应用中,根据需要可以增减层数。

3 模型

基于word embedding 和CNN的情感分类模型中卷积层描述输入情感文本特征,pooling层提取出文本中具有情感特性的词特征。通常文本中的部分词或短语的情感特征会影响整个文本情感类别,因此通过此相似度加上CNN卷积特征提出任务会解决传统情感分类方法特征提取能力有限困难。

3.1 模型的输入处理

卷积神经网络在图像处理,语音识别等领域成就优先,处理时二维数据组成图像数据,因此,文本数据处理的第一部是将文本数据组合成二维数据矩阵的形式输入模型进行处理。数据集中最长数据长度为s,第i个词对应word embedding 是ai∈Rd 。卷积神经网络的输入矩阵是由s个d维向量的两位数据矩阵S。

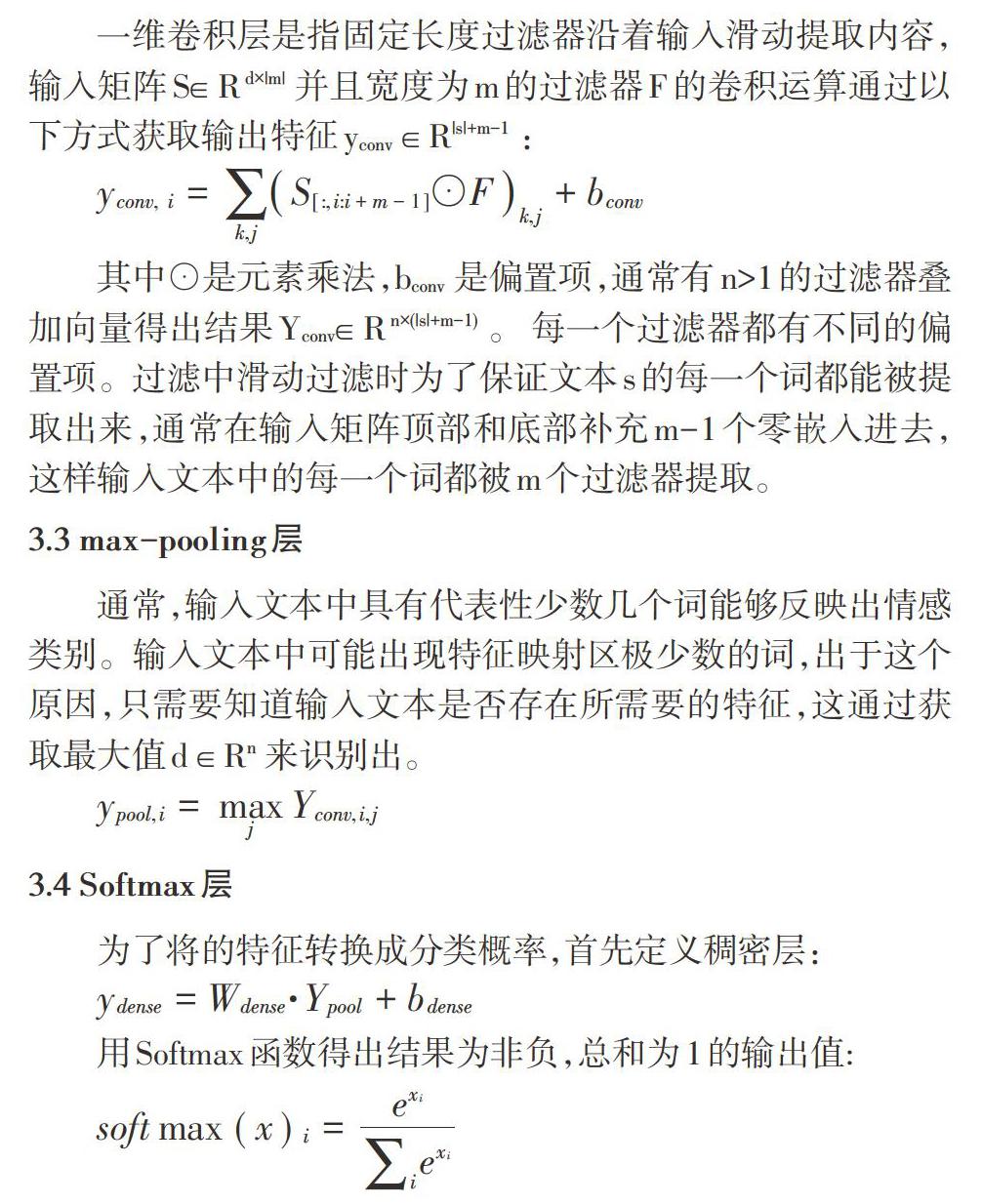

3.2 一维卷积层

一维卷积层是指固定长度过滤器沿着输入滑动提取内容,输入矩阵S∈ R d×|m| 并且宽度为m的过滤器F的卷积运算通过以下方式获取输出特征yconv ∈ R|s|+m?1 :

[yconv, i=k,jS[:,i:i+m-1]⊙Fk,j+bconv]

其中⊙是元素乘法,bconv 是偏置项,通常有n>1的过滤器叠加向量得出结果Yconv∈ R n×(|s|+m?1) 。 每一个过滤器都有不同的偏置項。过滤中滑动过滤时为了保证文本s的每一个词都能被提取出来,通常在输入矩阵顶部和底部补充m-1个零嵌入进去,这样输入文本中的每一个词都被m个过滤器提取。

3.3 max-pooling层

通常,输入文本中具有代表性少数几个词能够反映出情感类别。输入文本中可能出现特征映射区极少数的词,出于这个原因,只需要知道输入文本是否存在所需要的特征,这通过获取最大值d ∈ Rn 来识别出。

[ypool,i=maxjYconv,i,j]

3.4 Softmax层

为了将的特征转换成分类概率,首先定义稠密层:

[ydense=Wdense·Ypool+bdense]

用Softmax函数得出结果为非负,总和为1的输出值:

[softmax(x)i=exiiexi]

3.5 规范模型

卷积神经网络的训练方法采用梯度下降算法,梯度下降算法能够找到最优解。全连接层的训练过程中引入dropout策略,每次迭代过程中放弃一部分训练好的参数。直觉上,虽然放弃已训练好的参数仍然可以获取合理的分类。为此,使训练和测试具有相同的顺序,用Bernoulli 分布B(p)将每个维随机设置0,这样测试输出可以按比例缩放。

4 实验过程,结果及分析

训练 word embedding,共准备了334.3MB不同领域的无标注信息的维吾尔文生语料,利用 mikolov 等人提出的 Skip-gram模型训练 word embedding,word2vec工具实现,训练总单词数为21378723,503121个不重复单词的语料中选择频率大于等于5的123203单词分别训练维度为50,100,150,200和300的词向量。将word embedding 结合CNN模型,针对性的优化CNN在情感分类任务上的性能,试验结果如表所示:

相比于没加词向量模型,本文所提出的cnn+word embedding模型情感分类实验性能提升5.3%。一方面,word embedding 能够在更抽象的层面上描述输入数据的语义特征分布情况,人工特征提取方式很难完成此项任务。另一方面,模型训练是迭代训练过程,迭代中找出最佳特征,引导模型更好的方向并收敛到最优解。词向量维度方面,词向量的维度300时模型分类性能最佳。为了精确地反应低维空间下每个词的语义分布情况应该尽可能的高,这需要更大规模分布均匀语料训练词向量。但更高维度的词向量增加卷积神经网络模型参数,从而增加拟合而下降模型健壮性。因此,分领域生成词向量更明确的提高词义相似度,从而提高分类任务正确性。

5 结论

本文描述利用深度学习解决维吾尔语情感分类问题,设计词向量集合CNN模型和没结合的两种实验,结果表明,CNN 模型加上词向量模型实现了情感分类的性能提升,并未维吾尔语情感分类系统奠定了良好的基础。

参考文献:

[1] 朱俭. 文本情感分析关键技术研究[M]. 中国社会科学出版社,2015.

[2] Kim Y. Convolutional Neural Networks for Sentence Classification[J]. Proceedings of Ijcnlp, 2005.

[3] Irsoy O, Cardie C. Opinion Mining with Deep Recurrent Neural Networks [C]. Conference on Empirical Methods in Natural Language Processing. 2014:720-728.

[4] Chunqi Wang, Bo Xu . Convolutional Neural Network with Word Embeddings for Chinese Word Segmentation要 [D]. Coling, 2016.

[5] 江蛟,江常. 基语语分析评价对象-情感词抽取[R]. 计算机学报,2017,40(3):617-633.

[6] Tai K S, Socher R, Manning C D. Improved Semantic Representations From Tree-Structured Long Short-Term Memory Networks[J]. Computer Science, 2015, 5(1): 30-36.

[7] 亚森·伊斯马伊力,吐尔根·依布拉音,卡哈尔江·阿比的热西提.基于用户关系的维吾尔文微博.