图像描述生成方法研究文献综述

张姣 杨振宇

摘 要:随着人工智能技术的兴起,图像特征提取技术和文本自动生成技术都得到了长足的进步,将两者结合的图像描述生成技术也越来越受到学术界和工业界的重视。图像到文本生成是一个综合性问题,涉及自然语言处理和计算机视觉等领域。本文介绍了图像描述生成技术的研究背景及国内外研究现状,概述了目前研究者评估生成图像描述质量的图像数据集,对现有模型进行了详细的分类概括:基于模板的图像描述生成方法、基于检索的图像描述生成方法、基于深度学习的图像描述生成方法。与此同时一并总结阐述了该领域面临的问题和挑战。

关键词: 图像描述;文本生成;特征提取;计算机视觉

【Abstract】 Image caption generation technology is used in many fields such as news communication, smart transportation, smart home and smart medical. Therefore, this technology has important academic and practical value. Image-to-text generation is a comprehensive problem involving areas such as natural language processing and computer vision. This paper introduces the research background of image caption generation technology and the research status at home and abroad, and summarizes the current image datasets that researchers evaluate to generate quality of the image caption. The existing models are classified and summarized in detail: template-based image caption generation method, retrieval-based image caption generation method and deep-learning-based image caption generation method. It also summarizes the problems and challenges which the field is facing.

【Key words】 image caption; text generation; feature extraction; computer vision

0 引 言

0.1 研究背景

大数据时代的到来使人工智能產品不断进入人们的视野。图像描述生成技术的产生为计算机从图像中快速获取信息带来了新的发展和应用前景。

图像描述生成技术与图像语义分析、图像标注和图像高级语义提取等技术紧密相关。图像描述生成技术是计算机自动为图像生成一个完整、通顺的描述语句。大数据背景下的图像描述生成技术在商业领域有着广泛的应用。如购物软件中用户输入关键字快速地搜索出符合要求的商品;用户在搜索引擎中进行的图片搜索;视频中多事物目标的识别、医学图像专业的自动语义标注以及自动驾驶中目标物体的识别等。如何在计算机中更有效、准确、快速地实现这一过程即是本文的研发课题。

从图像描述生成的发展过程[1]来看,可以分为3个主要发展阶段:基于模板的图像描述生成方法;基于检索的图像描述生成方法;基于深度学习的图像描述生成方法。

0.2 国内外研究现状

结合国内外研究人员对图像描述生成方法的研究以及各个阶段所采用的不同关键技术,可将图像描述的方法分为3类。对此可做分析阐述如下。

(1)基于模板的图像描述生成方法。该方法[2]利用图像标注技术为物体、物体场景以及组成部分进行标注[3]。选择与图像内容描述场景相关的句子作为表达模板,将提取的图像特征填入模板,继而得到图像的描述句子。概率图模型方法[4]对文本信息和图像信息建立模型,可从文本数据集中挑选合适的关键词,将其作为体现图像描述内容的关键词,利用语言模型技术[5-7]将选取的内容关键词组合为合乎语法规则习惯的英文句子。该方法的研究虽然能够描述图像内容,但是在一定程度上限制了描述语句的多样性,使生成的描述不够灵活、新颖。

(2)基于检索的图像描述生成方法。该方法探寻文本与图像之间的关联[8-9],把文本和图像映射到一个共同语义空间。结合相似度[10-11]的计算方法,对图像内容和文本意义的关系程度进行排名,检索出和测试图像关系最接近的文本作为测试图像的最终文本描述。该方法把生成图像描述看作是一种检索任务,但检索前都需要调整和泛化过程,这无疑给描述任务又增加了处理过程和复杂度。

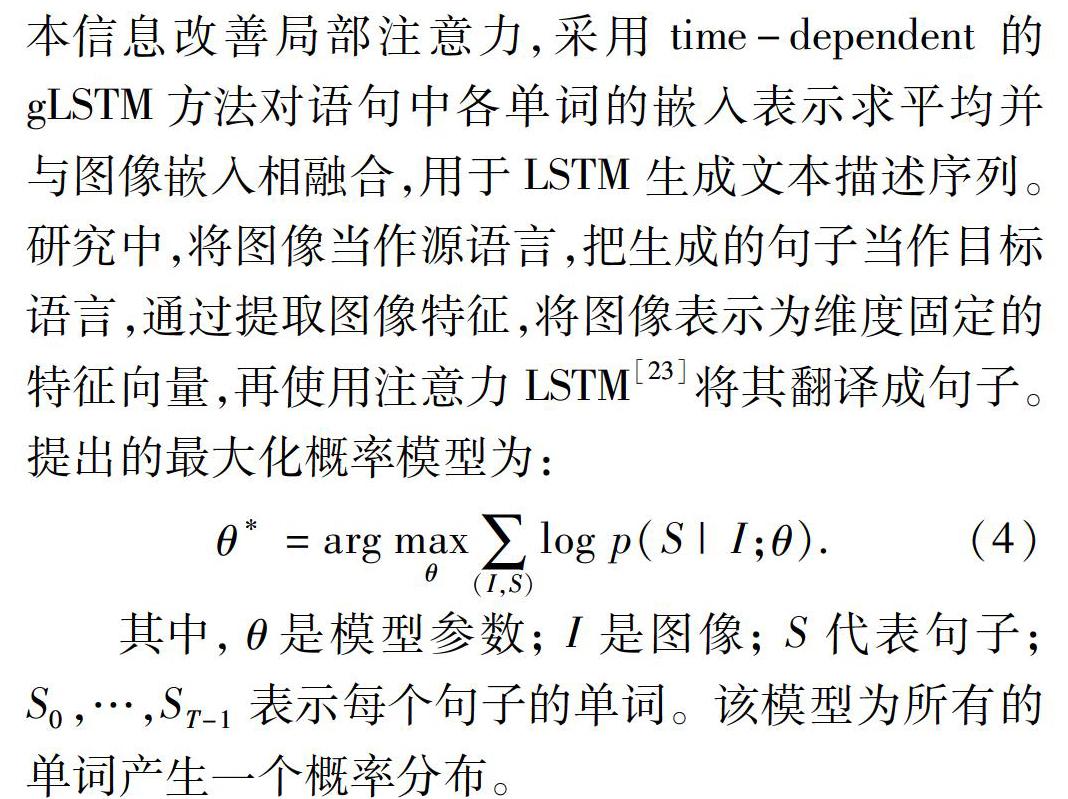

(3)基于深度学习的图像描述生成方法。目前主流的深度学习模型是端到端的训练方法。一方面采用多层深度卷积神经网络技术对图像中的物体特征概念建立模型;另一方面采用循环神经网络对文本建立模型。运用循环神经网络[12-15]进行建模,将文本信息与图像信息映射在同一个循环神经网络中,利用图像信息指导文本句子的生成。随着深度学习的研究进展,基于注意力机制和强化学习改进的研究方法[16-20]相继涌现,并不断推动图像描述生成模型的发展。该方法没有任何模板、规则的约束,能自动推断出测试图像和其相应的文本,自动地从大量的训练集中去学习图像和文本信息,生成更灵活、更新颖的文本描述,还能描述从未见过的图像内容特征。

1 數据集

大量免费公开的数据集用于图像描述研究,这些数据集中的图像与文本描述相关联,某些方面彼此不同,例如大小、描述的格式和描述词的长短。多种数据集信息汇总见表1。

表1中,Flickr8K数据集及其扩展版本Flickr30K数据集包含来自Flickr的图像,分别包含约8 000和30 000幅图像。这2个数据集中的图像是针对特定对象和动作的。这些数据集包含5个描述句子,每个图像是工作人员采用类似于Pascal1K数据集的策略收集的。

MSCOCO数据集包括123 287幅图像,每幅图像均可给出5个不同的描述。此数据集中的图像包括80个对象类别,所有图像都可以使用这些类别中的所有实例。该数据集已被广泛用于图像描述,目前有研究者正在开发MSCOCO的扩展,包括增加问题和答案。

Flickr30K和MSCOCO数据集举例如图1所示。

基于强化学习的研究方法是近期智能控制领域应用最广的方法。Liu等人提出的基于强化学习的策略梯度的图像描述方法,根据值函数对策略进行改进,选取最优策略。经过实验证明该方法生成的描述质量优于传统方法。深度强化学习[24-26]的融合极大地推动了图像描述生成的效果。将强化学习的奖惩机制[27]引入图像字幕任务中,可以通过抽取字幕来优化句子级评价标准,利用“策略网络”和“价值网络”[28]来共同预测每个时间步中的下一个单词。

基于深度学习的图像描述生成的主流是端到端的训练方法,生成的描述语句具有多样性,不依赖于单一的语言模板。不仅结构清晰明确、容易理解,而且训练速度和生成效果相当突出。

3 图像描述的挑战与难点

图像描述生成技术的研究经历了多个发展阶段并渐趋成熟,而且也已取得突破性的进步。深度学习技术的发展为图像描述领域打开一个新的局面。虽然图像描述生成技术表现出了强大的研发能力,但仍存在一定问题亟待解决,对此可做分述如下。

(1)描述文本信息的不完整。视觉特征的提取是生成图像文本描述的重要基础,包括图像类别、场景、对象及对象关系等。这些都依赖于目前还不成熟的计算机视觉技术。所以图像的视觉特征提取关键技术的提高是有待解决的关键问题和难点。

(2)复杂图像关注点的选取。图像中常存在多义和不确定的事物、隐式和显式的信息,如何充分利用图像特征和文本信息的融合特征,有效进行图像关注点的选取是图像描述中仍待解决的关键问题和难点。

(3)图像描述的泛化能力较低。从以往的研究中可以看出,对于同一个图像数据集中的图片进行测试时,效果往往是令人满意的。但是当采用随机的图片进行测试时,效果并不尽如人意。所以图像描述的泛化能力的提高是尚待解决的难题。

4 结束语

图像描述生成技术已广泛应用于新闻传播、智慧交通、智能家居、智能医疗等众多领域,现已成为各大顶尖科研机构综合研究实力的较量方式之一。

本文简述了图像描述生成任务的研究背景以及国内外研究现状;讨论了基于模板的图像描述生成方法、基于检索的图像描述生成方法和基于深度学习的图像描述生成方法。综前论述可以发现,图像描述生成技术正在向着更复杂、更灵活、更智能的方向发展。

针对图像描述面临的挑战与问题,未来可考虑结合更复杂的多任务或注意力机制,充分融合图像特征和语言特征向量。在图像描述文本信息不完整的问题上可考虑3D建模的方式对原2D数据进行映射处理,图像描述技术还可融入深度强化学习,使用无监督自主学习模型,在减少耗费资源的情况下,提升图像描述的性能。

参考文献

[1]HELMUT H. Building natural language generation systems[J]. Artificial Intelligence in Medicine,2001,22(3):277-280.

[2]YAO B Z, YANG Xiong, LIN Liang, et al. Image2text: Image parsing to text description[J]. Proceedings of the IEEE,2010,98(8): 1485-1508.

[3]郭乔进,丁轶,李宁. 基于关键词的图像标注综述[J].计算机工程与应用,2011,47(30):155-158.

[4]FENG Yansong, LAPATA M. How many words is a picture worth? Automatic caption generation for news images [C]//Proceedings of the 48th Annual Meeting of the Association for Computational Linguistics. Uppsala, Sweden:ACL, 2010: 1239-1249.

[5]康莹莹.新闻图像内容与字幕文本协同识别与检索方法研究[D].哈尔滨:哈尔滨工业大学,2012.

[6]LIT L, PELICAN E. A low-rank tensor-based algorithm for face recognition[J]. Applied Mathematical Modelling, 2015, 39(3):1266-1274.

[7]KULKARNI G, PREMRAJ V, DHAR S, et al. Babytalk: Understanding and generating simple image descriptions[C]//2011 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Colorado Springs, Co, USA:IEEE,2011,35(12):1601-1608.

[8]MITCHELL M, HAN Xufeng, DODGE J, et al. Midge: Generating image descriptions from computer vision detections [C]//Proceedings of the 13th Conference of the European Chapter of the Association for Computational Linguistics. Avignon,France:ACL, 2012:747-756.

[9]ELLIOTT D, KELLER F. Image description using visual dependency representations [C]//Proceedings of the 2013 Conference on Empirical Methods in Natural Language Processing. Seattle, Washington, USA:ACL, 2013:1292-1302.

[10]HODOSH M, YOUNG P, HOCKENMAIER J. Framing image description as a ranking task: Data, models and evaluation metrics [J]. Journal of Artificial Intelligence Research, 2013,47(1): 853-899.

[11]KARPATHY A, LI Feifei.Deep visual-semantic alignments for generating image descriptions [C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston, MA, USA:IEEE,2015:3128-3137.

[12]SOCHER R, KARPATHY A, LE Q V,et al. Grounded compositional semantics for finding and describing images with sentences[J]. Transactions of the Association for Computational Linguistics (TACL) , 2014,2:207-218.

[13]CHEN X, ZITNICK C L. Minds eye: A recurrent visual representation for image caption generation [C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston,MA, USA:IEEE, 2015:2422-2431.

[14]MAO Junhua, XU Wei, YANG Yi, et al. Deep captioning with multimodal recurrent neural networks (m-RNN)[J]. arXiv preprint arXiv:1412.6632, 2014.

[15]XU Hongteng, WANG Wenlin, LIU Wei, et al. Distilled Wasserstein learning for word embedding and topic modeling [C]// 32nd Conference on Neural Information Processing Systems (NIPS) 31. Montréal, Canada:[s.n.], 2018:1-10.

[16]XU K, BA J, KIROS R, et al. Show, attend and tell: Neural image caption generation with visual attention[C]//32nd International Conference on Machine Learning. Lille, France:dblp,2015:2048-2057.

[17]陳强普.面向图像描述的深度神经网络模型研究[D].重庆:重庆大学,2017.

[18]申永飞. 图像描述文本自动生成方法研究[D].重庆:重庆大学,2017.

[19]陈龙杰,张钰,张玉梅,等.基于多注意力多尺度特征融合的图像描述生成算法[J].计算机应用,2017,39(2):354-359.

[20]陈晨.基于深度学习及知识挖掘的零样本图像分类[D].北京:中国矿业大学,2016.

[21]SILVER D, HUANG A, MADDISON C J, et al. Mastering the game of Go with deep neural networks and tree search[J].Nature,2016,529(7587):484-489.

[22]XU K, BA J, COURVILLE R, et al. Show, attend and tell: Neural image caption generation with visual attention[J]. arXiv preprint arXiv:1502.03044v1,2015.

[23]VINYALS O, TOSHEV A, BENGIO S, et al. Show and tell: A neural image caption generator[C]//IEEE Conference on Computer Vision and Pattern Recognition(CVPR),Boston, MA, USA:IEEE,2015,1: 3156-3164.

[24]LEIBFRIED F, TUTUNOV R, VRANCX P, et al. Model-based stabilisation of deep reinforcement learning[J]. arXiv preprint arXiv:1809.01906v1,2018.

[25]WANG Pin, CHAN C Y, LI Hanhan. Maneuver control based on reinforcement learning for automated vehicles in an interactive environment[J].arXiv preprint arXiv:1803.09200,2018.

[26]WANG Jing, FU Jianlong, TANG Jinhui, et al. Show, reward and tell: Automatic generation of narrative paragraph from photo stream by adversarial training[C]// Proceedings of the Thirty-Second AAAI Conference on Artificial Intelligence. New Orleans,Louisiana,USA:AAAI,2018:7396-7403.

[27]LIU Xihui, LI Hongsheng, SHAO Jing, et al. Show, tell and discriminate: Image captioning by self-retrieval with partially Labeled data[M]//FERRARI V, HEBERT M, SMININCHISESCU C, et al. Computer Vision-ECCV 2018. Lecture Notes in Computer Science. Cham:Springer, 2018,11219:353-369.

[28]REN Zhou, WANG Xiaoyu, ZHANG Ning, et al. Deep reinforcement learning-based image captioning with embedding reward[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Honolulu, HI, USA:IEEE,2017:1151-1159.