基于Multi-TWE模型的短文本分类研究

王云云 张云华

摘要:针对目前词向量无法解决短文本中一词多义的问题,提出融合词向量和BTM主题模型的Multi-TWE多维主题词向量模型。将BTM模型训练得到目标词与相应主题进行不同方式的连接,形成多维主题词向量来表示多义词词义,最后将Multi-TWE模型应用于短文本分类,提出基于Multi-TWE模型的短文本分类方法,与SVM、BTM和Word2Vec分类方法进行对比实验,实验结果表明本文提出的短文本分类方法在平均F1值上比前三种方法分别提升了3.54%、11.41%和2.86%。

关键词: 短文本分类; 一词多义; BTM主题模型; 词向量

【Abstract】 Aiming at the current problem that word vectors cannot solve the problem of polysemy in short texts, a Multi-TWE multi-dimensional topic word vector model combining word vectors and BTM topic models is proposed. The BTM model is trained to connect the target word with the corresponding topic in different ways to form a multi-dimensional topic word vector to represent the meaning of the polysemous word. Finally, the Multi-TWE model is applied to short text classification, and a short text classification method based on the Multi-TWE model is proposed. Compared with the SVM, BTM, and Word2Vec classification methods, the experimental results show that the short text classification method proposed in this paper improves the average F1 value by 3.54%, 11.41%, and 2.86% compared with the previous three methods, respectively.

【Key words】 short text classification; polysemy; BTM topic model; word vector

0 引 言

短文本是人们生活信息口语化在互联网上的体现。顾名思义,短文本字数少、篇幅小,导致在分析短文本时,很难准确地分析出短文本的语义信息,并且有不少的词语具有多种词义和词性,会根据不同的使用场景表达出不同的语义[1],这更加剧了短文本分析的难度。

2013年,Mikolov等人[2]提出的word2vec模型,利用上下文语义关系将词语映射到一个低维稠密的空间,使相似词语在空间中的距离相近,通过空间位置获得对应的词向量表示[3]。Zhu等人[4]在使用词向量来表示文本向量的基础上,融合了改进的TF-IDF算法,并利用SVM分类器进行短文本分类。Yao等人[5]使用词向量来表示新闻标题类短文本,并通过判断语义相似度来扩展文档表示。以上研究表明词向量模型应用在文本表示上的可行性。在使用词向量进行词义消歧方面,Niu等人[6]融合了知网的义原信息和注意力机制,实现自动地根据上下文选取合适的词语词义的方法,在判断语义相似度和词义消歧方面取得了更好的效果。Liu等人[7]提出将词向量与主题模型相结合,组成主题向量用于词语消歧。曾琦等人[8]提出了一种将多义词的不同语义用不同主题来表示,最后训练多义词词向量。深度学习方法中利用词向量训练的便捷性与主题模型能挖掘主题语义的这一能力相结合,既能保证准确率又能降低邻域依赖。本文利用这一复合方法进行一词多义的研究。

1 相关工作

1.1 BTM主题模型

由于传统的主题模型是获取文檔级别的词共现[9],短文本的数据稀疏性导致传统主题模型效果不好。针对这一问题,Yan等人[10]提出了BTM主题模型,来进行短文本建模。BTM通过语料级别的词共现来为短文本建模。设有语料库L,语料库L中有一个二元词组集合|B|,表示语料中所有的词对,图模型如图1所示。

图1中,b=(bi,bj)表示其中的任一词对,bi,bj分别表示词对中的词语,z表示词语的主题,K表示主题数目,z∈[1,K],θ表示每篇文档的主题分布,φ表示不同主题下的词分布,两者皆服从狄利克雷分布。α和β分别是两者的先验参数。

2 基于Multi-TWE模型的短文本分类研究

传统词向量模型无法很好地处理汉语中存在的一词多义问题,主要是因为词向量模型对于多义词中各种语义信息的处理不敏感,训练出的单一词向量容易混淆多义词的含义。2015年,Liu等人[7]提出了主题词向量的概念,即将主题融入到基本的词向量表示中,并允许由此产生的主题词向量在不同语境下获得一个词的不同含义。

根据上述思想,本文将主题词向量的概念应用到短文本语义挖掘中,本文的算法使用基于义原信息和注意力机制的SE-WRL词向量模型来训练词向量,该模型使用注意力机制在一定程度上能够消除多义词的影响,但由于短文本本身具有的上下文特征稀疏性,SE-WRL词向量模型在短文本上的应用效果有限。因为BTM主题模型能够有效地解决短文本的特征稀疏的问题,因而,本文引入了BTM主题模型来进行短文本的语义挖掘,提出了一种Multi-TWE多维主题词向量算法。

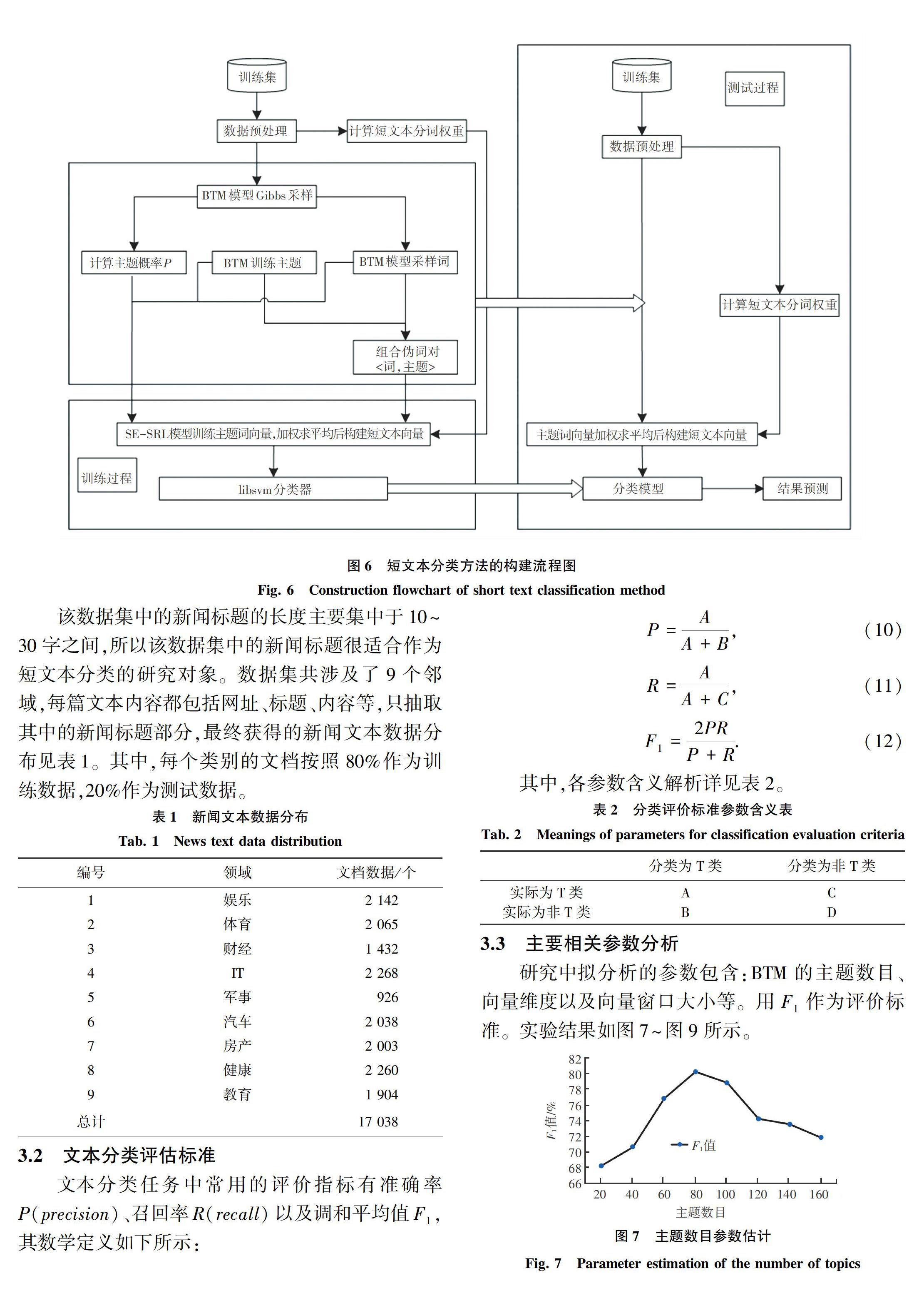

首先对于处理好的短文本语料进行BTM主题模型初始化,通过吉布斯采样过程获取词和主题,利用SE-WRL词向量模型分别进行向量的训练,得到不同的主题词向量,达到词义消歧的效果,实现文本分类。该算法框架包含MuTWE-1和MuTWE-2这两种主题词向量模型,接下来将具体分析MuTWE-1和MuTWE-2这两个模型算法。

2.1 MuTWE-1主题词向量模型算法

MuTWE-1模型算法具体的参数推理分为2步,分别是:BTM模型參数推理和MuTWE-1主题词向量训练,具体算法流程如图4所示。首先对BTM主题模型进行参数推理,这里通过使用吉布斯采样方法抽取词对b和每个词对相对应的主题z,[JP2]然后将词对b和主题词z组合成伪词(b,z),融入SE-WRL训练模型中,最后得到主题词向量W(b,z)。

分析图7~图9后得出:

(1)由图7得出当主题数在80时F1值取最大值。

(2)由图8得出词向量维度在100~160左右最有利,为了平衡各模型,最终将向量维度设置为150,主题词向量的维度设置为300。

(3)由图9看出,当窗口大小为大于10 时,窗口长度的增长对于F1值的增长并没有什么帮助,所以将实验的最佳向量窗口大小设置为10。

3.4 分类对比实验

为了验证本文提出的基于Multi-TWE算法模型的短文本分类方法的有效性,分别选取VSM模型、BTM主题模型和TF-IDF加权word2vec模型作为对比实验。所有分类方法选用libsvm作为分类器。实验采用五折交叉验证来评估各模型分类效果,测试结果见表3。

4 结束语

针对一词多义问题,本文提出了融合词向量和BTM主题模型的Multi-TWE多维主题词向量模型算法并将其应用于短文本分类任务中。再通过实验对模型中的参数进行了分析,确定了最佳的参数值,最后通过与几种基准分类方法进行对比实验,证明了本文提出的短文本分类方法的有效性和可行性。

参考文献

[1] 张俊. 基于人类认知过程的文本语义理解模型(HTSC)及构建方法研究[D]. 上海:上海大学,2016.

[2]MIKOLOV T, CHEN K, CORRADO G, et al. Efficient estimation of word representations in Vector Space[C]//Proceedings of the International Conference on Learning Representations (ICLR 2013). Scottsdale, AZ: dblp,2013: 1.

[3]汪静. 基于词向量的中文短文本分类问题研究[D]. 武汉:中南民族大学,2018.

[4]ZHU Lei, WANG Guijun, ZOU Xxiaocun. A study of Chinese document representation and classification with Word2vec[C]// 2016 9th International Symposium on Computational Intelligence and Design (ISCID). Hangzhou, China:IEEE, 2016:298.

[5]YAO Di , BI Jingping , HUANG Jianhui, et al. A word distributed representation based framework for large-scale short text classification[C]// 2015 International Joint Conference on Neural Networks (IJCNN). Killarney, Ireland :IEEE, 2015:1.

[6]NIU Y, XIE R, LIU Z, et al. Improved word representation learning with sememes[C]//Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). 2017, 1: 2049.

[7]LIU Y, LIU Z,CHUA T S,et al.Topical word embeddings[C]//Twenty-Ninth AAAI Conference on Artificial Intelligence.Austin, Texas: AAAI Press,2015:2418.

[8] 曾琦,周刚,兰明敬,等. 一种多义词词向量计算方法[J]. 小型微型计算机系统,2016,37(7):1417.

[9]刘良选. 融合文本内部特征与外部信息的主题模型研究[D]. 海口:海南大学, 2016.

[10]YAN X, GUO J, LAN Y, et al. A biterm topic model for short texts[C]//Proceedings of the 22nd International Conference on World Wide Web. New York,USA:ACM, 2013: 1445.