一种深度强化学习的C-RAN动态资源分配方法

张 永 棠

1(广东东软学院 计算机学院,广东 佛山 528225) 2(南昌工程学院 江西省协同感知与先进计算技术研究所,南昌 330003)

1 引 言

5G网络旨在支持人、机器和服务之间的大规模连接.随着5G的逐步推广和应用,无线接入网(Radio access networks,RAN)需要一个智能灵活的架构来充分利用5G网络的性能.云无线接入网络(Cloud radio access networks,C-RAN)被认为是5G的核心技术,它使5G服务具有前所未有的最小时延和能耗[1].与传统的RAN不同,C-RAN设计有独立的基带单元(Baseband units,BBU)和远程无线电前端(Remote radio heads,RRH).所有处理器都被移动到中央BBU池中,分布式RRHs负责通过前端链路将用户接收到的无线电信号转发到BBU.RRHs只需要维护一些基本的传输功能,大大降低了设计和运行成本,实现大规模高密度组网.

云计算已经变得非常流行,可以访问共享计算资源池[2,3].然而,云计算服务可能不能保证网络中的低延迟应用程序,因为云与终端设备之间的距离通常很大.为了解决这些问题,文献[4]研究了移动边缘计算(Mobile edge computing,MEC),将计算资源部署到更靠近终端的位置,可以有效提高需要密集计算、低延时的应用的服务质量(QoS)[5].因此,以计算卸载和资源分配为核心的MEC系统得到了广泛的关注[6].

近年来,研究者们针对不同的设计目标提出了一些关于MEC卸载和资源分配的观点[7].针对无线通信中数据速率的非恒定性,文献[8]提出了一种基于流优化的凸优化二进制计算方法.文献[9]从物理资源和时间两个维度分析了C-RAN中通信和计算的交互作用,说明了BBU池中资源合理配置的重要性.然而,在文献[8,9]中提出的方法需要获取准确的信道状态信息.考虑到无线信道的随机性,这些问题不适用于动态系统.也有很多研究者利用博弈论在动态环境下提供分布式解决方案,文献[10]研究了基于博弈论的分布式计算卸载机制,可以准确地得到较低的系统模型.然而,这种假设在某些环境中往往是不切实际的.

众所周知,使用深度学习框架可以实现网络资源的自动管理.Q-learning算法是应用最广泛的无模型强化学习(Reinforcement learning,RL)算法,可用于计算卸载策略[11]和资源分配策略[12].随着计算复杂性随着状态和动作的数量呈指数增长,Q-learning的最大挑战是处理具有极端状态和动作的应用.因此,使用深度神经网络(Deep neural network,DNN)来估计RL中的值函数,从而得到更精确的回归或近似[13].使用DNN增强传统RL创建了一种有前途的方法,称为深度强化学习(Deep reinforcement learning,DRL),它能够处理复杂的控制应用,如游戏和机器人[14].

本文提出了一种基于DRL的C-RAN动态资源分配框架,在保证每个用户的需求得到满足的同时,最小化时间和能量消耗.本文的主要创新点:

1)提出了一个基于DRL的主题来解决计算、卸载和资源分配问题,其优点是用户计算任务的卸载是按比例完成的.

2)定义了DRL代理的行为、状态和奖励函数,制定了资源分配问题,并应用DNN近似行动决策的行动值函数,从当前状态直接提取信息,不需要获取准确的信道状态.仿真结果很好地证明了所提出的基于DRL的框架在低功耗和用户满意度方面的有效性.

2 系统模型

本节介绍了系统的网络模型,给出了系统的计算模型,提出了本文的优化目标.

2.1 网络模型

图1展示了具有边缘高速计算能力的C-RAN上行链路传输网络架构.计算单元中有一个RRH和U个用户,用户集表示为U={1,2,…,U}.我们假设MEC服务器部署在RRH上,RRH和用户都装备了一个天线.每个用户都有一个计算密集型的任务要完成.用户可以根据比例α∈[0,1]将任务转移到MEC服务器,剩余任务的1-α由用户在本地执行.

图1 系统模型Fig.1 System model

我们使用准静态假设,即环境条件在一个时间段内保持不变.一个小区中只有一个RRH,因此忽略了间隔干扰.假设在某一时刻有多个用户选择一个任务,则将无线带宽平均分配给该用户用于上行链路传输卸载任务.用户u可以达到的上行链路传输数据速率可表示为:

(1)

2.2 计算模型

我们假设用户u计算密集型任务Ru=(Du,Cu,Tu),它可以在用户本地CPU和MEC服务器上根据比例因子α执行.这里Du表示计算Ru所需的计算输入数据的大小,包括程序代码和输入参数.Cu表示完成计算任务Ru所需的CPU周期总数,Du与Cu的大小呈正相关.Cu反映完成任务Ru所需的计算资源数量.我们假设Du的大小是不变的,不管它是由用户本地执行还是在MEC服务器上执行.Tu表示任务Ru的最大允许延迟,即每个用户的服务时间不应超过Tu,这将是我们优化问题的一个重要约束.这3个参数都与应用程序的功能相关,可以通过任务配置文件进行估计,因此它们在不同类型的应用之间可能有很大的差异.

我们假设任务可以划分为在不同设备上处理的分区,这意味着每个用户任务可以同时在本地计算并卸载到RRH以执行其任务.我们将α∈[0,1]表示为用户u的计算任务决策,并将决策向量定义为A=[α1,α2,…,αU].如果用户u都通过本地计算执行任务,则α=1;所有这些都通过MEC计算任务,则α=0.否则,根据任务比率α将其卸载到MEC中,并在本地执行比率1-α.

1)本地计算模型:如果用户u选择在本地执行它的任务Ru,那么我们将Tu,l定义为用户u本地CPU的处理延迟.然后,我们将fu,l表示为用户u的计算能力(CPU周期/秒),这取决于用户之间的计算能力.任务Ru的本地执行延迟Tu,l为:

(2)

我们使用Eu,l作为任务Ru在本地执行时的对应能耗,表示为:

Eu,l=ZuCu

(3)

其中,Zu表示每个CPU周期所需的能耗,并且根据文献[15]实际测量值设置为Zu=10-25(fu,l)2.

结合式(2)和式(3),本地计算的总成本可以表示为:

(4)

2)卸载计算模型:用户u通过MEC选择执行任务Ru,整个计算过程分为以下几个步骤:首先,用户u需要通过无线网络向RRH上传足够的数据,RRH将数据转发给MEC服务器.然后MEC服务器分配计算资源来执行计算任务,最后MEC服务器将执行结果返回给用户u.

根据上述步骤,将计算卸载到MEC所需的传输时间可以表示为:

(5)

其中,ru表示无线信道中用户u的上行速率.上传数据的数据消耗为:

(6)

计算所需的时间是MEC服务器的处理延迟,可以表示为:

(7)

综上所述,MEC执行用户u任务Ru的处理延迟为:

(8)

结合式(8)和式(6)的时间及能耗成本,卸载到MEC计算的总成本可以表示为:

(9)

将整个系统MEC中所有用户的总成本汇总为:

(10)

其中,αu∈[0,1]表示用户u的卸载决定.用户任务按比例分割,1-α部分在本地执行,α部分卸载到MEC.

2.3 问题表述

本节将求解MEC系统的负荷决策和计算资源分配的最优化问题.我们的目的是将MEC系统中所有用户的执行延迟和能耗相结合的总成本最小化.

基于上述分析,在最大容忍延迟和计算能力的约束下,最优化问题可描述为:

(11)

其中,A=[α1,α2,…,αU]表示卸载决策向量,f=[f1,f2,…,fU]表示MEC上的计算资源分配策略.最优化问题的目标是使整个系统的总成本最小化.式(11)中,C1为计算任务卸载的百分比,C2为整个服务时间成本不应超过用户的最大允许延迟,C3表示确保为用户U分配的计算资源不能超过F,C4表示确保分配给用户的计算资源的总和不超过MEC服务器的最大计算容量F.

3 优化方案

上述最优决策问题可表示为一个动态的未知马尔可夫决策过程.由于当前估计的状态可能在以后的时间框架中发生变化,所以我们不能简单地使用当前观察到的状态对以后的时间框架做出决策.在有限状态马尔可夫信道模型中,大多数现有的工作假设信道根据一组马尔可夫转移概率在无限个状态下变化[17].然而,在动态环境中,无线网络通常是未知的,因此我们使用一个无模型的RL,通过对当前状态的广泛训练来学习最佳策略,该状态可以以一个并非完全未知的转移概率转移到其他状态.

3.1 状态及动作向量

在t时刻,RL代理通过观察网络环境形成系统状态.我们假设状态空间由S表示,所以在t时刻系统状态向量st∈S可以表示为:

st={z1(t),z2(t),…,zU(t),d1(t),d2(t),…,dU(t)}

(12)

其中,zu表示计算任务Ru的数据大小,并du表示执行该任务Ru所需的计算资源.

在我们的问题中,代理将对计算任务做出决策,这个决策包括:计算任务执行的比例是多少,在边缘计算中应该分配多少计算资源.该行动向量由用户的卸载决策A=[α1,α2,…,αU]和MEC的资源分配f=[f1,f2,…,fU]两部分组成,因此行动向量可以由A和f给出.

3.2 求解最优策略和最优值函数

策略是通过长期优化得到的行动选择策略,它可以是确定性的,也可以是随机性的.事实上,确定性策略是随机策略的一个特例.随机策略保证了对行为空间的充分挖掘,因此我们使用了随机策略π(α|s)=Pr(αt=α|st=s).随机策略给出了动作的概率分布.Q值的标准定义是状态s从时刻t开始,选择动作α的轨迹的期望返回,表示为:

(13)

其中,β∈(0,1)是折扣系数.最优Q值是指在为所有决策采取最佳行动时所能达到的最大值.当使用这个值迭代地估计所有状态和动作对(s,α)的最佳Q值时,该策略可以通过简单地选择贪婪动作得到,即:

(14)

在上述问题中,状态和动作的维度非常高,因此在使用值迭代时,空间、时间和内存成本是无法测量的.在深入学习成为热门话题之后,人们认识到函数逼近技术,特别是DNN,可以用来表示Q值.因此,Q值函数Qπ(s,α)可以用包含多个隐藏层的完全连接DNN表示为Qω(s,α),并传递一组权重w={ω1,ω2,…,ωN}参数.DNN的输入层有两个单元,用于将系统状态s和动作α导入下一个隐藏层.

我们使用线性整流函数(Rectified Linear Unit,ReLU)作为非线性激活函数.通过迭代最小化损失函数,可以训练DNN学习最优配置权重ω

(15)

DRL算法描述如算法1所示.

算法1.DRL最优策略算法描述

1.Initialization

the experience replays bufferD,

the parameters of the actor networkθand its targetθt,

the parameters of the critic networkωand its targetωt.

2.forepisodee=1,…,Edo

3. reset environment states0,and reset rewardr=0.

4.forstept=1,…,Tdo

5. generate an actionαtaccording toπθ(α|s),

6. observe the rewardrtand the subsequent statest+1,

7. Store the tuple 〈st,αt,rt,st+1〉 in replay bufferD.

8. Draw a mini-batch ofNtuples fromD

9. update the parameters of the critic network:

10. update the parameters of the critic network:

12. EveryUsteps,update two target networks parameters:

13.ωt←Tω+(1-T)ωt

14.θt←Tθ+(1-T)θt

15.endfor

16.endfor

4 仿真及分析

4.1 模拟设置

神经元数目越多,值函数逼近越准确.但是,神经元数量过多,参数数量多,计算复杂度高.根据文献[14]我们将隐藏层的神经元数量设置为360.为参与者和批评者生成两个独立的目标网络,每隔N=250、rate=0.001次迭代,将两个目标网络的参数替换为原网络的当前估计参数.为了训练DNN,我们设置了大小为8000的经验回放缓冲区,可以在查询时随机返回一个小批量的经验,小批量的大小设置为64.将参与者学习率和批评者学习率分别设置为δα=0.0001和δc=0.001.

4.2 仿真结果

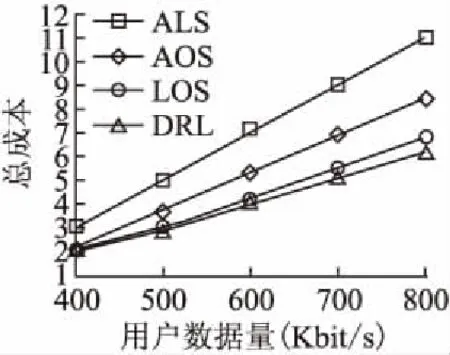

我们将DRL算法与All Local Scheme(ALS)[8]、All Offload Scheme(AOS)[9]、Local or Offload Scheme(LOS)[10]3种算法进行比较.其中,ALS是指所有用户通过本地计算执行他们的任务;AOS是指所有用户都将自己的任务分配给MEC服务器执行,整个计算资源F平均分配给用户;LOS是指用户任务可以在本地执行或卸载到MEC,但用户任务是不可分割的.

图2 用户数量对总成本的影响Fig.2 Impact of number of users on total cost

图2展示了系统成本随用户数量增加的变化趋势.其中MEC服务器具有F=8GHz/s的计算能力.从图上可以看出,随着用户数量的不断增加,4种方法的总成本也逐渐增加.可以看出,本文提出的DRL方法可以得到最好的结果,略优于LOS,两种方法的性能相对稳定.AOS曲线在5个用户点上略高于DRL和LOS,但当用户更多时增长更快.这是因为当用户数量增加时,MEC服务器计算资源不足以提供所有用户.有限计算能力的MEC服务器不应该服务太多的用户,因此如何选择这种情况下的解决方案变得非常重要.

图3 用户数据大小对系统总成本影响Fig.3 Impact of user data size on total cost

图3展示了用户数据大小对系统总成本影响的趋势图,其中用户数为5.从图上可以看出,4种方法的总成本随着数据大小的增加而增加,因为较大的数据大小将导致更多的时间和能量消耗,从而增加系统的总成本.由于DRL方法的增长趋势比其他方法慢,因此可以得到最好的结果.随着数据量的增加,全局和局部曲线的增长速度远远快于其他3种方法,这表明随着任务量的增加,数据量越大,计算延迟越大,卸载计算能耗越大.

图4 MEC服务器性能对总成本的影响Fig.4 Impact of MEC server performance on total cost

图4展示了不同MEC服务器性能对总成本的影响,MEC服务器的计算能力从2 GHz/s增加到10GHz/s.从图上可以看出,所提出的DRL方法在与服务水平相差不大的情况下得到了最好的结果.曲线ALS不会随MEC服务器的功能而改变,因为MEC服务器计算资源不会影响本地计算.除ALS以外的曲线随着MEC服务器的计算能力增加而减小,因为如果向每个用户分配更多的计算资源,则执行时间将变得更短.更重要的是,当F>9GHz/s时,AOS、LOS和DRL的总成本都在缓慢降低,并且这些方法的性能基本相同.结果表明,当MEC服务器上的计算资源远大于本地计算时,系统总成本主要受无线资源的限制.

5 结 论

研究了CRAN中的计算卸载方案和计算资源分配问题,运用深度强化学习构建了C-RAN动态资源分配框架,以实现时间消耗和能量消耗的最小化.由于无线环境是随机的,我们使用无模型RL框架来解决联合决策问题,实现用户计算任务的卸载按比例完成.定义了DRL代理的行为、状态和奖励函数,制定资源分配问题,并应用DNN近似行动决策的行动值函数,从当前状态直接提取信息,不需要获取准确的信道状态.通过与文献方法的比较,给出了该方案的性能评价.仿真结果表明,在不同的系统参数下,该方案能获得比其他算法更好的性能.