基于注意力的短视频多模态情感分析

黄 欢,孙力娟,2,曹 莹,郭 剑,2,任恒毅

基于注意力的短视频多模态情感分析

黄 欢1,孙力娟1,2,曹 莹3,郭 剑1,2,任恒毅1

(1. 南京邮电大学计算机学院,江苏 南京 210003; 2.南京邮电大学江苏省无线传感网高技术重点实验室,江苏 南京 210003; 3. 河南大学计算机与信息工程学院,河南 开封 475001)

针对现有的情感分析方法缺乏对短视频中信息的充分考虑,从而导致不恰当的情感分析结果。基于音视频的多模态情感分析(AV-MSA)模型便由此产生,模型通过利用视频帧图像中的视觉特征和音频信息来完成短视频的情感分析。模型分为视觉与音频2分支,音频分支采用卷积神经网络(CNN)架构来提取音频图谱中的情感特征,实现情感分析的目的;视觉分支则采用3D 卷积操作来增加视觉特征的时间相关性。并在Resnet的基础上,突出情感相关特征,添加了注意力机制,以提高模型对信息特征的敏感性。最后,设计了一种交叉投票机制用于融合视觉分支和音频分支的结果,产生情感分析的最终结果。AV-MSA模型在IEMOCAP和微博视听(WB-AV)数据集上进行了评估, 实验结果表明,与现有算法相比,AV-MSA在分类精确度上有了较大的提升。

多模态情感分析;残差网络;3D卷积神经网络;注意力;决策融合

近年来,随着社交媒体的发展,如微博、抖音、快手的出现,人们越来越倾向于在平台上传文字、图片、视频来表达个人情感,由此短视频的数量日益增多。面对海量的短视频数据,根据其情感进行分类,从而引导用户从大量数据中找到有价值的信息,已成为当前的研究热点之一。因此,研究人员开始专注于短视频情感分析的研究。

现有研究所探讨的情感分析多指文本中的情感分析(尤其是短文本情感分析),如推特以及电影评论等。由于文字是抽象的,文字个体之间是相互独立的,且具有不同语调的文字所承载的用户的情感是不一样的,单纯的基于文字来完成情感分析是远远不够的。考虑到短视频已经成为当前较为主流的情感载体,研究者们开始思考基于短视频的视频帧信息来完成情感分析。

但基于视频帧图像的短视频情感分析在一些场景下是不准确的,如在表达喜极而泣时,用户的面部表情和声音所表达的情感是不一样的,会对情感的分析造成误差。由此,学者们开始考虑多模态情感分析来降低上述场景对短视频情感分析的影响。PORIA等[1]使用卷积神经网络(convolutional neural networks,CNN)提取文本、音频和视觉特征;连接其特征,并采用多核学习(multiple kernel learnin,MKL)进行最终情感分类。MA等[2]融合了用于情感识别的音频模态和EEG信号。上述方法都依赖于特征级融合。WU和LIANG[3]在决策层融合了音频和文本特征。上述研究表明,多模态系统比任何单模态系统具有更优的性能。因此,多模态情感分析[4-7]成为当前短视频情感分析较为重要的研究方向。

本文采用音视频多模态情感分析(audio-visual multimodal sentiment analysis,AV-MSA)来完成短视频的情感分析,框架如图1所示。该模型包括2个分支:①音频情感分析,采用CNN架构[8]提取音频图谱中的情感特征并进行分析;②视频情感分析,首先,为了确保特征的时间相干性,本文使用了3D卷积[9];其次,在ResNet[10]的基础上,为了突出情感相关特征,添加了注意力机制,以提高模型对信息特征的敏感性;最后,以交叉投票机制融合2个分支的结果,最终的输出即为短视频的情感。将本文模型在IEMOCAP[11]和微博视听(Weibo audio-visual,WB-AV)数据集上进行了评估。本文自制了WB-AV数据集,主要反映亚洲人的语言特点。实验结果表明,与其他方法相比,本文模型在性能上提升了约3%。主要贡献为:①提出了基于残差注意力的AV-MSA模型,充分利用音频和视频中的信息对其中所包含的情感进行分类;②设计了交叉投票机制,以融合音频和视频的分类结果并获取短视频的情感;③在基于视频帧的基础上,改进了压缩奖惩[12](squeeze-and-excitation)网络模块的操作,并用于多模态情感分类;④制作了符合亚洲人语言特点的WB-AV数据集。其包含:生气、害怕、厌恶、中性、快乐、悲伤和惊讶7种类型的情绪。

图1 多模态情感分析流程图

1 多模态情感分析模型

图2为本文提出的AV-MSA模型。用公式表述为=-(PA,PV)。其中,为网络的整体输入;PA为音频网络输入;PV为视频网络;-为交叉投票机制;为输出。

1.1 音频网络

现有的方法一般使用开源软件openSmile[13]直接提取声学特征,但可能会丢失一些重要特征。本文首先将原始音频文件转换为音频图谱,并提取其特征;然后用对数梅尔带能量和梅尔频率倒谱系数(Mel-scale frequency cepstral coefficients,MFCC)作为声学特征,如图3所示。

图2 多模态情感分析框架图

图3 音频特征提取过程

本文采用CNN架构,在softmax层生成输出概率,包括2个连续的CNN块和一个全连接层,每个CNN块的输出与上一模块的输出沿频域连接,以在执行最大池化之前增加特征的数量。其中,每个CNN块由一个内核大小为3的卷积层,一个ReLU激活函数和一个批量归一化[14]组成。

1.2 视频网络

1.2.1 3D-CNN

对视觉内容的情感分析可以帮助正确识别短视频中包含的情感。相较于SIFT和HOG等传统特征提取方法,深度学习[15]方法由于随着网络深度的增加,特征提取愈发完备而得到了广泛地应用。

首先,由于2D CNN未考虑视频帧序列中特征的时间相干性[16],所以会降低短视频情感分类结果的准确性。其次,短视频中的异常情况(如目标位置失真)也会降低情感结果的准确性。最后,对于基于CNN的方法,随着深度的增加,会陷入局部最优解,这也会降低结果的准确性,并且训练过程变得极其缓慢。

为了解决上述问题,本文采用3D卷积形式的残差网络(ResNet)。如图4所示,时间维度为第三维。3D卷积是通过堆叠多个连续的帧组成一个立方体,然后再运用3D卷积核。在这个结构中,卷积层中每一个特征图都会与上一层中多个邻近的连续帧相连,因此能够捕捉时间信息。

图4 3D卷积结构图

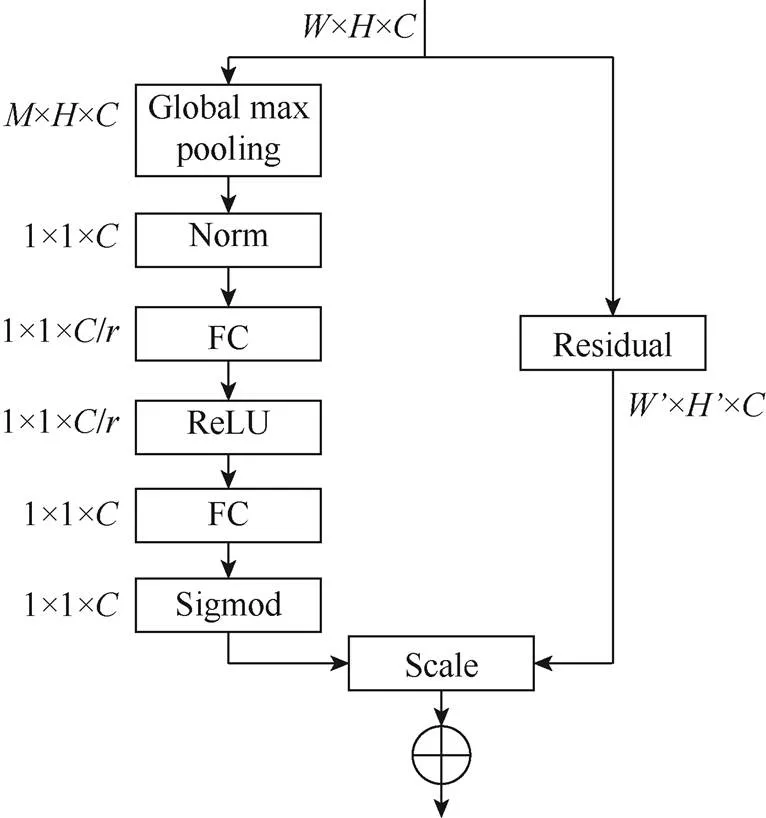

1.2.2 改进SE模块

现有研究未考虑不同通道之间重要性可能不一样,而是将其看成同等重要来处理的。因此,为了提高模型对信息特征的敏感性,本文基于SE (squeeze-and-excitation)进行改进。在SE模块中,不同通道的重要性是通过学到的一组权值来标定的,即对原来通道权值的一个重新标定。这提高了模型对信息特征的敏感性,使后续处理能够有效地利用与情感相关的信息特征。改进后的结构如图5和图6所示。

图5 改进SE模块结构图

图6 残差SE模块

实现过程为:

(1) 进行全局最大池化(global max pooling)操作,即相当于原来压缩(squeeze)操作中的全局平均池化操作。采用全局最大池化操作,是因为其可以有效地保留背景信息,并最大程度地提取有用的纹理特征,这对于进行情感分类十分重要。

其中,为经过卷积操作后,每个特征向量与基准之间的最小距离,通过max函数,可获取其中的最大值。

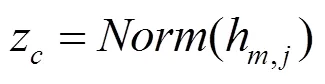

(2)由于全局最大池化操作后的输出值有时幅度波动较大,因此需添加归一化操作,即

(3) 通过excitation全面捕获通道依赖性。并采用了简单的门控机制,使用的Sigmoid激活函数为

(4) 得到后,可以对原来残差网络的输出进行操作,即

其中,U为残差网络的输出,是一个二维矩阵,下标表示channel。S是上一步的输出(向量)中的一个数值,也是权重,因此相当于将U矩阵中的每个值都乘以S。

1.3 交叉投票机制

其中,和分别为音频和视频中的情感,对每一种情感每次需连续取20帧。

其中,,分别为通过与阈值对比而确认的情感。

最后,使用P和P分别表示用视频和音频的结果去统计音频和视频分类的结果,其计算结果为

其中,为2种模态的权重。在诸如生气、快乐、悲伤等情绪的表达中,视频模态中表达的情感特征要多于音频模态,因此,将设置为0.2;correct为最终的分类正确结果。

2 实验和结果

2.1 数据集介绍

本实验中所采用了IEMOCAP和WB-AV 2个数据集。其中IEMOCAP数据集是用来研究多模态表达以及动态交互,包含的情感有快乐、悲伤、中性、生气、惊讶、兴奋、沮丧、厌恶、害怕等等。WB-AV数据集是本文采集制作的符合亚洲人语言特色的数据集,包含7种类型的情感,如图7所示。

2.2 实验环境配置

本文在NVIDIA GeForce GTX 1080Ti GPU平台上对所提出的网络进行训练和测试。在训练过程中,固定网络的一支,单独对另一支进行训练,在每次池化后,采用50%的Dropout[19-20]来减少过拟合问题。最后采用交叉投票进行决策融合。训练和测试过程,batch size大小设置为32,20。在训练中,根据训练次数使用动态学习率,初始学习率为0.01,随着训练次数的增加,学习率下降,最小值为0.000 01。另外,权重衰减系数(weight decay rate)用于避免模型过度拟合,其值为0.000 20。本文模型中引入了泄露修正线性单元,以防止在反向传播过程中ReLU的导数为0,relu_leakiness 的值为0.1。此外,在实验数据集中,80%的数据用于训练,20%的数据用于测试。所有的对比方法均采用相同的训练方法和实验环境。

2.3 实验结果分析

本文将音频、视频以及多模态情感分析的精确度在IEMOCAP和WB-AV 2种数据集上对SVM、文献[21]、文献[22]、文献[23]和本文的AV-MSA 5种方法的精确度进行了比较,结果见表1和表2。从实验结果可知,SVM结果较差,而深度学习方法均取得较好的结果。经过实验分析可知,与SVM依赖于核函数的方法不同,深度学习方法能够基于少数样本集中学习训练数据的本质特征。在此基础之上,本文方法引入注意力机制,其加强特征选择,聚焦于情感相关的特征。从表中可以看出,结合注意力机制的方法在性能上约有3%的提高。

图7 情感示意图

表1 IEMOCAP数据集上情感分类精确度

表2 WB-AV数据集上情感分类精确度

2.3.1 3种模态之间的比较

表1和表2展示了音频、视频和多模态分类的结果,可以看到在音频模态方面,本文采用的情感分类的几种方法差距不大,是因为将音频文件转化为音频图谱后,由于表达情感的方式不同,某些情感特征在音频图谱中表现不明显或某些特征表现形式比较相近;另在视频模态中,深度学习的方法要比传统的机器学习方法如SVM性能优异,这是由于直接从视频帧图片上提取的特征较多,且特征分布在面部的各个区域,如眼睛、嘴巴、鼻子等等,此外随着网络的加深,网络对特征的提取与学习也越来越准确。在多模态方面,可以看出使用了音频和视频模态后的结果相较单模态有了大约10%~14%的提升。另外,相较于其他方法,AV-MSA约提升了3%。

2.3.2 7种情绪在3种模态下精确度比较

图8为在AV-MSA方法下7种情绪在3种模态下的精确度,结果显示,音频的分类准确率要普遍低于视频的分类,并且可以看到,对于害怕及生气2种情绪,不管是用视频还是音频分类的结果,准确性均高于其他几类情绪,而对于中性,如厌恶之类情绪的准确度相对较低,这可能是因为当产生生气以及害怕情绪时,人的面部表情比较丰富,声音中的抖动也较多,能提取到较多的特征,而中性、惊讶之类的情绪则特征不明确。这与亚洲人在表达情感时较为含蓄有关,因此能提取到的特征较少。

2.3.3 数据增强vs非数据增强

在深度学习中,充足的、高质量的样本能够增强训练模型的泛化能力,因此,在本实验中,采用数据翻转、图像缩放、图像裁剪、图像平移、色彩增强等分别对音频和视频数据集进行增强操作。从表1和表2的结果可以看出,采用数据增强后的性能约有5%~7%的提高。

2.3.4 迁移学习

由于WB-AV在采集方面条件比较苛刻,每次采集到新的短视频,就要重新进行模型训练,这无疑增加了时间成本,降低了工作效率。因此,本文考虑通过较完备的IEMOCAP数据集来训练一个模型,并将其迁移到WB-AV数据集上进行分类实验。从表3中可以看出,通过迁移学习后,多模态情感分类的准确度大约在52%左右。产生这一结果的原因可能是由于人种的差异引起的情感表达方式不同,从而导致了2个数据集的数据分布存在差异,使得分类的精确度不高。

表3 迁移学习

3 结束语

本文提出了AV-MSA模型,以分析短视频中表现出的情感。该模型有2个分支:①音频情感分析,采用CNN架构提取音频图谱中的情感特征,实现情感分析的目的;②视频情感分析,首先,为了确保特征的时间相干性,使用了3D卷积;其次,在Resnet的基础上,为了突出情感相关特征,添加了注意力机制,以提高模型对信息特征的敏感性;最后,提出了将2分支结果融合在一起的交叉投票机制,融合结果即为短视频的情感。所提模型在IEMOCAP和WB-AV数据集上进行了评估,其中WB-AV数据集由本文制作,主要反映了亚洲人的特点。实验结果表明,与其他方法相比,该模型在性能上大约有3%的提升。在未来的研究中,将继续扩展数据集以添加更多特征,例如人类生理行为。

[1] PORIA S, CHATURVEDI I, CAMBRIA E, et al. Convolutional MKL based multimodal emotion recognition and sentiment analysis[C]//2016 IEEE International Conference on Data Mining (ICDM). New York: IEEE Press, 2016: 439-448.

[2] MA J, SUN Y, ZHANG X. Multimodal emotion recognition for the fusion of speech and EEG signals[J]. Xi’an Dianzi Keji Daxue Xuebao/Journal of Xidian University, 2019, 46(1): 143-150.

[3] WU C H, LIANG W B. Emotion recognition of affective speech based on multiple classifiers using acoustic-prosodic information and semantic labels[J]. IEEE Transactions on Affective Computing, 2011, 2(1): 10-21.

[4] SOLEYMANI M, GARCIA D, JOU B, et al. A survey of multimodal sentiment analysis[J]. Image and Vision Computing, 2017, 65: 3-14.

[5] HUSSION I O, JAZYAH Y H. Multimodal sentiment analysis: a comparison study[J]. Journal of Computer Science, 2018, 14(6): 804-818.

[6] 吴良庆, 刘启元, 张栋, 等. 基于情感信息辅助的多模态情绪识别[J]. 北京大学学报: 自然科学版, 2020, 56(1): 75-81. WU L Q, LIU Q Y, ZHANG D, et al. Multimodal emotion recognition based on emotional information assistance[J]. Journal of Peking University: Natural Science Edition, 2020, 56(1): 75-81 (in Chinese).

[7] 宋绪靖. 基于文本、语音和视频的多模态情感识别的研究[D].济南: 山东大学, 2019. SONG X J. Research on multimodal emotion recognition based on text, speech and video[D]. Jinan: Shandong University, 2019 (in Chinese).

[8] DANG A, VU T H, WANG J C. Acoustic scene classification using convolutional neural networks and multi-scale multi-feature extraction[C]//2018 IEEE International Conference on Consumer Electronics (ICCE). New York: IEEE Press, 2018: 1-4.

[9] AKILAN T, WU Q J, SAFAEI A, et al. A 3D CNN-LSTM-based image-to-image foreground segmentation[J]. IEEE Transactions on Intelligent Transportation Systems, 2019, 21(3): 959-971.

[10] HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). New York: IEEE Press, 2016: 770-778.

[11] BUSSO C, BULUT M, LEE C C, et al. IEMOCAP: interactive emotional dyadic motion capture database[J]. Language Resources and Evaluation, 2008, 42(4): 335-359.

[12] HU J, SHEN L, SUN G. Squeeze-and-excitation networks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2018: 7132-7141.

[13] PÉREZ-ROSAS V, MIHALCEA R, MORENCY L P. Multimodal sentiment analysis of Spanish online videos[J]. IEEE Intelligent Systems, 2013, 28(3): 38-45.

[14] IOFFE S, SZEGEDY C. Batch normalization: accelerating deep network training by reducing internal covariate shift[EB/OL]. [2020-03-02]. https://arxiv.org/ abs/1502.03167.

[15] PORIA S, CAMBRIA E, HAZARIKA D, et al. Context-dependent sentiment analysis in user-generated videos[C]//The 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Stroudsburg, PA: Association for Computational Linguistics, 2017: 873-883.

[16] PORIA S, CAMBRIA E, GELBUKH A. Deep convolutional neural network textual features and multiple kernel learning for utterance-level multimodal sentiment analysis[C]//2015 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2015: 2539-2544.

[17] NAIR V, HINTON G E. Rectified linear units improve Restricted Boltzmann machines[C]//The 27th International Conference on Machine Learning. New York: ACM Press, 2010: 807-814.

[18] HAN J, MORAGA C. The influence of the sigmoid function parameters on the speed of backpropagation learning[J]. From Natural to Artificial Neural Computation, 1995: 195-201.

[19] SRIVASTAVA N, HINTON G E, KRIZHEVSKY A, et al. Dropout: a simple way to prevent neural networks from overfitting[J]. Journal of Machine Learning Research, 2014, 15(1): 1929-1958.

[20] 程俊华, 曾国辉, 鲁敦科, 等. 基于Dropout的改进卷积神经网络模型平均方法[J]. 计算机应用, 2019, 39(6): 1601-1606. CHENG J H, ZENG G H, LU D K, et al. Improved convolutional neural network model averaging method based on Dropout[J]. Journal of Computer Applications, 2019, 39(6): 1601-1606 (in Chinese).

[21] TZIRAKIS P, TRIGEORGIS G, NICOLAOU M A, et al. End-to-end multimodal emotion recognition using deep neural networks[J]. IEEE Journal of Selected Topics in Signal Processing, 2017, 11(8): 1301-1309.

[22] CHAE M, KIM T H, SHIN Y H, et al. End-to-end multimodal emotion and gender recognition with dynamic joint loss weights[EB/OL]. [2020-06-12]. https://arxiv.org/abs/1809.00758.

[23] PARISI G I, BARROS P, WU H, et al. A deep neural model for emotion-driven multimodal attention[C]//2017 AAAI Spring Symposium Series. Palo Alot: AAAI, 2017: 482-485.

Multimodal sentiment analysis of short videos based on attention

HUANG Huan1, SUN Li-juan1,2, CAO Ying3, GUO Jian1,2, REN Heng-yi1

(1. College of Computer, Nanjing University of Posts and Telecommunications, Nanjing Jiangsu 210003, China; 2. Jiangsu High Technology Research Key Laboratory for Wireless Sensor Networks, Nanjing University of Posts and Telecommunications, Nanjing Jiangsu 210003, China; 3. College of Computer and Information Engineering, Henan University, Kaifeng Henan 475001, China)

The existing sentiment analysis methods lack sufficient consideration of information in short videos, leading to inappropriate sentiment analysis results. Based on this, we proposed the audio-visual multimodal sentiment analysis (AV-MSA) model that can complete the sentiment analysis of short videos using visual features in frame images and audio information in videos. The model was divided into two branches, namely the visual branch and the audio branch. In the audio branch, the convolutional neural networks (CNN) architecture was employed to extract the emotional features in the audio atlas to achieve the purpose of sentiment analysis; in the visual branch, we utilized the 3D convolution operation to increase the temporal correlation of visual features. In addition, on the basis of ResNet, in order to highlight the emotion-related features, we added an attention mechanism to enhance the sensitivity of the model to information features. Finally, a cross-voting mechanism was designed to fuse the results of the visual and audio branches to produce the final result of sentiment analysis. The proposed AV-MSA was evaluated on IEMOCAP and Weibo audio-visual (Weibo audio-visual, WB-AV) datasets. Experimental results show that compared with the current short video sentiment analysis methods, the proposed AV-MSA has improved the classification accuracy greatly.

multimodal sentiment analysis; ResNet; 3D convolutional neural networks; attention; decision fusion

TP 751.1

10.11996/JG.j.2095-302X.2021010008

A

2095-302X(2021)01-0008-07

2020-07-22;

22 Jnly,2020;

2020-08-04

4August,2020

国家自然科学基金项目(61873131,61702284);安徽省科技厅面上项目(1908085MF207);江苏省博士后研究基金项目(2018K009B)

:National Natural Science Foundation of China (61873131, 61702284); Anhui Science and Technology Department Foundation (1908085MF207); Postdoctoral Found of Jiangsu Province (2018K009B)

黄 欢(1995–),男,浙江嘉兴人,硕士研究生。主要研究方向为数字图像处理与模式识别。E-mail:13736832754@163.com

HUANG Huan (1995-), male, master student. His main research interests cover digital image processing and pattern recognition. E-mail:13736832754@163.com

孙力娟(1963–),女,江苏南京人,教授,博士。主要研究方向为无线传感网、深度学习、模式识别等。E-mail:sunlijuan_nupt@163.com

SUN Li-juan (1963–), female, professor, Ph.D. Her main research interests cover wireless sensor network, deep learning, pattern recognition, etc. E-mail:sunlijuan_nupt @163.com