基于改进YOLOv3 的红外目标检测方法

秦 鹏,唐川明,刘云峰,张建林,徐智勇

(1.中国科学院光束控制重点实验室,成都 610209;2.中国科学院光电技术研究所,成都 610209;3.中国科学院大学 电子电气与通信工程学院,北京 100049)

0 概述

目标检测是计算机视觉领域的重要研究方向,现有方法通常使用可见光图像进行目标检测,在黑夜、沙尘暴、大雾、雨天等缺少可见光光源、距离较远、能见度较低的情况下,很难进行有效成像,检测效果不佳[1]。红外成像技术根据不同目标向外界散发的不同红外辐射强度进行成像,无需借助外部环境光,不受雨雪风霜等天气影响,具有全天候工作、可视距离远等优点[2]。红外成像技术主要运用在目标捕获、跟踪、定位等军事领域以及铁路、煤矿、消防抢险、安防监控等民用领域。

传统红外目标检测主要包括模板匹配、阈值分割、帧差等方法。LIU 等[3]提出将主成分分析得到的投影系数用作模板,并通过非线性相关性衡量匹配度。ZHANG 等[4]改进固定阈值识别方法,根据计算二维红外通道中的亮度温度直方图,提出基于二维Otsu 和上下文测试的检测算法。YIN 等[5]提出一种基于经典W4 和帧差结合的算法,克服由背景突变引起的误检,消除帧差造成的空洞。然而,由于红外图像的纹理细节少、目标轮廓信息不明显,在快速变化的复杂背景环境下容易产生错检漏检,因此上述方法对红外场景目标的检测效果不理想。

随着科学技术的快速发展,依靠大数据管理和高性能计算的深度学习技术受到研究人员的广泛关注并基于其提出一系列目标检测方法。基于深度学习的目标检测方法在计算机视觉领域展现出超越传统算法的优越性能,其中,两阶段方法有R-CNN[6]、Fast R-CNN[7]、Faster R-CNN[8]等,单阶段方法有SSD[9]、YOLO[10-12]等。但目前专门用于红外目标检测的深度学习算法较少,由于红外目标的特性,因此直接使用这些通用的深度学习算法的检测准确度不高。为解决上述问题,LEE 等[13]将轻量级卷积神经网络(Convolutional Neural Network,CNN)和增强的随机森林相结合,改变原有的全连接方式,将CNN的输出与增强的随机森林相连接。HERRMANN等[14]提出一种红外数据预处理策略,使红外数据尽可能接近RGB 域,再使用红外数据集进行训练微调,提升对红外数据的检测效果。WEI 等[15]借鉴MobileNetv2 轻量化网络,将3 个特征输出层进行自上而下的特征金字塔逐次连接,结合YOLOv3 检测头进行红外目标预测,加快了网络检测速度。HU等[16]提出一种基于增强特征融合域的红外目标检测算法,将静态目标模式分析与动态多帧相关检测相结合,使用神经网络融合不同层次的红外目标特征,通过增强目标特征抑制背景杂波和虚警率。

上述研究工作从不同角度提升了对红外目标检测的性能,但对复杂背景的适应性不强,在检测准确度和速度的平衡方面还有待提升。本文在YOLOv3模型的基础上,提出改进的Effi-YOLOv3 模型。针对DarkNet53 模型规模大、训练速度慢且对设备性能要求高的问题,使用轻量高效的EfficientNet 骨干网络,降低内存消耗,提升网络模型的运行速度。由于目标尺度差异较大,浅层特征的感受野较小,通过模拟人类视觉的感受野机制,引入改进的感受野模块(Receptive Field Block,RFB),在增加少量计算量的情况下,大幅增加网络模型感受野。在检测层部分,基于可变形卷积以及动态ReLU 激活函数构建DBD结构和CBD 结构,提升模型特征编码灵活性,增加网络模型容量。使用兼顾预测框与真值框长宽比偏差、重叠率和中心点距离的CIoU 损失代替原来的IoU 损失,加快网络模型的训练速度,提升预测框的回归准确度。

1 相关工作

1.1 YOLOv3

YOLOv3 是目标检测中常用的单阶段网络,与两阶段网络先产生候选区域再进行分类不同,YOLOv3在产生候选区域的同时进行分类,提升了网络检测速度。YOLOv3 的骨干网络为由残差结构组成的DarkNet53,残差结构可以缓解深层网络训练时的梯度消失问题。YOLOv3 网络结构如图1 所示。为加强网络对不同尺度目标的检测精度,YOLOv3 采用类似FPN 的方式,将低层次的包含更多细粒度信息的特征层与高层次的包含较多语义信息的特征层进行特征融合,YOLOv3 中共进行两次特征融合,形成3 个不同尺度的检测层,分别对应检测大尺度目标、中等尺度目标、小尺度目标。不同尺度的特征层会被划分为S×S个网格,每个网格会生成3 个先验框,共生成10 647 个先验框进行预测,每个先验框预测(B+C+N)维向量,其中,B表示4 个边界框偏移量,C表示目标预测的置信度,N表示需要预测的类别总数。

图1 YOLOv3 网络结构Fig.1 Structure of YOLOv3 network

YOLOv3 损失函数由目标框位置损失Lloc、目标置信度损失Lconf和目标类别损失Lcls三个部分组成,其中,目标框位置损失包括中心点x、y产生的BCE Loss 和预测框长宽w、h产生的MSE Loss,目标类别损失为分类预测产生的BCE Loss。YOLOv3 损失函数定义如下:

1.2 EfficientNet

EfficientNet[17]是一个可以平衡缩放网络输入图像分辨率、网络宽度和网络深度的模型,减少了模型参数量,增强了特征提取能力,使网络处于高效平衡的状态。EfficentNet 由多个MBConv 模块构成,MBConv 中包含深度可分离卷积、Swish 激活函数以及Dropout 连接,并且在模块中加入了SE 通道注意力机制。MBConv 模块结构如图2 所示。

图2 MBConv 模块结构Fig.2 Structure of MBConv module

Swish 激活函数计算公式如下:

在Swish 函数中x为输入,包含β个常数或者可训练的参数。Swish 具备无上界、有下界、平滑、非单调的特点,将ReLU 替换为Swish 就能将Mobile NASNetA 在ImageNet 上的Top-1 分类准确率提升0.9%。

深度可分离卷积是由逐通道卷积和逐点卷积组合而成。逐通道卷积中每一个通道被一个卷积核独立计算,没有利用不同通道在相同的空间区域上的特征信息。因此,使用逐点卷积将逐通道卷积产生的特征图进行融合,逐点卷积的卷积核大小为1×1,对逐通道卷积产生的特征图在深度方向进行加权组合,得到最终的输出特征层。

2 基于Effi-YOLOv3 的红外目标检测

为解决YOLOv3 对于红外目标检测精度较低、计算复杂度较高的问题,本文提出一种基于Effi-YOLOv3 的红外目标检测方法。采用更轻量高效的EfficientNet-B2 作为目标特征提取表示的骨干网络,提高网络对目标表示的鲁棒性和特征提取的高效性。通过添加改进的RFB 结构,增强网络感受野。构建基于可变形卷积和动态ReLU 激活函数的DBD结构和CBD 结构,自适应调整卷积区域和通道激活率,提升模型表达能力。使用CIoU 损失加快模型收敛时间,提升预测框的准确率,最终实现对红外目标更高效准确的检测。

2.1 骨干网络

为改善YOLOv3 的特征提取能力以及减少模型参数,引入EfficientNet 作为特征提取骨干网络。对应不同场景的需求,EfficientNet 系列网络有B0~B7共8 种由小到大的网络模型。针对红外场景目标检测任务,将EfficentNet-B2 去除最后的全局平均池化层、Dropout 层和全连接层后代替YOLOv3 原始的DarkNet53 网络进行特征提取。

EfficeintNet-B2 共有23 个MBConv 模 块,为了进行多尺度的特征融合,取第8 个MBConv 模块的输出层为P3 层,取第16 个MBConv 模块的输出为P4 层,取第23 个MBConv 模块的输出为P5 层,将富有语义信息的高层特征通过上采样后与具有较多空间细节信息的低层特征进行通道级联,使用1×1 卷积对不同通道的特征进行融合。由于红外场景目标尺度变化较大,使用单一尺度特征层进行检测不能同时兼顾不同尺度的目标,借鉴YOLOv3 的多尺度检测策略,构建P3、P4 和P5 层特征融合后的3 种不同尺度的检测层,分别针对大尺度目标、中等尺度目标、小尺度目标进行检测,提升检测的准确性和鲁棒性。

2.2 网络感受野的增强

网络模型神经节点对于感受野中不同位置像素的敏感度不同,对感受野中心区域的像素敏感度高,对感受野边缘区域的像素敏感度低,并且从中心向边缘快速衰减,符合二维高斯分布。在人类视觉系统中,视网膜对于同一幅图像的不同区域的注意程度不同,在注视区域中心视觉灵敏程度最高,在周边区域灵敏度低很多,突出注视区域信息。

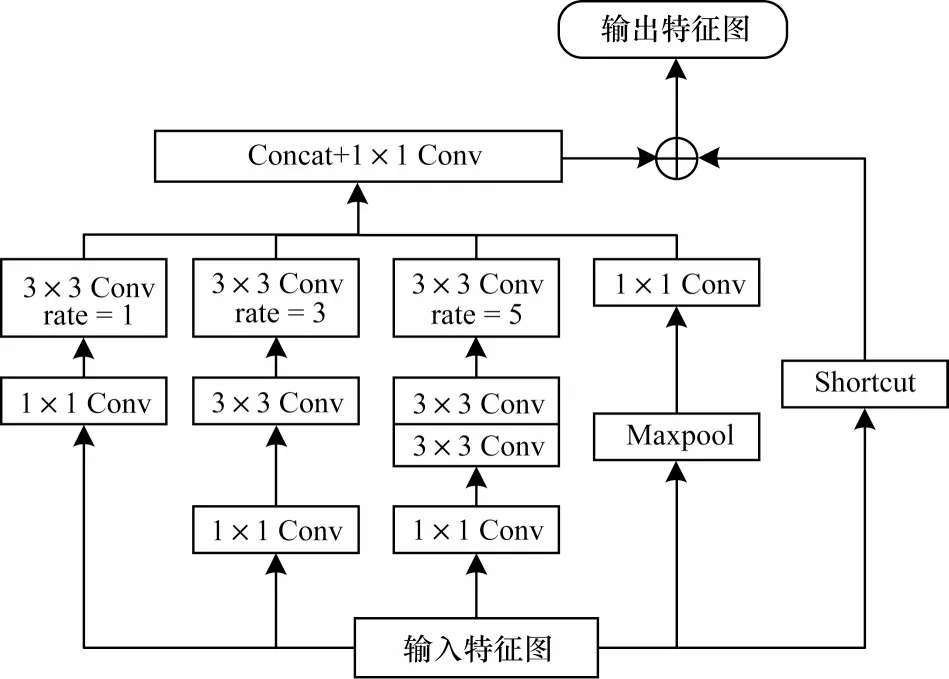

RFB[18]受人类视觉感受野结构启发,考虑视觉感受野大小和偏心率之间的关系以增大模型感受野,主要思想是采用不同尺寸卷积核和不同空洞率(rate)的空洞卷积,并对它们的结果进行级联组合。为获得不同尺度的局部特征信息,增大网络模型的感受野,进而提升网络的检测精度,同时为减少卷积层参数误差造成的估计均值的偏移,进一步改进RFB,获得增强的网络感受野,结构如图3 所示。由于红外成像中目标亮度高于背景亮度并且目标纹理特征弱,因此改进的RFB 在原有基础上增加一条Maxpool 分支以突出待检测目标,提升特征图在区域内的显著性,保留更多的目标纹理信息。

图3 改进的RFB 模块结构Fig.3 Structure of improved RFB module

改进的RFB 模块由具有不同大小的卷积核(类似Inception 结构)和不同空洞率的空洞卷积层构成,用于模拟人类视觉。首先将输入的特征经过1×1 的卷积进行降维,减少模块的参数量,并保留1 个残差边连接到输出层,有利于网络训练。多分支层由1×1、3×3、5×5 的卷积和Maxpool 构成,模拟不同多尺度的群体感受野,实际使用2 个3×3 卷积代替5×5 卷积,减少参数量。然后不同大小的卷积核连接对应空洞率为1、3、5 的3×3 空洞卷积用于模拟人类视觉中群体感受野尺度与偏心率之间的关系。最后将不同空洞卷积结果和使用1×1 卷积通道变换后的Maxpool 层级联在一起进行通道融合,并与之前的残差边逐元素相加得到最终的输出特征。

2.3 可变形卷积和动态激活函数

传统卷积只能对固定区域进行计算,导致对几何形变部分的建模受到限制。可变形卷积[19]在一定程度上解决了上述问题,主要思想是通过对不同的卷积区域计算附加的偏置,改变原有的卷积计算位置,使其卷积区域贴合目标的几何外形。引入可变形卷积,使其根据感兴趣的目标区域自适应调整卷积区域,增强特征提取能力,减少背景信息的干扰。

普通膨胀率为1 的3×3 卷积的采样区域是一个规则的形状R,R∈{(-1,-1),(-1,0),…,(1,1)}。对于输入特征图x中的位置p0,使用卷积核w加权计算得到输出y(p0):

如图4 所示,可变形卷积在卷积操作时,额外对每个采样点p0的感受野范围pn计算偏移,增加二维的偏移量Δpk,将输入图像的像素值索引与对应的像素偏移量相加,并将变形后的像素索引范围限制在输入图像尺寸范围内。

图4 可变形卷积计算流程Fig.4 Calculation process of deformable convolution

由于不同区域像素对检测性能的贡献不同,当可变形卷积的区域大于目标所在区域时,会对非目标区域进行错误识别,因此在DCNv2[20]中对每一个偏移量预测权重Δmk,使其实现准确的特征提取。可变形卷积的计算公式如下:

计算得到的偏移量像素索引是一个浮点类型索引,为了使得到的像素值更加准确并且可以进行反向梯度传导,还需要对浮点类型像素值坐标经过双线性插值得到输出像素值。在初始化时,位置偏移Δpk=0,偏移权重Δmk=0.5,偏移层的学习率为原始层的0.1 倍。

ReLU[21]是深度神经网络中常用的激活函数,将输入中的所有负值均设置为0,计算简单高效。之后出现了Leaky ReLU、PReLU、RReLU 等多种ReLU函数的变体,但激活函数在推理阶段均是静态的。静态激活函数在网络运行之前设定激活率,在推理过程中激活函数对所有的输入数据执行相同的操作,缺乏灵活性。CHEN 等[22]提出动态ReLU(DYReLU)替换静态的激活函数。

动态ReLU 可以根据输入特征来学习调节ReLU 的正值激活率和负值抑制率。对于一个给定的输入向量x,动态激活函数被定义为分段函数fθ(x)(x),其中θ(x)为可学习的参数,可为不同输入x进行上下文信息编码计算激活函数的参数,fθ(x)(x)使用θ(x)计算的参数生成激活函数,通过少量的额外计算可以带来大幅的性能提升。

传统的静态ReLU 函数定义为y=max{x,0},通道的激活函数为yc=max{xc,0},其中,xc为输入向量x的第c个通道的值。ReLU 可以统一表示为分段线性函数。动态ReLU 通过输入x={xc}调节使静态的ReLU 变为动态的ReLU,其中线性系数是θ(x)的输出。动态ReLU 函数定义如下:

其中:K为函数的个数;C为通道数;激活函数参数不仅与当前对应通道输入xc有关,还与其他输入通道有关。动态ReLU 网络结构如图5 所示,其中:R为超参数;C/R表示降维后的通道数量;2KC表示θ(x)输出的参数。

图5 动态ReLU 网络结构Fig.5 Structure of DY-ReLU network

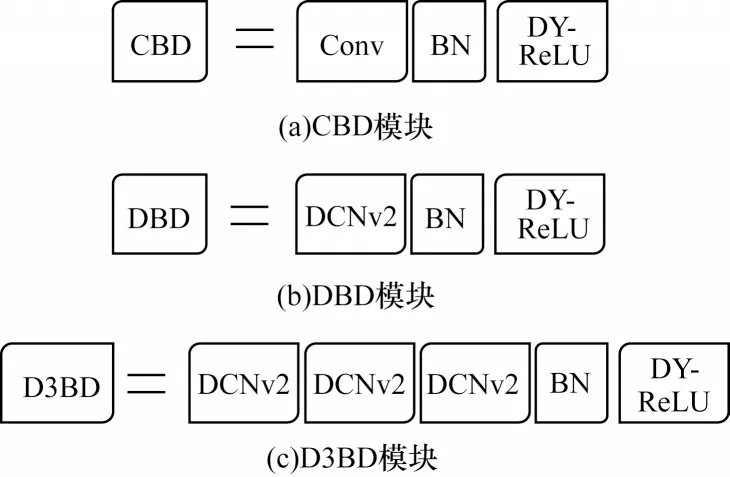

基于可变形卷积和动态ReLU 激活函数,设计CBD、DBD、D3BD 等3 种基础网络模块,其中:CBD由普通卷积(Conv)、BN 层、动态ReLU 函数组成;DBD 由可变形卷积(DCNv2)、BN 层、动态ReLU 函数组成;D3BD 由3 个可变形卷积、BN 层、动态ReLU函数组成。模块结构如图6 所示。

图6 CBD、DBD 和D3BD 模块结构Fig.6 Structure of CBD,DBD and D3BD modules

D3BD 相比DBD 和CBD 具有更强的特征提取能力,但是由于可变形卷积需要计算每一个卷积区域的偏移量以及对应偏移区域的权重比例,计算资源消耗相对较大,对模型运行速度产生较大影响。DBD 使用一个可变形卷积和动态ReLU 函数,兼顾网络运行速度和检测精度。CBD 由于没有使用可变形卷积,模型运行速度相对较快。在实际测试过程中,使用D3BD 网络运行速度降幅较大,为平衡检测速度和精度,选择在不同的检测层使用一次DBD 模块,以实现对不同尺度目标的自适应性特征提取,后续网络使用CBD 模块。

Effi-YOLOv3 网络结构如图7 所示。输入图像经过改进的EfficientNet-B2 骨干网络提取特征,其中P1 特征层分辨率为输入图像的1/2,P2 层分辨率为输入图像的1/4,以此类推,得到P3、P4、P5 等3 个有效特征层,其尺度大小分别为52×52、26×26、13×13,分别对应检测小尺度目标、中等尺度目标、大尺度目标。为补充P5 层检测大尺度目标时感受野不足的问题,在P5 层后使用改进的RFB 模块增加浅层特征层的感受野,利用DBD 模块使其适应大尺度的目标,得到P5_2 特征层,P5_2 特征经过4 次CBD 卷积模块得到P5_3。为进行不同尺度空间的特征融合,对P5_3 使用1 次CBD 卷积和上采样后与P4 特征层进行通道间级联融合,得到P4_1。为对中等尺度目标有更好的适应性,对P4_1 特征使用DBD 卷积得到P4_2,P4_2 特征经 过4 次CBD 卷积之后得到P4_3。将P4_3 经过1 次CBD 卷积和上采样后的特征与P3特征层进行通道间级联,得到融合多尺度特征。针对小尺度目标检测的P3_1,对P3_1 使用DBD 卷积得到更加适应小尺度目标检测的P3_2,并对P3_2 进行4 次CBD 卷积,得到充分融合特征后的P3_3。最终将P3_3、P4_3、P5_3 分别进行1 次CBD 卷积和普通卷积,输出尺度大小为13×13、26×26、52×52 的3 个YOLO 检测头。

图7 Effi-YOLOv3 网络结构Fig.7 Structure of Effi-YOLOv3 network

2.4 损失函数的改进

IoU 是预测框与真值框之间的交并比,不仅可以用于正负样本的判断,而且是目标检测中判断预测框准确度的常用指标。YOLOv3 位置损失由中心点距离损失和预测框宽高损失组合而成,不像IoU 能直观地反映预测的准确度,因此考虑通过IoU 反映的预测框与真值框之间的偏差作为损失函数。IoU的计算公式如下:

其中:A、B分别表示预测框、真值框区域;A∩B表示两者之间的交集;A∪B表示两者之间的并集。

当预测框与真值框不重合时,IoU 值一直为0,直接使用IoU 作为损失存在一定缺陷。为解决上述问题,REZATOFIGHI 等[23]使用GIoU 作为损失函数,使得预测框和真值框在没有重叠时,也能较好反映两者之间的重叠度。但当预测框和回归框之间完全包含或者两框在水平方向和垂直方向上时,此时的GIoU 损失会退化为普通的IoU 损失,降低了模型的收敛速度。由于预测框回归包括重叠面积、长宽比和中心点距离3 个要素,因 此ZHENG 等[24]提 出DIoU 及CIoU。DIoU 将预测框与真值框的中心点距离加入了损失计算,CIoU 在DIoU 的基础上将预测框的长宽比也加入损失函数计算中。

其中:p2(b,bgt)表示预测框与真值框的中心点之间的欧氏距离;c表示能够同时包围预测框和真值框的最小闭包区域的对角线距离;α是度量长宽比相似性ν的权重系数。α与ν的定义如下:

其中:w表示预测框宽度;h表示预测框高度;wgt表示真值框宽度;hgt表示真值框高度。

3 实验结果与分析

3.1 数据集

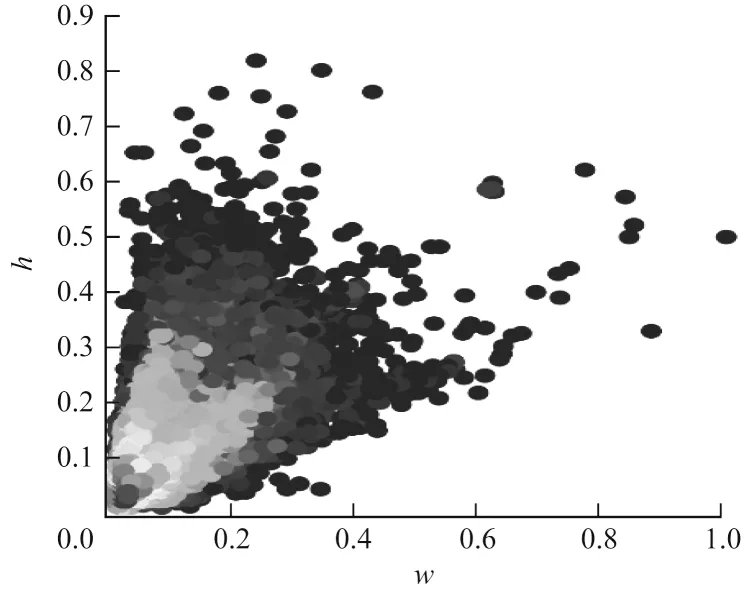

选择FLIR 公司提供的红外场景数据集,该数据集拍摄了美国加利福尼亚州的圣塔芭芭拉市的街道和高速公路,包含2017 年11 月至2018 年5 月的天气变化以及一天中不同时间的场景,图像背景有城市、山脉、隧道、树木、建筑等,背景相对复杂。训练集包含7 659 张红外场景图像,使用COCO 数据集格式进行标注,有22 372 位行人(person)、3 986 辆单车(bicycle)、41 260 辆汽车(car),共67 618 个目标。测试集包含1 360 张红外场景图像,有5 579 位行人、471 辆单车、5 432 辆汽车,共11 682 个目标。数据集中的目标尺寸分布如图8 所示,该数据集中的目标尺寸分布中小尺寸的目标较多,不同目标间的尺寸跨度较大,并且场景中目标受到不同程度的遮挡,加大了检测难度。

图8 FLIR 数据集目标尺寸分布Fig.8 FLIR dataset target size distribution

3.2 评价指标

通过平均精度均值(mean Average Precision,mAP),即各个类别的平均精度(Average Precision,AP)的均值来评价算法性能,mAP@0.5表示预测框与真值框的IoU大于等于0.5 的情况下的准确预测概率。在计算mAP前需要先计算查准率(P)和召回率(R)。查准率是指实际为正样本且被准确预测为正样本的数量与所有被预测为正样本数量的比率,计算公式如下:

其中:TTP表示实际为正样本,模型预测也为正样本的数量;FFP表示实际为负样本,但模型预测为正样本的数量。

召回率是指实际为正样本且被正确预测为正样本的数量与所有实际为正样本数量的比率,计算公式如下:

其中:FFN表示实际为正样本,但是模型预测为负样本的数量。

AP 计算公式如下:

3.3 结果分析

实验计算机CPU型号为Intel Core i7-4790、GPU型号为GTX1080、运行内存为16 GB、操作系统为Ubuntu18.04。编程语言为Python、深度学习框架为Pytorch1.4.0、CUDA 版本为10.1、cuDNN 版本为7.6.3。在训练过程中,采用Adam优化器对网络参数进行优化。在训练初始阶段,冻结骨干网络,仅对分类头进行训练,设置学习率为0.001,batchsize 为16,训练30 轮。之后将骨干网络进行解冻,对整个网络进行训练,设置学习率为0.000 3,batchsize 为4,训练170 轮。

3.3.1 Effi-YOLOv3 与其他网络模型的实验结果对比

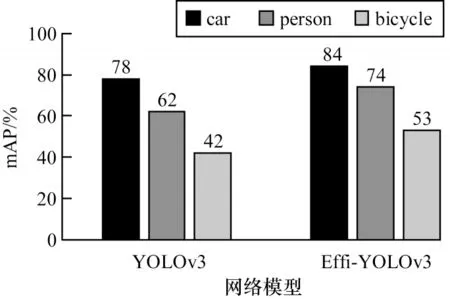

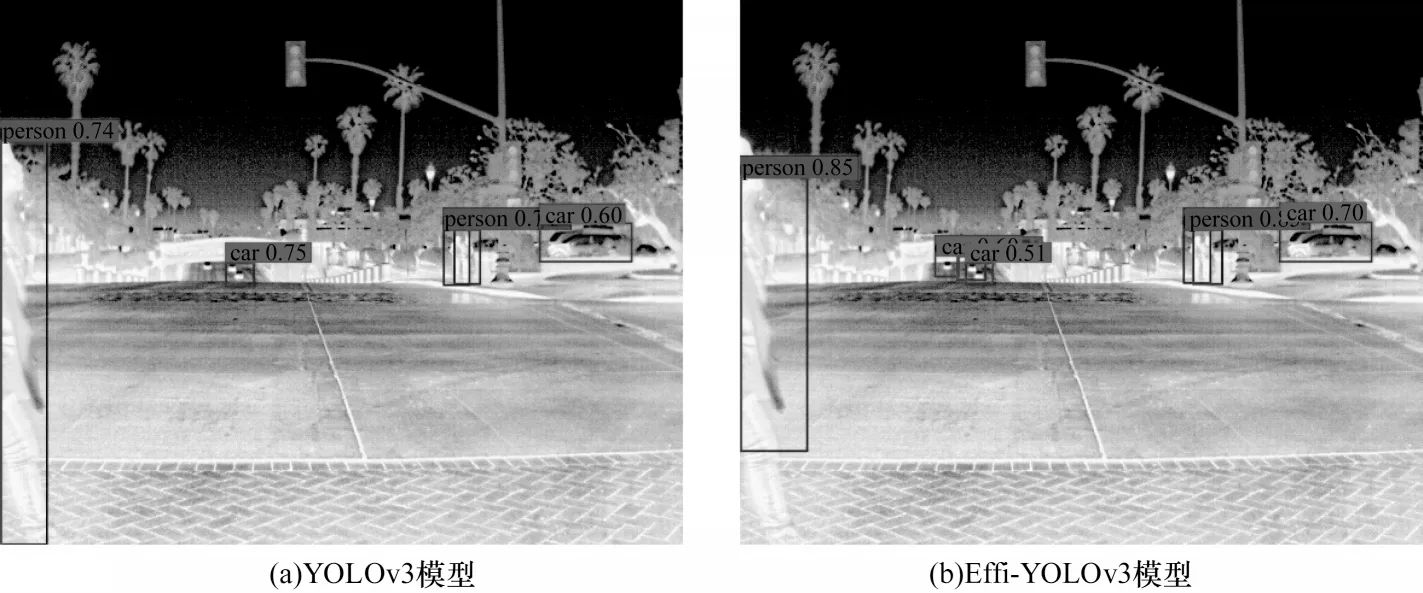

将Effi-YOLOv3 与原始YOLOv3 的检测效果进行对比,从图9 可看出Effi-YOLOv3 在3 种类别检测中均取得了较好的效果。Effi-YOLOv3 在单车类别的平均精度为53%,比YOLOv3 的42%提升了11 个百分点,行人检测从62%提升到了74%,提升了12 个百分点,检测效果提升明显。在复杂背景下的目标检测、遮挡情况下的目标检测和小尺度目标检测结果分别如图10~图12 所示。

图9 YOLOv3 和Effi-YOLOv3 对3 种目标的检测结果对比Fig.9 Comparison of detection results of YOLOv3 and Effi-YOLOv3 for three targets

图10 复杂背景下的目标检测结果Fig.10 Object detection results under complex background

图11 遮挡情况下的目标检测结果Fig.11 Object detection results under occlusion

图12 小尺度目标检测结果Fig.12 Small-scale object detection results

为进一步验证Effi-YOLOv3 模型性能,将其与YOLOv3、单阶段的SSD、两阶段的Faster R-CNN 以及当前较为先进的EfficientDet 网络模型进行对比实验,结果如表1 所示。从表1 可以看出,Effi-YOLOv3模型对红外目标的检测精度远高于其他网络模型,相比YOLOv3 模型的mAP 提升9.9 个百分点,相比当前较为优秀的EfficientDet-D1 模型的mAP 提升了4.7 个百分点。实验结果证明了改进的Effi-YOLOv3模型对红外目标检测具有更好的性能。

表1 红外目标检测实验结果Table 1 Experimental results of infrared target detection

3.3.2 消融实验结果对比

在复杂的深度学习网络背景下,采用消融实验检验去除网络中某些模块后的性能,有利于更好地理解网络中不同模块对网络检测性能的影响。为明确各个模块对于网络性能的影响,设置6 组实验分别进行训练,第1 组为原始的YOLOv3 模型,第2 组~第6 组为添加改进模块的网络模型,其中,“√”表示包含改进模块,“×”表示不包含改进模块。实验结果如表2 所示。从表2 中可以看出:在第2 组实验中,在更换骨干网络为EfficientNet 后,模型大小压缩为YOLOv3 的25.4%,在检测精度相差不大的情况下,运行速度提升了4 frame/s,说明EfficientNet 骨干网络相对DarkNet 更加轻量高效;第3 组实验增加了RFB 模块增强网络感受野,与第2 组实验的对比发现,大中尺度目标car 和person 的平均精度明显上升,分别提升了2.69 和6.11 个百分点,说明RFB 模块增大了网络模型的感受野,提升了网络对大中尺度目标的检测精度;第4 组实验增加了可变形卷积自适应调整卷积的区域及权重,对不同尺度目标的检测精度提升明显,其中由于person 通常呈现不规则形状,平均精度提升最多,增加了4.33 个百分点;第5 组实验增加了DY-ReLU,使得每一层模型自适应地调整激活率,虽然增加了一定参数量并导致运行速度略微下降,但是极大提升了对小尺度目标的检测精度;第6 组实验使用CIoU 作为损失函数,在几乎不增加参数量的情况下,提升了整体预测框的检测准确率,本组实验即改进的Effi-YOLOv3 模型。综上所述,改进的Effi-YOLOv3 模型相比原有YOLOv3模型具有明显的性能提升,更加适合红外场景目标检测。

表2 消融实验结果Table 2 Ablation experiment results

4 结束语

为提升红外场景目标检测精度,本文提出基于Effi-YOLOv3 的红外目标检测方法。将高效的EfficientNet 骨干网络与YOLOv3 网络相结合降低模型参数量,提升特征提取能力。通过改进RFB 增大网络的有效感受野,并基于可变形卷积和动态激活函数构建DBD 和CBD 结构,提升模型特征编码的灵活性及增加模型容量。实验结果表明,该方法能对红外目标进行有效检测,Effi-YOLOv3 模型参数量仅为YOLOv3 模型的33.3%,并且在运行速度比YOLOv3 模型略低的情况下,平均精度均值提升了9.9 个百分点。下一步将考虑采集更多的红外场景图像丰富训练数据集,加强对红外图像的预处理提升红外目标的辨识度,并且优化网络结构,增强模型泛化能力,在保证检测精度的同时进一步加快网络运行速度。