面向裸眼3D显示的实时多视角视频采集系统设计*

张 平,汤勇明,夏 军,吴 忠

(东南大学电子科学与工程学院,南京210096)

面向裸眼3D显示的实时多视角视频采集系统设计*

张 平,汤勇明*,夏 军,吴 忠

(东南大学电子科学与工程学院,南京210096)

针对裸眼3D显示屏研究了一种实时多视角视频采集系统。该系统使用高清网络摄像头阵列进行多视点原始画面拍摄,通过网络传输视频流,视频数据经过解码、矫正、合成等处理后变为具有多个视点(水平方向)的实时视频图像。实验结果表明,该系统较好地解决了实际拍摄中存在的畸变、图像对齐等问题,实现了实时4个视点(水平方向)的全高清视频输出,能直接在特定的裸眼3D显示器上观看。

立体视觉;实时多视角视频;摄像机阵列;矫正

实时裸眼3D多视点立体显示将是未来显示系统的主要形式,而构建实时视频源将是其中的关键技术。目前市场上多视角裸眼3D实时视频源的成熟产品较少,已有产品主要为通过2D转3D实现的非裸眼视频源,存在3D效果差,视点少等缺点。国内外相关研究也主要集中于非实时性3D视频源,这些研究往往对摄像头要求较高或者需要较多的处理时间。

东南大学对传统集成成像做了相应改进,开展了裸眼3D显示器的研究工作,提出了一种集成成像微透镜阵列制备方法[1-2],该透镜阵列可直接用于现有显示器,配合画面处理,即可实现多视角的裸眼3D效果。本文在上述基础上开展了一种面向裸眼3D显示的实时多视角视频源采集系统设计。该系统通过摄像头矩阵拍摄到不同角度的画面,针对实际拍摄中存在的问题对原图像进行矫正处理,并根据3D显示器的参数将其合成,实现多视角的3D实时视频源。

1 硬件系统

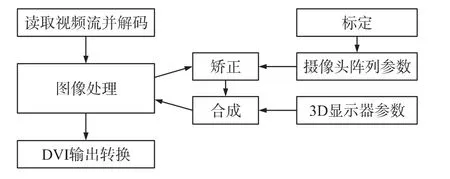

本文的多视点视频采集系统硬件体系组成如图1所示,主要可分为3部分:摄像头阵列、图像处理平台、裸眼3D显示器。摄像头阵列采用分辨率为1 920×1 080的网络摄像头水平排列而成;图像处理平台通过网络接收视频流后进行解码、矫正、合成处理,最后将其变为DVI格式(1 920×1 080)输出至裸眼3D显示器。我们选用了Tile-Gx36作为图像处理平台的处理器来满足实时性要求。Tile-Gx36芯片内包含36个64 bit RISC架构处理器核心,每个核具有1.2 GHz主频,能满足本系统中大量的图像处理运算,同时图像处理平台配备了1 000MHz的网口、4G内存为视频处理的实时性提供保障。DVI格式转换模块将运算处理完的视频图像YUV数据转换为裸眼3D显示器要求的DVI格式。

图1 硬件系统组成示意图

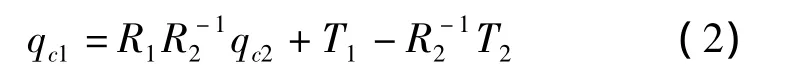

2 软件系统

图像处理平台软件工作流程如图2所示,分为读取视频流及解码、图像处理、输出DVI转换3个主要环节,其中图像处理环节的关键步骤为矫正、合成。矫正是根据摄像头模型中所介绍的参数,对原始图像进行去畸变、调整视差等处理。本系统假设工作时摄像头阵列保持固定,故该参数可通过标定提前获得。视频数据进行矫正处理后,再根据3D显示器的设置参数将多个子画面合成包含多个视点内容的画面,送至DVI输出转换模块。

图2 软件流程示意图

实时性是本系统一个难点之一。本系统对处理算法进行了大量优化,主要可分为3方面:①基于该处理器多核但各核性能不强的情况,使用 SMP Linux系统,同时将处理算法进一步细分,将计算量均摊至各个核,如图1中Tile-GX36处理器内部各个颜色表示不同的任务,相同颜色不同核为任务的进一步细分,再通过多线程技术使各个核得到充分利用。②基于该处理器浮点数运算较差的情况,将算法中的浮点数运算转化为整数运算。③基于该系统内存充足但运算量大的特点,通过增加内存使用量来减少运算量,如将部分计算通过查表方式实现。

3 摄像头模型

设Q(X,Y,Z)为实际世界中的一点(称该坐标系为世界坐标,该坐标系用大写XYZ表示,下文相同),q(x,y,f)为成像平面上一点(称该坐标系为相机坐标,该坐标系用小写xyz表示,f为焦距下文相同),O为摄像头的光心(即为相机坐标原点),如图3所示,通过旋转和平移可把世界坐标系变为相机坐标系,即Q在相机坐标系上为[R|T]Q。

图3 摄像头成像模型

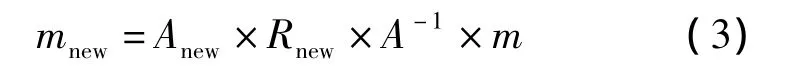

摄像头拍摄可简化为图中模型。故世界坐标Q和相机坐标q存在。至此,我们再引入像素坐标m(u,v),由于最后画面是以像素(整数)来表示,单位像素对应相机坐标为dx,dy。同时由于工艺等原因,像素坐标中心不可能100%在中心光轴上,故引入cx,cy,来表示像素平面中心对光轴的偏移。由此,我们可推出式(1):

当有多个摄像头时,由于摄像头物理上不能做到完全对齐,成像平面必然不可能做到完全平行,最有可能两摄像头成像平面交错,且Z轴上也未对齐。从单个摄像头的旋转和平移可以推出式(2):

其中,qc1为摄像头1坐标,qc2为摄像头2坐标,R,T分别为各自的旋转和平移矩阵。由此可以得到摄像头1基于摄像头2的旋转和平移矩阵。将该原理推广到更多的摄像头,假设都以某个摄像头为基准得到相应的旋转和平移矩阵,即可得到所有摄像头的位置信息。

4 标定和矫正

摄像头拍摄到的画面存在不同程度的畸变。根据Brown[4]提出的畸变模型,畸变主要分为两种:径向畸变和切向畸变。一般情况下离光心越远,畸变越大。有以下畸变公式:

径向畸变:

切向畸变:

摄像头标定主要用于计算式(1)中的内参数矩阵A,R、T为旋转和平移矩阵,Q为世界坐标,畸变矩阵D=[k1k2k3p1p2],再根据式(2)即可得到摄像头之间的位置关系。

本文利用自标定方法[5]进行标定。由上述可知,每个摄像头共有4个内参数(只跟摄像头内部参数相关),6个外参数(R、T向量,由物体跟镜头位置关系决定)及5个畸变参数。摄像头位置固定后,通过同时拍摄多幅角度不同的标定物(一般为平面棋盘格图像),假设有N幅图像(不同位置),每幅图有M个角点,则可以提供2N×M个约束,共有9+6N个未知数(每幅图内参数相同,畸变参数相同,外参不同),理论上只要2N×M>9+6N即可得到相应解。实际使用时,往往通过10幅8×8以上的图像来保证高质量结果。

矫正主要分为畸变矫正和视差矫正。根据上述畸变模型,对其做数学运算即可得到相应结果。本系统考虑到实际镜头边缘畸变太大,故等比例裁掉相应区域。如原1 920×1 080裁掉后变为1 600× 900。通过保持比例不变来保证最后图像不失真。

视差是指现实世界中同一点在不同成像平面上的位移差。可分为垂直视差和水平视差。本系统目前实现效果为水平多视角画面,故视差矫正目的为消除垂直视差,调整水平视差。

由摄像机成像模型可得出,不同摄像头的坐标系通过旋转,平移必然可以重合。本文中视差矫正通过使多个坐标系达到y,z轴重合,x轴保持相应距离实现该目的。该过程主要分为3步:(1)对摄像机坐标系旋转使其平行;(2)使摄像机坐标系y,z重合;(3)调整x轴。

图4 坐标系对齐方法示意图

下面介绍一种两坐标系对齐的方法。如图4所示,先对q2坐标系进行旋转使两坐标系平行后,建立新坐标系(图中虚线),以两坐标系原点连线方向为x轴,成像平面内与x轴垂直方向为y轴,与x,y共同垂直方向即为 z轴,即新坐标系为根据该坐标系构建新旋转矩阵(由于坐标原点即光心不变,故旋转即可实现),旋转矩阵Rnew通过转置新坐标系得到。最后可以得到式(3),Anew为新的投影矩阵。

将该方法扩展到多摄像头,首先通过标定得知摄像头参数后,旋转各摄像头画面使其平行;然后确定多摄像头光心理想连线,根据上述方法将各摄像头画面投影至所需位置,如图4所示,虚线坐标系即可得到垂直视差为0的画面;最后根据3D显示器及人眼观看舒适度的需求调节x轴位置(水平视差大小)。

5 图像合成

目前市面上的裸眼3D显示器根据实现原理主要可分为视差挡板法,透镜阵列法,微镜投影法,微位相差板法,指向光源法,全息等。家用电器上透镜阵列法应用较多,主要原理为通过透镜使左右眼看到不同的子画面,从而产生立体感。

系统连接东南大学研制的集成成像微透镜阵列裸眼3D显示器作为视频输出终端。图像合成算法与该微透镜阵列的排布一致,将处理后多个摄像头画面按一定规则重新排布。本文中采用透镜阵列为4×480×1 080,即每个单元为水平分布的4个像素,共480×1 080组。通过该透镜阵列,水平方向上将有4个视场。将4个摄像头画面合成后,观察者在不同角度观看时,将看到不同的子画面,实现了多视角的需求。

6 实验系统

图5 系统实物图

本系统实物如图5所示,左边为摄像头阵列,目前为水平排布,后期可增加摄像头个数扩展成多层结构;右边为图像处理平台。

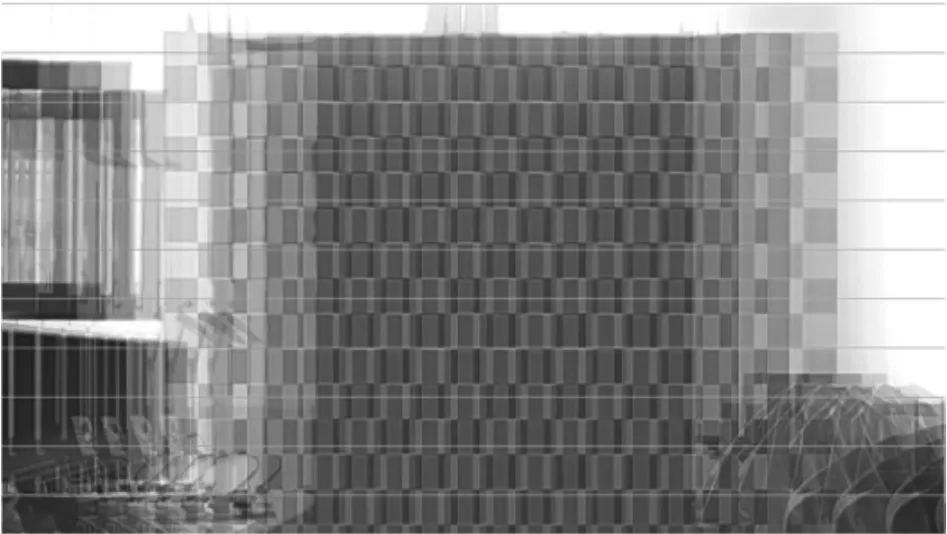

本系统最后形成水平方向具有4个视点的画面,每个视点有效分辨率为(480×1 080),但观看者观看时,显示器长宽比是16∶9(1080p格式)的。故原画面我们通过1 920×1 080的摄像头采集,使画面长宽比保持一致。4路摄像头采集数据(1 920×1 080)经处理后以DVI格式输出1080p全高清画面,DVI输出帧率为60帧/s,有效帧率为25帧/s,剩余35帧为重复25帧有效帧得到。图6为摄像头采集的原图,由该图看出,4个摄像头明显没有对齐,还存在一定倾斜。图7为矫正后效果,图中垂直视差已基本消除,水平视差基本均等。图8为合成后图,该图由图7中4幅子图水平拼接得到。观察该图,我们发现现实中的同一点在图中相应水平线上,且视差基本相等,保证了立体感及多视角的连贯性。

图6 摄像头采集原图

图7 矫正后画面

图8 合成图

7 结束语

本文开展了一种面向新型裸眼3D显示器的实时多视角视频采集系统设计,可将现实场景经多个摄像头拍摄后通过网络传输,在多核处理器内部进行相应处理转化为3D视频,该视频可在裸眼3D显示器上显示。本系统目前已实现了水平方向的4个视角、25帧/s有效帧率、单视点分辨率480×1 080,合成FHD分辨率的视频信号等功能。

[1] 程杰杰.两相流液体透镜的动态模型与仿真研究[D].南京:东南大学,2011:33-51.

[2] Xia J,Qu D,Yang H,et al.Self Assembly Polymer Microlens Array for Integral Imaging[J].Displays,2010,31(4):186-190.

[3] 缪陈峰.集成成像子图阵列获取方法的研究[D].南京:东南大学,2013:13-42.

[4] Duane C B R N.Close-Range Camera Calibration[J].Photo-grammetric Engineering,1971,37(8):855-866.

[5] Zhang Z.Flexible Camera Calibration by Viewing a Plane from Unknown Orientations[C]//Computer Vision,1999.The Proceedings of the Seventh IEEE International Conference on.IEEE,1999,1:666 -673.

[6] Taguchi Y,Koike T,Takahashi K,et al.TransCAIP:A live 3D TV System Using a Camera Array and an Integral Photography Display with Interactive Control of Viewing Parameters[J].Visualization and Computer Graphics,IEEE Transactions on,2009,15(5): 841-852.

[7] 张兆杨,安平,刘苏醒.3D多视点立体显示及其关键技术[J].电子器件,2008,31(1):302-307.

[8] 王琼华,陶宇虹,李大海.基于柱面光栅的液晶三维自由立体显示[J].电子器件,2008,31(1):296-298.

[9] Kang Y S,Lee C,Ho Y S.An Efficient Rectification Algorithm for Multi-View Images in Parallel Camera Array[C]//3DTV Conference:The True Vision-Capture,Transmission and Display of 3D Video,2008.IEEE,2008:61-64.

[10]王淑仙,汪静,邱崧,等.基于单片DMD的裸眼立体显示的实现方法研究[J].电子器件,2008,31(1):325-328.

[11]陈华华,杜歆,李宏东.平行多基线立体视觉图像校正[J].浙江大学学报(工学版),2004,38(7):799-804.

[12]Huang Y S,Xia J,Yin H C.Three-Dimensional Scene Recon-struction by Using Lenslet Array Model in Computational Integral Imaging[C]//International Conference on Optical Instrumentation and Technology.International Society for Optics and Photonics,2009: 75131E-75131E-8.

[13]郭秋艳,安平,张兆杨.基于多视点图像的摄像机自标定[J].电子器件,2008,31(1):290-295.

[14] Gary Bradski,Adrian Kaehler.Learning OpenCV[M].Oreilly,2008:406-498.

张 平(1989- ),男,汉族,浙江省绍兴市人,东南大学硕士在读,主要研究方向为嵌入式研究和应用,zping01234 @163.com;

汤勇明(1973- ),男,汉族,江苏省江都市人,东南大学研究员,主要研究方向为电子电路设计,tym@seu.edu.cn。

Glass-Free 3D Display Oriented Real-Time Multi-View Video Capture System Design*

ZHANG Ping,TANG Yongming*,XIA Jun,WU Zhong

(School of Electronic Science and Engineering,Southeast University,Nanjing 210096,China)

This paper implements a real-time system for multi-view glass-free 3D video.Its input image is captured by some high definition cameras,then it transfers the data through the net.To obtain the output video with some horizontal view angles,we process these data with decoding,rectification,composition.As the experimental results shows that the camera capturing problems like distortion and image alignment are solved and the real-time full HD video with four view angles realized by the system could be watched immediately on the specific glass-free 3D display.

stereo vision;real-time multi-view video;camera array;calibration

10.3969/j.issn.1005-9490.2014.02.009

TN27

A

1005-9490(2014)02-0210-05

项目来源:新型国家“863”项目(2012AA03A302)

2013-06-12修改日期:2013-07-07

EEACC:7200