藏文古籍图像二值化研究现状

冯炎

摘要: 藏文古籍是藏民族优秀文化宝库中的一颗璀璨明珠。由于年代久远及保存不当,古籍退化严重。二值化算法能够将退化古籍中的文本和背景分割开,更好地揭示古籍所记载内容,解决藏文古籍图像二值化时存在的质量差、对比度渐变、不均匀光照及字迹模糊等问题。参考文献的实验结果表明,众多的二值化算法中没有一个能够处理所有的古籍退化类型及所有的古籍图像数据库。为促进藏文古籍的保护和传播,对退化藏文古籍图像二值化研究迫在眉睫。该研究是古籍数字化和全文检索的必要步骤,蕴藏着巨大的应用价值。

关键词:藏文古籍; 古籍图像;二值化

中图分类号:TP391 文献标识码:A 文章编号:1009-3044(2016)27-0144-03

Abstract: Tibetan ancient document is a shining pearl of Tibetan cultural treasure-house. However, many environmental factors and improper handling cause them to suffer a high degree of degradation of various types. Binarization can segment the text from ancient document image accurately and better reveal the contents recorded in the document. As show in the Experimental Results of reference files, a problem associated with all the proposed binarization algorithms is that they can not deal with all types of degradation and with different datasets. In order to promote the protection and dissemination of Tibetan ancient document, the study of degraded Tibetan ancient document image binarization is imminent, it is also important for the ensuing document image processing tasks such as document digitization and full text retrieval and provides a huge potential market for application.

Key words: Tibeten Ancient; Historical Document Image; Binarization

1引言

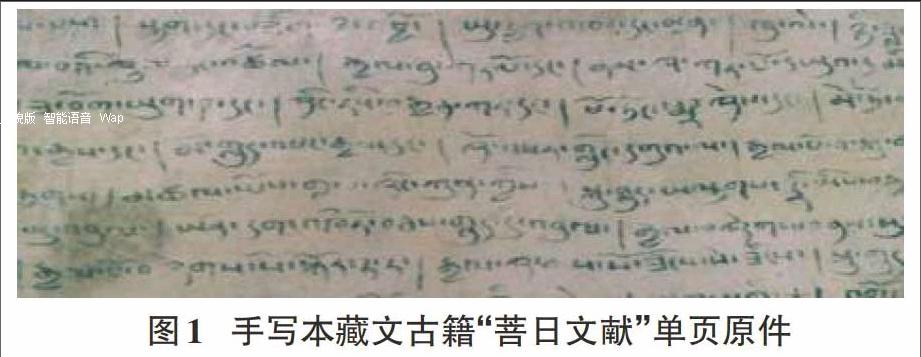

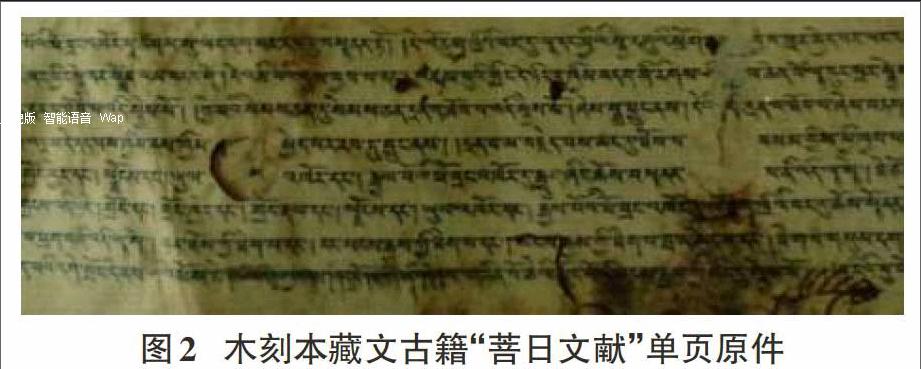

藏文古籍是研究藏族历史、政治、文化和医药等方面不可多得的珍贵史料,凝聚着千百年来藏族人民的智慧,受到国内外藏学专家的高度重视,具有重要的学术价值。长期以来,由于遭受了自然和人为因素的损坏,这些古籍均出现了不同程度的退化,有些是由于颜色退化引起的字迹不清晰,有些是由于较重的酥油污渍及人为的涂抹标记引起的印迹模糊,有些是水浸污染引起的墨迹扩散模糊。古籍所采用的古藏纸易受腐蚀、发黄变脆、色泽暗淡,经不起反复翻阅和利用。

近年来,人们越来越重视藏文古籍的保护和修复工作[1],但还面临许多问题和困难。若采用传统的原生性保护修复对本已脆弱的古籍原件进行操作,会造成无法挽救的损失,古籍数字化因其在技术上的优势及成本较低的优点,是古籍再生性保护的一种重要方式,可以更好地揭示古籍所记载内容。古籍数字化时先对古籍文献进行扫描(不能扫描的进行拍照),然后对影印本进行二值化,将退化古籍图像中的文本和背景分割开,达到妥善保护原件的目的,为藏文古籍数字化奠定基础。

目前,多数藏文古籍文献已完成写本编目、整理工作,部分古籍文献的影印本也已面世,为清晰显示古籍所记载内容,现在古籍二值化大多是通过Photoshop等图像处理软件对影印本进行人工处理。由于文献的页面数量极大,不但耗费大量的人力和时间,而且人工操作误差较大,还有图像处理工具的局限性,古籍中大量的低对比度藏文文字的修复效果基本无法令人满意,古籍原件的退化也大大增加了修复人员的工作难度。

2国内外研究现状

古籍图像是一种非常特殊的数字图像,其复杂程度远甚于普通图像。古籍图像处理和其他图像处理技术一样,是当今计算机应用领域的热点。为提高古籍图像的质量,人们研究了大量的方法和技术,这些方法中最重要的预处理步骤就是分离古籍图像的前景和背景。自20世纪70年代起,图像分割就以其在图像处理中的重要性受到人们的高度重视,也吸引了很多研究人员为之付出了巨大的努力。

古籍图像分割具有相当的难度[1]。由于边缘和噪声在频率域反映为同是高频分量,对这样的图像进行分割的结果常常把噪声当成字符而分割出来,从而给真正字符的分割带来困难。图像二值化[2]是古籍图像中文本和背景分割常用的方法。图像二值化就是将图像像素分为两类,黑色的像素作为前景,而白色像素的作为背景,从而将文本与背景分离。图像二值化算法分为全局阈值法和局部阈值法。全局阈值法如Otsu[3]提出的算法,但无法能处理复杂背景的古籍文档的情况。局部阈值法如Niblack[4]的算法,可以处理复杂背景,由于只考虑了文档的局部信息,容易将背景噪声当成字符处理。

Gatos 等[5]提出一个自适应二值化方法,该算法采用了低通滤波器和前景背景估计算法。文献[6]采用了多尺度Sauvola算法[7],然后通过统计方法来恢复丢失的笔划。文献[8]中,Valizadeh等将图像影射到二维特征空间,从而将前景和背景区分来,然后将特征空间分成更小的区域,接着应用Niblack [9] 的算法将它们分割成文本和背景。Lu等[10]提出了基于背景估计和笔划宽度估计的二值化方法,首先,通过一维迭代高斯平滑算法来估计文本图像背景,然后采用L1范数梯度图像来加快对笔划的二值化。在H-DIBCO09 会议[11]所提交的43个算法中,该算法获得了第一名。Su等[12]使用局部最大和最小算法来构造一个局部对比度图像,通过一个滑动窗口在这个图像上移动来确定局部阈值,在H-DIBCO10 会议[13]所提交的17个算法中,该算法获得了第一名。

文献[14]采用了局部对比度图像和Canny边缘图相结合的算法生成更加鲁棒的特征图,这个算法优越于文献[10][12]的采用的算法[15]。Farrahi Moghaddam 等[7]提出了一个多尺度的二值化算法,算法对输入图像的不同尺度分别用与Sauvola算法不同的参数进行二值化处理,然后合并输出结果从而产生最终输出结果,这个算法在不同的尺度用不同的参数。作为对比,Lazzara 和Gerard [16]提出了多尺度Sauvola算法,该算法采用相同的二值化算法参数对图像的不同尺度进行二值化,然后将不同尺度的二值化图像合并产生最终结果。综合性算法由于结果令人满意而受到了越来越多的关注,不同的算法结合使用时可以互补优缺点,从而提高输出结果。文献[17]提出了全局和局部自适应的二值化方法对手写文本图像二值化处理。结果显示,这个算法性能很好,然而,它仅限于处理手写文本图像。

这些年,提出了很多基于学习的算法,有三种算法[18-20]试图通过特征图来提高其他二值化算法的输出结果,有些算法试图确定每个图像二值化算法的最优参数[21,22]。在文献[18][20]中,提出了一个自我训练的文本图像二值化方法,输入的像素依赖所采用的二值化算法被分为三类型:前景、背景和不确定类型,然后通过k均值算法或马尔科夫随机域算法,将前景和背景像素划分为不同的簇,最后不确定的像素划分到最近的簇并加标记,最后决策时所使用的特征是像素亮度和局部图像对比度。文献[19]通过改进对比度特征,提出了另外一个综合性算法。Lelore 和Bouchara [23]通过粗阈值算法,将图像像素也分为三个类型,其中,无法确定类型的像素通过与前景相似的超分辨率来确定。Howe [14]提出了一个基于拉普拉斯图像的全局能量函数最优化方法,在这个方法中,采用一系列的训练图像用于最优化算法,接着,Howe在文献[21]中通过调整每个图像的两个关键参数来改进了前面的方法。文献[22]中提出了一个基于学习框架的最优参数自动选择方法,通过提取特征和所确定的最优参数,然后学习所提取的特征和最优参数之间的关系,文献说该方法对每个文本图像二值化方法所采用的参数均有效。为了自适应调节算法中的参数,Pellegrini [24]、Becker等[25]采用竞赛算法(Racing algorithms)来自动选择学习算法中的参数,从实验结果可知,竞赛算法能够有效调节算法中的参数。

综上所述,虽然这一课题的研究已经有了相当多的研究成果,从文献[15]的实验结果可知,目前这些算法没有一个能够处理所有的文本图像退化类型及所有的数据库中的文本图像,并且还存在其他一些缺陷与不足,主要包括计算耗时、需要的先验知识较多等。

3 结论

由于每种古籍所遭受的退化环境不一样,古籍中的不同的文字均有不同的直方图及不同的统计特点,每种文字还有自己独特的笔划特点,目前,关于古籍二值化的研究基本上还处于初期的探索阶段,而且针对藏文古籍二值化的研究非常少见,现有的大多数处理算法多以印刷体古籍图像为处理对象,在对退化的木刻版藏文古籍及手写藏文古籍图像进行处理时效果不理想,要最终形成成熟的应用技术,还可能需要更具创新性的研究。

参考文献:

[1]S L,C Z,P G Remote Sensing Image Deblurring Based on Grid Computation[J].Journal of China University of Mining and Technology,2006,1 6(4):409-4 1 2.

[2] Stathis, Pavlos, ErginaKavallieratou, and Nikos Papamarkos. "An evaluation survey of binarization algorithms on historical documents." Pattern Recognition, 2008.ICPR 2008.19th International Conference on. IEEE, 2008.

[3] Otsu.A Threshold Selection Method from Gray-Level Histograms.IEEE Transactions on Systems,Man and Cybernetics,1979,9(1):62-66.

[4] Niblack W. An Introduction to Digital Image Processing. Prentice-Hall,Englewood Cliffs,NJ,1986:115-116.

[5] B. Gatos, I. Pratikakis, and S. Perantonis, “Adaptive degraded document image binarization,” Pattern Recognit., 2006,39(3):317–327.

[6] R. Hedjam, R. F. Moghaddam, and M. Cheriet, “A spatially adaptive statistical method for the binarization of historical manuscripts and degraded document images,” Pattern Recognit., vol. 44, no. 9, pp. 2184–2196, 2011.

[7] R. F. Moghaddam and M. Cheriet, “A multi-scale framework for adaptive binarization of degraded document images,” Pattern Recognit., 2010, 43(6):2186–2198.

[8] M. Valizadeh and E. Kabir, “Binarization of degraded document image based on feature space partitioning and classification,” Int. J. Document Anal. Recognit., 2010,15(1):57–69.

[9] W. Niblack, An Introduction to Digital Image Processing. Englewood Cliffs, NJ, USA: Prentice-Hall, 1986.

[10] S. Lu, B. Su, and C. Tan, “Document image binarization using background estimation and stroke edges,” Int. J. Document Anal. Recognit., 2010,13(4):303–314.

[11] B. Gatos, K. Ntirogiannis, and I. Pratikakis, “ICDAR 2009 document image binarization contest (DIBCO 2009),” in Proc. 10th ICDAR, 2009:1375–1382.

[12] B. Su, S. Lu, and C. Tan, “Binarization of historical document images using the local maximum and minimum,” in Proc. 9th IAPR Int. Workshop DAS, 2010:159–166.

[13] I. Pratikakis, B. Gatos, and K. Ntirogiannis, “H-DIBCO 2010— Handwritten document image binarization competition,” in Proc. ICFHR, 2010:727–732.

[14] B. Su, S. Lu, and C. L. Tan, “Robust document image binarization technique for degraded document images,” IEEE Trans. Image Process., 2013,22(4):1408–1417.

[15] H. Ziaie Nafchi, R. Farrahi Moghaddam, and M. Cheriet, “Phase-based binarization of ancient document images: Model and applications,”Image Processing, IEEE Transactions on, vol. 23, no. 7, pp. 2916–2930, July 2014.

[16] G. Lazzara and T. Geraud, “Efficient multiscale Sauvolas binarization,” in Proc. IJDAR, Jul. 2013, pp. 1–19.

[17] K. Ntirogiannis, B. Gatos, and I. Pratikakis, “A combined approach for the binarization of handwritten document images,” Pattern Recognit. Lett., 2014 (35):3–15.

[18] B. Su, S. Lu, and C. L. Tan, “A self-training learning document binarization framework,” in Proc. 20th ICPR, Aug. 2010:3187–3190.

[19] B. Su, S. Lu, and C. L. Tan, “Combination of document image binarization techniques,” in Proc. ICDAR, Sep. 2011:22–26.

[20] B. Su, S. Lu, and C. L. Tan, “A learning framework for degraded document image binarization using Markov random field,” in Proc. 21st ICPR, 2012:3200–3203.

[21] N. Howe, “Document binarization with automatic parameter tuning,” Int. J. Document Anal. Recognit., 2013,16(3):247–258.

[22] M. Cheriet, R. F. Moghaddam, and R. Hedjam, “A learning framework for the optimization and automation of document binarization methods,” Comput. Vis. Image Understanding, 2013,117(3):269–280.

[23] T. Lelore and F. Bouchara, “Super-resolved binarization of text based on the fair algorithm,” in Proc. ICDAR, 2011:839–843.

[24]Pellegrini, P. Application of two nearest neighbor approaches to a rich vehicle routing problem. Technical Report TR/IRIDIA/2005-015 IRIDIA, Université Libre de Bruxelles,2005

[25] Becker, S., Gottlieb, J., & Stützle, T. Applications of racing algorithms: An industrial perspective. In Proceedings of the seventh international conference on artificial evolution EA05 (pp. 271–283). Berlin, Heidelberg: Springer-Verlag,2006.