基于深度强化对抗学习的图像增强方法

郭业才, 周腾威

(1. 南京信息工程大学 a. 电子与信息工程学院, 南京 210044; b. 滨江学院, 江苏 无锡 214105;2. 江苏省大气环境与装备技术协同创新中心, 南京 210044)

摄相机在弱光照或曝光不足的条件下所拍摄的图像质量偏低,易造成图像噪声大和颜色信息缺失,其分辨率和动态范围也受到一定的限制,故图像增强自动化技术的研究备受关注.Guo等[1]提出低照度图像增强(low-light image enhancement, LIME)算法,通过找到原始图像R、G、B三个通道中最大值的方法得到光照图, 再经伽马变换后得到增强图像,增强结果亮度虽得到明显提升,但易产生过增现象.Wang等[2]提出基于人类视觉系统的内容自适应直方图均衡化算法, 并根据对比度调整图像的色彩饱和度; 黄丽雯等[3]利用双边和引导滤波对经典Retinex理论进行了改进.上述传统算法均缺乏对图像语义信息的理解,增强结果泛化性较差.随着深度学习的普及,许多学者专注于将卷积神经网络应用于图像增强领域; Yan等[4]提出了基于深度学习的照片修饰方法; Yang等[5]提出个性化的照片实时曝光控制方法; Hu等[6]提出Exposure框架图像增强算法,利用深度强化学习[7]中的行动者-评论家(actor-critic, AC)算法结合生成对抗网络(generative adversarial networks, GAN)模型,将图像增强问题建模为顺序决策问题,模拟照片后期增强处理的过程.但AC算法及GAN模型训练不稳定性会导致网络获得次优的图像修饰策略,其增强结果存在过曝现象以及色彩和对比度失真等问题.针对Exposure框架存在的问题,本文提出critic正则化相对对抗优势行动者-评论家(relativistic adversarial advantage actor-critic with critic-regulatization, RA3C-CR)框架, 利用相对平均生成对抗网络(relativistic average generative adversarial networks, RAGAN)的损失函数近似AC算法中的奖励函数.当价值网络对值估计高度不准确时, 一般采用延迟策略更新方法[8]解决策略执行次优的步骤所致的误差累积, 该方法须多次训练价值网络以确保其准确度, 故耗时较长; 因此, 本文通过惩罚算法中critic的时间差分误差来约束actor的学习行为, 以期提升AC算法的稳定性及整体表现.

1 Exposure框架图像增强模型

基于Exposure框架图像增强过程建模为顺序决策问题, 定义该框架的算子集合,包括对图像曝光度、对比度、饱和度、颜色曲线、色调曲线、黑白调整以及白平衡和伽马校正等8种修饰操作.智能体从集合中选用一个操作并确定其参数值对输入图像进行修饰,系统评估该动作的优劣并进入到下一修饰状态.通过不断重复上述行为,直至获得视觉效果较好的图像.该框架利用强化学习优化算子及其参数值的决策过程, 其增强过程如图1所示.

以P=(S,A)表示该图像增强模型, 其中S为状态空间, 即原始图像以及增强进程所有中间状态的集合;A为动作空间, 即决策过程中可采用算子的集合. 以st∈S表示在第t步时智能体所处的状态,at∈A表示当前状态下采用的动作.将智能体在状态st执行动作at时转移到状态st+1的概率表示为

st+1=p(st+1|st,at),

(1)

(2)

(3)

Qπ(st,at)=Es~ρπ,a~at, φ~π[r(st,at)+γVπ(p(st,at))].

(4)

通过优势函数Aπ(st,at)=Qπ(st,at)-Vπ(st)来衡量动作at的合适程度.为模拟图像后期处理过程, 现将动作空间分为离散动作空间A1(修饰算子的选择)和连续动作空间A2(算子的参数取值范围).故上述策略π包含随机策略π1和确定性策略π2.π1为当前状态下动作a1选择的概率分布,π2为选择某动作后在该动作参数取值范围内确定其最优参数a2.算法框架主要由随机性策略网络、确定性策略网络和价值网络组成.价值网络近似计算状态值函数Vπ, 双策略网络分别根据状态-动作值函数Qπ和优势函数Aπ更新策略, 得到各状态下选择每一个动作的合理概率及最优参数取值.状态函数V以及策略函数π=(π1,π2)分别通过卷积神经网络Vω和π(θ1,θ2)近似, 其中ω,θ=(θ1,θ2)分别为价值网络和双策略网络的学习参数.时序差分(temporal-difference, TD)误差δ[9]被用作优势函数的无偏估计.通过最小化Lω优化价值网络:

(5)

由于动作分为离散和连续动作, 故分别采用随机性及确定性策略梯度算法更新模型[10-11], 策略梯度为

(6)

(7)

优势函数A可由TD误差δ进行计算, 通过式(4)代入动作值函数Q, 根据链式法则计算其梯度.参数的更新公式为

(8)

2 RA3C-CR框架

2.1 RA3C框架奖励函数

合理的奖励机制驱动强化学习算法的期望行为, 故本文提出RA3C框架, 采用RAGAN代替Exposure中的GAN模型来判别增强图像, 并近似算法的奖励函数, 以改善判别器存在的偏置情况, 稳定梯度并加快收敛速度.该相对平均判别器预测真实图像sr相对于生成图像sf更为逼真, 其鉴别行为表示为FRaD(sr,sf)=σ(D(sr)-E[D(sf)]), 其中σ为sigmoid函数,D(·)为判别器输出.定义相对平均判别器的损失函数为

(9)

r(s,(a1,a2))=logFRaD(s′f,sr)-logFRaD(sf,sr),s′f=p(sf, (a1,a2)).

(10)

奖励值越大, 表明执行动作越合适.RA3C的生成器即AC算法框架,其目的是提供最优策略使增强图像尽可能接近真实图像.因奖励函数中包含sf和sr, 生成器同时将各个状态和真实数据纳入损失函数的梯度计算中,以提升信息流的传递.因此, RA3C有助于网络学习到更合适的曝光度、对比度及图像的颜色分布, 其框架如图2所示.

2.2 CR正则化

应用critic正则化(critic-regulatization, CR)约束策略梯度算法, 将上述RA3C框架改进为RA3C-CR框架.该方法将价值网络的损失函数TD误差作为策略网络梯度的正则项来规范actor对策略的更新.避免当critic对价值函数估计极不准确时,高错误状态的actor产生次优策略引起偏差累积,提高了AC算法的稳定性及整体表现.根据式(6), 正则化策略梯度表示为

(11)

式中C(s,(a1,a2);ω)=A(s,(a1,a2);ω)-λiδ2(s,s′;ω),s′=p(s,(a1,a2)),λiδ2(s,s′;ω)为critic正则项,δ为TD误差,λi为惩罚系数. 随迭代次数i的增加, 价值网络critic对值函数的近似估计越准确, 正则项的影响逐渐减小, 故引入衰减因子k使得惩罚系数随训练进程衰减,即λi+1=kλi,0 (12) 本文选择MIT-Adobe FiveK公开数据集作为实验数据, 使用2 000张原始图像作为训练集, 2 000张专家C修饰的图像作为标签, 250张原始图像作为测试集, 在训练过程中,随机打乱标签顺序,形成训练集与标签的非成对映射,实现弱监督学习.本实验依赖于tensorflow v1.80, 运行环境为64位Ubuntu,计算机配置为CPU Inter(R) Core(TM) i8-8700 3.75 GHz, 内存为16 GB, 计算显卡为NVIDIA 1080Ti.为体现RA3C-CR框架的优越性, 采用与Exposure框架中相同的网络结构及输入输出处理方式进行对比.采用Adam算法优化所有网络.策略网络、判别网络及价值网络的学习率分别为1.5×10-5, 5×10-5,5×10-4.在训练期间, 这些学习率以指数方式衰减至原始值的10-3.设置batch size为64, critic正则项惩罚系数初始值λ1为0.1, 衰减因子k为0.98.整体框架训练时间为1.1 h. 采用图像增强优化算法LIME[1]、CLHE[2]、非成对映射数据集训练的Exposure[6]以及本文无CR正则项的RA3C方法和RA3C-CR方法进行对比实验, 结果如图3所示.由图3可见: LIME算法可使亮度明显得到提升, 但存在过度增强问题; CLHE算法下图像亮度、颜色饱和度适宜, 但图像失真; 与类似框架的Exposure相比, RA3C增强的图像更真实, 但对比度过高, 加入CR正则项后, 改善了图像的曝光度及对比度,其颜色分布也与标签图像最为接近.因此,本文RA3C-CR算法增强图像主观视觉效果与颜色自然程度最佳.此外, Exposure中GAN模型为WGAN-GP,为确保判别网络的收敛性, 其每次迭代须更新5次判别器和1次生成器,耗费255 ms, 而本算法每次迭代仅需训练1次判别器, 耗费96 ms, 总体训练时间约占Exposure的1/3.综上所述, RA3C-CR框架在收敛速度及增强效方面皆优于Exposure. 为了客观地对比各算法的增强表现, 现选取峰值信噪比(peak signal to noise ratio, PSNR)、结构相似度(structural similarity, SSIM)作为客观评价指标,验证算法的性能, 各方法评价指标平均值如表1所示.由表1可见,本文算法较对比算法具有更高的SSIM和PSNR, 说明其增强还原后的结果具有更小的失真程度, 可更有效地保持场景的原有结构,验证了RA3C-CR框架以及CR正则化有效性, RA3CCR增强的图像质量最高.为进一步验证CR正则化的有效性,计算RA3C和RA3C-CR框架每500次迭代下测试图像获得的平均峰值信噪比和结构相似度, 结果如图4所示.由图4可见,有正则项的RA3C-CR获得的平均PSNR和SSIM值更高, 且在网络训练初期价值网络高度不准确的情况下也可获得更高的指标.结果表明, critic正则化有助于提升actor-critic算法的性能. 表1 各方法在MIT-Adobe FiveK数据集 本文提出了基于深度强化对抗学习的RA3C-CR框架图像增强算法, 通过生成修饰算子序列作用于原始图像,最终实现图像视觉效果的改善.该框架使用RAGAN对奖励函数进行建模, 增强了判别器的鉴别能力.同时, 利用critic正则化约束策略梯度算法,减小价值网络估计不准确对策略更新造成的不利影响.由于本框架训练参数较少,故可移植于手机端或数码相机端处理高分辨率图像.

3 实验结果与分析

3.1 实验设置

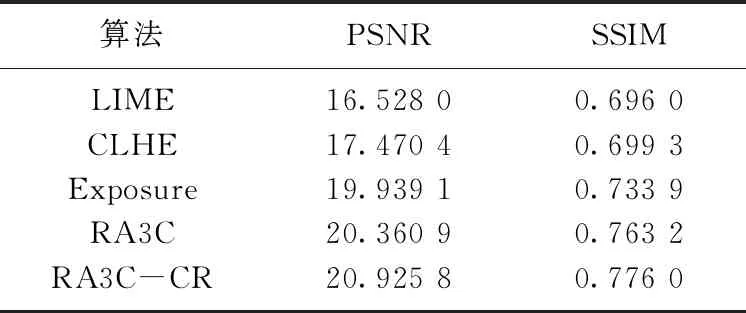

3.2 结果分析

4 结论