基于“面部表情+手”的混合手势交互技术

秦浩楠,于 鲲,卢朝茜

(昆明理工大学,云南 昆明 650500)

0 引 言

面部是身体的一部分。每个人的面部具有独特的特征。相像的两个人的面部特征也存在一定的差异,因此面部特征识别成为使用最广泛的生物特征识别方式之一[1-2]。面部识别一直是近年来研究的重点方向,为非接触式交互提供了研究平台。如今,基于人工智能的面部识别技术为面部表情的相关研究提供了技术基础。Pilarczyk等人[3]提出一种基于CNN/MMOD人脸检测器的计算机算法,通过网络摄像机获取人的面部特征信息并进行识别,其中CNN为卷积神经网络(Convolutional Neural Networks)。Jinhyuk等人[4]提出了免提自然用户界面,是一种基于头戴式显示器(Head Mounted Display,HMD)传感器的面部表情研究,实验时用户需要佩戴HMD设备。Zhang等人[5]提出了一种注视峰值应用程序,可以实时识别眼睛手势。程序把这些手势解码为预测性动作,并为用户提供一个非否认界面,可方便用户交流。Sun等人[6]提出了一种时空融合模型和多模式分层融合策略。Li等人[7]提出了一种基于手势和身体运动识别算法的机器人手臂的HRI模型。Anja和Marion[8]进行了一项可用性研究,采用头部运动和头部姿势来帮助无法使用上肢的残疾人。

面部识别相关的研究极大地丰富了多通道人机交互的研究方向,然而暂时没有对于面部表情和手部移动相结合的研究示例[9-11]。之前的大多数研究都需要用户佩戴识别设备,不仅增加了用户操作的难度,而且降低了用户操作的舒适度。本研究提出的基于“面部表情+手”的混合手势交互技术不需要用户佩戴任何设备,极大地简化了操作流程,实现了非接触式交互。

1 研究介绍

基于“面部表情+手”的混合手势交互技术基于外接摄像头和Leap Motion传感器[12-14],构建了一个交互式操作界面。通过接收面部和手部的输入数据,实现了以面部表情和手部移动方式进行目标选择和点击的操作[15]。该技术具有手部移动和面部表情两种输入方式,是一种全新的非接触式交互技术。

2 实验设备及方法

2.1 实验设备

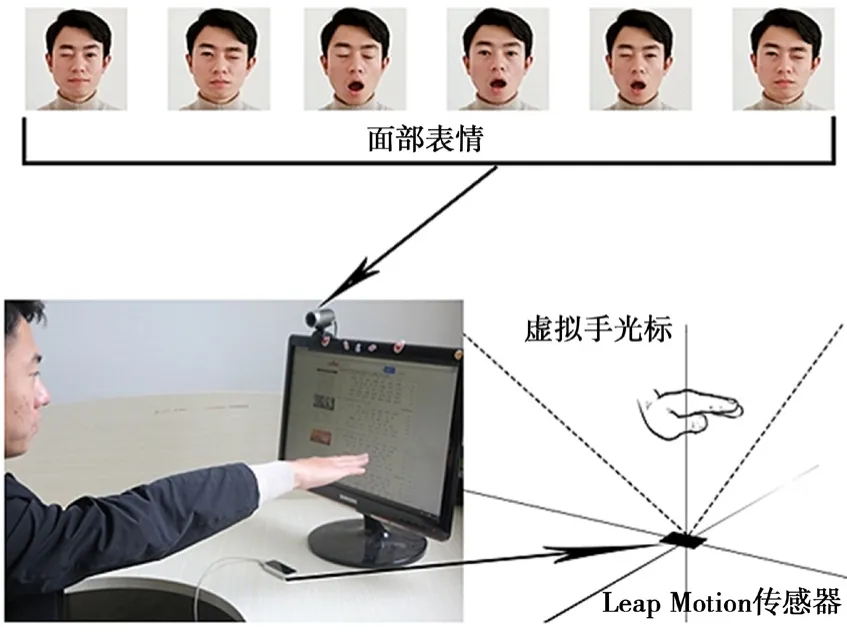

实验使用了第二代Leap Motion传感器用于识别手部移动。Leap Motion传感器放置在距离显示器底座中心边缘15 cm处。外部摄像头是Core ANC HD 1080p网络摄像头,位于显示器顶部,离显示器的左边缘8 cm,用于实时获取用户面部特征连续图像流。设定实验设备的距离仅是为了保持实验条件的一致性,减少距离不同导致的偏差。计算机显示器为三星SyncMaster SA350(分辨率为1 920×1 080像素),操作系统为Windows 10。实验设备的安装示例和混合手势交互技术的操作方式如图1所示。

图1 设备安装图

2.2 面部表情识别

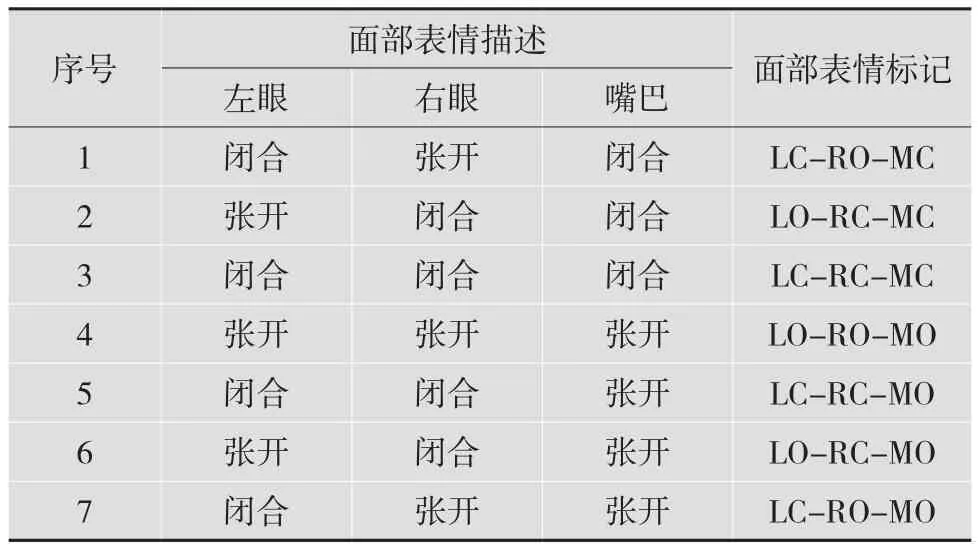

所有面部表情动作都是基于眼睛和嘴巴的张开与闭合两种状态的不同定义的。根据张开和闭合两种状态,共设定8种不同的面部表情。双眼张开、嘴巴闭合是人们正常放松时的面部表情。为了确保数据的可靠性和准确性,实验中这种面部表情被删除。剩余的7种表情是实验定义的面部表情,如表1所示。

表1 面部表情

面部表情识别通过调用摄像头拍摄用户的静态面部特征图片,并调用Face++平台URL接口将静态面部特征图片上传到Face++面部识别系统,对图片的面部特征点进行特征信息提取,最终根据提取的面部特征数据进行面部识别。

2.3 手部识别

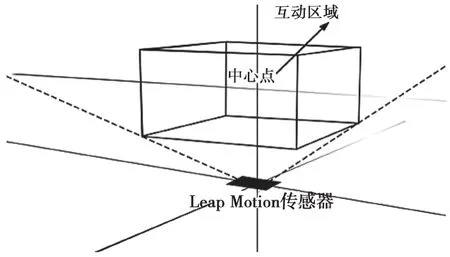

基于“面部表情+手”的混合手势交互技术对手部的识别主要是基于Leap Motion传感器。Leap Motion传感器是一种专门用于手部识别的设备。用户在操作时只需启动程序,将手部放到Leap Motion传感器的正上方,即可通过手部移动来操控鼠标光标的移动。如果用户的手或手指处于Leap Motion的交互区域,Leap Motion可以对其进行跟踪识别。在对界面进行编程时,Interaction-Box类有助于映射Leap Motion坐标。为了模拟虚拟手,实验使用了java.awt.Robot库,可以使鼠标光标随着手部的移动而移动。Leap Motion传感器的交互区域如图2所示。

图2 Leap Motion传感器识别交互区域

2.4 面部表情判定阈值

为了更加精准地识别用户的面部表情动作,识别时用户的面部表情动作要保持静止状态,并利用程序通过检测左眼和右眼的基线值区分左眼和右眼。识别过程中,通过Face++提取到的面部特征数据并不能直接反映眼睛和嘴巴的开闭状态,因此在程序中对眼睛和嘴巴的张开闭合状态定义了相应阈值。其中,设置左、右眼在张开状态时的阈值为30,设置左、右眼在闭合状态时的阈值为10,设置嘴巴闭合状态时的阈值为0,设置嘴巴张开状态时的阈值为70。

3 实验原理

3.1 实验任务

实验设置了6组不同半径的圆形按钮作为被选择的目标。6组按钮的半径分别为10像素、15像素、20像素、25像素、30像素及35像素。设定3种高度(指目标按钮界面顶部距离计算机屏幕底部的高度),分别为6.5 cm、16 cm及26.5 cm。结合6组半径和3种高度,设计出18组目标选择测试实验。

参与测试的所有实验者均身体健康,且具有一定的面部手势识别交互的经验。由于眼镜片会引起光反射,因此参与测试的所有实验者在实验中都没有佩戴眼镜。每名实验者均对18组目标选择实验进行测试。实验开始前,工作人员向每名实验者详细说明实验的具体流程,允许实验者进行10次练习。实验过程中,实验者对每个目标按钮的识别顺序依次从左到右、从上到下执行。共设定7个目标按钮,每个目标按钮对应一组面部表情动作,顺序为LORC-MC、LC-RO-MC、LO-RC-MO、LO-RO-MO、LC-RC-MC、LC-RC-MO及LC-RO-MO。

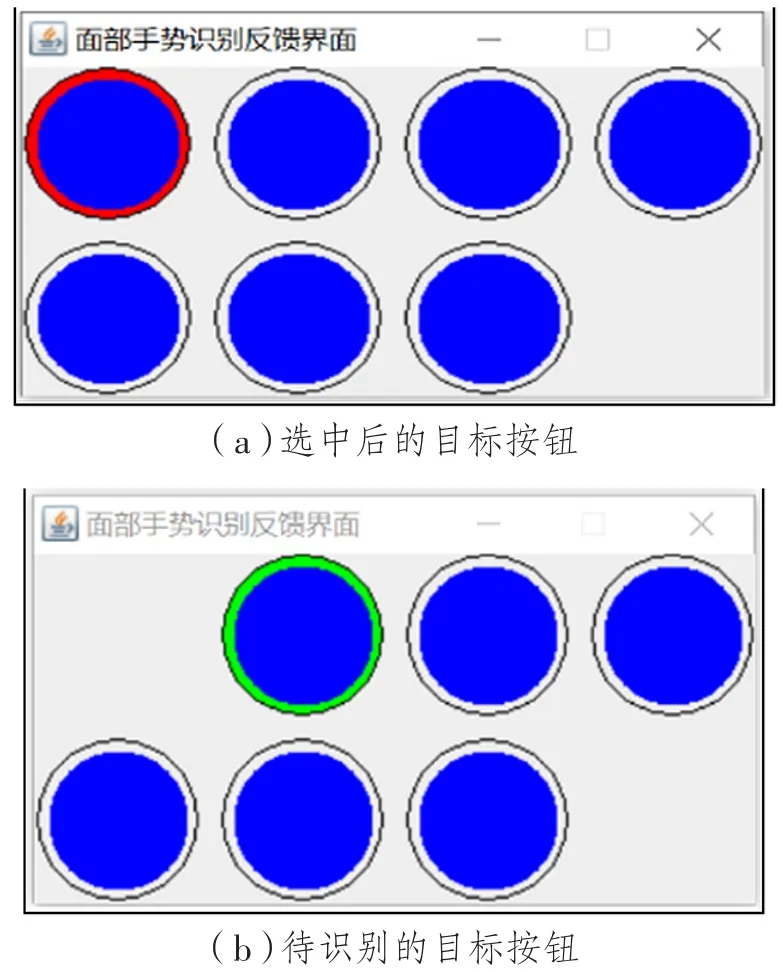

实验开始后,用户需要通过手部的移动控制鼠标光标移动到目标按钮上,选中按钮后做出与该按钮对应的面部表情并保持静止状态。面部表情识别成功后,该按钮会消失,下一个待识别的目标按钮外圈将会变成绿色,以此来提示实验者。当用户选中目标按钮时,按钮的外圈会变为红色,内圈为蓝色,此时实验者需要尽快通过手部移动控制光标选中内圈的蓝色区域。程序将外圈红色区域定义为错误识别区域,将内圈蓝色区域定义为正确识别区域。光标选中两个区域后都能进行面部识别,但只有在内圈蓝色区域内识别成功的操作才会被记录为正确识别,而在外圈红色区域识别成功的操作会被记录为错误识别。目标按钮选择的具体变化情况如图3所示。

3.2 实验流程

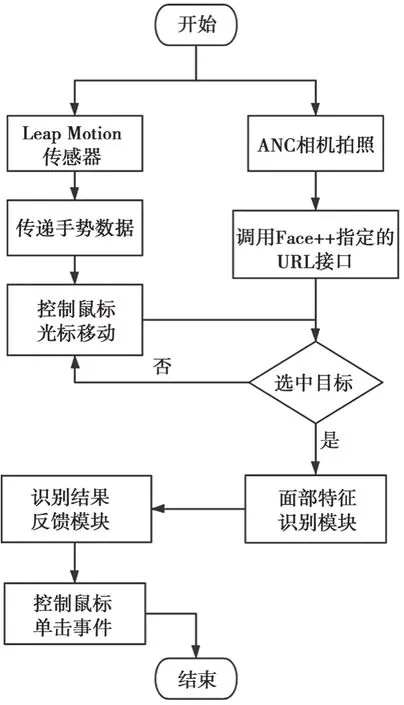

实验测试过程中,手部识别系统和面部表情识别系统是并行关系。手部识别系统程序启动后,激活Leap Motion传感器,只需将手放到传感器上方便可通过手部移动控制鼠标光标的移动。面部表情识别系统程序启动后,电脑摄像头首先被激活,程序后台自动调用Face++的URL识别接口。当实验者通过手部移动控制鼠标光标选中目标按钮时,摄像头开始实时获取实验者的面部表情特征数据。面部表情识别成功后,该目标按钮消失,下一个目标按钮继续开始识别。如果识别没有成功,摄像头将不断更新所获取的面部表情特征数据,直到识别成功。整个识别流程如图4所示。

图3 目标按钮选择的具体变化

图4 混合手势控制识别流程图

3.3 SPSS数据分析

测试完成后获得的数据主要包括识别时间和识别正确或错误的次数。经过SPSS软件双向重复测量方差分析,得出了不同目标半径(10像素、15像素、20像素、25像素、30像素及35像素)和不同目标高度(低6.5 cm、中16 cm、高26.5 cm)的变化对混合手势交互技术的平均识别时间和识别错误次数的影响。其中,目标半径和目标高度为自变量,而识别时间和识别错误次数为因变量。

3.3.1 平均识别时间

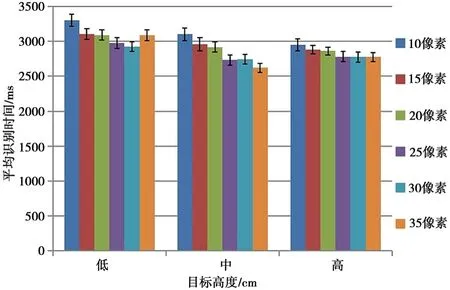

目标半径和目标高度的变化对混合手势交互技术的识别时间的影响如图5所示。其中,横坐标代表3种目标高度,6种颜色代表6组目标半径;纵坐标代表平均识别时间。

图5 不同目标高度和目标半径的平均识别时间

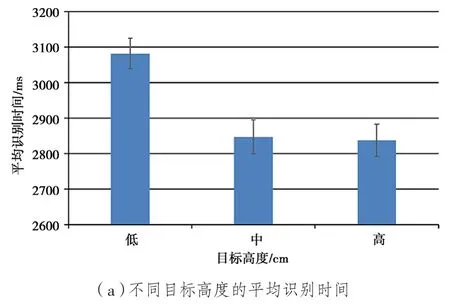

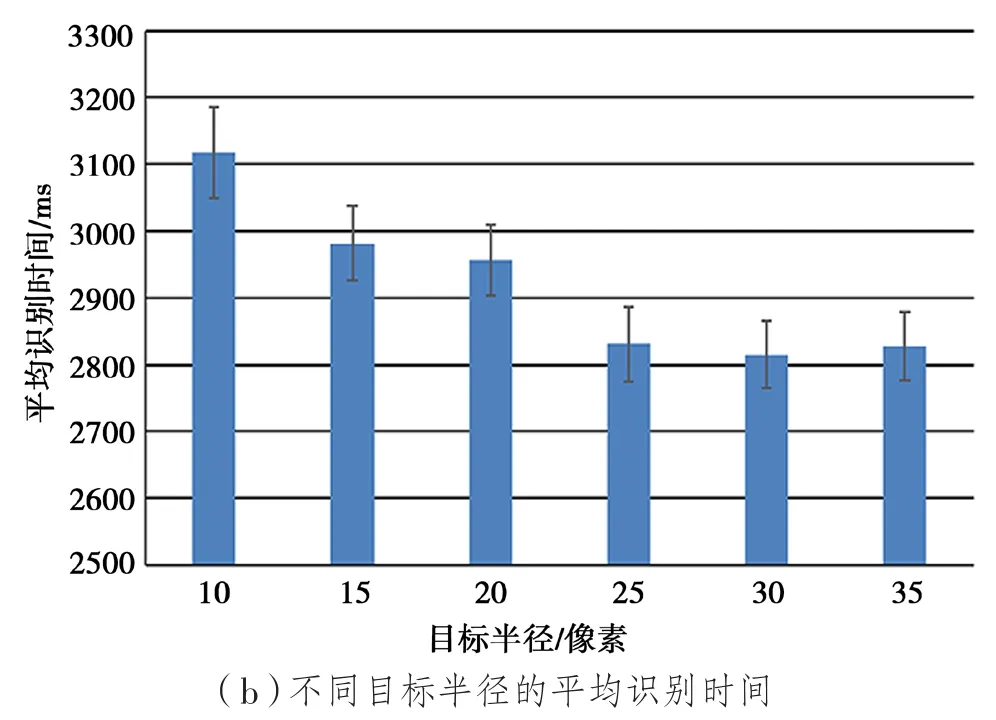

不同任务下的平均识别时间如图6所示。其中,图6(a)是不同的目标高度对平均识别时间的影响;图6(b)是不同的目标半径对平均识别时间的影响。

3.3.2 识别错误率

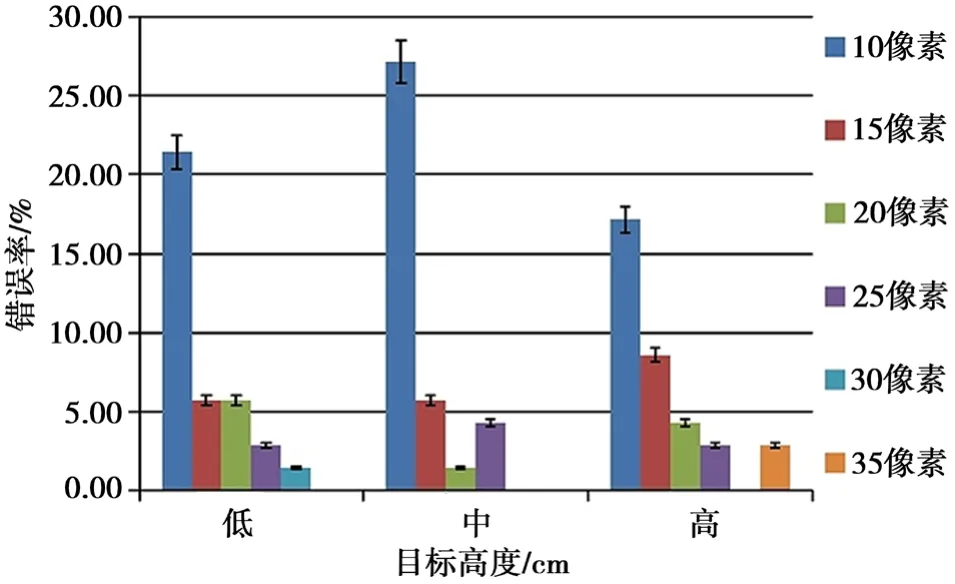

实验将实验者进行目标按钮选择识别时的识别错误次数百分比定义为混合手势交互技术的识别错误率。经过SPSS分析,得出了不同的目标半径和目标高度对混合手势交互技术的识别错误率的影响,如图7所示。

图6 不同任务下的平均识别时间

图7 不同目标高度和目标半径的识别错误率

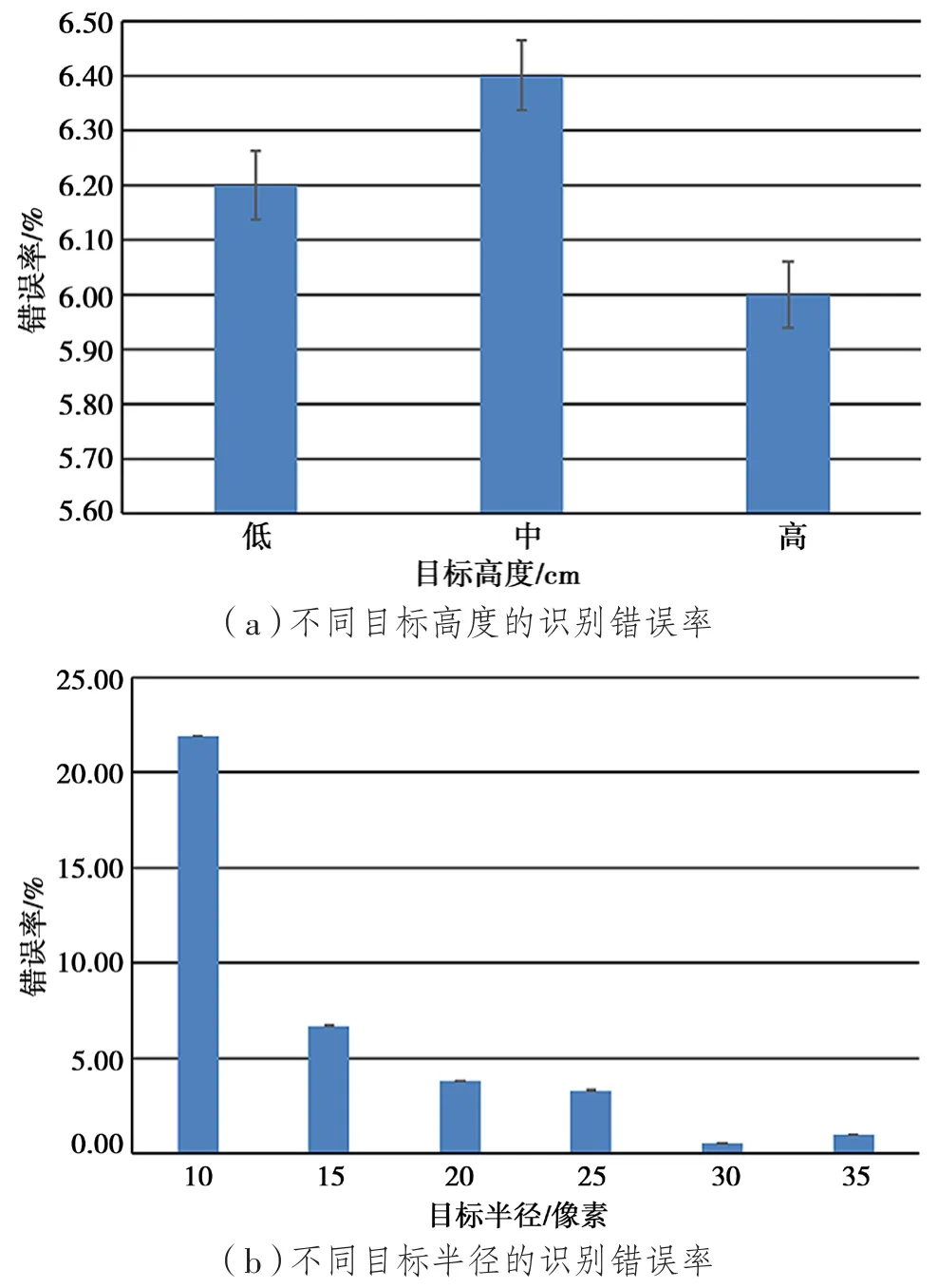

根据SPSS数据分析结果,整理出不同任务下的平均识别错误率。图8(a)是不同目标高度对识别错误率的影响,图8(b)是不同目标半径对识别错误率的影响。

4 实验结果

本实验共进行18组测试,通过SPSS数据分析后得出了不同任务条件下混合手势交互技术识别的差异。通过实验数据得出结论:

(1)目标半径为35像素、目标高度为中16 cm时,混合手势的平均识别时间最短;

(2)目标半径为10像素、目标高度为低6.5 cm时,平均识别时间最长;

(3)目标半径为10像素、目标高度为中16 cm时,识别错误率最高;

(4)目标半径为30像素、目标高度为高26.5 cm时,识别错误率最低。

可见,目标高度和目标半径的变化对混合手势的平均识别时间有显著的影响。测试数据标明,在最佳任务条件下,混合手势交互技术的整体平均识别时间为2 921 ms,整体识别错误率为6.19%(即识别准确率为93.81%)。

图8 不同任务下的识别错误率

5 结 语

提出基于“面部表情+手”的混合手势交互技术,通过手部移动控制鼠标光标移动,通过面部表情识别目标按钮替代鼠标的点击操作。研究结果表明,基于“面部表情+手”的混合手势交互技术的识别性能优良,可以满足日常的人机交互需求,实现了非接触式交互操作。由于面部表情的识别容易受到光线强弱和相机分辨率的影响,下一步将针对这两个因素对该技术进行进一步的优化。