基于FPGA的神经网络算法应用研究

刘维华

(中共陕西省委党校陕西行政学院 文化与科技教研部, 陕西 西安 710000)

0 引言

视觉神经网络算法的基本原理是以收集图像数据为基础,对外界图像进行处理,并通过GPRS无线系统将图像的信息单元以冲脉电流方式对神经网络组织进行适当的感官接触,起到视觉神经兴奋的作用,在一定的电流刺激过程中可以使人的视觉感官对眼前的事物有基本的识别能力[1-2]。尽管国内外研究学者在视觉网络辨别中取了很多的研究成果,但是受到信号交互、电极硬件设备和结构部件通讯等技术因素制约,可以实现视觉感官刺激的电流模块非常少。本研究以DretionNet模型和ReaqiueNet模型为基础,通过神经网络算法进行优化,得到基于FPGA的高效算法的神经网络模型,对其多条分支的组织结构进行优化[3-5]。根据DretionNet模型和ReaqiueNet模型的评价分析,得到两种模型针对神经网络算法的改进点,并以设备性能提升为依据,结合神经网络适应的优化设备,对原有的神经网络模型进行改进,根据优化后的神经网路模型和FPGA为基础的高速网络算法,提出多分支的深度卷积算法,根据设备中的卷积算法,运用电流脉冲和数据采集系统,更好地提升算法效率。

1 神经网络模型

1.1 DretionNet模型

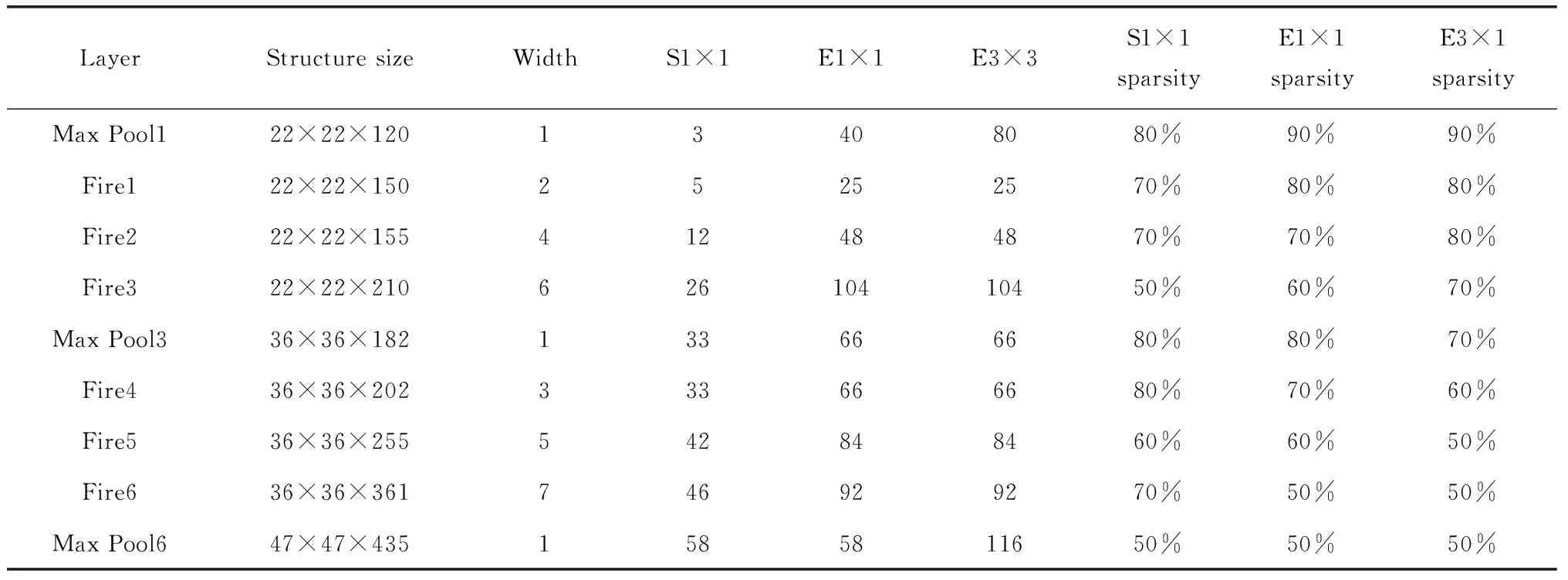

DretionNet模型相对于其他模型有更好地兼容性和可塑性,由于DretionNet模型是根据原有模型的基础改良而成,因此其参数和结构是可以结合实际情况进行改变[6]。针对模型的不同敏感参数,结合参数的变化程度可以随时调整,这样类似的改变可以有效控制研究模型被修改,导致因参数变化引起模型精准度降低的结果,此类模型特征改变在视觉神经网络算法中起到非常重要的作用[7-8]。在实际工作过程中,由于工程应用需要满足图像清晰度、像素种类识别和工程中的精准度要求,对原有的视觉神经网络按照划定的规格进行校对。DretionNet模型不仅满足模型修改过程中的兼容性,而且可以使开发者获得视觉神经网络的对应模型,DretionNet模型是可以改变的,提高了模型的构建效率和开发模式,根据DretionNet模型原始参数标准,模型参数结构,如表1所示。

1.2 ReaqiueNet模型

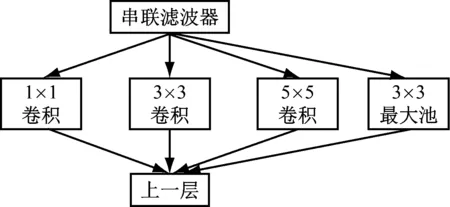

ReaqiueNet模型的主要架构是以视觉神经网络局部算法的最优解决方式进行卷积网络的模型结构实现,如图1所示。

表1 DretionNet模型参数

图1 ReaqiueNet结构

根据ReaqiueNet模型的叠加效果,其结构模型在输出结果方面一定会发生变化,在结构优化方面,模型的最高层会捕捉其形态特征,但模型的空间密集度会降低,这意味着指标层会转移到较高层次,视觉神经系统中的其他层次结构随之增加[9-10]。ReaqiueNet模型在Cliet V1、Cliet V2结构中可以继续使用等比例层次的卷积模式,尽管在模型构建过程中可以为结构层次进行替换,但ReaqiueNet模型在其他多分支结构数量中的比例没有发生变化,仍然可以保持已形成的模型数量。

2 基于FPGA视觉神经网络

2.1 网络模型多层次分支

DretionNet模型和ReaqiueNet模型在视觉神经网络计算过程中可以降低模型参数的使用量和运算过程,缓解了建模压力,从而有效提高了FPGA在大数据平台的计算能力。但是此类算法在模型构建的过程中显示出不完全的适应性,导致网络模型在工程实际过程中运算效率被降低,实验结果因此会受到影响,无法满足在实际应用中的计算步骤。结合中外学者的研究成果,以基础模型构建为基础,总结在不同网络模型中的计算缺陷,研究基于FPGA神经网络的多分支同步算法。

由于构建的参数模型对计算机硬件平台的运算条件具有很高的要求,根据DretionNet模型和ReaqiueNet模型的构建机理,以改善计算机硬件平台为出发点,结合模型多分支结构分布特点,通过对DretionNet模型和ReaqiueNet模型多层次分支结构的数据进行分布统计,并根据数据统计结果重新分流调整,确保计算精度的前提下,减缓各个分支计算路径的延迟效果。在分散的结构模型中,通过减少卷积模型数据通道的输入量,降低后期模型构建过程中运算量激增的问题,可以较好地提升计算机的硬件平台的运算效率,并降低了数据导入时间。设定第i层的图像输入量为ci×si×zi,按照卷积模型从上至下的运算顺序,则DretionNet模型和ReaqiueNet模型的参数计算量,如式(1)。

ei=ci×si×zi

(1)

若降低卷积模型的运算维度,提高数据模型的计算精度,则模型的计算参数,如式(2)。

ei,s+ei,e=ci×m+m×si×zi

(2)

式中,模型参数m不应大于公式中的其他单元参量,这样可以保证构建模型在运算过程中降低参数的数量,减少模型的体量,提升参数的运算效率。

2.2 基于FPGA结构折叠

基于FPGA神经网络的深度卷积算法中,采用深度卷积分割法对构建的模型进行分步计算,对照构建的标准模型,将一个深度卷积算法分割为1×1,3×3,5×5……(2n-1)×(2n-1)单层次的模型分量,运用FPGA将独立的卷积模量插入在每个模型的运算通道上,并按照单一的卷积模量进行重新输出,一个合理的卷积模型不仅可以满足数据的输入,还可以在新的计算过程中输出一组新的组合计算量。FPGA在深度卷积计算过程中可以把构建的模型分割为两个部分,其中一部分是将通道数据进行卷积量化,另一部分将量化的数据重新组合。

标准卷积模型参数量化并重新输出的计算方式,如式(3)。

Gi,s,n=∑i,j,mKi,j,m,n×Fi+j-1

(3)

深度卷积在模型分割为单层次结构进行重新输出的计算,如式(4)。

P=Fn×M×N×K×Di×Dj

(4)

按照标准模型卷积项M×N×K产生的特征值G,并重新输出产生GM×GN×GK的特征图,图像的特征宽度和高度满足深度卷积的计算要求,M是数据输入通道的容积量,N是数据输出通道的容积量,D是特征图像的尺寸大小。

3 结果分析

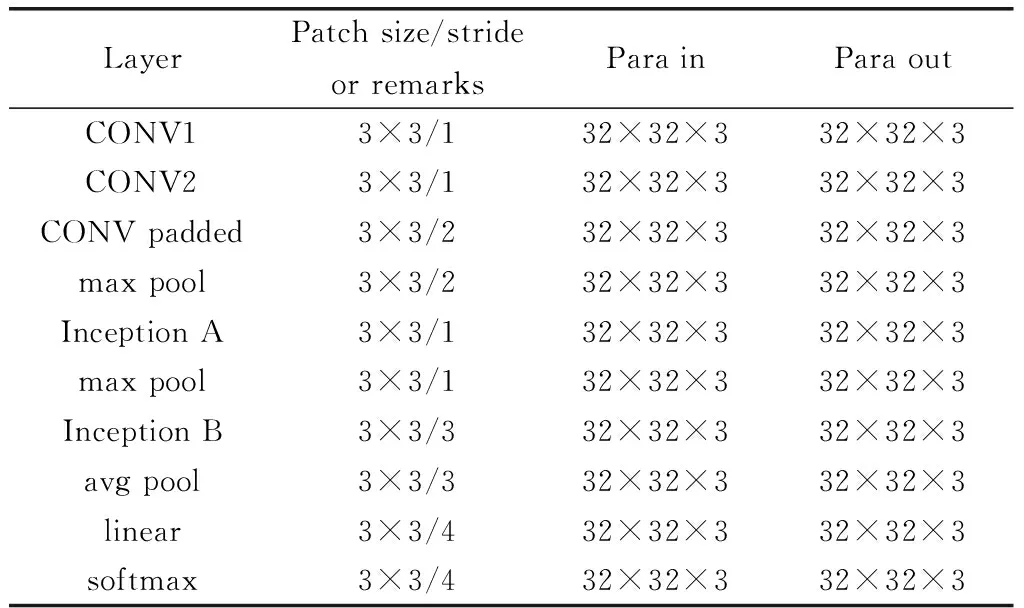

按照深度卷积模型的计算标准,基于FPGA的多分支同步算法的输出结果呈现出对称性且互不干扰,根据DretionNet模型和ReaqiueNet模型的层次结构,从模型的顶端到底部呈现相互叠加的形式,模型后一层的容积量是前一层容积量的2倍。ReaqiueNet模型运用了常见的5×5结构尺寸,并以两个结构单元为标准作为深度卷积模型的滑动窗口,构建模型的过程中采用了结构交叉方案,因此对模型边缘的数值做归一化处理不会影响结构尺寸。改良后的结构尺寸,如表2所示。

表2 改良的Inception体系结构尺寸

在5条支路模型的输入量为13×13×3,深度卷积核的数量为46组,以FPGA作为ReaqiueNet模型的优化标准,运算结束后5条支路的输出量为5×5×3,深度卷积核的数量保持不变。

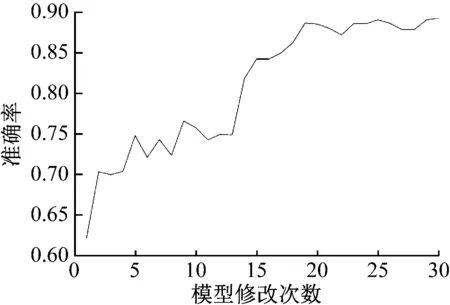

DretionNet模型和ReaqiueNet模型的准确率随着修改次数的改变而变化,如图2所示。

图2 模型修改次数与准确率比较

当修改次数低于3,模型的准确率会有较大幅度的提升,当修改次数介于3和14之间时,模型准确率在70%至75%之间震荡,修改次数大于15时,模型准确率增长速率较快,最高值可达90%。模型深度卷积次数由5×5转换为5×1/1×5,不仅提高了运算速率的准确性,而且可以保证模型结构的完整性。

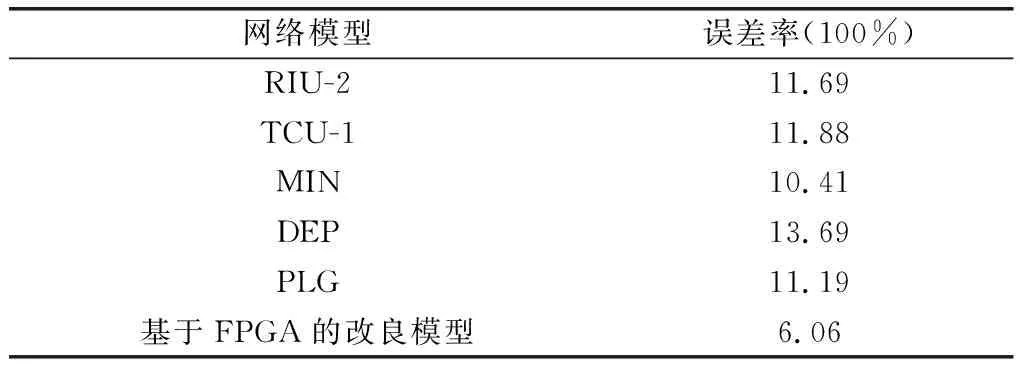

不同网络模型的误差率也存在差异,构建模型不同误差率的区别,如表3所示。

表3 不同模型数据准确率比较

由表3中统计数据可以看出,DEP模型的误差率为13.69%,MIN模型的误差率为10.41%,改良前模型平均误差率为11.78%,基于FPGA改良模型的误差率仅为6.06%,模型误差率显著下降,但改良后的模型与深度卷积模型的结构样式保持不变。

4 总结

本研究针对DretionNet模型和ReaqiueNet模型的优化改进,结合传统模型的在一般硬件设备中存在的问题,提出以FPGA为基础的高效网络模型算法,运用FPGA将独立的卷积模量插入在每个模型的运算通道上,并按照单一的卷积模量进行重新输出,当修改次数介于4与13之间时,模型的准确率会有较大幅度的提升,以FPGA为硬件改良模型的误差率仅为6.06%,显著提高了神经网络算法的识别精准度。