病理辅助诊断系统中数字滤光片的实现方法

王紫旋,谢怡宁,何勇军

摘要:病理輔助诊断系统采用在切片上放置滤光片的方法实现光源过滤,得到单色平行光,用于计算图像的光密度参数来反映切片中某物质含量。但滤光片的使用不仅会导致图像的颜色对比度降低,从而干扰医生后续诊断、增加误诊可能性,而且提高了支出成本。为了解决该问题,训练CGAN模型实现无滤光图到有滤光图的转换,取代硬件滤光片,并将训练好的模型称作数字滤光片。为提高数字滤光片性能,在生成器中添加全尺度跳跃连接以提高生成图像质量,在损失函数中添加积分光密度的约束以利于准确测量生成图像的细胞核积分光密度。实验表明,数字滤光片可达到硬件滤光片的滤光效果,生成图像在视觉效果上逼近真实滤光图像。在计算细胞核积分光密度的任务上,生成图像与均值为119的真实滤光图像偏差5.3%,表现效果分别比CycleGAN、pix2pix、pix2pixHD方法提升10.9%、3.2%、6.1%。

关键词:医学研究;条件生成对抗网络;图像翻译;光密度;滤光片

DOI:10.15938/j.jhust.2022.01.006

中图分类号: TP391.1 文献标志码: A 文章编号: 1007-2683(2022)01-0040-07

Realization Method of Digital Filter in Pathological

Assistant Diagnosis System

WANG Zixuan,XIE Yining,HE Yongjun

(School of Computer Science and Technology, Harbin University of Science and Technology, Harbin 150080, China)

Abstract:The pathologyassisted diagnosis system adopts the method of placing a filter on the slice to filter the light source and obtain the monochromatic parallel light, which is used to calculate the optical density parameter of the image to reflect the content of a certain substance in the slice. But the use of filter not only reduces the color contrast of the image, which interferes with the doctors followup diagnosis and increases the possibility of misdiagnosis, but also increases expenditure costs. In order to solve this problem, the CGAN model is trained to realize the conversion from unfiltered image to a filtered image, which is used to replace the hardware filter, and the trained model is called a digital filter. In order to improve the performance of the digital filter, a fullscale jump connection is added to the generator to improve the quality of the generated image, and the integral optical density constraint is added to the loss function to facilitate accurate measurement of the integrated optical density of the nucleus in the generated image. Experiments show that the digital filter can achieve the filtering effect of a hardware filter, and the generated image is close to the real filtered image in terms of visual effects. In the task of calculating the integral optical density of the cell nucleus, the generated image deviates 5.3% from the real filtered image with a mean value of 119, the performance is improved by 10.9%, 3.2%, and 6.1% compared with CycleGAN, pix2pix, and pix2pixHD methods.

Keywords:medical research; conditional generative adversarial network (CGAN); image translation; optical density; optical filter

0引言

在医学研究中,经常利用图像的光密度参数来反映切片中某物质的含量或反应的强度[1-2]。该操作的理论基础是朗伯比尔定律[3]:当一束平行单色光垂直通过某一均匀非散射的吸光物质时,其吸光度与吸光物质的浓度及吸收层厚度成正比,与照射光强度无关。即要通过计算图像的光密度参数来反映切片中某物质的含量,则需要满足切片被单色平行光透过的前提条件。医学研究中广泛采用在切片上放置滤光片的方法来满足该条件[4]。病理辅助诊断系统[5-6]的实现中利用到该原理。该系统首先将病理切片和滤光片置于显微镜下,进行扫描拍摄得到病理图像[7]。然后计算病理图像细胞核的积分光密度[8](integral optical density,IOD)来得到细胞核DNA含量,并给出辅助诊断结果。最后由病理医生观察病理图像,结合辅助诊断结果来给定最终的诊断结果。由上述过程可知,病理辅助诊断系统的使用中必须在切片上放置滤光片。但是滤光片的使用既会导致图像的颜色对比度降低,从而干扰医生后续诊断、增加误诊可能性,又提高了支出成本。为了解决以上问题,提出训练深度学习模型实现滤光片的功能,并将训练好的模型称作数字滤光片。在处理病理图像时,先用数字滤光片将病理图像转化为其对应添加滤光片后的图像,然后再基于转化后的图像进行IOD值的计算,用于准确反映细胞核DNA含量。数字滤光片的应用不会影响病理医生后续诊断,同时降低硬件滤光片的使用成本。据调研,目前文献上还没有用软件实现滤光片功能的相关方法报道。

数字滤光片的功能类似于图像翻译(imagetoimage translation),即将一幅图像转化为另一幅图像。图像翻译旨在通过设计端到端的模型,将源域图像转换到目标域图像。通常由源域提供图像内容,目标域提供图像“风格”(图像属性或图像风格)。在源域内容下实现目标域的“风格”化,从而实现源域图像到目标域图像的转换。目前图像翻译研究在图像的美化、风格迁移等方面取得了一定的效果[9-10]。传统图像翻译的方法主要是基于模型框架的构造和详细纹理的合成。Hertzmann等[11]进行多图像训练得到细节纹理生成模型,该模型仅利用到提取的底层特征合成新风格图像,应用在具有复杂信息的图像时效果不佳。近年来,许多基于深度学习的图像翻译方法取得了重大进展,主要可以分为两类:基于卷积神经网络(convolutional neural network,CNN)的方法和基于生成对抗网络(generative adversarial network,GAN)[12]的方法。第一类方法主要是基于CNN网络对图像进行内容和风格的特征提取,然后再将图像的风格和内容进行重塑,从而实现图像的风格翻译。Gatys等[13]采用深度卷积神经网络来提取特征,并不断地迭代优化,从而生成新风格图像。第二类方法主要采用生成对抗网络及其衍生模型,可以更好地控制图像的风格,生成更高质量的图像。Isola等[14]提出基于条件生成对抗网络(conditional generative adversarial network,CGAN)[15]的网络,实现了从源域到目标域图像的转换,是一种适用于图像翻译的通用网络。Wang等[16]在此基础上,提出多级生成网络和多级判别网络,以提高生成图像的分辨率。以上生成对抗网络采用了监督学习的方法,要求训练数据必须在源域空间和Y目标域间严格成对。然而现实中获得符合要求的成对样本往往比较困难。CycleGAN[17]、DiscoGAN[18]、DualGAN[19]引入了循环不变性损失(cycle consistency loss),通过训练两组生成器和判别器来分别学习两类图像间的来回映射,解决了在图像翻译任务中模型需要成对数据才能训练的问题,实现了非成对数据的训练。上述方法只能实现两个域间的变换。若涉及到多域变换问题,则需要分别为每一对图像域构建合适的模型,不仅降低操作效率,而且影响生成图像的质量。基于以上原因,Yunjey Choi等[20]提出了StarGAN,将目标域的信息作为标签,通过对域标签的控制来实现多域变换。

图像翻译方法可以将图像转化成对应添加滤光效果的图像,实现数字滤光片功能。但以上图像翻译方法生成的图像主要追求人眼视觉效果。本文实现的数字滤光片用于病理辅助诊断系统,由数字滤光片生成的图像不仅要满足符合人眼视觉效果,还要有利于精准测量图像中细胞核IOD值。因此本文采用pix2pix[14]框架实现数字滤光片,并在pix2pix的生成器中添加全尺度跳躍连接以提高生成图像质量,在损失函数中添加IOD的约束以利于准确测量生成图像的细胞核IOD。实验结果表明,本文实现的数字滤光片生成图在视觉效果上与真实滤光图像逼近;在计算细胞核IOD任务上,生成图像的细胞核IOD值与均值为119的真实滤光图像偏差5.3%。因此本文实现的数字滤光片能够有效实现数字滤光,可取代硬件滤光片。

本文创新点表现在:①提出并实现数字滤光片,数字滤光片可取代硬件滤光片;②为提高数字滤光片的滤光效果,在pix2pix的生成器中添加全尺度跳跃连接,并在损失函数中加入IOD的约束。

1数字滤光片的实现

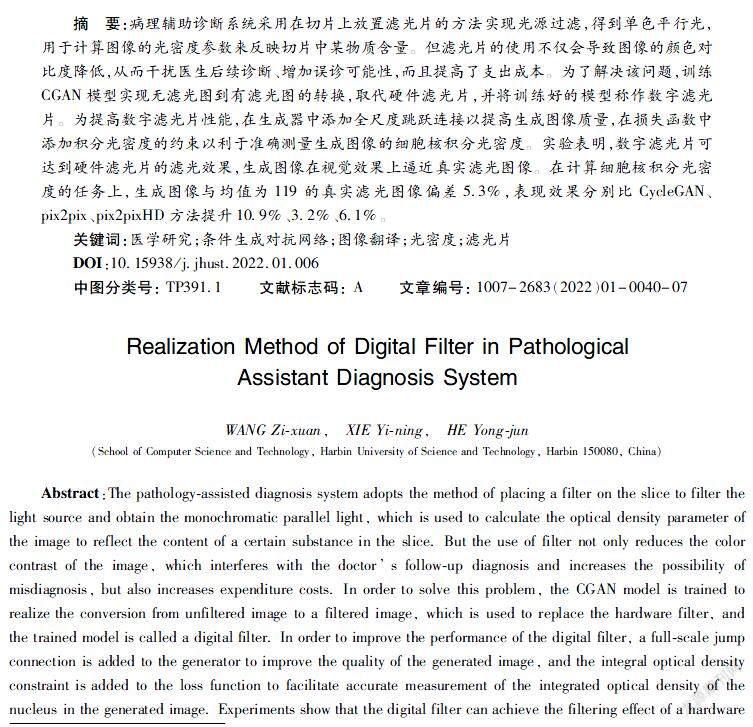

1.1方法流程

数字滤光片的原理是利用pix2pix具有图像翻译的特性,实现由无滤光图像到有滤光图像的映射。具体实现方法如图1所示。首先采集显微镜下病理切片图像,得到病理图像;然后对病理图像进行预处理和数据增强,得到数据集;最后为提高滤光效果,对pix2pix进行改进,并用训练集对改进后的模型进行训练。训练完成的生成网络即可用作数字滤光片。

1.2采集显微镜下病理切片图像

采集图像时所用的显微镜为OLYMPUS BX43型号,所用的高清数码摄像机的分辨率为2048×2048,其中CMOS相机在20倍物镜下的像素约0.11μm2,图像位深度在8bit到24bit之间,灰度在256级以上,帧率为80帧/s。

准备好宫颈细胞病理切片并对细胞核进行染色,然后将病理切片置于显微镜下,分别在有滤光片和无滤光片的情况下对切片进行扫描拍摄。因pix2pix需要成对数据,故两种情况下拍摄时的光照和切片拍摄位置都尽量保持一致。采集得到对应细胞位置大致相同的有滤光片和无滤光片两组病理图像,每组各含50张2048×2048的图像。

为方便人眼观看图像,不加滤光片时使用彩色相机进行拍摄采图。因有滤光的病理图像仅用于计算细胞核IOD值,而IOD值基于灰度图进行计算,所以添加滤光片时使用黑白相机进行拍摄采图。

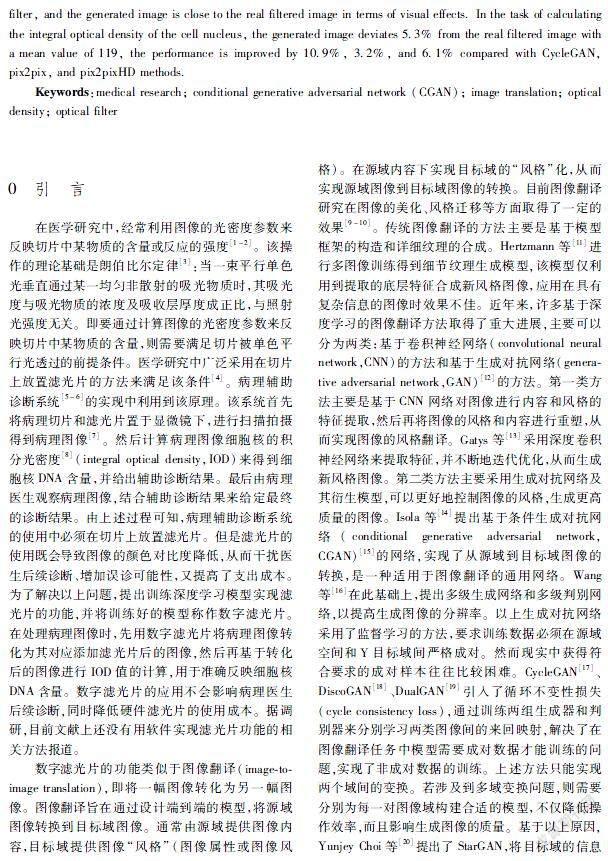

1.3数据预处理与数据增強

pix2pix的训练需要对齐数据,本文在损失函数中添加的约束项也基于严格对齐的数据来进行计算。上述步骤在拍摄成对的有滤光片和无滤光片图像时,虽然尽量使两种情况下切片的拍摄位置保持一致,但还是会使对应图像中的对应细胞位置产生轻微错位。错位情况如图2(a)所示,其中A为无滤光片彩色相机拍摄图像,B为有滤光片黑白相机拍摄图像。因此需要对采集到的两组病理图像进行预处理,使其达到像素级别的精准对齐,如图2(b)所示。

数据预处理过程如图3所示。首先,输入图像A和图像B;其次,对A和B进行图像二值化操作;然后,遍历A图中的所有轮廓,对于当前轮廓a,若在B图中找到一个轮廓b,使两个轮廓的最小外接矩形中的所有像素值都相等,则两轮廓为完全对应轮廓;接着判断a和b的相对位置,并根据该相对位置来裁剪B图,使得b在裁剪后B图中坐标与a在A图中坐标相同;最后以(1024,1024)像素点为中心,分别在A图和裁剪后B图上裁剪1792×1792大小的图像,得到精准对齐的图像A和B。

经数据预处理后,得到了50组1792×1792大小的精准对齐的成对图像。对所有图像进行十六等分切割,为提高数字滤光片鲁棒性,对图像进行翻转、旋转、缩放、裁剪、移位、添加高斯噪声、转置输入、模糊等数据增强操作。成对图像采取相同的操作,保证了操作后成对图像仍精准对齐。经上述操作后,得到8000组448×448大小的成对图像。

1.4数字滤光片的实现模型

本文使用基于CGAN的pix2pix框架实现数字滤光片。为提高数字滤光片性能,在pix2pix的生成器中添加全尺度跳跃连接以提高生成图像质量,并在损失函数中添加IOD的约束以利于准确测量生成图像的细胞核IOD。

1.4.1生成器

生成器以输入的病理图像为条件,生成满足条件且与真实滤光图像难以分辨的病理图像。pix2pix框架的生成器G采用Encoderdecoder结构,并在每一个i和n-i层之间添加跳跃连接,其中n是总层数。

为了获取更多输入图像的信息,使生成图像具有更多细节特征,使得数字滤光片取得更好的滤光效果,本文参照Huang等[21]提出的 UNet 3+结构,在pix2pix的生成器中添加全尺度跳跃连接。但与UNet 3+不同的是,本任务经实验对比,采用平均池化从较小规模的编码器层获取底层信息,采用双立方插值从较大规模的解码器层传输高级语义信息,会达到比原始UNet 3+中的跳跃连接更好的效果。经本文改进后的生成器结构如图4所示。输入图像首先经过8层卷积层提取特征,然后经由8层反卷积层还原放大至原图大小。其中卷积核的大小均为4×4。

1.4.2判别器

判别器的作用是在输入的病理图像的条件下,对生成器生成的图像判断为假,对真实滤光图像判断为真。此处的判别器D采用了条件判别器 PatchGAN[14],加快计算以及收敛。

1.4.3损失函数

原始CGAN的目标函数为

LcGAN(G,D)=Ex,y[logD(x,y)]+

Ex,z[log(1-D(x,G(x,z)))]

其中:G代表生成器;D代表判别器;x代表输入到生成器网络中的不添加滤光片的图像;y代表训练集中x对应的真实滤光图像;z代表输入噪声。

pix2pix在原始CGAN的基础上添加了式(2)所示的L1 Loss,得到最终的目标函数如式(3)所示:

LL1(G)=Ex,y,z[||y-G(x,z)||1](2)

G*=argminGmaxDLcGAN(G,D)+λLL1(G)(3)

其中λ表示L1正则化约束所占据的比例参数。

本文实现的数字滤光片,具有硬件滤光片的滤光效果。真实滤光图像是在添加滤光片后由黑白相机拍摄得到的灰度图像,根据其计算出的细胞核IOD最能准确反映细胞核IOD。因此,将生成图像

与真实滤光图像的细胞核IOD的平均绝对误差作为MAE Loss,如式(4)所示:

LMAE(G)=Ex,y,z[1n∑ni=1|yi_IOD-G(x,z)i_IOD|]

其中:yi_IOD和G(x,z)i_IOD分别表示真实滤光图像与生成图像中第i个对应细胞核的IOD值;n表示两张图像共同识别出的对应细胞核的数目。

在光学领域,IOD的计算公式[8]如式(5)所示:

IOD=∑OD=∑log(Ia/Ib)(5)

其中:Ia为光线通过介质前的入射光强度;Ib为通过介质后的透射光强度。在图像处理领域,图像光照的变化可反映为图像灰度值的变化。在实际计算时,使用图像的背景灰度值表示Ia,用被测量物体的灰度值表示Ib。

将MAE Loss作为惩罚项加入到pix2pix的损失函数中,可以使本文的数字滤光片更好地实现硬件滤光片的功能。改进后的pix2pix的目标函数为

G*=argminGmaxDLcGAN(G,D)+λ1LL1(G)+λ2LMAE(G)(6)

其中:λ1和λ2分别表示L1正则化约束和LMAE(G)惩罚项所占据的比例参数,参数λ1延用pix2pix中设定的值,λ2的值设为1。

2实验分析

2.1数据集准备

在数据预处理与数据增强步骤中,得到了8000组448×448大小的精准对齐的成对图像。随机选取其中6400组图像作为训练集,剩余1600组图像作为测试集。

2.2评价指标

本文将网络生成图与真实滤光图的对应细胞核IOD的平均绝对误差(mean absolute error,MAE)作为评价指标,来衡量本文方法的优劣。具體公式如式(7)所示。

MAE=1n∑ni=1|yi_IOD-G(x,z)i_IOD|(7)

其中:n表示两张图像共同识别出的对应细胞核的数目;yi_IOD和G(x,z)i_IOD分别表示真实滤光图像与生成图像中第i个对应细胞核的IOD值。

2.3实验过程

实验采用Pytorch 1.4.0深度学习框架,在Linux Ubuntu 18.04.2操作系统下运行,配有4个NVIDIA GeForce RTX 2080 Ti显卡,CPU为12核的Intel(R) Xeon(R) CPU E5-2678 v3 @ 2.50GHz,内存125G。为解决模型训练优化过程中可能出现的学习率消失等问题,使用Adam[22]函数作为优化器,初始参数β1和β2设为0.9、0.999,∈设为1×10-8,初始学习率设为0.001。

在网络训练阶段,将无滤光图输入到网络的生成器G中,得到假的有滤光图。将假的有滤光图和真实滤光图输入到网络的判别器D中,Patch的大小设置为70×70。判别器D来判别当前图像是真实的有滤光图还是假的有滤光图。网络的生成器和判别器联合进行训练,对一方参数进行更新时,另一方的参数保持固定,然后交换参数固定方与更新方,双方不断进行博弈、优化。

在测试阶段,将训练好的生成器用作数字滤光片,然后取测试集中的无滤光图,输入到数字滤光片中,得到生成的有滤光图。

2.4实验结果展示与分析

将本文方法的滤光效果与无滤光效果、CycleGAN[17]滤光效果、pix2pix[14]滤光效果、pix2pixHD[16]滤光效果进行对比。

2.4.1人眼视觉效果

以测试集中一张图为例,各方法的滤光效果如图5所示。

由图5可以看出,与真实滤光图相比,CycleGAN网络生成图的细节不清晰、细胞核颜色过深;pix2pixHD生成图的清晰度要远大于真实滤光图,导致部分细胞核的细节颜色较深;pix2pix生成图虽然在整体视觉效果上逼近真实滤光图,但个别

细胞核却有较大差距(例如图像底部中间位置的细胞核);本文方法生成图在整体视觉效果和具体细节上均表现较好,与真实滤光图逼近。

2.4.2MAE定量评估

测试集中真实滤光图像的细胞核IOD均值为119,记作M。针对测试集中图像,计算各方法生成图与真实滤光图的对应细胞核IOD的MAE,并计算各MAE值占M的比例。各方法对比结果如表1所示。

如表1所示,Ours的MAE/M值为5.3%,说明本文方法生成图的细胞核IOD与真实滤光图的对应细胞核IOD仅相差5.3%。同时,Ours的MAE/M值明显小于不添加滤光片时的值,说明本文方法生成的有滤光图大大降低了与真实滤光图的差距。以上两点都说明了本文实现的数字滤光片可以很好地将无滤光图转化为有滤光图。此外,Ours的MAE/M值明显小于其他方法,说明相较于用其他方法实现的数字滤光片,本文实现的数字滤光片效果更好。

实验还选取了一些含较多团状细胞、细胞模糊的图像进行测试。测试结果分别如表2、表3所示。

如表2、表3所示,对于团状细胞较多、细胞模糊等复杂图像,相较于其他方法,本文实现的数字滤光片也表现优异。

3结论

针对病理辅助诊断系统中硬件滤光片技术会干扰医生诊断、增加支出成本等问题,本文训练CGAN模型实现滤光片的功能,并将训练好的模型称作数字滤光片。为提高数字滤光片的滤光性能,在生成器中添加全尺度跳跃连接以提高生成图像质量,在损失函数中添加IOD的约束以利于生成图像的细胞核IOD的准确测量。实验表明,本文实现的数字滤光片生成图在视觉效果上与真实滤光图像逼近;在计算细胞核IOD任务上,生成图与与均值为119的真实滤光图偏差5.3%,分别比CycleGAN、pix2pix、pix2pixHD方法提升了10.9%、3.2%、6.1%。因此该技术的采用可以取代硬件滤光片,实现对图像的有效滤光。

参 考 文 献:

[1]汪薇, 王诗航. 光密度值测定在实验医学研究中的应用及意义[J]. 解剖科学进展, 2006(3):286.

WANG Wei,WANG Shihang. Application and Significance of Optical Density Value Measurement in Experimental Medical Research[J]. Progress of Anatomical Sciences, 2006(3):286.

[2]李志华, 夏潮涌, 黄中新, 等. 乳腺癌细胞核DNA含量不同分析方法的比较[J]. 中国体视学与图像分析, 2003(3):154.

LI Zhihua, XIA Chaoyong, HUANG Zhongxin, et al. Compare the Difference on Measuring Methods of DNA Content of Breast Cancer[J]. Chinese Journal of Stereology and Image Analysis, 2003(3):154.

[3]李朋軍, 夏潮涌. 肿瘤细胞DNA干系倍体分析及其临床应用[J]. 中国体视学与图像分析, 2005(2):72.

LI Pengjun, XIA Chaoyong. Analysis and Clinical Application of DNA Stemline Ploidy of Tumor Cells[J]. Chinese Journal of Stereology and Image Analysis,2005(2):72.

[4]魏清柱, 夏潮涌, 刘江欢. 滤光片对细胞核DNA含量检测的影响[J]. 中国体视学与图像分析, 2009,14(3):292.

WEI Qingzhu, XIA Chaoyong, LIU Jianghuan, et al. The Influence of Filter on Measurement of Nuclear DNA Content[J]. Chinese Journal of Stereology and Image Analysis,2009,14(3):292.

[5]新型乳腺癌病理诊断辅助系统[J]. 上海生物医学工程,1998(4):36.

New Pathological Diagnostic Aid for Breast Cancer[J]. Shanghai Journal of Biomedical Engineering, 1998(4):36.

[6]王继伟, 樊伟, 陈岗, 等. 基于深度卷积神经网络的数字病理辅助诊断系统设计[J]. 中国数字医学, 2020,15(12):48.

WANG Jiwei, FAN Wei, CHEN Gang, et al. Design of the Digital Pathologyassisted Diagnosis System Based on the Deep Convolutional Neural Network[J]. China Digital Medicine, 2020,15(12):48.

[7]卢祎,张雪媛,何勇军.基于焦平面估计的快速扫片方法[J].哈尔滨理工大学学报,2020,25(1):51.

LU Yi, ZHANG Xueyuan, HE Yongjun. Fast Scanning Method Based on Multipoint Focusing[J]. Journal of Harbin University of Science and Technology, 2020,25(1):51.

[8]李枫. 图像分析中光密度参数物理意义的正确理解和使用[J]. 解剖学杂志, 2009,32(2):271.

LI Feng. Proper Understanding and Use of the Physical Meaning of Optical Density Parameters in Image Analysis[J]. Chinese Journal of Anatomy, 2009,32(2):271.

[9]陈淑環, 韦玉科, 徐乐, 等. 基于深度学习的图像风格迁移研究综述[J]. 计算机应用研究, 2019,36(8):2250.

CHEN Shuhuan, WEI YuKe, XU Le, et al. Survey of Image Style Transfer Based on Deep Learning[J]. Application Research of Computers,2019,36(8):2250.

[10]LEDIG C, THEIS L, HUSZR F, et al. Photorealistic Single Image Superresolution Using a Generative Adversarial Network[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 4681.

[11]HERTZMANN A, JACOBS C E, OLIVER N, et al. Image Analogies[C]//Proceedings of the 28th Annual Conference on Computer Graphics and Interactive Techniques, 2001: 327.

[12]GOODFELLOW I, POUGET A J, MIRZA M, et al. Generative Adversarial Nets[J]. arXiv:1406.2661.2014..

[13]GATYS L A, ECKER A S, BETHGE M. A Neural Algorithm of Artistic Style[J]. arXiv Preprint arXiv:1508.06576, 2015.

[14]ISOLA P, ZHU J Y, ZHOU T, et al. Imagetoimage Translation with Conditional Adversarial Networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 1125.

[15]MIRZA M, OSINDERO S. Conditional Generative Adversarial Nets[J]. arXiv Preprint arXiv:1411.1784, 2014.

[16]WANG T C, LIU M Y, ZHU J Y, et al. Highresolution Image Synthesis and Semantic Manipulation with Conditional Gans[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 8798.

[17]ZHU J Y, PARK T, ISOLA P, et al. Unpaired Imagetoimage Translation Using Cycleconsistent Adversarial Networks[C]//Proceedings of the IEEE International Conference on Computer Vision, 2017: 2223.

[18]KIM T, CHA M, KIM H, et al. Learning to Discover Crossdomain Relations with Generative Adversarial Networks[C]//International Conference on Machine Learning. PMLR, 2017: 1857.

[19]YI Z, ZHANG H, TAN P, et al. Dualgan: Unsupervised Dual Learning for Imagetoimage Translation[C]//Proceedings of the IEEE inTernational Conference on Computer Vision, 2017: 2849.

[20]CHOI Y, CHOI M, KIM M, et al. Stargan: Unified Generative Adversarial Networks for Multidomain Imagetoimage Translation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 8789.

[21]HUANG H, LIN L, TONG R, et al. Unet 3+: A Fullscale Connected Unet for Medical Image Segmentation[C]//ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2020: 1055.

[22]KINGMA D P, BA J. Adam: A Method for Stochastic Optimization[J]. arXiv Preprint arXiv:1412.6980, 2014.

(編辑:温泽宇)