机器学习中差分隐私的数据共享及发布:技术、应用和挑战

胡奥婷 ,胡爱群 ,胡 韵 ,李古月,3 ,韩金广

1 东南大学网络空间安全学院 南京 中国 211189

2 东南大学信息科学与工程学院 南京 中国 210096

3 网络通信与安全紫金山实验室 南京 中国 211111

4 南京财经大学江苏省电子商务重点实验室 南京 中国 210023

1 引言

数据分析和发布技术使得数据分析者可以学习大数据的共有规律。其中,统计信息分析[1-2]和机器学习是热门应用领域。然而,所有的数据分析任务如不添加合适的隐私保护技术都有可能泄漏个人隐私信息。这导致如今数据拥有者由于担忧个人隐私泄漏问题不愿贡献个人数据供第三方使用。欧洲针对此类问题,已经出台了《通用数据保护法规》(GDPR)规定第三方数据使用者有权保护个人隐私。

1.1 隐私保护背景

首先,本文举例描述数据分析任务场景以及可能存在的隐私威胁。图1 为Adult 公开数据库的片段截取示例。在Adult 数据库中,每一行代表一条个人(隐私)信息。数据分析者想要分析数据库中所包含的模式规律。例如,统计问题“数据库中有多少人的信息满足属性P?”属性P 可以是“年收入超过50K?”或者“年龄超过50 岁”,或者两者的交集。机器学习二分类任务可以是“基于个人的其他信息预测该人的年收入是否超过50K”。

为了在保护数据拥有者的个人信息的同时允许数据分析者分析数据中暗藏的模式,传统隐私保护方式有非交互式和交互式两种。其中匿名化为非交互式保护方式。匿名化指数据收集者把能表示个人身份信息的唯一识别号(例如身份证号,学号,姓名等)从原始数据库中去除再发布。然而,Sweeney[3]提出87%的美国人可以通过邮编、出生日期和性别这三个组合属性唯一识别,这暗示仅仅去除唯一识别号不足以保护个人身份不被泄漏。随后,Narayanan和Shmatikov 提出链接攻击(linkage attack)[4]。该攻击通过将一个公共数据库的信息链接到私有数据库从而暴露私有数据库里的隐私属性。为了应对该攻击,k-匿名[3]、l-多样化[5]、t-近似[6]等技术相继提出。但是,这些攻击或受到背景知识攻击影响,或缺少严谨量化的隐私定义。这些技术假设数据集中的属性可分类为隐私属性和公共属性。隐私属性需要保护而公共属性可以公开。但根据后来研究表明[7],隐私属性和公共属性并不存在明显的分界,因为任何属性组合皆有可能泄漏个人的独有特征规律。这个结论尤其符合如今的大数据环境。

当非交互式数据发布难以两全个人隐私保护和数据分析任务时,交互式问答成为研究者的新方向。然而,直接回答关于数据库的统计问答也有可能会泄漏个人隐私,例如差分攻击。攻击者向某医疗数据库提问“数据库中有多少人患有癌症?”和“有多少除了小明的人患有癌症?”可以直接差分出小明是否患有癌症。

在以上案例场景中,隐私保护目标是在不违反个人隐私的条件下允许数据分析者学习群体规律。因此,如何定义个人隐私泄漏至关重要。从信息论的角度上分析,群体规律的学习必然会导致数据分析者得到更多的信息以猜测个人隐私。例如,某调查结果“肺癌和吸烟有紧密关系”必然会增强攻击者猜测吸烟人群是否患有肺癌的正确概率。在图1 中,某机器学习分类器获得80%的测试集正确率。然后其预测个人年薪是否超过50K 的正确率会从原本的50%提高到80%(假设income 属性平衡)。这些情况是否能称为隐私泄漏?现有的隐私定义难以回答这类定性问题,因此需要新的隐私保护定义。

差分隐私(Differential Privacy,DP)定义了“合理的可否认性”[8],即某条个人信息是否参与调查,调查结果都维持“大致”相同。这等同于保证攻击者几乎无法察觉某个人的信息是否用于计算调查结果。“大致”是由隐私预算ε 控制。该参数提供隐私和实用性的折中。在实际应用中,差分隐私机制向调查结果中加入一定量的噪声。噪声的量由隐私预算ε 和问题敏感度控制。敏感度度量了两个汉明距离为1的数据库回答同一个问题的最大差值。

如今,差分隐私已经成为执行隐私保护的实际标准。微软[9]、苹果[10]、谷歌[11-12]、美国人口调查局[13]、哈弗大学PSI 项目[14]等都通过利用该技术分析敏感数据。本文旨在分析差分隐私技术在机器学习领域用于隐私保护的理论与应用。通过剖析差分隐私与机器学习交叉领域技术,提出该领域存在的问题和可能的解决方向。

1.2 相关研究介绍

近年来有以下与差分隐私相关的综述性分析。在这些综述分析中,Dwork 等人[2]首先给出隐私保护分析中存在的问题以及初步的差分隐私解决方案。Dwork 和Roth[15]总结了到2014 年为止差分隐私出现的理论性技术。Sarwate 和Chaudhuri[7],Ji 等人[16],Goryczka 等人[17]和Jain 等人[18]分别强调信号处理、机器学习、多方安全计算、大数据中存在的差分隐私问题。Zhu 等人[19]介绍了差分隐私的数据共享和分析,与本文目标类似。然而近年来,随着差分隐私技术及机器学习技术的迅速发展,许多新的理论突破和实践层出不穷。因此本文将涵盖更多新发展的技术和问题。

本文旨在帮助读者迅速了解差分隐私的进化发展历程,并熟悉差分隐私机制的在机器学习领域的应用。图2 给出常见的隐私数据分析场景架构,其中数据拥有者提供敏感数据集;服务提供者,例如机器学习服务提供商(Machine Learning as a Service,MLaaS)负责数据分析和以及用户隐私保护;常规用户旨在获取查询结果,同时恶意用户可能成为窃取隐私信息的攻击者。

后文结构如下:第2 节介绍差分隐私的定义、实现机制、常用性质定理;第3 节介绍机器学习领域热门的威胁模型、攻击以及与差分隐私的联系;第4节介绍差分隐私机制在机器学习中两种热门模型:鉴别模型(discriminative model)以及生成模型(generative model)中的运用;第5 节总结差分隐私在机器学习领域应用存在的公开问题和研究方向。

2 差分隐私预备知识

2.1 差分隐私

2.1.1 定义

直观上,差分隐私向数据拥有者保证:无论某一条数据是否存在于隐私数据集D中,调查结果大致不变。首先,定义相邻数据集(neighboring datasets)为:数据集D和数据集D′相差一条个人信息xi∊N|X|,即汉明距离dHD,D=1。差分隐私定义为:

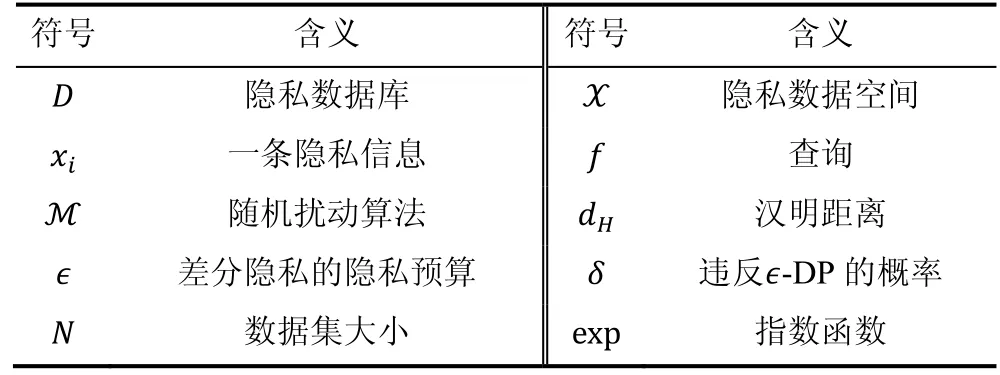

表1 常用符号Table 1 Notations

定义1.∊-差分隐私[8].对任意相邻数据集D和数据集D′和任意算法结果S,随机算法M如果满足

则M是∊-差分隐私。概率空间由M的随机性算法决定。

在定义1 中,隐私预算∊是乘性界限的自然对数。小的隐私预算∊指数据集D和数据集D′分布距离更小,即一条隐私数据的信息对结果的影响力十分有限。因此,小隐私预算∊意味着更高的隐私保护力度。

2.1.2 机制

纯粹的差分隐私可以通过拉普拉斯(Laplace)机制、指数机制和随机应答(randomized response)实现。

1) 拉普拉斯机制

拉普拉斯机制[8]旨在向数字查询结果f:N|X|→Rk添加校准噪声。例如,在图1 中,某计数查询或分数查询为“有多少人的年收入超过50K?”。为了保证相邻数据集对同一个问题的答案差距足够小,我们需要度量查询f的敏感度(sensitivity)。在拉普拉斯机制中,用ℓ1度量敏感度,定义如下。

定义2.ℓ1敏感度.ℓ1-敏感度定义了相邻数据集D和D回答问题f结果的最大差

其中‖∙‖1是一阶范数。

根据定义2,计数查询的ℓ1-敏感度为1。分数查询的ℓ1-敏感度为1/N,N为数据集D的大小.

由于定义1 中应用乘性距离,添加拉普拉斯噪声天然满足差分隐私。尺度为b、中心为0 的拉普拉斯分布的概率密度函数为据此,拉普拉斯差分隐私机制如下:

定理1.拉普拉斯机制[8].给定数值查询函数f,隐私数据库D和拉普拉斯噪声Y~如下随机扰动函数ML满足∊-差分隐私。

定理1 的合理性可以通过计算MLD,f,∊在相邻数据集上结果的最大差值对数比得出。

根据定理1,拉普拉斯机制ML的噪声被缩放为用以满足∊-差分隐私。因为噪声大小与隐私损失∊成反比,所以隐私损失∊越小,所添加的的噪声幅度越大,则查询结果越不准确。因此,隐私损失∊控制隐私与效用之间的折中。

2) 指数机制

不同于拉普拉斯机制,指数机制[20]旨在向非数值型查询函数f:N|X|→R结果r ∊R添加噪声,特别是选择最优解。对于有些无法直接向答案中添加噪声的非数值型问题和有一些直接添加噪声会破坏数据可用性的数值型问题,例如医疗记录、产品名称等查询,指数机制通过定义效用函数u:N|D|×R →R将输入输出对映射为一个实数。效用函数u定义首选对获得更高的分数。效用函数的敏感度定义如下:

据此,差分隐私的指数机制MED,u,R有如下定理:

因此满足∊-差分隐私。

3) 随机应答机制

拉普拉斯机制和指数机制都是在交互式问答的查询结果中添加噪声以满足差分隐私,而随机应答应用于非交互式场景。它直接向本地个人信息中添加噪声,然后发布净化的本地信息。该机制适用于收集众包数据(谷歌、苹果,微软等公司运用该技术收集用户信息,如输入习惯、表情包喜好等)。随机应答机制[21]早在差分隐私提出之前就已经广泛使用。但是后来证明其满足差分隐私要求。

回顾图1,数据分析者想了解“Adult 数据库中多少比例的人群年收入超过50K?”。拉普拉斯机制要求有某个可信数据中心先收集所有用户的真实答案,计算查询结果再添加差分隐私噪声。而在随机应答模式中无需可信数据中心。数据分析者获取查询“某个人年薪是否超过50K”的扰动答案,再自行聚合扰动答案以逼近真实答案。具体操作如下:每个参与回答“年薪是否超过50K”的人,都扔一枚硬币,如果是“字”即诚实回答,如果是“花”则再扔一枚硬币,硬币是“字”回答“是”,硬币是“花”回答“否”。假设真实答案中“是”的比例为q,那么扰动回答中“是”的比例则为q=0.5*q+0.25。当发布了一批扰动答案后,数据分析者估计真实“是”比例为2*q-0.5。据此,数据分析者既获得年收入大于50K 的人数比例,个人信息得到了保护。在该机制中,参与问答的用户越多,数据分析者得到的查询结果越准确。因此当数据量稀少时,不适合该机制。

根据以上随机扰动案例,令单个查询函数为f,随机应答机制为MRD,f,∊,对任意x ∊D和其随机应答r,满足

同理,

因此,随机扰动算法MRD,f,∊满足3-差分隐私。更广泛的,在二元分布中,给定随机应答机制

2.1.3 性质

差分隐私定义的广泛使用离不开其满足的性质:合成定理(composition)、对辅助信息的鲁棒性、抗后处理(post-processing)、群差分隐私(Group Differential Privacy,GDP)。这些性质可以保证差分隐私适应于模块化设计。

1) 合成定理

合成定理[15]使得差分隐私可优雅的模块化叠加。多步差分隐私算法作用于同一数据库,其隐私消耗线性叠加。

定理3.合成定理[15].令D为隐私数据库,f为查询函数。同时输出扰动结果M1D,f,∊1,M2D,f,∊2满足∊1+∊2差分隐私。

2) 对辅助信息的鲁棒性

差分隐私的保护效果应不受攻击者掌握的背景知识多少影响[15]。该性质可利用贝叶斯定理比较攻击者先验和后验的攻击优势差。令攻击者对数据集D分布的先验知识为pD,扰动机制MD,f,∊输出结果为r。由定义1 可知,pr|Dpr|D≤exp∊,在等式左边使用贝叶斯定理得

3) 抗后处理

抗后处理定理指对某个差分隐私的结果做后续分析不会削弱其差分隐私保护效果。

定理4.抗后处理定理[15].令M:N|X|→R是∊-差分隐私机制,g:R →R为任意函数。g ˚ M:N|X|→R依然是∊-差分隐私。

该定理保证了,如果算法M是∊-差分隐私,无论数据分析者如何使用差分隐私的结果,利如使用算法g对M的结果做进一步数据分析,都不会降低算法M对隐私数据的保护效果。

4) 群差分隐私

群差分隐私保护“关联的隐私数据”。当多个隐私数据之间存在确定性或者概率性的关联时,可以将其当作一个群组。群差分隐私定义隐私损失随着群组大小的增大而线性增大。例如,当某调查中出现一个家庭的多条隐私数据时,他们的数据属性是高度关联的。他们可能会共享地址、邮编等。因为改变某一条记录的属性对结果产生的影响可能会比原先估计的要大。

定理 5.群差分隐私[15].某差分隐私机制MD,f,∊在群组大小为k时满足k∊-差分隐私。即,对≤k以及其可能出现的扰动结果S

该定理用于处理数据库分析中的关联数据集。但是,后续有研究指出当群数组关系为概率性而非确定性时,差分隐私会引入过多的噪声[22]。

2.2 近似差分隐私

差分隐私在实际使用中,存在几种近似定义。近似定义意在降低达成同等隐私损失∊而添加的噪声量(对比定义1)。主流的近似定义有∊,δ-差分隐私[23],Concentrated 差分隐私(CDP)[24]和zero-Concentrated 差分隐私(zCDP)[25],Moments Accountant[26],Rényi 差分隐私(RDP)[27]。其中∊,δ-差分隐私使用最为广泛。

定义3.∊,δ-差分隐私[23].对任意相邻数据集数据集D和数据集D′和任意算法结果S,随机算法M如果满足:

该定义配合高斯机制使用。高斯噪声比拉普拉斯噪声存在更为普遍,且原始数据集中可能已经包含高斯噪声。另外,高斯噪声的分布函数比拉普拉斯噪声更加集中。因此添加高斯噪声是更自然的选择。高 斯 噪 声N0,σ的 概 率 密 度 函 数 为。与拉普拉斯机制类似,高斯机制也是向查询结果中添加噪声。噪声幅度由问题敏感度与隐私预算决定。不同于拉普拉斯机制的是,高斯机制使用ℓ2敏感度度量两个查询结果的最大差别。

定义4.ℓ2敏感度[23].ℓ2-敏感度定义了相邻数据集D和D回答查询f结果的最大差:

其中‖∙‖2是欧几里德范数。

对于查询函数f,ℓ2敏感度通常要比ℓ1敏感度小(特别是敏感度小于1)。因此,需要添加的高斯噪声幅度通常要比拉普拉斯噪声小。

定理6.高斯机制[23].给定数值查询函数f,隐私数据库D 和拉普拉斯噪声N~N0,σ,如果c2>2ln1.25/δ,σ≥cΔ2f/∊,则随机函数MG满足∊,δ-差分隐私。

与拉普拉斯机制类似,高斯噪声的标准差设置小于cΔ2f/∊,其中参数c控制不满足∊-差分隐私机制的概率不大于δ。感兴趣的读者可以在文献[15]的附录A 中找到推导过程。

高斯机制的优势有:第一,差分隐私所添加的噪声可能与数据集中原本存在的噪声同分布;第二,高斯噪声的和依然是高斯噪声(拉普拉斯噪声不是);第三,高斯分布概率密度的尾端比拉普拉斯分布降速更快,即更集中。

其弱点为:第一,高斯机制为了降低同等隐私预算下的噪声添加量,遗留δ概率的完全隐私侵犯。实际使用中,我们一般将δ设置成远远小于数据库大小倒数的值,即δ ≪1/N,以保证没有用户的隐私会被侵犯。第二,虽然基于高斯机制的∊,δ-差分隐私定义与∊-差分隐私同样享有对冗余信息的鲁棒性、抗后处理、群差分隐私,但是其合成定理较为复杂。其中同质(homogeneous)∊,δ-差分隐私机制M的合成定理[28]见定理6。但是异质(heterogeneous)差分隐私机制的合成是#P-难度[29-30]。

定理7.高级合成定理(advanced composition)[28].同质∊,δ-差分隐私机制M重复输出k次对数据库D的查询结果满足差分隐私。

为了解决合成定理的难题,后续提出了其他的近似差分隐私定义。

2.2.2 其他近似定义

1) CDP 和zCDP

Dwork 和Rothbulum 提出CDP[24],其利用了亚高斯尾巴很小的特点以平均隐私损失。CDP 定义比∊,δ-差分隐私定义弱一些,但是提供更高的可用性和更优的高斯机制合成定理。其后,Bun 和Steinke[25]利用Rényi 差异(Rényi divergence)捕获两分布的差异性以提出改良的zCDP。

2) Moments Accountant

Abadi 等人[26]提出Moments Accountant 技术,用于跟踪深度学习中差分隐私预算的变化量。在第3节讲述差分隐私的随机梯度递减算法时会详述。

3) Rényi 差分隐私

2017 年,Mironov 提出Rényi 散度是差分隐私的一种天然近似形式[27]。∊-差分隐私使用最大差异(maximum divergence)来度量两个相邻数据库查询差别。而Rényi 散度使用参数α放松该最大差异条件。

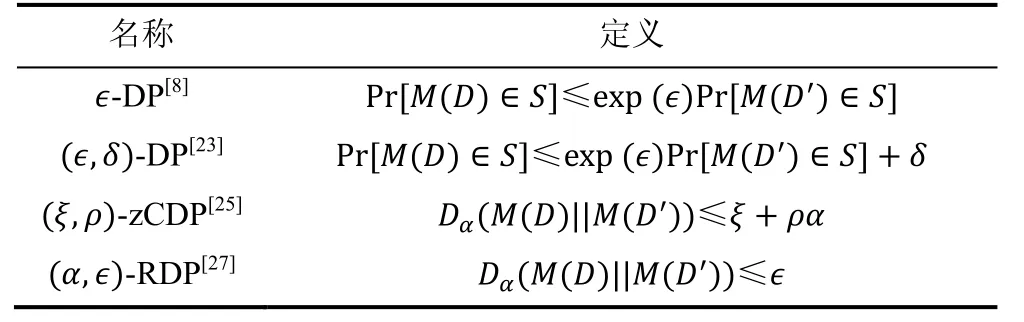

表2 中总结了几种差分隐私定义。值得注意的是,Jayaraman 和Evans 在文献[30]中对比了Advanced Composition(定理7)、CDP、zCDP 和RDP 在实际使用中的隐私预算累加效果,总体来说,RDP 表现最优。因此在机器学习领域中常采用的差分隐私机制是高斯机制。在追踪隐私预算时,使用RDP+Moments Accountant 技术,最后将RDP 中所定义的转化成∊,δ-差分隐私。据此,下文简述RDP 机制原理及其对比∊,δ-差分隐私的优势。

表2 差分隐私常见定义Table 2 Different definitions of differential privacy

理解RDP 机制首先要理解Rényi 散度的定义,以及为什么Rényi 散度是∊-差分隐私的天然泛化形式。

定义5.Rényi 散度.对分布Px和Qx,α >1条件下的Rényi 散度定义为

定义6.Rényi 差分隐私[27].对任意相邻数据集数据集D和数据集D′和任意算法结果S,随机算法M 如果满足DαMD||MD≤∊,则称为α,∊-RDP。

根据定义6,∞,∊-RDP 就是∊-DP。Rényi 差分隐私有以下两个重要性质。

定理8.α,∊-RDP 转换成∊,δ-DP[27]。对任意δ和α,α,∊-RDP 可以转换成

定理 9.RDP 的合成定理.给定α,异质α,∊i-RDP 机制Mi的累加满足α,∑i ∊i-RDP。

首先,RDP 依然享有冗余信息的鲁棒性、抗后处理、群差分隐私。更重要的是,同∊-DP,它能够优雅的累加异质差分隐私算法的隐私预算(见定理9),但是这在∊,δ-DP 定义中是难题(见2.2.1 分析)。除此之外,依据定理8,(α,∊-RDP 在累加结束后可便捷转换成∊,δ-DP 定义。之所以需要转换,是因为∊,δ-DP定义更容易理解且δ具有物理意义(即不满足∊-DP 的概率)。

RDP 的实现机制?RDP 有多种实现机制,其中高斯机制较为常用。当查询f的ℓ2-敏感度为1 时,添加N~N0,σ噪声的高斯机制MG满足α,α/2σ2-RDP。该证明可以由直接计算两个高斯分布的DαN0,σ,Nμ,σ的Rényi 散度得出。

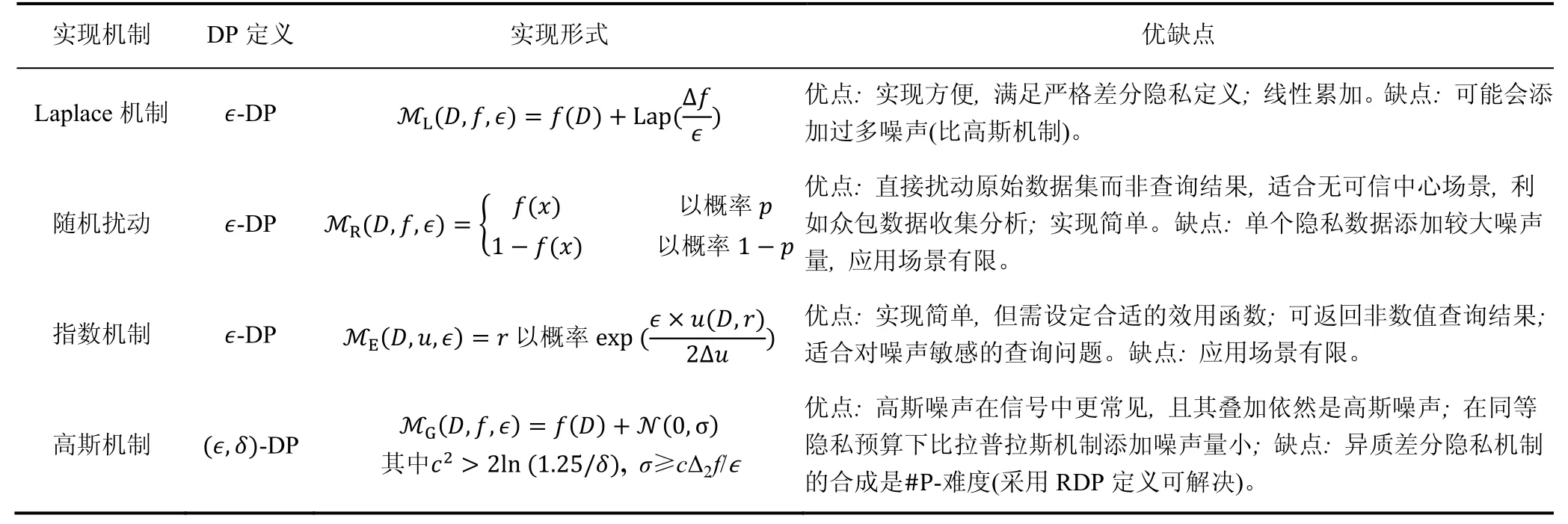

综上,本节总结了差分隐私常用的定义形式(表2)和实现机制以及其利弊(表3),下一节我们详述机器学习中存在的威胁模型及与差分隐私的联系。

表3 差分隐私实现机制Table 3 Mechanisms for Differential Privacy

3 机器学习中的隐私威胁模型与攻击

随着机器学习的深入发展,深度学习已经成为寻找数据规律的重要手段。一般的,机器学习通过建立模型、优化损失函数来拟合数据。但是,机器学习模型如果用来拟合个人敏感数据,例如医疗数据、人口普查信息、学校数据、银行数据等,会对个人隐私保护提出挑战。当攻击者获取机器学习模型后,模型输出特性可能泄漏训练数据的隐私信息。例如某个人的信息是否存在于隐私数据集中(成员猜测攻击),或者猜测某个人的隐私属性(属性猜测攻击)。

3.1 隐私威胁模型

讨论攻击之前,首先需要定义威胁模型。威胁模型可以用来度量攻击者能力及其抵抗方法的有效性。具体包括以下三个方面:攻击者的目标、知识和能力。攻击者的目标根据不同攻击类型有所不同,我们将在3.2 节详述。攻击者的知识和能力在机器学习领域主要体现在以下两个方面:模型知识和数据集知识。

模型知识:白盒子MW和黑盒子MB。白盒子攻击者掌握目标机器学习模型的模型架构和模型参数。黑盒子攻击指的是攻击者只能接入模型API,即查询模型并获取返回的预测结果(可能包含预测结果的概率),但是不知道模型参数。许多黑盒子模型假设攻击者知道目标模型的架构。因为当攻击者使用现有机器学习及服MLaaS 时,其能够复现目标模型的架构。

数据集知识:攻击者是否拥有额外数据集。攻击者能力由强到弱依次分为:(1)可获取部分训练集;(2)获取同分布数据集;(3)无额外数据集。第一种情况下,攻击者获得部分训练集;第二种情况下,攻击者获取与训练集同分布但不相交数据集(例如,对抗生成网络生成的人工合成数据集,又叫影子数据集);第三种情况,攻击者没有任何额外数据集。

3.2 隐私威胁攻击

常见的在机器学习领域与隐私保护(privacy protection)相关的攻击分为以下几类:成员猜测攻击(membership inference attack),模型反演攻击(model inversion attacks),属性猜测攻击(attribute inference attack),模型窃取攻击(model stealing attack),无意识记忆(unintended memorization)。值得注意的是,对抗样本攻击(adversarial samples)[31]是另一类较为热门的威胁到机器学习模型安全的议题,但是属于模型安全领域(model security),与隐私保护无关,因此不在本文讨论范围内。

3.2.1 成员猜测攻击

成员猜测攻击[32],也叫追踪攻击,攻击目标是猜测某条个人信息是否在目标模型的训练集中。成员猜测攻击导致的直接后果是当某个数据集本身具有敏感属性,则探知成员信息存在性可直接泄漏其隐私属性。例如,用某一癌症数据库作为训练集训练模型,当攻击者探知A属于该训练集,则可知A患有癌症。另外,成员猜测攻击还可以用于检测非法数据使用[33]。成员猜测攻击的原理是目标模型对于训练集和其他数据的表现不同。例如,目标分类器在预测阶段,对训练集会表现出更高的置信度,而对其他数据则表现较低的置信度。因此,过拟合的模型比泛化的模型更容易受到成员猜测攻击影响。根据攻击者掌握的目标模型知识不同,分为黑盒子攻击[32,34]和白盒子[35]攻击。在白盒子攻击下,攻击者通常利用模型梯度向量进行攻击;在黑盒子攻击下,攻击者通常利用对标签预测的置信度向量进行攻击。最新的文献中[36-37],也有提出仅仅需要黑盒子模型预测的标签(无需置信度)也可以发起有效成员猜测攻击。

差分隐私技术可以有效防止成员猜测攻击。从定义上可以看出,差分隐私限制某一条信息对查询结果的影响,因此限制了成员猜测攻击的成功率上限。大多研究也表明[32,38-39],差分隐私可以有效防止成员猜测。

3.2.2 模型反演攻击

模型反演攻击,指的是攻击者拥有白盒子模型,意图重构部分训练集,或者部分类表征。例如,Fredi kson 等人[40]依据目标黑盒子模型和部分公共属性猜测个体基因型。随后,Fredrikson 等人[41]提出模型反演可以恢复部分训练集面部信息。但是,该攻击只有当类成员近似时,才能发挥作用,例如MNIST 数据集,人脸识别数据集,等。此后,Hitaj 等人[42]提出在合作深度学习(collaborative deep learning)模式下的模型反演攻击。攻击者利用多方在线学习所传递的更新梯度以训练自己的GAN 生成模型[43],使得该生成模型能够恢复部分人脸。近期,Zhang 等人[44]提出通过GAN 生成模型以及公共信息反演深度学习模型以人工合成(恢复)训练集图片。综上,模型反演攻击与下文即将提到的属性推测攻击有相似之处。但是模型反演攻击所恢复的部分敏感属性可能是和标签高度相关的。其攻击的成功性也许依赖于目标模型达到预期的泛化能力[45],因此模型反演攻击是否需要防护在隐私保护领域的尚有争议。

3.2.3 属性猜测攻击

属性猜测攻击旨在猜测与鉴别模型任务无关的属性值。比如,某用于预测年龄的鉴别模型,攻击者可以从中推测出种族属性。或者,某张Bob 的人脸用于学习分类性别,但是攻击者却可以用其判断Bob这张照片中其他人是否戴眼镜。该攻击说明,某些模型过度学习(overlearning)以致模型信息中包含了许多与原始任务无关的信息。Melis 等人[45]提出在合作模型学习中利用在线学习中的更新信息推测隐私属性。比如,泄漏合作学习中的参与者在每轮更新的参与情况。防止过度学习并不十分容易。现有抵抗措施主要包括学习训练集的替代表征[46]x →z,使得其与目标最为相关的部分属性,并尽量降低无关属性的信息量s。但是,Song 和Shmatikov[47]的研究表示,即使训练集已经被压缩为不泄漏隐私的替代表征z,逆向工程仍然可以轻易的估计出逆向函数Tz→xapprox,再用xapprox训练攻击模型以估计隐私信息量s。即,作者认为过度学习可能是本能的,在不过度学习的条件下满足目标任务分类,也许不太可能。

3.2.4 模型窃取攻击

模型窃取攻击指的是,攻击者只能提问黑盒子目标模型 API(例如 Google,Amazon,BigML 等),推测出目标模型的参数,以使得窃取的模型和目标模型具有相似特性。模型窃取攻击有严重后果。其一,许多模型是私有财产并且按照查询问题次数计费,因此偷取模型侵犯模型所有者的权利;其二,模型窃取攻击给许多需要白盒子知识的攻击(比如属性知识攻击,对抗生成样本攻击等)提供便利。Tramèr 等人[48]提出用解方程攻击偷取逻辑回归模型(logistic regression),用寻找路径攻击偷取决策树模型。尽管模型窃取攻击没有直接泄漏用户隐私,但是其侵犯模型所有者权益,并提高了攻击者在其他类型攻击者的模型知识和取胜概率。

3.2.5 无意识记忆

无意识记忆由Carlini 等人[49]在2019 年提出。作者发现语言生成模型可能会无意间暴露训练集隐私。比如,某个文字自动补全模型会自动补全隐私信息。例如,输入“我的社交密码是078-”,生成模型此时会自动补全后半部分“-05-1120”。隐私信息的自动补全说明模型不仅学习到语言模式,还记住了部分训练集中存在的隐私信息。更有甚者,作者发现,模型记忆并非源自模型过拟合训练集,因为模型在训练初期已经发生记忆,并非在后期。因此某些预防过拟合的正则化方法,例如提前停止训练(early-stopping)或者dropout 等并不能有效防止模型记忆。幸运的是,作者发现,只需要很小隐私预算∊的差分隐私技术即可以有效防止模型记忆。

3.3 差分隐私抵抗机制

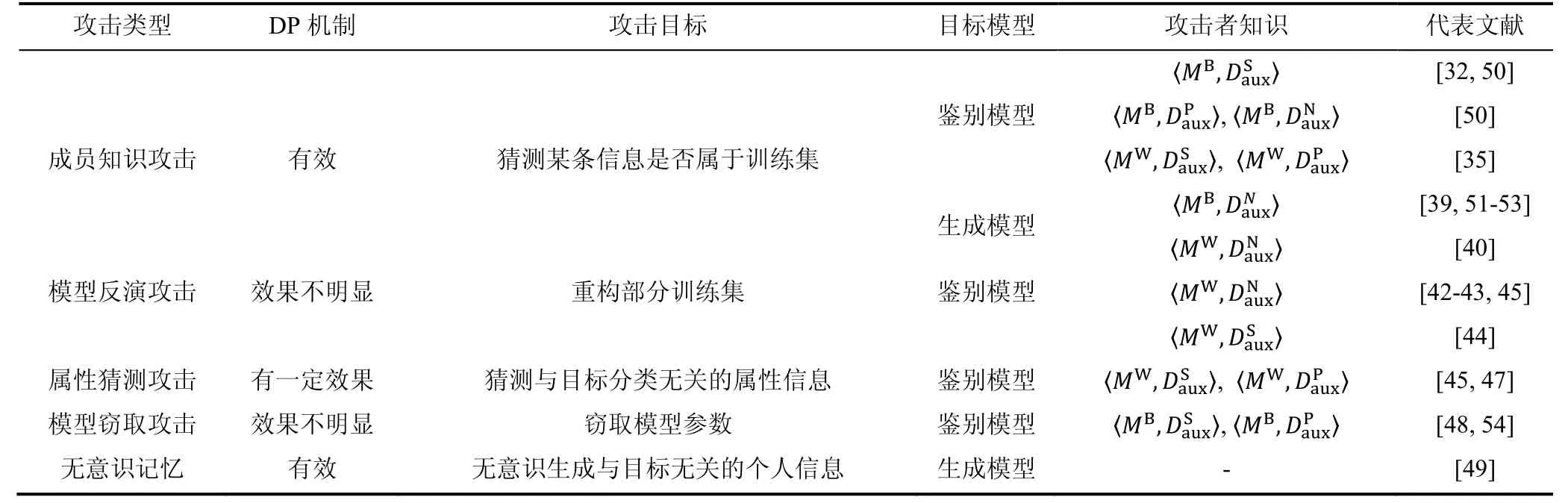

差分隐私机制从定义上防止成员猜测攻击,模型记忆,并弱化属性猜测攻击。但是,其对模型反演攻击和模型窃取攻击的弱化效果不明显。具体可参考Liu 等人[38]的研究。表4 总结了以上提到的五种攻击以及差分隐私对它们的抵抗能力。

表4 机器学习模型的隐私威胁Table 4 The attacks that threat the machine learning models

为了能够尽量减少对机器学习可用性的影响,不修改模型结构及损失函数,主流差分隐私抵抗机制研究分为梯度扰动(gradient perturbation)[55,26]和知识转移(knowledge transfer)[57-58]两种差分隐私方案。梯度扰动旨在修改训练过程中的梯度更新算法,在每个迭代周期的随机梯度递减算法结果中添加差分隐私噪声。知识转移机制基于采样和聚合架构(Sample and Aggregate Framework,SAF),将非隐私的学生模型采用差分隐私机制聚合出一个满足差分隐私机制的老师模型然后发布。第4 节将详细描述目标/输出/梯度扰动和知识转移两种差分隐私技术在鉴别模型和生成模型中的运用。

4 机器学习中的差分隐私方法

鉴别模型主要指的是分类器模型,即给予目标属性,模型判断其属于哪个类别。鉴别模型在机器学习任务中应用广泛。生成模型,本文主要指对抗生成模型(Generative Adversarial Nets,GAN),用于生成与训练集近似分布的人工合成数据集。由于常见的GAN 分为一个鉴别器(discriminator)和一个生成器(generator)。所以许多针对鉴别模型的差分隐私机制可以微调以适应GAN 模型。下文将首先介绍鉴别模型中的差分隐私机制,再介绍这些机制如何微调以保护GAN 模型。

4.1 鉴别模型

4.1.1 目标扰动和输出扰动机制

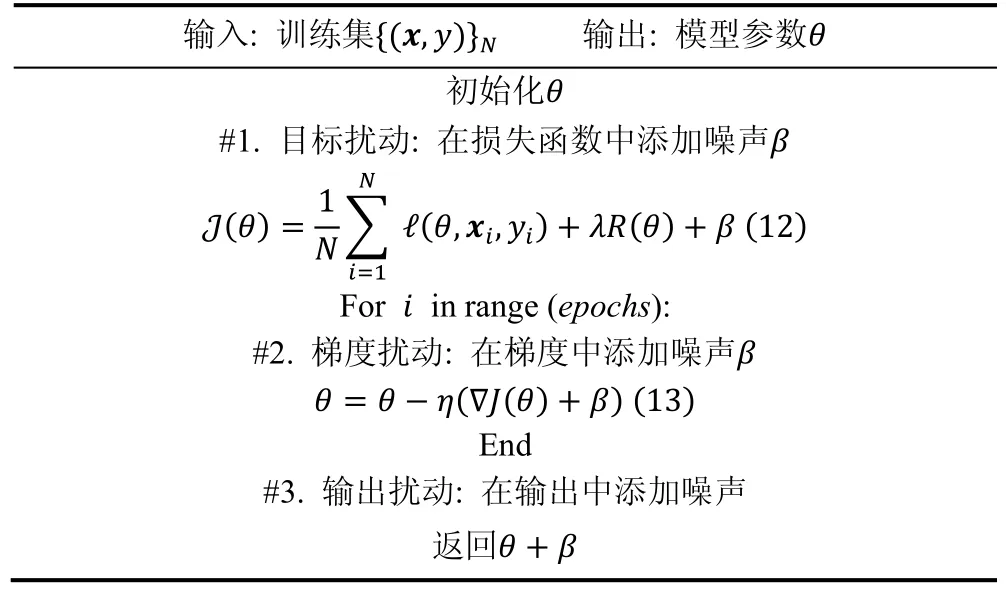

机器学习领域,在早期经验风险最小化(Empirical Risk Minimization,ERM)优化凸函数时,研究者率先提出了两种方式:目标扰动[59-61]和输出扰动[58-59]。其中Chauhuri 等人[58]以逻辑回归(logistic regression)为例,给出目标扰动和输出扰动的敏感度分析方法。但是其敏感度分析方法依赖目标函数为强凸函数。随着神经网络(neural networks)的深入发展,损失函数不再是凸函数,因此依赖强凸函数条件的分析敏感度的方法不再可行,隐私保护的方法逐渐转入梯度扰动[26,55]。梯度扰动无需损失函数为强凸性。且敏感度分析可以通过梯度裁剪实现。表6 总结了3 种扰动的实现机制。

机器学习任务背景:设训练集为x,yN,其中x是属性,y是标签,机器学习目标是根据属性x预测标签y。目标函数有如下基本形式:

其中,ℓ为某种损失函数,例如交叉墒或均方差函数。R为正则函数。机器学习的目标是找出最优参数使得

目标扰动和输出扰动。分别对应表5 中的方案#1 和方案#3。目标扰动在损失函数中加入噪声。输出扰动在输出结果中加入噪声。难点都在于敏感度分析。Chauhuri 等人[58]给出在二分类的逻辑回归任务中采用smooth 敏感度技术等方法推导出的差分隐私加噪幅值,使之可以应用于实际案例中。但是,该机制只能应用于二分类模型,且要求目标函数为强凸型,训练集为较低维度。

表5 差分隐私噪声添加方法Table 5 Differential private noise addictive mechanisms

4.1.2 梯度扰动机制

随机梯度下降(Stochastic Gradient Decent,SGD)是目前优化神经网络损失函数的常用方法。它在每个周期随机采样部分训练集,计算经验梯度以估计总体梯度并更新参数。如果损失函数并非强凸(神经网络中,一般都不是强凸),则随机梯度下降会优化至某个局部最优点。差分隐私的随机梯度扰动(DPSGD)旨在将符合差分隐私规范的噪声添加到每个周期的经验梯度中,用扰动的梯度估计更新网络,以使得每个周期更新的网络参数都满足差分隐私机制。

根据表5 公式(12),随机梯度扰动在周期t的基本形态如下

其中,wt是第t轮模型的权重,ηt是学习率,J是损失函数,Bt为第t轮选择的训练集批次(batch)且b=|Bt|。

添加差分隐私扰动的形式如下:

定理10.子采样隐私放大定理[63-64].如果机制M 满足∊,δ-DP,则M ˚subsample 满足log1+qe∊-1,qδ-DP,其中q=b/N指子采样率。

TensorFlow Privacy①https://github.com/tensorflow/privacy。RDP 可以看作是moments accountant 技术的一个实例化,其中比较著名的开源实现是TensorFlow 的Privacy 项目。我们简要介绍其隐私追踪思路:通过添加噪声采样自N0,σ2,将非隐私保护的SGD 算法修改为高斯机制 DP-SGD,则单轮对某个批次满足α,αC2/2σ2-RDP,其中C为裁剪阈值。然后根据RDP 的子采样放大定理[61]计算其放大后的隐私预算。之后,根据RDP 线性叠加定理,对k轮迭代线性叠加隐私消耗。最后根据定理8 遍历部分α参数找出最小∊,并将RDP 转换为∊,δ-DP。

4.1.3 知识转移

知识转移方法指的是从一群非隐私保护的老师模型(teacher ensembles)中以隐私保护的模式把模型知识转移到一个新的学生模型(student model)中,使得学生模型满足隐私保护,并将学生模型发布给使用者。其中代表性的案例为Private Aggregation of Teacher Ensembles (PATE)①https://github.com/tensorflow/privacy/tree/master/research[56]。PATE可以看成是SAF技术[62]在深度学习中的一个实例化应用。PATE 的训练过程可以分解为两部分:teacher ensembles 训练(图3 左侧)和student model 训练(图3 右侧)。

· Teacher ensembles 训练。首先,对于隐私数据集x,yN将其分成均等大小的n份,对于每一份数据集x,yi训练一个神经网络做分类任务。由此,总共获取n个老师模型Ti。当有用户用老师模型做标签预测时,老师模型们会集合出一个加噪的标签返回给用户。Papernot[56-57]采用Laplace 机制和高斯机制返回扰动最大值。到此为止,机制返回了一个差分隐私的预测标签给用户,用户可以直接使用。但是,因为用户每次通过DP 接口界面获取答案时,都会消耗隐私,因此当隐私预算消耗殆尽,老师模型就只能丢弃。为了解决这个问题,PATE 系统又添加了学生模型,以便更高效的转移老师模型的知识。

· Student model 训练。学生模型的训练主要由公开的无标签数据集和老师模型预测的加噪标签训练。学生模型较好的选择是半监督的GAN[63],半监督的GAN 的鉴别器是一个m+1的分类器,除了原始m个标签类别外,额外添件一个“fake”类别。在训练该学生GAN 时,除了标签是询问老师得到的加噪标签,其他都和原始半监督的GAN 的训练过程类似。训练结束后,公开鉴别器(discriminator),可以当作是满足差分隐私的分类器使用。

4.1.4 DP-SGD VS PATE

对于DP-SGD和PATE两种截然不同的隐私策略,我们从以下三个角度对比其优劣。

· 隐私保护:基于SAF 技术的PATE 架构与DP-SGD 有略微不同的隐私假设。PATE 假设属性x及其分布并非是需要保护的。其保护的是与x关联的标签y的值。拿图1 举例,PATE 保护其他属性与收入(income)之间的关联性,但是并不保护某个人的公共属性(婚姻状态marital staturs 等)。该隐私保护对数据集的假设要强于DP-SGD,且并非所有数据集都满足此要求。例如图1 中的Adult 数据集、医疗数据集等的个人属性也可能也是需要隐私保护的。

· 可用性:PATE 天然适合于分布式架构。PATE 无需修改现有模型架构,但是DP-SGD 需要修改梯度下降策略。PATE 只能用于分类任务,而DP-SGD 可以应用于线性回归、分类任务、生成任务等。当用分类准确度来衡量发布的差分隐私架构可用性时,在同等隐私预算下,PATE可能优于DP-SGD。这是因为PATE 从公共分布中获取了更多与分类任务无关的先验知识。且其用数据相关的隐私分析。

· 计算复杂度:在计算复杂度这一项,DP-SGD 对比PATE 有优势。一个典型的PATE 模型需要250 个老师模型才能获取隐私和有效性的较优平衡。除此之外,PATE如果采用数据相关的隐私预算分析,计算消耗也很大。

4.2 生成模型

生成模型有多种,本文专指对抗生成模型GAN。GAN 有很强的分布模仿能力,能够生成与原始训练集分布近似的高纬度数据集。因此许多研究者用其当作天然的规避隐私保护的方法,生成并发布合成数据集,并用人工合成数据集替代隐私数据集发布使用。但是近年来研究发现GAN 本身并没有严格证明的隐私保护性能,特别的,成员猜测攻击对GAN 也有攻击效果[40,42-43,45,68]。根据第3 节,差分隐私机制能够抵抗成员猜测攻击,因此研究差分隐私的GAN 对于隐私保护至关重要。

GAN 基本知识:GAN 的基本结构如图4 所示,包括一个鉴别器网络(Discriminator)和一个生成器网络(Generator)。敏感训练集为Xreal。生成器和鉴别器相互博弈,生成器要生成更加逼真的数据,鉴别器提高鉴别能力以鉴别出人造数据和训练集的区别。两者的损失函数如下。

鉴别器和生成器同时优化自己的损失函数,最后达到平衡点。从公式(16)(17)以及图4 中的损失函数流程可以看出,只有鉴别器网络D 的损失函数用到了敏感训练集Xreal,生成器网络G 在训练过程中没有直接接触敏感数据,而是使用D 返回的信息进行梯度更新。因此只需要保证鉴别器网络的差分隐私安全,根据抗后处理定理(定理4),生成器的参数及其输出也可以自动保持差分隐私。值得注意的是,生成器的输出为人工合成数据集,因此差分隐私的GAN 可以用来生成并发布满足差分隐私的合成数据集。

4.2.1 基于梯度扰动的差分隐私GAN

DP-GAN 是GAN 技术与DP-SGD 技术的结合。总体思路是对GAN 的鉴别器做差分隐私的随机梯度递减。根据抗后处理定理,生成器参数也能保持差分隐私。Xie 等人[65]在鉴别器中的Wasserstein 距离[66]的梯度优化上加入高斯机制以满足差分隐私,且也用moment accountant 技术追踪隐私。Frigerio 等人[67]将其拓展至生成连续、时间序列、以及离散的合成数据,并证明其差分隐私的合成数据集可以抵抗成员猜测攻击。

对比4.1.2 节,DP-SGD 在鉴别模型和生成模型上的技术十分类似,都是修改随机梯度递减SGD 使其满足差分隐私。值得注意的是GAN 训练时只需要修改鉴别器的随机梯度递减,无需修改生成器的SGD。在DP-GAN 隐私追踪时,注意追踪鉴别器的SGD 周期即可(有些GAN 为了增加稳定性会增加一轮生成器周期里对应的鉴别器周期数)。

4.2.2 基于知识转移的差分隐私GAN

PATE-GAN[68]和DP-GAN 采用的方法截然不同,源自PATE 系统。如图5 所示,作者把整个PATE 系统都当成是GAN 的鉴别器,让其与额外添加的生成器博弈。训练结束后,发布差分隐私的生成器。PATE-GAN 不再需要无标签的公共数据集来训练学生模型,取而代之的是,用生成器的部分难以被老师模型鉴别出真假的数据当“真数据”。PATE-GAN的差分隐私部分与PATE类似,也是用SAF技术聚合所有老师模型输出结果。图5 中生成器的差分隐私也是依赖于抗后处理性质。

5 总结和展望

上文详细讨论了差分隐私技术在机器学习领域的发展历程,包括定义、实现机制和常用性质。并且针对实际攻击,分析并比较了差分隐私的抗攻击能力。此后,给出了目前主流的差分隐私的鉴别模型和生成模型保护方案。本节将讨论差分隐私技术在机器学习领域的公开问题以及研究方向。

(1) 模型隐私安全和功能性安全存在折中

一直以来,机器学习模型的隐私安全和功能性安全处于两个相对平行的研究线路。本文探讨的是模型的隐私安全,即模型是否泄漏个人隐私。还有一类安全指模型的功能性安全,例如对抗样本攻击、样本毒化等,指的是存在恶意攻击者可以用肉眼难以分辨的数据模型的发生误判。差分隐私目前公认对模型的隐私安全有一定的保护效果。但是近期许多研究[69]发现模型的功能性安全可能与隐私安全有对立性,即防止模型的功能性安全的措施可能会加重隐私安全威胁。因此差分隐私如何同模型功能性安全的抵抗措施有效结合全面防护机器学习的安全性有待研究。

(2) 差分隐私保护机制不是万能

根据本文表4 的总结,差分隐私可以防止成员猜测攻击和无意识记忆,对属性猜测攻击有一定弱化效果。但是对防止模型反演、模型窃取攻击效果不明显。甚至有研究发现[38],模型窃取攻击和成员猜测攻击的成功率是负相关的。差分隐私机制的效果和攻击原理有直接关系。如果攻击依赖于模型过拟合,那么差分隐私有明显效果;如果攻击不是依赖于模型过拟合,甚至利用模型的泛化能力,那么差分隐私没有直接抗攻击效果。因此依赖差分隐私单一机制并不能解决机器学习隐私安全的所有攻击,应考虑多机制结合以全面防护隐私泄漏问题。

(3) 隐私预算追踪方法有待提高

许多研究表示目前针对机器学习的差分隐私机制牺牲过多有效性以保证安全[30]。另外一些研究也在试图寻在更加严谨的差分隐私预算追踪方法[70]。例如,目前的DP-SGD[26]研究假设攻击者可以获取机器学习模型每一轮迭代参数(权重更新),而不仅仅是可以获取最终训练好的模型的参数。在实际中,该攻击条件假设太强,但是这却是目前唯一一种已知的分析DP-SGD 隐私累加的方式[71]。为此,Feldman等人[70]推导出直接分析最后一轮模型隐私的方法,但是其证明依赖损失函数是凸函数的假设,在神经网络下还没有解决方法。另外,Nasr 等人[71]提出在不同的攻击者能力下,应该制定不同的差分隐私下限。差分隐私一直考虑最恶劣的攻击条件来保护隐私安全。然而实际环境中很少有攻击者能达到如此强的攻击能力。因此,针对不同攻击强度细化不同的差分隐私下限有待研究。

(4) 联邦学习模式中差分隐私存在局限性

联邦学习通常指掌握自己部分训练集的多方,在不泄漏个人训练集的前提下,共同训练综合模型。原理是训练的每个周期,各方先下载综合模型,然后用自己的训练集计算梯度更新并上传,中心利用各方上传的梯度加权平均更新综合模型。差分隐私机制通常类似SAF(见图3),用差分隐私的方式传递扰动的梯度平均。但是2017 年Hitaj 等人[42]研究发现,即使是差分隐私保护的联邦学习依然不安全。当有恶意参与者存在时,其可以窃取其他合规参与者的隐私信息。目前还没有可靠的用于联邦学习的差分隐私机制。这使得目前联邦学习的安全性只能依赖计算量以及通信量开销巨大的多方安全计算技术或者是同态加密技术。

(5) GAN 模型中差分隐私存在局限性

差分隐私技术在对抗生成模型(GAN)中的应用尚在探索阶段。比如,较为先进的WGAN-GP[72]尚没有差分隐私版本。因为梯度惩罚部分用到了真实训练集,其隐私预算追踪是个难点。除此之外,对抗生成模型与鉴别模型的网络架构以及性质也有所不同。其中,对抗模型的过拟合程度难以衡量(差分隐私主要保护模型过拟合)[39,51]。对抗模型的随机性可能使得非差分隐私的GAN 可能天生含有弱差分隐私性质[72]。因此,在GAN 中的差分隐私机制可能需要考虑其特点进行定制。比如,实验性衡量原始非隐私保护的GAN 的隐私保护程度,再补充加噪。