多机器人系统强化学习研究综述

马 磊, 张文旭, 戴朝华

(西南交通大学电气工程学院,四川成都610031)

多机器人系统强化学习研究综述

马 磊, 张文旭, 戴朝华

(西南交通大学电气工程学院,四川成都610031)

强化学习是实现多机器人对复杂和不确定环境良好适应性的有效手段,是设计智能系统的核心技术之一.从强化学习的基本思想与理论框架出发,针对局部可观测性、计算复杂度和收敛性等方面的固有难题,围绕学习中的通信、策略协商、信度分配和可解释性等要点,总结了多机器人强化学习的研究进展和存在的问题;介绍了强化学习在机器人路径规划与避障、无人机、机器人足球和多机器人追逃问题中的应用;最后指出了定性强化学习、分形强化学习、信息融合的强化学习等若干多机器人强化学习的前沿方向和发展趋势.

多机器人系统;强化学习;马尔科夫决策过程;计算复杂度;不确定性

多机器人合作是近年自动化与控制领域发展的前沿方向[1].多机器人的研究与应用体现出了广泛的学科交叉,涉及众多的课题,目前已在工业、农业、商业、太空与海洋探索、环境监测、灾害救险、国防等领域获得越来越多的关注与应用.

要实现多机器人灵活和有效的行为选择能力,保证它们之间的协作关系,仅依靠设计者的经验和知识,很难获得多机器人系统对复杂和不确定环境的良好适应性[2].为此,必须在机器人的规划与控制中引入学习机制,使机器人能够在与环境的交互中,具有一定的识别、判断、比较、鉴别、记忆和自行调整的能力.

机器学习是研究如何使用机器来模拟人类学习活动的一门学科,强化学习(reinforcementlearning,RL)作为机器学习的一种重要手段,可以使机器人与复杂的动态环境建立起一种交互关系.其尝试获得知识的过程与人类的学习十分相似,因此获得了广泛的关注,被认为是设计智能系统的核心技术之一[3].

多个机器人可以通过协作完成单个机器人无法解决的复杂任务.协作是多机器人系统的核心,但并非机器人与生俱来的特性.人类的许多协作行为都是通过后天不断的学习获得的,因此,多机器人也可以通过学习来增强和改进自身的能力,提高团队的协作行为与效率.多机器人系统的学习并不是单个机器人学习的简单叠加.事实上,多机器人系统的学习过程直接依赖于学习系统中多个机器人的存在和交互,是一个复杂的交互学习过程,需要考虑到它们之间的协商、信度分配及局部性等多方面因素.

本文第1节首先介绍强化学习的基本思想和理论框架,并在第2节将相关概念扩展到多机器人强化学习.在第3节中,针对局部可观测性、计算复杂度和收敛性等方面的固有难题,围绕学习中的通信、策略协商、信度分配和可解释性等内容总结多机器人强化学习的研究进展和存在的问题.第4节介绍强化学习的在多机器人系统中的若干典型应用.最后指出多机器人强化学习的前沿方向及发展趋势和面临的挑战,以期促进相关研究.

1 强化学习理论与方法

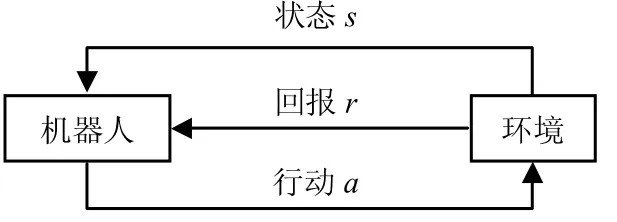

1.1 强化学习原理

经典的强化学习基于马尔科夫决策过程(Markov decision process,MDP),介于监督式学习和无监督式学习之间,以一个单独的学习系统为载体进行.如图1所示,学习系统(机器人、个体(Agent))通过与环境的即时交互来获得环境的状态信息,并通过反馈强化信号对所采取的行动进行评价,利用不断地试错和选择,进而逐步改进从状态到动作的映射策略,达到学习的目的.在强化学习的过程中,所有系统和环境状态都被认为具有马尔科夫性,即当前的状态只取决于上一时刻的状态和动作.这一假设大大简化了决策过程的复杂性.

图1 强化学习框架Fig.1 Framework of reinforcement learning

1.2 强化学习方法

1.2.1 瞬时差分法

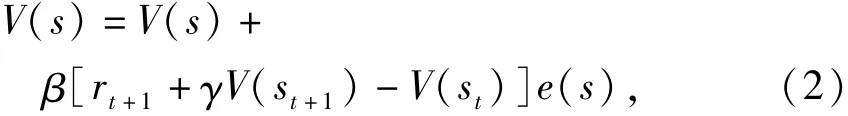

对于一个还未完全了解的系统,可以通过学习过去的经验预测其未来行为.瞬时差分法(temporal difference,TD)[4]基于这一思想,结合了动态规划与蒙特卡洛算法,通过预测当前动作的长期影响(即预测未来回报)将奖惩信号传递到动作中.最简单的TD算法是一步TD算法(TD(0)),个体获得瞬时奖赏值仅向后回退一步,即只迭代修改了相邻状态的估计值,迭代表式为

式中:β为学习率;V(st)和V(st+1)分别为个体在t和t+1时刻访问状态st和st+1时估计的状态值函数;rt+1为瞬时奖赏值;γ为折扣因子.

个体获得瞬时奖赏值可以向后回退任意步,则形成TD(λ)算法,其表达式为

式中:e(s)为状态s的选举度,可通过式(3)计算:

式中:λ为折扣速率;

在当前状态历史的t步,如果一个状态被多次访问,则其e(s)越大,表明其对当前奖赏值的贡献越大.式(4)为式(3)的递归形式:

与TD(0)算法相比,TD(λ)算法在收敛速度上有很大提升.但是,由于其在递归过程中的每个时间步都要对所有的状态进行更新,所以当状态空间较大时,难以保证算法的实时性.近年来,很多学者都对其做了研究,代表性工作有:文献[5]提出一种基于核心的在线选择TD(OSKTD)学习算法,通过对值函数进行在线稀疏化和参数更新两个过程,用以处理大规模连续的强化学习问题;文献[6]证明了任意的表格型折扣回报TD(λ)学习算法的概率收敛性;文献[7]研究了TD(λ)学习算法均方差与的函数关系,给出了一定假设下的表达式,针对采用线性值函数逼近的TD(λ)学习算法.

1.2.2 Q-学习

文献[8]提出了一类通过引入期望的延时回报,求解无完全信息的马尔科夫决策过程类问题的方法,称为Q-学习(Q-learning).Q-学习是一种模型无关的基于瞬时策略的强化学习方法,提供机器人在马尔科夫环境中,利用经历的动作序列执行最优动作的一种学习能力.Q学习算法的基本形式为:

其中:Q*(s,a)表示机器人在状态s下才用动作a所获得的奖赏折扣总和;γ为折扣因子;P(s,a,s′)表示概率函数.最优策略为状态s下选用Q值最大的行动a.

不同于TD算法,Q-学习迭代时采用状态-动作对的奖赏和Q(s,a)作为估计函数,而不是TD算法中的状态奖赏V(s),这样在每次学习迭代时都需要考察每个行为,可确保学习过程收敛[9].Q-学习可以根据TD(λ)算法的方法扩展到Q(λ)算法.

近年来,Q-学习算法得到广泛关注.文献[10]提出一种基于最小二乘支持向量机的Q-学习方法,由一个最小二乘支持向量回归机(LS-SXRM)和一个最小二乘支持向量分类机(LS-SVCM)构成,LS-SXRM用于逼近状态-动作对的值函数映射,LS-SVCM用于逼近连续状态空间到离散动作空间的映射;文献[11]将流形学习中计算复杂度较小的LE方法引入启发式Q学习中,提出了一种基于谱图理论的启发式函数设计方法;文献[12]提出一种保真概率的Q-学习(fidelity-based probabilistic q-learning,FPQL)方法,在学习迭代过程中采用保真度帮助学习过程和行动概率的选择,以此来平衡强化学习中策略的试探与利用的关系.

Sarsa(state-action-reward-state-action)算法[13]是Q-学习算法的一种特殊在线策略形式.Q-学习采用值函数的最大值进行迭代,Sarsa采用实际的Q值进行迭代.另外,Sarsa算法的每个学习步,机器人都依据当前Q值确定下一状态时的动作,Q-学习中需要依据修改后的Q值确定动作.Sarsa算法的更新规则为

1.2.4 Actor-Critic学习算法

上述3种学习算法具有一个共同特点,即仅对MDP的值函数进行估计,行为选择策略则由值函数的估计完全确定.为了同时对值函数和策略进行估计,文献[14]提出了Actor-Critic学习算法,采用TD学习算法实现值函数的估计,并利用一种策略梯度估计方法进行梯度下降学习.文献[15]进一步研究了求解连续行为空间MDP最优策略的Actor-Critic学习算法.

2 多机器人的强化学习方法

与单个机器人相比,多机器人的强化学习更注重机器人之间学习知识、经验等的交互.在有多个机器人参与的协作过程中,考虑到环境的不确定性与局部可观测的影响,它们与环境的交互扩展至局部可观测马尔科夫决策过程(POMDP)和分布式局部可观测马尔科夫决策过程(DEC-POMDP).学习过程不再具有马尔科夫性,每个时刻都需要通过考虑自身及队友的历史信息及经验来进行学习和判断,在这种情况下,学习的难度与计算复杂度都远高于单机器人的强化学习.DEC-POMDP的求解是一个NEXP(non-deter-ministic exponential time)问题[6].

多机器人的强化学习分为集中式和分布式.集中式的强化学习将所有机器人看作一个整体,利用一个全局学习单元,采用经典的强化学习方法进行学习,然后将策略分配给每个机器人.其常用于调度问题,例如电梯组[17]和异构机器[18]等调度问题.分布式强化学习要复杂得多,又可以分为独立强化学习(reinforcement learning individually,RLI)与群体强化学习(reinforcement learning in group,RLG),是当前研究的主要课题.在学习系统中,如果每个机器人的学习不考虑其他机器人的状态,称之为独立强化学习,其协作过程可以称为自私型或者完全自私型;如果每个机器人在学习过程中,既考虑自身及任务,还要考虑到队友可能的行动与策略,通过学习和推理后得到一个利于团队的个体策略,则称为群体强化学习,其协作过程为协作型或完全协作型.

多机器人分布式强化学习中,所有机器人在追求一个共同的目标过程中彼此通信、合作.每个机器人在与环境的交互中,由于获取信息而改变自身状态和周围环境,在学习过程中又受到其他机器人的知识、信念、意图、经验等的影响,这在状态局部感知情况下尤为突出,其结构如图2所示.多机器人强化学习难点就在于如何协调它们间的知识和学习,以及如何在保证学习速度的前提下加强它们之间的协作.

单个机器人强化学习的思想和算法可以通过组合状态、组合动作、策略分配等方法,实现在多机器人强化学习中延续和扩展.一些代表性工作有:文献[19]提出了一种基于多个体并行采样和学习经验复用的改进算法,在探索阶段,通过多个体并行采样,快速收集模型信息;在利用阶段,通过保留最优值函数的方式复用算法的学习经验,提高了算法迭代计算值函数的效率;文献[20]依靠局部通信和计算,设计了一种网络环境中基于MDP的分布式Q-学习算法,并证明了该算法的渐进收敛性;文献[21]设计了一种分布式的核强化学习方法,首先通过添加虚拟机器人领队实现编队控制,再利用强化学习算法来优化编队控制策略;文献[22]提出了一种多个体的合作树框架,定义两种树枝权重来描述个体是否参与合作,然后利用强化学习算法求解联合行动的策略.

图2 多机器人学习与交互方式Fig.2 Learning and interactive mode of robots

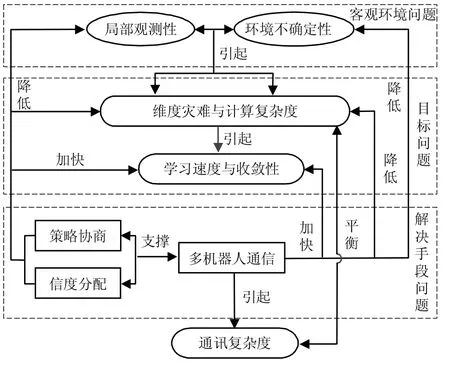

3 多机器人强化学习存在的问题

在多机器人的强化学习中,随着参与机器人数量的增加,它们之间的交互关系愈加繁杂.客观环境会带来局部可观测及不确定性等问题,每一个机器人在考虑自身局部信息的情况下,还需要考虑队友的信息,需要考虑机器人行为对环境的影响;求解多机器人的强化学习计算难度更高,解决目标问题时存在维度灾难问题;利用现有算法,求解强化学习的手段会引出多机器人通信、策略协商及团队信度分配等问题.所有问题围绕着强化学习的核心:学习速度与收敛性,呈现出一个相互关联的逻辑关系,如图3所示.

在隆重纪念改革开放40年的日子里,我们认认真真地总结一下自己走过的路,认认真真借鉴一下历史和他人的正面经验和反面教训,是非常有必要的。我们理应在改革开放今天与明天的伟大事业中,力求有所作为!我们做人就清清白白地做人,做官就规规矩矩地做官,做事就扎扎实实地做事,做学问就正正经经地做学问!中国优秀传统文化的重要内容之一是“三不朽”——立德,立功,立言,我们要学习实践“三不朽”。

3.1 局部可观测与环境不确定性

描述一个智能系统面临的环境可以从五方面进行分析[23],其中状态部分可知(partial observation)和不确定性(uncertainties)在多机器人的研究

图3 问题逻辑关系Fig.3 Logic of problems

中尤为突出.

由于每个机器人的感知能力和范围有限,以及复杂环境中突发情况等因素的存在,机器人获得的信息往往带有局部性和不确定性,这在大规模的多机器人系统中更是难以避免.因此,克服状态局部感知与不确定性,是多机器人强化学习的重要研究方向.一些代表性工作有:文献[24]结合了MaxQ算法和分层强化学习算法,首先通过MaxQ学习获得环境特征,然后综合局部选择并制定多机器人在未知环境下的合作策略;文献[25]利用学习压力领域作为一种手段来评估强化学习算法在多个体学习进程,研究了部分可观察模型有限分析随机过程框架,以长期的平均预期收益为实际策略.

在学习过程中,每个机器人都需要考虑系统的不完整信息和其他个体的不确定因素,目前多数针对局部观测的研究都使用POMDP,但是该模型是研究团队中每个机器人的局部性后才考虑机器人间的协作的.作者认为,DEC-POMDP模型将单个机器人的局部性扩展到了所有机器人,使得多个机器人间的局部性得到交互,可以更好地还原它们在复杂未知环境中的学习和协作过程.目前多机器人的强化学习与DEC-POMDP的结合还不多见,是一个值得研究的方向.

3.2 维度灾难与计算复杂度

多机器人协作过程中,环境是在多个机器人的联合动作下进行状态迁移的.强化学习方法采用状态-动作的映射来表示行为策略,由于复杂环境的不确定性影响和机器人感知的局部性,因而不可避免地出现学习策略随状态、动作的维数呈指数增长的现象,即“维数灾难”.

“分而治之”是解决复杂问题的重要手段[26].分层强化学习(hierarchical reinforcement learning,HRL)基于这一思想,对问题空间进行结构化分解或分层,代表性工作有文献[27-29].另外,文献[30]提出一种基于分层强化学习的多机器人任务分解方法,在每个机器人的运动范围基础上,假设存在一个位置坐标负载(load position),负载类似于运动中的障碍,通过逐渐减小位置坐标负载来分解任务.文献[31]基于分层理论,通过研究多个体的分层状态表达、状态-行动抽象空间和社会结构,将其嵌入学习过程,并量化搜索过程,达到减小计算复杂度和提高强化学习效率的目的.其余解决维数灾难问题的方法还有状态聚类法[32]、有限策略空间搜索法[33]、值函数近似法[34]等.但目前的方法仍存在学习效率不高、收敛性难以保证等缺点[35].

作者研究了一致性算法与多个体决策过程的结合[36],探索了一致性收敛对策略空间规模的影响、策略空间的化简和最优策略搜寻方法,并寻求一种新的方法来删减、合并冗余和冲突的策略,以此缓解维度灾难并降低计算复杂度.

3.3 学习速度与收敛性

强化学习速度较慢的主要原因是没有明确的教师信号.个体在与环境的交互过程中,完全采用试探的方法,仅依靠外部的评价来调整自己的行为,这势必需要经过一个漫长的学习过程.这是强化学习的固有难题.

文献[19]提出在学习的不同阶段复用以前的学习经验,通过设定初始值函数融入模型先验知识的方法,提高了算法的收敛速率;文献[37]将欧拉向前微分计算方法与强化学习算法相结合,提出一类非线性不确定动态系统基于强化学习的最优控制方法,较好地解决了连续状态-动作空间的泛化问题,提高了非线性系统的学习效率;文献[38]通过Q-学习获取协作行为准则,使多机器人在预知的环境中相互协作,缩短了学习时间;文献[39]提出一种基于启发式的快速多个体强化学习算法(HAMRL),利用启发式函数表示初始行动策略,从前期经验中提取特征或从观察中学习.另外,文献[40]提出了利用经验回放(experience replay)思想提高强化学习的学习效率.文献[41]提出一种基于Actor-Critic结构的积分强化学习(integral reinforcement learning,IRL)方法,利用经验回放更新Critic的权重,以此来求解IRL的Bellman方程,提高学

习收敛速度.

3.4 学习中的通信

由于无法获得全局的环境信息,处于复杂和未知环境中的多机器人很难进行正确的学习,容易根据自身获得的局部信息,做出多余或有冲突的策略,因此通信是重要的提高学习速度和质量的手段.

多机器人间协作的通信可以分为隐式与显式通信.隐式通信利用机器人的行为对产生环境的变化来影响其他机器人的行为.当某一个机器人做出特定的动作或达到指定的位置时,相当于告诉其他机器人一个之前约定好的信息,但是这种方式可以传递的信息量有限,并且不能保证其他机器人都观测到,因此只能用于比较简单的学习模型中.显式通信指机器人间通过硬件通信设备直接通信,是当前主要的在线学习手段.文献[42]研究了多移动机器人通信仿真系统设计方案,侧重于反映通信网络的拓扑变化情况.文献[43]研究了基于强化学习的通信在多个体合作中的应用.

目前大多数多机器人系统仍然采用集中通讯方式,该方式存在通讯消耗大、延迟明显等缺点,因此,如何降低多机器人系统对通信的依赖程度也是一个重要的问题.作者认为,可以在网络化多机器人学习系统中应用一致性方法[44],通过局部通讯,以较少的通讯代价实现信息传输和共享.目前,专门针对通讯代价或通讯复杂度的研究还不多见.文献[45]将通讯复杂度定义为通讯次数和一致性收敛精度的函数,并研究了确定性和随机(Gossip)一致性算法要求的通讯复杂度,提出了一种在Gossip算法中通讯复杂度的凸优化方法.事实上,通讯复杂度是分布式计算中的一个重要问题,文献[46]提出了一种通讯复杂度最优和时间复杂度几乎最优(almost optimal)的Gossip算法,通过挑选若干“协调者(coordinators)”承担主要的决策任务,避免了节点之间的冗余信息交换.

3.5 策略协商

协商的思想产生于经济活动中的理论,主要用于资源竞争,任务分配和冲突消解等问题中.文献[47]指出,在当前还不足以成功地将人类的协商技巧程序化的情况下,机器人在协商过程中通过学习不断更新策略是一个有效的办法.

在协商策略的研究中,对于机器人如何获得合适的策略有两种解决方案,一种方案是在机器人初始化时配置足够的策略,这意味着需要先验描述所有可能的情况及其解决办法,但是,对于大多数的实际应用来说这是不可能做到的.另外一种方案是机器人自身具有学习能力,能够从协商过程中获取经验.在多个体系统的强化学习中,个体间交换即时状态、学习片段或学习策略,都可以提高个体的学习和任务完成效率[48].文献[49]在多机器人协作的MaxQ学习方法中引入π心智演算过程,构建起具有学习与通信能力的机器人心智状态模型,对机器人主体的公共知识、信念、目标、意图、承诺、信任、知识更新等进行了定义,并构建起多机器人主体协商模型.文献[50]研究了多个体协商决策过程,设计了一种基于Q-学习的第n步多主体协商算法,多个体之间通过协商未来的行动,来选择最优的联合策略.

协商过程中信息交互量越大,协商效果越好.以适当的通讯为代价实现个体间的信息交换和共享,加强多机器人之间的协商,是提高决策效率的重要手段,故有必要研究通讯代价和学习效果之间的平衡.

3.6 信度分配问题

信度分配问题(credit-assignment problem,CAP)是实现强化学习的一个难点,主要需要考虑如何根据系统性能的改变,合理地将奖惩分配到学习系统中每个行为动作上,可以分为结构分配(structure-CAP,SCAP)和时间信度分配问题(time-CAP,TCAP)[51-54].

对于多机器人学习,该问题(multi-robot credit assignment,MCA)变得更加复杂,首先要考虑结构信度分配问题.当一个由多个机器人的合作任务完成时,如果全部回报由最后一个执行动作的机器人获得,则只有这一个机器人可以进行学习,是不利于机器人团队的,要考虑如何合理地将回报分配给参与合作的机器人.但是,如果仅按照机器人的贡献来分配,也会存在一些问题,比如在异构多机器人合作中,某次偶然出现高性能的机器人会得到较多的回报,使其性能评价逐渐增强,而影响到团队中真正拥有高性能并需要强化的机器人.目前主要的可行方法是将任务分解为子任务,然后根据每个子任务的重要性及执行的机器人进行评判.文献[55]研究了噪声环境中的多个体信度分配问题,利用强化学习算法消除噪声对回报值的影响;文献[56]利用配置评判个体(critic agent)的方法研究了信度分配问题.

在实际应用中,一个动作的成功或失败可能需要一段时间以后才能知道,所以强化信号往往是一个动作序列中以前的某个动作引起的响应,也就是所谓的延迟回报.回报被延迟得越多,学习算法就需要越多的尝试,收敛时间会越长,这就是时间信度分配问题.回报函数的设计对于强化学习算法的学习性有重要的意义,逆强化学习(inverse RL)[57]在近年来得到了关注[26].逆强化学习的思想就是利用已有的经验数据来学习MDP的回报函数,从而实现回报函数的自动设计.目前逆强化学习的研究已经取得了若干成果[58-59].但是,回报函数与经验知识的融合依旧存在一些问题,比如,如何评判过去经验是否有价值、如何判断环境的变化与经验的关系等问题,还有待深入研究和完善.

3.7 可解释性

机器学习的另一个问题是得到的模型的可解释性差[60].可解释性和实际应用密切相关,机器人通过学习解决一些具体的问题时,需要领域的专家能够理解模型,能够理解“为什么”这个模型能够对未知样本做预测.在求解学习问题时可能得到多个解,如果使用其一直以来所遵循的“输入输出满足”原则,可能建立的多个模型获得多个解,则需要以对问题世界可解释性来分辨其优劣.

4 多机器人强化学习的应用

对于多自主移动机器人系统,强化学习是实现具有自适应性、自学习能力的智能机器人的重要途径,这也为解决智能系统的知识获取这个瓶颈问题提供了一个可行之法[35].

4.1 机器人路径规划与避障

移动机器人的路径规划是指在有障碍物的工作环境中,如何寻找一条从给定起点到终点的适当的运动路径,使机器人在运动过程中能安全、无碰地绕过所有障碍物[61],一般可以归结为面向路径长度、所需时间、能量消耗等多目标的优化问题.

复杂环境下机器人路径规划是强化学习的主要应用领域之一.文献[62]利用强化学习方法学习局部导航行为,通过矢量量化(vector quantization,VQ)来表示空间状态的一般化方法,从而获得多个体的状态空间;文献[63]基于迪科斯彻算法(Dijkstra's algorithm),设计了结合强化学习的多机器人最优路线算法;文献[64]利用波尔兹曼(Boltzmann)分布与Q-学习方法的结合,Q-学习算法用来解决低维路径规划问题,玻耳兹曼策略采用统计概率和模拟退火法,避免多机器人的策略陷入局部最优并提供全局最优解,减少数量的探索和加快收敛的过程;文献[65]结合波尔兹曼分布与基于动态规划的Q-学习方法(QVDP),研究了多个体路径规划及延迟问题.

4.2 多机器人任务分解

多机器人任务分配(multi-robot task allocation,MRTA)是保证多机器人协调的重要因素,任务分配的好坏将直接影响整个多机器人系统协作的效率,并关系到每个机器人能否最大限度发挥自身的能力.

近年来,强化学习在多机器人任务分配的问题中也受到广泛的关注.文献[66]基于强化学习算法,提出一种智能合作控制框架,用于解决多个无人机(UAV)的任务分配问题;文献[67]分析多卫星协同任务规划问题的数学模型,提出了一种多卫星强化学习算法,引入了约束惩罚算子和多卫星联合惩罚算子,对卫星个体原始的效用值增益函数进行改进,以求解多卫星协同任务分配策略;文献[68]结合强化学习,设计了一种空置链调度(vacancy chain scheduling,VCS)的多机器人资源分配过程,依赖于优化配置模式来摆脱不直接机器人交互作用的影响;文献[69]提出一种多个体的分布式并行多任务分配算法,每个个体先通过利益分享学习(profit sharing learning,PSL)方法进行学习,然后利用通讯和协商来分配每次任务的真实工作量.

4.3 机器人足球

机器人足球比赛是典型的开放式、分布式、动态的、实时的多机器人系统,其中涉及到的技术包括机器人学、机电一体化、多机器人协作、决策与对策、人工生命和传感器数据融合等,是人工智能与机器人领域的应用基础研究课题.本文主要从机器人的高层决策方面阐述强化学习的应用.

文献[70]研究了基于动作预测的多个体强化学习算法,使用朴素贝叶斯分类器来预测其他个体的动作,并引入策略共享机制来交换多个体所学习的策略;文献[71]使用重复Q-学习和经验复用Sarsa算法进行了机器人足球守门员的实验;文献[72]通过策略梯度强化学习方法来寻找机器人足球赛中的最优策略;文献[73]研究了强化学习在机器人足球赛中的决策机制,并利用分层的思想改进每个机器人的个体行为.对于大规模强化学习系统,通过融入恰当的知识(knowledge)和建议(advise),可以有效提高系统的学习效率.文献[74-75]分别将基于知识的核回归(knowledge basedkernelregression,KBKR)和优先级(preference KBKR)算法引入到强化学习系统中,并将其应用于机器人足球仿真比赛中.

4.4 多机器人追逃问题

多机器人追逃问题是多机器人系统的典型应用,在搜救和对抗领域有重要实用价值,常被用于评价多机器人协作方法的性能.

代表性的工作有:文献[76]采用强化学习方法更新回报值并在追击者间传播,从而获得最优捕获时间;文献[77]引入关联规则数据挖掘方法进行任务分配,针对各逃逸者建立相应的追捕联盟,降低了策略空间的复杂度,基于不同状态下的奖励差异提出了一种分段式强化学习方法,利用其作为已知环境下追捕问题的模型求解追捕联盟的协作追捕策略;文献[78]采用了基于模型的Rmax学习算法解决多机器人追逃问题;文献[79]基于分层强化学习研究了多机器人追逃算法,将学习过程分解为高层与低层两个阶段,并设计学习机制以平衡两个学习阶段的值函数.

作者在前期工作中[80],假设了环境不确定性与机器人的局部观测性,在DEC-POMDP框架下对多机器人追逃问题进行了数学描述,将其用8元组建模,并采用分布式滤波对逃逸者的运动状态进行估计,在此基础上更新追击者的回报值和策略空间,再进行追击决策.下一步研究会将通讯代价、追击者信息可信度和回报值等因素统一到该模型中.

5 多机器人强化学习的前沿方向与挑战

根据任务的具体特点,寻求适当的多机器人系统的学习、决策和控制方法,使其能够在复杂环境中高效、可靠地完成给定任务,是多机器人系统研究所面临的巨大挑战和机遇.

5.1 分形学习

分形理论是非线性科学理论中的一个分支,用以描述复杂、混沌现象背后的规律性,揭示局部与整体之间的关系.分形理论认为,整体的复杂性远远大于部分,而分形中任何一个相对独立的部分,在一定程度上都是整体的再现和相对缩影(分形元),人们可以通过认识部分来认识整体.分形学习(fractal learning)利用系统的自相似性,通过对数据集分形维数的计算,提取出相关规则、建立相应的模型,并为以后的行为提供指导,行为的反馈信息又可以用来修正更新规则或模型,进而使系统的性能不断优化.如何将分形学习与多机器人相结合,以及如何突破分形学习的应用范围约束以及简化分形维数的计算等都还需要不断地探索和完善[81].

5.2 模糊强化学习

模糊理论具有对复杂不精确知识较强的表达能力,以及对实际问题较好的处理能力,且易于先验知识的加入,使之一直受到研究者的重视,并在实际中取得了广泛应用.比如在复杂未知环境下,利用模糊强化学习的移动机器人导航应用等[82-84].但是,对多机器人的模糊强化学习研究还比较少见,在模糊不确定环境下,采用模糊理论可以使得多机器人获得更多信息,为学习和决策过程提供更有弹性的空间,以便采取更加灵活的回报值和行动策略,提高学习效率.

5.3 定性强化学习

定性推理源于对物理现象的常识推理,是一种从物理系统的结构描述出发,导出行为描述和功能描述.定性推理可充分利用定性及不完全、不精确的信息来推理系统的定性行为,给出易于理解的行为描述和因果解释,为信息不完全的复杂系统产生行为预测,便于先验知识的加入,从而加快推理过程[85].文献[86]通过建立系统的定性模型,提出一种基于定性模糊网络的强化学习知识传递方法,并利用定性模糊网络抽取基于定性动作的次优策略的共同特征获得与系统参数无关知识.如何将定性推理应用于强化学习是一个诱人的研究方向,比如通过局部传播在较高层次上给出系统的宏观描述、结合灰色系统理论和定性推理构建灰色定性强化学习策略,以及从知识运用的角度论证强化学习理论的完备性等问题都需要深入研究[86].

5.4 迁移强化学习

迁移学习(transfer learning)考虑了任务之间的联系,利用过去的学习经验加速对于新任务的学习,可以分为行为迁移和知识迁移.行为迁移通常意味着将先前学到的策略或者某些公共的“子过程”用于新任务的学习,这一类技术侧重于挖掘、利用不同任务的解决方案之间的相似性.知识迁移技术注重对任务本身的理解,并试图学习解决问题的一般原理,因此知识迁移技术更多地涉及知识表示、规则提取等内容[87].文献[88]利用拉普拉斯特征映射能保持状态空间局部拓扑结构不变的特点,对基于谱图理论的层次分解技术进行了改进,提出一种基函数与子任务最优策略相结合的强化学习混合迁移方法;文献[89]提出了一种局部约束模型(partially constrained model,PCM)下的迁移学习方法,可以更好地处理状态-行动策略.多机器人的迁移学习可以扩展传统的强化学习方法,考虑如何将多个机器人间不同的学习任务相互关联,以及获得更多的知识表示、规则提取等内容,可以作为今后的研究方向.

5.5 结合信息融合的强化学习

结合信息融合,实现值函数估计的强化学习是一个新的研究方向.文献[90-91]将卡尔曼滤波与TD算法结合起来,提出一种卡尔曼瞬时差分法(Kalman temporal different,KTD)算法,引入了一个值函数估计问题的状态空间,通过卡尔曼滤波器融合值函数的近似过程;文献[92]提出了基于Q-学习的KTD-Q学习算法和基于Sarsa算法的KTDSarsa算法,通过信息融合的强化学习算法,可以更好地处理在线学习、有效样本、非定常性和非线性等问题.但噪声模型的选择与如何融入KTD模型,以及KTD如何由MDP扩展至POMDP依旧是一个开放性问题,而且在结合多机器人上的研究还比较少见,是一个值得深入探究的领域.

5.6 多目标强化学习

传统的强化学习中,所有机器人都为达成一个共同目标而协作.多目标强化学习(multi objective reinforcement learning,MORL)考虑的是多个机器人在合作中,可能会面对两个或两个以上的目标,每个目标都有自己的回报值,目标间可能相关也可能冲突,需要研究学习任务间的协调与决策等问题[93].文献[94]提出一种基于最大集合期望损失的多目标强化学习算法,在平衡各个目标的前提下选择最佳联合动作以产生最优联合策略,并应用到机器人足球射门局部策略训练中;文献[95]利用MORL算法扩展了多个体蒙特卡罗树型检索(Monte-Carlo tree search)中的的连续决策问题.文献[96]提出了一种新的多任务学习方法,通过学习潜在的形函数来获取相关领域的知识,用人造回报来增大任务的回报函数.但是,多目标强化学习在使用非线性函数泛化时,依然存在算法不稳定、不收敛等问题,尚需深入研究.

6 结束语

多机器人的强化学习是一个年轻而充满活力的研究领域,结合了博弈论和最优搜索等内容,涉及到多机器人的群体体系结构、感知与多传感器信息融合、通信与协商、运动规划、任务分配、冲突消解、系统实现等许多方面,为多机器人在缺少或只有局部先验知识的情况下,解决非线性、随机策略任务提供了一个有力的方法论和一系列算法.

本文简要介绍了强化学习的基本思想与理论框架,对基于强化学习的多机器人研究现状作了概述,以期促进相关研究.应当指出,强化学习的本质是一种试错反应式的学习,并不能理解事物之间的因果联系,更无法归纳出一般事物的发展规律.当前的研究重点在于对分布式强化学习的算法研究,但其在多机器人的合作应用尚不充分.在今后的发展中,仍然需要在理论和应用方面开展创新研究,增强机器人的分析、归纳、推测、任务分解等方面的学习能力,以此更好地理解多个机器人之间的关系,使其协作更加紧密,结构信度分配更加合理,从而达到更高的智能层次.

[1] MURRAY R M,ASTROM K M,BODY S P,et al.Future directions in control in an information-rich world[J].IEEE Control Systems Magazine,2003,23(2):20-23.

[2] 陈学松,杨宜民.强化学习研究综述[J].计算机应用研究,2010,27(8):2834-2844.CHENXuesong,YANGYimin.Reinforcement learning:surveyofrecentwork[J].Application Research of Computers,2010,27(8):2834-2844.

[3] WIERING M,OTTERLO M V.Reinforcement learning state-of-the-art[M].Berlin:Springer-Verlag,2012:3-42.[4] SUTTON R S.Learning to predict by the methods of temporal differences[J].Machine Learning,1988,3(1):9-44.

[5] CHEN Xingguo,GAO Yang,WANG Ruili.Online selective kernel-based temporal difference learning[J].IEEE Transactions on Neural Networks and Learning Systems,2013,24(12):1944-1956.

[6] ZOU Bin,ZHANG Hai,XU Zongben.Learning from uniformlyergodicMarkovchains[J].Journalof Complexity,2009,25(2):188-200.

[7] YU Huizhen,BERTSEKAS D P.Convergence results for some temporal difference methods based on least squares[J].IEEE Transactions on Automatic Control,2009,54(7):1515-1531.

[8] WATKINS C,DAYAN P.Q-learning[J].Machine Learning,1992,8(3):279-292.

[9] 沈晶,程晓北,刘海波,等.动态环境中的分层强化学习[J].控制理论与应用,2008,25(1):71-74.SHEN Jing,CHENG Xiaobei,LIU Haibo,et al.Hierarchicalreinforcementlearningindynamic environment[J].Control Theory&Applications,2008,25(1):71-74

[10] 王雪松,田西兰,程玉虎.基于协同最小二乘支持向量机的Q学习[J].自动化学报,2009,35(2):214-219.WANG Xuesong,TIAN Xilan,CHENG Yuhu.Q-learning system based on cooperative least squares support vector machine[J].Acta Automatica Sinica,2009,35(2):214-219.

[11] 朱美强,李明,程玉虎,等.基于拉普拉斯特征映射的启发式Q学习[J].控制与决策,2014,29(3):425-430.ZHU Meiqiang,LI Ming,CHENG Yuhu,et al.Heuristically accelerated Q-learning algorithm based on Laplacian eigenmap[J].Control and Decision,2014,29(3):425-430.

[12] CHEN Chunlin,DONG Daoyi,LI Hanxiong.Fidelitybased probabilistic Q-learning for control of quantum systems[J].IEEE Transactions on Neural Networks and Learning Systems,2014,25(5):920-933.

[13] RUMMERY G,NIRANJAN M.On-line Q-learning using connectionist systems[D].Cambridge:University of Cambridge,1994.

[14] BARTO A G,SUTTON R S,ANDERSON C W.Neuronlike adaptive elements that can solve difficult learning control problems[J].IEEE Transactions on Systems,Man and Cybernetics,1983,13(5):834-846.

[15] LIN C T,LEE C S G.Reinforcement structure/parameter learning for neural-network based fuzzy logic controlsystem[J].IEEETransactionsonFuzzy System,2008,2(1):46-63.

[16] BERNSTEIN D S,GIVAN R.The complexity of decentralized control of Markov decision processes[J].Mathematics of operations Research,2002,27(4):819-840.

[17] CRITES R H,BARTO A G.Elevator group control usingmultiplereinforcementlearningagents[J].Machine Learning,1998,33(2/3):235-262.

[18] KIM G H,LEE C S G.Genetic reinforcement learning approach to the heterogeneous machine scheduling problem[J].IEEETransactionsonRoboticsand Automation,1998,14(6):879-893.

[19] 刘全,杨旭东,荆玲,等.基于多Agent并行采样和学习经验复用的E~3算法[J].吉林大学学报:工学版,2013,43(1):135-140.LIU Quan,YANG Xudong,JING Ling,et al.Optimalcontrol of a class of nonlinear dynamic systems based onreinforcementlearning[J].JournalofJilin University:EngineeringandTechnologyEdition,2013,43(1):135-140.

[20] KAR S,MOURA J M F,POOR H V.QD-Learning:a collaborativedistributedstrategyformulti-agent reinforcementlearningthroughconsensusplus innovations[J].IEEETransactionsonSignal Processing,2013,61(7):1848-1862.

[21] 吴军,徐昕,连传强,等.采用核增强学习方法的多机器人编队控制[J].机器人,2011,33(3):379-384.WU Jun,XU Xin,LIAN Chuanqiang,et al.Multirobot formation control with kernel-based reinforcement learning[J].Robot,2011,33(3):379-384.

[22] FANG M,GROEN F C A,LI H.Collaborative multiagentreinforcementlearningbasedonanovel coordination tree frame with dynamic partition[J].EngineeringApplicationsofArtificialIntelligence,2014,27:191-198.

[23] BOWLING M,Multi agent learning in the presence of agentswithlimitations[D].Pittsburgh:Carnegie Mellon University,2003.

[24] CAI Yifan,YANG Simon X,XU Xin.A hierarchical reinforcement learning-based approach to multi-robot cooperationfortargetsearchinginunknown environments[J].Control and Intelligent Systems,2013,41(4):218-30.

[25] DICKENS L,BRODA K,RUSSO A.The dynamics of multi-agentreinforcementlearning[C]∥In19th EuropeanConferenceonArtificialIntelligence(ECAI).Lisbon:Univ Lisbon,FacSci,2010:367-372.

[26] 徐昕,沈栋,高岩青,等.基于马氏决策过程模型的动态系统学习控制:研究前沿与展望[J].自动化学报,2012,38(5):673-687.XU Xin,SHEN Dong,GAO Yanqing,et al.Learning control of dynamical systems based on Markov decision processes:research frontiers and outlooks[J].Acta Automatica Sinica,2012,38(5):673-687.

[27] 沈晶,刘海波,张汝波,等.基于半马尔可夫对策的多机器人分层强化学习[J].山东大学学报:工学版,2010,40(4):1-7.SHEN Jing,LIU Haibo,ZHANG Rubo,et al.Multirobot hierarchical reinforcement learning based on semi-Markovgames[J].JournalofShandong University:Engineering Science,2010,40(4):1-7.

[28] GHAVAMZADEH M,MAHADEVAN S.Hierarchical average reward reinforcement learning[J].Journal of Machine Learning Research,2007,8:2629-2669.

[29] ZUO Lei,XU Xin,LIU Chunming.A hierarchical reinforcementlearningapproachforoptimalpath tracking of wheeled mobile robots[J].Neural Computing&Applications,2013,23(7/8):1873-1883.

[30] KAWANO H.Hierarchical sub-task decomposition for reinforcementlearningofmulti-robotdelivery mission[C]∥In IEEE International Conference on Robotics and Automation(ICRA).Karlsruhe:IEEE,2013:828-835

[31] SUN Xueqing,MAO Tao,LAURA R.Hierarchical stateabstracted and socially augmented Q-Learning for reducingcomplexityinagent-basedlearning[J].Journal of Control Theory and Applications,2011,9(3):440-50.

[32] SINGH SP,JAAKOLAT,JORDANMI.Reinforcement learning with soft state aggregation[M].Cambridge:MIT Press,1995:361-368.

[33] MORIARTY D,SCHULTZ A,GREFENSTETTE J.Evolutionary algorithms for reinforcement learning[J].Journal of Artificial IntelligenceResearch,1999,11(1):241-276.

[34] BERTSEKAS D P,TSITSIKLIS J N.Neuro-dynamic programming[M].Belmont:Athena Scientific,1996:107-109.

[35] PALLOTTINO L,VINCENZO G S,BICCHIA.Decentralized cooperative policy for conflict resolution in multivehicle systems[J].IEEE Transactions on Robotics,2007,23(6):1170-1183.

[36] ZHANG Wenxu,CHEN Xiaolong,MA Lei.Online planningformulti-agentsystemswithconsensus protocol[C]∥In 33nd Chinese Control Conference.Nanjing:IEEE,2014:1126-1131.

[37] 陈学松,刘富春.一类非线性动态系统基于强化学习的最优控制[J].控制与决策,2013,28(12):1889-1893.CHEN Xuesong,LIU Fuchun.Optimal control of a classofnonlineardynamicsystemsbased onreinforcement learning[J].Control and Decision,2013,28(12):1889-1893.

[38] XIEMengchun.Representationoftheperceived environment and acquisition of behavior rule for multiagent systems by Q-learning[C]∥In 4th International ConferenceonAutonomousRobotsandAgents.Wellington:Inst of Elec and Elec Eng,2009:453-457.

[39] REINALDO A C B,MARTINS M F,RIBEIRO C H C.Heuristically accelerated multi agent reinforcementlearning[J].IEEETransactionsonCybernetics,2014,44(2):252-265.

[40] K-LIN L J.Self-improving reactive agents based on reinforcement learning,planning and teaching[J].Machine Learning,1992,8(3/4):293-321.

[41] MODARES H,LEWIS F L,NAGHIBI-SISTANI M B.Integral reinforcement learning and experience replay foradaptiveoptimalcontrolofpartially-unknown constrained-inputcontinuous-timesystems[J].Automatica,2014,50(1):193-202.

[42] 蔡自兴,任孝平,邹磊.分布式多机器人通信仿真系统[J].智能系统学报,2009,4(4):309-313.CAI Zixing,REN Xiaoping,ZOU Lei.A simulated communications system for distributed multi robots[J].CAAI Transactions on Intelligent Systems,2009,4(4):309-313.

[43] MARAVALL D,JAVIER D L,DOMINGUEZ R.Coordination of communication in robot teams by reinforcement learning[J].Robotics and Autonomous Systems,2013,61(7):661-666.

[44] 马磊,史习智.多智能体系统中一致性卡尔曼滤波的研究进展[J].西南交通大学学报,2011,46(2):287-293.MA Lei,SHI Xizhi.Recent development on consensusbased Kalman filtering in multi-agent systems[J].JournalofSouthwestJiaotongUniversity,2011,46(2):287-293.

[45] YILIN M,BRUNO S.Communication complexity and energy efficient consensus algorithm[C]∥2nd IFAC Workshop on Distributed Estimation and Control in Networked Systems.Annecy:The IFAC Secretariat,2010:209-214

[46] KOWALSKI D R,GILBERT S.Distributed agreement withoptimalcommunicationcomplexity[C]∥Proceedings of the 21st Annual ACM-SIAM Symposium onDiscreteAlgorithms.Austin:Associationfor Computing Machinery,2010:965-977.

[47] DWORMAN G,KIMBROUGH S O,LAING J D.Bargaining by artificial agents in two coalition games:a studyingeneticprogrammingforelectronic commerce[C]∥Proceedings of Genetic Programming 1996 Conference.Stanford:MIT Press,1996:54-62.

[48] NUNES L,OLIVEIRA E.Cooperative learning using advice exchange[J].Adaptive Agents and Multi-Agent Systems,2003,2636:33-48.

[49] 柯文德,洪炳镕,崔刚,等.一种基于π-MaxQ学习的多机器人协作方法[J].智能计算机与应用,2013,3(3):13-17. KE Wende,HONG Bingrong,CUI Gang,et al.A cooperative method for multi robots based on π-MaxQ[J].Intelligent Computer and Applications,2013,3(3):13-17.

[50] JOB J,JOVIC F,LIVADA C.Q-learning by the nth step state and multi-agent negotiation in unknown environment[J].Tehnicki Vjesnik-Technical Gazette,2012,19(3):529-534.

[51] HOLLANDJ H.Properties of the bucket brigade[C]∥Proceedings of the 1st International Conference on Genetic Algorithms.Berlin:Springer-Verlag,1985:1-7.

[52] CHAPMAN K L,BAY J S.Task decomposition and dynamic policy merging in the distributed Q-learning classifiersystem[C]∥ProceedingsofIEEE International Symposium on Computational Intelligence in Robotics and Automation,CIRA.Monterey:IEEE Computer Society,1997:166-171.

[53] ONO N,IKEDA O,FUKUMOTO K.Acquisition of coordinatedbehaviorbymodularQ-learning agents[J].IEEEInternationalConferenceon Intelligent Robots and Systems,1996,3:1525-1529.

[54] BAY J S,STANHOPE J D.Distributed optimization of tacticalactionsbymobileintelligentagents[J].Journal of Robotic Systems,1997,14(4):313-323.

[55] RAEISY B,HAGHIGHI S G,SAFAVI A A.Active noisecontrolsystemviamulti-agentcredit assignment[J].JournalofIntelligent&Fuzzy Systems,2014,26(2):1051-1063.

[56] ZAHRA R,HAMID B.Addition of learning to critic agent as a solution to the multi-agent credit assignment problem[C]∥5th International Conference on Soft Computing,Computing with Words and Perceptions in System Analysis,Decision and Control.Famagusta:IEEE Computer Society,2009:219-222.

[57] NG A Y,RUSSELL S J.Algorithms for inverse reinforcement learning[C]∥Proceedings of the 17th International Conference on Machine Learning.San Francisco:Morgan Kaufmann,2000:663-670.

[58] RAMACHANDRAN D,AMIR E.Bayesian inversereinforcement learning[C]∥Proceedings of the 20th InternationalJointConferenceonArtificial Intelligence.Hyderabad:IJCAI,2007:2586-2591.

[59] MICHINB,JONATHANPH.Improvingthe efficiencyofbayesianinversereinforcement learning[C]∥IEEEInternationalConferenceon Robotics and Automation(ICRA).St Paul:IEEE,2012:3651-3656.

[60] 张长水.机器学习面临的挑战[J].中国科学:信息科学,2013,43(12):1612-1623.ZHANG Changshu.Challenges in machine learning[J].ScientiaSinica:Informationis,2013,43(12):1612-1623.

[61] 席裕庚,张纯刚.一类动态不确定环境下机器人滚动路径规划[J].自动化学报,2002,25(2):261-175.XI Yugeng,ZHANG Chungang.Rolling path planning of mobile robot in a kind of dynamic uncertain environment[J].Acta Automatica Sinica,2002,25(2):261-175.

[62] MARTINEZ-GIL F,LOZANO M,FERNANDEZ F.Multi-agentreinforcementlearningforsimulating pedestrian navigation[C]∥In Adaptive and Learning Agents,International Workshop.Berlin:Springer-Verlag,2011,7113:54-69.

[63] ROKHLO M Z,ALI S,HASHIM M,et al.Multiagentreinforcementlearningforrouteguidance system[J].International Journal of Advancements in Computing Technology,2011,3(6):224-232.

[64] WANGZeying,SHIZhiguo,LIYuankai.The optimization of path planning for multi-robot system usingBoltzmannPolicybasedQ-learning algorithm[C]∥In IEEE International Conference on RoboticsandBiomimetics(ROBIO).Shenzhen:IEEE,2013:1199-204.

[65] MORTAZA Z A,ALI S,HASHIM S Z.Mohd,modeling of route planning system based on Q valuebaseddynamicprogrammingwithmulti-agent reinforcementlearningalgorithms[J].Engineering Applications of Artificial Intelligence,2014(29):163-177.

[66] GERAMIFARDA,REDDINGJ,HOWJP.Intelligentcooperativecontrolarchitecture:a framework for performance improvement using safe learning[J].Journal of Intelligent&Robotic Systems,2013,72(1):83-103.

[67] 王冲,景宁,李军,等.一种基于多Agent强化学习的多星协同任务规划算法[J].国防科技大学学报,2011,33(1):53-58.WANG Chong,JING Ning,LI Jun,et al.An algorithm of cooperative multiple satellites mission planning based on multi-agent reinforcement learning[J].JournalofNationalUniversityofDefense Technology,2011,33(1):53-58.

[68] DAHL T S,MATARIC M,SUKHATME G S.Multirobottaskallocationthroughvacancychain scheduling[J].Robotics and Autonomous Systems, 2009,57(6/7):674-687.

[69] SU Zhaopin,JIANG Jianguo,LIANG Changyong,et al.A distributed algorithm for parallel multi-task allocation based on profit sharing learning[J].Acta Automatica Sinica,2011,37(7):865-872.

[70] 段勇,崔宝侠,徐心和.多智能体强化学习及其在足球机器人角色分配中的应用[J].控制理论与应用,2009,26(4):371-376.DUAN Yong,CUI Baoxia,XU Xinhe.Multi-agent reinforcementlearninganditsapplicationtorole assignment of robot soccer[J].Control Theory&Applications,2009,26(4):371-376.

[71] ADAM S,LUCIAN B,BABUŠKA R.Experience replay for real-time reinforcement learning control[J].IEEE Transactions on Systems,Man and Cybernetics Part C:Applications and Reviews,2012,42(2):201-212.

[72] MARTINR,THOMASG,ROLANDH.Reinforcementlearningforrobotsoccer[J].Autonomous Robots,2009,27(1):55-73.

[73] HWANG K S,CHEN Y J,LEE C H.Reinforcement learning in strategy selection for a coordinated multirobot system[J].IEEE Transactions On Systems Man and Cybernetics Part A Systems and Humans,2007,37(6):1151-1157.

[74] OLVI L M,SHAVLIK J W,EDWARD W W.Knowledgebasedkernelapproximation[J].The Journal of Machine Learning Research Archive,2004,5:1127-1141.

[75] RICHARD M,JUDE S,LISA T,et al.Giving advice about preferred actions to reinforcement learners via knowledge-based kernel regression[C]∥Proceedings ofthe20thNationalConferenceonArtificial Intelligence.Pittsburgh:AmericanAssociationfor Artificial Intelligence,2005:819-824.

[76] KWAK D J,KIM H J.Policy improvements for probabilisticpursuit-evasiongame[J].Journalof Intelligent&Robotic Systems,2013,74(3/4):709-724.

[77] LIJun,PANQishu,HONGBingrong.Anew approach of multi-robot cooperative pursuit based on association rule data mining[J].International Journal of Advanced Robotic Systems,2009,6(4):329-336.

[78] BOUZY B,M TIVIER M.Multi-agent model-based reinforcement learningexperimentsinthepursuit evasion game[D].Paris:Paris Descartes University,2008.

[79] LIU Shuhua,LIU Jie,CHENG Yu.A pursuit-evasionalgorithmbasedonhierarchicalreinforcement learning[J].Information:AnInternationalInterdisciplinary Journal,2010,13(3):635-645.

[80] ZHANG Wenxu,CHEN Xionglong,MA Lei.Multiagentsystempursuitwithdecision-makingand formationcontrol[C]∥32ndChineseControl Conference,Xi'an:IEEE,2013:7016-7022.

[81] 倪志伟,胡汤磊,吴晓璇,等.基于分形理论的一种新的机器学习方法:分形学习[J].中国科学技术大学学报,2013,43(4):265-270.NI Zhiwei,HU Tanglei,WU Xiaoxuan,et al.A novel machine learning approach based on fractal theory:Fractal learning[J].Journal of University of Science and Technology of China,2013,43(4):265-270.

[82] 陈卫东,朱奇光.基于模糊算法的移动机器人路径规划[J].电子学报,2011,39(4):971-974.CHEN Weidong,ZHU Qiguang.Mobile robot path planningbasedonfuzzyalgorithms[J].Acta Electronica Sinica,2011,39(4):971-974.

[83] JUANG C F,HSU C H.Reinforcement ant optimized fuzzy controller for mobile-robot wall-following control[J].IEEE Transactions on Industrial Electronics,56(10):3931-3940,2009

[84] 徐明亮,柴志雷,须文波.移动机器人模糊Q-学习沿墙导航[J].电机与控制学报,2010,14(6):83-88.XU Mingliang,CHAI Zhilei,XU Wenbo.Wallfollowing control of a mobile robot with fuzzy Q-learning[J].Electric Machines and Control,2010,14(6):83-88.

[85] 陈宗海,杨志华,王海波,等.从知识的表达和运用综述强化学习研究[J].控制与决策,2008,23(9):961-968.CHEN Zonghai,YANG Zhihua,WANG Haibo,et al.Overview of reinforcement learning from knowledge expression and handling[J].Control and Decision,2008,23(9):961-968.

[86] 黄晗文,郑宇.强化学习中基于定性模型的知识传递方法[J].计算机工程与科学,2011,33(6):118-124.HUANG Hanwen,ZHENG Yu.Knowledge transfer method based on the qualitative model in reinforcement learning[J].Computer Engineering&Science,2011,33(6):118-124.

[87] 王皓,高阳,陈兴国.强化学习中的迁移:方法和进展[J].电子学报,2008,36(12A):39-43.WANG Hao,GAO Yang,CHEN Xingguo.Transfer of reinforcement learning:the state of the art[J].Acta Electronica Sinica,2008,36(12A):39-43.

[88] 朱美强,程玉虎,李明,等.一类基于谱方法的强化学习混合迁移算法[J].自动化学报,2012,38(11):1765-1776.ZHU Meiqiang,CHENG Yuhu,LI Ming,et al.A hybrid transfer algorithm for reinforcement learning based on spectral method[J].Acta Automatica Sinica,2012,38(11):1765-1776.

[89] BORJA F G,JOSE M L G,MANUEL G.Transfer learning with partially constrained models:application to reinforcement learning of linked multicomponent robot system control[J].Robotics and Autonomous Systems,2013,61(7):694-703.

[90] GEISTM,PIETQUINO.Kalmantemporal differences[J].JournalofArtificialIntelligence Research,2010,39:483-532.

[91] PIETQUIN O,GEIST M,CHANDRAMOHAN S,et al.Sampleefficienton-linelearningofoptimal dialoguepolicieswithKalmantemporal differences[C]∥InternationalJointConferenceon ArtificialIntelligence(IJCAI).Barcelona:InternationalJointConferencesonArtificial Intelligence,2011:1878-1883.

[92] GEIST M,PIETQUIN O.Revisiting natural actorcritics with value function approximation[J].Modeling Decisions for Artificial Intelligence,2010,6408:207-218.

[93] FERREIRA L A,COSTA R,CARLOS H,et al.Heuristicallyacceleratedreinforcementlearning modularization for multi-agent multi-objective problems[J].Applied Intelligence,2014,41(2):551-562.

[94] 刘全,李瑾,傅启明,等.一种最大集合期望损失的多目标Sarsa(λ)算法[J].电子学报,2013,41(8):1469-1473.LIU Quan,LI Jin,FU Qiming,et al,A multiple-goal Sarsa(λ)algorithm based on lost reward of greatest mass[J].Acta Electronica Sinica,2013,41(8):1469-1473.

[95] WANG Weijia,SEBAG M.Hypervolume indicator and dominance reward based multi-objective Monte-Carlo tree search[J].Machine Learning,2013,93(2/3):403-29.

[96] SNEL M,WHITESON S.Learning potential functions and their representations for multi-task reinforcement learning[J].AutonomousAgentsandMulti-Agent Systems,2014,28(4):637-681.

(中文编辑:唐 晴 英文编辑:周 尧)

A Review of Developments in Reinforcement Learning for Multi-robot Systems

MA Lei, ZHANG Wenxu, DAI Chaohua

(School of Electrical Engineering,Southwest Jiaotong University,Chengdu 610031,China)

Reinforcement learning(RL)is an effective mean for multi-robot systems to adapt to complex and uncertain environments.It is considered as one of the key technologies in designing intelligent systems.Based on the basic ideas and theoretical framework of reinforcement learning,main challenges such as partial observation,computational complexity and convergence were focused.The state of the art and difficulties were summarized in terms of communication issues,cooperative learning,credit assignment and interpretability.Applications in path planning and obstacle avoidance,unmanned aerial vehicles,robot football,the multi-robot pursuit-evasion problem,etc.,were introduced.Finally,the frontier technologies such as qualitative RL,fractal RL and information fusion RL,were discussed to track its future development.

multi-robot systems;reinforcement learning;Markov decision process;computational complexity;uncertainties

TP181

:A

0258-2724(2014)06-1032-13

10.3969/j.issn.0258-2724.2014.06.015

2014-05-28

国家自然科学基金资助项目(61075104)

马磊(1972-),男,教授,博士,研究方向为控制理论及其在机器人、新能源和轨道交通系统中的应用,

E-mail:malei@swjtu.edu.cn

马磊,张文旭,戴朝华.多机器人系统强化学习研究综述[J].西南交通大学学报,2014,49(6):1032-1044.