面向动感影院交互控制的视频分析方法

孟 宇,王长波

(华东师范大学 软件学院,上海 200062)

面向动感影院交互控制的视频分析方法

孟宇,王长波

(华东师范大学 软件学院,上海 200062)

动感影院给人身临其境体验的关键在于与影片视频结合的互动操控.传统的互动控制方法是根据影片手动编辑动感座椅的运动参数文件,费时费力也不精确.设计并实现了一种基于视频的智能分析方法,可以对视频进行自动分析反求出摄像机参数,经过智能编辑后传递给动感座椅.实验表明,该方法能够快速准确求解影片中摄像机的位姿信息,满足动感影院中播放的实时性,给观众更强的体验感.

动感影院;视频处理;特征点;交互控制

动感影院是从传统的立体影院基础上发展而来的,具有主题突出、科技含量高、效果逼真等特点,越来越受到观众喜欢.动感影院的一个主要技术问题是动感座椅的操控.这需要求得影片摄像机的自身三维位姿,从而实现座椅有更强的动感效果,而不仅仅是简单颠簸震动效果.目前的互动控制方法,或者依靠美工根据影片手动编辑动感座椅的运动参数文件,或者采用摇杆设备硬件来计算,费时费力且不精确,影响了互动体验感.

动感影院交互控制的关键是获取摄像机的运动参数. 文献[1]提出了基于SIFT[2](scale-invariant feature transform)的目标识别和粒子滤波定位方法,实现单目摄像机的自定位. 文献[3-4]提出的Mono-SLAM算法[5]可以定位单个摄像头的三维轨迹. 文献[6]结合基于卡尔曼滤波的视觉算法,提高了Mono-SLAM算法的鲁棒性和可靠性.但在动感影院的互动控制中,由于涉及动感座椅机械运动幅度限制等,同时需要一些特效运动,比传统的视频反求更复杂.

本文提出了一种面向动感影院播放控制的视频智能反求方法,采用自动化的智能视频分析过程,基于时间动作码的动态影院软硬协同控制方式,实现精确的六自由度动感平台控制具体包括以下几步:(1)检测和跟踪基于视频的特征点;(2)根据特征点求解摄像机六自由度信息;(3)定义一套匹配运算规则,把摄像机的位姿参数映射到动感座椅的运动范围上,并且对摄像机镜头剧烈运动做监测和处理;(4)把六自由度信息编成指令通过网络通信接口传到动感座椅.

1 基于视频特征点的检测和跟踪

采用光流检测与跟踪运动目标是计算机视觉[7]领域一个很重要的研究方向.文献[8]采用了Horn-Schunck[9]方法计算光流;文献[9]提出一个VLSI(very large scale integration)计算框架来改进Lucas-Kanade[10]方法,从而快速估计光流. 本文采用改进的Lucas-Kanade光流法进行检测和跟踪,图像序列中的光流可以通过跟踪相邻帧的特征点来进行计算.光流计算的两个基本假设条件是亮度恒定和时间连续[11].对于图像中某个点P(x,y),在t时刻的亮度为I(x,y,t),运动速度为(u, v).在Δt→0时间内,亮度不变,可以得出:

I(x, y, t) = I(x + uΔt, y + vΔt, t+Δt)

(1)

在光流计算中,当光流较大,也就是物体运动范围较大时,计算误差可能会比较大,这里采用图像金字塔[12]的方法来提高计算的鲁棒性.当图像分解到一定层后,相邻的帧之间图像运动量将变得足够小,满足光流计算的约束条件.

金字塔特征跟踪的步骤:从最上层开始,计算出光流、仿射矩阵、变换矩阵,并把计算结果传递给下一层图像;然后计算下一层的光流、仿射矩阵、变换矩阵,直到计算得到最后一层的光流、仿射矩阵、变换矩阵.假设计算得到某一层的光流gL、仿射矩阵GL、位移矢量dL和变换矩阵AL,那么下一层的计算结果[13]为

gL-1=2(gL+GLdL)

GL-1=GLAL

(2)

2 摄像机六自由度信息的反求

由目标物体上的若干个特征点和它们在图像中的对应点,可以计算得到目标物体的位姿参数变化[14].本文采用的POSIT(pose from orthography and scaling with iterations)算法[15]是高精度的摄像机位姿求解算法,并且满足实时性的要求.

图1所示为尺度正交投影和透视投影的模型.以P0为参考点定义目标参考坐标系为(P0u,P0v,P0w).特征点Pi在参考坐标系的坐标为(Ui,Vi,Wi),在图像坐标系的对应点为pi(xi,yi),Pi在摄像机坐标系的坐标记作 (Xi,Yi,Zi).特征点Pi的尺度正交投影点为Qi.经过特征点P0取平行于像平面G的平面D,投影中心O到它的距离为Z0.将特征点Pi正交投影到平面D于Qi,再将Qi透视投影到平面G于qi.

图1 尺度正交投影和透视投影的模型示意图Fig.1 Model of scale orthogonal projection and perspective projection

位姿计算主要是求解摄像机的旋转矩阵R和平移向量T.旋转矩阵R是摄像机坐标系的单位向量i, j, k在物体坐标系(P0u,P0v,P0w)中的投影.可以表示为

(3)

摄像机坐标系原点Oc和参考点P0之间的向量是平移向量T,即坐标值Z0.物体姿态的求解,即求解i, j,X0,Y0和Z0.目标坐标系和摄像机坐标系的对应关系为

(4)

(5)

(6)

在给定εi下,可以通过式(5)的线性方程组归一化得到i, j和Z0,再由式(6)得到更精确的εi,然后将εi迭代计算得到更精确的位姿参数.最后,根据摄像机坐标系和目标坐标系之间的关系(式(3)),求解出摄像机的六自由度信息.

3 动感座椅的参数映射和调整

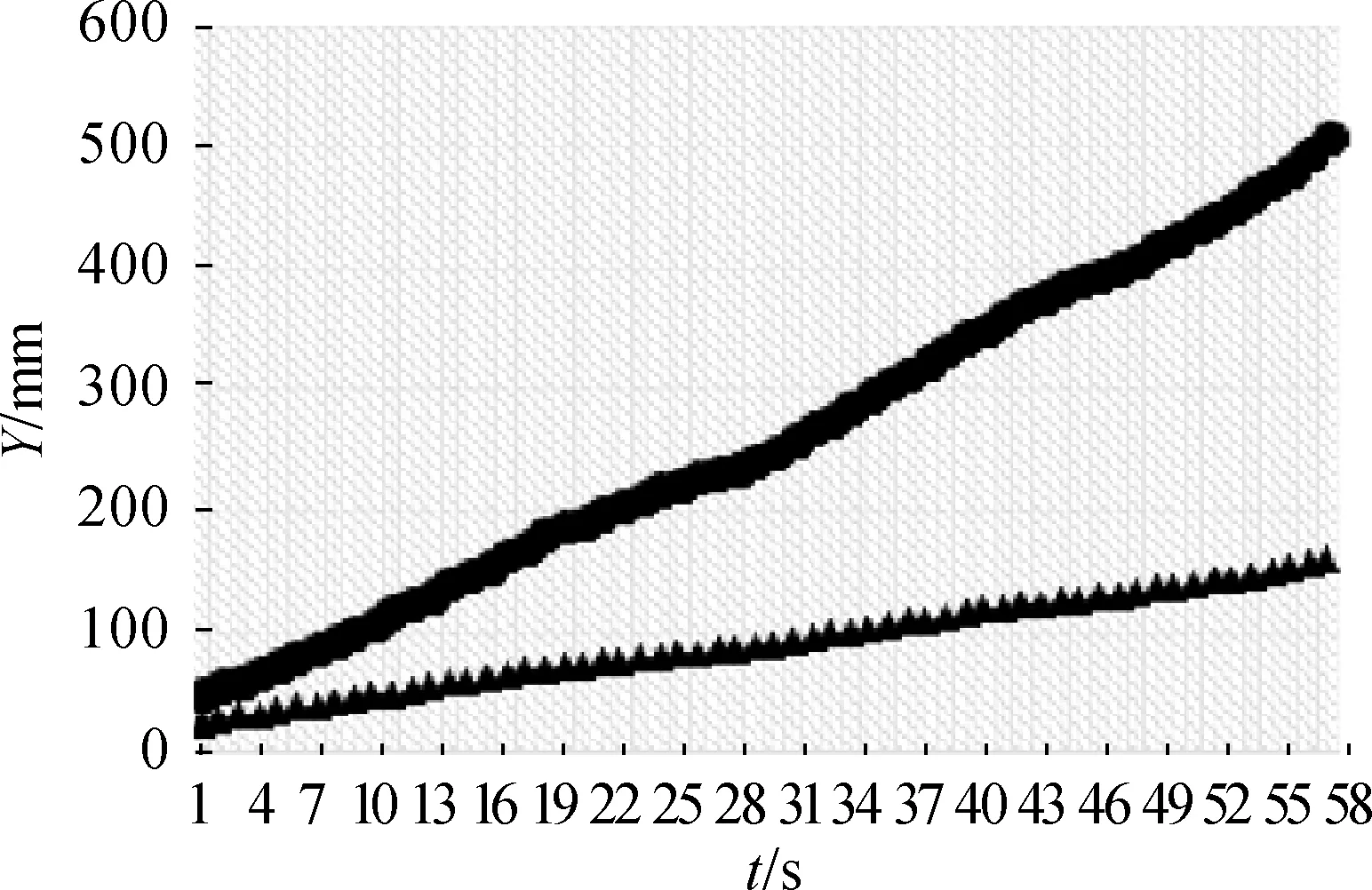

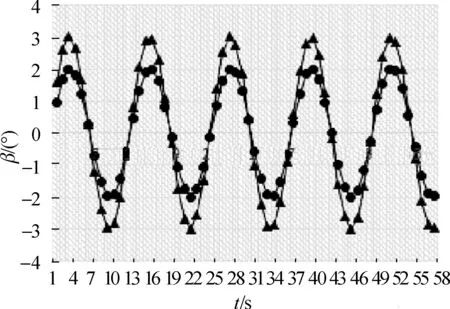

由于摄像机六自由度参数信息与动感座椅的运动范围(位移为±200 mm,偏转角度为±15°)不是直接对应的,本文设计了一套合理的运算规则,对六自由度参数做了映射处理(图2所示),其中,X,Y,Z分别代表摄像机和座椅在三维空间中的坐标,α, β, γ分别代表摄像机和座椅的偏转角度.当动感座椅的运动参数在摄像机动作比较小时(在±30 mm内)略微放大,若某个方向的位移为d(0<|d|<30 mm),那么调整后的d′=d/sin2(|d|·2+30);在摄像机动作比较大时(大于100 mm或小于-100 mm)作了缩减处理,若某个方向的位移为d(|d|>100 mm),那么调整后的d′=40·d1/5.其他的位移参数直接映射. 对摄像机偏转角度介于±3°的参数做了放大,若某个方向的偏转角度为c(0<|c|<3°),那么调整后的c′=c·sin(|c|·2+30). 对偏转角度大于10°或小于-10°的参数做了缩小,若某个方向的偏转角度为c(|c|>10°),那么调整后的c′=c·cos3(|c|·2-30).其他的偏转参数直接映射.

考虑到动感座椅突然剧烈运动可能会引起危险,对于前后时刻的六自由度参数相差太大(位移差超过50 mm,偏转角度差超过5°),则后一时刻的位移或者偏转角就会调整到前一时刻与阈值的差值,确保动感影院安全运行.

图2 摄像机参数和动感座椅六自由度参数Fig.2 Parameters of camera and dynamic seats

4 实验效果

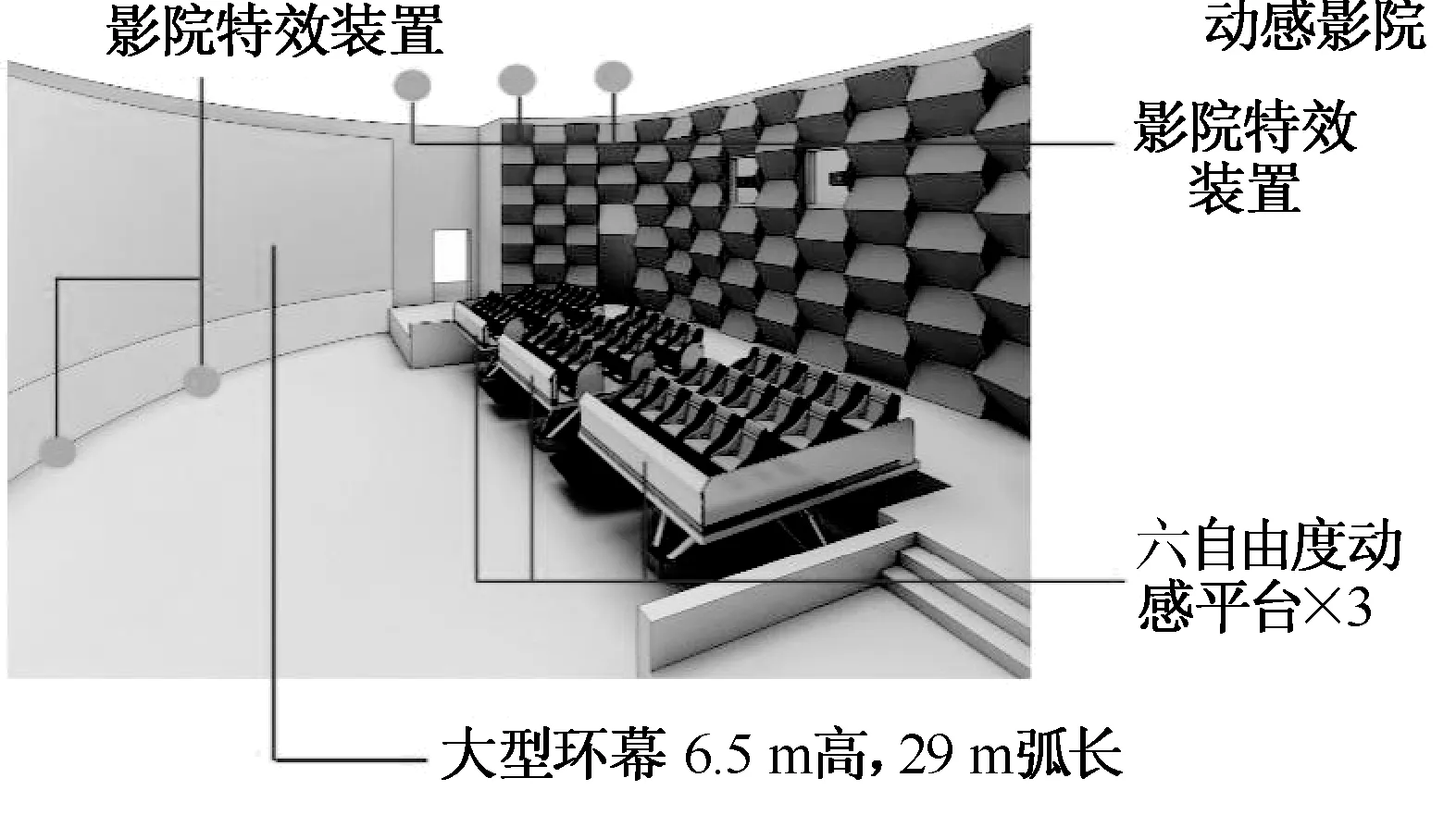

基于以上理论与方法,本文研发了动感影院的控制集成系统,包括影院总控制系统、影片放映系统、动感座椅平台及控制系统和环境特效控制系统

4.1六自由度信息的显示与智能编辑

在影片放映系统(图3所示)六自由度参数显示区域,显示了影片实时计算结果,以及添加人为震动后的结果.

图3 影片放映系统和影院总控制系统界面Fig.3 System interface of video playing and major control

在交互操作一栏,可以添加合适的周期性震动.目前分别定义了舒缓和剧烈两种震动:(1)频率为3 Hz,振幅为3 mm;(2)频率为2 Hz,振幅为5 mm.

4.2动感座椅的交互控制

输出结果操作会将六自由度信息以文本方式保存到本地,以备检查或其他需要,也可以直接将六自由度信息通过指令方式传到动感座椅. 影院总控制系统能够自动控制所有与影片放映有关的活动并使之同步运作,系统自动监测各分系统,显示系统现状,并根据预先编排的任务发出指令,控制影院的自动运行.

该系统在四川省级综合科普教育基地等动感影院中示范应用(图4所示),不仅可以智能方便地进行互动参数文件的获取,同时智能编辑也为动感影院的特效控制提供了便利,运动的连贯性和体验感得到了大大增强.

图4 动感影院示意图Fig.4 Schematic diagram of live movie theatre

5 结 语

本文提出的面向动感影院播放控制的视频智能分析方法解决了单目摄像机定位困难的问题,添加了周期性震动的交互设计,实现了从摄像机参数到动感座椅的映射,可以运用到虚拟现实中,具有主题突出、效果逼真、画面冲击性强等特点.未来的工作包括:进一步提高摄像机位姿计算的准确率,以及时间编码动作信息转换成平台动作的准确度,并添加更多的交互功能.

[1] KARLSSON N, BERNARDO E, OSTROWSKI J, et al. The vSLAM algorithm for robust localization and mapping[C]// International Conference on Robotics and Automation. 2005:24-29.

[2] LOWE D. Object recognition from local scale-invariant features[C]//In Proc of the International Conference on Computer Vision (ICCV 1999).1999:1150-1157.

[3] DAVISON A. Real-time simultaneous localization and mapping with a single camera[C]//In Proc of the International Conference on Computer Vision. 2003:1403-1410.

[4] DAVISON A. Active search for real-time vision[C]//Proc 10th Int’l Conf, Computer Vision. 2005:66-73.

[5] DAVISON A, REID I, MOLTON N. MonoSLAM: Real-time single camera SLAM[J]. IEEE Trans Pattern Anal, 2007, 29(6):1052-1067.

[6] SUNDERHAUF N, LANGE S, PROTZEL P. Using the unscented kalman filter in Mono-SLAM with inverse depth parametrization for autonomous airship control[C]//IEEE Int Workshop on Safety, Security and Rescue Robotics. 2007:1-6.

[7] BIRCHFIELD S, RANGARAJAN S. Spatiograms versus histograms for region-based tracking[C]//Int Conf on Computer Vision and Pattern Recognition (CVPR’05). 2005: 1157-1162.

[8] LABUTOV I,JARAMILLO C,XIAO J. Generating nearspherical range panoramas by fusing optical flow and stereo from a single-camera folded catadioptric rig[J].Machine Vision and Application,2013, 24(1):133-144.

[9] MAHALINGAMV, BATTACHARYA K, RANGANATHAN N. A VLSI architecture and algorithm for lucas-kanade-based optical flow computation[J].IEEE Transactions on Very Large Scale Integration System, 2010, 18(1):29-38.

[10] HSIEH C K, LAI S H, CHEN Y C. An optical flow-based approach to robust face recognition under expression variations[J].IEEE Transaction on Image Processing. 2010,19(1):233- 240.

[11] LASARUK A. Approximate regularization for structural optical flow estimation[C]// International Conference on Advanced Concepts for Intelligence Vision Systems. 2012:336- 348.

[12] TOMASI C, KANADE T. Detection and tracking of point features [R]. Carnegie Mellon University Technical Report. 1991.

[13] SENST T, EISELEIN V, SIKORA T. Robust local optical flow for feature tracking[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2012, 22(9):1377-1387.

[14] CHEN P,HU G D.A simple algorithm for camera pose estimation[C]//Proceedings of International Conference on Mechatronics and Automation.Chengdu:IEEE,2012:2181- 2186.

[15] TRIGGS B.Camera pose and calibration from 4 or 5 known 3D points[C]// Proceedings of the 7th IEEE International Conference on Computer Vision.Kerkyra,Greece:IEEE, 1999:278-284.

A Video Analysis Method for Live Theater Interactive Control

MENG Yu, WANG Chang-bo

(Software Engineering Institute, East China Normal University, Shanghai 200062, China)

The key point to be personally on the scene brought by the live theater is the interaction manipulation combined with the film. Traditional interactive control method is to manually edit the motion parameters file of the dynamic seat from the video, which costs lots of time and even not be accurate. An intelligent analysis method is designed and implemented based on video, which can automatically analyze the feature points from the video, then compute six dimensional motion parameters of the camera, and transmit it to the dynamic seat after intelligent editor. Experimental results show that this method can fast compute pose parameters of camera in the film, satisfying the real-time playback in theater movement,giving the audience a stronger experience feeling.

live theater; video analysis; feature points; interactive control

1671-0444(2015)04-0474-04

2014-11-30

国家高技术研究发展计划(863计划)资助项目(2015AA016404);国家自然科学基金资助项目(61272199);教育部博士点基金资助项目(20130076110008);上海科委科技攻关计划重点资助项目(12511504700)

孟宇(1989—),男,浙江嘉兴人,硕士研究生,研究方向为计算机图形学、人机交互等.E-mail:clark_abrams@outlook.com

王长波(联系人),男,教授,E-mail:cbwang@sei.ecnu.edu.cn

TP 301.6

A