医用内窥镜图像计算机辅助诊断研究进展

敬雪平,郑秀娟,刘 凯

四川大学 电气信息学院 自动化系,成都 610065

1 引言

医用内窥镜作为一种重要的医学诊断仪器,主要用于观查人眼不能直接观察或者不方便观察的腔体内组织或者结构。内窥镜按照其应用场景可以分为消化道内窥镜、呼吸道内窥镜、腹膜腔内窥镜和血管内窥镜等,而按照成像构造分类,则可以分为硬管式内窥镜、纤维式内窥镜、电子内窥镜。随着数字成像技术的不断发展,电子内窥镜逐渐取代了纤维内窥镜成为了主流,与纤维内窥镜相比,电子内窥镜的成像质量好、光亮度强、外径更细,更有利于细小病变的检查和医生的操作,同时能够将图像存储起来,便于进一步的分析和诊断。

当前内窥镜图像的诊断主要依赖人工阅片完成,然而日益增加的图像数据也为人工阅片带来极大挑战。例如在使用胶囊内窥镜(Wireless Capsule Endoscope,WCE)进行食道检查的过程中,每个病人会产生约55 000张图像[1],如此多的图片如果人工检视,将会极大地增加医生的工作负担。此外,由于医生之间的个体差异,对于同一个病例,可能得出不同的诊断结果,往往还需要进行二次审查。

为了降低医生的工作强度,同时为疾病的诊断提供有效的辅助诊断信息,以机器学习和图像处理技术为基础的计算机辅助诊断(Computer Aided Diagnosis,CAD)逐渐成为医学领域的研究热点[2]。在眼底疾病自动诊断方面,由Google公司研发的自动诊断方法在准确率上已经超过了人类医生的平均水平[3]。而在皮肤镜图片的诊断方面,Esteva等[4]人研发的自动算法在两种癌症的辨别上也达到了人类专家的水平。与此同时,在内窥镜图像的辅助诊断方面,因为其巨大的市场潜力和较高的研发难度,也逐渐成为相关研究的热点。

本文选取近10年内窥镜领域的计算机辅助诊断相关研究文献展开综述。分别介绍了基于人选特征(Hand-crafted Features)和卷积神经网络(Convolutional Neural Networks,CNN)的相关研究进展。

2 内窥镜图像的特征选取

获得合适的特征表达,是一个分类系统成功的关键。在卷积神经网络兴起之前,根据图像的特点和相关医学经验,提出合适的人选特征往往是设计一个分类系统最大的难点。

传统的内窥镜图像处理研究主要集中于两个方面:(1)图像变换,即通过频域变换、色彩空间变换等方式来充分适应和表达图像的信息,以便于更好地分析和处理图像;(2)图像特征提取,通过提出新的特征算子或算子组合来提高和改进图像分析算法。内窥镜图像的颜色分布与自然图像有较大差异,且不同病变的纹理差异较大,在常见的特征算子SIFT、SURF和HOG算子之外,更多的特异特征算子及其不同算子的组合相继提出。其中利用频域变换来获得有效特征较为常见。

2.1 频域变换

常见的图像频率域变换包括傅里叶变换、小波变换、曲波变换(Curvelet Transform)等,广泛应用于图像去噪、图像压缩、图像融合等领域。频率域变换能够使得图像的某些特征更加突出,从而更有利于特征的选择。

Li等[5]通过曲波变换将肠道内窥镜图像转换到频域,再利用局部二值模式(Local Binary Pattern,LBP)提取特征。曲波变换是良好的多尺度分析工具,同时LBP是一种强大的纹理描述算子,具有旋转不变性和灰度不变性的特征。这两种工具的组合能更加充分提取和利用病灶位置的纹理特征。

为了区分不同结肠癌的种类,Hafner等[6]通过二维离散傅里叶变换获得肠道内窥镜图像的频域表达后,再通过筛选基于傅里叶级数矩阵的特征来更好地区分不同病变类型。由于用于分类的判别信息都是通过对图像的进行频域滤波得到的,因此关键问题转变为构建适当的频域滤波器以得到合适的特征。

Yamaguchi等[7]则利用离散小波变换和分形维数来提取内窥镜图像中癌变部位的特征。将原始图像分解为4个分量,即RGB和亮度分量,并使用离散小波变换分别对这4个分量进行两次变换,再使用方框计数法在每个小块处计算分形维数,并根据分形维数检测异常区域。其中分形维数主要用于衡量小区域的复杂度,他们认为一个异常区域与其他区域的复杂性会有所不同。

Charisis等[8]则将胃部内窥镜图像进行曲波变换后,再利用遗传算法有效地提取病变部位相关的形态学特征。

2.2 色彩空间变换

内窥镜图像通常以RGB图像的形式保存显示,通过色彩空间变换,则可以在不同的色彩空间提取基于色彩的特征,这也是自然图像处理中常见的方法之一。但由于内窥镜图像色彩较为单一(主要以红色分量为主)、亮度变化较大等特点,在设计内窥镜图像的辅助诊断算法时,一些新的方案便被提出以适应上述特点。

Wang等[9]将消化道内窥镜图像由RGB空间转换到HSV空间后,再根据内窥镜图像的特点将色调分量H和饱和度分量S重新加权,形成新的颜色分量,然后分别从颜色直方图和纹理光谱中提取颜色特征和纹理特征。最后使用一个贝叶斯分类器来分类溃疡、出血和癌症图像。他们指出内窥镜图像的色彩分布和自然图像不同,红色分量很多,将其转换到HSV空间中更有利于特征的提取。

为了在WCE图像中检测大肠息肉,Li等[10]则将肠道内窥镜图像转换到HSI空间。首先提出了基于色度直方图的亮度不变颜色特征,使用缩放,平移和旋转不变的泽尔尼克矩(Zernike Moments)作为形状特征,通过这两种特征的结合并使用多层感知器作为分类器来达到在海量图片中检测结肠息肉的目的。

为了获取更充分的特征用于胃食管反流病的诊断,Huang等[11]在6个颜色空间中分别提取两种算子(SIFT和CCH)来表征食管粘膜。

Yuan等[1]则在YCbCr空间中获得了更好的颜色特征用于肠道出血检测。为了充分利用WCE图像的颜色信息,利用K-means算法对图像像素进行聚类,获得聚类中心,并以此生成图像的色彩特征表示,接着通过支持向量机(SVM)和K最近邻(KNN)算法来对WCE图像进行分类。

2.3 其他方法

除了频域变换和色彩空间变换外,其他的特征提取方案也被应用到内窥镜图像处理当中。

Hiroyasu等[12]通过共生矩阵和游程长度矩阵共提取11个特征来评估早期胃癌的病变程度,其中6个特征来自共生矩阵,5个特征来自游程长度矩阵。整合这些特征值可以形成一个有效且具有代表性的特征向量,从而可以明显地显示从病变到正常区域的过渡。

3 基于卷积神经网络的内窥镜图像处理方法

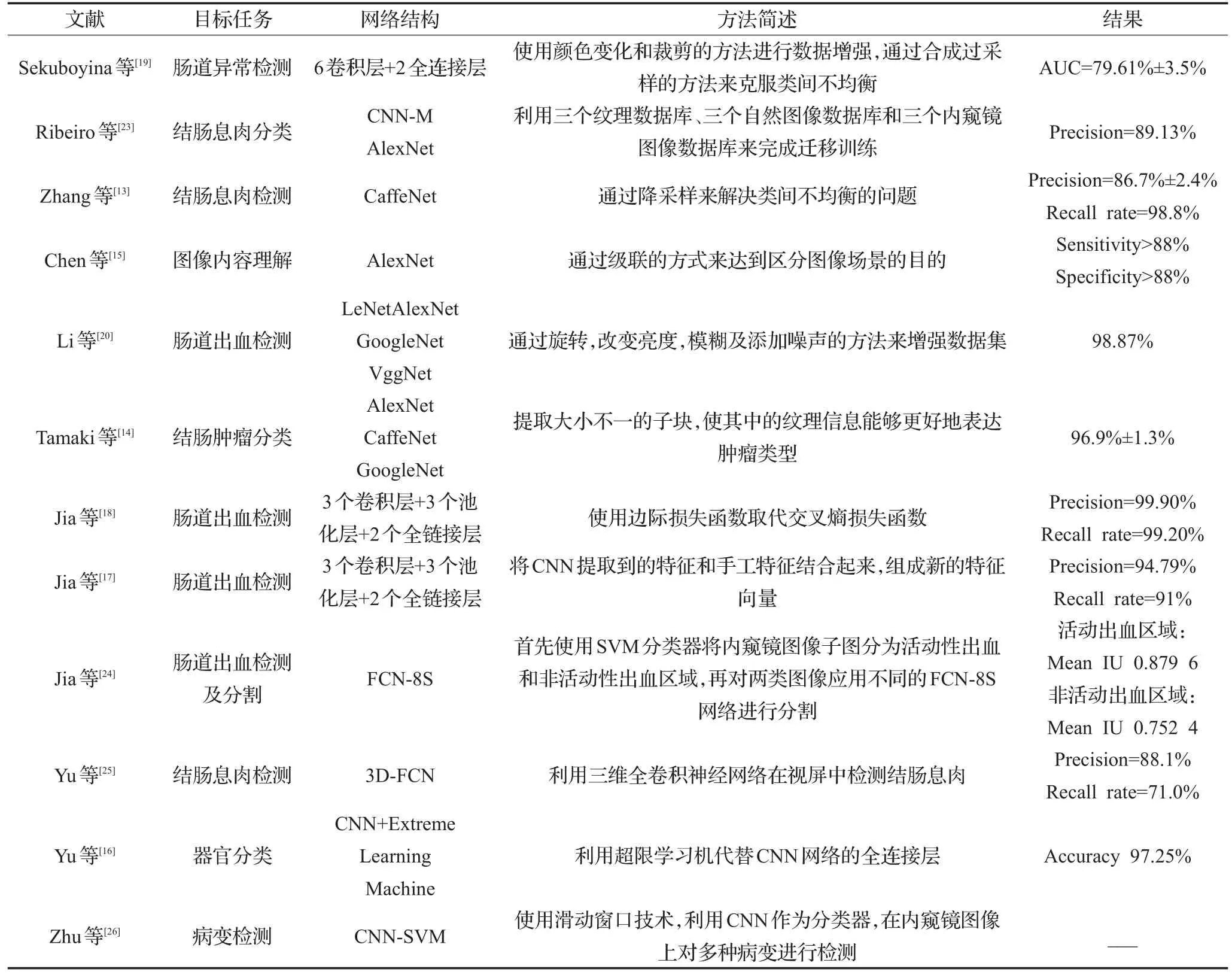

经过数十年的发展,人工神经网络已经被成功应用到多个领域,针对不同的应用场景也发展出了不同的种类。其中在机器视觉领域,卷积神经网络主要应用于图像分类、去噪和分割等应用场景。在自然图像分析取得巨大成功的同时,不少研究都尝试将CNN引入到内窥镜图像的分析当中。基于CNN的内窥镜图像分析方法,主要是利用CNN强大的特征提取能力,取代先前的人选特征的方法,将CNN作为特征提取工具及分类器,来达到病变检测和图片分类的目的(参考表1)。

3.1 特征提取器

CNN具有强大的特征提取能力,通过有监督学习(Supervised Learning),CNN能够学习到足够的特征,并将学到的特征进行组合。在前向传播时,CNN卷积层的每个卷积核都会生成对应的特征图,而卷积核的卷积操作就是一种特征提取的过程。但与手动设计特征不同的是,CNN的卷积核是在损失函数指导下,通过误差反向传播不断更新,并由此获得更好的特征提取效果。CNN的网络结构一般由卷积层、池化层(Pooling Layer)和全连接层组成。其中,卷积层一般用于特征提取,池化层用于减小特征规模,节约计算量,而全连接层则主要起到分类器的作用。但CNN的卷积层在特征提取的过程中也各具特点,比如靠前的卷积层更倾向于对边缘、形状、颜色等低阶特征的提取,而靠后的卷积层则倾向于对高级语义特征的提取。基于这样的特性,CNN的卷积层也被广泛用作特征提取器,以获得更好的特征表达。

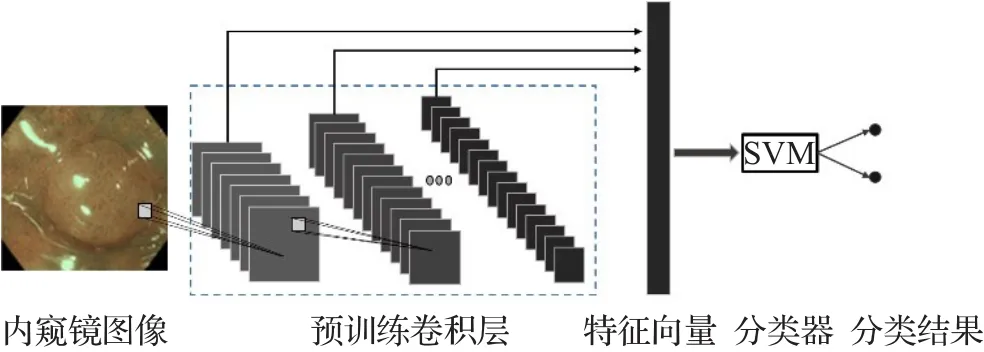

Zhang等[13]利用CNN的特征提取能力,将训练好的CNN网络中生成的特征图向量化后,再交由SVM分类器来进行分类,以此达到结肠息肉检测的目的。如图1所示,每个卷积核在输入图像或前一卷积层的输出上做卷积运算后,都会生成相应的特征图,每个卷积层产生的特征图的数量与卷积核的数量一致,而网络中卷积核的权重则来自用自然场景分类的卷积神经网络的卷积部分。

图1 利用预训练CNN卷积层进行特征提取示意图

Tamaki等[14]也采用了CNN卷积层来提取图像特征以进行结直肠肿瘤的分类。此外,通过在原图像上截取大小不一的子图的方式,使得获得的纹理能够更好地表达肿瘤的类型。

表1 基于卷积神经网络的内窥镜图像处理方法

Chen等[15]利用多个CNN网络级联的方式来完成内窥镜图像的分类,首先利用一个去噪网络来筛查含有粪便、气泡等不利于分类的图像,并将这些图像移除。接着将清晰图像送给下一级的网络进行分类。这种多网络级联的方法将不同的功能分配给不同的网络,使得单个网络的训练变得容易。

Yu等[16]在消化道器官分类的研究中提出,利用超限学习机(Extreme Learning Machine)代替CNN网络的全连接层能够改善最终的分类效果。

Jia等[17]将CNN得到的特征和人工特征相结合,以达到更好的分类效果。其中人工特征使用基于K-means聚类的特征表示。他们指出,采用CNN特征和人选特征相结合的方式,更有利于在小的数据集上获得更好的分类效果。在后续的工作中[18],他们还发现训练CNN网络进行内窥镜图像分类时,使用边缘损失函数代替交叉熵损失函数能够提高准确率。

3.2 数据增强

使用基于CNN的图像处理方法,不可避免地要运用数据增强(Data Augmentation)的方法来扩大训练集,从而提高网络的泛化性能。

Sekuboyina等[19]通过随机裁剪和颜色空间变换的方法来扩增数据集,对于不同种类病变图像的数量不一致导致的类间不均衡,则利用合成过采样的方法来解决。合成过采样是通过插值的方式在样本及其k个最近邻样本中生成新的样本的方法。

同样针对类间不均衡的问题,Zhang等[13]则采取了降采样的方法,即减少数量较多类别的样本数量。利用无线内窥镜设备收集的大量消化道图片样本中,包含病变的图片样本与不含病变的图片样本的数量往往相差巨大,而过多的正常样本并不能提高分类器的性能,相反还会造成过拟合的发生,在这样的情况下,通过降采样的方式来改善类间不均衡是合理的。

此外,旋转、亮度变化、模糊和添加噪声等方式也可以用来获得更多的训练样本[20]。

3.3 迁移学习

迁移学习是使用CNN进行图像分析时的重要手段,能够将其用于其他目的已训练好的CNN模型,通过较少的训练样本进行微调(Fine-tune),来适应新的任务。在自然图像领域,已经拥有庞大的图像数据集,比如ILSVRC,拥有1 000个类别的120万幅图像,而在医学图像领域,获取如此大规模的数据集则几乎是不可能的。因此,迁移学习提供了将在自然图像领域取得成功的网络应用到医学图像领域的桥梁。

Zhang等[13]使用迁移学习的方法,将在ILSVRC上训练的CaffeNet通过1 930张内窥镜图像进行微调,该组内镜图像包括1 104个无息肉图像、263个增生性息肉图像和563个腺瘤性息肉图像。

Tajbakhsh等[21]则通过比较迁移学习和从头学习两种方案在结肠息肉检测等三种医学图像分析任务上的效果得出结论:使用迁移学习的方法获得的CNN模型优于从头训练得到的网络模型。在最坏的情况下,二者的表现也至少相同。

Wimmer等[22]也开展了类似的研究来验证迁移学习对利用CNN进行乳糜泻自动诊断的影响。他们比较了不使用迁移学习和Fine-tune全连接层以及Fine-tune整个网络三种策略,实验结果证实,Fine-tune整个网络能取得最好的结果。

4 结束语

基于医学图像的CAD系统可以辅助临床医生快速、准确、高效地做出诊断决策。然而,无论是人工提取特征,还是基于CNN的算法,都各有优缺点。

手动提取特征具有主观性,并且无法利用高维特征之间的关系所提供的有效信息,但是在样本数量较少的情况下,结合临床经验,人工设计特征依然是设计计算机辅助系统时最好的选择。基于CNN的内窥镜图像分析算法能够自动地提取特征而无需人为设计,而且由于其在自然图像处理领域取得的巨大成功,大量的经验和方法同样可以被引入医学图像处理中。但是CNN的训练往往需要在较大的数据集上进行,而收集一定规模的医学图像数据集往往是十分困难的,并且数据集的标记也需要具备相关资质的医生耗费大量的时间来完成。此外,CNN模型在图像分类和目标检测等领域取得巨大成功的同时,其可解释性则一直被诟病。与手动提取特征不同,CNN中的特征是在反向传播中自动学习到的,这些特征可以通过可视化方法表现出来,但其训练和推导的过程则无法用数学手段予以解释。CNN的“黑盒”特性也成了制约其被医学界接受的关键因素。

利用CNN进行内窥镜图像的处理和分析已经逐渐取代手动提取特征的方法成为主流。早期的研究多将CNN作为特征提取器,将提取到的特征作为其他分类器(如SVM)的输入,而近来相关的研究则更多专注于对新的网络结构的探索和应用(如VggNet、GoogleNet等)。目前,大量的研究都集中于内窥镜图像的分类,关于病变定位和分割的研究则相对较少,而病变定位和分割对于疾病的监测和细粒度的精细分析则至关重要。全卷积神经网络(Fully Convolutional Networks,FCN)模型已经在自然图像语义分割上取得了巨大的进步,相关模型在内窥镜图像上的应用将会对内窥镜图像的精细分析产生巨大的推动作用。

对于医用内窥镜图像的计算机辅助诊断来说,未来的发展可能有如下几个方面:第一,更好的数据增强方法,在训练数据有限的条件下,更好的数据增强方法将会有效提升网络的泛化性能;第二,迁移学习技术的进一步发展,迁移学习的研究处于起步阶段,在自然图像上获取的特征如何更好地应用于医学图像仍然值得进一步研究;第三,网络结构的改进,提出更有效的网络结构以更好地提取图像包含的信息;第四,大型内窥镜图像数据库的建立,这是内窥镜图像处理技术取得进一步发展的关键基础。

随着更多医学图像数据库的建成和神经网络方法的继续发展,可以预见,更多的基于CNN的内窥镜图像辅助诊断系统将会为医生提供更为准确高效的诊断信息。

[1]Yuan Y,Li B,Meng Q.Bleeding frame and region detection in the wireless capsule endoscopy video[J].IEEE Journal of Biomedical&Health Informatics,2015,20(2):624-630.

[2]Doi K.Computer-aided diagnosis in medical imaging:Achievements and challenges[J].IEEE Transactions on Medical Imaging,2009,20(12):1205-1208.

[3]Gulshan V,Peng L,Coram M,et al.Development and validation of a deep learning algorithm for detection of diabetic retinopathy in retinal fundus photographs[J].Jama,2016,316(22):2402.

[4]Esteva A,Kuprel B,Novoa R A,et al.Dermatologist-level classification of skin cancer with deep neural networks[J].Nature,2017,542(7639):115.

[5]Li B,Meng Q H.Ulcer recognition in capsule endoscopy images by texture features[C]//World Congress on Intelligent Control and Automation,2008:234-239.

[6]Hafner M,Brunauer L,Payer H,et al.Computer-aided classification of zoom-endoscopical images using fourier filters[J].IEEE Transactions on Information Technology in Biomedicine A Publication of the IEEE Engineering in Medicine&Biology Society,2010,14(4):958-970.

[7]Yamaguchi J,Yoneyama A,Minamoto T.Automatic detection of early esophageal cancer from endoscope image using fractal dimension and discrete wavelet transform[C]//International Conference on Information Technology-New Generations,2015.

[8]Charisis V S,Hadjileontiadis L J.Use of adaptive hybrid filtering process in Crohn’s disease lesion detection from real capsule endoscopy videos[J].Healthc Technol Lett,2016,3(1):27-33.

[9]Wang B,Yang D.Computer-assisted diagnosis of digestive endoscopic images based on bayesian theory[C]//International Conference on Information Engineering and Computer Science,2009.

[10]Li B,Fan Y,Meng M Q H,et al.Intestinal polyp recognition in capsule endoscopy images using color and shape features[C]//IEEE International Conference on Robotics and Biomimetics,2009.

[11]Huang C R,Chen Y T,Chen W Y,et al.Gastroesophageal reflux disease diagnosis using hierarchical heterogeneous descriptor fusion support vector machine[J].IEEE Transactions on Biomedical Engineering,2016,63(3):588.

[12]Hiroyasu T,Hayashinuma K,Ichikawa H,et al.Endoscope image analysis method for evaluating the extent of early gastric cancer[C]//IEEE Symposium on Computational Intelligence for Multimedia,Signal and Vision Processing(CIMSIVP),2004.

[13]Zhang R,Zheng Y,Mak W C,et al.Automatic detection and classification of colorectal polyps by transferring low-level CNN features from non-medical domain[J].IEEE Journal of Biomedical& Health Informatics,2017(99):1.

[14]Tamaki T,Yoshimuta J,Kawakami M,et al.Computeraided colorectal tumor classification in NBI endoscopy using local features[J].Medical Image Analysis,2013,17(1):78-100.

[15]Chen H,Wu X,Tao G,et al.Automatic content understanding with cascaded spatial-temporal deep framework for capsule endoscopy videos[J].Neurocomputing,2017,229(C):77-87.

[16]Yu J S,Chen J,Xiang Z Q,et al.A hybrid convolutional neural networks with extreme learning machine for WCE image classification[C]//IEEE International Conference on Robotics and Biomimetics,2015.

[17]Jia X,Meng Q H,Jia X,et al.Gastrointestinal bleeding detection in wireless capsule endoscopy images using handcrafted and CNN features[C]//International Conference of the IEEE Engineering in Medicine and Biology Society,2017.

[18]Jia X,Meng M Q.A deep convolutional neural network for bleeding detection in wireless capsule endoscopy images[C]//Conf Proc IEEE Eng Med Biol Soc,2016:639-642.

[19]Sekuboyina A K,Devarakonda S T,Seelamantula C S.A convolutional neural network approach for abnormality detection in Wireless Capsule Endoscopy[C]//IEEE International Symposium on Biomedical Imaging,2017.

[20]Li P,Li Z,Gao F,et al.Convolutional neural networks for intestinal hemorrhage detection in wireless capsule endoscopy images[C]//IEEE International Conference on Multimedia and Expo,2017.

[21]Tajbakhsh N,Shin J Y,Gurudu S R,et al.Convolutional neural networks for medical image analysis:Fine tuning or full training?[J].IEEE Transactions on Medical Imaging,2016,35(5):1299.

[22]Wimmer G,Vécsei A,Uhl A.CNN transfer learning for the automated diagnosis of celiac disease[C]//International Conference on Image Processing Theory Tools and Applications,2017.

[23]Ribeiro E,Uhl A,Wimmer G,et al.Exploring deep learning and transfer learning for colonic Polyp classification[J].Computational&Mathematical Methods in Medicine,2016,2016:6584725.

[24]Jia X,Meng Q H.A study on automated segmentation of blood regions in wireless capsule endoscopy images using fully convolutional networks[C]//IEEE International Symposium on Biomedical Imaging,2017.

[25]Yu L,Hao C,Qi D,et al.Integrating online and offline 3D deep learning for automated polyp detection in colonoscopy videos[J].IEEE Journal of Biomedical&Health Informatics,2016(99):1.

[26]Zhu R,Zhang R,Xue D.Lesion detection of endoscopy images based on convolutional neural network features[C]//International Congress on Image and Signal Processing,2015:372-376.