基于深度学习的问题回答技术研究

李家乐 吴明礼

摘要:針对非事实类问答任务,本文搭建了带有注意力机制的双向长短时记忆(BiLSTM)网络模型。实验表明,在2016 NLPCC QA任务数据集上,该模型MRR可达到75.12%,优于传统的机器学习方法。

关键词:问题回答;深度学习;注意力机制;双向长短时记忆网络

中图分类号:TP311.52 文献标识码:A 文章编号:1007-9416(2019)02-0116-02

0 引言

近年来,深度学习在自然语言处理领域的一些任务上取得了较好的成绩。非事实类问答任务基于深度学习的技术研究具有较高的学术及应用价值。循环神经网络(RNN),其结构可对数据信息起到传递的作用,非常适合于文本数据,因此其及其变体网络在自然语言处理任务中得到了广泛应用[1]。

面向中文问答任务,本文搭建了RNN的变体BiLSTM模型,探索了学习率、注意力机制的影响,并取得了较好的实验效果。

1 模型构建

模型的整体框架包括:向量化模块、深度模型及评分计算模块。

向量化模块:通过一个词表将问题与答案句子转化为向量表示。此处词表是由Word2Vec模型以中文维基百科作为训练语料得到的。其中,Word2Vec是一个可将字词转化为向量形式表达的模型,并且意思相近的词将被映射到向量空间中的相近位置。

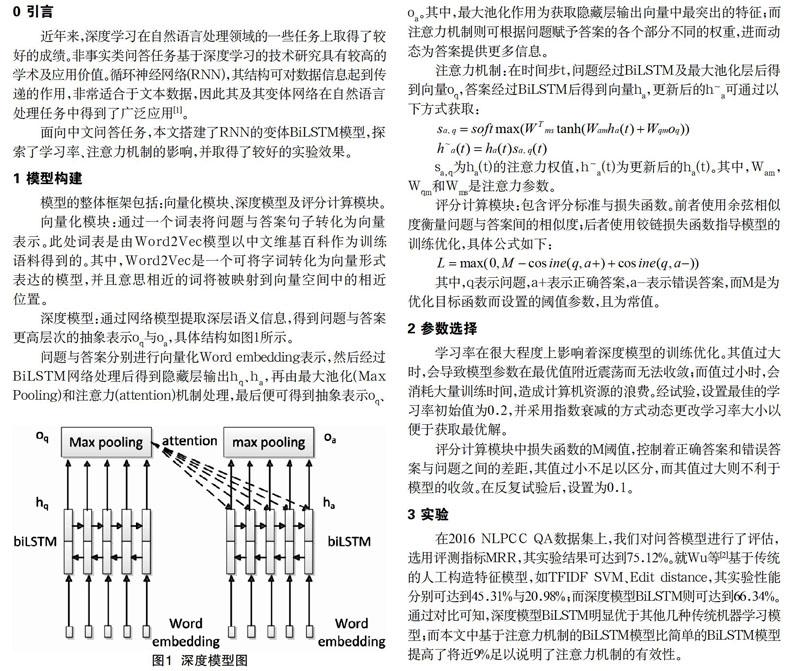

深度模型:通过网络模型提取深层语义信息,得到问题与答案更高层次的抽象表示oq与oa,具体结构如图1所示。

问题与答案分别进行向量化Word embedding表示,然后经过BiLSTM网络处理后得到隐藏层输出hq、ha,再由最大池化(Max Pooling)和注意力(attention)机制处理,最后便可得到抽象表示oq、oa。其中,最大池化作用为获取隐藏层输出向量中最突出的特征;而注意力机制则可根据问题赋予答案的各个部分不同的权重,进而动态为答案提供更多信息。

注意力机制:在时间步t,问题经过BiLSTM及最大池化层后得到向量oq,答案经过BiLSTM后得到向量ha,更新后的h~a可通过以下方式获取:

sa,q为ha(t)的注意力权值,h~a(t)为更新后的ha(t)。其中,Wam,Wqm和Wms是注意力参数。

评分计算模块:包含评分标准与损失函数。前者使用余弦相似度衡量问题与答案间的相似度;后者使用铰链损失函数指导模型的训练优化,具体公式如下:

其中,q表示问题,a+表示正确答案,a-表示错误答案,而M是为优化目标函数而设置的阈值参数,且为常值。

2 参数选择

学习率在很大程度上影响着深度模型的训练优化。其值过大时,会导致模型参数在最优值附近震荡而无法收敛;而值过小时,会消耗大量训练时间,造成计算机资源的浪费。经试验,设置最佳的学习率初始值为0.2,并采用指数衰减的方式动态更改学习率大小以便于获取最优解。

评分计算模块中损失函数的M阈值,控制着正确答案和错误答案与问题之间的差距,其值过小不足以区分,而其值过大则不利于模型的收敛。在反复试验后,设置为0.1。

3 实验

在2016 NLPCC QA数据集上,我们对问答模型进行了评估,选用评测指标MRR,其实验结果可达到75.12%。就Wu等[2]基于传统的人工构造特征模型,如TFIDF SVM、Edit distance,其实验性能分别可达到45.31%与20.98%;而深度模型BiLSTM则可达到66.34%。通过对比可知,深度模型BiLSTM明显优于其他几种传统机器学习模型;而本文中基于注意力机制的BiLSTM模型比简单的BiLSTM模型提高了将近9%足以说明了注意力机制的有效性。

4 结语

本文中,我们探索了BiLSTM与注意力机制在非事实类中文问答任务中的应用。实验所选数据集具有一定权威性,其规模较大,且为开放域。通过实验对比分析,可知深度模型及注意力机制在问答任务中的有效性。

参考文献

[1] Wang B, Liu K, Zhao J. Inner Attention based Recurrent Neural Networks for Answer Selection[C]//ACL (1).2016:1288-1297.

[2] Wu F,Yang M,Zhao T,et al.A Hybrid Approach to DBQA[C]// International Conference on Computer Processing of Oriental Languages. Springer International Publishing, 2016.

Question Answering Technology Research Based on Deep Learning

LI Jia-le,WU Ming-li

(School of Information Science and Technology, North China University of Technology,Beijing 100144)

Abstract:For non-factoid QA tasks, in this paper,we build a BiLSTM model with Attention mechanism.Experiments show that in 2016 NLPCC QA dataset, this model can reach 75.12% on MRR, which is better than the traditional machine learning method.

Key words:question answering; deep learning; attention; BiLSTM