改进的弹性网模型在深度神经网络中的应用

冯明皓 张天伦 王林辉 陈荣 连少静

摘 要:由于具有较高的模型复杂度,深层神经网络容易产生过拟合问题,为了减少该问题对网络性能的不利影响,提出一种基于改进的弹性网模型的深度学习优化方法。首先,考虑到变量之间的相关性,对弹性网模型中的L1范数的不同变量进行自适应加权,从而得到L2范数与自适应加权的L1范数的线性组合。其次,将改进的弹性网络模型与深度学习的优化模型相结合,给出在这种新正则项约束下求解神经网络参数的过程。然后,推导出改进的弹性网模型在神经网络优化中具有群组选择能力和Oracle性质,进而从理论上保证该模型是一种更加鲁棒的正则化方法。最后,在多个回归问题和分类问题的实验中,相对于L1、L2和弹性网正则项,该方法的回归测试误差可分别平均降低分类测试准确度可分别平均提高3.98、2.92和3.58个百分点。由此,在理论和实验两方面验证了改进的弹性网模型可以有效地增强深层神经网络的泛化能力,提升优化算法的性能,解决深度学习的过拟合问题。

关键词: 神经网络模型;深度学习;正则化方法;弹性网模型;过拟合

中图分类号:TP183

文献标志码:A

Abstract: Deep neural networks tend to suffer from overfitting problem because of the high complexity of the model.To reduce the adverse eeffects of the problem on the network performance, an improved elastic network model based deep learning optimization method was proposed. Firstly, considering the strong correlation between the variables, the adaptive weights were assigned to different variables of L1-norm in elastic network model, so that the linear combination of the L2-norm and the adaptively weighted L1-norm was obtained. Then, the solving process of neural network parameters under this new regularization term was given by combining improved elastic network model with the deep learning optimization model. Moreover, the robustness of this proposed model was theoretically demonstrated by showing the grouping selection ability and Oracle property of the improved elastic network model in the optimization of neural network. At last, in regression and classification experiments, the proposed model was compared with L1-norm, L2-norm and elastic network regularization term, and had the regression error decreased by 87.09, 88.54 and 47.02 and the classification accuracy improved by 3.98, 2.92 and 3.58 percentage points respectively. Thus, theory and experimental results prove that the improved elastic network model can effectively improve the generalization ability of deep neural network model and the performance of optimization algorithm, and solve the overfitting problem of deep learning.

Key words: neural network model; deep learning; regularization method; elastic network model; overfitting

0 引言

近年來,深度学习[1]技术受到广泛关注,并在众多应用领域有着较好表现。理论上,深层神经网络能够拟合任意分布的数据,但是在实际中,有限的数据资源和较高的模型复杂度使得神经网络很难具有理想的泛化能力,过拟合现象由此产生。该现象是机器学习中一种常见的病态问题,解决该问题的方法通常分为三种:第一种是扩充训练数据规模,例如,Szegedy等[2]通过对原有图像样例进行翻转、裁剪等变化来增加训练数据,从而提升了神经网络在图像分类中的性能;与之不同,陈文兵等[3]通过生成小样本数据来增加训练样本的数量,这种合成数据的方法同样可以降低神经网络的过拟合程度。第二种是更改训练方式,最具代表性的工作是Dropout[4],该方法通过在每次优化迭代中随机删除一些神经元来降低模型的复杂程度;除此之外,Zhang等[5]通过监控损失值的变化来决定网络训练的中止或重启,从而避免过拟合问题。第三种是在损失函数中引入正则项因子,对网络模型中的参数进行约束优化求解。与第一种方法相比,正则化方法没有增加额外的训练数据,从而不会加剧计算负担,同时,也不会受到冗余数据和噪声数据的影响;与第二种方法相比,正则化方法具有较好的收敛性,不会导致较长的训练周期。此外,正则化方法具有可靠的理论基础和严格的理论推导,因此,在解决过拟合问题的工作中,对正则化方法的研究与应用最为普遍。

正则化方法最早由Tikhonov等[6]在1963年提出,并于20世纪90年代以后,成为一种主流的解决机器学习中解决病态问题的有效方法。本质上,该方法是将正则项作为含有解的先验知识引进经验风险中,从而约束解空间的范围,进而获得理想中的稳定解。在理论上,Antoniadis等[7]提出一个理想的正则化方法应该具备以下四个性质:1)连续性。所求参数的估计值在范围内应当连续,以获得一个更稳定的解。2)无偏性。所求参数的估计值应当是近似无偏的,以获得一个偏差较小的模型。3)稀疏性。所求模型能够将较小参数直接压缩为0,降低模型的复杂程度。4)Oracle性质。正则项能够正确识别模型的能力,可用渐进正态性和变量选择一致性来解释。在该领域里,这四个性质被广泛用作评价正则化方法的标准,因此在设计正则化方法时,应尽量保证所提出的模型具备以上性质。

在实际中,被广泛使用的正则化方法主要有:最小绝对值收敛和选择算子(Least Absolute Shrinkage and Selection Operator, LASSO)模型、岭回归模型和弹性网模型。其中:LASSO模型又被称为L1正则化方法,该方法可以保证求解结果具有稀疏性[8],降低原始数据维度,并可以过滤出重要的特征,因而该模型通常被用于高维数据的建模问题,例如,Cui等[9]利用LASSO模型构造特征池来对高维数据进行特征提取;Tang等[10]提出一种基于L1正则化方法的稀疏自动编码器模型。但是LASSO模型忽略了变量之间的相关性,不满足无偏性。岭回归模型又被称为L2正则化方法,这种方法在参数估计中限制较大的解,从而启发式地得到趋近于零的解,并且该方法可以保留变量之间的相关性,在样本维度高于样本规模时,可以获得光滑的稳定解。因此为了避免神经网络模型过于复杂,L2正则化方法常被用于惩罚神经网络中较大的参数[11];同时,Jin等[12]通过在神经网络优化问题中引入L2正则项来提高神经网络对离群点数据的鲁棒性。但是L2正则化方法往往得到较稠密的解,因而不具备稀疏性。弹性网模型是前两种方法的线性组合,该模型既具备L1正则化的特征选择能力和稀疏性的特点,又具备L2正则化保留变量之间相关性的特点,因而该模型在防止过拟合的问题中有更加广泛的应用[13-14];但是在理论上,弹性网很难满足无偏性和Oracle性质。

为了更好地解决深度学习里的过拟合问题,本文在神经网络的损失函数中引入一种改进的弹性网模型,该模型可以被看作是L2正则化与加权的L1正则化的线性组合。在该模型里,L1正则化中的不同变量被自适应地赋予不同的权重因子,在优化神经网络参数时,这种加权的方式可以有选择性地保留重要的权重分量,使得到的网络参数具有稀疏性,从而降低过拟合的风险。同时,通过理论推导可以证明,在L2正则化的协同作用下,该模型具有合理的群组选择能力,因而相关性强的权重分量得以同时去除或者保留。除此之外,该模型还具备Oracle性质,可以保证对系数不为零的参数进行无偏估计。因而该模型是一种功能性更强的正则化模型。为了进一步验证该模型的实际效果,本文做了充分的对比实验,通过实验结果验证了该方法可以有效地防止深度学习中的过拟合问题,而且正则化的效果要明显优于现有的主流模型。

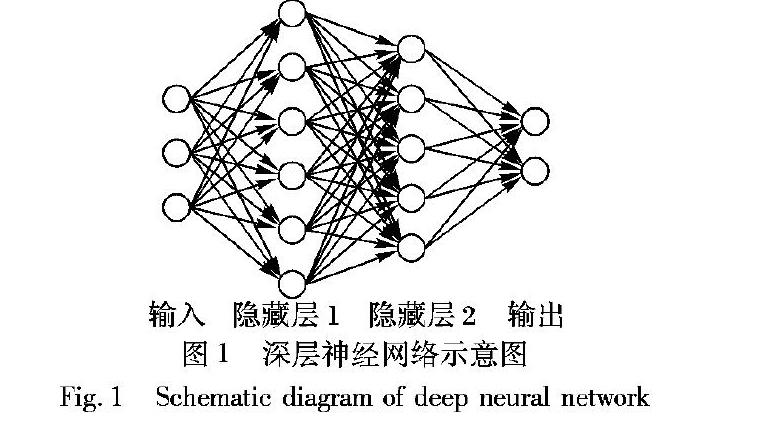

1 基于改进的弹性网的神经网络优化模型深层神经网络(如图1所示)的学习目标是在给定的样本集上最小化期望损失,可以定义为:

其中:w和b分别是网络的权重和偏置,也是深度学习的优化对象;x是神经网络的输入,即样本属性; y*是样本的期望输出; p(x)为样本的概率密度函数;J(w,b;x, y*)是关于权重w和偏置b的函数,该函数用来度量实际输出y和期望输出y*之间的距离(可以是欧氏距离,也可以是Kullback-Leibler(K-L)散度)。 为了提升神经网络的性能,一种最有效的办法是通过加入正则化项对损失函数进行约束求解,有如下定义:

其中:R(w)为正则化项。常用正则化项有: ,即弹性网。λ为正则项参数,表示正则项在整体模型中占的比重。这些模型的性质已在引言中进行讨论,为了克服这些现有模型的不足,一种改进的弹性网正则化模型被引入到神经网络的优化过程中。

首先,引入这种改进的弹性网模型:为一个非常小的数,用来防止分母为0;w*i为弹性网模型的参数优化结果;λ2必须和弹性网的参数相同;λ*1可以和λ1相同也可以不同;参数γ是一个正数。

最后,将改进的弹性网模型代入式(1),则深度学习优化模型的定义可变形为:

在分类实验里,损失函数为交叉熵(Cross Entropy, CE)函数,定义如下:

其中:c为输出层神经元的个数;n为样本数。在回归实验里,损失函数为均方误差(Mean Squared Error, MSE),定义如下:

具体地,这里选取目前最流行的深度学习优化算法为研究对象,即自适应矩估计(Adaptive moment estimation, Adam)[15]。其中,在Adam模型中梯度的计算如下:

其中:sgn(·)為符号函数,J(w,b)w可以通过神经网络的BP算法得到。

基于改进的弹性网的神经网络优化算法的流程如算法1所示。

算法1 基于改进的弹性网的神经网络优化算法。

输入 数据集(X,Y),Adam算法超参数,正则项系数λ。

输出 训练后的模型参数。

1)输入数据集,构建弹性网模型进行迭代:

2)得到弹性网模型的参数后,按式(2)构建改进的弹性网。

3)按式(3)构建新的优化模型,重新进行迭代。

2 改进的弹性网的相关性质 性质为了防止反向传播中的梯度消失现象,通常采用的激活函数为修正线性单元(Rectified Linear Unit, ReLU),此函数的形式如下:

不失一般性,考虑神经元输出不为零的情况,此时一个神经元的前向计算可以被视为一个线性回归过程。为了表述方便,下面的证明中偏置暂时不被考虑。设第l层神经元的输入为n×cl-1维度的矩阵X,设期望输出为n×cl维度的矩阵Y,其中cl-1和cl分别表示第l层和第l-1层神经元的个数。在衡量实际输出与期望输出的距离时,使用欧氏距离作为标准,此时优化目标可以表示如下:其中:*为模型参数估计值,为模型参数真实值,并且通过证明改进的弹性网模型满足性质1)与性质2),说明了该模型具有Oracle性质。该性质表明:该模型的估计值可以以1的概率正确估计非零的参数,并且估计值的非零部分服从渐近正态分布。

3 实验与分析

3.1 实验数据集

本文实验采用的数据集包括分类实验数据集和回归实验数据集两个部分,这些数据集的信息分别汇总在表1~2中。这些数据集来自UCI机器学习数据库网站和KEEL数据集网站,并且在回归问题中都是对单一属性进行回归预测。为了更好地进行实验,数据集在标准化处理后被划分为训练集、验证集和测试集。

3.2 实验设置

所有实验的实验环境为Windows 10(64位)操作系统, Python 3.6以及Tensorflow 1.5 GPU版本,显卡为GTX 1060 6GB显存。实验中用到的神经网络为全连接的多隐层前向传播网络模型,并且对于同一个数据集采用的网络结构相同。超参数λ1和λ2的取值范围是{107,106,…,10-7},在每个数据集上固定网络结构,经过多次实验,使得L1、L2和弹性网(Elastic Net,EN)模型取得最好结果的参数作为该数据集上实验对比所用的参数,改进的弹性网(Advanced EN, AEN)模型的λ*1和λ2设置与EN相同,后续实验可以验证,在EN达到最好效果时,改进的弹性网仍能继续改善网络的性能。训练集用来进行模型参数的学习,验证集用来评估不同阶段的模型的表现;测试集用来评估训练结束后的模型的性能。分类实验采用交叉熵(CE)作为验证集上的评价指标,同时采用准确度(Accuracy, ACC)作为测试集上的评价指标;回归实验采用均方误差(MSE)作为验证集和测试集上的评价指标。

3.3 实验分析

本文主要对比的方法有:在L1正则项约束下的优化模型(L1),在L2正则项约束下的优化模型(L2),在弹性网约束下的优化模型(EN),以及在本文方法约束下的优化模型(AEN)。图2展示了在其中四个数据集的验证集上的对数损失值随迭代次数的变化趋势。图3~4为在不同数据集上训练结果和测试结果之间的差值,这些差值反映了模型的过拟合程度,差值越大,过拟合情况越严重。具体表现为:在分类问题上,测试准确率越低于训练准确率;在回归问题上,测试误差越高于训练误差。表3~4则给出了以上方法在不同测试集上的最终测试结果,以及AEN相对于L1、L2和EN的平均准确率提升数值和均方误差下降数值。

从图3~4可看出,AEN在防止过拟合的问题中取得了较为突出的表现。除此之外,从表3~4可看出:AEN方法在大多数情况下可以得到更低的回归损失值和较高的分类准确率,且通过图2中在验证集上的损失变化曲线可以看出:L1方法由于其稀疏性更容易得到一个较低的损失;L2方法由于其平滑的特性,曲线一般更加光滑稳定,但一般不会得到一个较低的损失;EN方法由于将两者结合,经常会得到一个比前两者更好的结果;AEN方法在不同的数据集上可以得到比其他方法更低的预测损失。结合图3~4和表3~4可以得出:AEN方法不仅可以在训练阶段使得深层神经网络模型更鲁棒地拟合数据分布,而且所得到的模型在未知数据上也有较好的泛化能力。产生这些结果的原因可以被归结为以下两点:1)在弹性网的框架下,能够兼顾稀疏性和平滑性,在能够减轻模型复杂度的同时又容易找到最优解;2)改进的弹性网模型是在弹性网基础上对L1部分再进行加权,对不同的参数,配给不同的权重变量,对于较大的参数将会配给一个较小的权重,对于较小的参数将会配给一个较大的权重,这样在迭代更新时,较大的、重要的参数将会更容易被保留下来,较小的、不重要的参数也会更容易接近0。

4 结语

本文对深度学习以及正则化方法进行了研究与分析。首先讨论了L1正则化、L2正则化和弹性网正则化,并基于这些正则化模型的优势与缺点,提出一种基于弹性网的改进模型。然后,将这个改进的弹性网正则化方法与深度学习算法相结合,提出一种对神经网络参数进行约束求解的新方法。在理论上,证明了这个改进的弹性网模型具有群组选择能力和Oracle性质,这些性质的证明可以保证改进的方法在一定程度上避免深度学习中的过拟合问题,从而提高深层神经网络的泛化能力。在实验上,通过对比不同方法在多个验证集和测试集的表现,可以看到改进的弹性网模型不仅可以在训练阶段较鲁棒地收敛至较低的损失值,在对未知样本的预测阶段也体现出了较好的泛化能力,通过对实验结果进行分析,得出改进的弹性网模型取得好的效果的原因,日后主要的研究目标是把本文方法应用在更多的实际问题中。

参考文献(References)

[1] LECUN Y, BENGIO Y, HINTON G. Deep learning[J]. Nature, 2015, 521(7553): 436-444.

[2] SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions[C]// Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2015: 1-9.

[3] 陳文兵, 管正雄, 陈允杰. 基于条件生成式对抗网络的数据增强方法[J]. 计算机应用, 2018, 38(11): 3305-3311. (CHEN W B, GUAN Z X, CHEN Y J. Data augmentation method based on conditional generative adversarial net model[J]. Journal of Computer Applications, 2018, 38(11): 3305-3311.)

[4] SRIVASTAVA N, HINTON G, KRIZHEVSKY A, et al. Dropout: a simple way to prevent neural networks from overfitting[J]. The Journal of Machine Learning Research, 2014, 15(1): 1929-1958.

[5] ZHANG Z, LUO P, LOY C C, et al. Facial landmark detection by deep multi-task learning[C]// Proceedings of the 2014 European Conference on Computer Vision, LNCS 8694. Cham: Springer, 2014: 94-108.

[6] TIKHONOV A N. Solution of incorrectly formulated problems and the regularization method[J]. Doklady Akademii Nauk SSSR, 1963, 151: 501-504.

[7] ANTONIADIS A, FAN J. Regularization of wavelet approximations[J]. Journal of the American Statistical Association, 2001, 96(455): 939-967.

[8] LIAN L, LIU A, LAU V K N. Weighted LASSO for sparse recovery with statistical prior support information[J]. IEEE Transactions on Signal Processing, 2018, 66(6): 1607-1618.

[9] CUI C, WANG D. High dimensional data regression using Lasso model and neural networks with random weights[J]. Information Sciences, 2016, 372: 505-517.

[10] TANG J, DENG C, HUANG G. Extreme learning machine for multilayer perceptron[J]. IEEE Transactions on Neural Networks and Learning Systems, 2016, 27(4): 809-821.

[11] PHAISANGITTISAGUL E. An analysis of the regularization between l2 and dropout in single hidden layer neural network[C]// Proceedings of the 7th International Conference on Intelligent System, Modelling and Simulation. Piscataway: IEEE, 2016: 174-179.

[12] JIN J, CHEN C L P. Regularized robust broad learning system for uncertain data modeling[J]. Neurocomputing, 2018, 322: 58-69.

[13] 李光早, 王士同. 基于稀疏表示和彈性网络的人脸识别[J]. 计算机应用, 2017, 37(3): 901-905. (LI G Z, WANG S T. Face recognition based on sparse representation and elastic network[J]. Journal of Computer Applications, 2017, 37(3): 901-905.)

[14] LI Q, SUN Y, WANG C, et al. Elastic net hypergraph learning for image clustering and semi-supervised classification[J]. IEEE Transactions on Image Processing, 2017, 26(1): 452-463.

[15] KINGMA D P, BA J L. Adam: a method for stochastic optimization[EB/OL]. [2019-01-10]. https://arxiv.org/pdf/1412.6980.pdf.

[16] MARQUARIDT D W. Generalized inverses, ridge regression, biased linear estimation, and nonlinear estimation[J]. Technometrics, 1970, 12(3): 591-612.