一种基于非对称决策融合的行人检测方法∗

孙 妍 谭毅华 李彦胜 田金文

(华中科技大学多谱信息处理技术国家级重点实验室 武汉 430070)

1 引言

行人识别是行人跟踪和行为分析的基础,因此对行人的快速准确地识别是十分重要的。尽管关于检测方法精确度的提升已有诸多研究,如使用基于Haar 特征[1],或加入运动信息[3]、先验信息辅助检测[2],也有采用全局灰度特征的方法[4],除此之外,基于神经网络和深度学习的行人检测也有所研究和进展[10~13],然而,自从光流信息被开始使用获取运动特征[19~20],在运动检测平台上基于光流[21]的运动特性仍然不能很好地实现实时行人识别,所以关于行人检测仍具有更多的潜在线索来提高识别的准确性。故本文意在利用从单帧、图像序列到场景上下文的运动信息,在单目视频监控中挖掘尽可能多的信息,以提高行人识别的准确程度。

当行人暂时保持静止时,运动信息消失;当行人开始移动时,它会再次出现。所以Stefan Walk和Konrad Schindler 等提出整合多方面特征以提高行人识别的准确性[22]。但在实际跟踪过程中,相比经常变化的运动特征,保持不变的行人外观特征更加稳定一些;如果贸然将这二者融合起来用于跟踪,不稳定的运动特征可能反而影响跟踪效果。基于此种情况,本文提出了一种非对称决策融合的方法来处理这种不稳定特征的融合,在使用该方法进行融合的特征,可以获得更准确的行人识别结果。

2 行人识别检测算法框架介绍

对监控摄像视频的单帧数据进行分析时,整幅图像上的行人由于出现位置的不同,其尺度大小、出现概率都是各不相同的。因此,选取的滑动窗口将会成为影响检测效果一个很重要的因素。如图所示,图1(a)为固定位置后不同尺寸的滑动窗口在原始图像上的投影大小对比示意,图1(b)为固定大小的滑动窗口改变位置后的示意图。可以看出,选取这两种不同的滑动窗口将对下一步的行人检测结果是否准确有着不可忽略的影响,因此滑动窗口的选择相当重要。

图1 不同尺度、方位的行人检测滑动窗口示意图

鉴于上述的情况,本文拟采用固定尺寸的滑动窗口对原图像降采样后的图像金字塔[18]进行行人信息的提取。每个滑动窗口都可以使用度量(location,scale)被唯一的标记,其中location表示了该滑动窗口所处的位置,scale 表示该滑动窗口所处的图像金字塔层级中图像尺度。这样,当使用的所有窗口在原图像上映射后,就相当于我们使用了位置、尺度均有变化的滑动窗口用于检测。而从图1 可以看出,每个窗口最下方的中点“足点(foot)”可以唯一标记该窗口位置信息,窗口高度(height)可以唯一标记该窗口尺度信息,统一起见,下文我们将使用足点和窗口高度(foot,height)作为该窗口的唯一标记。

图2 单目监控视频下的行人检测框架

如图2 所示为本文使用的特征组合框架,首先通过滑动窗口提取行人外观特征,训练外观特征分类器;另一方面,本文利用相邻帧之间的光流信息[26]训练基于运动特征分类器,然后根据上述两种分类器所产生的结果,建立非对称融合分类器,该分类器将用于行人检测,输出检测结果。

3 滑动窗特征提取与决策融合

3.1 行人外观特征获取

本文采用了J. Wu 等[5]所提出的Centrist 特征作为行人描述符,Centrist 特征主要描述了滑动窗口中目标的轮廓信息,具有较强的识别正负样本的能力,具有快速的评价速度和较高的精度。概括来说,Centrist 特征是在原始图像的Sobel 边缘图上计算出的一致变换的直方图。设Χ代表滑动窗口的Centrist 特征,我们使用s=(Χ,foot,height)作为扩展特征向量来表示行人的描述特征,以便更好地计算行人的先验概率。

3.2 行人运动特征获取

在视频监控应用中,大多数行人目标都沿着特定的方向移动,所以其运动信息将能够提供出判断目标为行人的重要依据。由于光流的运动幅度可以很好地给出运动物体的轮廓信息,所以本文将通过计算光流的运动信息来提取目标的运动特征。

通过光流计算,图像中的每个像素在足够的迭代后均可以准确地获得光流向量(u,v)。尽管静止的摄像机在大多数时间内可以人为其所导致的背景运动为零,但我们有时也需要考虑摄像机的抖动可能性,因此,我们令(mˉx,mˉy)表示背景的平均运动分别在x方向和y方向的位移。平均运动位移通过计算运动矢量较为接近的像素集合组成的区域可以获得,然后就可得到运动物体的相对运动信息,即运动幅度I和运动相位p,公式如下:

如图3 所示,(a)、(b)为用于计算的相邻帧原图,(c)为该光流的幅值I表示,(d)为该光流的相位p 信息。可以看出通过计算得到的光流的幅值I 可以获得运动目标的完整轮廓信息并提取到运动目标的运动特征。最后,再将运动幅值归一化至[0,255]区间内即可。

下一步本文将使用场景的外观图像和运动图像来进行行人目标检测工作。通过滑动窗口提取Centrist 特征的方法分别在原图像和运动图像上计算,就可以获得行人目标的外观特征集合和运动特征集合。此外,本文提出的运动特征提取方法也可以推广使用到背景有缓慢运动的场景当中。

图3 相邻帧间光流计算示意图

另一个需要考虑的情况是,当行人目标暂时保持静止时,其运动信息将会消失。因此,与外观信息相比,运动信息是不稳定的,针对这种情况,本文提出的非对称决策融合方法可以解决这类问题。

3.3 外观特征与运动特征的决策融合

在训练阶段,相邻两帧被定义为一个样本,外观图像定义为示例对的第一帧,并以光流法计算得到运动图像。对于外观特征的分类器训练时,正样本为外观图像上标注直立的行人目标,负样本为原图上选择随机的背景图像块。对于运动特征的分类器训练时,正样本被定义为在运动图像帧间具有明显移动的直立行人目标,而负样本被定义为运动图像上没有移动行人目标的随机图像块。如图4所示,图(a)为滑动窗口的外观特征正样本平均Sobel模板,图(b)为滑动窗口的运动特征正样本平均Sobel模板,可见对这两特征样本来说,其平均Sobel模板都可以很好地描述行人的轮廓。根据所选择的这两类特征的正负样本集,对外观特征分类器和运动特征分类器进行训练,使之能有效分辨出正确的、用于有效目标检测的特征。

普遍使用的用于行人识别的分类器包括SVM[5,9~10]和boosting分类器[1],无论何种分类器,其输出的归一化对决策融合方法都至关重要。所以本文使用通过Sigmoid 函数将两个分类器的输出z变换为[0,1]之间的概率值,以便使分类器输出的融合,运算公式如下:

图4 行人目标的平均模板图

如上所述,最终在监控场景图像上的同一位置同一尺度的滑动窗口将会得到两个特征来进行融合:目标外观特征和运动特征。本文提出了一种非对称融合方法来代替普通的融合方法,为了描述这种非对称融合方法,下文先给出了一些基本的定义。

在当前帧图像序列检测,使用Iatpp和分别表示外观图像和运动图像;令sapp=(Χapp,foot,height) 和=(Χmotion,foot,height) 分 别 表示提取到的目标外观特征和运动特征。简化起见,设i ∈{a pp,motion} 和j ∈{ pedes,bg },这里pedes表示行人和bg 表示背景。 pj(si)表示第i 个分类器识别滑动窗口的特征向量到第j 类的概率值,对于本算法中的分类器来说,pj(si)中的s 即为特征X ,故pj( si)=pj(Χi)。在特征向量对的归一化之后,可得:

令r=( pped( sapp),pped( sapp),foot,height )表示滑动窗口的最终行人检测结果,该结果各项分别表示外观特征与运动特征的置信度概率值,滑动窗口的位置与尺度大小。那么我们可以使用前一帧的检测结果来帮助增强当前滑动窗口的决策,具体算法如下式所示:

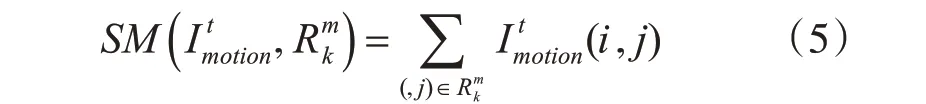

在式(5)中,Rm表示序列前一帧的行人检测的结果,Rmk表示包含总共m 个行人目标的检测结果中的第k 个行人的识别结果;表示所在区域的运动图像的累积运动幅值。

由于Rs表示行人识别结果,可以理解为诸多行人目标识别序列的子集,每个子集表示某一特定行人目标前一帧的识别序列与当前帧目标暂时保持静止提取序列的集合。这样,每个行人目标的结果都对其一定范围的邻域具有增强作用(在式(8)中,s 表示半径,本算法取值s=5),以此用来提高行人目标静止时的识别准确率。式(9)表示,Rs中第k 个行人识别结果产生的增强因子与其运动特征置信度概率值conf_motionk成正比,与滑动窗口的位置距离和窗口尺寸大小成反比。

如式(10)所示,当行人暂时静止时,前一帧的运动信息可以增强当前帧的外观决策值。本文使用式(11)中的方法以降低运动信息的速度衰减,作为辅助来平稳行人识别结果,其中α 表示运动信息的延迟系数,α 越大,运动信息的衰减速度越慢。整个算法流程总结如下:

算法步骤

1.如式(4)所示,归一化分类器的输出;

2.如式(10)和(11)所示,当行人在当前帧上保持静止时,增强帧间的外观决策和动作决策;

3.令qj(s)表示特征向量s属于第j类的概率值,则qj(s)的计算方法如下所示。

4. 令ω(s)表示特征向量s 归属于哪一类的最终决策,则ω(s)的计算方法如下:

4 实验结果与分析

4.1 数据集与实验条件

本算法实验采用的图像序列,其应当包括各种真实的行人识别情况:暂时保持静止的行人序列,与背景对比度较低的行人序列,伴随有阴影的行人序列等。本文采用的实验数据及均包含这些情况,基本考虑到了监控中行人识别的各种问题。我们将实验数据可分为训练数据和测试数据。训练数据主要包括大约661 个带注释的图像正样本,以及50 个不同场景、不包含行人的图像负样本。这些样本均来自自己收集的监控场景图像以及TUD-BRUSSELS-MOTIONPAIRS 公共数据集。测试数据主要包括了各种户外环境中收集的直立行走的行人目标,以及PETS 2006 公共数据集中的直立行走行人目标子集。

4.2 非对称融合方法的行人识别结果

为了论证本文提出的非对称融合方法在实际监控中的有效性,首先给出了在实际监控中采集的3 个图像序列的行人识别结果,如图5 所示,序列1(第1 行)为行进的伴随影子的行人目标识别情况,序列2(第2行)为与监控场景背景对比度较低的行人目标识别情况,序列3(第3 行)为行人目标忽然停止的识别情况;其中(a)列表示外观分类器的行人识别结果,(b)列表示运动分类器的行人识别结果,(c)列表示一般融合分类器的行人识别结果,(d)列表示非对称融合分类器的行人识别结果。

从图中可以看出,当目标有阴影干扰时,基于滑动窗口的行人检测算法基本都能识别出行人目标,且效果没有太大的差异。第二行的实验结果表明,当运动目标与背景对比度较低的时候,外观分类器的识别效果锐减,基本不能识别出运动目标;但此种场景对运动分类器的检测并没有太大的影响。而第三行行人目标出现帧间内停止行为时,运动分类器检测效果很不理想,非对称融合特征分类器的检测效果明显优于普通的特征融合分类器,能够准确识别出两个目标。综合考虑多种情况下的行人识别结果可以得出,非对称融合方法的鲁棒性较强,具有处理更复杂行人识别的能力。

图5 各场景下行人识别情况示意图

如图6 所示,图(a)为外观分类器、运动分类器、一般融合分类器和非对称融合分类器的行人识别结果检测率曲线(The DetectionRate-FPPI curve)对比,图(b)为本文提出的非对称融合分类器与其他算法的人识别结果检测率曲线对比。

从图6(a)中可以看出,运动分类器的识别目标能力最弱,外观分类器的识别效果近似于普通的融合方法,本文提出的非对称融合方法相比一下具有最好的识别效果;又从图6(b)中可以看出,本文提出的非对称融合方法检测效果与Felzenszwalb[16]、J. Wu 等[5]提出的检测方法相比,在实际监控场景下具有更好的识别能力。

5 结语

本文提出了一种基于非对称多特征融合的行人识别方法,该方法有效地提高了行人识别的准确度。本文算法中的基于光流的滑动窗口运动特征可以推广应用到运动检测平台中。在实际检测情况中,非对称融合问题不仅存在于视频行人监控中,也同样存在于运动检测平台,故在接下来的工作,本文提出的非对称特征融合方法可以应用于相关运动检测平台用以提高其性能。且由于非对称融合方法可以同时计算外观特征和运动特征,适合并行计算,故当有实时需求出现时,可以使用GPU或多核CPU进行本算法的加速。