基于改进的神经网络算法在装配过程中的应用

陆坤龙 王 一

(华北理工大学电气工程学院,河北 唐山063200)

在装配过程中,产品工件笨重且组装环节繁多,加上测量定位方面的精度问题,导致机器人装配效率和精度低下。[1-2]。应运而生的是多视觉信息融合技术应用在了机器人自动装配流程中解决机器人装配过程中的问题。利用多个视觉传感器对工件进行不同方位的定位,进而引导机器人执行相关动作,在这个过程中涉及到把各个传感器的有用信息融合到统一坐标系下的问题[3-5]。目前,一些改进的新算法实质上是主要通过各种不同的方法共同作用来实现相互加强的目的。例如,模糊神经网络方法不仅增强了神经网络的算法鲁棒性,还填补了模糊逻辑自适应能力的缺点[6]。虽然现在可以集成许多不同类型的传感器来进行信息综合,弥补单个传感器信息不足的问题,但是,融合过程却浪费了很多系统资源。文献[7]提出了一种改进的D-S 参数理论算法,该方法比原算法多了一个距离因子,这增强了传感器采集数据时的稳定性。文献[8]提出了基于任务的神经网络多传感器数据融合的新方法,该方法在全面比较和分析了遥控机器人执行不同任务过程中的效果后,进而优化了神经网络算法。结合本文研究内容特点,针对设计的视觉辅助系统采用改进型自适应BP 神经网络算法对多个视觉传感器采集到的视觉信息进行融合,从而为机器人提供视觉信息。

1 视觉辅助结构设计

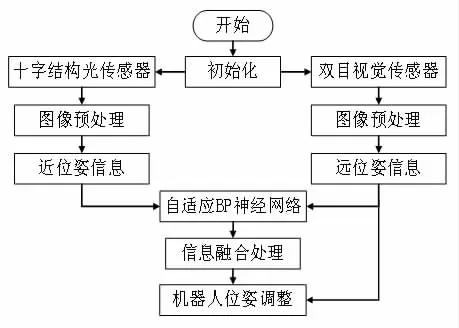

本文主要对柔性装配系统的视觉感知部分进行了设计。视觉感知系统主要有十字结构、光视觉传感器和双目视觉传感器。双目视觉传感器作为待装配物的远视场测量装置,得到待装配物的远位姿信息后,引导执行机构到达合适的装配位置,之后启动十字结构光传感器对待装配物进行二次位姿测量,其测量的结果与双目视觉传感器测量的位姿结果相融合,得出待装配物的精确位姿信息,进而二次引导机器人进行准确的装配动作。

2 视觉信息融合算法

2.1 自适应BP 神经网络信息融合算法

本文提出的自适应改进BP 神经网络信息融合算法不仅考虑到了原始BP 神经网络的学习性能的高低,还优化了原始算法的复杂程度以及应用性能等问题。针对传统自适应算法的不足之处,本文的改进型BP 神经网络新方法采用了差异化的学习率,不仅能够动态地调整着不同节点之间的连接权重数值,还能使得收敛误差函数所需的时间减少。在改进的BP 神经网络中,阈值是随着权值变化的,并且将变化的阈值引入到权值的矩阵中进行再计算,形成一个反馈闭环。自适应BP 神经网络算法实现过程如下:

第一步,算法初始化。

在软件里面确定好三层的神经网络后,再开始选择合适的参数预设值。要进行设定的参数有:学习速率,误差精度,权重矩阵。设定好后对这些参数进行训练学习。

第二步,正向传播误差的求取。

首先把准备训练的样本进行分组,然后按照分组顺序对样本进行训练,并记下训练出的正向传播误差。

第五步,使用新权重进行正向传播训练,并更新网络误差。

第六步,BP 网络迭代学习完成后,记录最终值。

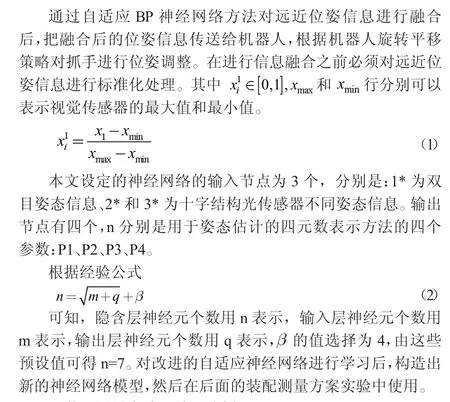

2.2 基于视觉信息融合的位姿估计方法设计

本文采用的是两个组合式视觉传感器进行数据采集的,双目视觉传感器位于机械臂之外,相对机器人基座是固定的,远距离测量范围比较大,处于0.3m-5m 之间。十字结构光传感器是属于近距离测量,测量范围处于0.1m-0.3m 之间。双目视觉传感器的作用是预先测量被测物位姿信息引导机器人达到待装配位置,然后待十字结构光传感器也测量出待装配物信息后,结合近测量信息进行信息融合,从而对近距离测量的结果进行一个精度补偿。继续配合十字结构光传感器对机器人进行姿态调整,直到装配精度符合预期值。其具体的算法流程如图1 所示。

图1 视觉信息融合算法流程图

3 装配测量实验及结果分析

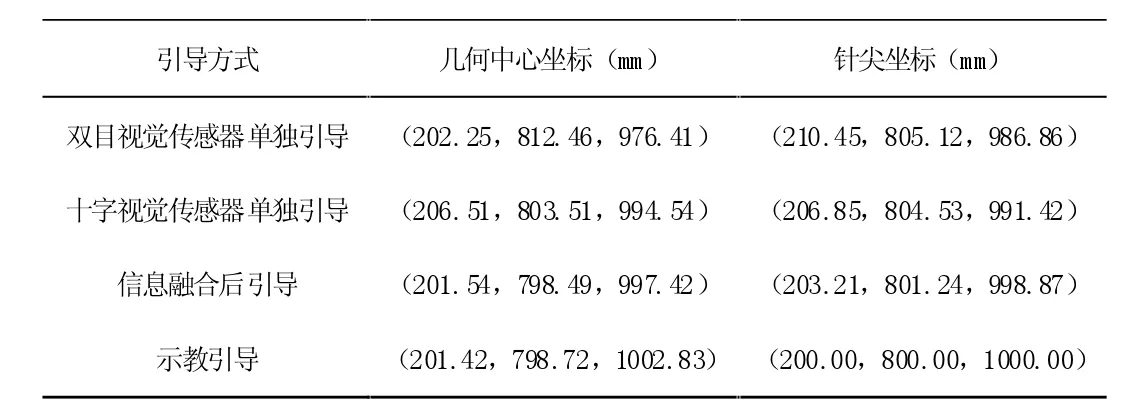

实验平台由KUKA 机器人及控制系统、十字结构光传感器、双目视觉传感器、机器人末端工具铅笔、标准方块、计算机和三维位移台组成。实验的检测结果如表1 所示,以示教对准结果为真实值,其他方式的引导结果为测量值,并且所有坐标结果都是相对于机器基坐标系而言的。

机器人在不同的引导方式下,从表1 中可以看出双目视觉单独引导效果最差,因为受到实验条件和光线影响使得图像配准效果欠佳,得到的标准块的位姿信息不是太精确;十字结构光传感器单独引导精度明显比双目视觉引导精度要好,因为与双目视觉传感器相比,除了实验条件一样的情况下,十字结构光传感器能够自身打出激光线,形成自己独有的特征线,有效的降低了外界光线对图像处理过程中的干扰;信息融合后的引导精度最接近于示教引导效果,这也说明了本文视觉信息融合方法的有效性。

表1 对准实验数据

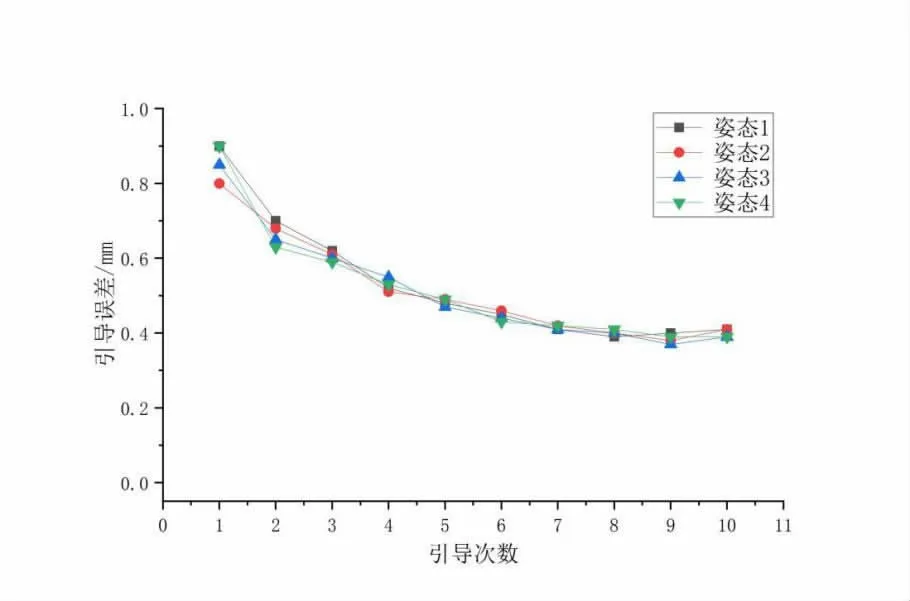

在验证了视觉信息融合方法有效性的基础之上,为了更好的说明其性能,再验证其引导误差的收敛性。本文利用位移台对标准块进行多次位置改变,其几何中心也会随之改变,每次改变标准块姿态之后,用视觉信息融合方法对其对准性进行验证。记录标准块在不同位姿下的引导次数和每次引导对准数据,本次实验对四种不同姿态下的标准块进行对准实验,具体数据如图2 所示。

把示教的数值当成0 基线数值,那么每次引导的效果都是相对于基线来说的,通过拟合曲线可以看出,随着拟合引导次数的增加,也就是机器人调整姿态次数的增加,引导误差越来越趋近于基线,每种姿态下的测量误差基本都在距离基线0.41mm 处稳定下来。这说明整个系统重复运作引导性能较好,融合算法具有良好的鲁棒性能。

图2 引导误差曲线

4 结论

本文针对机器人装配领域一直以来存在的装配精度不高、装配效率慢、次品率多等问题,制定了合理的视觉测量系统方案,为机器人提供精确的实时位姿引导信息。为了使视觉信息得到充分利用和提高装配精度,提出了一种基于自适应BP 神经网络的视觉信息融合算法。实验结果表明融合算法引导结果最接近于示教结果,体现了本文提出的视觉信息融合算法的准确性和鲁棒性能。