基于深度学习的无人机载平台多目标检测和跟踪算法研究

王旭辰 韩煜祺 唐林波 邓宸伟

(北京理工大学信息与电子学院雷达技术研究所,北京 100081)

1 引言

随着科技的进步,计算机逐渐可以代替人类的视觉系统去处理各种图像、视频信息。其中多目标跟踪是目前计算机视觉领域研究的主要内容之一。在生活中,各大城市的机动车保有量与日俱增。然而交通系统,尤其是交通监管系统发展较为缓慢。面对持续增长的机动车总量,在重要道路口安装固定相机进行车辆监管的方法明显无法满足目前需求。

随着多翼无人机技术的发展,为解决车辆监管问题提供了新思路。与路口固定相机相比,无人机有着小巧灵活、视角广、可快速移动部署等优点,有助于采集更全面的车辆信息。同时在军用领域中,无人机技术和计算机视觉技术的结合,可以完成对地面目标快速跟踪和精准打击,在地面侦察、敌我识别、精准制导等方面均有重要的应用。因此,无论从民用还是军事领域,基于无人机视角下的多目标检测和跟踪技术都有着重要的应用场景。

近年来,国内外学者对多目标跟踪领域进行了深入研究,并提出大量算法。多目标跟踪主要基于“Tracking-By-Detection”策略,即基于检测的多目标跟踪。其中分为传统多目标跟踪算法和基于深度学习的多目标跟踪算法。传统的多目标跟踪算法,主要通过传统的数据关联方式,关联帧和帧之间的检测结果。主要有联合数据关联[1](JPDA,Joint Probabilistic Data Association)、多假设跟踪(MHT,Multiple Hypothesis Tracking)等。基于深度学习的多目标跟踪算法主要基于图像特征设计端到端的卷积神经网络对目标进行跟踪。2014 年,Zhang 基于双层自编码特征,将数据关联问题建模成求解最小生成树问题[2],首次将深度学习用于多目标跟踪领域;Xu 等人提出深度匈牙利匹配网络[3](DHN,Deep Hungarian Net),确定了合适的损失函数,使网络实现端对端的训练;Wan 等人建立一个表观特征提取网络并与深度数据关联算法结合的端到端网络。针对训练样本不充足的问题,采用单目标跟踪中常用的跨帧匹配的方式,进行数据关联[4]。Zhu等人在端到端的网络中,融入空间注意力模块,使网络更加注意前景目标。引入循环网络,利用时间注意力机制分析目标轨迹中各个历史信息的权重,增强了算法的鲁棒性[5]。Chu 等人通过局部关联的形式完成了K 帧的联合数据关联,通过一个连续的外积公式来近似K 阶关联矩阵,使端到端数据关联算法集成的更为紧密[6]。Bing 等人将多目标跟踪中,检测、重识别、数据关联多个子任务合并为一个整体框架,共享任务特征,提高了网络的利用率[7]。

然而对于传统多目标跟踪方法,提取目标信息较少,难以符合所有实际可能出现的情况[8];对于基于深度学习的多目标跟踪方法,可以从大量数据中提取外观、运动、交互等信息,进行建模,鲁棒性较高。但是由于一般计算量较大,对硬件要求较高,实时性较差。而利用无人机对目标进行跟踪属于动态背景下对运动目标的跟踪,面对障碍物遮挡视角旋转等复杂情况,对跟踪技术的稳定性和准确性有着很高的要求。

基于以上的分析,结合传统多目标跟踪和基于深度学习的多目标跟踪两类方法的优点,提出一种可以在无人机载平台下,对于多个目标进行自主检测与跟踪的算法。数据关联方面参考了传统多目标跟踪算法中的匈牙利匹配算法,通过增广路径求出检测与跟踪结果的最优匹配结果。在目标信息提取方面,参考基于深度学习的多目标跟踪算法,训练了一个重识别网络,以提取不同帧的目标外观信息,同时使用卡尔曼滤波,提取不同帧间相同目标的运动信息。并将两个信息进行融合,通过匈牙利匹配算法得到最终跟踪结果。检测器使用YOLOv3算法[9],通过公开数据集和大量无人机采集的数据进行训练。并最终在公开数据集和实地无人机采集的数据中,对于障碍物遮挡、视角旋转、目标尺度变化三方面进行了仿真验证,取得了良好的跟踪效果。

2 无人机载平台下多目标检测和跟踪算法

本节提出了一种无人机载平台下的多目标检测和跟踪算法,基于YOLOv3算法的检测结果,对无人机视角下的多个目标进行锁定和跟踪。

2.1 基于深度学习的多目标检测算法

本小节介绍基于YOLOv3算法的多目标检测算法工作原理和工作流程。

相比于YOLOv2[10]算法,YOLOv3算法在特征提取方面,使用更深的Darknet-53 网络。通过卷积层进行了五次采样,最后通过全连接层进行目标分类。同时借鉴ResNets[11]引入残差网络结构,很大程度上增加了网络的深度,解决了训练深度网络中的梯度消失问题,明显的提升了识别的准确率。在预测方面,借鉴了FPN[12](Feature Pyramid Networks)网络采用多尺度特征融合的预测方式,可以更好的提取小目标的信息,更适合应用于无人机视角下的目标检测。

多目标检测算法的主要工作流程如图1所示。

(1)通过视频流读取测试视频,分别在尺度为13*13、26*26、52*52的特征图中进行预测。

(2)以尺度为13*13的特征图为例,将视频帧分为169个grid cell,并在每个grid cell中预测是否由目标中心点存在,同时预测出目标属于车辆种类的置信度。并依据网络权重,预测出在每个目标的位置坐标偏移量,通过公式计算出目标框的具体参数。

(3)为了消除目标检测中,同一目标的多余框,进行非极大值抑制处理。即首先过滤掉小于置信度阈值的检测框,然后对于剩下所有预测框,根据预测类别为车辆的概率依次排序。将概率最大的检测框开始分别与其余检测框进行交并比检测,并过滤掉大于阈值的检测框。最后从剩余检测框中,选取置信度最高的检测框作为车辆检测的最终检测框。

2.2 目标运动信息匹配

本小节介绍了一种基于目标运动信息的跟踪匹配算法,如图2 所示。使用卡尔曼滤波根据上一帧目标位置预测本帧中目标的位置。借鉴SORT[13]算法引入马氏距离,计算本帧目标预测位置和检测位置之间的马氏距离,最后根据匈牙利匹配算法进行目标运动信息匹配。

2.2.1 卡尔曼滤波

卡尔曼滤波最早于1960 由匈牙利数学家卡尔曼提出,是一种利用线性系统状态方程,根据输入输出数据,对系统状态进行最优解的估计算法。其核心思想为:根据当前时刻的测量值和上一时刻的预测值和误差,计算得到目前时刻的最优解,再预测下一时刻的测量值。具体步骤为:

(1)由k-1 时刻的最优值xk-1去预测当前时刻的系统状态值,见公式(1)。

(2)由k-1 时刻的误差协方差Pk-1和噪声Q 预测当前时刻的均方误差。

(3)计算卡尔曼增益,见公式(3)。

(4)通过滤波估计方程计算中K时刻的最优值,见公式(4)。

(5)通过滤波均方误差更新矩阵,见公式(5)。

卡尔曼滤波用于根据之前视频帧目标位置数据,预测当前视频帧中目标所在位置,再通过数据拟合和滤波估计方程计算出当前时刻目标所在位置的最优解,即在目标检测的基础上得到更准确的预测框。

2.2.2 运动信息匹配

为了提取目标位置变化时的运动信息,计算本帧卡尔曼滤波预测出的目标位置与检测位置之间的马氏距离,计算如公式(6)所示:

其中,(yi,Si)表示第i个轨迹在空间内的投影,dj表示第j个检测框。跟踪场景定义在八维空间(u,v,γ,h,x',y',γ')内,其中包含检测框中心位置(u,v)、横纵比γ、高度h、以及它们在空间坐标内的速度。由于包含不同的量纲,所以选择不受量纲影响的马氏距离。通过计算检测位置与卡尔曼滤波得出的平均轨迹位置的距离超过标准差的多少来衡量卡尔曼滤波预估目标位置的不确定性,如公式(7)所示。

如果第i个跟踪轨迹与第j个检测之间的关联是允许的,则结果为1。设置t(1)为9.4877。

2.3 目标外观信息匹配

本小节介绍了一种基于目标外观信息的跟踪匹配算法。首先引入一个深度特征网络,用来提取目标外观信息。然后借鉴DeepSort算法引入余弦距离,计算不同帧间所有检测目标两两之间的余弦距离,余弦距离越小,则代表两个目标为同一目标的概率越大。

2.3.1 深度特征提取网络

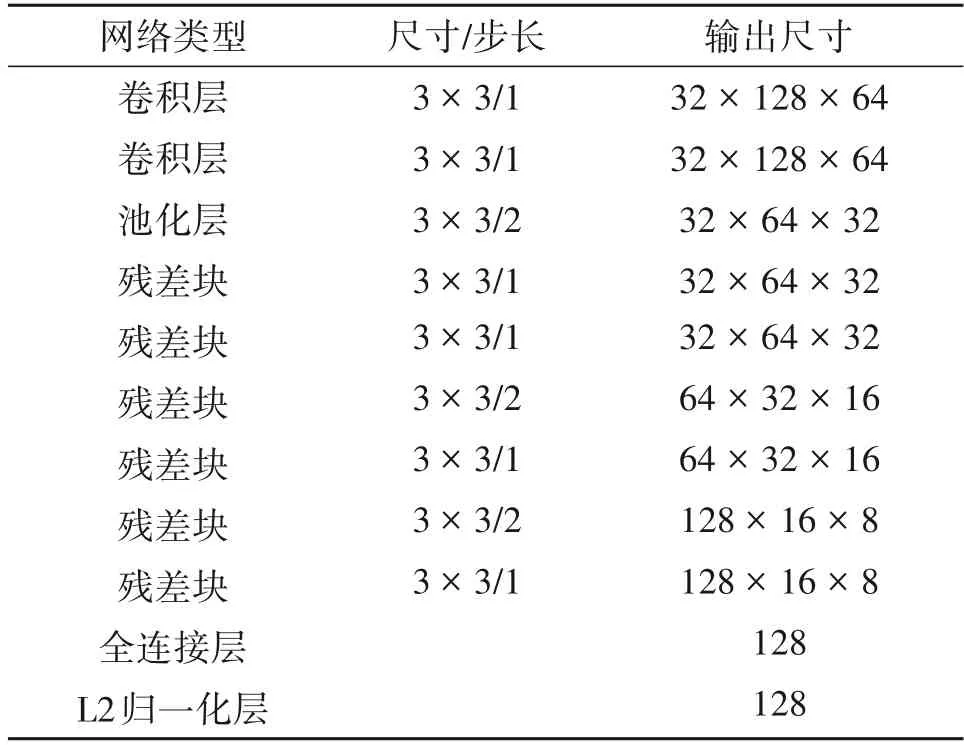

通过引入一个基于深度学习的深度特征网络来提取每帧的不同目标的外观信息。使用Car-Reid数据集训练了该特征网络,使其可以提取出得出区分度较高的车辆外观信息。Car-Reid数据集包括了576 种不同类型外观颜色的车辆照片组,每一种车辆照片组包含了此类车的不同角度拍摄的图片,保证网络可以最大限度的提取每一种车的各类角度的外观信息,具体网络结构如表1所示。

表1 目标外观特征提取网络Tab.1 Object appearance feature extraction network

网络由2 个卷积层和6 个残差块组成,共有2,800,864个参数。在稠密层(Desne10)中计算128维的全局特征,最后通过BN层批处理和l2标准化,将外观特性投影到单位球面上,使其与余弦外观度量兼容。

2.3.2 外观信息匹配

参考DeepSort 算法[14]引入余弦距离,用来描述不同帧之间的目标外观相似度,如公式(8)所示。其中对于每帧中的每一个检测框d(i,j),计算同时对于每一个轨迹,创建一个数组,用于储存最近50帧成功关联的目标的外观特征向量。

d(2)(i,j)表示第i个跟踪轨迹和第j个检测目标之前的余弦距离。其中表示每个轨迹保存对应目标的外观信息。表示关联外观描述符的原型库。并且根据t(2)来衡量是否允许关联。

2.4 数据关联

数据关联方法采用传统多目标跟踪算法中的匈牙利匹配算法,匈牙利算法是基于Hall 定理中充分性证明的思想,用增广路径求二分图最大匹配的算法。为了更好的融合目标运动信息和目标外观信息,提出信息融合公式,如公式(10)所示。

其中,d(1)(i,j)为由卡尔曼滤波提取的目标运动信息而得出的马氏距离,d(2)(i,j)为由特征提取网络提取的目标外观信息而得出的余弦距离。并引入参数λ,λ代表了两种信息在进行数据关联时所占的影响因子,在本文中λ取0.995。当λ取0.9 时外观特征和运动信息对成本矩阵的影响因数大概均为0.5。但由于无人机视角的灵活性使得即使在匹配正确的情况下,相邻两帧的马氏距离依旧很大,所以在参数选择中刻意减小了运动信息的影响因数。但是由于提取外观时,不可能百分百提取目标车辆的全部信息,过于的忽略运动信息会使得在匹配的过程中,遇到障碍物遮挡等情况下,ID 跳变成与目标车辆外观特征相似的跟踪轨迹。所以经过大量实验,本课题选取了较为合理的,适用于无人机视角的参数λ。最后通过得到的成本矩阵,由匈牙利匹配算法得到匹配结果。下面给出匈牙利算法的具体表示形式,如公式(11)所示。

其中ci,j为成本矩阵中,对应位置的权重,xi,j为第i个检测框与第j个跟踪框的匹配结果的二进制数值。

3 实验与结果分析

为进一步验证提出的无人机视角下的多目标检测和跟踪算法,在UAV123 数据集和实测数据集中,对于障碍物遮挡、视角旋转、目标尺度变化三类情况进行仿真验证。其中UAV123 数据集中选取car1、car2、car6 共3 组数据,实测数据集为无人机实地采集数据共5325 帧,测试平台CPU 为I5-7300HQ,GPU为1050Ti。

3.1 无人机视角旋转

在实际应用中,当无人机视角旋转时,由于视角移动过快等原因,可能会出现检测器在个别帧漏检情况,导致下一帧重新识别到目标时,算法错误判断成新目标,造成ID 跳变。本算法中,使用外观信息和运动信息同时对重检目标进行判断,可以很大程度上避免因漏检造成的跟踪失效情况。

在实际采集的无人机数据下,测试算法在无人机视角旋转下的稳定性,测试结果如图3 所示。可见,在第一行图片中,290帧无人机视角发生快速横向移动,导致本帧视野模糊同时检测器失效。在297 帧到301 帧的过程中,依次检测到1~3 号车,最后重新跟踪成功。在第二行数据中,无人机视角发生旋转,从326 帧到750 帧的过程中,视野里的三辆车的暴露面逐渐改变,算法依然可以保持稳定的检测跟踪效果,不发生ID跳变。

3.2 跟踪目标尺度变化

随着无人机相对目标由远及近的过程,会带来目标在无人机视角中的尺度大范围变化,容易造成跟踪器不能很好的适应目标的尺度变化,使得跟踪相对于目标过大或者过小的情况。本算法中,并没有使用一般跟踪算法中的尺度金字塔,通过不同步长来适应目标尺度变化。本算法通过检测器中FPN 网络分别从三个尺度上进行信息提取和融合,可以很好的适应目标的尺寸变化。从而根据检测器结果生成跟踪结果。

为验证算法稳定性,选取了UAV123 数据集中car1和car6中,目标尺度变化较为明显的测试视频,来验证本算法对于车辆目标尺度变化的跟踪效果稳定性,测试结果如图4 所示。可以看出在测试视频中,car1 中第8 帧到第418 帧,目标车辆在无人机视角下尺度逐渐变小;在car6 中第2 帧到第457 帧,目标车辆在尺度变化的同时还包含了轻微的视角变化。本课题算法均可以在ID 不发生跳变的情况下进行稳定的检测与跟踪。

3.3 障碍物遮挡

在无人机跟踪目标的过程中,由于无人机的灵活性,使得无人机视角很容易被障碍物遮挡,此时十分考验算法对于目标的重检和重识别的能力。如果仅根据目标运动信息进行跟踪,当目标通过障碍物的同时,发生运动方向的突变,会造成跟踪算法的失效;如果仅根据目标外观信息进行,目标中若存在相似目标,很容易在无人机视角发生遮挡后,跟踪目标ID 跳变成外观相似目标的ID。本算法通过储存之前跟踪轨迹的最近50 帧车辆外观信息特征同时预测车辆的运动轨迹,在当无人机飞过障碍物后目标车辆再次出现在视角时,同时结合目标外观信息和目标运动信息,再次重新识别匹配,使其ID不发生跳变。

UAV123 数据集中,选取在无人机视角遮挡下,即包含相似目标又包含目标遮挡后目标运动方向发生突变的情况进行测试,测试结果如图5所示。

四号和五号车的外观相似,均为黑色轿车。同时,四号和五号车在经过障碍物遮挡之后,并没有进行沿着环形车道行驶,运动方向改变成另一条匝道。可以看出,三辆车通过障碍物后,即使存在外观相似目标和目标运动突变的情况,本算法依然可以有效的重新检测跟踪,并且保持相同的ID。

4 结论

无人机技术和计算机视觉技术的结合应用,在民用和军事领域均具有重要价值和研究意义。本文结合传统多目标跟踪算法和基于深度学习的多目标跟踪算法特点,提出基于深度学习的无人机载平台多目标检测与跟踪算法。数据关联方面参考传统多目标跟踪算法,采用匈牙利匹配算法。在信息提取方面,参考基于深度学习的多目标跟踪算法,训练了一个重识别网络,以提取不同帧的目标外观信息,同时使用卡尔曼滤波,提取不同帧间相同目标的运动信息。通过一个信息融合公式,将两类信息转换成为一个成本矩阵,最后通过匈牙利匹配算法得出跟踪结果。本文提出的跟踪算法在大量公开数据集和实际采集视频中进行了仿真验证,并取得了良好的跟踪效果。