编码-解码技术的图像标题生成方法研究综述

耿耀港,梅红岩,张兴,李晓会

辽宁工业大学 电子与信息工程学院,辽宁 锦州121000

随着多媒体技术和计算机网络的快速发展,数据的多模态性日显突出,数据量爆发式增长,学术界和企业界对多模态数据处理的需求也日益迫切。另一方面,深度学习技术的日益成熟,给处理多模态数据提供了强有力的技术支持。

图像标题生成任务由Farhadi 等人在2010 年提出,其任务是通过模型实现从图像模态到文本模态的模态转换,具体化表示为二元组(,),模型完成图像模态(image)到文本模态(sentence)的模态转换。图像标题生成任务是计算机视觉领域(computer vision,CV)和自然语言处理领域(natural language processing,NLP)的交叉任务。这项任务对有一定生活经验的人类来说非常简单,但是对于计算机来说却有着巨大的挑战性,这不仅要求计算机能够理解图像的内容,而且还要求计算机能够生成符合人类语言习惯的句子。图像标题生成任务,在图像理解、人机交互和视觉障碍患者辅助和新闻等领域有着重要的作用,由于任务的重要性和挑战性,逐渐成为人工智能领域研究的一个重要方面,越来越多的研究者们投身到了这个领域的研究,提出了一系列效果显著的算法和模型框架。

从Farhadi 等人提出的基于模板的方法,到Kuznetsova 等人提出的基于检索的方法,再到现在主流的基于编码-解码的方法,图像标题生成技术不断革新,图像标题的质量也越来越高。目前基于编码-解码的图像标题生成方法在图像生成质量和模型性能方面取得了较好的效果,备受关注。本文基于编码-解码图像标题生成方法整体流程,分别从图像理解和标题生成两方面对该方法的研究进展进行了相关的研究与阐述。

1 图像标题生成方法概述

目前图像标题生成领域中主要有三种图像标题生成方法,分别是基于模板的方法、基于检索的方法和基于编码-解码的方法。本章简要介绍三种方法的代表工作和各自的优缺点。

1.1 基于模板的方法

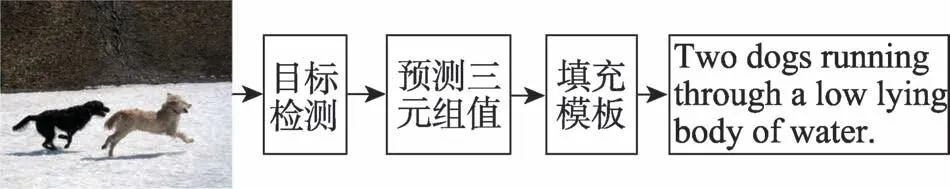

基于模板的方法(template-based method)是一种依赖人工设计语言模板和目标检测技术的图像标题生成方法。首先由人工设计语言模板,然后通过目标检测技术检测图像中的对象、对象属性、对象之间的相互关系等信息;最后使用这些信息将模板填充完整,生成图像标题,其代表性研究是Farhadi 等人在2010 年提出的基于模板的图像标题生成方法和模型。该模型首先按照语法规范人工设定句型模板和<对象,动作,场景>三元组,然后使用计算机视觉中目标检测的方法检测图像中的场景、对象、对象的属性及动作所有可能的值,并使用条件随机场算法(conditional random field,CRF)预测正确的三元组填入模板,组成标题的基本结构;最后使用相关算法填充模板中的其他部分,生成图像标题,其流程如图1所示。Kulkarni 等人在此基础上提出了Baby talk 模型。该模型通过目标检测技术,检测多组对象及其相关信息,使用分类器对其分类。然后使用CRF 对三元组的值进行预测,最后填充模板,生成完整的标题。该模型中使用了更多的对象及其相关信息驱动标题的生成,为此获得了更为详细、质量更好的图像标题。

图1 基于模板的方法流程Fig.1 Template-based method flow

基于模板的方法的优点是生成的标题符合语法规范,但该方法需要人工设计句法模板,依赖于硬解码的视觉概念,受到图像检测质量、句法模板数量等条件的限制,且该方法生成的标题、语法形式单一,标题的多样性不足。

1.2 基于检索的方法

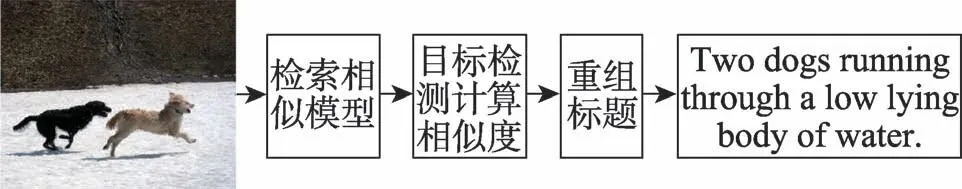

基于检索的方法是一种依赖大型图像数据库和检索方法的图像标题生成方法。该方法首先检索数据库中与给定图像相似度高的图像作为候选图像集,从候选图像集中选取最相似的几个图像,利用它们的图像标题,组合成给定图像的标题,其代表性研究是Kuznetsova 等人在2012 年提出的基于检索方法的图像标题生成模型。该模型由整体的数据驱动生成图像标题,基于输入图像,在数据库中检索相似图像以及描述该图像的人工合成短语,然后有选择地将这些短语组合起来,生成图像标题,其示意图如图2 所示。Ordonez 等人基于对图像数据库规模的扩充和相似度计算方法的改进对该模型进行了优化。数据库包括从网络上收集的100 万张带有标题的图片。该模型获取到输入图像后,在数据库中检索相似的图像作为候选,通过目标检测技术检测候选图像中的对象、动作、场景和TF-IDF(term frequencyinverse document frequency)权重,计算候选图像与输入图像的相似度,取相似度前四的图像标题组合成输入图像的标题。在一定程度上提高了标题质量。

图2 基于检索的方法流程Fig.2 Retrieval-based method flow

基于检索的方法是由现有的图像标题驱动生成新的图像标题,对输入图像与数据库图像的相似度有较强的依赖性,即若给定的图片与数据库中的图像相似度高,生成的图像标题质量就高;若相似度低,结果就不尽人意,且图像标题的形式也受到数据库中标题形式的限制,不会产生数据库以外的单词,标题生成局限性较大。

1.3 基于编码-解码的方法

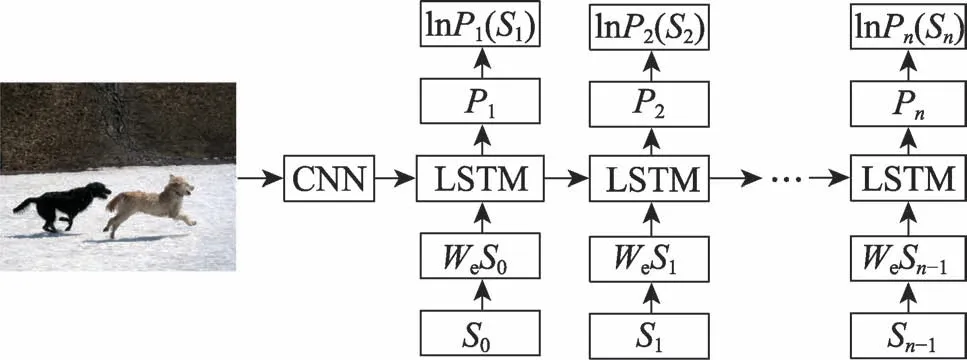

基于编码-解码的方法是一种依赖深度学习技术的图像标题生成方法。该方法使用两组神经网络分别作为编码器和解码器。编码过程是使用编码器提取图像的特征,解码过程是对图像的特征进行解码,按照时间顺序生成单词,最终组合成图像标题。其代表性工作源于Cho 等人在2014 年提出的解决机器翻译(machine translation,MT)任务的编码器-解码器模型,该模型使用两个递归神经网络(recursive neural network,RNN)分别作为编码器和解码器,模型使用编码器对源语言进行编码,再使用解码器解码成目标语言,该模型在机器翻译任务中取得了令人鼓舞的效果。2015年,Vinyals等人将编码-解码的思想引入图像标题生成领域中,提出NIC(neural image caption)模型。该模型采用卷积神经网络(convolutional neural network,CNN)作为编码器,长短期记忆网络(long short-term memory networks,LSTM)作为解码器。模型获取到输入图像后,首先使用CNN提取图像的全局特征,使用图像的全局特征初始化解码器,然后解码器按时刻生成单词,最终组合成图像标题,其流程如图3 所示。~S代表图像标题中的单词,和S为标题的开始标志和结束标志,代表生成单词的概率。

图3 基于编码-解码方法流程Fig.3 Method flow based on encode-decode

基于编码-解码的方法摆脱了对模板和数据库的依赖,生成的标题具有前两种方法不具有的高灵活性、高质量和高扩展性。但该种方法依然存在一些问题需要深入研究,如视觉特征的提取问题、语义鸿沟问题、模型复杂度高等问题。

图像标题生成方法均有其各自的优缺点,其中基于编码-解码的方法凭借其生成标题不受模板和数据库容量限制,具有高多样性、高灵活性等优点,目前已经成为图像标题生成领域的主流生成方法。针对基于编码-解码方法的研究也不断深入,本文将在第2 章深入介绍基于编码-解码的图像标题生成方法的研究现状。

2 基于编码-解码的图像标题生成方法研究现状

随着深度学习技术的快速发展和针对图像标题生成任务研究的不断深入,研究者们提出了一系列优秀的模型和算法。本章按照图像标题生成流程将这些模型和算法分类为图像理解阶段的研究和标题生成阶段的研究,阐述相关研究的思路、优势以及存在的问题。本章采用NIC 模型作为基线进行对比。

2.1 图像理解阶段的研究

图像理解阶段工作为完成对图像内容的理解,提取图像特征。作为本节的基线,NIC 模型在图像理解阶段存在以下两个主要缺陷:

(1)模型直接使用图像的全局特征指导解码器生成标题,因此模型没有关注图像重点区域的能力。

(2)图像的全局特征中只含有图像的高层语义,其感受野较大,对图像中对象的位置和相互关系感知能力较差,不足以支撑模型生成高质量的标题。

根据解决这两个问题的方法,本文将相关研究分类为注意力机制的研究和语义获取的研究。

注意力机制在机器翻译领域广泛应用的背景下,研究者们针对模型生成标题关注不到图像重点的问题,提出使用注意力机制解决此问题。2015 年,Xu 等人首次将注意力机制应用到图像标题生成领域,提出基于注意力机制的图像标题生成模型,其中包括基于“软”注意力机制(soft attention)的模型和基于“硬”注意力机制(hard attention)的模型。“软”注意力每次解码会将权重分配到所有区域,权重取值在0 到1 之间,采用后向传播进行训练。“硬”注意力机制每次解码只关注图中的一个区域,采用one-hot 编码,花费时间较少,但是不可微分,一般采用蒙特卡洛采样方法先对梯度进行估计,然后进行后向传播训练。目前图像标题生成领域常用的注意力机制,以“软”注意力机制为主。注意力机制模型将CNN 提取的图像特征由全局特征优化为区域特征。模型在生成单词之前都会通过注意力机制计算要生成的单词与图像中各区域的相关度,选取相关度高的区域的区域特征,传入解码器,指导解码器生成图像标题。注意力机制的引入使图像标题生成模型有了关注重点区域的能力。但这种注意力机制会将单词与去向区域强制对应,像“of”“the”这种虚词也会强制对应图像中的区域造成算力浪费。因此,Lu等人提出一种自适应注意力机制。该注意力机制引入“视觉前哨(visual sentinel)”向量,此向量表示生成单词与视觉信息的相关性取值在0 和1 之间,当单词与图像直接相关时,取值为1,模型会关注图像的区域并生成单词。当生成“of”“the”这种与图像相关性低的单词时,则直接通过语言模型推测。该模型解决了虚词强制对应图像区域的问题,并且有良好的泛化性,改善了原有的注意力机制的算力浪费的问题。Huang 等人提出了一种AOA(attention on attention)模块。AOA 是针对注意力机制设计的一种扩展模块,AOA 能够更加精确地计算向量和注意力查询的相关性,避免了即使无关也产生加权平均值的问题。该模块相当灵活,可以对任何模型和任何注意力机制进行扩展。

传统模型采用CNN 的高层卷积层提取的图像特征作为输出,这种特征图丢失了很多图像信息并且较大的感受野会影响注意力机制的性能。于是研究者们提出使用注意力机制融合高层特征图中的高级特征与低级特征图中的低级特征。Chen 等人提出空间和通道注意力机制模型(spatial and channel-wise attention,SCA),融合了通道注意力机制和空间注意力机制的SCA 可以同时关注多层的图像特征图,即在使用低层特征图保留的图像信息的同时关注高层特征图提取的图像的高层语义,避免了传统注意力机制使用高层空间特征图造成的空间信息丢失和注意力机制功能受限的问题。Ding 等人模仿人类视觉系统的感官刺激理论,提出自底向上的注意力机制算法,对图像区域的低级特征,如对比度、锐度、清晰度,高级特征,如人脸影响进行评分,并将评分进行综合,以此来决定注意力应该关注的区域。You 等人则是融合自顶向下和自底向上方法。该模型获取到图片后,通过CNN 获取其视觉特征,同时检测图像中的视觉概念,如对象、区域、属性等。然后通过一个语义注意力模块将图片的视觉特征和视觉概念融合,并使用LSTM 生成单词。该模型能够处理图像中语义上重要的概念或感兴趣的区域,加权多个概念所关注的相对强度和根据任务状态动态地在概念之间切换注意力。以上几项研究,选择使用注意力机制算法融合高级特征和低级特征的方式,弥补了只使用高级特征造成的信息丢失,获取了更多的图像信息。其中,文献[10]直接使用完整图像的特征图作为图像的高级特征,文献[10-11]则是使用Faster RCNN(faster region convolutional neural network)检测后的区域特征作为高级特征。这两种方式在图像方面都有一定的局限性,文献[10]使用整张图像的特征,提取的为图像的粗粒度语义。文献[11-12]提取的则是区域级的细粒度语义,会造成一定的区域外的语义丢失问题。而这一问题,也是未来需要研究的问题。

语义作为计算机视觉和自然语言处理领域的常见概念,其对于图像标题生成领域也是及其重要的。图像理解阶段其实就是获取的图像特征和语义的过程,这个阶段获取的图像特征和语义越多,解码器生成标题时获得的指导也就更多,而NIC 模型的全局图像特征对对象属性、位置和相互关系等语义反映不足。图像标题生成模型中语义获取方面的问题,研究者们也进行了相应的探索。

Wu 等人首先对图像标题生成任务中是否需要图像的高级概念(对象属性)进行了探究,方法是CNN和LSTM 之间加入了一层属性预测层,构成基于属性的卷积神经网络(attribute convolutional neural network,att-CNN)模型。该模型是一种基于属性的神经网络模型,att-CNN 模型中的编码器在提取了图像特征后,对图像中的对象属性进行预测,获取图像的高级概念,将其构造成向量,并指导LSTM 生成图像标题。经过实验对比发现,模型获取了图像的高级概念之后,模型在标准数据集和评价指标下的评分均显著高于以NIC 模型为代表的传统编码器-解码器模型。证明了图像标题生成模型中图像高层语义的必要性和重要性。在此基础上,Yao 等人探究了五种不同的将图像特征和语义注入LSTM 的方式,分别是:(1)只注入语义特征;(2)先注入图像特征再注入语义特征;(3)先注入语义特征再注入图像特征;(4)先注入语义特征,将图像特征伴随词嵌入注入;(5)先注入图像特征,将语义特征伴随词嵌入注入。最终得出结论第五种方式是五种方式中语义特征和图像特征结合最好的方式。文献[13-14]为图像标题生成领域语义获取方面的研究奠定了基础,文献[13]证明了模型需要图像的对象属性指导标题生成。而文献[14]则是对语义注入解码器的最优方式进行了探究。不同于将编码器优化为属性预测器,Tanti等人在获取语义方面采取了双编码器策略。一个CNN 提取图像特征,一个RNN 提取标题特征,特征融合后输入前馈神经网络,生成标题。该模型同时对图像和标题进行特征提取,获取图像特征及图像语义,指导模型生成标题。该方法优点是更加适合迁移学习,两个编码器都可以进行迁移学习。

自编码器-解码器模型提出以来,由于技术条件所限,对图像的高层语义提取的研究进展较为缓慢。直到Kipf 等人提出图卷积神经网络(graph convolutional network,GCN)。GCN 在提取图结构这种非欧式数据的特征时,表现出了极高的性能,而且其在未经过训练时的性能也保持较高的性能。而图结构在表达图像中的语义信息方面有着其他数据结构无法比拟的优势,其可以表达出图像中的对象、对象的属性以及对象间的相互关系这种图像的高层语义。

2018 年,Yao 等人提出了GCN-LSTM 架构的图像标题生成模型,首次将GCN 应用到图像标题生成领域。模型依赖目标检测技术(如Faster R-CNN)。该模型首先通过目标检测技术检测出图像中的对象、对象属性和对象之间的关系,然后构造图结构。使用GCN 提取图结构的特征,使用该特征指导LSTM生成标题。目前图卷积神经网络被广泛地使用在图像标题生成模型中。值得一提的是配合图卷积神经网络的出现,图像的特征由原来的直接提取网格级(grid)特征变成了先由目标检测技术提取图像的区域级(region)特征。Yao等人提出了层次分析法体系结构(hierarchy parsing,HIP),该结构通过Faster RCNN 和Mask R-CNN(mask region convolutional neural network)技术对图像进行区域级和实例级分割,将图像构造成树结构={,,,,其中代表图像,代表区域级对象,代表实例级对象,代表树结构中的关系,然后采用GCN 提取树结构的特征,将特征传入Up-to-down 注意力机制进行计算,计算出最相关的几个对象,通过对象特征指导Tree-LSTM 生成图像标题。HIP 层次分析法,模型能够提取到图像的三级语义,获取的语义更加丰富,产生的标题质量更高且模型泛化能力较强。但是树结构在表达图像中对象的复杂关系时,有一定的局限性。因此,Shi等人提出了一种标题引导的视觉关系图(captionguided visual relationship graph,CGVRG)的框架。该框架首先通过Faster R-CNN 获取图像中的对象,文本场景图解析器从标题中提取关系三元组。然后将对象和谓语动词通过弱监督学习对应起来,构造CGVRG。将CGVRG 输入GCN,通过GCN 提取CGVRG 的特征和上下文向量,该模型使用图结构的特征和上下文向量指导解码器生成标题,因此模型具有更好的语义信息。与之类似的,Chen 等人提出了一种ASG2Caption(abstract scene graph to caption),该模型通过一种名为抽象场景图的有向图结构驱动模型生成标题。ASG 中包含三种抽象节点,对象节点、属性节点以及关系节点。模型首先通过目标检测技术构建ASG,然后使用GCN 对ASG 进行编码,最后通过ASG 和图像特征指导解码器生成标题。以上几项研究总体上概括了图卷积神经网络在图像标题生成领域应用的现状。首先使用Faster R-CNN 对图像进行目标检测,生成区域级的图像特征。然后使用区域级的图像特征和语义,如对象、对象属性和对象关系等,构造成不同的数据结构(大部分是各种图结构)。最后将生成的图结构传入GCN,通过解码器生成标题。

图卷积神经网络高度依赖目标检测技术提取的区域级描述特征,这种特征本身存在缺乏上下文信息和细粒度信息的缺点。传统卷积提取的网格特征不存在这两种缺点,但语义并不如区域级特征丰富。Luo 等人针对这个问题提出了双极协同的Transformer 架构,这种架构可以通过注意力机制运算选取并融合两种级别的特征,并传入Transformer解码器中生成图像标题。该架构生成的标题,具有丰富的细节和语义信息。Li等人则是通过两个Transformer构成一个Entangle-Transformer 结构,分别对文本和图像进行特征提取并通过Entangle-Transformer 融合,缓解了语义鸿沟问题。

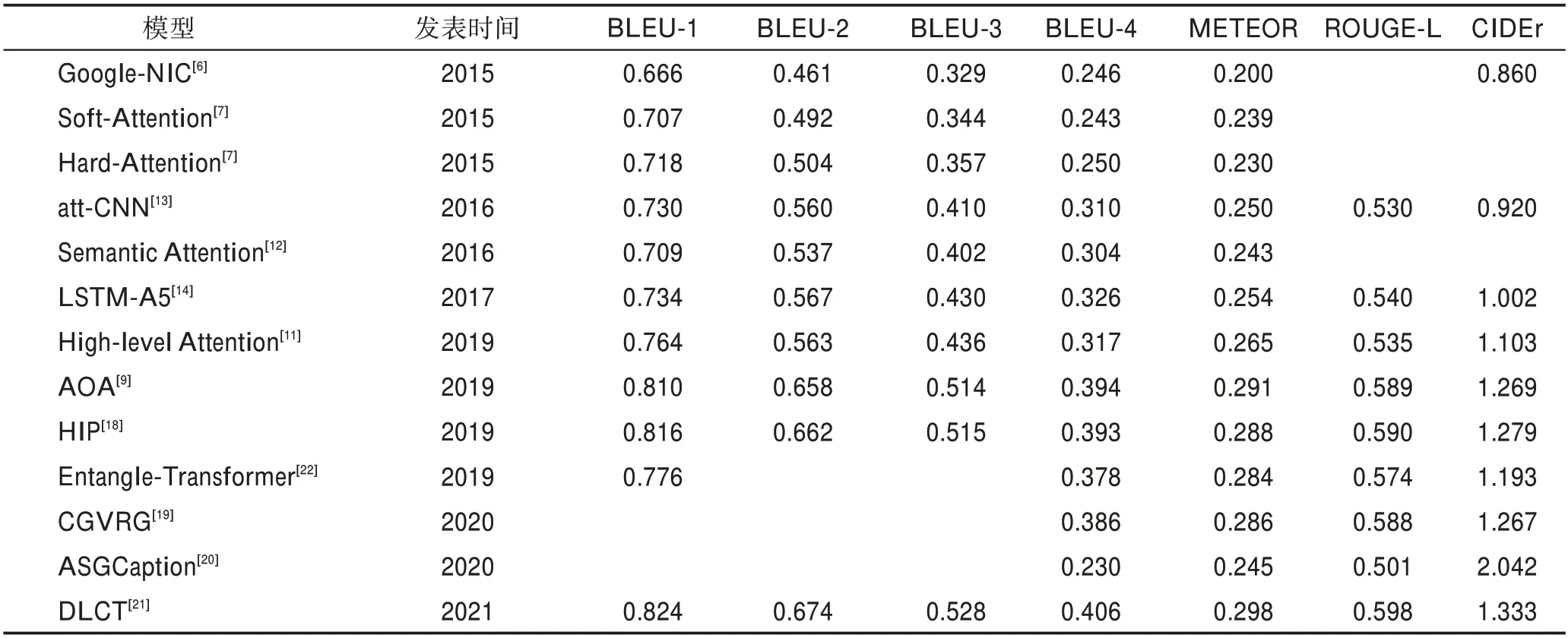

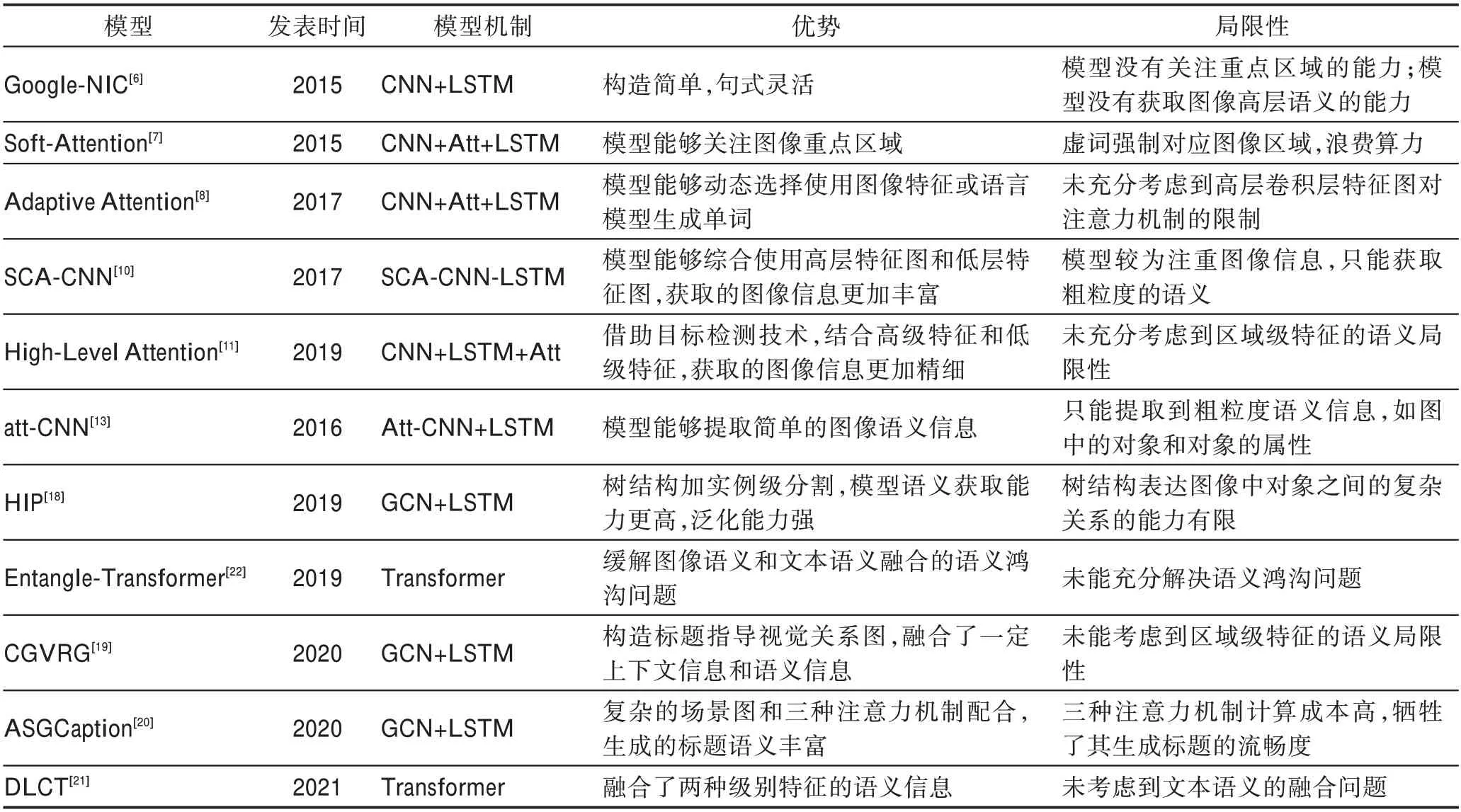

以上针对图像理解阶段的研究模型的性能表现如表1 所示(实验数据均源自相关文章,只统计在Karpathy 分割下MSCOCO 数据集上的实验结果),优势及缺陷如表2 所示,具体数据集和评测指标相关内容见第3章。由以上研究可以看出,目前在图像理解阶段的研究依然围绕两个方面。一方面通过各种技术获取图像中更丰富的语义信息,比如将属性预测器添加进CNN-LSTM,使用各种图结构表达图像中的语义信息。另一方面则是获取到丰富的信息之后,使用各种不同的注意力机制方法,使模型能够在生成单词时“关注”到正确且丰富的信息。

表1 图像理解模型在MSCOCO 数据集上的性能表现Table 1 Performance of image understanding models on MSCOCO dataset

表2 图像理解模型优势及局限性Table 2 Advantages and limitations of image understanding models

图像理解阶段的主流编码器已经完成了从CNN到GCN 的更迭,但正如文献[21-22],Transformer和BERT及其相关变体模型,也逐步应用到图像标题生成领域。相对于CNN 对整张图片进行特征提取,GCN 则是依赖目标检测技术中的Faster R-CNN 先对图像进行目标检测,再提取区域级特征。目前对于GCN 的研究主要集中在构造各种类型的图结构,表达更多的图像语义。这方面的研究的确取得了卓越的表现。但其依然存在一些问题值得未来深入研究:一方面,区域级特征和传统网格特征融合的问题;另一方面,目前的针对图像理解的研究还是处于割裂的阶段,很少能有模型注意到标题中的文本语义对模型的影响。因此,如何融合图像语义和文本语义也是未来需要深入研究的一个问题。

2.2 标题生成阶段的研究

标题生成阶段的工作为解码器根据编码器提取的图像特征和语义信息生成图像标题。解码器主要采用长短时记忆神经网络。本节根据生成标题的类型,将近年来针对标题生成阶段的研究分为三类:生成传统标题的研究、生成密集标题的研究和生成个性化标题的研究。

传统标题作为最常见的标题,多为陈述性句子。按照主谓宾经典结构,再加以适当的修饰,能够言简意赅地描述出图像的核心内容。然而,作为主流解码器的LSTM 存在明显的局限性,主要有以下几点:

(1)LSTM 作为一种序列型语言模型,倾向于预测语料库中出现频率高的语料,造成标题多样性低。

(2)序列模型在逐字预测过程中,对象、对象的属性和对象的关系的混合会影响训练的效果。

(3)LSTM 作为循环神经网络的一种变体,具有高复杂度的递归单元,且其固有时间顺序,无法并行训练,训练成本较高。

因此,针对传统标题的研究热点主要是站在语言模型的角度,优化解码器的结构。目的是生成更流畅、更多样以及更符合逻辑的句子。2016 年,Wang等人对LSTM 结构进行了调整,提出了双向深层LSTM,这种模型将LSTM 由单向构造为双向,并通过堆叠多层LSTM,相较于原始LSTM,双向深层LSTM能够更好地表达图像以及上下文语义。值得一提的是,该模型在未引入注意力机制的情况下,表现出的性能在当时也具有很强的竞争力。但其缺点也很明显,双向深层LSTM 具有更高的复杂度,需要更多的训练时间。

Wang 等人针对序列模型的局限性,提出了组合型LSTM,该组合型LSTM 由一个骨架LSTM 和一个属性LSTM 组成,使用含有高级语义的图像特征的骨架LSTM 指导生成句子的基本骨架,然后通过属性LSTM 生成句子的定语部分,最终组合成句子。Dai等人同样针对此问题提出了不同的解决方法,模型首先从图像中提取各种名词-属性的短语,组成初始短语池。然后递归地使用一个连接模块将两个短语组合成一个较长的短语,直到评估模块确定获得了一个完整的标题。以上两种模型都通过组合的思想,改善序列模型的问题,能够更准确、更具体地生成分布外的图像标题,因此该模型在SPICE 指标上表现优越,但是牺牲了一定的句子流畅度(BLEU 评分较低)。为了调节序列模型和组合模型的缺陷,Tian等人提出了一种组合神经模块网络的序列模型,该模型结合了序列模型和组合模型的优点。该模型首先提出感兴趣的区域,根据上下文计算要关注的区域;然后所选区域的区域特征和整个图像特征被输入到一组模块中,其中每个模块负责预测对象的一个方面,如数量、颜色和大小;最终将这些模块的结果动态组合,并在多次预测后组合成标题。该模型产生的标题既拥有序列模型产生标题没有的灵活性,也比组合型模型产生的标题流畅度更高。

为了增强LSTM 长序列依赖性,Ke 等人提出反射解码网络(reflective decoding network,RDN),该网络通过反射注意力模块(reflective attention module,RAM)和反射位置模块(reflective position module,RPM)的协作,增强了解码器的长序列依赖性和位置感知能力,有效地提高了解码器的长序列建模能力。该网络生成的图像标题能关注到“更早”之前生成的单词,并且具有了联想的能力,例如模型可以通过图中的“火车”“铁轨”推断出所在的地点为车站。Wang 等人在解码器上引入了一种召回机制,模仿人类进行图片描述时会思考过去的经验的行为,提出了基于召回机制的图像标题生成模型。召回机制由召回单元(recall unit,RU)、语义指南(semantic guide,SG)和召回词槽(recalled-word slot,RWS)组成。模型首先通过计算图像特征和单词特征映射在同一空间,然后语义指南模块通过注意力机制计算图像与召回词之间的相关度,获得召回词权重,选择召回词。召回词槽负责将被召回的单词复制到标题中。该模型生成的标题更加符合人类语言逻辑,增加了模型的长依赖性。

LSTM 的递归性和时序性,造成其高复杂度和无法并行训练的固有局限。因此,Aneja 等人开创性提出了一种卷积解码结构,该结构将模型中的解码器替换成了一组掩码卷积神经网络。该网络通过掩码的操作能够完成并行训练,且没有任何递归单元,节省了模型训练的时间,且不受梯度消失的影响。Transformer 和BERT 近年来也开始逐渐被应用在标题生成阶段,Cornia 等人提出了一种MTransformer(meshed-memory transformer)结构,该体系结构改进了图像编码和语言生成步骤:它整合学习到的先验知识,学习图像区域之间关系的多层次表示,并在解码阶段使用类似网格的连接来利用低级和高级特征,在降低模型复杂度的同时,缓解了语义鸿沟问题。Hosseinzadeh 等人则是使用Transformer模型完成了描述图像细微差别的任务,该模型通过与图像检索技术相结合,能够对两张只有细微差别的图片进行差别描述。

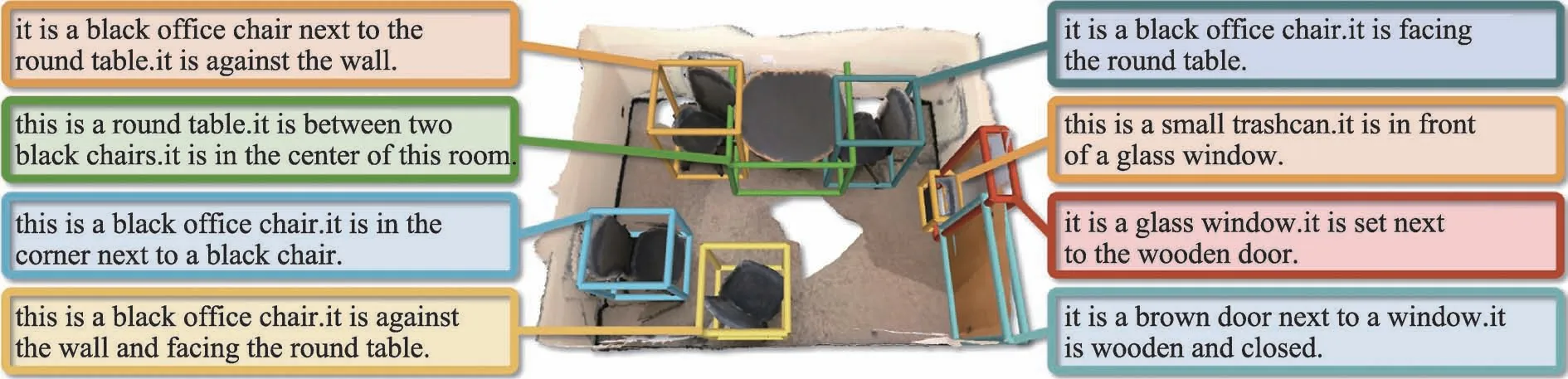

密集标题(dense caption)是标题生成模型功能的一种扩展。其功能是为所有检测到的对象生成描述。具体标题形式见图4。

图4 密集标题Fig.4 Dense caption

2013 年,Kulkarni 等人在基于模板的模型上进行了密集标题,提出了一个能够生成密集标题的模型。该模型检测到图像中的对象后,对图像的属性和关系进行推理,生成一个详细的描述,然后通过条件随机场生成具有一定逻辑性的段落。该模型虽然一定程度上完成生成密集的任务,但是由于当时技术限制,以及基于模板方法手动提取特征的缺陷,导致该模型鲁棒性较差。

2016 年,Johnson等人首次引入了密集的标题任务概念,即为图像生成更多条语句,多条语句之间有一定的相关性,能够更加详细地描述图像的内容。其还提出了一个全卷积定位网络(fully convolutional localization network,FCLN)架构,该架构由一个卷积网络、一种密集定位层和生成标签序列的递归神经网络语言模型组成,密集定位层即对图像分块定位、分块描述。密集定位层的加入使得图像能够被更精细地描述,生成更加详细的标题。虽然取得了令人印象深刻的结果,但这种方法没有考虑到突出的图像区域之外的上下文。为了解决这个问题,Yang 等人提出了使用Faster R-CNN 进行目标检测,并提取区域图像特征后,将整个图像的特征传入解码器中作为上下文使用。而Kim 等人提出使用POS(part of speech)标签指导生成标题。该模型使用一个多任务三重流网络预测各个对象的POS,然后使用POS 作为上下文指导标题生成。以上的工作只能针对2D图像无法捕捉到3D 图像。Chen 等人使用commodity RGB-D 传感器的三维扫描密集标题任务。该模型通过三维扫描,能够更加精准地捕获对象的定位,以及对象的特征及属性,使模型能够完成3D 图像的密集标题生成任务。

通过以上研究可以看出,针对生成图像密集标题的任务,研究重心主要集中在对象定位的准确性上,一般来说目标检测越精准,生成的密集标题质量也越高。

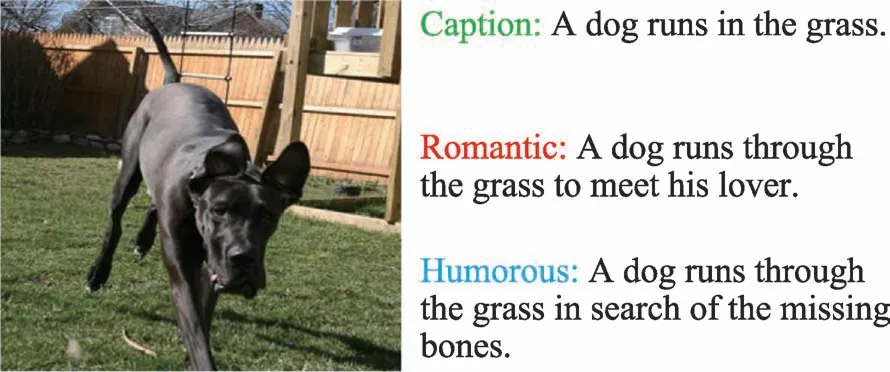

传统的图像标题生成模型生成的标题大多数都是陈述性句子,基本不带有感情色彩。随着图像标题生成模型在日常生活中的应用,人们发现了让生成句子带有情感的必要性,具体标题形式见图5。

图5 个性化标题Fig.5 Stylish caption

Mathews 等人提出了具有开关式RNN 的模型。这种模型实际上是在传统RNN 上添加了一个“情感门”,“情感门”通过函数来控制生成句子中的积极情感(positive)和消极情感(negative),从而生成带有情感色彩的文本描述。但是该模型对于积极情感和消极情感的区分过于粗糙,并且无法生成带有复杂情感的句子。Chen 等人提出了Style-Factual LSTM,通过对抗性训练的方法来训练程式化的图像标题生成模型。该模型可以生成积极、消极、浪漫和幽默风格的标题。以上这两种方法很大程度上依赖于成对图像的程式化句子来训练程式化图像标题生成模型。

Gan 等人提出一种StyleNet 框架,该框架使用未配对的程式化语料库生成具有浪漫、幽默风格的图像标题。该框架中使用了一种可以自动提取文本语料库中的样式风格的Factored-LSTM,可以通过对图像数据集和带有风格的文本数据集的联合训练,生成带有风格的标题。张凯等人提出了一种双解码器的双语图像标题生成模型,该模型使用双解码器,对同一图像生成两种语言的标题,这种方法虽然有效地利用了两门语言特征,但是由于不同语种的语序有所不同,两种语言的联合方法可能存在融合噪声的问题。Chen 等人提出了一种可控的时尚图像描述生成模型。使用两种训练集和两种编码器——传统训练集(源训练集)和带有目标风格的文本训练集(目标训练集),传统编码器CNN 和文本编码器(skip-thought vectors,STV),通过对两种数据集的联合训练,可以生成带有写作风格的图像标题,句子的灵活性有了极大的提高。Zhao 等人提出了一种新的程式化图像字幕方法MemCap。MemCap 使用记忆模块记忆语言风格,并在解码阶段使用注意力机制关注标题和语言风格来生成标题。因此,该方法能够准确地描述图像的内容,并适当地反映出图像所期望的语言风格。另外,该方法能够同时执行单风格和多风格标题,泛化性强。

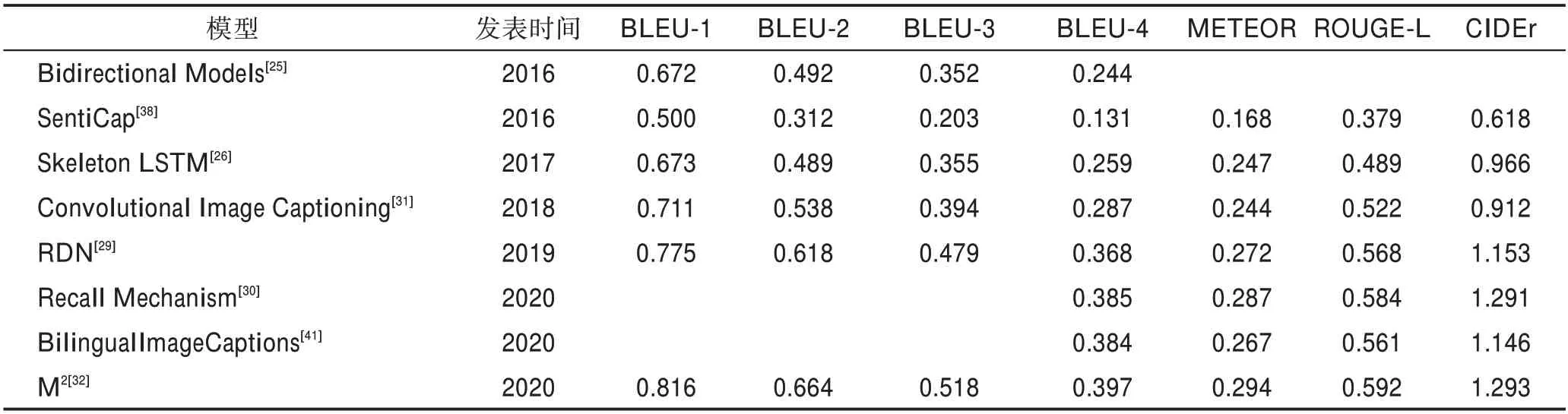

以上针对图像理解阶段的研究模型的性能表现如表3所示(实验数据均源自相关文章,只统计在Karpathy 分割下MSCOCO 数据集上的实验结果),优势及缺陷如表4 所示,具体数据集和评测指标相关内容见第3章。由以上研究可以看出,相较于图像理解阶段的围绕大方面进行研究,标题生成阶段的研究更加多样。传统标题生成、密集标题生成和个性化标题生成的研究重点各有侧重。传统标题生成较为依赖目标检测技术,因此其研究重点主要是优化解码器局限性,提高标题的流畅性、逻辑性、长依赖性等质量指标。密集标题生成的研究主要围绕着如何对图像中的对象进行精准定位,获取更多的对象信息,如位置、属性和相对关系等。而个性化标题的生成研究焦点则是使用不同风格的语料库和配对方式,生成不同风格的标题。

表3 标题生成模型在MSCOCO 数据集上的表现Table 3 Performance of caption generation models on MSCOCO dataset

表4 标题生成模型优势及局限性Table 4 Advantages and limitations of caption generation models

3 图像标题生成数据集与评测指标

3.1 图像标题生成数据集

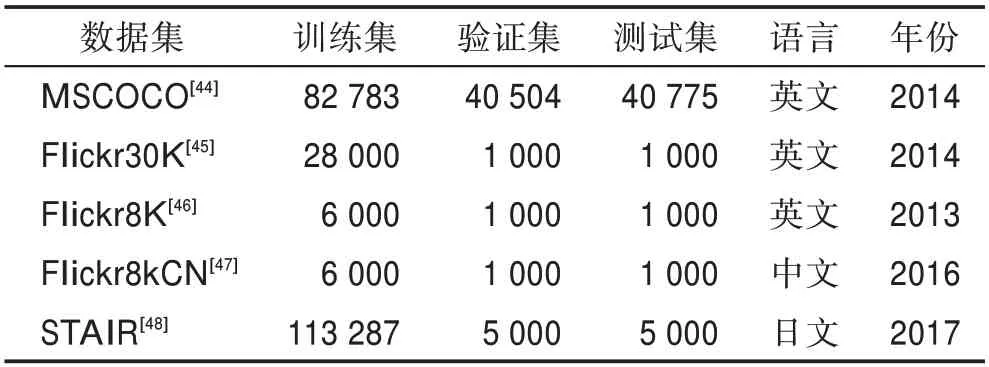

图像标题生成领域,目前有多个常用的数据集,如MSCOCO、Flickr30K、Flickr8K 等,其信息如表5所示。

表5 图像标题生成数据集信息Table 5 Information of image captions generation datasets

(1)MSCOCO 数据集是目前最大的图像标题生成数据集,适用于各种计算机视觉任务,如目标检测、图像分割、图像标题生成等。在图像标题部分,包括训练集82 783 张图像,验证集40 504 张图像。MSCOCO 数据集对图像标题生成模型和算法具有极高的挑战性,因为大多数图像中都包含复杂场景下的多个对象,每张图像都包括5 个人工标注的图像标题。模型评估时,一般采用Karpathy 等人的划分标准,即从验证集中取出10 000 张图像,其中5 000 张图像用于验证,另外5 000 张用于最终测试。由于MSCOCO 数据集的专业性及挑战性,MSCOCO 数据集目前是图像标题生成领域的主流评测标准数据集,各种模型和方法在该数据集上的评分是评价模型和算法性能的重要指标。

(2)Flickr30K 数据集由Young 等人提出,其数据量相对较小,包括31 783 张日常活动、事件和场景的照片,每张图像对应5 条人工标注的描述句子。在线评估是采用Karpathy 等人的划分标准,取其中29 000 张图像及其标题作为训练集,1 000 张图像及其标题作为验证集,其余样本作为测试集。Flickr30K也是图像标题生成领域的一个重要评测标准数据集,一般和MSCOCO 数据集一起评测模型和算法的性能,作为MSCOCO 的补充。

(3)Flickr8K 数据集,由Hodosh 等人提出,其样本量更少,共包含8 091 张图像。同样地,每张图像对应5 条参考句子。在具体使用时,一般选取其中的6 000 张图像及其参考句子用于模型训练,另外1 000张图像与参考句子用于模型验证,其余1 091 张图像用于最终的模型测试。

(4)其他数据集基本都是在以上三种数据集基础上扩展而来,如Flickr8kCN 是由Li等人对Flickr8K进行了中文标注,STAIR 数据集是Yoshikawa 等人对MSCOCO 数据集进行了日文标注。

3.2 图像标题生成评价指标

图像标题生成任务的研究多采用生成的标题和参考标题之间的匹配程度来评价生成标题的质量。常用的评价指标有BLEU(bilingual evaluation understudy)、METEOR(metric for evaluation of translation with explicit ordering)、ROUGE-L(recall-oriented understudy for gisting evaluation)、CIDEr(consensusbased image description evaluation)和SPICE(semantic propositional image caption generation evaluation)。其中BLEU、METEOR 和ROUGE-L 是机器翻译的评测标准,CIDEr 和SPICE 是图像标题生成任务专用的评测标准。

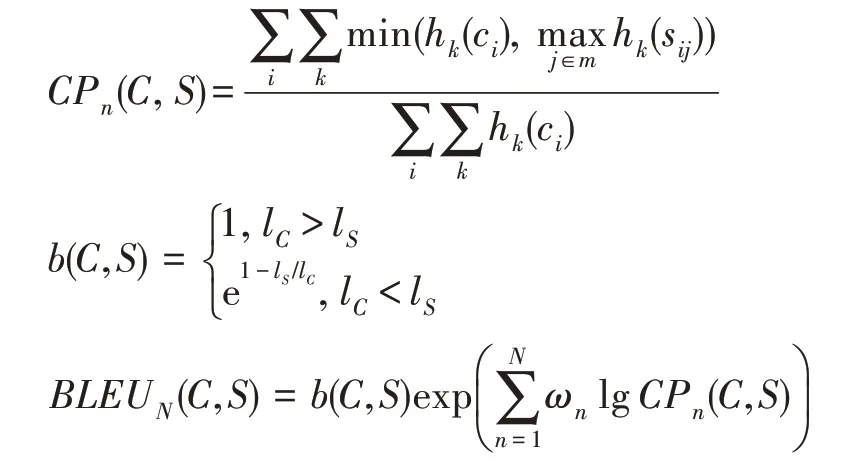

BLEU 指标主要用于衡量句子的准确性和连贯性,它通过计算生成句子与参考句子-gram 的匹配程度对生成句子进行打分,其中的取值为{1,2,3,4},指几个连续的单词分为一个元组。当确定时,BLEU 的值越高,生成的句子就越连贯,其计算公式如下:

其中,每一个语句用元组ω来表示,元组在人工标注语句S中出现的次数记作h(S),元组ω在待评价语句c中出现的次数记作h(c),l是待评价语句的总长,l是人工标注语句的总长度。BLEU 得分越高,性能也就越好。BLEU 指标对句子的长度也有一定的要求,若句子过短,便会使用惩罚因子降低句子的分数。BLEU 关注的是-gram 而不是单个单词,考虑了更长的匹配信息。但是由于BLEU 提出的时候,研究者们还没有发现召回率这个因素对评价指标的影响,BLEU 并没考虑到召回率这个因素。

METEOR 则是研究者们发现在评价指标加入召回率之后,评测的结果和人工评测的结果相似度提高之后提出的评价指标。METEOR 提出时就是为了解决BLEU 的固有缺陷,因此METEOR 指标考虑了召回率的影响,并且该指标可以计算同义词、词根、词缀之间的匹配关系,评测结果与人工评测的结果相关度更高,其计算公式如下:

其中,为召回率,为准确率,为匹配的总对数,为候选标题的长度,为参考标题的长度,为惩罚因子,是为了考虑词之间的顺序,如果两句子中,互相匹配的单词都是相邻的,那么就将它们定义为同一个,总数为。

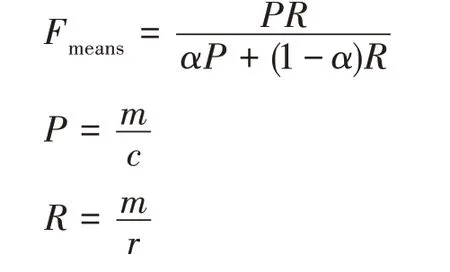

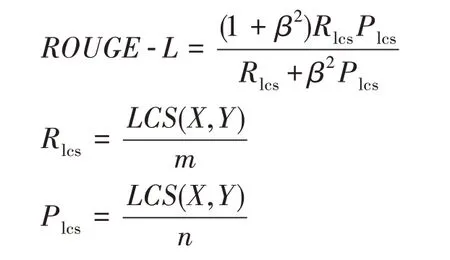

ROUGE 是由Lin 提出的一组评价指标,主要包括ROUGE-N、ROUGE-L、ROUGE-S、ROUGE-W、ROUGE-SU,使用者可以根据需要选择合适的评价指标,图像标题生成领域一般采用ROUGE-L 评价指标来评价模型的性能。ROUGE-L 主要针对BLEU 评价指标忽视了召回率的问题做出了优化,与BLEU 类似,ROUGE-L 也是基于-gram 的评价指标,计算生成标题与参考标题之间的元组重合度来衡量标题的质量,其思路与BLEU 基本一致,只是在算法中增加了召回率因素,其计算公式如下:

其中,表示候选标题,表示参考标题,(,)表示候选标题和参考标题的最长公共子序列长度,表示参考标题的长度,表示候选标题的长度。

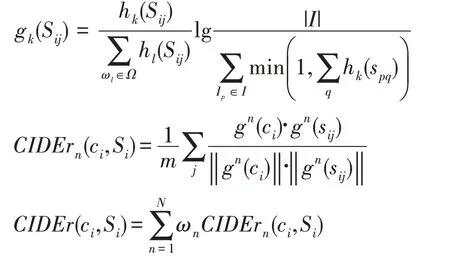

CIDEr 是图像标题生成任务提出后,专门为图像标题生成任务设计的评价主表,避免了前几种指标只在自然语言的角度评价句子质量的缺陷。CIDEr是一种对BLEU 评价指标的改进,首先计算生成标题和参考标题的TF-IDF 向量,然后计算它们的余弦相似度,通过余弦相似度来衡量生成标题与参考标题之间的相关性,其计算公式如下:

其中,一个元组ω在人工标注语句S中出现的次数记作h(S),在待评价语句中出现的次数记作h(C),元组的TF-IDF 权重g(S),是所有元组的个数,是数据集中所有图像的集合。CIDEr 的得分越高,生成的语句的质量也就越好。

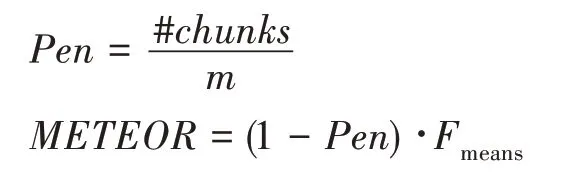

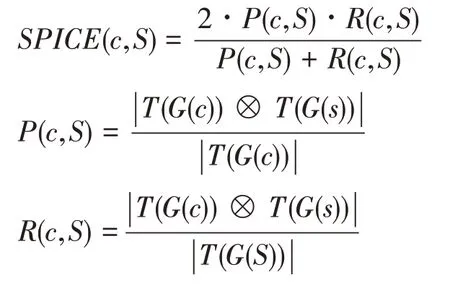

SPICE 指标也是针对图像标题生成领域设计的评价指标。与CIDEr 不同的是,SPICE 更加关注语义命题内容。SPICE 认为图像标题中应该包括图像中存在的各个语义命题,SPICE 将生成标题和参考标题均转化为场景图的形式,场景图中表示了图像中的对象、属性和关系,通过对比场景图来生成标题评分,其计算公式如下:

其中,为候选标题,为参考标题集合,(·)表示转换场景图的方法,(·)表示元组转换方法,⊗表示匹配运算。

以上几个指标均为标题工作中进行语义相关性评估的指标,而个性化标题生成任务评价指标比较特殊。个性化标题的评价分为两个方面:一方面是语义相关性的评估,采用的评分标准为以上几个评分指标,而其中SPICE 指标在个性化标题生成中更关键;另一方面是标题的个性化评估,这方面由于其构造数据集和评估的复杂性,目前没有明确统一的评估指标,一般是采用语言风格迁移的评价指标或采用人工评估的方式进行评估。

4 研究难点与热点

目前,经过近几年的研究工作,图像标题生成领域的工作已经有了显著的进展。但其在语义融合、模型的高复杂度以及数据集的标注及规模方面仍然存在诸多问题需要深入研究。

语义融合问题:目前大部分图像标题生成的研究图像和文本的割裂感较为严重,容易出现语义鸿沟问题。如何将图像语义和标题的文本语义结合起来,关注到图像模态和文本模态,是未来值得研究的问题。

模型复杂度问题:LSTM 作为图像标题生成模型的解码器,尽管一定程度上解决了RNN 网络梯度消失、梯度爆炸和长依赖性等问题,表现出了较高的性能。但随着自然语言处理领域的研究愈加深入,生成的文本越来越长,越来越复杂,LSTM 的缺陷也暴露出来,如训练开销巨大,在处理长文本时性能会降低等问题。因此,解决解码器的自身缺陷,也是图像标题生成领域的难点。目前解决这个问题的思路是采用2017 年Vaswani 等人提出的Transformer 模型,该模型是一种利用纯注意力机制计算的神经网络模型,在处理序列数据上表现出了很好的性能,目前其各种变体已经广泛应用在了自然语言处理领域和计算机视觉领域。因此,使用或改进Transformer 模型,将其应用在图像标题生成领域将是热门问题。

数据集的构建:图像标题生成领域的数据集在构建时需要专业人员为每张图片标注五条或以上不同表达形式的标题,构建成本高昂。随着研究的不断深入,高性能模型层出不穷,现有的数据集规模已经很难满足训练需求。另外如中文、德语、日语等数据集规模较小,难以训练出高性能模型,限制了图像标题生成模型的跨语言能力。这方面的解决思路一般是通过半监督学习去训练图像标注的模型作为数据集。

5 结束语

图像标题生成任务作为一种融合了计算机视觉和自然语言处理的多模态任务,打破了视觉与文本之间的界限,在人工智能领域引起了广泛关注。自其被提出以来,经历了基于模板的方法、基于检索的方法和基于编码器-解码器的方法。而基于编码器-解码器的方法中又经历了从CNN 到GCN,从LSTM到目前逐渐被应用的Transformer 和BERT 的技术革新。可以发现图像标题生成领域的研究与计算机视觉技术和自然语言处理技术之间的关系越来越密切。诸如目标检测、图像检索、机器翻译等任务的思路和技术都逐渐被应用在了图像标题生成领域,可见其研究思路的开阔性和巨大的可能性。近年来,研究者们不断提出高性能的图像标题生成模型及其相关算法。本文在广泛阅读国内外文献的基础上,对图像标题生成的概念和三种方法进行了阐述。其次本文按照图像标题生成的流程,将近年来的研究分为图像理解阶段的研究及标题生成阶段的研究并详细介绍了各项研究的模型内容及优缺点。最后,介绍了图像标题生成领域的经典数据集和评价指标,讨论了图像标题生成领域目前的研究难点与热点。