基于深度学习和哈希方法的敦煌壁画移动视觉搜索研究

殷婕 曾子明 孙守强

关键词: 移动视觉搜索; 图像; 敦煌壁画; 深度学习; 哈希; 语义融合

DOI:10.3969 / j.issn.1008-0821.2023.05.004

〔中图分类号〕G203 〔文献标识码〕A 〔文章编号〕1008-0821 (2023) 05-0035-11

文化遗产是人类文明的载体, 文化遗产保护是全球高度重视的议题。敦煌石窟开凿于前秦建元二年, 融合中外多民族千余年的历史文化, 形成了具有中国特色的佛教艺术体系, 敦煌壁画是全面认识中国艺术史必不可少的部分, 同时对于推动现代艺术创新具有重要意义[1] 。信息技术快速发展, 文化遗产数字化进程加快, 敦煌壁画修复技术和数字化采集技术日趋成熟, 图书馆、档案馆和博物馆(Li?braries, Archives and Museums, LAMs)中存储了大量敦煌壁画图像资源。因其抽象的视觉表现形式和晦涩的图像语义内容, 用户难以用准确语言描述搜索对象, 敦煌壁画存在搜索难度大、资源利用率低等问题, 阻碍科研人员对敦煌壁画研究工作的开展, 打击用户通过搜索敦煌壁画了解敦煌文化的积极性。

移动视觉搜索(Mobile Visual Search, MVS)借助移动设备上传实体的视觉资源, 并在网络上搜索相关信息[2] 。将该项技术应用到敦煌壁画搜索领域能有效提高资源获取效率, 在壁画实体修复与保护、数字化采集与存储等环节的基础上, 从资源利用与信息传播角度助力敦煌文化遗产保护与文化传承。移动视觉搜索强调移动泛在、实时便捷的用户体验, 在网络覆盖环境下对模型计算速度、信息传输稳定性等技术要求更高, 其准确性、完整性、灵活性等是影响用户体验的核心要素[3] 。

传统基于文本的图像检索只考虑文本关键词,缺少图像特征融合, 导致搜索准确性不高。基于内容的图像检索存在语义鸿沟, 图像高层语义和用户检索意图未被考虑。目前深度卷积神经网络(DeepConvolutional Neural Network, DCNN)性能突出[4-6] ,能提取到敦煌壁画更复杂和更深层的图像特征, 语义标签文本特征的融合能减少图像语义鸿沟, 弥补传统图像检索的不足。使用DCNN 提取图像特征时, 高维的特征向量对设备的存储能力和计算性能要求较高, 导致搜索耗时长、端到端成功率无法保证, 会严重影响用户搜索体验。在此基础上引入哈希方法对高维图像特征向量进行压缩, 能提高计算速度和传输稳定性。因此, 本文基于DCNN 和哈希方法并融合图像语义特征构建敦煌壁画的移动视觉搜索模型, 为用户提供结果准确、检索快速、知识丰富的即时即地资源获取服务, 帮助用户深入理解敦煌壁画内涵。

1相关研究

1.1敦煌壁画

敦煌壁画融合東西方特色, 蕴藏丰富的经济、政治、宗教和文化内涵, 是研究古代历史最有价值的文化遗产之一。学者以敦煌壁画为对象, 研究古代丝绸之路上的文化交融、历史变迁、礼仪功能、人与自然、宗教信仰等; 从线条语言、色彩语言、人物形象、图像叙事、情感表达等角度探讨敦煌壁画对现代服装设计、建筑设计、构图与美术创作、影视动画创作等领域的影响与启发。

敦煌壁画是数字人文领域的重点研究对象。

“数字人文” 起源于“人文计算”[7] , 涉及多学科有机融合, 强调对计算机科学和人文社会科学交叉领域的研究创新以及数字技术在文化传播中的应用, 引发了传统人文研究范式的变革, 推动了人文社会科学研究的进步[8] 。王晓光等[9] 搭建敦煌壁画语义框架并构建领域词汇, 解决图像检索中的语义鸿沟问题。Zeng Z 等[10] 使用视觉词袋方法提取壁画图像特征并用支持向量机进行图像分类, 探讨敦煌壁画的主题分布特点和朝代演变规律。WangH 等[11] 研究了基于生成对抗网络的敦煌壁画修复技术, 通过学习退化和恢复的壁画纹理之间的关联, 实现壁画的自动修复。李清泉等[12] 提出了基于线描图稀疏编码的壁画修复算法。陈永等[13] 改进曲率扩散算法, 结合自适应策略研究壁画的修复方法。Fu X 等[14] 设计了基于虚拟现实的RestoreVR系统, 让用户在洞窟的数字游览中体验敦煌壁画复原。“数字敦煌” 项目利用科学技术完成对敦煌文化遗产的数字化采集、处理和保存[15],通过构建多模态互联的敦煌数字化资源库在世界范围共享[16] 。但是, 如何高效、便捷搜索敦煌壁画提高文化遗产资源利用率的研究还不够充分。

1.2移动视觉搜索

移动视觉搜索由David M C 等[17] 于2009年首次提出, 关键技术涉及关键点检测、特征提取、特征表示、特征索引等[18] ; 被广泛应用于植物、杂志、购物、旅游、地标、博物馆、图书馆等多个领域[19] 。图博档中存储的大量非结构化数据资源于数字人文研究而言具有极高价值[20] 。然而资源利用效率低下是当今图博档建设面临的主要问题之一, 研究移动视觉搜索在该领域的应用, 优化资源获取服务是解决此问题的有效途径[21] 。

在数字人文领域视觉资源组织中, 移动视觉搜索作为核心技术, 提高了图书馆资源组织效率和知识服务水平[22] 。在体系结构与服务模式研究方面,张玥等[23] 提出了图书馆文旅融合发展的MVS 解决方案。韩玺等[24] 融合用户、资源、服务、时空、技术、线索要素, 设计了基于情景感知的MVS 服务。李晨晖等[25] 以文化遗产数字化为基础, 对数字图书馆MVS 机制建设提出了新的见解。曾子明等[26] 构建模型为读者提供情景化服务, 提升了文化遗产领域知识服务的智慧化水平; 在模型中引入用户画像概念, 解决用户搜索过程中的个性化需求满足问题[27] 。李默[28] 讨论了将深度学习应用到智慧图书馆MVS 的可行性, 提出了基于深度学习的服务模式。董晶等[29] 基于该技术构建了智慧公共文化服务模型。在技术研究方面, 秦思琪等[30] 从提取图像语义特征和提高搜索速度出发, 将哈希编码嵌入卷积神经网络进行端到端的图像特征提取和压缩, 实现了数字人文领域资源的图像检索, 但该方法缺乏资源针对性且搜索性能有待提升。曾子明等[31] 搭建了基于视觉词袋(Bag-of-Words, BoW)的MVS 模型, 但该模型使用机器学习方法提取图像特征, 敦煌壁画的深层特征和高层语义未被考虑,且搜索性能仍有提升空间。已有研究聚焦在体系结构与服务模式的探讨, 而技术研究主要围绕普适性的搜索方法或模型框架展开, 欠缺对领域资源特征的考虑, 且搜索性能亟需提升。

1.3DCNN 和哈希方法

随着计算能力的提高, 深度学习在图像特征提取上显示出了优越的性能。AlexNet[32] 、VGG16[33] 、VGG19[34] 、ResNet[35] 、DenseNet[36] 、Inception[37] 、InceptionResNet[38] 、Xception[39] 、NasNet[40] 、Effi?cientNet[41] 等多个DCNN 算法被相继提出。在应用层面, Li W 等[42] 设计了基于DCNN 的车位检测方法, 对于从不同角度观察到的不同形状的停车位,根据入口线的类型、位置、长度和方向等特征推断出完整的停车位。Nandagopal S 等[43] 基于关键点提取和DCNN 设计了人体姿势估计模型, 可用于多场景的人体动作识别。Islam M S 等[44] 提出了一种基于DenseNet 的新冠肺炎图像识别方法, 从胸部X 光图像中检测新冠肺炎、普通肺炎和正常病例。哈希方法是一种输出特定长度二进制编码的加密算法, 现在多被用于区块链[45] 、云计算[46] 等场景。除用于加密传输外, 也有可直接用于相似图像计算的感知哈希、均值哈希和差异哈希, 以及用于相似文本计算的SimHash[47] 等。

在移动视觉搜索的图像特征提取过程中, 部分学者将深度学习和哈希方法结合, 同时实现特征的精确提取和快速计算。主要有先使用算法完成图像特征提取再进行哈希压缩[48-49],以及在神经网络结构中嵌入隐藏层构造端到端的图像特征二进制编码输出模型[50-51]两种模式。前者的特征提取和压缩过程相对独立, 方便对各模块进行单独优化, 在不同数据集上寻求更好的效果; 后者将图像处理过程封装, 能充分利用深度学习机制的优势, 但泛化能力相对较弱。综上, 本文提出基于深度学习和哈希方法的语义融合MVS 模型, 同时构建包含人工语义标注的敦煌壁画图像数据集, 以验证该模型搜索敦煌壁画的优越性。

2基于DCNN 和哈希方法的移动视觉搜索模型构建

基于DCNN 和哈希方法, 融合图像语义特征,构建敦煌壁画移动视觉搜索模型, 如图1 所示, 实现敦煌壁画的高效便捷搜索。本文创新点如下: ①技术层面。考虑资源特征和用户需求, 构建了全新的移动视觉搜索模型; 结合深度学习和哈希方法,在特征提取准确性和模型计算效率上改进传统基于机器学习方法的移动视觉搜索; 此外, 通过融合语义特征并对搜索结果进行重排序, 解决图像搜索的语义鸿沟问题, 返回更贴近用户检索意图的可视化结果; ②应用层面。将移动视觉搜索的理念应用到敦煌壁画的资源获取, 打破传统信息检索的时空限制, 提高敦煌壁画资源的利用率, 亦可将该模型用于数字人文领域的其他视觉资源检索, 促进数字人文研究与文化交流。

基于标准化架构[18] , 模型搭建具体步骤为:①资源库构建: 向系统上传敦煌壁画原始图像, 根据壁画内容和主题进行人工语义标注, 构建敦煌壁画图像库和语义库; ②图像特征提取: 用户于移动端上传待检索图像并传输至云服务器, 模型在服务器端使用DCNN 完成图像特征提取; ③图像特征压缩: 使用哈希算法将特征向量压缩为哈希编码,计算汉明距离与资源库中的图像进行相似图像匹配, 锁定top-1 相似图像; ④语义特征融合: 使用SimHash 处理语义标签, 融合图文特征, 计算top-1图文特征与资源库中其余图文特征的汉明距离进行二次匹配和重排序, 得到最相似的前16 个图文组合, 最后将搜索结果可视化并返回用户端。

2.1图像特征提取

当前移动视觉搜索模型普遍采用机器学习方法提取图像特征, 如SIFT(Scale-Invariant Feature Trans?form)、SURF(Speeded -Up Robust Features)、HSV(Hue, Saturation, Value)、HOG(Histogram of Orien?ted Gradients)等。此类方法提取到的特征维度不高,能较好满足移动视觉搜索对设备性能的要求, 但基于机器学习的图像特征提取仅能检测图像局部特征点或浅层的全局特征。在计算机视觉领域, 图像的颜色、纹理、几何形状等属于全局特征, 容易受到拍摄环境和拍摄角度的影响, 可以通过HSV、HOG等方法实现提取, 若仅提取敦煌壁画的全局特征,用户实地参观时, 通过拍摄上传的方式进行搜索的效果会大打折扣; 局部特征是在图像内部选择能够代表图像主要内容的特征点, 这些特征点可以在方向、大小上进行调整, 提高了特征匹配的灵活性和鲁棒性, SIFT、SURF 等是使用较多的局部特征提取方法, 但对于富含语义内容的敦煌壁画而言, 语义鸿沟问题难以解决。

2012年, DCNN 被首次用于ImageNet 的图像分类, 同时AlexNet 算法模型被提出[32] 。此后的模型多是基于AlexNet 从增加神经网络的深度、宽度、优化特征传输效率等维度去优化卷积神经网络结构, 实现模型精度和计算效率的提高。VGG16[33]和VGG19[34] 主要通过增加网络的深度来提高模型性能, 将AlexNet 中较大卷积核替换成堆叠的3×3卷积核, 增加网络层数的同时减少参数量, VGG19比VGG16 更深, 特征提取效果更好。ResNet 从特征利用角度切入, 首次引入残差连接来优化全连接导致的信息丢失现象[35] 。DenseNet 延续了ResNet的思想, 每个卷积层与其他所有卷积层通过前馈方式连接, 传统L 层的卷积网络有L 个连接, 在DenseNet 中有L(L+1) / 2 个连接, 从而加强特征传递并减轻因为网络太深带来的梯度消失问题[36] 。在增加宽度方面, Inception 将不同数量的卷积和池化组合成一个更宽的模块, 整个网络由多个不同的模块以稀疏连接的方式堆叠加深[37] 。InceptionRes?net 在Inception 基础上引入残差结构, ResNet 提供了有效地将上一层的特征汇总到下一层的快捷链接, 从而最大限度地利用这些特征并获得更高的精度[38] 。Xception 将原Inception 的模块更换成深度可分离卷积, 以此来减少模型参数, 提升模型计算效率, 同时使用残差连接来加快模型收敛, 提高准确率[39] 。NasNet 基本思想与Inception 类似, 但在细节结构上更复杂, 在ImageNet 上图像分类的准确率优于所有的Inception 模型, 且支持調整模型大小来实现准确率和计算量的平衡[40] 。此外, Ef?ficientNet 同时增加神经网络的深度、宽度和分辨率, 使用缩放系数实现这3 个维度在不同数据集上的平衡以达到最优效果[41] 。

模型在图像特征提取模块采用深度卷积神经网络提取敦煌壁画更深层和复杂的图像特征, 并综合考虑底层特征和高层语义。由于敦煌壁画在线条、构图、颜色等绘制元素上呈现出丰富的视觉特征以及具有价值极高的抽象语义特征, 实验部分探索不同优化方式的DCNN 在敦煌壁画图像上的表现差异, 在更深的网络上选择VGG19, 更宽的网络上选择Inception、InceptionResnet、Xception 和NAS?Net, 在优化特征传递效率方面选择具有代表性的DenseNet, 在多维度优化上选择最新的Efficient?Net; 并选出在敦煌壁画MVS 模型中性能最优的算法。如图2 所示, 使用DCNN 提取敦煌壁画图像特征时, 输入原始图像后, 首先在壁画图像上移动卷积核并执行计算, 得到一组平行的特征图, 即卷积层; 随后进行池化操作, 对特征图进行降采样, 保留重要的壁画特征信息, 减小图像空间大小, 能减少过拟合率, 加快计算速度; 最后在经过多个卷积层和池化层之后, 通过全连接层进行输出, 得到敦煌壁画图像的特征表示。

2.2图像特征压缩

3实验方法与结果分析

3.1数据收集与处理

1)本文从《中国敦煌壁画全集》[54]上收集敦煌壁画图像, 为保证样本平衡性, 从北魏到西夏元10个时期中各抽取120 张壁画, 构建总数为1200张的图像数据集。

2)根据敦煌壁画内容和主题, 人工添加语义标签构建文本数据集, 邀请5位熟悉敦煌壁画的研究人员从壁画的描述中提取标签进行语义标注, 其中4位研究人员被分成两组并行完成图像初始标注, 1位博士负责核查两组标注的最终结果。语义标签主要集中在“菩萨” “飞天” “观音” “说法”“藻井”“文殊”“观无量寿经變”“弥勒经變”“维摩诘经變” “天王” “力士” 等。不同朝代的敦煌壁画图像前20个高频主题的语义标签如表1所示。

3.2实验环境与实验设计

实验环境为Window10, 64 位操作系统, 32G 运行内存, RTX3060-6G 独显, AMD Ryzen 7 5800Hwith Radeon Graphics 3 20 GHz 处理器, Pycharm+Anaconda, Python3 9, 加载Scikit-Learn, OpenCV-3 4 2 16 库等。设计两个实验: 实验一, 筛选图像特征提取算法与图像特征压缩算法的最优组合; 实验二, 在实验一的基础上进行模型对比, 并验证模型搜索效果。选择平均搜索时间、特征存储空间作为无序搜索结果评价指标; 选择P@ k(k = 4、8、16)、R@ k(k= 4、8、16)、mAP 作为有序搜索结果评价指标。P@ k 用于衡量前k 个搜索结果的准确率, R@ k 用于衡量前k 个搜索结果的召回率,mAP 可综合反映模型的平均搜索性能[30] 。

3.3基于DCNN 和哈希方法的相似图像搜索

3.3.1最优算法组合选取

实验一使用DenseNet、EfficientNet、Inception、InceptionResnet、NASNet、VGG19、Xception 提取敦煌壁画图像特征; 使用MD5、SHA2 压缩图像特征, MD5 将高维图像特征向量压缩至128 位的哈希编码(MD5-128), SHA2 将向量压缩至216 位(SHA2-256)和512 位(SHA2-512); 并使用Sim?Hash 算法提取语义标签的文本特征进行图文特征融合与重排序。如图3 所示, MD5 算法与各DCNN算法组合的平均搜索性能显著优于使用SHA2 压缩图像特征的各算法组合, 其中MD5 与EfficientNet组合时模型平均搜索性能最好(mAP =0.6993)。如图4 所示, 随着压缩后图像特征维度的升高, 模型搜索的准确率和召回率均有下降, 最终导致模型平均搜索性能的下降。一方面, 特征编码的维度越高, 稀疏性越强; 另一方面, 在压缩过程中SHA2比MD5 信息丢失更多, 影响特征区分和相似度计算。MD5 具有易计算、抗修改碰撞等特点[55] , 在敦煌壁画图像数据集上表现更好。

模型选用EfficientNet 提取敦煌壁画图像特征,再用MD5 将图像特征压缩为128 位的哈希编码,此时模型在存储空间占用(0.3MB, 如图4 所示)和平均搜索时间(0.56s, 如图5 所示)上均呈现出显著优势。EfficientNet在进行模型缩放时, 同时提升了神经网络的深度、宽度和分辨率, 并通过平衡这3 种缩放以实现更好的效果, 使得模型在保证性能的同时能提取到敦煌壁画图像更深层且复杂的特征, 相比其他DCNN 算法在敦煌壁画图像特征提取上具有更高的精度和效率。

3.3.2模型效果验证

实验二进行模型对比实验: ①与未使用Sim?Hash 提取语义特征的Efficient+MD5模型对比, 突出语义融合效果; ②与仅使用EfficientNet 提取图像特征、不进行哈希压缩、未融合语义特征的相似图像搜索模型对比, 体现特征压缩效果; ③與敦煌壁画移动视觉搜索领域最新的BoW_SIFT(num_word=1000)[31] 模型对比, 验证模型性能提升。如图6 所示, 将EfficientNet 用于图像特征提取后,用MD5算法压缩图像特征, 并融合SimHash 提取的语义标签的文本特征时, 模型搜索性能(mAP =0.6993)显著高于①未使用Simhash 进行语义融合的模型(mAP = 0.2813); ②仅使用EfficientNet 提取图像特征的模型(mAP =0.3576); ③当前最新的BoW_SIFT 模型(mAP = 0.2866)。从模型搭建来看, 使用EfficientNet 深度学习方法提取敦煌壁画图像特征时, 相比于基于BoW_SIFT 机器学习方法的模型的准确率和召回率有明显提升, mAP 值提高0.0710; 但同时在存储空间占用和平均搜索时间上有显著升高, 该问题在引入MD5 算法进行特征压缩后得到解决, 且存储空间占用远低于原BoW_SIFT 模型, 如图7 所示。融合语义特征后,模型搜索时间略微增加, 但对用户搜索体验影响不大; 而此时模型搜索性能较其他组合优势十分显著, mAP 值比仅考虑图像特征时提升0.4180, 说明敦煌壁画图像搜索的语义鸿沟问题得到有效改善。从整体来看, 该模型mAP 值为0.6993、存储空间占用0.3MB、平均搜索时间0.56s, 在搜索性能和空间占用上显著优于BoW_SIFT模型, 本模型在同类模型中的优越性得到验证, 能有效实现敦煌壁画的移动视觉搜索。

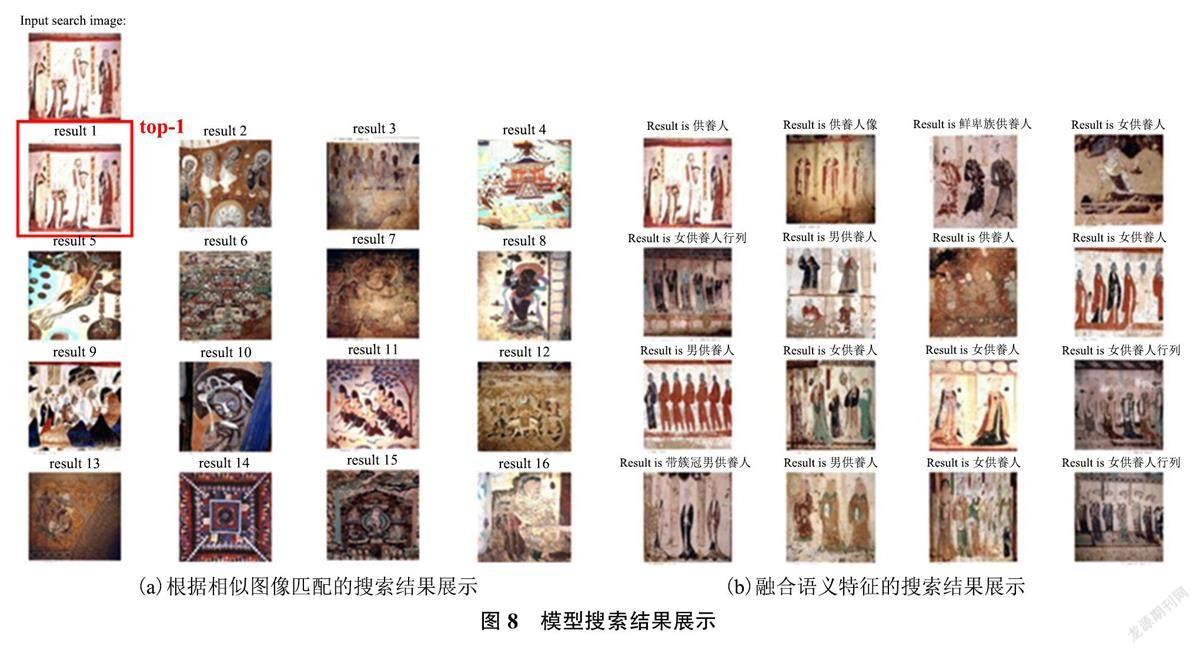

因此, 模型首先使用EfficientNet 提取敦煌壁画图像特征, 然后使用MD5将图像特征压缩为128维的图像特征向量; 同时用SimHash 提取语义标签的文本特征, 表示为128 维的文本特征向量。在输入图像进行搜索时, 根据图像特征的汉明距离进行相似图像匹配, 如图8(a)所示; 提取top-1 返回结果, 拼接图像和文本特征, 再次计算汉明距离,返回最相似的前16 项搜索结果并输出, 如图8(b)所示。

在通过相似图像匹配得到的搜索结果中, 仅能精准匹配最相似图像, 返回的其余图像与目标图像关联不大。如图8(a)所示, 输入待搜索图像, 返回一组在图像底层特征上相似的壁画图像, 除了有体现“供养人” 的top-1 相似图像外, 还有体现“飞天” (result 9)、“菩萨” (result 10)、“藻井”(result 14)等元素的壁画图像。在融合语义特征后, 向模型输入目标图像能同时返回视觉特征相似图像和语义特征相似图像, 并加以语义标签辅助用户对壁画的理解。如图8(b)所示, 输入未知语义的待搜索图像, 模型返回与目标图像视觉上最相似的图像和语义标签“供养人”, 同时返回资源库中表示“供养人” 的其他相似图像, 这些图像具有不同的视觉表现形式, 绘制于不同的朝代, 分布在不同的洞窟。使用该模型进行搜索, 用户不仅能了解到目标图像的相关知识, 还能获取具有相似语义的图像资源, 能辅助有关敦煌壁画相同语义本体的朝代演变研究和关于不同洞窟内具有相同语义的敦煌壁画的差异研究, 对于加深用户对敦煌壁画的理解以及提高用户进一步探索敦煌壁画的兴趣具有重要价值。

4结语

随着文化遗产数字化进程的加快和数字人文研究的不断深入, 图博档中存储的海量文化遗产数字资源亟需高效便捷的获取方式。基于此, 本文构建基于EfficientNet 图像特征提取、MD5 图像特征压缩和SimHash 语义特征融合的敦煌壁画移动视觉搜索模型, 提供移动泛在的敦煌文化遗产数字资源智慧搜索服务, 满足科研人员和普通用户的资源获取需求。用户仅需借助手机、平板、笔记本等移动智能设备即可实现搜索: 使用移动智能设备的摄像头拍摄敦煌壁画实景图片或使用网络上获取的敦煌壁画图片, 于5G网络环境下将图像传输至云服务器, 在后台进行图像特征提取和压缩, 完成特征匹配和相似度计算, 返回相似图像和语义描述, 再将搜索结果传输至用户端, 实现敦煌壁画的移动视觉搜索。

后续研究可以从以下角度进行优化: ①结合用户实验研究对本文提出的模型搜索效果进行进一步检验和分析, 从用户角度优化该模型; ②研究推荐算法与移动视觉搜索的结合, 采集用户历史行为数据, 搭建用户画像, 感知移动环境情景要素, 为用户提供个性化的搜索与推荐一体化服务; ③关联敦煌壁画图像與图博档中存储的文献、古籍、音频、视频、3D 模型等多模态资源, 实现敦煌文化遗产数字资源的跨模态搜索, 为用户提供丰富多元的信息, 深化用户对敦煌文化的感知和理解。