基于Kinect的三维重建技术综述*

艾 达, 倪国斌, 王 苗, 杨 珍

(1.西安邮电大学 公安部电子信息勘验应用技术实验室,陕西 西安 710121;2.西安邮电大学 通信与信息工程学院,陕西 西安 710121)

综述与评论

基于Kinect的三维重建技术综述*

艾 达1, 倪国斌2, 王 苗2, 杨 珍2

(1.西安邮电大学 公安部电子信息勘验应用技术实验室,陕西 西安 710121;2.西安邮电大学 通信与信息工程学院,陕西 西安 710121)

详细介绍了三维重建和Kinect工作原理;对现有利用Kinect进行三维重建的技术方法进行了说明,重点对配准过程中的迭代就近点(ICP)算法的相关改进进行分析和比较;并在上述基础上对Kinect Fusion做了介绍和说明,列举其最新改进和应用;最后对基于Kinect的三维场景重建的发展趋势进行了简单总结和展望。

Kinect; 三维重建; 迭代就近点算法; Kinect Fusion

0 引 言

三维重建是在虚拟环境中处理、分析和操作模型的基础,同时也是虚拟现实的关键技术[1],根据获取的场景信息的不同可将其分为基于纹理和基于深度的三维重建[2],后者又可分为非接触式和接触式,而非接触式技术又有主、被动扫描之分。常见的飞行时间(time of flight,ToF) 相机、手持激光系统、结构光系统和Kinect深度传感器等[3]均使用了非接触式主动扫描技术。Rushmeier H等人[4]将基于深度图像的三维重建过程分为几何处理和面的表示。

Kinect由于其成本低廉拥有广泛的应用潜力而在近两年备受关注,操作简单、携带轻便的特性使其成为理想的深度数据获取设备。因此,基于Kinect的三维场景重建技术应运而生。

1 Kinect概述

与普通的摄像机只能获得一般的彩色图像不同,Kinect可以不受光照条件影响,同时获得被测物体的颜色和深度信息。

一代Kinect搭载PS1080芯片[11],通过光编码技术[12]获取深度信息。由于Kinect 2.0使用了X871141—001 SoC处理器[13],在第一代光编码的基础上,加入了ToF技术[14],通过发射一个强度随时间周期变化的正弦信号,获得发射和接收信号的相位差计算深度信息,在传感器分辨率相同的情况下获得了更高的精度。

在获取深度信息的同时,Kinect的彩色摄像头实时拍摄场景彩色图像。为了方便后续的纹理映射操作[2],两个相机产生的视差经过修正,使得两种目标图像对齐到相同的位置。

2 基于Kinect的三维重建过程

利用Kinect完成三维场景重建的方法有很多种,基本均由三个主要步骤构成[2]:获取点云数据并处理、配准及重建与纹理映射。

2.1 三维点云数据获取与处理

Kinect获得深度图像后将深度数据转化为点云。需要注意的是,后续的三维模型重建精度会因为Kinect获取的大量点云数据,尤其是边缘处的不稳定噪声点,而受到严重影响。为了在去除深度噪声点的同时充分保留边缘信息,还需对获得的数据进行滤波等预处理。中值滤波[15],高斯滤波[16],拉普拉斯滤波[17]和双边滤波[18]等是比较常用的几种处理算法。通过对滤波算法的合理改进可以在降低噪声影响的同时充分保留图像信息,尤其是图像边缘的信息。

2.2 三维点云配准

不同视角下获取的数据经过滤波后,需要将点云配准到一个单一的模型中。配准过程大体分为两大类:粗配准和精细配准[19]。配准的关键是找出正确的旋转和平移向量以表示两组点云数据集的空间变换关系,通过变换使其处于同一坐标系下,使两者的交集区域重叠。粗配准过程通过求出近似配准变换,使两组点云数据尽可能的靠近,以达到缩小差异、为更精细配准提供好的初始位置、增大迭代收敛到最优变换概率的目的;在此基础上,通过逐渐逼近、迭代,可以获得更好的变换参数,实现精细配准。

由于无法获取精确的控制点,粗配准往往很难达到较高的精度。而精配准中的ICP算法是改进的较为成熟、使用最广的精确配准算法。

2.2.1 ICP算法

在20世纪90年代由Besl P J等人[20]提出了ICP算法,利用在来自不同坐标系的两组数据点集中找到的变换关系进行数据匹配。其一般过程可分为以下几个步骤:1)点选择,选择样本寻找两组点云之间的最优转换;2)点匹配,找出目标表面和原数据点的交集,或直接找出最邻近的点。这是ICP算法中最关键的一步;3)点对加权,给匹配程度不同的点对赋予不同的权值以改善质量;4)点对去除,排除噪声或不重叠的区域产生的离群点;5)误差最小化,两个点云数据集合需要通过合适的最小化误差度量表达。

2.2.2 ICP不同阶段上的改进

除上文所述,根据ICP数据处理阶段,其过程还包括重采样、空间查找及距离度量、目标度量函数最小化和算法迭代4个阶段[22]等划分方法。但Nishino K等人[23]提出:几乎所有的改进都着手于配准策略、配准元素和误差度量3个方面。各个阶段的相关改进以及因改进而增加的新阶段如下[24]:

1)控制点选取

在标准的ICP算法中,采用集合中的所有点计算对应点,并没有控制点选取这一阶段[20,25]。算法一经提出,就有学者尝试使用一致采样[26]、随机采样[27]和深度图梯度采样[28]等方法有效提高算法效率;通过边缘点集采样[29]和法向量分布最大化采样[25]显著优化了算法。总之,通过对深度图像的合理采样可以获取更可靠的控制点集或更小的计算数据量。

2)特征度量

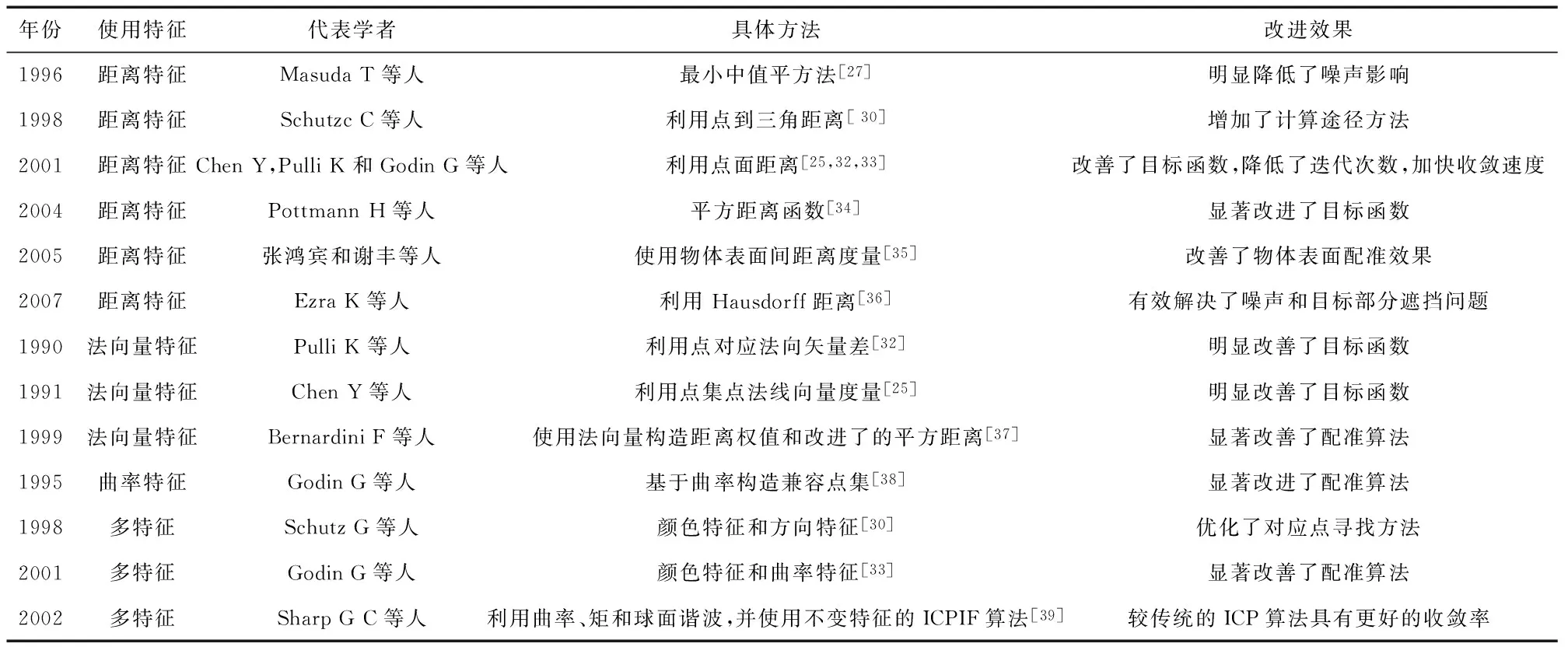

为了找到对应点,首先要确定模型数据点和场景数据点的特征差异,于是引入了特征度量的概念。表1为多种在特征度量方面的代表性改进。此外,在确定特征差异后迭代优化的目标函数仍需利用特征度量建立。

表1 特征度量的代表性改进

3)空间搜索

ICP算法在选取对应点时需要进行大量的搜索,从上世纪末至本世纪初,通过引入多维二元搜索树(K-D Tree)[40]、近似多维二元搜索树(AK-D Tree)[41]和自适应对偶近似搜索树(ADAK-D Tree)[40]等算法,有效处理了非完全对应点集、局部遮挡和自遮挡问题,并自动剔除异常值,逐步提高了配准效率;期间利用反响定标技术和Z-buffer方法和投影搜索[44]明显改善了配准效率;此后Okuda H等人使用分级搜索[45]显著提高了搜索效率,Greenspan M等人提出了球面三角形约束的最近邻域方法[46],显著减少了计算量。

4)点对权重

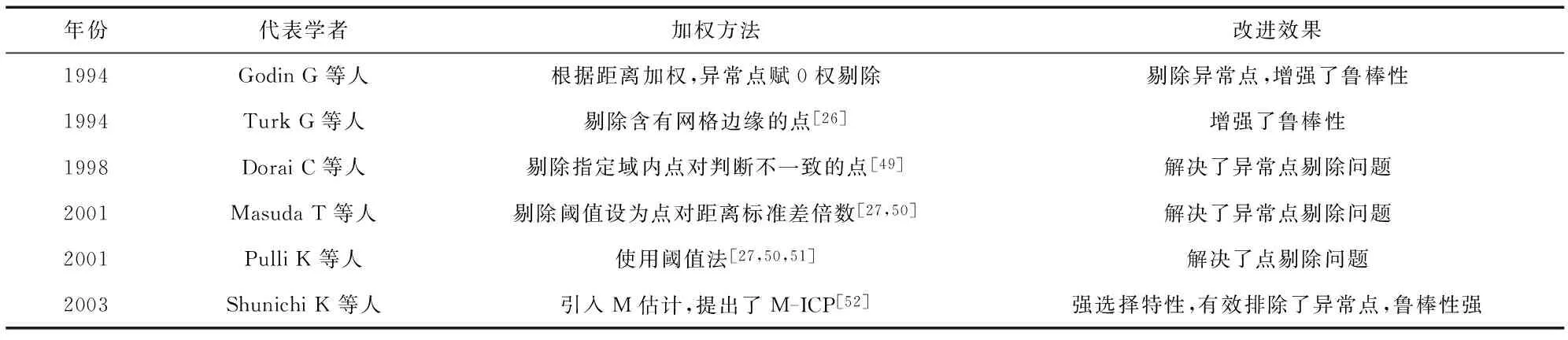

表2列出了几种不同的加权方法。

表2 点对加权的代表性改进

标准ICP算法中对点不做区别,均赋予非零常数权重。通过改进效果可以看出,提高了算法的鲁棒性,并在点选择、异常筛除等方面进一步改善了算法。

5)刚体变换的求解

为ICP算法的最后一个阶段,最小化方法有四元数[53]、正交矩阵[54]、双四元数和奇异值分解等;Eggert D W分析了上述方法的精确和稳定性,并总结了其差异[55 ];此外,选择不同的计算方法以适应不同的目标函数可以获得更好的效果,例如通过点到面距离建立的目标函数即通常采用非线性最小二乘方法求闭合解[25]。

2.3 三维点云重建与纹理映射

相邻帧点云完成配准后,还需要将这些不同视角的点云融合为一个完整的三维模型,使融合后的模型中,不同点云的重叠区域没有重复的数据点。

2.3.1 面元表达下的点云融合

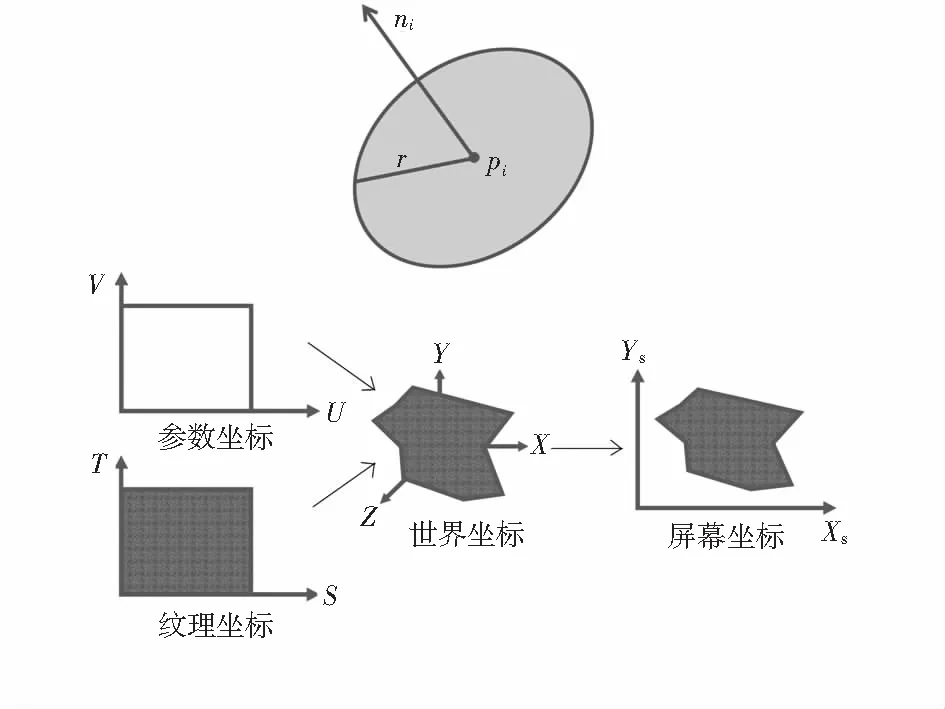

点云融合[56]大致可以分为面元更新、面元增加和面元移除3个主要步骤,面元[57]是局部近似物体表面形状和阴影属性的零维n元组,非常适合于动态几何形状建模,每个面元由位置pi、半径r、法向量ni以及可见置信度vi组成,其中模型曲面Mt用一组面元si,i=1,…,Nt表示[58]。融合时,首先更新扫描输入对应的面元,在所有面元完成更新后,新的面元会增加到还未被模型面元覆盖的扫描深度图中。另外可以根据输入设备的理论精度限制设置合适的面元半径估计,从而实现通过将目标物体靠近摄像头来增加模型细节水平的效果[2]。

2.3.2 纹理映射

即通过纹理模式将其映射到对象表面上是为目标表面添加细节的常用方法。进行纹理映射的基本问题为定义映射函数,即确定指定像素与目标对象上指定点的一一对应关系[2]。利用OpenGL[2]开源库中包含的大量关于纹理操作的API函数,Kinect获取的彩色信息作为纹理输入,映射到三维点云模型中,即可得到可视化的真实三维模型显示,如图1。

图1 模型面元和纹理映射

3 Kinect Fusion

Kinect Fusion能够实现通过Kinect传感器进行现实场景的三维重建,重建后的三维场景数据可以通过.obj及.stl等格式导出。Kinect Fusion在工业设计、3D打印等领域均有较为广阔的发展潜质。相比于传统的三维建模方式,快速便捷、交互友好是Kinect Fusion最大的优势。

3.1 Kinect Fusion概述

与Kinect Fusion类似的建模系统很早就有研究:2010年,华盛顿大学利用基于SIFT特征匹配定位和TORO优化算法[59],设计了一种实时视觉SLAM系统;次年,弗莱堡大学提出了RGBD-SLAM算法,使用Hogman优化算法和SURF特征匹配[60]搭建了实时性高、鲁棒性强的重建系统;结合上述经验,微软在2012年采用高效并行的GPU算法和基于TSDF的点云融合方法[61,62],使系统实时性更高,并增加了点云融合,重建模型冗余点少,质量更好。

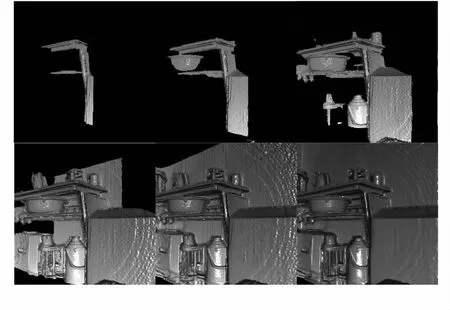

图2为Kinect Fusion的流程效果。Kinect获取的深度图像起初有较多的数据丢失,通过移动传感器扫描物体,很快就能够重建足够平滑和完整的静态场景,同时生成3D模型和点云数据。

图2 Kinect Fusion流程效果

3.2 Kinect Fusion工作原理

Kinect Fusion融合了从多个角度得到的深度图像数据,重建物体的单帧光滑表面模型[63]。

1)深度图像数据转换和预处理:首先将传感器获取的原始深度帧数据转换为浮点数据并优化,然后通过获取传感器的坐标信息,将这些浮点数据转换为与传感器朝向相同的点云数据。

2)传感器追踪通过计算传感器的位置、朝向等姿势信息,再在Kinect移动时不断获取其姿势,计算出当前传感器相对于起始帧时的相对姿势。配准时,Kinect Fusion将从传感器深度影像数据中获取的点云与从重建目标计算得来的点云进行配准,同时配准同一场景不同视场角的数据。

3)体元数据融合:将从已知姿势传感器生成的深度数据逐帧、连续地融合成代表传感器视场内的模型体元,并加入平滑算法来降低噪声的影响,同时一定程度解决了场景内的动态变化问题。原始图像中没有捕捉到的部分则随着Kinect的移动陆续捕捉,重建场景中的空洞也会被相继填充。

4)渲染场景,并根据光线跟踪方法,预测传感器即将接收到的环境数据,重建的同时反馈给步骤(2)进行配准。

通过上述步骤,Kinect Fusion通过其独特的体绘制技术完成了较高质量的模型重建,精度能够达到mm级别。并且与传统的重建方法相比,效率较高,极大地改善了消费级传感器的实时三维场景重建效果,为三维场景重建创造了良好的用户体验,甚至提供了基于重建场景人机交互应用[61,62]的可能。

3.3 Kinect Fusion相关改进及应用

自Kincet Fusion加入软件开发工具包(SDK)中后,不少学者和研究人员都对该快捷便利的建模方式做了进一步的改进以及更深一步的应用。童伟亮[64]等人用Kinect架在不同位置获取到的深度数据和传感器位置、姿势信息进行特征匹配、表面拼接、生成点云信息,完成场景建模;蔡晨贾农[65]等人基于Kinect Fusion 扫描的点云数据,用一种新的点云分割方法将点云数据中的平面结构准确识别、提取并重建;朱笑笑[66]等人使用边线特征进行匹配并预设地面点云提高了Kinect Fusion的鲁棒性并降低了累积误差;Yilmaz O[67]等人同时使用了主动和被动深度传感器以及外围硬件使重建精度进一步改进;Igelbrink T[68]等人提出了一种无需附加滤波过程即可从RGBD图像中生成拓扑结构的三角形网格;Centonze E[69]等人通过对从Kinect获得的数据进行了特征提取进行睡眠障碍分析;Hisahara H[70]等人利用多个Kinect构造了更大范围场景来进行机器人控制方案的安全测试。

4 结 论

首先对目前三维重建的基本概况进行了介绍;其次对现有利用Kinect进行三维重建的技术方法进行了说明,重点对配准过程中的ICP算法的改进进行了分析,对比和总结了不同改进和取得的效果。通过对比发现:基于Kinect的三维重建技术有着比较成熟且效果明显的改进,改进后的重建算法在重建质量、帧率和运行时间等核心参数上有明显提高。基于此,引出Kinect Fusion,为未来基于消费级设备的高精度快速三维重建提出了解决方案。

[1] 曾庆军,黄惟一.虚拟现实中的传感器技术[J].传感器与微系统,1997,16(1):1-4.

[2] 叶日藏.基于Kinect深度传感器的三维重建技术应用研究[D].广州:华南理工大学,2013:1.

[3] 赵建敏,赵忠鑫,李 琦.基于Kinect传感器的羊体体尺测量系统[J].传感器与微系统,2015,34(9):100-103.

[4] Rushmeier H,Bernardini F.The 3D model acquisition pipe-line[J].Comput Graph Forum,2002,21(2):149-172.

[5] Hilton A,Illingworth J.Geometric fusion for a hand-held 3D sensor[J].Machine Vision & Applications,2000,12(1):44-51.

[6] Tubic D,Hebert P,Deschenes J,et al.A uified representation for iteractive 3D modeling[C]∥International Symposium on 3D Data Processing Visualization and Transmission,IEEE Computer Society,2004:175-182.

[7] Koninckx T P,Jaeggll T,Van GooL L.Adaptive scanning for online 3D model acquisition[C]∥Workshop on Real-Time 3D Sensors and Their Use,2004:32.

[8] Huang P,Zhang S.High-resolution,real-time 3D shape acquisition[C]∥2012 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops,IEEE Computer Society,2004:28-28.

[9] Kim Y M,Theobalt C,Diebel J,et al.Multi-view image and tof sensor fusion for dense 3D reconstruction[C]∥2009 IEEE 12th International Conference on Computer Vision Workshops (ICCV Workshops) ,IEEE,2009:1542-1549.

[10] Cui Y.3D shape scanning with a time-of-flight camera[J].Computer Vision and Pattern Recognition(CVPR),2010,23(3):1173-1180.

[11] 范 哲.基于Kinect的三维重建[D].西安:西安电子科技大学,2012:1.

[12] 余 涛.Kinect应用开发实战:用最自然的方式与机器对话[M].北京:机械工业出版社,2012:56-60.

[13] Xbox One Kinect内部芯片拆解详解[EB/OL].[2015—06—16].http:∥jingyan.baidu.com/article/6dad5075c91d68a123e36ee4.html.

[14] 微软自主研发的 Xbox One Kinect 2.0 体感技术跟上代机型所使用 PrimeSense 的方案有何不同?-Kinect-知乎 [EB/OL].[2015—06—17].http:∥www.zhihu.com/question/22058180.

[15] Arce G R.Nonlinear signal processing:A statistical approach[M].Hoboken:John Wiley & Sons,Inc,2005:80-138.

[16] Nixon M S,Aguado A S.Feature extraction and image processing[J].Journal of Medical Ethics,2008,26(1):78.

[17] Ulichney R.Digital halftoning[J].Digital Halftoning,1987(4):12-13.

[18] Tomasi C,Manduchi R.Bilateral filtering for gray and color images[C]∥Sixth International Conference on Computer Vision,Bombay,IEEE Computer Society,1998:839-846.

[19] 肖慧敏.点云数据的配准算法[D].西安:西安电子科技大学,2012:1.

[20] Besl P J,Mckay N D.A method for registration of 3D shapes[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,1992,14(2):239-256.

[21] Rusinkiewicz S,Levoy M.Efficient variants of the ICP algori-thm[C]∥Proceedings of Third International Conference on 3D Digital Imaging and Modeling,Quebec,IEEE,2001:145-152.

[22] 伍 毅.三维扫描信息获取的深度图像配准算法设计及开发[D].杭州:浙江大学,2005:1.

[23] Nishino K,Ikeuchi K.Robust simultaneous registration of multiple range images comprising a large number of points[J].Electronics & Communications in Japan,2001(8):61-74.

[24] 李世飞,王 平,沈振康.迭代最近点算法研究进展[J].信号处理,2009,25(10):1582-1588.

[25] Chen Y,Medioni G.Object modeling by registration of multiple range images[C]∥Proceedings of IEEE International Conference on Robotics and Automation,IEEE,1991:2724-2729.

[26] Turk G,Levoy M.Zippered polygon meshes from range images[C]∥Proceedings of Annual Conference on Computer Graphics & Interactive Techniques,Siggraph’94,1994.

[27] Masuda T,Sakaue K,Yokoya N.Registration and integration of multiple range images for 3D model construction[C]∥Procee-dings of 13th International Conference on Pattern Recognition,1996:879-883.

[28] Weik S.Registration of 3D partial surface models using luminance and depth information[C]∥1997.Proceedings of International Conference on Recent Advances in 3D Digital Imaging and Modeling,IEEE,1997:93-100.

[29] Angel Domingo S,Restrepo-Specht A,Devy M.Range image registration by using an edge-based representation[C]∥Proceedings of the 9th International Symposium on Intelligent Robotic Systems,SIRS’01,2001.

[30] Schutz C.Geometric point matching of free-form 3D objects[D].Neuchatel,Switzerland; University of Neuchatel,1998:1.

[31] Jost T.Fast geometric matching for shape registration[D].Neuchatel,Switzerland:University of Neuchatel,2002:1.

[32] Pulli K.Multiview registration for large data sets [C]∥The Second International Conference on 3D Digital Imaging and Modeling ,Ontario,IEEE,1999:160-168.

[33] Godin G,Laurendeau D,Bergevin R.A method for the registration of attributed range images[C]∥Int’l Conf on Imaging & Mode-ling,Quebec,2001:179.

[34] Pottmann H,Leopoldseder S,Hofer M.Registration without ICP[J].Computer Vision and Image Understanding.2004,95(1):54-71.

[35] 张鸿宾,谢 丰.基于表面间距离度量的多视点距离图像的对准算法[J].中国科学,2005,35(2):150-160.

[36] Ezra E,Sharir M,Efrat A.On the Performance of the ICP Algorithm[J].Computational Geometry,2008,41(1-2):77-93.

[37] Bernardini F,Mittleman J,Rushmeier H,et al.The ball-pivoting algorithm for surface reconstruction[J].IEEE Transactions on Visualization & Computer Graphics,1999,5(4):349-359.

[38] Godin G.Range image registration through invariant computation of curvature[C]∥Proc of ISPRS Workshop from Pixels to Sequences,Zurich,1995:170-175.

[39] Sharp G C,Lee S W,Wehe D K.ICP registration using invariant features[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2002,24(1):90-102.

[40] Zhang Z.Iterative point matching for registration of free-form curves and surfaces[J].International Journal of Computer Vision,1994,13(2):119-152.

[41] Greenspan M,Yurick M.Approximate k-d tree search for efficient ICP[C]∥(3DIM) Proceedings of Fourth International Confe-rence on 3D Digital Imaging and Modeling,IEEE,2003:442.

[42] Lee J D,Hsieh S S,Huang C H,et al.An Adaptive ICP Registration for Facial Point Data[C]∥(ICPR)18th International Conference on Pattern Recognition,IEEE,2006:703-706.

[43] Neugebauer P J.Geometrical cloning of 3D objects via simulta-neous registration of multiple range images[C]∥1997 International Conference on Shape Modeling and Applications.IEEE,1997:130-139.

[44] Benjemaa R,Schmitt F.Fast global registration of 3D sampled surfaces using a multi-z-buffer technique[C]∥Proceedings of International Conference on Recent Advances in 3D Digital Imaging and Modeling,1997:113-120.

[45] Okuda H.Fast 3D registration algorithm with hierarchical and region selection approach of M-ICP[J].Journal of Robotics & Mechatronics,2006,18:765-771.

[46] Salvi J,Matabosch C,Fofi D,et al.A review of recent range image registration methods with accuracy evaluation[J].Image & Vision Computing,2007,25(5):578-596.

[47] Greenspan M,Godin G.A nearest neighbor method for efficient ICP[C]∥Proceedings Third International Conference on 3D Digital Imaging and Modeling,Quebec ,IEEE Computer Society,2001:161-168.

[48] Godin G ,Rioux ’VI ,Baribeau R.Three-dimensional registration range and intensity information[C]∥Proc of SPIE 2350,Boston ,SPIE.1994:279-290.

[49] Dorai C,Wang G,Jain A K,et al.Registration and integration of multiple object views for 3D model construction[J].IEEE Tran-sactions on Pattern Analysis & Machine Intelligence,1998,20(1):83-89.

[50] Rusinkiewicz S,Levoy M.Efficient variants of the icp algorithm[C]∥The Third International Conference on 3D Digital Imaging and Modeling,IEEE,2001:145-152.

[51] Pulli K.Multiview registration for large data sets[C]∥Procee-dings of Second International Conference on 3D Digital Imaging and Modeling,IEEE,1999:160-168.

[52] Shunichi K,Tomonori K,Atsushi M.Robust matching of 3D contours using iterative closest point algorithm improved by M-estimation[J].Pattern Recognition,2003,36(9):2041-2047.

[53] Horn B K P.Closed-form solution of absolute orientation using unit quaternions[J].Journal of the Optical Society of America A,1987,4(4):629-642.

[54] Horn B,Hilden H M,Negahdaripour S.Closed-form solution of absolute orientation using orthonormal matrices[J].Journal of the Optical Society of America A,1988,5(7):1127-1135.

[55] Eggert D W,Lorusso A,Fisher R B.Estimating 3-D rigid body transformations:A comparison of four major algorithms[J].Machine Vision & Applications,1997,9(5-6):272-290.

[56] Weise T,Wismer T,Leibe B,et al.Online loop closure for real-time interactive 3D scanning[J].Computer Vision & Image Understanding,2011,115(5):635-648.

[57] Pfister H,Zwicker M,Van Baar J,et al.Surfels:Surface elements as rendering primitives[C]∥Proceedings of the 27th Annual Conference on Computer Graphics and Interactive Techniques,ACM,2000:335-342.

[58] Habbecke M,Kobbelt L.A surface-growing approach to multi-view stereo reconstruction[C]∥2007 IEEE Conference on Computer Vision and Pattern Recognition,2007:1-8.

[59] Henry P,Krainin M,Herbst E,et al.RGB-D mapping:Using depth cameras for dense 3D modeling of indoor environments[J].International Journal of Robotics Research,2012,31(5):647-663.

[60] Fioraio N,Konolige K.Realtime visual and point cloud SLAM[C]∥RSS Workshop on RGB-D Cameras,2011.

[61] Izadi S,Kim D,Hilliges O,et al.Kinect Fusion:Real-time 3D reconstruction and interaction using a moving depth camera[C]∥Proceedings of the 24th Annual ACM Symposium on User Interface Software and Technology,ACM,2011:559-568.

[62] Fitzgibbon A.Kinect Fusion:Real-time dense surface mapping and tracking[C]∥Proceedings of the 2011 10th IEEE International Symposium on Mixed and Augmented Reality,IEEE Computer Society,2011:127-136.

[63] Kinect Fusion[EB/OL].[2016—03—07].https:∥msdn.microsoft.com/en-us/library/dn188670.aspx.

[64] 童伟亮,王广伟.基于Kinect及双目机器视觉原理的物体3维建模系统[J].中国水运月刊,2015,15(8):121-122.

[65] 蔡晨贾农,施逸飞,徐 凯,等.基于KinectFusion的室内场景平面结构重建[J].系统仿真学报,2015(10):2239-2245.

[66] 朱笑笑,曹其新,杨 扬,等.一种改进的KinectFusion三维重构算法[J].机器人,2014,36(2):129-136.

[67] Yilmaz O,Karakus F.Stereo and kinect fusion for continuous 3D reconstruction and visual odometry[C]∥2013 International Conference on Electronics,Computer and Computation(ICECCO),Ankara,IEEE,2013:115-118.

[68] Igelbrink T,Wiemann T,Hertzberg J.Generating topologically consistent triangle meshes from large scale kinect fusion[C]∥2015 European Conference on Mobile Robots(ECMR),Lincoln,IEEE,2015:1-6.

[69] Centonze F,Schatz M,Prochazka A,et al.Feature extraction using MS Kinect and data fusion in analysis of sleep disorders[C]∥2015 International Workshop on Computational Intelligence for Multimedia Understanding(IWCIM),Prague,IEEE,2015:1-5.

[70] Hisahara,S HaneH,Takemura,et al.3D point cloud-based virtual environment for safe testing of robot control programs:Measurement range expansion through linking of multiple kinect v2 sensors[C]∥2015 6th International Conference on Intelligent Systems,Modelling and Simulation(ISMS),IEEE,2015:24-27.

Review of 3D reconstruction technology based on Kinect*

AI Da1, NI Guo-bin2, WANG Miao2, YANG Zhen2

(1.Key Laboratory of Ministry of Public Security-Electronic Information Processing Techniques in Criminal Investigation Applications,Xi’an University of Posts and Telecommunications,Xi’an 710121,China;2.School of Telecommunication and Information Engineering,Xi’an University of Posts and Telecommunications,Xi’an 710121,China)

3D reconstruction technology and working principle of Kinect are introduced in detail,existing 3D reconstruction methods using Kinect are reviewed,iterative closest point(ICP) and its improvements are analyzed and compared.On this basis,the Kinect Fusion and its improvement and applications are introduced.Prospects of development trend of 3D reconstruction based on Kinect are summarized and prospected in brief.

Kinect;3D reconstruction; iterative closest point(ICP) algorithm; Kinect Fusion

10.13873/J.1000—9787(2017)08—0001—06

2016—05—05

公安部科技强警基础工作专项项目(2014GABJC023)

TP 391

A

1000—9787(2017)08—0001—06

艾 达(1973-),男,博士,副教授,高级工程师,硕士生导师,研究方向为视频、图像处理,人工智能技术、虚拟现实技术。