基于小麦群体图像的田间麦穗计数及产量预测方法

李毅念,杜世伟,姚 敏,易应武,杨建峰,丁启朔,何瑞银

基于小麦群体图像的田间麦穗计数及产量预测方法

李毅念,杜世伟,姚 敏,易应武,杨建峰,丁启朔,何瑞银

(南京农业大学工学院,南京 210031)

在田间小麦测产时,需人工获取田间单位面积内的麦穗数和穗粒数,耗时耗力。为了快速测量小麦田间单位面积内的产量,该文利用特定装置以田间麦穗倾斜的方式获取田间麦穗群体图像,通过转换图像颜色空间RGB→HSI,提取饱和度S分量图像,然后把饱和度S分量图像转换成二值图像,再经细窄部位粘连去除算法进行初步分割,再由边界和区域的特征参数判断出粘连的麦穗图像,并利用基于凹点检测匹配连线的方法实现粘连麦穗的分割,进而识别出图像中的麦穗数量;通过计算图像中每个麦穗的面积像素点数并由预测公式得到每个麦穗的籽粒数,进而计算出每幅图像上所有麦穗的预测籽粒数,然后计算出0.25 m2区域内对应的4幅图像上的预测籽粒数;同时根据籽粒千粒质量数据,计算得到该区域内的产量信息。该文在识别3个品种田间麦穗单幅图像中麦穗数量的平均识别精度为91.63%,籽粒数的平均预测精度为90.73%;对3个品种0.25 m2区域的小麦麦穗数量、总籽粒数及产量预测的平均精度为93.83%、93.43%、93.49%。运用该文方法可以实现小麦田间单位面积内的产量信息自动测量。

农作物;算法;图像分割;小麦;麦穗群体图像;单位面积麦穗数;籽粒数;产量预测

0 引 言

为保证国家粮食安全、制定合理的粮食价格及宏观调控政策,需要及时、准确地预测、估算农作物的预期产量[1]。在田间小麦测产过程中,现有估产方法首先要获得单位面积内的麦穗数和穗粒数信息,然后根据籽粒的千粒质量计算得到小麦的产量[2]。然而目前单位面积内的麦穗数和穗粒数信息的获取往往通过人工计数来完成,耗时耗力。

近年来,随着图像处理技术在农业领域各方面研究的不断深入和发展,涌现出了许多基于图像处理技术来改善传统农业操作方法的报道。在水稻测产方面,龚红菊[3]利用自制计算机视觉系统,拍摄成熟期水稻群体图像,应用分形理论分析水稻群体图像的分形特征,最后建立水稻单位面积产量模型,模型精度为92.57%。Reza等[4]基于图像处理方法利用所搭建的无人机平台获取田间水稻的秧苗图像,通过图像算法对图像中的水稻植株进行计数,其识别精度在89%到93%之间。

目前对于小麦田间产量预测,主要是基于机器视觉的方法用于群体特性研究。Cointault等[5]设计了田间自动行走机器人来获取小麦单位面积内图像,然后通过提取图像颜色和纹理特征的方法仅仅识别出小麦穗数量信息。Zhu等[6]为了实时获取抽穗期田间小麦生长信息情况利用田间监控摄像头获取图像识别出指定范围内的麦穗数量。Fernandez-Gallego等[7]基于图像处理技术,通过滤波和寻找最大值的方法来检测计数所采集田间麦穗图像中的麦穗数,其算法识别精度达到了90%,并未对田间小麦的产量信息做进一步研究。Li等[8]提出利用麦穗植株图像中穗头的颜色和纹理等特征参数并结合神经网络来检测小麦穗头,其检测正确率在80%左右,但是该研究是在基于实验室环境下所培养的盆栽小麦上进行的,并未应用到实际田间测产中。杜世伟等[9]利用抛物线分割单株小麦穗部各小穗的方法获取穗部小穗数及籽粒数,其精度分别为97.01%、94.38%,只是对单株麦穗穗部信息做了深入研究,并未涉及田间麦穗群体图像的产量预测。刘涛等[10]提出了一种利用图像分析技术实现田间麦穗快速计数的方法,通过对撒播和条播各35幅样本图像进行计数试验,准确率分别为95.77%和96.89%;范梦扬等[11]在已有研究的基础上采用支持向量机学习的方法,精确提取小麦麦穗轮廓,同时构建麦穗特征数据库,来对麦穗进行计数,平均识别精度高于93%,均未对田间单位平方米内的小麦籽粒及产量信息进行研究。

综上可知,对于小麦田间测产研究方面,只是通过图像分析的方法对单位面积内麦穗进行计数,鲜有通过田间小麦群体图像直接获取小麦单位面积内籽粒及产量信息的相关研究报道。因此,本文基于图像处理技术,以田间小麦群体图像为研究对象,利用凹点检测匹配分割算法及提取穗头面积像素数的方法,对图像中的麦穗数和籽粒数进行识别预测,根据籽粒千粒质量计算得到田间小麦单位面积内的产量信息,以期实现田间小麦单位面积内产量的自动测量。

1 材料与方法

1.1 图像采集

田间图像拍摄地点为南京市浦口区江浦农场大田正常条播小麦地块,图像采集时间为2017年5月22日— 5月29日15:00到傍晚时段,品种分别为“苏科麦1号”、“苏麦188号”、“扬麦22号”,所取图像样本数量分别为64、60、60幅。图像采集时,如图1a所示,将1个正四棱台壳体(上底面边长为0.5 m,下底面边长为1 m)的上下2个正方形底面去除,倒扣在田间麦穗上(为增加装置稳定性,分别在倒扣的正四棱台壳体上底面4个角下方固定4个支腿,支腿高度为0.5 m);然后正四棱台中间用1个正四棱锥壳体(底面边长为0.5 m,棱锥高为0.5 m)从麦穗上方垂直放下,其作用是将0.5 m×0.5 m区域内的麦穗分到正四棱台的4个方向的4个内侧面上;然后在正四棱锥壳体底面中央安装旋转底座,旋转底座上安装固定支架,用来固定相机;最后用照相机镜头以固定距离(本文以能够看到所拍摄内侧面上所有的麦穗时的距离=0.6 m)垂直于4个内侧面分别采集图像,相机型号为Canon EOS 80D,图像分辨率为6 000×3 368像素,图像格式为JPG。相机拍摄视场大小为0.75 m×0.42 m,图像背景颜色为白色。试验中采集到的图像如图1b所示。

1. 相机 2. 固定支架 3. 正四棱锥壳体 4. 正四棱台下底 5. 正四棱台内侧面 6. 旋转底座 7. 正四棱台上底

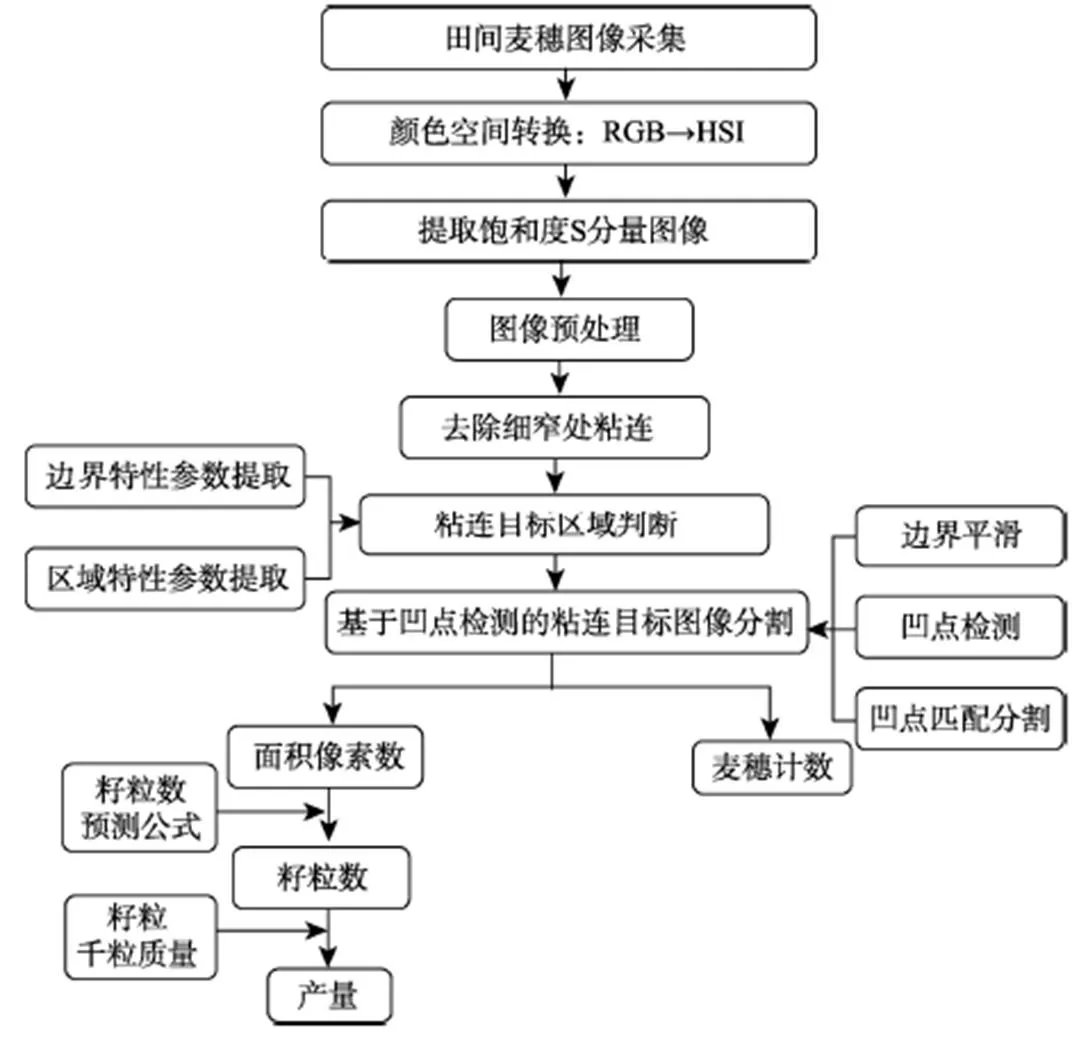

1.2 图像处理算法流程

麦穗图像采集后,首先经过图像颜色空间转换提取饱和度分量图像,然后进一步通过图像预处理、去除细窄处粘连、凹点检测匹配分割等算法处理,实现图像中麦穗分割计数,以及籽粒数、产量预测。算法流程图如图2所示。

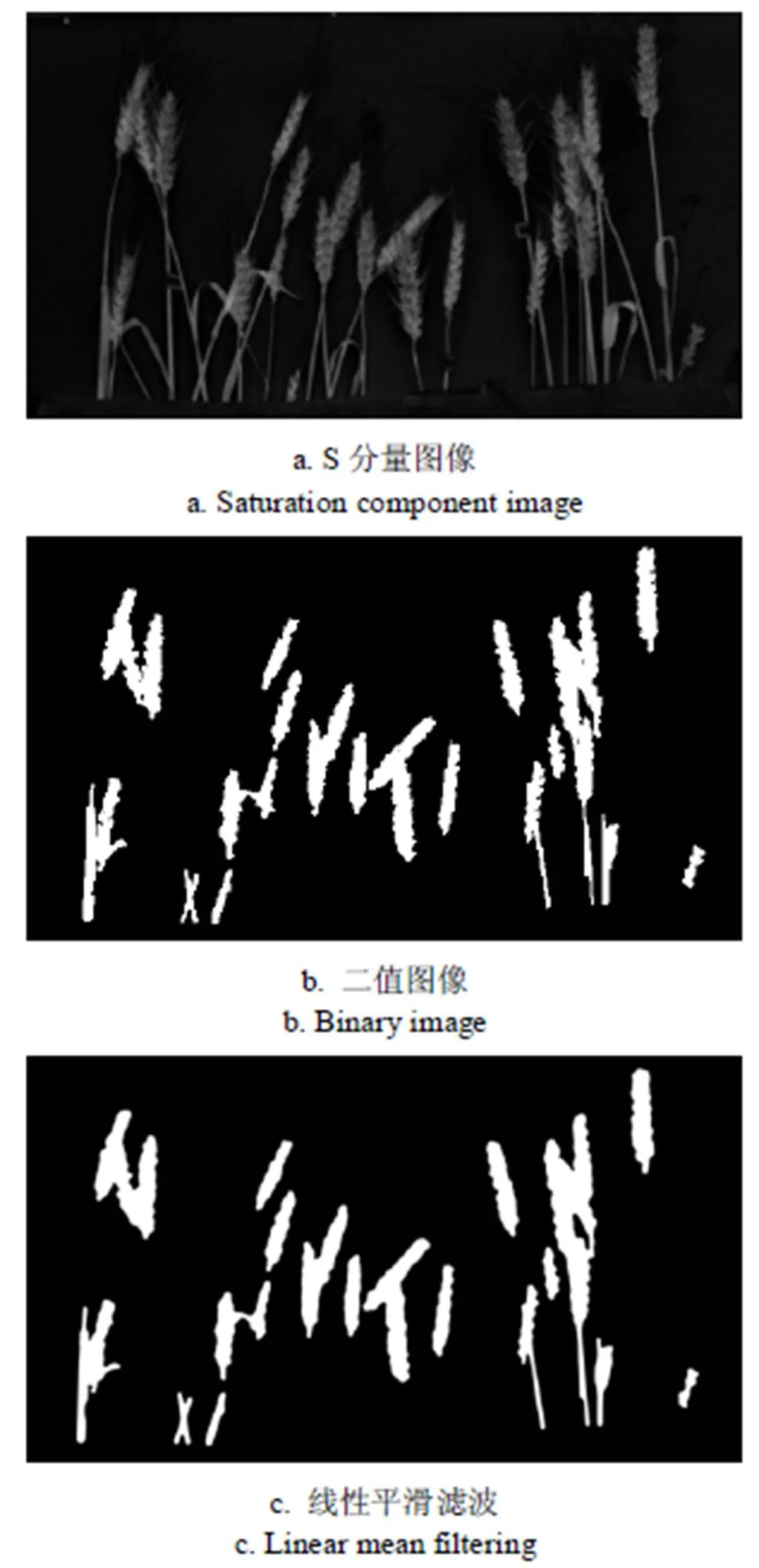

1.3 图像预处理

为了降低原图像受外界亮度不均的干扰[12],本文首先将采集的图像由RGB颜色空间向HSI颜色空间转换;然后提取S分量(即饱和度分量)图像,如图3a所示。再对S分量图像进行二值化、形态学开运算、去除小面积得到二值图像,如图3b所示。再对二值图像进行线性平滑滤波[13-14],如图3c所示。

图2 田间麦穗图像处理算法流程图

图3 小麦群体图像预处理

1.4 去除细窄处粘连

为便于麦穗分割,需去除图3c中各连通域内细窄粘连部位,具体实施思路如下:

1)首先,对图3c二值图像进行连通区域标记,并依次读取每个连通域。为减小运算量,提高计算效率,需对每个连通域按最小矩形剪切,如图4a所示。

2)获取目标区域边界(包含外边界和内边界)坐标。为了简化后续算法计算量,在不影响计算精度的情况下,本文将各边界坐标长度简化缩短5倍,即从第1个坐标点开始每隔4个点取1个坐标值,得到的目标区域边界图像如图4b所示。

3)所有边界各点坐标依次求相互距离。通过设定阈值1(根据细窄粘连部位一般宽度设定,1=45),筛选出距离小于阈值1的点对的坐标。其中,各点求相互距离利用的欧几里得距离公式如下[15]

式中1与2分别为边界上2点的横坐标;1与2分别为边界上2点的纵坐标。

4)判断符合距离条件的点对是否在同1个边界上,若否,则这2个点直接相连并使2点连线之间的坐标位置处置0,实现连线分割;若是,则进一步判断该点对在该边界上的序数距离是否大于1个指定阈值2(根据小麦穗头端部宽度确定,2=55):如果大于2,则2个点直接相连并使2点连线之间的坐标位置处置0,实现连线分割;如果小于2,则这个点对不是所需要连线分割的点对,应舍去。经过距离判断后筛选出的需要连线分割的点对坐标分布如图4c所示。

5)经过上述过程可实现同1个连通域内目标图像的细窄部位连线分割,然后再通过去除小面积等算法得到初步分割图,如图4d所示。最后依次对每个连通域进行上述算法流程处理。

1.5 粘连麦穗识别判断

1.5.1 边界特性参数提取

1)边界长度,即区域轮廓的周长[16]。本文选择4连通域情况下,首先获得单个连通域外边界,然后统计轮廓边界上像素点的个数,记作。

2)边界点角度,即轮廓边界上各点分别与其前后绩点所组成向量之间的夹角。前绩点和后绩点分别表示边界上一点沿边界向前或向后取一定距离像素点处的点[17]。

1.5.2 区域特性参数提取

1)区域面积,即边界所包围的区域轮廓的大小[18]。本文计算区域面积就是对属于区域的像素进行计数,记作1。

2)形状因子,即区域周长的平方与面积1的比:1=2/1。形状因子在一定程度上描述了区域的紧凑型,有时也称为致密度或分散度[18]。

3)凸闭包面积占空比,即指1个连通域内的面积1与该连通域凸壳面积0的比值,即:=1/0。凸壳定义为对于任何1个子集(如1个连通域),有1个最小的包含的凸集,即所有包含的凸集的交集,称其为的凸壳[19]。连通域的凹域定义为连通域的凸壳减去该连通域剩下的部分,其面积为:2=0–1。

图4 去除细窄处粘连

1.5.3 多特征参数综合识别

由图5a可见,由于麦穗与麦穗粘连的形态多种多样,所以只通过连通域的1个特征参数无法较准确地判断该连通域是否粘连。因此,本文通过提取多个特征参数来综合判断图像中每个连通域内的组成情况。对于麦穗的边界,由图5a可以观察到,其边界一般比较粗糙曲折,边界点的角度就复杂多样,但是其角度值一般要小,而对于连通域内的茎杆部分,其边界比较光滑笔直,边界点的角度也比较均匀集中,值主要分布在170°~180°之间。所以对于茎秆来说,其边界点的角度值在170°~180°之间的点数量占边界点总数的比率170º–180º要大于麦穗的边界情况,本文根据每个品种小麦穗图像中茎秆和穗的实际统计情况确定选择170º–180º=0.35。对同1个品种相同处理条件下的小麦图像中的各连通域,若是单个穗,其边界长度要比粘连的情况小(本文通过统计比较单个穗和粘连穗的边界长度选择0=2 000);同理,粘连穗的面积像素数要比单个穗的大(本文通过统计比较单个穗和粘连穗的面积像素数选择0=70 000)。粘连穗形状比单个穗要复杂,所以,粘连穗形状因子要高于单个穗(本文通过统计比较单个穗和粘连穗的形状因子,选择0=40)。单个穗的凸闭包更接近麦穗的形状,而粘连穗由于多个麦穗连接会增大凹域的面积,从而降低凸闭包面积占空比的值,使其低于单个麦穗的凸闭包面积占空比的值。本文通过统计比较单个穗和粘连穗的凸闭包面积占空比的值,选择0=0.75。经过阈值法对各连通域进行识别判断,得到分类结果图像见图5b~图5d。

图5 识别分类后图像

1.6 凹点检测匹配分割

基于凹点检测的方法主要利用粘连目标边界轮廓上的特征信息来寻找目标边界上合适的凹点作为分割点,然后根据某种配对规则对分割点进行配对,最后连接分割点即可将粘连在一起的目标物体分离成单个不粘连的目标物体[20-22]。当有2个及以上的目标个体相互粘连在一起时,在粘连处会形成凹形区域(称作凹域),凹曲程度最大的点则为要寻找的待分割点[23]。

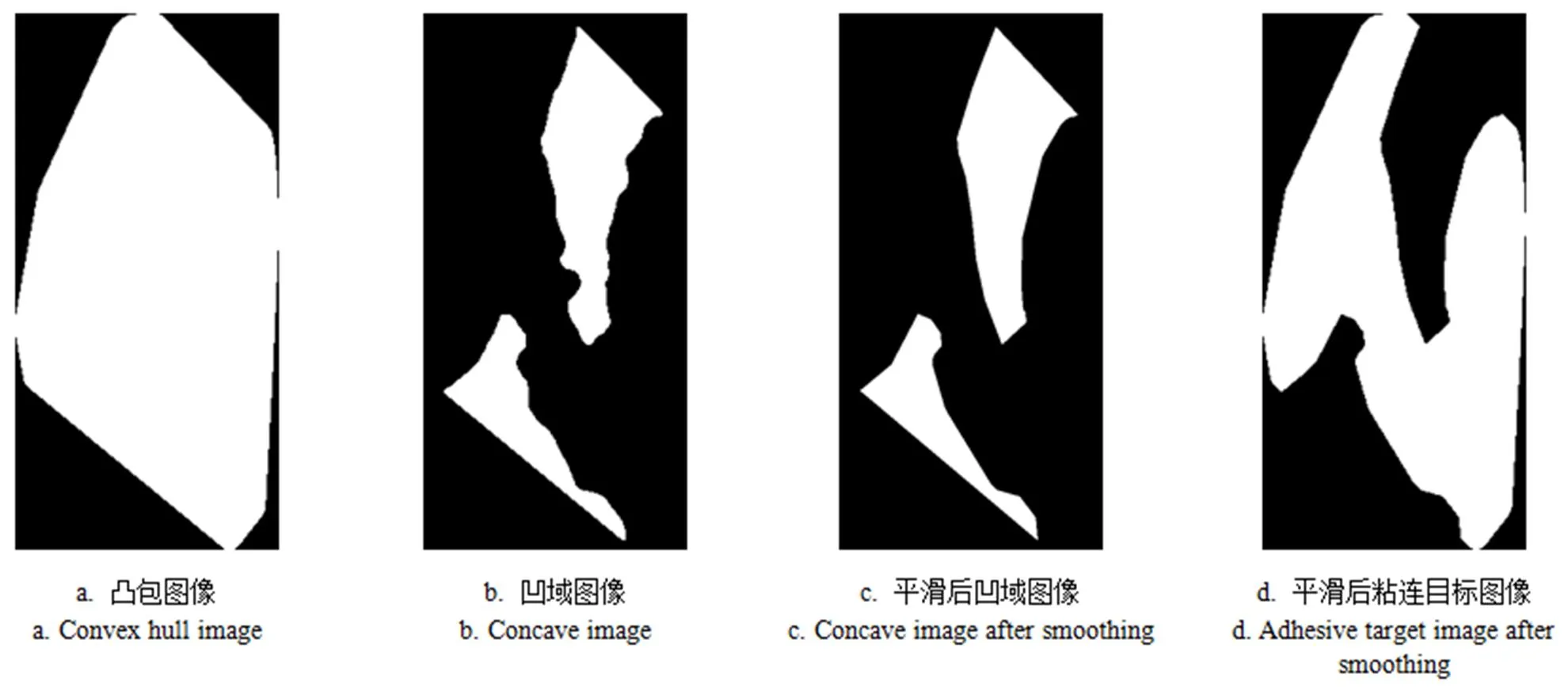

1.6.1 粘连麦穗图像边缘平滑

由于得到的目标图像中粘连麦穗轮廓边界存在微小的凹凸不规则处,会对选择准确的凹点产生干扰,所以,在凹点提取之前要对粘连麦穗图像边缘进行平滑。本文借鉴文献[22]中求目标区域凹域的方法,采用多次平滑目标图像的凹域,然后利用凸包图像减去平滑后的凹域图像,得到平滑后的粘连目标图像见图6。

1.6.2 凹点提取

本文在凹点提取时先利用夹角法初选出部分待选凹点,再利用面积法确定出最终的合适凹点,综合2种方法的优势,使凹点提取过程准确快速。具体算法过程如下:

图6 粘连麦穗图像边缘平滑

2)由图7c可知,已经初选出来的部分凹点中仍然存在少数多余的凹点,故本文又采用面积法来筛选出最佳的凹点。如图7d所示,对已经初选出的凹点,在其位置处作指定半径的圆,该圆被目标轮廓边界划分为两部分,一部分在边界内部而另一部分在边界外部。通过统计每个待选凹点处落在边界内部的部分圆的像素数,然后设定阈值,来优选出最终所需要的凹点。面积法的优点是凹点处凹角越小,落在边界内部的圆的面积越大,反之,凹点处凹角越大,面积越小。筛选出的凹点如图7e所示,图中仍然存在多余的凹点,可以通过设定距离阈值剔除,最终筛选出的凹点如图7f所示。

3)上述凹点提取的过程主要针对的是粘连目标只有外边界的情况,但在实际图像处理试验过程中,还存在极少数的粘连目标图像具有内边界的情况。这就需要首先判断粘连目标图像是否存在内边界,如果不存在内边界,则按照上述过程只对外边界提取凹点处理;如果存在内边界,则采用对外边界提取凹点,而内边界提取凸点的方法进行处理。

注:图7a.中V表示凹点处向量积的方向垂直纸面向里,表示凸点处向量积的方向垂直纸面向外。

1.6.3 凹点匹配分割

目前,凹点匹配的方法主要是以距离最近原则进行匹配。针对不同的识别目标,距离最近原则方法分离的正确率有所差异,这种原则对形状比较规则的目标分割的正确率要高一些,比如圆形的细胞[24]或矿石颗粒[25]等,而对于比较复杂的粘连麦穗图像单纯的利用这种方法往往会出现错误的分割结果。为此,本文通过观察不同的粘连麦穗图像的凹点分布特点,提出6条凹点匹配原则:

1)2个待匹配的凹点连线均应该在目标图像内部,不应该穿过目标边界外部的黑色背景区域。

2)2个待匹配的凹点连线应该穿过目标图像的中轴线(即骨架线),如图8a所示,也就是两凹点连线肯定要和目标区域的中轴线存在交点。

3)优先选择符合反向角区域双向选择的凹点。1个待匹配的凹点和其位置处边界前后距点所组成的夹角的反向角区域内的凹点优先选择,如果反向角区域内存在多个符合要求的凹点,则再判断待匹配凹点是否也在这些凹点处的反向角区域内,如果是,则优先选择,即优先选择符合双向选择的两凹点。如图8b所示,凹点在凹点处前后距点的反向角区域内,故凹点、匹配;而、两凹点符合反向角区域双向选择,故凹点、匹配。

4)距离最近原则。如果满足以上条件的凹点处仍然存在多个凹点等待选择,那么再考虑距离最近原则,优先选择距离较近的凹点组成凹点对。

图8 凹点匹配分割

5)凹点对连线应该避免交叉。当存在多条分割线时,应该在选出1个凹点对时,再判断该凹点对连线是否和前面已经选出的凹点对连线是否存在交点,若不存在交点,则确定使用该凹点对;反之,若存在交点,则舍弃该凹点对,选择另外的符合上述原则的凹点进行匹配。

6)当存在内边界时,优先选择内边界上的凸点按照以上原则和外边界上的凹点相匹配。

根据以上原则可筛选出需要匹配的凹点对,然后对凹点对进行连线分割。本文粘连麦穗图像凹点连线分割的效果图见图8c。各粘连麦穗图像分割完毕后,再与原本未粘连的单个麦穗图像叠加,即可得到分割后的麦穗图像见图8d。

1.7 产量计算方法

1.7.1 麦穗计数

本文将每幅图像识别测量的麦穗数作为预测值,实际人工计数得到的麦穗数作为实测值。通过比较每幅图像上麦穗数预测值和实测值之间的相对误差和绝对误差来评价本文算法识别的精度及可靠性;同时对0.25 m2内对应的4幅图像麦穗数预测值进行累加求和,得到0.25 m2内总麦穗数预测值,并与总麦穗数实测值作误差分析。

1.7.2 籽粒计数

采集图像时,事先在正四棱台每个内侧面上任意选择3株麦穗,然后在其茎秆位置上做好标记,并记录每幅图像上所标记的3株麦穗的实测籽粒数;再通过图像识别过程获得该3株麦穗的面积像素数,最后建立起每个麦穗籽粒数与其面积像素数之间的线性相关关系,进而得到每个品种籽粒数的预测公式。利用该预测公式可以对每幅图像上所识别出的每个麦穗进行籽粒数预测,然后将每个麦穗的预测结果记录下来并进行求和得到该幅图像上的预测总籽粒数。本文将每幅图像上的麦穗在采集时用剪刀剪下穗头进行烘干脱粒,然后通过人工计数获取每幅图像区域上的实测总籽粒数。同样,通过比较每幅图像的籽粒数预测值和实测值之间的相对误差和绝对误差来评价本文算法识别的精度及可靠性;同时对0.25 m2内对应的4幅图像中总籽粒数预测值与实测值作误差分析。

1.7.3 千粒质量测定

千粒质量是以克表示的1 000粒种子的质量,它是体现种子大小与饱满程度的一项指标。千粒质量也是作物产量构成因素之一,是在作物测产时必须要使用的。本文对每个品种的麦穗籽粒随机数出1 000粒,在电子天平(型号:FA2204B,Max=220 g,检定标尺分度值为10 d,试剂标尺分度值为0.1 mg)上进行称质量,并记录数据,然后重复5次,取5次千粒质量的平均值作为对应品种的千粒质量。

1.7.4 产量计算

在计算产量时,首先将0.25 m2内对应的4幅图像籽粒数识别预测值相加,然后乘以对应品种的千粒质量并除以1 000,得到该品种在0.25 m2内的产量,作为产量预测值;将同区域内的麦穗脱粒后进行称质量,得到该区域的产量实测值,最后通过比较每个区域内的产量预测值和实测值之间的相对误差和绝对误差来评价本文算法的识别精度与可靠性。

1.8 试验数据处理方法

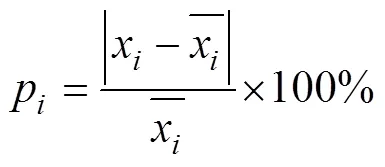

使用式(2)计算单个样本图像中所提取参数算法预测值和人工实测值的相对误差,使用式(3)计算每个品种总体样本图像的平均绝对误差,使用式(4)计算每个品种总体样本图像的平均相对误差。

2 结果与分析

2.1 麦穗计数结果分析

注:AE为平均绝对误差,RE为平均相对误差,%。

为了比较本文凹点检测分割算法对图像中粘连麦穗分割前后麦穗数识别精度的影响,本文分别对粘连麦穗分割前图像中的麦穗连通域进行计数,并与图像中的实测麦穗数做误差分析,见表1。由表1可以计算出:3个试验小麦品种所采集图像的粘连麦穗分割前麦穗数的识别平均绝对误差为8.84个,平均相对误差为29.07%,和粘连麦穗分割后麦穗数的识别误差相比,粘连麦穗未分割时的识别误差明显升高。所以,本文凹点检测分割算法可有效地对图像中粘连麦穗实现分割,从而提高图像中麦穗数的识别精度。由上分析可知,本文算法在识别田间麦穗图像中麦穗数量时单幅图像的识别精度为91.63%。

表1 粘连麦穗分割前麦穗数识别误差分析

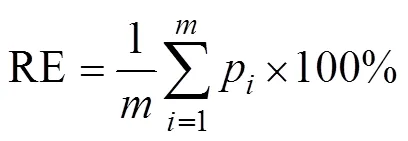

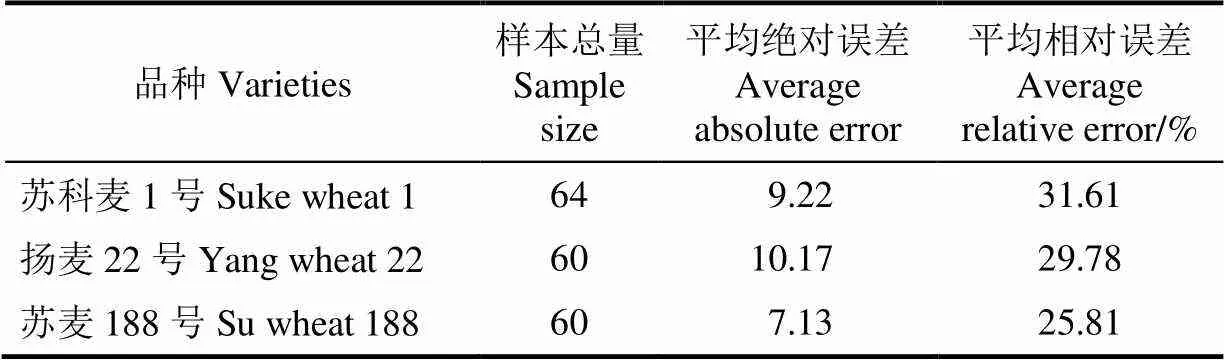

2.2 籽粒数和产量预测结果分析

2.2.1 单个麦穗实测籽粒数与面积像素数相关关系建立

通过对3个品种每幅图像中的麦穗进行识别,再提取图像中事先标号的麦穗的面积像素数,最后将每个品种标号的麦穗的实测籽粒数与其图像中得到的面积像素数建立线性关系见图10。由图10可知,事先标记的麦穗的实测籽粒数与其在图像上所占的面积像素数具有极其显著的线性相关性,决定系数2均达0.82以上(< 0.001)。说明可以利用籽粒数与面积像素数的线性相关关系来间接地预测图像中已分割好的每个麦穗的籽粒数。

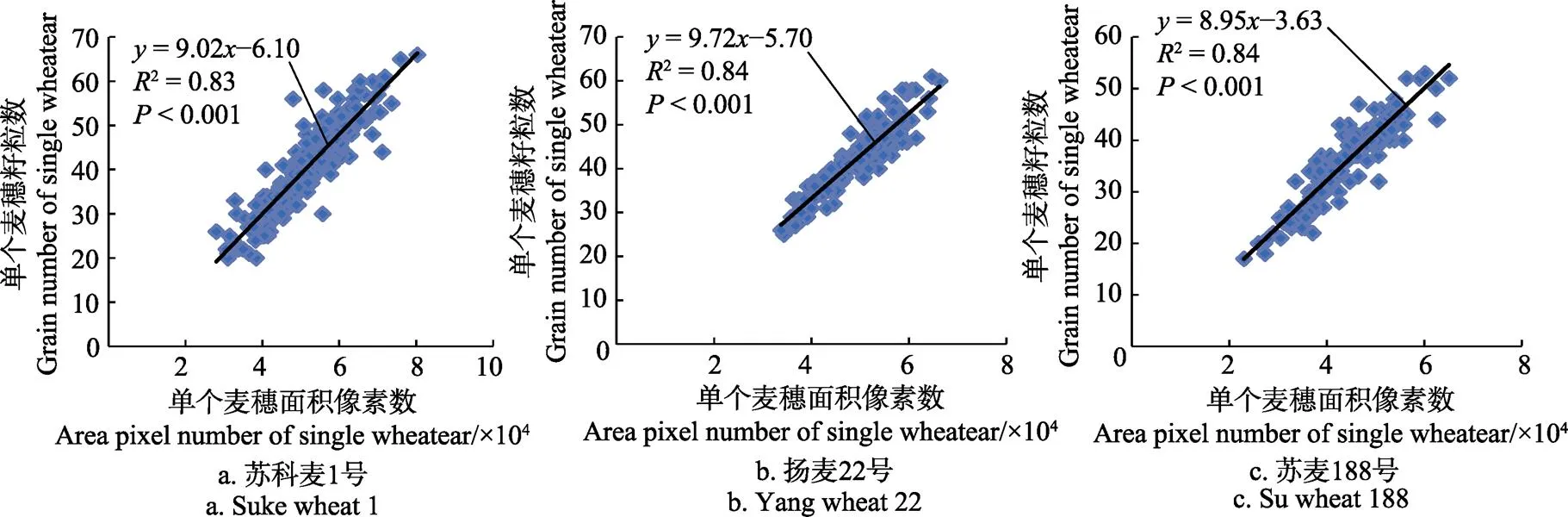

2.2.2 籽粒数预测结果分析

图10 3个品种小麦图像中已标记麦穗的籽粒数与面积像素数的线性相关关系

图11 3个品种小麦图像预测籽粒数与实测籽粒数的线性相关关系

2.2.3 产量预测结果分析

本文还将所选定的0.25 m2区域内对应的4幅图像的总穗数、总籽粒数和产量的预测值和该区域内的总穗数、总籽粒数和产量的实测值进行了统计并做了误差分析,见表2。由表2可进一步计算:

1)3个品种麦穗图像的麦穗数识别平均绝对误差为6.83个;平均相对误差为6.17%。所以本文算法在识别田间0.25 m2面积区域内麦穗数时的精度为93.83%;

2)3个品种麦穗图像的籽粒数预测平均绝对误差为257.88粒;平均相对误差为6.57%。所以本文算法在预测田间0.25 m2面积区域内籽粒数时的精度为93.43%;

3)3个品种麦穗图像的产量预测平均绝对误差为8.40 g;平均相对误差为6.51%。所以本文算法在预测田间0.25 m2麦穗图像的麦穗产量时的精度为93.49%;

表2 0.25 m2麦穗数、籽粒数和产量预测结果误差分析

3 讨论

本文在进行田间麦穗图像测产试验时,所采用的3个品种麦穗均取自江浦农场不同农户田间地块的小麦,从3个品种小麦的千粒质量数据可以看出:不同品种麦穗之间存在一定的差异性。

通过建立单个麦穗实测籽粒数与面积像素数相关关系,由图10可以进一步观察到,虽然单个麦穗实测籽粒数与面积像素数存在极其显著(<0.001)的线性相关性,但是其散点分布相对来说还较分散,其2还未达到0.90以上。这也是造成本文籽粒数预测精度较低的直接原因。通过观察原图像可发现同一幅图像上的麦穗并不是都以正视图或侧视图呈现,而是两者混合的情况,由于小麦穗的正视图与侧视图面积上的差异,导致单个麦穗的实测籽粒数与面积像素数的线性相关性减弱。所以要想进一步提高籽粒数的预测精度可以通过改善算法以识别区分出图像中麦穗的呈现形态。此外,在采集图像时,应该注意严格控制所采集图像都要在相同条件下。

通过对图像中的麦穗数预测值的误差分析,本文方法要优于范梦扬等[11]的基于支持向量机学习的识别方法。而和刘涛等[10]研究单位面积麦穗数量的方法识别精度相比,本文方法识别精度还有待提高。经过仔细观察本文算法处理前后的图像可知,误差来源主要是采样点处的麦穗在4个方向的分布不均匀导致部分图像出现麦穗堆积现象,从而增大误差。所以,图像采集装置还应该继续改进完善,同时提高算法的识别精度。另外,已有文献的小麦田间图像测产方法并没有实现图像中麦穗的分割计数,仅仅是通过穗头骨架拐点的个数进行麦穗数预测,更没有进一步得到图像中麦穗的籽粒数及产量的相关信息,而本文通过一系列分割算法实现了图像中麦穗数、籽粒数、产量的识别预测。

通过对每个品种单幅图像籽粒数预测值的误差分析,发现试验相对误差在15%以上的频数较大,尤其是“苏科麦1号”品种,经过试验观察分析,发现这些相对误差较大的图像多分布于整体样本序数的后面部分,这是由于这些图像在采集时正值临近傍晚时段,天色逐渐变暗,导致所采集图像清晰度明显下降,最终影响了算法的识别精度。

近年来在小麦田间产量预测方面,除了人工实地取样测产外,还包括:利用基于高光谱遥感的预测模型方法来预测小麦产量,其模型平均识别精度在84%左右[26];利用主动遥感仪器获得小麦冠层归一化植被指数以及比值植被指数的变化情况来建立回归模型来预测小麦产量,其模型预测精度因小麦不同的生长期变化而变化,在返青期和灌浆期模型的识别精度最高在92%~93%之间[27];利用气象数据与遥感数据相结合的估产模型来预测小麦产量[28],其精度要好于仅基于遥感或气象模型,为91.50%。而本文算法在对0.25 m2区域小麦产量预测方面精度为93.49%,要优于基于高光谱遥感图像的识别精度和利用气象数据与遥感数据相结合的模型的预测精度,并且本文在小麦产量预测精度上还有可提高的空间。要进一步提高单位平方米内产量预测的精度,需要提高区域内每幅图像上的麦穗数及籽粒数的识别精度,可通过进一步改善算法,优化籽粒数的预测公式以及改进图像采集装置来实现。

4 结 论

本文以田间0.25 m2区域小麦穗为研究对象,利用特定装置使麦穗倾斜的方式获取小麦穗部图像,通过颜色空间转换、去除细窄处粘连、粘连麦穗判断、凹点检测分割等算法过程,实现了图像中粘连麦穗的有效分割,提高图像中麦穗数的识别精度,在识别3个品种田间麦穗单幅图像中麦穗数量的平均识别精度为91.63%;通过计算图像中每个麦穗的面积像素点数以及像素点数与籽粒数之间的相关关系得到的预测公式得到每个麦穗的籽粒数,进而计算出每幅图像上所有麦穗的预测籽粒数,籽粒数的平均预测精度为90.73%;进一步得到了单位面积内的小麦麦穗数量、总籽粒数及产量信息,3个品种0.25 m2区域的小麦麦穗数量、总籽粒数及产量预测的平均精度为93.83%、93.43%、93.49%。运用本文方法可以实现小麦田间单位面积内的产量信息自动测量。

[1] 欧文浩,苏伟,薛文振,等. 基于HJ-1卫星影像的三大农作物估产最佳时相选择[J]. 农业工程学报,2010,26(11):176-182.Ou Wenhao, Su Wei, Xue Wenzhen, et al. Selection of optimum phase for yield estimation of three major crops based on HJ-1 satellite images[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2010, 26(11): 176-182. (in Chinese with English abstract)

[2] 李向东,吕风荣,张德奇,等. 小麦田间测产和实际产量转换系数实证研究[J]. 麦类作物学报,2016,36(1):69-76.Li Xiangdong, Lü Fengrong, Zhang Deqi, et al. Empirical study on conversion factors between yield monitoring and actual yield of winter wheat[J]. Journal of Triticeae Crops, 2016, 36(1): 69-76. (in Chinese with English abstract)

[3] 龚红菊. 基于分形理论及图像纹理分析的水稻产量预测方法研究[D]. 南京:南京农业大学,2008. Gong Hongju. Estimating Paddy Yield based on Fractal and Image Texture Analysis[D]. Nanjing: Nanjing Agricultural University, 2008. (in Chinese with English abstract)

[4] Reza M N, Na I S, Lee K H. Automatic counting of rice plant numbers after transplanting using low altitude UAV images[J]. International Journal of Contents, 2017, 13: 1-8.

[5] Cointault F, Journaux L, Gouton P. Statistical methods for texture analysis applied to agronomical images[C]//Electronic Imaging 2008. International Society for Optics and Photonics, 2008: 593-602.

[6] Zhu Y, Cao Z, Lu H, et al. In-field automatic observation of wheat heading stage using computer vision[J]. Biosystems Engineering, 2016, 143: 28-41.

[7] Fernandez-Gallego J A, Kefauver S C, Gutiérrez N A, et al. Wheat ear counting in-field conditions: High throughput and low-cost approach using RGB images[J]. Plant Methods, 2018, 14(1): 1-12.

[8] Li Q Y, Cai J, Berger B, et al. Detecting spikes of wheat plants using neural networks with laws texture energy[J]. Plant Methods, 2017, 13(1): 1-13.

[9] 杜世伟,李毅念,姚敏,等. 基于小麦穗部小穗图像分割的籽粒计数方法[J]. 南京农业大学学报,2018,41(4): 742-751. Du Shiwei, Li Yinian, Yao Min, et al. Counting method of grain number based on wheatear spikelet image segmentation[J]. Journal of Nanjing Agricultural University, 2018, 41(4): 742-751. (in Chinese with English abstract)

[10] 刘涛,孙成明,王力坚,等. 基于图像处理技术的大田麦穗计数[J]. 农业机械学报,2014,45(2):282-290.Liu Tao, Sun Chengming, Wang Lijian, et al. In-field wheatear counting based on image processing technology[J]. Transactions of the Chinese Society for Agricultural Machinery, 2014, 45(2): 282-290. (in Chinese with English abstract)

[11] 范梦扬,马钦,刘峻明,等. 基于机器视觉的大田环境小麦麦穗计数方法[J]. 农业机械学报,2015,46(增刊1):234-239.Fan Mengyang, Ma Qin, Liu Junming, et al. Counting method of wheatear in field based on machine vision technology[J]. Transactions of the Chinese Society for Agricultural Machinery, 2015, 46 (Supp.1): 234-239. (in Chinese with English abstract)

[12] 王建新. 基于HSI空间的单幅图像去雾算法研究[D]. 石家庄:河北师范大学,2015. Wang Jianxin. Research Single Image Defogging Algorithm based on HSI Color Space[D]. Shijiazhuang: Hebei Normal University, 2015. (in Chinese with English abstract)

[13] 杜慧,邓潇潇,李建,等. 智能的图像滤波去噪算法[J]. 计算机工程与设计,2015(8):2180-2184.Du Hui, Deng Xiaoxiao, Li Jian, et al. Smart algorithm for image filtering de-noising[J]. Computer Engineering and Design, 2015(8): 2180-2184. (in Chinese with English abstract)

[14] 余胜威,丁建明,吴婷,等. MATLAB图像滤波去噪分析及其应用[M]. 北京: 北京航空航天大学出版社,2015:1-22.

[15] 赵荣椿,赵忠明,张艳宁,等. 数字图像处理[M]. 西安:西北工业大学出版社,2016:369-376.

[16] 章毓晋. 图像处理和分析技术[M]. 北京:高等教育出版社,2015:69-74.

[17] 李丰军,吾守尔•斯拉木,刘宏杰,等. 一种基于角度的边界点检测算法[J]. 计算机工程,2008,34(11):203-205. Li Fengjun, Wushour•Silamu, Liu Hongjie, et al. Boundary points detect algorithm based on angle[J]. Computer Engineering, 2008, 34(11): 203-205. (in Chinese with English abstract)

[18] 张徳丰. MATLAB数字图像处理[M]. 北京:机械工业出版社,2009:285-305.

[19] 陶德威. 基于凹点匹配和分水岭变换的车辆图像分割算法研究[D]. 南昌:南昌大学,2016. Tao Dewei. Research on the Vehicle Image Segmentation Algorithm based on Concave Points Matching and Watershed Transformation[D]. Nanchang: Nanchang University, 2016. (in Chinese with English abstract)

[20] 童振,蒲立新,董方杰. 基于改进分水岭算法和凹点搜索的乳腺癌粘连细胞分割[J]. 生物医学工程学杂志,2013(4):692-696.Tong Zhen, Pu Lixin, Dong Fangjie. Automatic segmentation of clustered breast cancer cells based on modified watershed algorithm and concavity points searching[J]. Journal of Biomedical Engineering, 2013(4): 692-696. (in Chinese with English abstract)

[21] 李宏辉,郝颖明,吴清潇,等. 基于凹点方向线的粘连药品图像分割方法[J]. 计算机应用研究,2013,30(9):2852-2854. Li Honghui, Hao Yingming, Wu Qingxiao, et al. Based on concave point direction line adhesion drug image segmentation method[J]. Application Research of Computers, 2013, 30(9): 2852-2854. (in Chinese with English abstract)

[22] 宋怀波,张传栋,潘景朋,等. 基于凸壳的重叠苹果目标分割与重建算法[J]. 农业工程学报,2013,29(3):163-168. Song Huaibo, Zhang Chuandong, Pan Jingpeng, et al. Segmentation and reconstruction of overlapped apple images based on convex hull[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2013, 29(3): 163-168. (in Chinese with English abstract)

[23] 高星. 基于标记分水岭和凹点的粘连大米图像分割技术研究[D]. 郑州:河南工业大学,2015. Gao Xing. Study on Image Segmentation Technique of Touching Rice based on Watershed and Pits[D]. Zhengzhou: Henan University of Technology, 2015. (in Chinese with English abstract)

[24] 杨辉华,赵玲玲,潘细朋,等. 基于水平集和凹点区域检测的粘连细胞分割方法[J]. 北京邮电大学学报,2016,39(6):11-16. Yang Huihua, Zhao Lingling, Pan Xipeng, et al. Overlapping cell segmentation based on level set and concave area detection[J]. Journal of Beijing University of Posts and Telecommunications, 2016, 39(6): 11-16. (in Chinese with English abstract)

[25] 董珂. 基于机器视觉的矿石粒度检测技术研究[D]. 北京:北京工业大学,2013. Dong Ke. Research on Ore Granularity Detection Technology based on Machine Vision[D]. Beijing: Beijing University of Technology, 2013. (in Chinese with English abstract)

[26] 冯伟,朱艳,田永超,等. 基于高光谱遥感的小麦籽粒产量预测模型研究[J]. 麦类作物学报,2007,27(6):1076-1084. Feng Wei, Zhu Yan, Tian Yongchao, et al. Model for predicting grain yield with canopy hyperspectal remote sensing in wheat[J]. Journal of Triticeae Crops, 2007, 27(6): 1076-1084. (in Chinese with English abstract)

[27] 曹伟,张娜. 基于Green Seeker对小麦植被指数与产量形成模型的研究[J]. 华北农学报,2015, 30(增刊1):383-389. Cao Wei, Zhang Na. A model research can be built by yield of wheat and green vegetation index of wheat based on the green seeker[J]. Acta Agriculturae Boreali-Sinica, 2015, 30(Supp.1): 383-389. (in Chinese with English abstract)

[28] 彭丽. 基于MODIS和气象数据的陕西省小麦与玉米产量估算模型研究[D]. 杭州:浙江大学,2014. Peng Li. Wheat and Maize Yield Model Estimation based on MODIS and Meteorological Data in Shaanxi Province[D]. Hangzhou: Zhejiang University, 2014. (in Chinese with English abstract)

Method for wheatear counting and yield predicting based on image of wheatear population in field

Li Yinian, Du Shiwei, Yao Min, Yi Yingwu, Yang Jianfeng, Ding Qishuo, He Ruiyin

(210031,)

At present,the wheatear number and grain number for unit area wheat in field can be measured whenpredicting yield. Generally, phenotype parameters should be obtained by manual count technique. It is time-consuming and needs great effort. In order to quickly measure the yield of unit area wheat in field, the wheatear population image was obtained by tilting the wheatear with specific device in field. The contour information on wheatear image in field was collected. Firstly, the color space of wheatear population image was converted from RGB (red green blue) to HSI (hue saturation intensity) for the sake of improving the uniformity of image color. Then the saturation component of image was extracted from the HSI color space of wheatear population image. Binary image of the saturation component of image was obtained by using image binary algorithm,morphological opening operation and removing of small regions algorithm. Then binary image was smoothed by linear mean filtering algorithm. The adherent and narrow part was removed by setting distance threshold between boundary points. Then the adhesive wheatear in image was judged out by its boundary and region characteristic parameters from the binary image. The boundary characteristic parameters included the length of entire boundary and the angle of on boundary point. The region characteristic parameters included the region area and shape factor of region and duty cycle of convex closure. Then image edge of adhesive wheatear was smoothed by using concave domain smoothing method. Then concave points on the boundary of adhesive wheatear were extracted by using included angle method and area method. The concave point pairs were found by 6 matching principles of concave points. The adhesive wheatear in image was segmented by connecting concave point which was already detected and matched on the binary image boundary. The separated wheatears and non-adhesive wheatears were superimposed on a binary image. The connected regions on the binary image were marked by image labeling algorithm. The number of wheatears in one binary image was counted. And the total number of wheatears in 0.25 m2area was obtained by summing the number of wheatears in corresponding 4 wheatear images. Meanwhile, the area pixels number of each wheatear in binary image was extracted. The grain number prediction formula of wheatear in image was obtained by the linear relationship between actual grain number and area pixels number of pre-marked wheatear. Then the grain number of each wheatear in binary image was forecasted by using grain number prediction formula. The total grain number of wheatear in one image was obtained by summing the grain numbers of each wheatear in binary image. The total grain number of wheatear in 0.25 m2area was obtained by summing the grain numbers in corresponding four wheatear images. The 1 000-grain weight of 3 varieties of wheat which included Suke wheat 1, Yang wheat 22 and Su wheat 188 was measured respectively. Finally the yield of wheat in 0.25 m2area was calculated according to the 1 000-grain weight and the total grain number of wheatear. Compared with the actual wheatear number, grain number in a wheatear image and actual yield information of wheat in 0.25 m2area, the experiment results manifest that the average identification precision of the wheatear number in a wheatear image for 3 varieties of wheat is 91.63%, and the average prediction precision of the grain number in a wheatear image for 3 varieties of wheat is 90.73%. And the average prediction precision of the total wheatear number, total grain number and yield of wheat in 0.25 m2area for 3 varieties of wheat are 93.83%, 93.43% and 93.49%, respectively. The automaticallypredicting yield information of wheat in unit area can be realized by using wheatear image features method.

crops; algorithms; image segmentation; wheat; wheatear population image; wheatear number in unit area; grain number; yield prediction

10.11975/j.issn.1002-6819.2018.21.022

TP391.4

A

1002-6819(2018)-21-0185-10

2018-06-23

2018-09-13

国家重点研发计划(2016YFD0300908);江苏省政策引导类计划(产学研合作)前瞻性联合研究项目(BY2016060-01)

李毅念,副教授,主要从事现代农业装备研究。 Email:liyinian@163.com。

李毅念,杜世伟,姚 敏,易应武,杨建峰,丁启朔,何瑞银. 基于小麦群体图像的田间麦穗计数及产量预测方法[J]. 农业工程学报,2018,34(21):185-194. doi:10.11975/j.issn.1002-6819.2018.21.022 http://www.tcsae.org

Li Yinian, Du Shiwei, Yao Min, Yi Yingwu, Yang Jianfeng, Ding Qishuo, He Ruiyin. Method for wheatear counting and yield predicting based on image of wheatear population in field[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(21): 185-194. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2018.21.022 http://www.tcsae.org