基于大数据的电视用户收视行为数据挖掘与分析

吉勇佳 夏征宇

摘 要 随着大数据时代的到来,电视媒体市场有了更多的解决方案。从传统的日记卡、测量仪到如今的智能化大数据处理系统实时监测。大数据正以其大量、多样、高速、价值等特点影响着各行各业,我国的传统电视媒体的传播效果评估与视听效果监测也发生了巨大的变化。文章通过大数据处理平台收集并分析电视用户的行为数据,采用多维度统计分析的方法挖掘用户的收视行为特征,对电视媒体形态下的频道和节目进行分析,得出频道或节目的传播效果,用以指导并辅助产品运营、广告投放及节目编排,并根据分析结果提出相应措施,提高收视率。

关键词 大数据;Hadoop;数据处理;收视率;传播效果

中图分类号 G2 文献标识码 A 文章编号 2096-0360(2020)23-0027-04

1 大数据处理平台构建

1.1 大数据相关概念

何谓“大数据”?在中文维基百科中解释为“在传统数据处理应用软件不足以处理的大或复杂的数据集的术语,也有人认为大数据是指海量无法计算的数据”[1-2]。大数据技术是数据科学领域的一种新的技术框架或模型,它可以及时处理和更新各种数据,综合运用数据感知、采集、存储、处理、分析和可视化技术来提取有用数据信息[3]。目前,大数据主要解决的是大数据量的存储和海量数据的分析计算,并且大数据处理技术也应用在了各行各业,如物流仓库,广告推荐,金融业务等多个方面。

大数据有大量、多样、高速、价值的特点,并有高可靠、高扩展性、高效性、高容错性的优点。移动互联网、电子商务、社交网络等是新一代信息技术的应用形态,这些应用不断产生大数据,大数据技术的应用将成为行业提高核心竞争力的关键因素。

1.2 Hadoop集群规划

本文中大数据处理平台采用的是5台装有CentOS7.6的Linux操作系统,以Hadoop2.7.2版本和jdk1.8.0_121版本搭建完全分布式Hadoop大数据处理集群。通过配置集群环境ssh免密登录设置、节点网络配置、jdk环境安装等。在Hadoop集群配置的过程中,可以使用xsync和scp命令编写文件分发脚本,辅助完成集群内各个节点的环境配置。集群配置中各节点主要进程分配见表1。

1.3 Hadoop生態体系介绍

Hadoop集群中的节点主要是由Common模块、MapReduce计算框架、HDFS模块和Yarn编程框架四个部分构成,Common模块为平台提供基础性的服务功能、系统支持和软件支持;MapReduce模块的核心是Map函数与Reduce函数,MapReduce是一种面向大数据的运算框架;HDFS模块的主要功能是负责Hadoop云平台数据信息的存储、调取、管理和使用;yarn是一种新的Hadoop资源管理器。

2 电视媒体传播效果评估方法

评价体系既是一种效果评价机制,也是一种激励和管理机制,还是一种导向机制[5]。本小节主要是在前人研究的基础上,通过实验筛选,从评价指标体系的众多指标中抽出最核心的人均日收视时长(分钟)、到达率和收视率、观众忠诚度、市场占有率5个指标对频道或者节目进行收视分析。通过Hadoop大数据处理平台,对用户行为数据进行数据清洗和业务逻辑处理,得出业务数据,并基于此数据对用户频道节目收视效果评估,进而验证本方案的可行性。

2.1 电视媒体传播效果评估的几个重要指标

2.1.1 收视率

收视率是指针对某特定时段(节目),平均每分钟的收视人数或平均每分钟的收视人数占总推及人口的百分比(%)[6]。计算公式如下。

2.2 总体评估方案设计

视听效果监测和媒体传播效果评估的难点一方面在于评价的维度和指标多且复杂,需要有一套完整的指标体系或者构建出一套媒体效果评价方案;另一方面在于用户庞大的视听数据量。电视、IPTV、OTT和手机等多种媒体形态时时刻刻都会产生大量的用户行为数据。在传统的处理方法中存在数据采集来源单一,存储、运算速度慢的特点。针对这些问题,通过把大数据处理技术应用于媒体领域,大数据可以通过MapReduce这一并行处理技术来提高数据的处理速度,并挖掘出用户的收视行为特征。

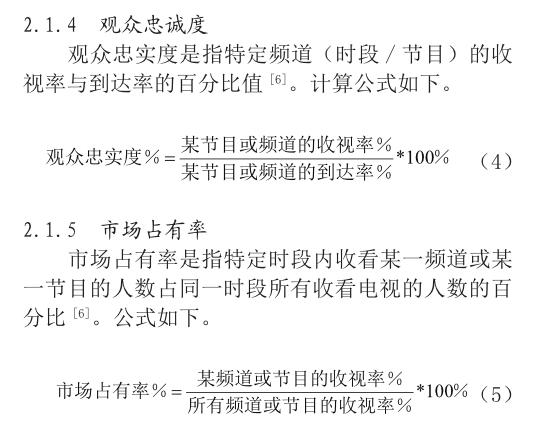

针对上述两个难点,评估方案按照三个步骤进行。首先,在评价指标方面,通过抽出频道或节目的一个维度的几个核心指标来进行分析,通过统计分析方式对每个节目的收视率,到达率,人均日收视时长(分钟),市场份额,观众忠诚度几个方面进行研究,得出某节目在某天中按不同时间粒度的收视情况。其次,在数据处理方面,采用hadoop大数据处理集群,通过flume进行日志收集并上传至HDFS分布式文件系统,MapReduce任务进行大规模数据集的并行计算完成数据清洗,把清洗后的数据与Hive表进行绑定。Hive是一种数据仓库,可以使用sql进行便捷的读写,管理存储在分布式系统上的数据集,通过hive进行业务逻辑操作,得出最终处理完成后的数据信息,最终使用sqoop将hive中的数据信息导入到支撑业务开发和计算的mysql库。最后,在业务开发模块中,我们可以根据清洗后的数据,通过指标计算,得出某节目或者某频道的收视率,到达率等多个指标信息,并通过echarts可视化、报表等方式输出分析结果。由此,分析得出各个节目1小时、30分钟、10分钟、5分钟等不同时间粒度的收视情况,可以精确的知道某个节目在某一时段收视最高,从而推导得出某个节目的最精彩的部分,甚至根据收视分析结果指导节目编排和广告投放,具体的算法流程图如图1。

2.3 收视指标计算模块设计

为了评价一个频道或节目对象,就要为该节目或频道设定一个评估对象,取得与该节目有关的各项监测数据,然后进行计算分析[4]。本文总体评估方案设计模块中,通过模块化的设计方 法,整体处理流程分为大数据处理阶段和收视指标计算阶段两大部分,此模块将重点分析上述谈到的5个核心指标计算,并以处理后的业务数据为出发点,通过具体的案例方式进行分析,得出分析结果。表2为基于实验模拟收视行为数据并进行数据处理后某地区5个频道的用户收视情况,该5个频道构成该地区的总体收视市场,案例通过计算分析,验证处理方案的可行性。

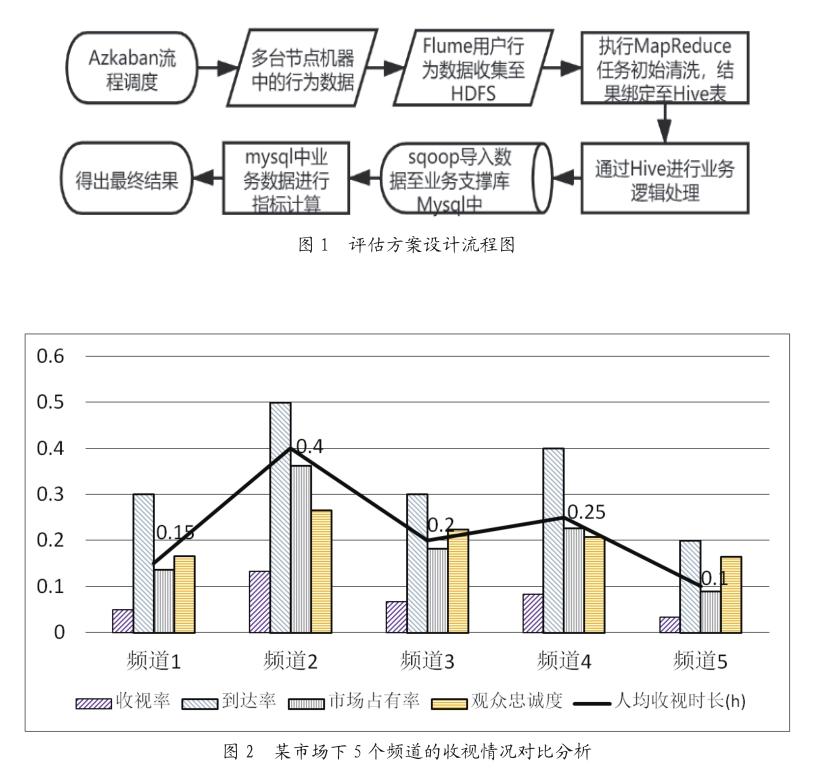

根据上述收视情况,我们可以计算出各个频道的人均日收视时长(分钟)、到达率和收视率、观众忠诚度、市场占有率。统计梳理如表3。

分析得出,该市场下的5个频道的总体收视率为36.67%,在5个频道中,频道2的收视率、观众忠诚度最高,人均收视时长达24分钟/人,远高于该市场下其他频道人均收视时长。

3 結语

本文主要基于大数据处理技术,分别从收视率、到达率、观众忠诚度、人均日收视时长和市场份额5项衡量指标着手,对电视媒体受众的媒介接触行为进行挖掘分析。通过Hadoop大数据处理框架及Azkaban分别进行数据处理和流程调度,先后完成了数据清洗、指标计算、结果分析和可视化等操作,得出任意频道或节目一天、半天、一小时、半小时、十分钟等不同时间粒度的收视情况。同时,以半小时为时间粒度综合分析了某市场下五个不同频道的收视情况并得出对比结论。由此,可以更好的指导各频道进行节目编排,有效提升广告投放效果,并提高频道收视率。

参考文献

[1]李国杰.大数据研究的科学价值[J].中国计算机学会通讯,2012,8(9):8-15.

[2]Vance A. Start-up goes after big data with hadoop helper[EB/OL].(2010-04-22)[2020-11-23].https:// web.archive.org/web/20150908124357/http://bits. blogs.nytimes.com/2010/04/22/start-up-goes-afterbig-data-with-hadoop-helper/?dbk.

[ 3]张锋军.大数据技术研究综述[J].通信技术,2014(11):1240-1248.

[ 4]熊华明,谢长生,夏征宇.电视节目综合评估与预警系统的设计与实现[J].计算机工程与应用,2002,38(20):215-217.

[ 5]刘燕南.关于电视评估中纳入新媒体指标的思考[J].中国广播电视学刊,2013(5):11-14.

[ 6]赵利城.基于双向机顶盒的收视率调查系统研究与实现[D].北京:北京邮电大学,2012.