基于离散非策略Q-学习最优控制鲁棒性研究

刘秋丽 李金娜

摘 要:针对离散系统鲁棒非策略Q-学习算法的研究的必要性进行了分析和验证。首先提出了最优控制问题,然后利用Q-学习算法设计了基于数据驱动的最优控制器,并重点分析了非策略Q-学习算法在不确定性离散系统的最优控制问题中是否有效。最后通过仿真实验得出结论,在不确定环境下应该设计鲁棒非策略Q-学习算法以保证系统的稳定性。

关键词:最优控制;非策略Q-学习;离散系统;鲁棒性

中图分类号:TP181;TP13 文献标识码:A 文章编号:2096-4706(2020)12-0010-04

Abstract:The necessity of robust non-strategic Q-learning research for discrete systems is analyzed and verified. First,the optimal control problem is proposed,and then the optimal controller based on data driving is designed using Q-learning method,and the focus is on whether the non-strategic Q-learning algorithm is effective in the optimal control problem of uncertain discrete systems. Finally,it is concluded through simulation experiments that a robust non-strategic Q-learning algorithm should be designed in an uncertain environment to ensure the stability of the system.

Keywords:optimal control;non-strategic Q-learning;discrete systems;robustness

0 引 言

强化学习算法是一种通过与环境进行试错交互寻找能够带来最大累积奖赏策略的学习方法[1]。目前强化学习的方法广泛应用于控制领域中,以达到最优控制的效果。强化学习分为策略(On-policy)学习和非策略(Off-policy)学习。如果在学习过程中,动作选择的行为策略和学习改进的目标策略一致,该方法就被称为策略学习,否则被称为非策略学习[2]。

Q-学习是强化学习算法的一种,又称为动作相关启发式动态规划(ADHDP),是一种近似动态规划(ADP)方案法,它结合了自适应批评理论[3,4]。Q-学习算法的优点之一是能够在不了解环境的情况下评估效用和更新控制策略[2,5]。

笔者研究了一些用强化学习算法求解线性DT系统的线性二次调节问题,如贪婪HDP迭代算法[6]和非线性DT系统的迭代自适应动态规划(ADP)[7],还有具有时滞的非线性系统启发式动态规划(HDP)[8]和线性系统的输入和输出数据的策略迭代(PI)和值迭代(VI)[9]算法。然而,上述文献并没有分析和验证鲁棒强化学习算法研究的必要性,理论上非策略Q-学习算法需要考虑系统的鲁棒性,否则绝大多数控制器很难维持系统的稳定性。这是本文研究鲁棒非策略Q-学习问题的动机。

1 最优控制问题阐述

以下是对线性二次调节问题的非策略Q-学习的阐述。

研究目标:寻找一种最优控制率,能够使式(2)中性能指标xk+1越小,并保证式(1)中系统J能够在不确定的环境下保持稳定。若不考虑不确定性,对于标准型式(3),可以参考现有文献[10]来分析非策略Q-学习算法在不确定性离散系统的最优控制问题中是否有效。

2 非策略Q-學习算法设计

以下是对非策略Q-学习算法的设计。根据Q-函数与值函数之间的关系,基于非策略Q-函数的Bellman方程,得到一种非策略Q-函数学习算法。

然后实现非策略Q-学习算法1,经过30次迭代后算法收敛,得到最优Q-函数矩阵H*和最优控制器增益K*,结果同式(16)(17)。

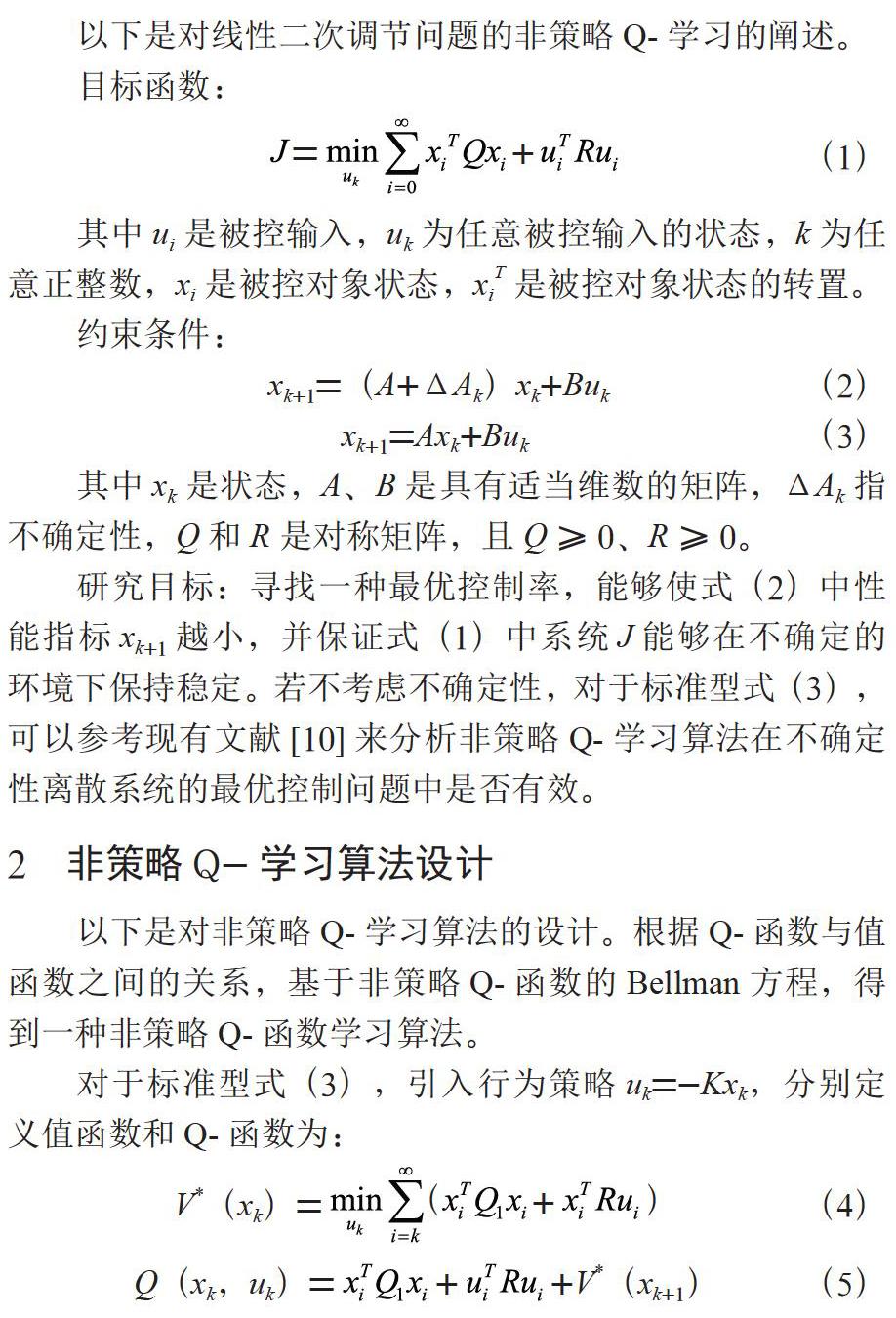

在不考虑不确定性时,即bound=0时,系统状态x1和x2都收敛于0,说明原有的非策略Q-学习算法1对于系统的适应性较好。具体系统状态仿真曲线如图1所示。

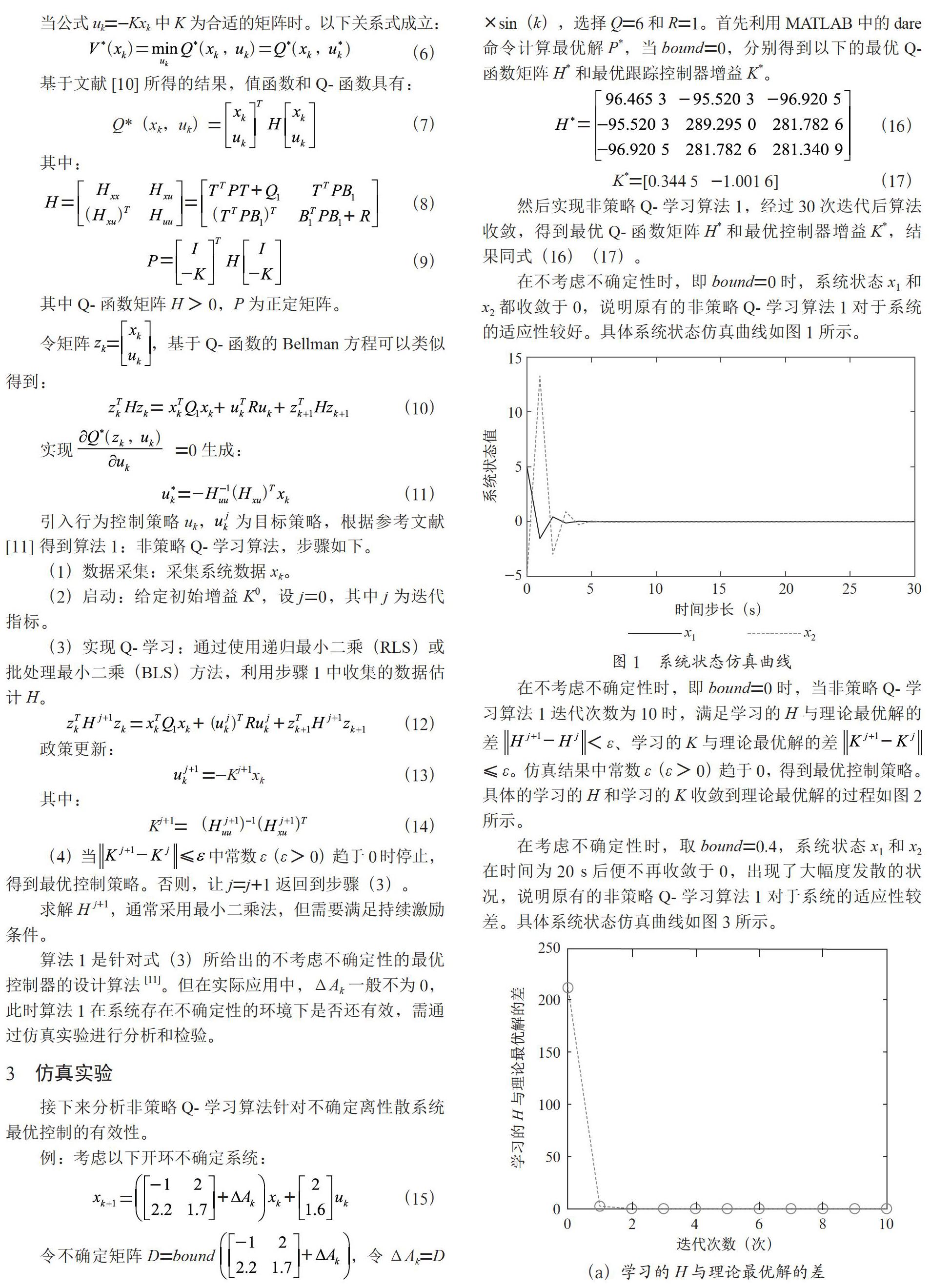

在不考虑不确定性时,即bound=0时,当非策略Q-学习算法1迭代次数为10时,满足学习的H与理论最优解的差 <ε、学习的K与理论最优解的差 ≤ε。仿真结果中常数ε(ε>0)趋于0,得到最优控制策略。具体的学习的H和学习的K收敛到理论最优解的过程如图2所示。

在考虑不确定性时,取bound=0.4,系统状态x1和x2在时间为20 s后便不再收敛于0,出现了大幅度发散的状况,说明原有的非策略Q-学习算法1对于系统的适应性较差。具体系统状态仿真曲线如图3所示。

在考虑不确定性时,取bound=0.4,当非策略Q-学习算法1迭代次数为20时,学习的H与理论最优解的差 和学习的K与理论最优解的差 的结果不再收敛于0,得到的最优控制策略将不能够使系统保持稳定状态。具体的学习的H和学习的K收敛到理论最优解的过程如图4所示。

分析得到:在bound≠0时,非策略Q-学习算法1考虑了系统的不确定性,并且随着不确定性ΔAk的增加,系统状态稳定性受到了一定程度的影响,可见算法1对不确定性ΔAk的容忍范围是有限的;如果不确定性ΔAk过大,系统的稳定性将无法得到保障。

4 结 论

针对系统模型参数未知的离散系统,本文重点分析和验证了鲁棒非策略Q-算法研究的必要性,提出了最优控制问题,并且在非策略Q-学习算法设计过程中考虑了不确定性。文章通过仿真实验得出结论,在研究不确定环境下的离散控制系统时,应该设计鲁棒非策略Q-学习算法以保证系统的稳定性。

参考文献:

[1] 刘全,傅启明,龚声蓉,等.最小状态变元平均奖赏的强化学习方法 [J].通信学报,2011,32(1):66-71.

[2] KIUMARSI B,LEWIS F L,MODARES H,et al. Reinforcement Q -learning for optimal tracking control of linear discrete-time systems with unknown dynamics [J]. Automatica,2014,50(4):1167-1175.

[3] WATKINS C J C H. Learning from delayed rewards [D]. Cambridge:University of Cambridge,1989.

[4] MILLER W T,SUTTON R S,WERBOS P J. A Menu of Designs for Reinforcement Learning Over Time [J]. Neural networks for control,1995(3):67-95.

[5] AL-TAMIMI A,LEWIS F L,ABU-KHALAF M. Model-free Q -learning designs for linear discrete-time zero-sum games with application to H-infinity control [J]. Automatica,2006,43(3):473-481.

[6] ZHANG H G,WEI Q L,LUO Y H. A novel infinite-time optimal tracking control scheme for a class of discrete-time nonlinear systems via the greedy HDP iteration algorithm [J]. IEEE Transactions on Systems,Man,and Cybernetics,Part B:Cybernetics,2008,38(4):937-942.

[7] WANG D,LIU D,WEI Q. Adaptive dynamic programming for finite-horizon optimal tracking control of a class of nonlinear systems [C]//中国自动化学会控制理论专业委员会.中国自动化学会控制理论专业委员会B卷.2011:2450-2455.

[8] ZHANG H G,SONG R Z,WEI Q L,et al. Optimal tracking control for a class of nonlinear discrete-time systems with time delays based on heuristic dynamic programming [J]. IEEE transactions on neural networks,2011,22(12):1851-1862.

[9] KIUMARSI B,LEWIS F L,NAGHIBI-SISTANI M,et al. Optimal Tracking Control of Unknown Discrete-Time Linear Systems Using Input-Output Measured Data [J]. IEEE transactions on cybernetics,2015,45(12):2770-2779.

[10] 李金娜,尹子軒.基于非策略Q-学习的网络控制系统最优跟踪控制 [J].控制与决策,2019,34(11):2343-2349.

[11] LI J N,YUAN D C,DING Z T. Optimal tracking control for discrete-time systems by model-free off-policy Q-learning approach [C]. 2017 11th Asian Control Conference(ASCC),2017:7-12.

作者简介:刘秋丽(1997—),女,汉族,河南郸城人,本科,研究方向:自动化;李金娜(1977—),女,汉族,山东单县人,教授,硕士生导师,博士,研究方向:数据驱动控制、运行优化控制、强化学习、网络控制。