智能作文评价的效果研究

刘淑君 李 艳 杨普光 李小丽 高红芳

(1.浙江大学 教育学院, 浙江杭州 310028; 2.郑州外国语学校,河南郑州 450001; 3.浙江大学教育学院附属学校,浙江杭州 310013; 4.杭州市萧山区金惠初中,浙江杭州 311202)

一、背 景

近年来,智能技术的教育应用方兴未艾。研究显示,人工智能技术具有促进学生知识理解和迁移的巨大潜力,对未来的人才结构变革带来全新的影响(舒越等, 2018;顾小清, 2021)。人工智能教育应用的一个重要领域是写作教学。早在20世纪60年代,智能作文评价(Automated Essay Evaluation) 就在欧美国家兴起,美国研发的PEG(Project Essay Grader)、E-rater、Intellimetric、IEA(Intelligent Essay Assessor)等都是具有代表性的智能作文评价系统,有的已被应用在TOEFL和GMAT等大规模英语测试中。早期的智能作文评价系统侧重评分功能,通过抽取语言学特征对文章整体或分项评分。随着计算机自然语言处理技术的发展,系统逐渐将作文评分、诊断性反馈和学情报告相结合,为作者提供更全面和综合的写作评价。近年来,国内智能作文评价系统也层出不穷,英语智能作文评价领域代表性系统包括句酷批改网、iWrite、冰果英语等,中文作文评价领域代表性系统包括IN课堂语文作文智能批改、365学堂在线作文批改平台、爱语文APP等。这些系统将自然语言处理、统计检索和互联网技术相结合,体现了人工智能在写作教学领域的最新进展。本研究采用“智能作文评价”描述智能作文评价系统开展的作文评价。

智能作文评价的有效性是影响其推广的重要因素,包括智能作文评分的有效性和反馈精准度两方面。已有研究验证智能作文评分有效性的方式主要有三种:1)比较智能作文评分与教师作文评分的一致性和相关性。研究证明,英语智能作文评价系统E-rater、Intellimetric、IEA等与教师评分的一致性较高,一致性系数在87%-100%之间;且两者相关系数在0.76- 0.95之间(Attali & Burstein, 2006;Foltz et al., 2011;Liu & Kunnan, 2016)。然而,也有不一致的结论。例如,对My Access和iWrite的调查发现,它们和教师作文评分一致性分别为71.4%和34%,远低于教师评分之间的一致性(Hoang & Kunnan, 2016;Qian et al., 2020)。2)调查智能作文评分与教师评价、学生自我评价、专家评级、课程成绩等外部指标之间的一致性。有学者用学业测试、自我评价、专家评价和教师评价等指标检验My Access的作文评分质量,得出My Access评分有效的结论(Vantage Learning,2007)。3)研究文章长度等文本特征对智能作文评分的预测程度。当系统评分受文章长度等表面特征影响过大时,评分效度会降低(Chodorow & Burstein, 2004; Landauer, 2003)。约恩(Jones,2006)对IntelliMetric的调查发现,该系统的人机评分一致性较高,但文章长度影响对其评分预测程度高达85%,不足以证明系统评分的有效性;黄和昆南(Hoang & Kunnan, 2016)的研究发现,My Access和教师作文评分受文章长度影响的预测度都是53% ,具有一致性。该方法往往和前两种结合使用,为智能作文评分有效性提供多维证据。

智能作文反馈的精准度对学生写作修改有重要意义,精确度和召回率是已有研究中较常用的衡量指标。精确度指系统正确识别项数除以全部识别项数,召回率指系统正确识别项数除以文本实际错误项数(Hoang & Kunnan, 2016)。研究发现,智能反馈工具的精确度达90%时,学习者才能从中受益(Burstein et al., 2003),与不能识别部分错误相比,将正确内容标注为错误的行为对学生的负面影响更大,因而研究者对智能作文评价的反馈精确度更重视(Chodorow et al., 2010)。研究表明,大部分智能作文评价的反馈精确度不到90%,不能提供其促进学习的有力证据。比如,My Access的反馈精确度和召回率分别为73%和30%,Write To Learn仅为49%和18.7%,提升空间较大(Hoang & Kunnan, 2016;Liu & Kunnan, 2016)。

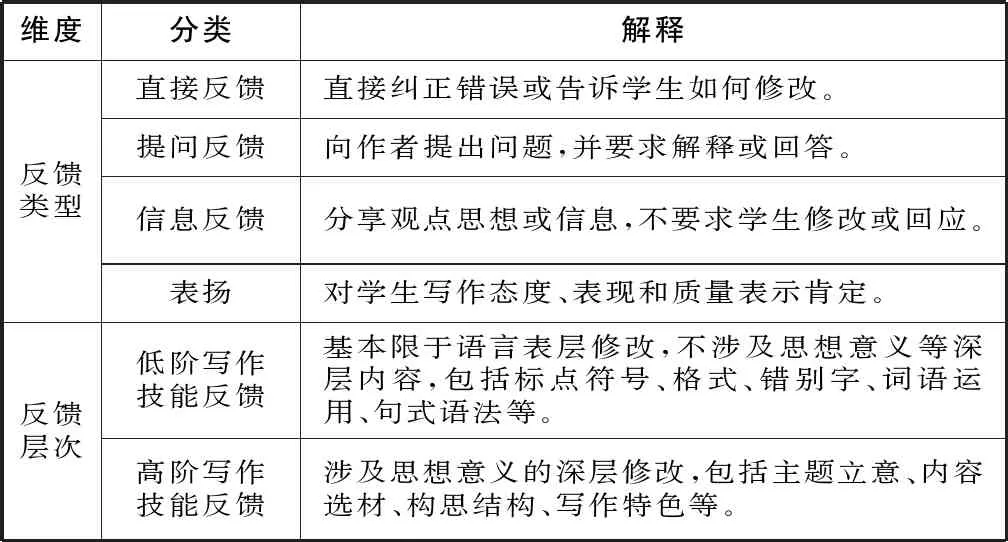

此外,研究者还关注了智能作文反馈和教师作文反馈的关系。作文反馈信息指教师对文本的点评建议,通常按类型和层次分类。反馈类型可分为直接反馈、提问反馈、信息反馈和表扬(Biber et al., 2011;Shute, 2008)。直接反馈指教师直接纠正错误或告诉学生如何修改;提问反馈是向作者提出问题,并要求解释或回答;信息反馈侧重向学生传递观点或信息,不要求学生回应或修改文本;表扬是对学生态度、表现和写作质量的肯定(Cho et al., 2006)。反馈层次是作文反馈信息所针对的写作技能层次(Biber et al.2011),可分为低阶写作技能反馈和高阶写作技能反馈。前者侧重对标点、语法等文本表层错误的反馈,后者聚焦内容、结构、意义等高阶技能的提升(Matsumara et al. , 2002;Peterson et al.,2004)。威尔逊等(Wilson et al.,2016)研究智能作文评价对教师反馈的影响时,依据反馈类型与层次编制了作文反馈信息分类细则,并将其应用于教师作文反馈的信息分析。研究发现,与传统的教师反馈相比,与智能作文评价相结合的教师反馈跟聚集内容选材、结构构思等高阶写作技能反馈。之后,林克等(Link et al., 2020)就该问题做的延伸性研究也获得了类似的发现。智能作文评价系统早期主要针对低阶写作技能直接反馈,较少涉及高阶写作技能,也不能提供其他类型的反馈。因此,早期智能作文反馈往往局限于针对低阶写作技能的直接反馈。比如,对Criterion与教师作文反馈信息的比较研究发现,智能作文反馈的数量和质量都低于教师反馈(Dikli & Bleyle, 2014)。研究者为了保持两种反馈信息在类型与层次上的一致,排除了教师评价的高阶反馈信息,也忽略了教师评价中直接反馈外的其他类型反馈信息。目前,部分中英文智能作文评价系统不仅提供直接反馈,还提供信息、表扬等反馈信息,且出现较多针对高阶写作技能的反馈信息。因此,针对两种作文评价反馈信息的综合比较就显得很有必要。

智能作文评价让反馈变得即时而便捷,加速了“写作-评价(反馈)-修改”的循环,是传统教师作文评价很难达成的(Warschauer & Grimes, 2008;Shute, 2008;Foltz, 2013),给传统写作教学变革带来可能。研究发现,智能作文评价能提高学生的文本准确性和写作成绩(Shermis et al., 2008;Attali,2004; Choi, 2010),也会提高学生的写作动机(Wilson & Roscoe, 2020;Grimes & Warschauer, 2010),对学生的写作修改和认知参与也有影响(Lee,2020;钟彩顺,2015)。不过,如果学生写作动机的提高是新奇效应的产物,那么随着时间的推移,写作动机也会停滞增长或消退(Cheung & Slavin, 2013)。智能作文评价的教学应用价值需要引起更多教育研究者和实践者的关注(Chen & Cheng, 2008)。

在传统中小学写作教学中,教师布置写作任务,学生当堂或课外完成习作,教师再逐一批改。这一过程往往耗费教师大量的时间和精力,教师的评价和反馈滞后(少则一天,多则一个礼拜或更久);同时,囿于时间、精力和经验的限制,教师的作文评价容易出现单一、主观或片面等问题。智能作文评价系统的开发旨在解决传统作文教学的这些顽疾,但其应用和推广并不顺利,原因在于传统中小学语文老师对其评价的有效性充满质疑。

调研发现,国外英语智能作文评价系统的实践和研究起步较早,研究成果丰富。相比而言,中文智能作文评价起步较晚,需要更多实证研究回应教育者和学习者的质疑。在此背景下,本研究选取“IN课堂语文作文人机批改系统”作为智能作文评价的平台,尝试通过人机作文评价的多维度比较检验智能作文评价的有效性,并为其推广和应用提供依据和建议。

二、研究目的与问题

本研究的目的是验证智能作文评分的有效性,并从反馈类型与层次和反馈精准度等方面展开人机作文评价的比较研究。研究问题有以下三项:

1)智能作文评分的有效性如何?包括:智能作文评分与教师作文评分的一致性与相关性如何?作文长度对二者评分的预测程度是否有差异?

2)智能作文评价和教师作文评价的反馈类型与层次各有什么特点?

3)智能作文评价和教师作文评价的反馈精准度表现如何?

三、研究对象与评价规则

(一)研究对象

本研究以智能作文评价结果作为研究对象,选取国内较成熟、使用范围较广的智能作文评价系统——IN课堂语文作文智能批改(简称IN课堂)作为智能作文评价工具。该系统受国家语委语言智能研究中心指导研发而成,是一个交互式的智能作文批改和反馈平台,于2018年投入应用。它从语料库中挖掘打分细则、评级参数、偏误规则及常用范式,不仅可以给学生作文即时提供反馈分数,还能生成句段点评并提出建议,也支持教师建立虚拟班级、推送作文题、人机协同批改等操作,同时能为师生积累写作过程数据(IN课堂智能教育平台,2020)。

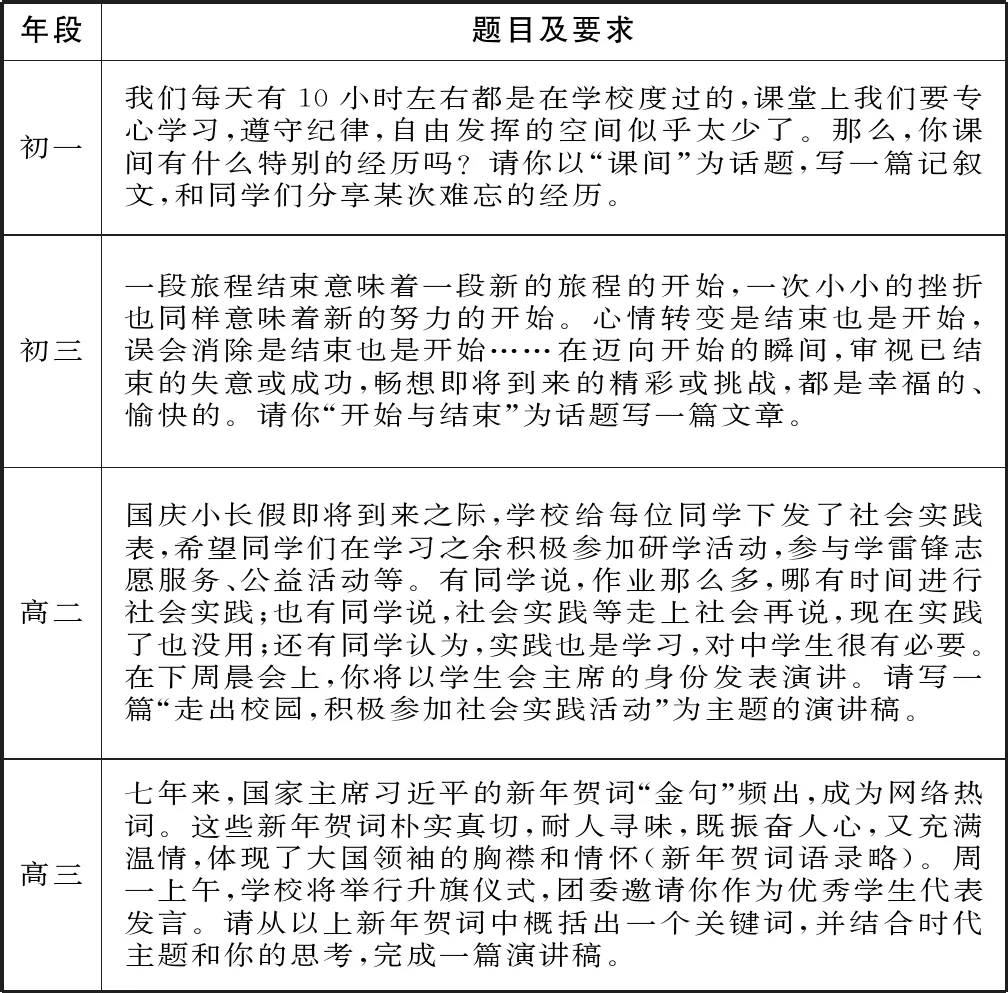

本研究选取Z初中和W高中各两个班的学生作文作为评价样本,分别由语文老师各自布置作文题目(见表一),学生当堂完成,共得到149篇作文样本(初中81篇,高中68篇),初中和高中的写作文体分别为记叙文和议论文。研究者将全部作文样本用于智能作文评分有效性的研究,并选取其中101篇的人机批改信息作为作文反馈类型与层次的分析内容(另外48篇因完成时间较晚,错过集中批改期,故未纳入分析),最后,从全部样本中随机抽取20篇作文检验智能作文评价的反馈精准度。

表一 学生作文题目及要求

(二)作文评价规则

研究者(曾教中学语文,目前在读教育博士)分别与A教师(初中语文教师)和B教师(高中语文教师)合作完成初中、高中作文的评分。评分者首先研习作文评分标准,随后选六份作文试评,对评分差异较大的样本深入交流,对评分标准达成一致理解后,再各自独立评分。之后,研究者和B教师分别对101篇初中、高中作文精批细改,以文内批注和文末总评的形式进行反馈。

IN课堂采用中高考作文评分标准对中学生作文评分。为了保证评分标准的一致性,教师依据评分者所在地区的中考作文评分标准和卷面分值,从内容、结构、表达、立意等方面评分,满分40分;高中作文评分遵循语文高考全国卷的评分标准和卷面分值,兼顾内容、表达、发展三个维度,满分60分。为了便于数据分析,研究者以满分60分为标准,对初中作文成绩按比例折算。

四、数据收集与分析过程

(一)评分有效性的数据收集与分析

本研究从两方面验证智能作文评分的有效性:一方面分析智能作文评分和教师作文评分的一致性和相关性,另一方面比较文章长度对两种作文评分的预测程度。IN课堂对作文样本的评分构成智能作文评分数据;研究者分别与A教师和B教师合作完成初中、高中的作文评分,由此得到两组教师作文评分,取两者均值作为教师作文评分数据。文章长度的衡量指标是文章字数,借助word文档的字数统计功能获得。

在统计智能作文评分和教师作文评分一致性时,本研究援引前人文献常用的精确一致和相邻一致两个衡量指标(Liu & Kunnan,2016)。精确一致指两个评分完全相同。相邻一致指两个评分等级相近。由中高考阅卷程序和相关文献可知,作文满分60分时,两位教师评分差在六分内取两者均值作为最终得分,大于等于六分时会发起三评或仲裁(佟威等, 2020)。因此,研究者将分差小于六分的评分界定为相邻一致,分差大于等于六分的评分界定为评分差异。评分一致性指精确一致项与相邻一致项之和除以总样本数。

智能作文评分与教师作文评分的相关性分析借助SPSS23软件完成。研究还以作文长度为自变量,分别以智能作文评分和教师作文评分为因变量进行一元回归分析,验证作文长度对智能作文评分和教师作文评分的预测程度。

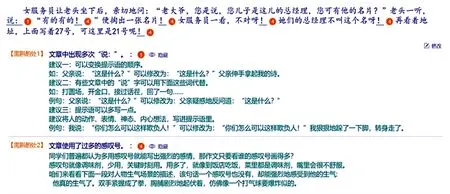

(二)反馈类型与层次的数据收集与分析

本研究选取初中52篇、高中49篇用于反馈类型与层次的分析与比较。IN课堂的机器评阅信息构成智能作文反馈信息;研究者和B教师对初中和高中作文的精批细改形成教师的作文反馈信息。两类反馈信息都被录入Excel文档,接着被拆分为有独立意义的信息单位,即反馈单元。遵循前人文献反馈单元的拆分操作程序(Cho et al.,2006;Hayes & Berninger,2010) ,先抽取五篇作文的反馈信息,研究者和B教师分别进行单元拆分,比对拆分结果,对不一致处协商达成共识。随后,研究者完成全部作文反馈信息的拆分工作,B教师再对拆分后的反馈单元进行核对检查。通过以上拆分,本研究共得到2911个作文反馈单元,包括1955个智能作文反馈单元和956个教师作文反馈单元。

本研究借鉴威尔逊等(Wilson & Gzik,2016)提出的作文反馈信息分类方法,并根据国内作文批阅习惯对其略作调整,比如,将“拼写、大小写”合并为“错别字”,将“语法、句子结构”合并为“句式语法”等,最终编制了适用于国内中学作文的反馈信息编码表(见表二)。该编码表将用于智能作文反馈信息的分析与比较。

表二 作文反馈信息编码

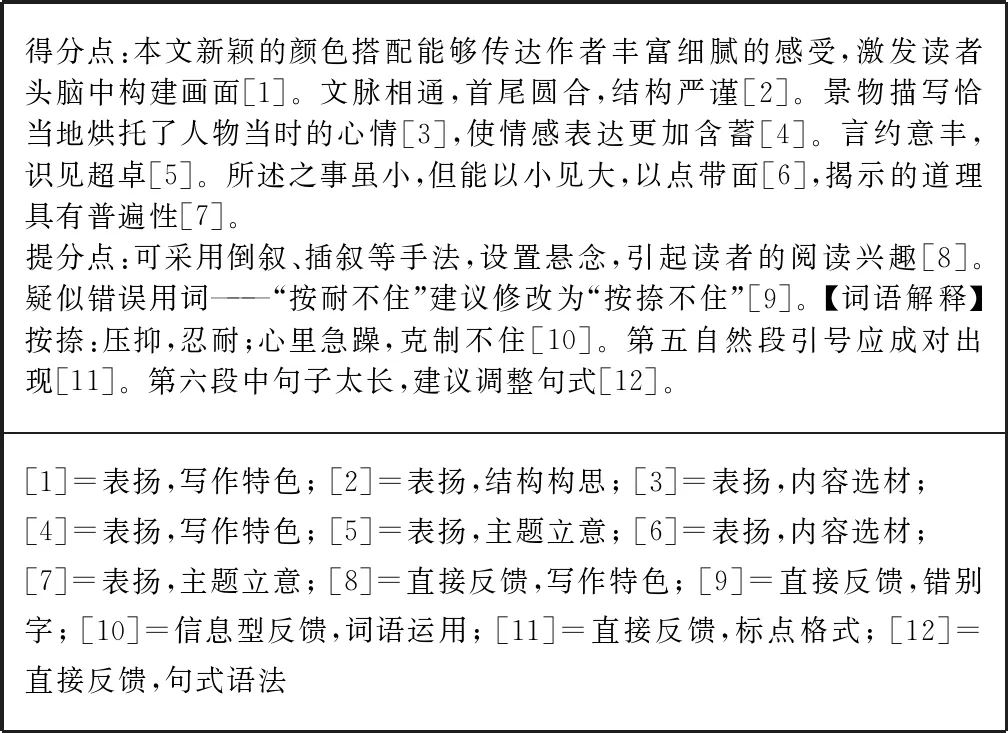

研究者先与B教师交流编码方案,确认其符合中学写作评价习惯;再随机抽取300个反馈单元,各自背靠背完成编码。一致性计算发现,反馈类型的编码一致性为0.91,表示反馈类型的编码一致性高;反馈层次的编码一致性为0.70,表明反馈层次的编码一致性有待改进。对编码分歧项目协商一致后,研究者进一步明确“内容选材”“结构构思”“写作特色”的编码范围。然后研究者和B教师再抽取100个反馈单元进行背对背编码,反馈类型的编码一致性达到0.98,反馈层次的编码一致性为0.81,表明反馈类型和反馈层次编码的一致性比较理想。研究者完成所有反馈单元的编码工作后,由B教师抽取15%的反馈单元进行二次编码验证,二者反馈类型的编码一致性达到0.96,反馈层次的编码一致性达到0.80。作文反馈信息的拆分和编码样例见表三。

表三 作文反馈信息拆分和编码样例

(三)反馈精准度的数据收集与分析

本部分随机抽取20篇作文作为反馈精准度的研究样本。精确度和召回率是广泛应用于信息检索和机器学习领域的度量指标,欧美研究者首先将其应用于智能作文反馈精准度的评估(Liu & Kunnan,2016)。本研究的精确度指系统正确识别项数除以全部识别项数(正确识别项+错误识别项),召回率指正确识别项数除以文本实际错误项数。人机作文评价反馈精准度的检验都使用这两个指标以便互相比较。作文高阶写作技能反馈往往指向主题立意、结构构思等,不宜进行是非判断,因此本研究只关注低阶写作技能的直接反馈信息,它们客观性较强,可以判断正误,更适合精确度和召回率的计算和分析。

已有研究常把教师作文反馈信息作为检验智能作文反馈精准度的标准,但这种检验标准的客观性易引起质疑(Hoang & Kunnan, 2016; Dikli & Bleyle, 2014)。为了建立科学的反馈检验标准,研究者与两位教师合作对20篇作文样本进行错误标注,程序如下:A教师、B教师分别检查初中、高中作文样本,用粗体字全面标注错误点;研究者逐字检验文本内容及相关标注,用斜体字补充或纠正;最后,研究者分别与两位教师交流初中、高中作文的标注信息,用下划线补充标注遗漏信息(见表四)。这一标准将用来检验智能作文反馈的精准度。

表四 作文反馈精准度检验标准生成过程

对20篇样本的人机作文反馈信息分别进行梳理和筛选后,研究者对指向低阶写作技能的直接反馈信息进行正误判断,并根据错误类型统计,计算智能作文反馈的精确度和召回率,并从人机比较的角度进行解释。

五、研究发现

(一)评分有效性

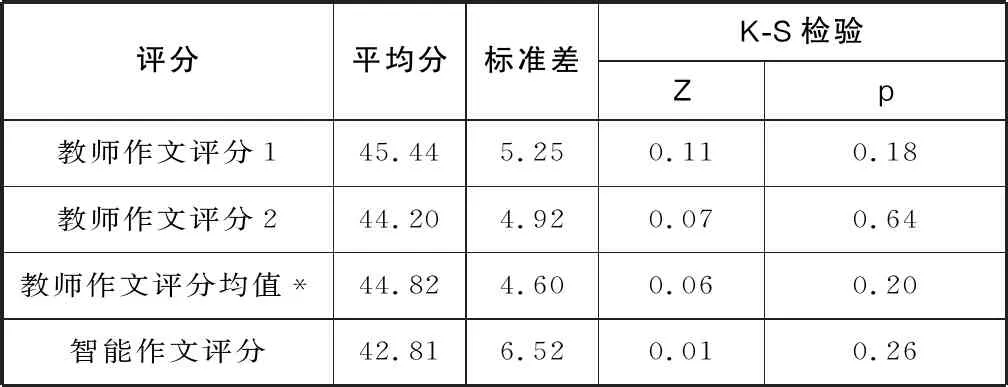

教师作文评分1、教师作文评分2、教师作文评分均值和智能作文评分的Kolmogorov-Smirnov(K-S)检验显著性都大于0.05(见表五),说明四类评分的数据符合正态分布。因此,后续研究可以对其进行相关性和线性回归等统计和分析。

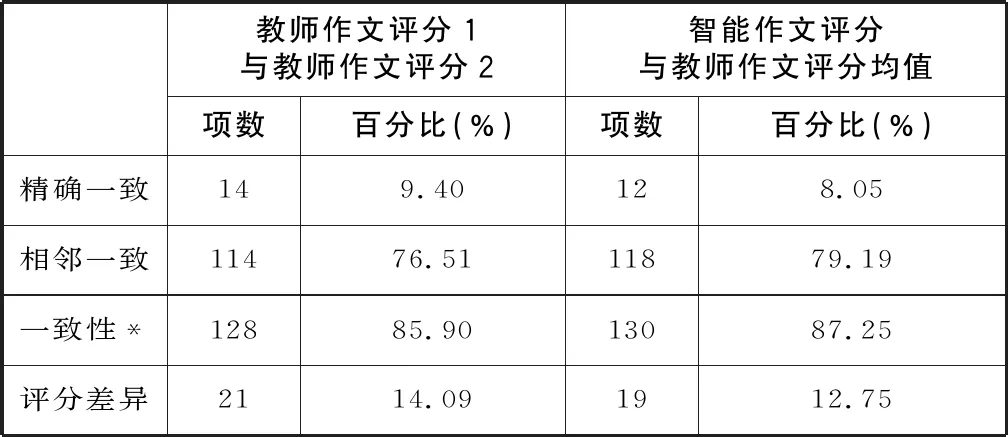

表六显示,智能作文评分与教师作文评分均值之间精确一致的项数(12项)略低于两组教师评分之间的项数(14项),智能作文评分与教师作文评分均值之间具有相邻一致的项数(118项)略高于两组教师评分之间的项数(114项)。从整体看,智能作文评分与教师作文评分的一致性为87.25%,略高于两组教师评分均值之间的一致性(85.90%)。可见,两种作文评价方式在评分方面具有比较高的契合度。

表五 智能作文评分和教师作文评分描述性统计(n=149)

表六 智能作文评分与教师作文评分的一致性(n=149)

皮尔逊相关分析显示,两组教师评分之间的相关系数为0.64,智能作文评分与教师作文评分均值的相关系数为0.63,且二者都在0.01水平上具有显著性。可见,智能作文评分与教师作文评分均值之间和两组教师评分之间都具有强相关性,且相关系数基本持平。

为了检验文章长度对智能作文评分和教师作文评分的预测程度是否有差异,本研究以作文长度为自变量,分别以两种作文评分为因变量进行一元线性回归分析。回归方程的拟合度越接近1,意味着自变量对因变量的预测程度越高。研究者以作文长度为自变量、智能作文评分为因变量进行一元线性回归分析,结果显示,调整后R2(判断方程拟合度的指标)等于0.35,方差分析表明该回归方程具有统计学意义(F=79.99,p <0.05)。回归方程系数为0.03(t=8.94,p<0.01),常量为26.13(t=13.65,p<0.01),两者都具有显著性,且标准化残差P-P图近似正态性分布,符合回归分析的前提。智能作文评分与作文长度之间的回归方程可以列为:y=26.13+0.03x。可以理解为,作文字数每增加1,智能作文评分会上浮0.03,且作文长度对智能作文评分的预测程度为35%。

同样的,以作文长度为自变量、教师评分均值为因变量进行一元线性回归分析,调整后R2为0.29,系数为0.02(t=7.80,p<0.01),常量为34.11(t=24.20, p<0.01),且回归关系具有统计学意义(F=60.79,p<0.01)。从标准化残差图看,数据基本上沿着对角线或对角线方向分布,满足回归模型的正态性假设。因此,教师作文评分与文章长度之间的一元回归方程为:y=34.11+0.02x。由此可知,作文字数每增加1,教师作文评分会上浮0.02,作文长度对教师作文评分的预测程度为29%。

由此可知,智能作文评分与教师作文评分都在一定程度上受到作文长度的影响,回归方程的拟合度分别为0.35和0.30。这说明,文章长度对智能作文评分与教师作文评分的预测度分别为35%和30%,前者略高于后者,但两者相差不多,都处于合理范围内。

(二)反馈类型与层次比较

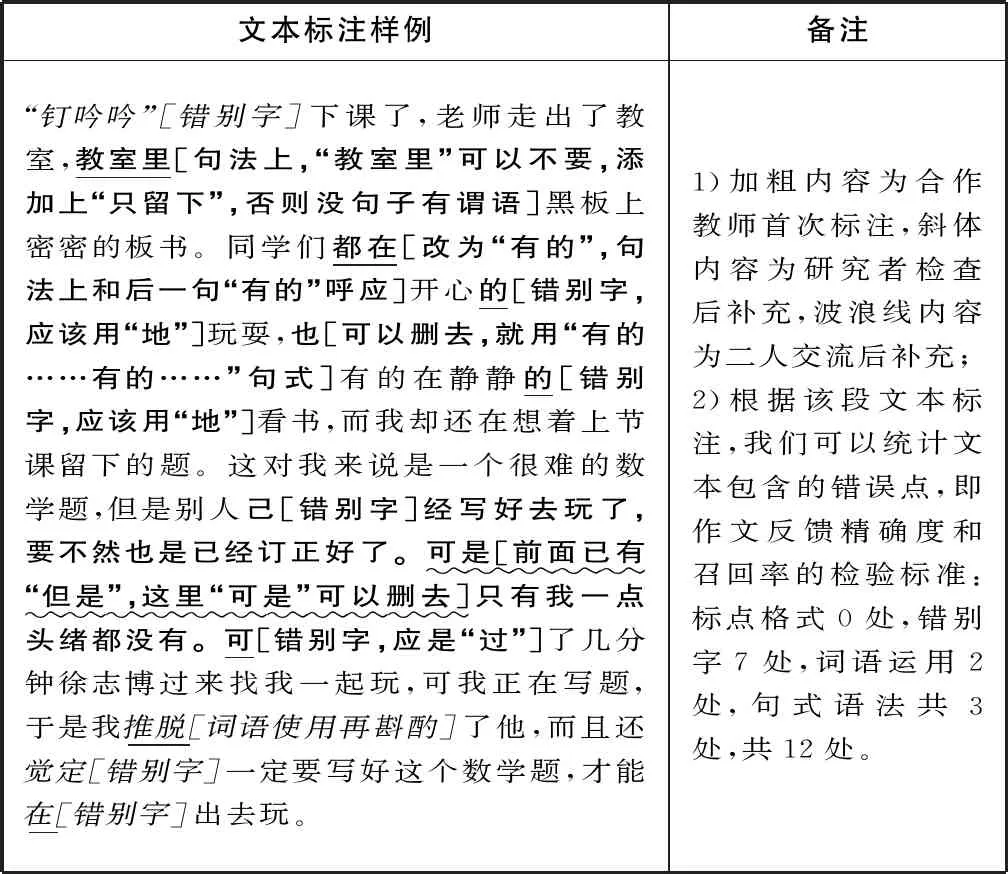

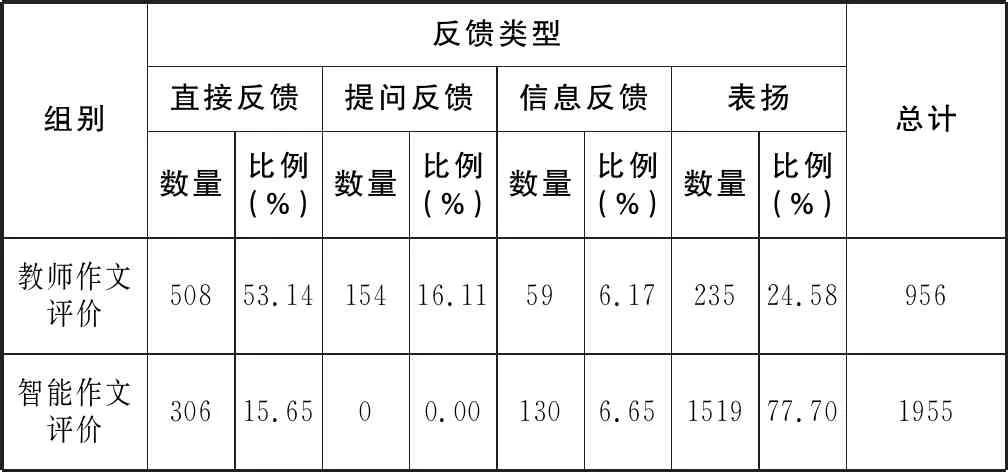

智能作文评价和教师作文评价在反馈类型上各有侧重(见表七)。智能作文评价反馈信息占比最高的是表扬(77.70%),远高于该反馈类型在教师作文评价中的占比(24.58%);直接反馈(15.65%)和提问反馈(0)低于两者在教师作文评价中的比例(53.14%、16.11%)。教师作文评价反馈信息占比最高的是直接反馈(53.14%),信息反馈(6.17%)最欠缺。

表七 智能作文评价不同反馈类型的数量和比例(n=101)

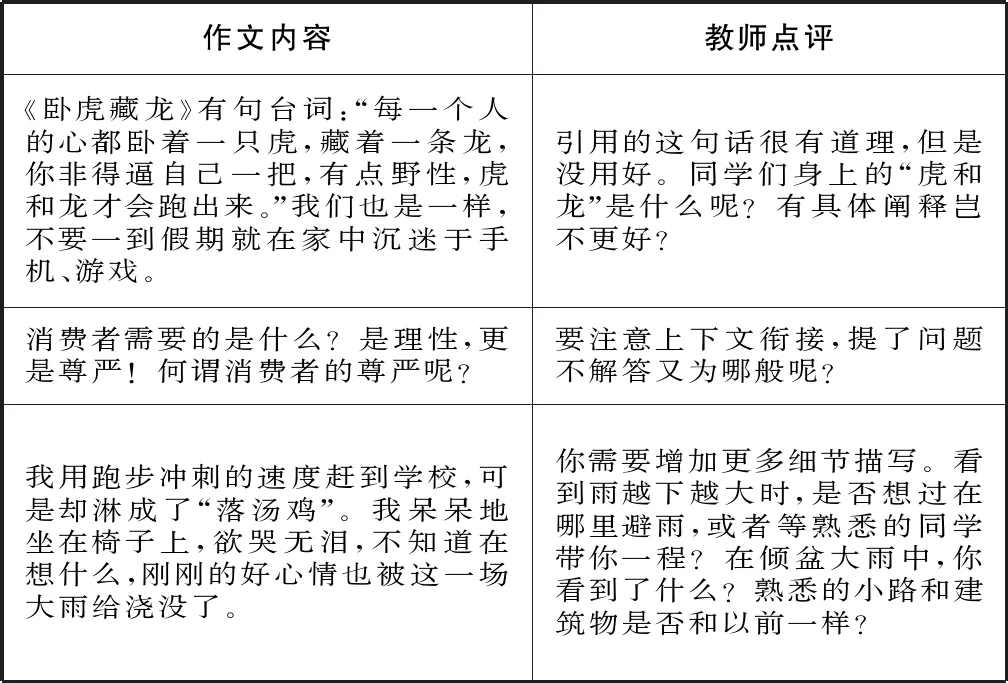

从反馈类型特点看,智能作文评价呈现“直接+信息”反馈的组合特点,教师作文评价常出现“直接+提问”的反馈组合。观察发现,在智能作文评价反馈信息中,直接反馈后通常紧跟信息反馈,且两者内容密切相关(见图1);教师作文评价反馈信息中,直接反馈后往往进行提问,提问内容和直接反馈内容相呼应(见表八)。

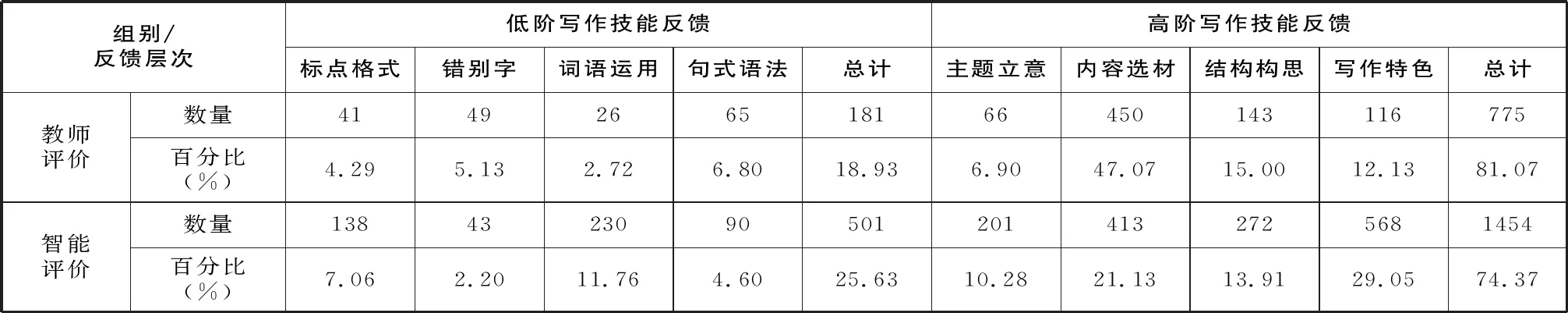

表九 智能作文评价反馈层次的数量和比例(n=101)

表十 智能作文评价反馈精确度与召回率统计(n=20)

表八 教师作文评价 “直接+提问”反馈样例

图1 智能作文评价 “直接+信息”反馈样例

两种作文评价方式的反馈层次呈现以下特点(见表九):1)两种作文评价的高阶写作技能反馈占比都高于低阶写作技能反馈,智能作文评价的高阶反馈占比(74.37%)低于教师作文评价(81.07%)。2)低阶写作技能反馈信息中,智能作文评价占比最高的是词语运用(11.76%),最低的是错别字(2.20%);教师作文评价占比最高的是句式语法(6.80%),最低的是词语运用(2.72%)。3)高阶写作技能反馈信息中,智能作文评价占比最高的是语言特色(29.05%),教师作文评价中内容选材的占比最高(47.07%)。两种评价方式占比最低的都是主题立意(智能10.28%、教师6.90%)。

(三)反馈精准度比较

两种作文评价的反馈精确度和召回率,以及基于错误类型的分类统计数据见表十。智能作文评价的反馈精确度(94.44%)略低于教师作文反馈(95.24%)。在智能作文反馈中,错别字反馈的精确度达100%,其次是标点格式(96%)和句式语法(80%)。教师作文反馈的标点格式、错别字和句式语法的精确度都达到100%,词语运用层面的精确度为80%。可见,两种作文反馈识别的文本错误大多都是客观存在的,识别不准确的概率很低。 然而,智能作文反馈的召回率只有11.89%,这意味着88.11%的文本错误没有被识别。系统在标点格式方面的召回率最高,识别出错率27.59%,其次是错别字(9.38%)和句式语法(4.76%),词语运用层面的召回率为0。教师作文反馈的召回率更低,只有6.99%,说明教师忽略了93.01%的文本错误。教师反馈在错别字方面的召回率最高(18.75%),其他三种错误类型的召回率处于1%-8%之间。两种作文评价的反馈召回率都有较大的提升空间。

六、结论、讨论及建议

通过对智能作文评价效果的多维度探究,本研究的结论对人机协同写作教学的实践与探索具有参考价值。

首先,智能作文评分具有良好的效度。1)智能作文评分与教师作文评分有着较高的一致性和相关性。两种作文评分之间的一致性为87.25%,高于两组教师评分的一致性(85.90%);同时,智能作文评分与教师作文评分均值之间具有强相关性,相关系数(0.64)与两组教师评分之间的相关系数(0.65)基本持平。这说明,智能作文评分与教师作文评分有较高的契合度。这一发现和以往针对E-rater、Intellimetric等英语智能作文评价的调查结果类似(Attali & Burstein, 2006;Foltz et al., 2011),表明国内中文智能作文评价产品在人机评分一致性与相关性方面和国外英语智能作文评价系统相当。2)作文长度对智能作文评分和教师作文评分的影响程度分别为35%和29%,两者相差不大。相比而言,智能作文评分受文章长度的影响略高,这或许是由于系统自带字数统计功能,因而对该因素的变化更灵敏。总之,它们都能综合考虑内容、结构、表达等因素打分,不会过度依赖作文长度,也不会被作文字数“欺骗”。该发现与先前针对My Access的研究发现基本一致(Hoang & Kunnan, 2016),都证明文章长度对智能作文评分的影响没有太大差异。文章长度对IN课堂作文评分的影响处于合理范围内,这也为其评分有效性提供了另一项证据。

其次,智能作文评价和教师作文评价在反馈类型上各有侧重,反馈层次都聚焦高阶写作技能。从反馈类型看,智能作文评价占比最高的是表扬,善于通过句评、段评、总评等对文本给予肯定。大量的表扬预期可以提高学生的写作动机,然而系统的表扬信息来源于语料库的自动匹配,难免程式化和重复,重复表扬也有可能会让学生麻木和产生错觉。同时,智能作文评价中提问反馈是缺失的,说明系统还不能引导学生就具体问题思考,达成深度交流。此外,智能作文评价常出现“直接+信息”反馈,在指出问题后也会提供支持性信息供学习者参考,体现了系统个性化资源推送的优势。

教师作文评价更重视指出并纠正文本错误,直接反馈占比超过一半。然而,教师较少向学生提供信息支持,这或许是由传统的大班教学方式决定的。教师需要指导几十位甚至上百位学生,受时间、精力的限制,教师只能简明扼要地点出每篇作文的问题,后续还要靠讲评、面谈和学生自主学习保证反馈质量,师生后续如果跟进不及时,将会影响作文反馈质量。教师作文反馈出现较多的是“直接+提问”反馈组合,即教师先指出问题,随后用提问激发学生思考,此类反馈多针对内容选材、结构构思等高阶写作技能,是教师对学生的个性化指导和深层交流,体现了教师的不可替代性。

在反馈层次上,智能作文评价和教师作文评价都侧重对高阶写作技能的反馈,但两者侧重点不同。智能作文评价更侧重对写作特色的反馈,着力对文本的修辞、风格进行点评,比如“可采用倒叙、插叙等手法,设置悬念,引起读者的阅读兴趣”“细腻的描写,更生动形象地表现出人物性格”等。教师作文高阶反馈关注最多的是内容选材,比如“故事后半段写水晶球引发的矛盾有点突兀,你可以试着加些说明性文字”“文章围绕你对昆虫的喜爱展开,题材非常新颖有趣”等,基本都会针对文本内容对选材适宜性进行点评。目前,智能作文评价还无法达成对内容和意义的深度理解,只能借助文本特征和语法规则推测学生写作短板并匹配相关资源;而教师可以基于对具体内容的理解提供个性化建议或情感交流,两者存在互补的可能性。值得注意的是,智能作文评价系统的实时反馈功能让它超越单一的评分工具,为学生写作提供过程性支持,对写作教学有重要意义。根据董艳等(2021)对反馈机理的界定,智能作文评价的反馈具有动态性和交互性,它可以获取学生写作和修改文本的行为和认知数据,提供比较全面的反馈建议和学习资源;机器反馈信息给学生后,学生也需要修改,以提交新文本的形式向机器反馈,由此进入新一轮的“写作—反馈—修改”循环。考虑到教师作文评价在情感交流、个性化引导方面有着不可替代性,人机协同的作文评价与反馈在提升学生高阶写作能力和保持学生主体地位方面应该能发挥关键作用。

再次,智能作文评价的反馈精确度与教师作文评价相差甚微,两者都比较高;其反馈召回率高于教师作文评价,两者都有待提升。尽管智能作文反馈精确度略低于教师表现,但已超过WriteToLearn、My Access、Criterion等英语智能作文评价系统的反馈精确度(Hoang & Kunnan,2016;Liu & Kunnan,2016;Dikli & Bleyle,2014),且两者相差甚微,基本持平。IN课堂对文本的错误识别绝大部分都是科学准确的,其反馈精确度已超过智能学习反馈工具对精确度的最低要求90% (Burstein et al.,2003)。然而,IN课堂作文反馈的召回率并不理想,80%以上的文本错误都被忽略,这与英语智能作文评价的反馈召回率还有差距(Hoang & Kunnan, 2016; Liu & Kunnan, 2016 )。英语智能作文评价聚焦语言质量的反馈,侧重对书写、格式、句式语法等低阶写作技能进行纠正性反馈;基于IN课堂的中文智能作文反馈信息的77.77%属于高阶写作技能反馈,它们往往是基于文本特征的整体点评,不就具体问题做诊断。IN课堂的反馈召回率较低,或许与系统研发的侧重点有关,也可能受限于汉语语法结构的复杂性,相关理论和技术还有待突破。即使如此,基于IN课堂的智能作文反馈召回率还高于教师作文反馈,依然呈现出优势。限于时间和精力,教师日常作文批改也会忽视大部分标点、错别字、语法等语言类错误,更多地关注高阶写作技能。因此,基于IN课堂的智能作文反馈对学生有一定的参考价值,可以辅助学生进行写作修改。

当智能技术融入学科教学时,教师的角色和能力将面临全新的挑战(阎志明等,2020)。不过,写作是基于真实情景的社会交流和意义建构,需要以读者为交流对象(Clark, 2010)。因此,智能作文评价尽管有优势,但在它与写作教学融合的过程中,师生间的互动和协作还是教育的核心,教师的地位不会被机器取代(张慧等,2019)。智能作文评价可以成为教师评价的有益补充,它能作为形成性评价工具辅助学生写作,人机协同的写作教学具备实施的可能性(周琴等,2020)。

基于结论,本研究针对智能作文评价及其教学应用提出建议。

(一)产学研应加强合作,确保智能作文评价系统功能完善和用户体验良好

作为典型的人工智能教育应用产品,智能作文评价系统的优化需要多学科、多部门的协同努力。企业在人力、物力、财力投入以及技术研发和产品迭代等方面具有天然优势,是智能作文评价系统研发的主要推动力;学校是智能作文评价系统落地的真实场景,师生的用户体验以及实际需求是企业研发的最重要依据;高校和(或)科研机构的各学科(教育学、心理学、语言学、计算机学科等)专家可以为系统的科学性和合理性提供理论和研究支持。因此,高校、企业、中小学应不断加强合作与交流,各尽其责,群策群力,才能持续推动智能作文评价系统的优化升级。

国内外及本研究结果发现,智能作文评价系统在内容识别与理解、人机交互和写作过程支持等方面还需要优化升级。首先,系统应提高文本错误的识别率,并增强修辞、结构、意义等高阶文本特征的理解程度。智能作文评价全面反馈文本错误,将会切实辅助学生的写作修改过程;系统增强对高阶文本特征的理解,也会有助于实现真正意义上的个性化作文反馈与指导。其次,系统可考虑提供多元交互的写作评价平台。智能作文评价如果能支持师生和生生交互,增加同伴协作写作、同伴作文互评等功能,会让作文反馈更多元化,发挥写作的交流功能,提升学生作为反馈主体的能动性,增强读者意识。最后,系统可以开发更多的写作支持工具和课程资源。写作支持工具可以是辅助写作构思过程的思维导图;课程资源最好采用文本文档、课件、微视频等多种形式,内容上可以聚焦不同文体的写法指导和同题作文点评等。

(二)学校应创设条件,鼓励教师人机协同的写作教学实践

虽然研究发现智能作文评价在评分有效性、反馈类型与层次和反馈精准度等维度表现良好,但作为前沿的教育创新产品,要得到广大语文教师的认可和接受,还需要一个过程。人机协同的写作教学创新实践对传统语文老师有一定的挑战,写作教学的任务设计、活动组织和成果评价等都需要调整,要求教师能整合学科、技术以及教学法等知识,并努力探寻人机协同教学场景下的新规律。作为教学创新过程的重要把关者和促进者,学校管理者、教科研职能部门和学科教研组等都发挥着不可替代的作用。学校可以组织专题培训深化教师对人机协同写作教学的认识和理解,培训可以是专题讲座、工作坊、听评课等多种形式,并融入以下几方面的内容:第一,介绍智能作文评价的设计原理和评分规则。学校可联合开发公司开展讲座,拉近教师与智能技术的距离,消除教师的偏见和误解。第二,分享智能作文评价的教学应用案例,加强教师对智能技术的信念和认知。第三,指导教师分析和解释系统生成的各种数据,培养教师基于数据教学决策的能力。智能作文系统生成的学习行为和结果等数据只有经过科学的解释和分析,才能对后续教学产生正向影响。第四,探讨智能作文评价系统的科学管理模式。学生需要使用电脑、平板和手机等电子设备,必然面临家校沟通、亲子关系和家庭教育等问题,因而教师引导学生科学使用智能终端至关重要,也是家长给予支持的前提条件。

此外,智能作文评价要融入各级各类系统,还需要学校管理者与时俱进,为广大师生创设富含人工智能技术支持的智慧校园学习环境。学校要尽力为师生提供学习终端、无线网络、云服务等设施,为大规模教育中的个性化学习提供技术和环境支持。考虑到人机反馈与互动很有可能在家中进行,学校需要做好家校沟通工作,让人机协同作文评价顺利实施;同时,管理者应给予语文教师对学科教学、教法和教材更多的决策权,创设包容开放的教学和工作环境,通过各种激励政策和措施鼓励语文教师能够且敢于进行写作教学领域的创新和变革。

(三)语文教师应勇于实践,积极探索人机协同写作教学的规律和路径

作为语文学科的核心内容之一,写作具有很强的实践性和交互性,教师评价及反馈对学生写作能力提升有着不可或缺的作用。然而,教师批改过程费时费力、反馈效果欠佳;智能作文评价能为大量学生提供作文“秒”评价和“秒”反馈,大大缩短学生“写作—评价(反馈)—修改”过程,提高作文修改的效率和效果。因此,语文教师应抱着开放的心态,勇于尝试智能辅助工具,感受智能技术变革教学的力量。不过,人机协同环境下的写作教学的规律和特点,也会给语文教育者带来新的挑战:在学生与智能作文评价系统互动前、互动中和互动后,教师应如何引导学生?教学内容和程序应怎样调整?写作任务如何设计才能发挥人机协同的最大优势?这些问题都有待语文老师的探索和思考。

人机协同的写作教学有以下两种可能的路径:第一,对日常习作落实人机协同评价。学生完成初稿后,先借助机器反馈完成初次修改,同伴互评后再次修改,最后提交给教师。教师通过智能作文评价系统完成最终评价,或者引导学生开启下一轮的写作修改。人机协同评价让学生得到的反馈更多元,更有可能促进学生写作质量的提升。机器即时评价会强化学生修改过程,大量表扬也能激发学生的写作内在动机;同时,教师评价可以提供更个性化的建议和指导,提升写作评价的精准度。第二,对学生假期写作提供人机协同支持。在传统的假期中,由于时空隔离等因素,教师很难监控学生完成写作并给予指导,后期批改反馈多流于形式,效果欠佳。在人机协同支持的假期写作评价中,教师通过系统发送写作任务并进行构思点拨,还可以规定最低提交分数;学生完成初稿后,借助机器反馈修改完善后提交给教师,教师分析学生班级和个体的学情报告,对学生进行个性化指导,培养学生的元认知能力。

综上所述,中文智能作文评价是认知心理学、计算机科学、教育测量、语言学等多个学科交叉融合的产物,为写作教学注入了新生力量。本研究通过智能作文评价的多维度比较,发现智能作文评分及其反馈信息对师生都有较高的参考价值,为教师与智能作文评价的人机协同教学提供依据。当然,智能作文评价系统也存在问题,面临诸多理念和技术层面的挑战。随着各学科的交叉融合和发展,智能作文评价的评分效度和反馈质量也一定会不断提升,为个性化写作教学与评价创造更多可能。在“智能+”时代,语文教育者应积极探索人机协同写作教学的最佳路径,寻求师生与智能作文评价系统共处与互动的合宜方式。