基于F3Net显著性目标检测的蝴蝶图像前背景自动分割

黄世国, 洪铭淋, 张飞萍, 何海洋, 陈亿强, 李小林,*

(1.福建农林大学, 生态公益林重大有害生物防控福建省高校重点实验室, 福州 350002;2.福建农林大学, 智慧农林褔建省高校重点实验室, 福州 350002)

蝴蝶属于鳞翅目昆虫,其种类众多,人工鉴定费时费力,基于计算机视觉的昆虫自动识别则是解决这些问题的关键技术(黄世国等, 2010; 竺乐庆和张真, 2013; 竺乐庆等, 2015)。但昆虫图像中的背景会严重干扰计算机自动识别昆虫的性能(Norouzietal., 2014; Jingetal., 2020)。为了消除干扰,一些学者应用传统的图像分割方法分割出昆虫的前背景(程小梅等, 2008; 黄世国等, 2008; 刘国成等, 2015)。同时,基于深度学习的语义图像分割技术也已用于解决鳞翅目昆虫图像的自动分割问题(竺乐庆等, 2018),其分割效果优于传统方法。这些研究主要处理昆虫标本图像数据,这些图像背景单一,目标种类数量易确定,采用基于深度学习的语义图像分割技术可以获得良好的图像分割结果。但由于蝴蝶野外栖息环境多样,拍摄的蝴蝶图像背景复杂,目标的种类数量难以确定,易造成分割准确性下降。因此,基于深度学习的语义图像分割较难解决背景复杂的蝴蝶图像的前背景分割问题。

显著性目标检测(也称为显著性目标分割)是一种二分的图像分割技术,把图像中的目标分为显著性目标和非显著性目标,不需要指定图像中目标的种类数量。传统的显著性目标检测技术一般基于人工设计的特征(如颜色、纹理和边缘梯度)及其组合(张鹏和王润生, 2004; Chengetal., 2014; Chengetal., 2015),但特征设计的过程复杂,得到的显著性目标边缘较模糊且不准确,需要复杂的图像后处理方法才能得到较好的分割结果。

随着全卷积神经网络技术的发展,许多学者提出了基于该结构的深度学习显著性目标检测算法。围绕如何得到具清晰边缘的显著性目标,不同的学者提出了多种不同层次的特征融合方法,并加入明确的边缘特征信息以及不同的评价方法,有效地提高了前背景分割的效果(Wangetal., 2016; Liuetal., 2018; Wangetal., 2018; Zengetal., 2018; Wuetal., 2019; Zhaoetal., 2019)。F3Net算法除了考虑上述方法外,提出了级联解码器的新框架,并采用反馈机制对每个层次的信息进行补充,得到了良好的显著性图(Weietal., 2020)。

本研究以具复杂背景的蝴蝶图像作为昆虫前背景自动分割的例子。其分割的目的是将蝴蝶和其背景区分开,形成前景区域即蝴蝶区域和背景区域。该目的和显著性目标检测的目的是一致的,也就是将显著性目标检测中的显著性区域和蝴蝶区域对应,将非显著性目标区域和背景区域对应。本研究旨在探索利用F3Net显著性目标检测算法实现蝴蝶图像前背景自动分割,为野外调查拍摄的昆虫图像自动分割提供新的技术解决方案。

1 材料与方法

1.1 蝴蝶图像数据集

利兹蝴蝶数据集为开源数据集,包含10种蝴蝶(分别为黑脉金斑蝶Danausplexippus、黄条袖蝶Heliconiuscharitonius、艺神袖蝶Heliconiuserato、鹿眼蛱蝶Junoniacoenia、红灰蝶Lycaenaphlaeas、丧服蛱蝶Nymphalisantiopa、美洲大芷凤蝶Papiliocresphontes、白粉蝶Pierisrapae、优红蛱蝶Vanessaatalanta、小红蛱蝶Vanessacardui)(Wangetal.,2009)。每种蝴蝶的图像数量不等,每个种最少有55幅,最多有100幅,共832幅蝴蝶图像。拍摄的图像大部分为野外拍摄的照片,图像背景复杂。图1展示了该数据集中部分原始图像(上行图)及其对应的前景蒙板(下行图)。

图1 蝴蝶图像及其前景蒙板示例

1.2 F3Net模型结构

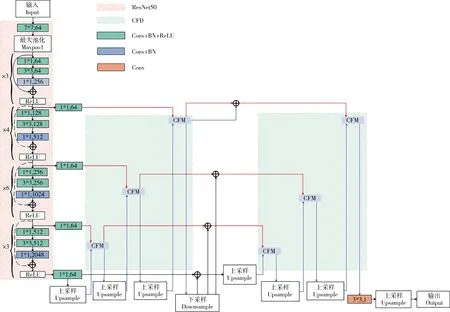

本文使用的F3Net算法是最近提出的显著性目标检测算法(Weietal., 2020)。F3Net模型采用ResNet50作为主干。对于大小为H×W的输入图像,ResNet50在5个级别上提取其特征,用分辨率来表示{fi|i=1,…,5}。由于低阶特征耗费计算资源多,对性能影响较小,因此,F3Net仅使用4个层即f2,f3,f4和f5,作为显著性目标检测的骨架。其结构如图2中左边粉色区域所示。

图2 F3Net的网络结构图

ResNet50可以提取图像的低层特征(记为FL)和高层特征(记为FH)。低层特征保留了丰富的细节和背景噪声,具有清晰的边缘;高层特征则保留了目标的轮廓,但丢失了边缘消息。对上述4个层进行交叉特征模块(cross feature module, CFM)、级联反馈解码器(cascade feedback decoder, CFD)和像素感知损失(pixel position aware loss, PPAL)等处理。不同模块之间的交互见图2。

CFM通过不同层的信息融合实现信息互补,得到具清晰边缘的显著性图。具体步骤是:(1)对3×3卷积处理过的不同层次的特征,分别进行卷积、批归一化和ReLU激活;(2)对第1步处理过的特征做元素乘法操作,得到FL和FH的公共部分(记为FC);(3)对FC做卷积、批归一化和ReLU激活;(4)对第3步的结果应用元素加法分别与FL和FH进行融合。经上述4个步骤,不同的层可以相互吸收有用的信息,抑制低层的噪声,锐化高层的边缘。其结构模块见图3。

图3 CFM模块

CFD模块由多个解码器构成,前一个解码器的输出作为后一个解码器的输入。在每个解码器中,采用自底向上策略通过CFM模块逐步融合高层次特征和较低层次特征,直至最低层得到显著性图。对该显著性图采用自顶向下的策略经下采样后与每层处理过的特征做元素加法,然后将结果作为下一解码器的输入。

(1)

(2)

其中:第一项对应于所有子解码器损失的平均值,第二项对应辅助损失的加权和,其中高层损失因误差较大而给予较小的权重。

在本研究中,考虑到本数据集中蝴蝶的图像数量较少,也研究了F3Net和迁移学习相结合的方法。此时,假设主干网络部分的参数已经是最优的,即不需要对主干网络的参数进行训练和修改,而仅训练F3Net模块进一步提高算法的预测性能。

1.3 分割结果评价标准

为了全面评价前背景分割结果,我们用精度、召回率、F测度、平均绝对误差(MAE)、S测度、E测度和平均IoU 7个指标来评价分割结果。

精度(precision)的计算公式如下:

(3)

其中:TP表示真阳,是指实际为前景预测也为前景的像素个数;FP表示假阳,是指实际为背景而错误预测为前景的像素个数。

召回率(recall)的计算公式如下:

(4)

其中:FN表示假阴,是指实际为前景而错误预测为背景的像素个数。

F测度(F-measure)的计算公式如下:

(5)

其中,β2=0.3。

平均绝对误差(mean absolute error, MAE)的计算公式如下:

(6)

其中:H和W分别表示图像的长度和宽度,P和G分别表示预测显著性图和前景蒙板。

S测度(S-measure)(Fanetal., 2017)的计算公式如下:

Sm=α·So+(1-α)·Sr

(7)

其中,α=0.5,So和Sr分别用于计算目标结构相似性和区域结构相似性。

E测度(E-measure)(Weietal., 2018)的计算公式如下:

(8)

IoU的计算公式(Rahman and Wang, 2016)如下:

(9)

2 结果

2.1 分割效果的定量评价

F3Net算法在Ubuntu系统的PC机上使用Pytorch框架实现,CPU为Intel(R)Xeon(R),内存为12 GB。GPU为Tesla T4,显存为16 GB。为了比较F3Net在蝴蝶前背景图像分割中的性能,我们用了几种2017年以来提出的基于深度学习的显著性目标检测算法进行对比。这些算法分别为EGNet(Zhaoetal., 2019), SCRN(Wuetal., 2019), ASNet(Wangetal., 2018), lps(Zengetal., 2018)和PiCANet(Liuetal., 2018)。鉴于FCN语义分割算法已用于昆虫标本图像前背景分割中(竺乐庆等, 2018),本文也给出了该算法对具复杂背景的蝴蝶图像的分割结果及平均IoU、最大IoU和最小IoU值。根据显著性目标检测算法一般采用DUTS-TR数据集(Yangetal., 2013)预测其他数据集,本研究利用该数据集作为训练集得到训练模型,然后将该模型用于预测蝴蝶数据集的前背景。进一步,为了符合蝴蝶图像数据的特点,从利兹数据集的832张蝴蝶图像中随机选取其中582张图片作为训练集,剩余的250张为测试集。将迁移学习方法用于F3Net(记为F3NetTL),保持ResNet50主干网络不变,使用训练集对CFM, CFD和PPAL模块重新训练得到新的预测模型,然后用该模型分割蝴蝶图像前背景,设计参数batch为4,epoch为32。

分析结果(表1)表明,基于深度学习的目标检测算法在不同的指标上均获得了较好的效果(除平均绝对误差值越小表示性能越好外,其他指标值越大表示性能越好)。从表1可知,S测度值最小均在0.90以上,E测度值则在0.91以上,F测度和精度值除了ASNet低于0.90以外,其他均在0.90以上,平均IoU值均在0.81以上,MAE值则均在0.06以下。这说明上述这些算法用于蝴蝶图像的前背景分割时均获得了较好的分割效果,证明了显著性目标检测算法用于前背景分割是可行的。同时,与FCN语义分割算法在IoU指标上进行比较,发现所有的显著性目标检测算法其平均IoU值均在0.8以上,最大IoU值均在0.96以上,最小IoU值均在0.34以上。而FCN语义分割算法的平均IoU值仅为0.703,最大和最小IoU值仅分别达到0.840和0.233。这说明FCN语义分割算法在处理具复杂背景的蝴蝶图像分割时性能有待进一步提高。

表1 不同显著性目标检测算法以及FCN语义图像分割的性能比较

进一步比较F3Net和其他5种算法的性能。由表1可知,F3Net在各项指标上均获得了更优的性能,如F3Net算法7个指标S测度、E测度、F测度、平均绝对误差、精度、召回率和平均IoU(除了最大IoU和最小IoU)值分别为0.940, 0.945, 0.938, 0.024, 0.929, 0.978和0.909,与ASNet相比分别改进了0.038, 0.030, 0.069,-0.033, 0.056, 0.056和0.098。

由于F3Net的性能优于其他5种算法,对其进一步比较使用迁移学习后的效果。从表1可知使用F3NetTL后性能得到了进一步提升(除召回率略有降低外)。F3NetTL在上述7个指标(除了最大IoU和最小IoU)比F3Net分别改进了0.021, 0.019, 0.025,-0.011, 0.036,-0.011和0.029。这说明结合迁移学习的F3Net算法有效提取了蝴蝶图像的特征,从而进一步提高了前背景自动分割的性能。

2.2 分割效果的定性分析

图4给出了蝴蝶图像测试数据集的前背景自动分割结果。该图中第1列为原图像,第2列为手工标注的前景蒙板即去除了背景后的参考标准图像。第3列为结合迁移学习的F3Net算法(F3NetTL)的分割结果,第4-10列分别为F3Net, ASNet, EGNet, SCRN, lps, PiCANet和FCN语义分割的结果。从FCN语义分割结果(第10列)可以看出该算法将前背景分为两类后,只得到了不完整的昆虫图像分割结果,且内部产生碎片,无法准确得到具复杂背景的蝴蝶图像分割结果。从前3行第4-9列可以看出所有的6种算法均获得了较好的前背景分割结果,这说明显著性目标检测算法将蝴蝶图像分为显著性目标和非显著性目标较好地对应了蝴蝶图像前背景自动分割的问题。同时,从第4-5行的第4-9列可知用公共数据集训练的模型有时会把图像中的其他显著性目标和蝴蝶目标产生混淆,此时,应用F3Net的预测效果不理想。从第4-5行的第3列和第4列比较可知,结合迁移学习算法的F3NetTL由于重新训练了显著性目标检测网络,将错误的显著性目标从蝴蝶前景中去除,得到了比F3Net更好的图像分割效果。为了进一步说明迁移学习的性能,选取了F3Net中IoU最小的两幅图像,比较其采用迁移学习前后的效果(图5)。由图5可知,原图像存在多个显著性目标,其区域面积甚至比蝴蝶所占面积大,导致其分割效果很差(见图5第4列),应用迁移学习后则得到了很好的图像分割效果(见图5第3列)。

图4 蝴蝶图像前背景分割结果的定性比较

图5 最小IoU值图像的迁移学习性能

3 讨论

具有复杂背景的蝴蝶图像前背景自动分割难以用传统的图像分割算法或者基于深度学习的语义图像分割算法实现。本研究应用显著性目标检测算法,将显著性目标和非显著性目标分别和蝴蝶区域和背景区域对应,很好地解决了以往研究需事先给定待分类类别数量的难题。对蝴蝶图像数据集分割的定量分析和定性分析结果表明基于深度学习的显著性目标检测算法均能较好地分割出蝴蝶图像前背景,其中F3Net在所有的指标上表现最优,其7个指标S测度、E测度、F测度、MAE、精度、召回率和平均IoU值分别达到了0.940, 0.945, 0.938, 0.024, 0.929, 0.978和0.909。而FCN算法较难获得好的分割效果。同时,结合迁移学习的F3Net算法进一步提高了分割效果的准确性,其上述7个指标值分别进一步达到了0.961, 0.964, 0.963, 0.013, 0.965, 0.967和0.938,其分割效果可以达到人工标注的水平。本研究为野外拍摄的蝴蝶图像前背景自动分割提供了新的技术解决方案。由于显著性目标检测主要关注显著性区域和非显著性区域,本方法较FCN等非卷积网络方法可以用于更多种类的蝴蝶图像分割。同时,该方法也可以方便地用于其他种类昆虫的自动分割。本研究提出的方法为后续的昆虫自动识别消除了背景干扰,可以进一步提高昆虫分类识别的性能,为昆虫多样性野外调查过程中的昆虫识别提供了有力的预处理步骤。同时,本研究也拓宽了显著性目标检测算法的应用范围。

- 昆虫学报的其它文章

- 利用CRISPR/Cas9系统检测果蝇细胞中组蛋白甲基化修饰对20E信号传导的调控

- 孤雌产雌生殖品系松毛虫赤眼蜂产卵强度对Wolbachia诱导的其生殖表型的影响

- Biology and management of the litchi stink bug, Tessaratoma papillosa(Hemiptera: Tessaratomidae):Progress and prospects

- 家蚕鞣化激素基因对翅展及繁殖力的调控作用

- 朱砂叶螨硒代谢通路基因筛选及硒磷酸合成酶TcSPS1的原核表达和特性分析

- 球囊菌侵染对意大利蜜蜂幼虫肠道免疫与解毒相关基因表达及蛋白质、脂质和糖类含量的影响