基于强化学习的雷达干扰决策技术综述

朱霸坤, 朱卫纲, 李 伟, 杨 莹, 高天昊

(航天工程大学,a.研究生院; b.电子与光学系,北京 101000)

0 引言

随着数字波束成形技术、数字T/R组件技术等软硬件的成熟,相控阵雷达、数字阵列雷达相继诞生,多功能雷达随之出现。同时,脉冲压缩、频率捷变、脉冲多普勒等对抗干扰技术被运用于雷达,增强了雷达的抗干扰性能。多功能雷达快速的天线波束扫描能力和灵活的多波束形成能力结合强大的人工智能技术使得多功能雷达的检测、跟踪和抗干扰能力进一步提高,多功能雷达逐渐具备初步的智能性。面对抗干扰性能日益强大而且还具备一定智能性的多功能雷达,传统的干扰措施越来越难以发挥作用。

在这种情况下,认知电子战出现并迅速发展。美国发布了一系列的认知电子战项目,典型的包括自适应电子战行为学习(BLADE)项目、自适应雷达对抗 (ARC)项目和反应式电子攻击(REAM)项目等,旨在提升电子战装备的快速反应能力和自适应能力。认知电子战是“认知”理念与电子对抗技术的结合,“认知”即模仿人类进行信息加工和知识应用的过程。认知电子战涉及的关键技术包括认知侦察技术、认知干扰策略优化和实时干扰效果评估技术[1]。其中,认知侦察技术和实时干扰效果评估技术为认知干扰策略优化提供了数据支撑,而认知干扰策略优化是认知电子战系统进行自适应对抗的体现,也是认知电子战技术的核心优势[2]。认知干扰策略优化的一个重要内容就是进行干扰决策,即在雷达对抗系统中能够通过威胁目标感知建立雷达状态与干扰样式之间的最佳对应关系。在认知电子战领域,利用强化学习算法进行干扰决策是研究的热点之一,强化学习通过“试错”不断地与环境进行交互,从环境中获得反馈来修正决策的模型,进而得到最优的行为策略,这在某种程度上体现了“认知”的思想。因此,将强化学习运用于雷达干扰决策有望实现对多功能雷达的认知干扰。

1 传统的雷达干扰决策方法

根据干扰决策方法是否具有自适应和自学习的能力,将雷达干扰决策方法分为传统的干扰决策方法和基于强化学习的雷达干扰决策方法。传统的干扰决策方法相比于基于强化学习的方法不具备自适应和自学习的能力,更加依赖于先验的知识。更进一步,根据具体决策原理的不同,将传统的雷达干扰决策方法分为3类:基于模板匹配的干扰决策方法、基于博弈论的干扰决策方法和基于推理的干扰决策方法,本章的主要内容就是分析讨论这3类方法。

1.1 基于模板匹配的干扰决策方法

模板匹配是一种最基本的模式识别算法,通过比对待识别样本与模板库中样本的相似性来进行识别。在雷达辐射源信号识别中,常用样本间的距离来衡量信号样本间的相似性[3-4],主要包括:

1) Minkowsky距离

(1)

2) Manhattan距离

(2)

3) Euclidean距离

(3)

4) Camberra距离

(4)

5) City Block距离

(5)

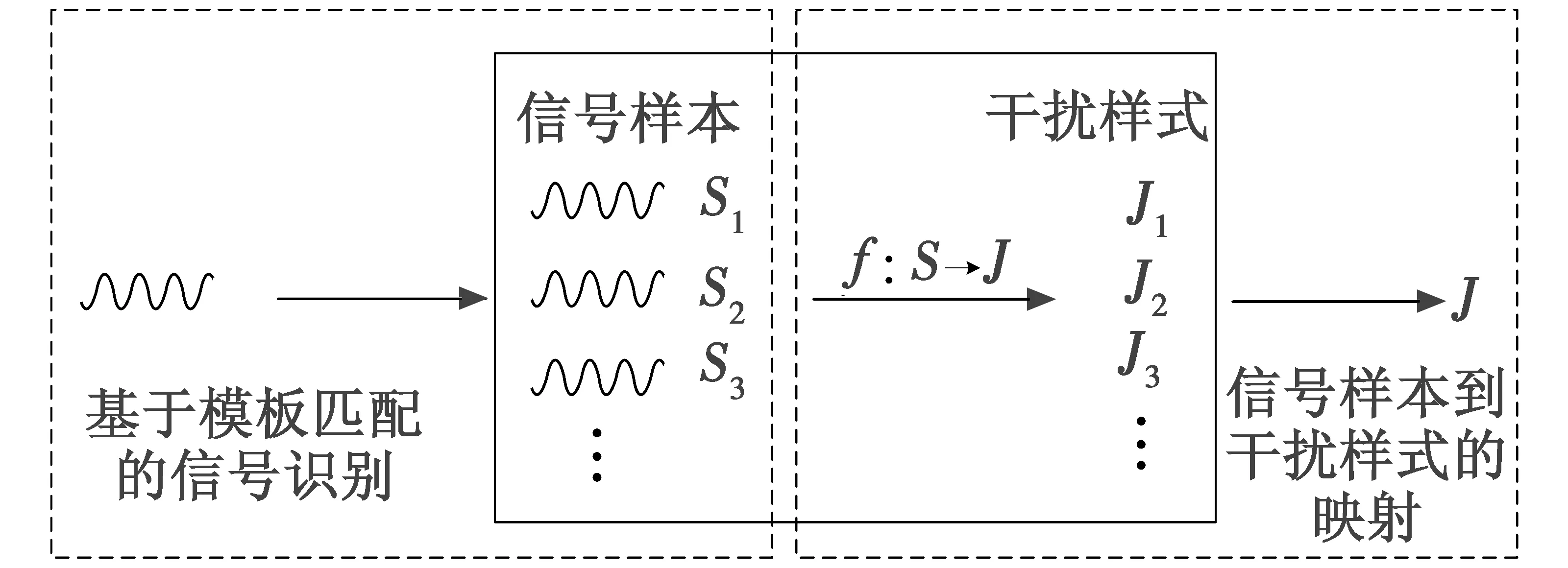

在基于模板匹配的干扰决策方法中,需要在实施干扰前构建一个干扰知识库,其中存储了威胁对象信号样本和每个样本对应的最佳干扰样式。在进行干扰决策时,将侦察到的雷达信号与干扰库中的信号样本进行比对,进而选择与雷达信号相似度最高的信号样本对应的干扰样式,基于模板匹配的方法操作流程简单,适用范围广。如图1所示,基于模板匹配的干扰决策方法由基于模板匹配的信号识别和信号样本到干扰样式的映射两部分组成,因此,该方法的干扰有效性主要受到两方面因素影响,即信号识别的精度以及信号与干扰间的映射关系是否准确。对雷达信号识别目前已有了较多的研究[5],相关技术相对成熟,而信号与干扰样式间映射关系的获得则比较困难,需要长时间、大量的先验数据积累,并且随着电磁环境的日益复杂,新信号体制雷达的推陈出新,相关工作会变得更加困难。

图1 基于模板匹配的雷达干扰决策Fig.1 Radar jamming decision-making based on template matching

1.2 基于博弈论的干扰决策方法

博弈论是研究对抗相关问题的一种数学理论和方法。通常将雷达对抗的过程构建为一个零和博弈的模型,然后通过博弈论的方法解决干扰决策的问题。一个博弈论模型包括局中人、策略集、盈利函数(矩阵)3个要素。在雷达对抗中,局中人是对抗的双方,即雷达和干扰机;策略集是对抗双方可以采取的策略的集合;盈利函数,决定了对抗双方在每一次博弈中获得的收益。表1为干扰方选择某一干扰样式后,干扰方获得的盈利值[6]。

表1 盈利矩阵Table 1 Profit matrix

基于博弈论的干扰决策方法直观体现了雷达对抗中双方的博弈过程,但也存在着3个不容易解决的问题:1) 博弈论的目标是博弈双方达到纳什均衡,但纳什均衡下的干扰策略不一定是最优的干扰策略;2) 博弈论的一个前提假设是博弈双方都是绝对理性的,这个建模的前提在雷达对抗问题中过于苛刻;3) 基于博弈论的干扰决策方法高度依赖于盈利函数(矩阵)的构建,而盈利矩阵(函数)的构建缺乏相关理论的指导,目前主要是依靠专家经验来获得,这限制了博弈论方法的推行。前两个问题的解决有赖于对博弈论模型的进一步研究和改进。针对第三个问题,文献[7]提出了基于干扰效果和干扰效率的干扰效能评估方法,利用干扰效能函数构建盈利矩阵;文献[8]提出用经验法和模糊函数两种方法来获取盈利矩阵,在一定程度上可以解决盈利矩阵(函数)构建的问题,但这两种方法的适用范围是有限的,并且需要依赖于其他的先验信息。

1.3 基于推理的干扰决策方法

基于推理的干扰决策方法将雷达对抗的过程分解为离散的事件集,然后再利用D-S证据理论或者贝叶斯网络从历史事件中分析事件的相关性或者因果性,推理出未来在一定的条件下某个事件(如干扰成功)发生的概率,进而进行决策。根据推理方法的不同,分为基于D-S证据理论的干扰决策方法和基于贝叶斯网络的干扰决策方法。

D-S证据理论可以直接处理不确定的信息,运用融合算法处理不确定性,通过不确定性推理,从不确定信息和不完整信息中得到可能性最大的结论。对于一个决策问题,结果中所有可能事件用有限集合Θ表示,称Θ为一个识别框架。若有集函数m:2Θ→[0,1]满足:m(φ)=0且∑m(A)=1,则m为Θ上基本概率分配函数,又称mass函数,其中,A为事件或者事件的集合,称为焦元,m(A)为A的基本可信度。对A的信任度用信任度函数表示,计算方法为:Bel(A)=∑m(B)。对于∀A⊆Θ,识别框架Θ上的有限个mass函数m1,m2,…,mn的合成规则为

(m1⊕m2⊕…⊕mn)(A)=

(6)

实际战场上的信息往往具有很大的不确定性,利用D-S证据理论合成能降低信息的不确定性,增加决策的准确性[9]。但证据的合成计算量大,随着事件数的增加,计算量呈指数级增加,在情况复杂的多功能雷达干扰决策问题中不容易实现。

在基于动态贝叶斯网络的干扰决策方法中,雷达对抗过程被描述为一个随时间变化的动态贝叶斯网络,通过一系列的转移矩阵来描述雷达工作状态、环境信息和干扰样式间的相互作用关系,最后,利用从大量统计样本中学习到的贝叶斯网络模型计算干扰成功的概率,进而做出决策。文献[10]对飞行器自卫干扰的过程进行了基于动态贝叶斯网络的建模,仿真结果表明,飞行器能根据与雷达之间的距离推测雷达的工作状态,进而选择合适的干扰样式,但该方法要想成功运用,需要构建准确的模型和大量先验的统计样本。

上文讨论的3类传统的干扰决策方法虽然各具特点,但它们无一例外地都需要大量的先验数据作为决策的支撑。而多功能雷达的波形灵活多变,自适应能力强,因此,依靠对大量先验数据进行统计或者分析进而得到干扰策略的方法面临着先验数据获取困难、干扰决策的时效性和有效性低的问题。而基于强化学习的干扰决策方法具备传统方法所不具备的“认知”能力,能够在缺少先验数据的情况下,通过不断的“试错”修正决策模型,进而得到最佳的干扰策略。

2 基于强化学习的雷达干扰决策方法

基于强化学习的干扰决策方法所适用的威胁对象是具备一定智能性的多功能雷达,所以在本章中,先介绍了多功能雷达的信号模型和强化学习的基本原理,然后再对当前基于强化学习的雷达干扰决策相关研究进行综述和分析。

2.1 多功能雷达的信号模型

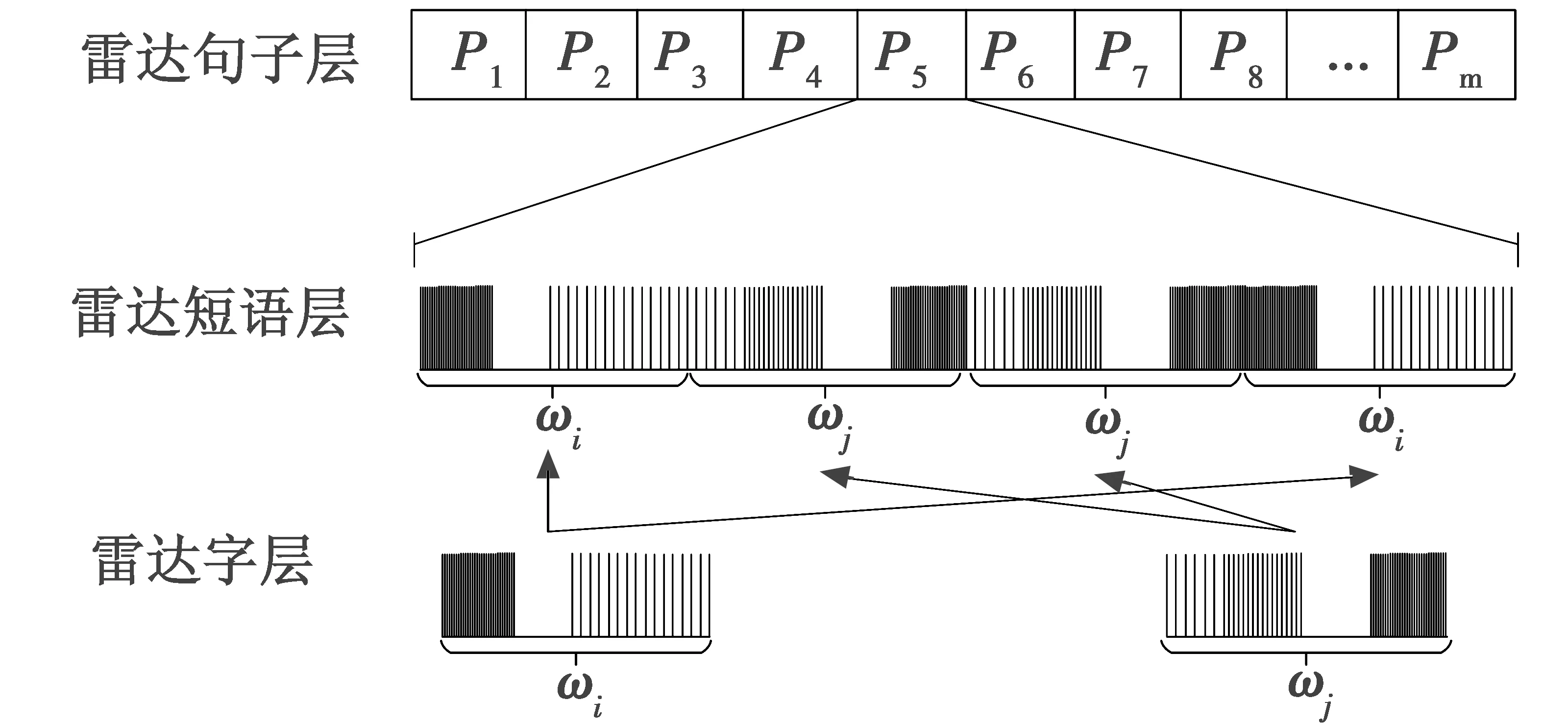

多功能雷达多采用相控阵体制,通过计算机控制天线阵列单元[11]和雷达内部的可编程器件[12],可以生成各种样式的波形,实现雷达的各种工作方式和搜索、跟踪、制导等多种功能[13]。多功能雷达还能根据目标和环境特性的变化自适应地选择合适的波形参数,提升雷达的工作效能。当前在对多功能雷达信号的研究中,主要是参考VISNEVSKI等[14-15]提出的多层级的多功能雷达信号模型。如图2所示,该模型分为3层,即雷达字层、雷达短语层和雷达句子层。其中:雷达字即有限数目雷达脉冲的固定排列,是最基本的信号单元;有限个雷达字的固定排列构成了雷达短语,雷达短语反映了雷达的工作模式和雷达任务;雷达短语又构成了雷达句子,雷达句子与雷达要实现的功能密切相关。多功能雷达自适应、信号参数捷变的特点会使得多层级信号模型的层内和层间的关系复杂多变。这种复杂多变的雷达信号结构给传统的雷达干扰决策方法带来了巨大困难,促使学者们关注到一种全新的决策方法,即强化学习。

图2 多层级的多功能雷达信号模型Fig.2 Multi-level multi-function radar signal model

2.2 强化学习基本原理

强化学习是研究智能体通过与环境的互动学习最优行为策略的机器学习方法,智能体与环境的交互过程为马尔可夫决策过程(Markov Decision Process,MDP),智能体能够通过观测与环境互动得到的数据序列做出相应的适应环境的行动,其本质是学习最优的序贯决策[16]。图3以马尔可夫决策过程的形式展现了强化学习中交互学习的过程。在每一次的交互中,智能体产生的一个动作At作用于环境,环境在动作的作用下发生状态转移,由St转移到St+1。智能体观察到环境状态的变化并从中得到一个收益Rt,进而根据收益调整决策模型。智能体经过与环境大量的交互,逐渐学习到如何采取动作才能使获得的累计收益达到最大,累计收益表示为

图3 强化学习的马尔可夫决策过程Fig.3 Markov decision-making process of reinforcement learning

Gt=Rt+1+γRt+2+γ2Rt+3+…

(7)

式中,γ∈[0,1],为折扣率,表示未来的收益在当前时刻的现值。策略π,即智能体选择动作的方法,是状态到动作的映射,π:S→A。强化学习的目标就是要学习到一个最佳策略π*,使智能体获得的累计收益达到最大。

2.3 基于强化学习的雷达干扰决策研究

在多功能雷达的干扰决策中,决策的战术目标与传统雷达的干扰决策不同,传统雷达的干扰决策目标是选择一种干扰样式,使其对当前雷达状态的干扰效果达到最好;而多功能雷达的干扰决策目标则是根据一个策略,使雷达状态尽快转移到目标的雷达状态,这样的决策目标设置与决策中心战[17]、马赛克战[18]的思想更加契合。将雷达对抗过程中雷达的行为过程分解为一个个离散的雷达状态,干扰机采取某种干扰样式Jt后,雷达的状态发生转移,干扰机侦察到雷达状态的转换并从中获得收益,进而调整干扰策略,这样就可以将雷达对抗的过程构建为一个马尔可夫决策过程,该过程如图4所示。

图4 雷达对抗的马尔可夫决策过程Fig.4 Markov decision-making process ofradar countermeasure

在一个马尔可夫决策过程中,通过强化学习的相关算法就可以学习得到最佳的雷达干扰策略。利用强化学习进行雷达干扰决策目前还是一个崭新的领域,相关文献相对较少,所以下文将从界定雷达状态、设置收益函数以及选择强化学习算法3个角度来对相关文献展开分析。

2.3.1 界定雷达状态

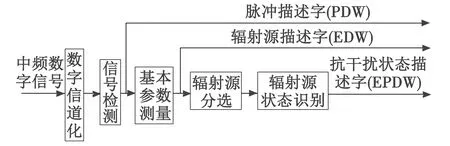

将雷达对抗中雷达的一系列行为过程分解为离散的雷达状态是进行干扰决策的前提条件。文献[19]将雷达状态定义为:以干扰方所接收的信号参数为基本依据而界定的目标雷达所处的情况,一方面,雷达状态是干扰机选取干扰样式的依据,另一方面,雷达状态的变化也是后续获取收益的依据,雷达状态的界定对于干扰决策具有重要意义。文献[20]将多功能雷达的工作模式等价于雷达状态,虽然简洁地解决了雷达状态界定的问题,也有现有的雷达工作模式识别的相关研究作为前提支撑,但将雷达工作模式作为雷达状态不能很好地反映多功能雷达的自适应、波形捷变的信号特点,也不利于提高干扰决策的有效性。在多功能雷达中,在同一种工作模式下,往往存在多套不同的波形参数,雷达会根据目标和环境特性选择不同的雷达波形参数,如果依据雷达工作模式来选择干扰样式,针对在同一工作模式下的不同波形参数,干扰机就会选择同一种干扰样式,这对于干扰决策是不利的。文献[21-22]在已有的侦察测量技术及测量分选结果形成脉冲描述字(PDW)和辐射源描述字(EDW)的基础上,引入抗干扰状态描述字(EPDW)来表征雷达状态,雷达状态识别实现的流程[21]如图5所示。

图5 雷达状态识别的流程Fig.5 Process of radar status identification

引入EPDW来表征雷达状态很好地对接了现有的关于雷达辐射源识别的相关研究,但文献[21-22]中没有给出选取何种特征来表征EPDW,这将是一个值得研究的方向。文献[23]将多功能雷达信号划分为功能层、任务层、波形层,分别对应多层级的多功能雷达信号模型中的雷达句子层、雷达短语层、雷达字层,并将雷达任务作为雷达状态。从雷达的工作过程来看,雷达工作过程可以分解为雷达任务序列,将雷达任务作为雷达状态可以达到分解雷达对抗过程中雷达行为过程的目的,但雷达任务与雷达短语并不是一一对应的,如何界定雷达任务又成为一个新的问题。如何从多层级的多功能雷达信号模型出发,更好地界定雷达状态,也是一个值得研究的方向。

在雷达状态识别算法方面,文献[24]采用了有监督和无监督两种机器学习方法来识别未知的雷达状态,识别准确率能分别达到90%和85%。仿真实验的数据采用的是某多功能雷达6种工作模式的参数,在实验过程中也发现了雷达状态与雷达工作模式并非一一对应的问题,将雷达工作模式作为雷达状态是不合理的。结合上述分析,界定雷达状态存在两种方法,一是从PDW和EDW中选取特征表征雷达状态,二是基于多层级的多功能雷达信号模型定义雷达状态。

2.3.2 设置收益函数

强化学习的目标是学习一个最优策略π*使得累计收益达到最大,因此,如何合理地设置收益函数引导智能体去学习到π*是强化学习中的一个重要问题。文献[21]中,雷达状态转换至目标雷达状态的收益为r=100,其他情况收益r=0。文献[20,25-26]将雷达状态分为不同的威胁等级,雷达状态转换至最低威胁等级的雷达状态收益为r=100,除了转换为最低威胁等级外的雷达状态之间的转换收益为r=0,雷达工作状态之间无转换收益为r=-1。文献[20-21]同样将雷达状态分为不同的威胁等级,雷达状态转换至威胁等级最低的收益为r=100,除了转换至最低威胁等级外的威胁等级降低为r=1,威胁等级不变或者升高为r=-1。以上文献中,收益的设置主要是依据决策的目标和一些收益函数设置的通用经验,在接下来的第3章中,对不同的收益函数的设置方法进行了对比,结果表明,收益函数的设置不仅会影响算法的收敛速度,还会影响决策的结果。

2.3.3 选择强化学习算法

强化学习发展至今,已经在机器人控制[27]、无人驾驶[28]和金融交易[29]等领域取得了广泛的应用。许多优秀的强化学习算法被提出,如Q-Learning[30],DQN[31](Deep Q-Learning),DDQN[32](Double Deep Q-Learning)等,强化学习算法的数量众多,不胜枚举,本节主要讨论已经被用于干扰决策的强化学习算法。文献[20-22,25-26]中采用Q-Learning作为干扰决策的算法。Q-Learning算法中,在状态s下依据策略π选择动作a的累计收益期望被称为动作价值函数,记为Qπ(s,a)。Qπ(s,a)是策略π选择动作的依据,最佳策略π*满足贝尔曼最优方程

Qπ*(s,a)=∑p(s′,r|

s,a)[r(s,a)+

γmaxa′Qπ*+(s′,a′)]

(8)

式中:s′,a′表示下一时刻的状态和动作;动态环境特性用p(s′,r|s,a)表示;收益被表示为关于状态s和动作a的函数,即r(s,a)。在Q-Learning算法中采用差分的方式对Q值进行更新,不断迭代直至Qπ(s,a)的值收敛就可以得到最佳策略,即

Q(s,a)←Q(s,a)+α[r(s,a)+

γmaxQ(s′,a′)-Q(s,a)]。

(9)

Q-Learning是一种简单的基于表格的强化学习算法,在雷达状态数目比较少的情况下能够通过学习寻找到最佳的干扰策略。

文献[23]针对雷达状态数量增加时决策效率降低的问题,将DQN用于雷达干扰决策。DQN将Q-Learning与深度学习相结合[32],在Q-Learning中采用表格的方式存储Qπ(s,a)的值,而在DQN中通过训练神经网络输出Q值,节省了决策过程中查找Q表的时间,也节省了存储Q值的空间。训练神经网络输出Q值的原理如图6所示,给神经网络输入雷达状态S,神经网络输出该状态下选择每种干扰样式Jt的Q值,然后干扰机根据Q值进行决策。文献[23]的实验表明,DQN能在雷达状态数量增加时有效地降低决策时间,提升决策效率。但是由于使用到了深度学习,在DQN中将面临更多的超参,调参的难度比Q-Learning更大。

图6 基于DQN的雷达干扰决策Fig.6 Radar jamming decision-making based on DQN

目前在雷达干扰决策中用到的强化学习算法主要是Q-Learning和DQN,在现有的干扰决策模型中都能够找到最佳的干扰策略,Q-Learning适用于雷达状态数量较少的情况,而DQN适用于雷达状态数量较多的情况。

3 基于强化学习的干扰决策方法性能分析

为了验证基于强化学习的干扰决策方法不依赖于先验数据的特性和具有自学习的能力,同时也为了比较不同的收益函数设置方式对强化学习算法的影响,设置以下仿真实验。

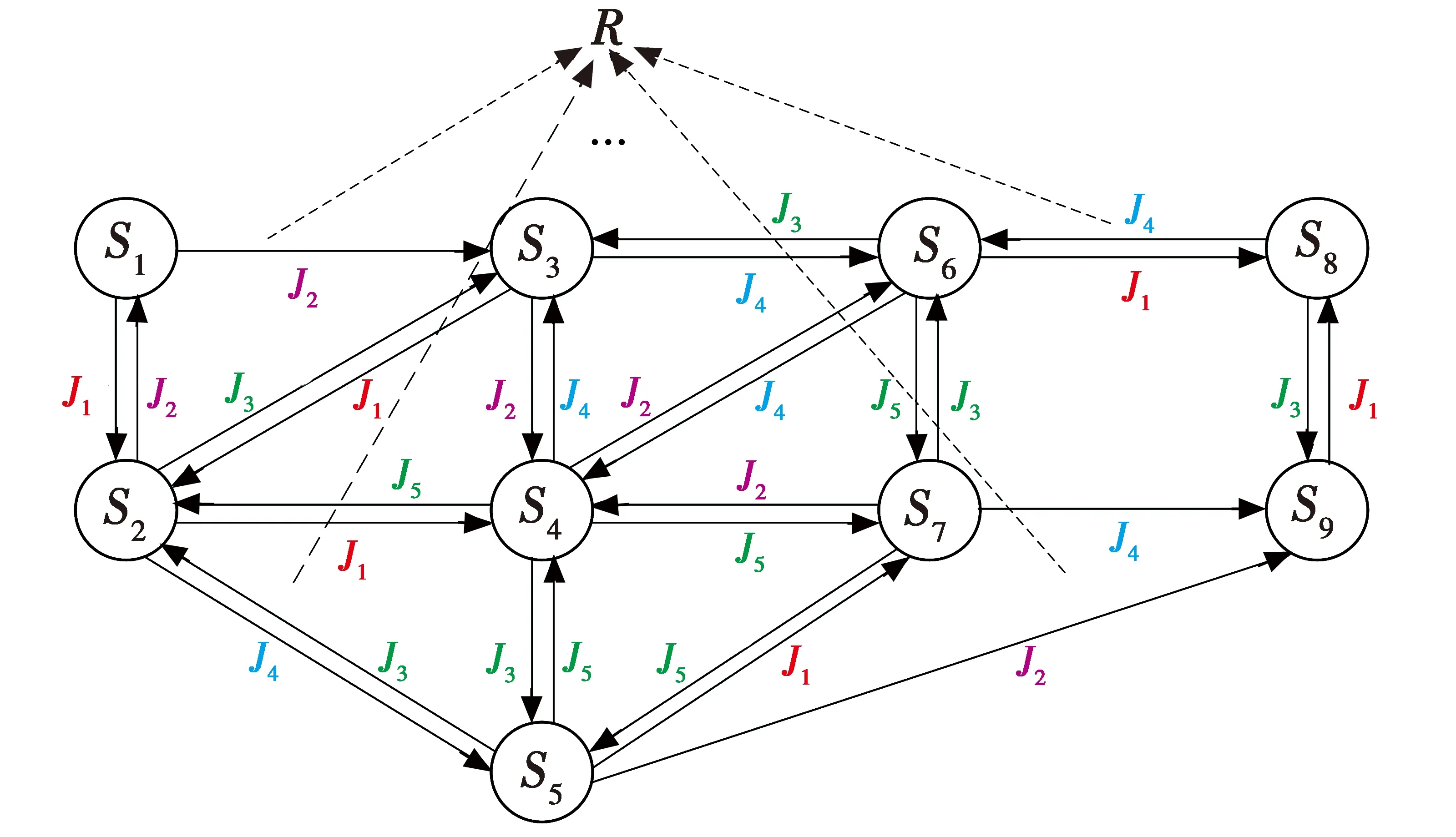

多功能雷达通常具有搜索、跟踪、测距、非合作目标识别等多种工作模式,在每种工作模式下,雷达根据目标环境特性选择不同的波形参数,因此同一种工作模式下通常包含多种不同雷达状态。针对不同的雷达状态,干扰机可以选择不同的干扰样式,包括射频噪声干扰、脉冲卷积干扰、间歇转发干扰、距离波门拖引干扰等。现假设某多功能雷达具有9种状态S1,S2,…,S9,威胁等级分别为1,1,2,2,2,3,3,4,5,S9是目标雷达状态,具有最低的威胁等级。同时,假设干扰机具有J1,J2,…,J55种干扰样式,雷达的初始状态为S1,强化学习智能体的目标是学习一个策略选择干扰样式使得雷达状态最快转移至目标雷达状态,不同雷达状态间的转换关系如图7所示,干扰机(智能体)在实施干扰前是无法得知雷达状态间的转换关系的。

图7 雷达状态转换Fig.7 Diagram of radar state transition

采用Q-Learning作为本次仿真实验的算法,参数设置如下。学习率α=0.01,折扣率γ=0.9,采用ε贪心策略,ε随迭代次数逐渐减小,ε最小为0.02,收益函数的设置同文献[21]。实验结果如图8所示,横坐标为回合数,多功能雷达的状态转移至目标状态称为一个回合,纵坐标为在一个回合中雷达状态从初始状态到目标状态所需的干扰次数。在对抗的开始阶段,干扰需要进行大量的试探,才能使多功能雷达的状态转移到目标雷达状态;而随着干扰机与多功能雷达之间交互的回合数不断增加,干扰机学习到了越来越多有关干扰决策的知识,多功能雷达转移到目标雷达状态所需的干扰次数在不断减少,最后收敛至3附近。而从图7中可以看出,干扰机的最佳干扰路径为J1→J4→J2,与之对应的雷达状态转移路径为S1→S2→S5→S9,所需干扰次数刚好为3。这表明,干扰机在与多功能雷达不断交互后最终学习到了最佳干扰策略,基于强化学习的干扰决策方法是一种具备“认知”能力的方法。

图8 强化学习的收敛过程Fig.8 Convergence process of reinforcement learning

为对比文献[21](收益函数1)、文献[20,25-26](收益函数2)和文献[22-23](收益函数3)中不同的收益函数设置对干扰决策结果的影响,进行100次独立的蒙特卡罗实验,实验结果取平均值,可不为整数,如图9所示。

从图9中可以看出,收益函数1和收益函数2具有相似的性能,其收敛曲线基本重合,最终都收敛至3附近,这表明干扰机能够学习到最佳的干扰策略。而收益函数3最终收敛至4附近,没有学习到最佳的干扰策略,但其收敛速度快于收益函数1和收益函数2,收益函数3在回合数为100时已经收敛,而收益函数1和收益函数2则需要125个回合才能收敛。仿真实验的结果表明,收益函数的设置会影响干扰决策算法的收敛速度和收敛结果,进而影响干扰决策的实时性和有效性。

图9 不同收益函数的对比Fig.9 Comparison of different revenue functions

4 总结与展望

新的雷达技术催生新的对抗手段,多功能雷达的出现催生新的对抗方法。多功能雷达不仅波形捷变,而且具备强大的自适应能力,传统的依靠统计和先验数据的干扰决策方法对此束手无策。强化学习可以不依赖于先验的数据,通过不断地“试错”调整策略,进而做出最优的选择,是一种具有自适应和自学习能力的决策方法。基于强化学习的干扰决策方法或许就是实现真正的认知电子战的一个重要方法。但就目前而言,基于强化学习的干扰决策方法仍面临一些挑战,在未来还有很大的发展空间。

1) 如何界定雷达状态,将雷达对抗中雷达的行为过程分解为离散的雷达状态是使用强化学习方法进行干扰决策的重要前提。目前相关的研究还比较少,可以在现有的PDW和EDW的基础上选取特征表征雷达状态,或者从多层级的多功能雷达辐射源模型出发,定义雷达状态。

2) 收益函数的设置方法有待优化。收益函数的设置会影响强化学习算法收敛的速度和最终的结果,现有的收益函数设置方法常基于经验,缺乏系统性、理论性的研究。可以结合雷达干扰决策任务的特点优化收益函数的设置。

3) 将性能更好的强化学习算法运用于雷达的干扰决策。在当前基于强化学习的雷达干扰决策研究中,主要是使用Q-Learning 和DQN两种算法。而强化学习中有数量庞大的算法,可以探索其他强化学习算法在雷达干扰决策问题中的适用性,在现有基础上提升算法的收敛性能和决策性能。