通道融合的渐进增强遥感图像全色锐化算法

贾雅男,郭晓杰

天津大学智能与计算学部,天津 300350

0 引 言

高分辨率的多光谱图像在遥感图像应用中发挥着重要的作用,如目标检测(Cheng和Han,2016)、场景分类(Nogueira等,2017)、环境监测(Foody,2003)和土地测量(Mulders,2001)等。然而,由于机载存储技术和传输技术的限制(Thomas等,2008),大多数卫星无法直接获取高分辨率的多光谱图像,只能提供低分辨率的多光谱图像和高分辨率的全色图像。低分辨率的多光谱图像拥有丰富的光谱信息,但缺乏空间细节信息;而其对应的高分辨率全色图像有丰富的细节信息但几乎没有光谱信息。显然,这两种图像都无法满足实际应用的需求,所以将两种图像融合为高分辨率的多光谱图像是很有必要的,这种图像融合技术称为全色与多光谱图像融合或全色锐化(唐霖峰 等,2023)。

传统的全色与多光谱图像融合方法可大致分为成分替换法、多分辨率分析法和基于模型的方法。常见的成分替换算法有主成分分析(principal component analysis,PCA)方法(Ghadjati等,2019)、基于强度色彩饱和度(intensity-hue-saturation,IHS)的方法(Tu等,2001)和施密特正交变化(Gram-Schmidt,GS)方法(Laben和Brower,2000)。该类方法使用线性变换将上采样的低分辨率多光谱图像分解为光谱分量和空间分量,之后用全色图像替换空间分量。虽然成分替换法速度快,易于实现,但在融合过程中忽略了两种图像的差异性,直接替换导致图像的低频信息被破坏,造成了严重的光谱失真。多分辨率分析法(Liu,2000;Schowengerdt,1980)利用多尺度滤波器提取全色图像的高频信息,之后将其注入到上采样的低分辨率多光谱图像中。虽然在一定程度上解决了光谱失真的问题,但这类方法容易产生混叠效应和边缘伪影(方帅 等,2020)。基于模型的方法(Ballester等,2006;Fang等,2013;Vivone等,2015,2018)假设低分辨率多光谱图像和全色图像分别是高分辨率多光谱的图像的空间和光谱的退化版本。基于这个假设,这类方法通过不同的模型建立源图像和高分辨率多光谱图像之间的关系。然而,实际情况远比假设复杂得多,而设计一个优良的模型优化算法也是极为困难的。

近年来,基于深度学习的全色与多光谱图像融合算法成为一个新的研究热点。基于深度学习的方法有更加优秀的非线性拟合能力,可以获得比传统方法更好的融合效果。Masi等人(2016)提出了一个由3层卷积组成的遥感图像融合神经网络(pan-sharpening by convolutional neural networks,PNN),将上采样的低分辨率多光谱图像与全色图像拼接起来作为输入,通过卷积重构为高分辨率的多光谱图像。然而,仅仅3层卷积无法完全发挥出深度神经网络优秀的拟合能力,还有很大的优化空间。所以,很多研究者通过加大网络的深度进行优化。如PANNet(Yang等,2017)利用更深的网络提取高频信息,并将提取到的高频信息注入到上采样的多光谱图像中。此外,Wei等人(2017)利用ResNet(He等,2016)架构改进PNN,提出了深度残差泛锐化神经网络(deep residual pan-sharpening neural network,DRPNN)。Wang等人(2019)用紧密连接的结构构造了一个44层的网络,增加了网络的深度,在一定程度上提升了性能。但随着网络深度的增加,训练会变得越来越困难,并且这种直接增加网络层数的方式没有充分利用两种模态的图像特性。

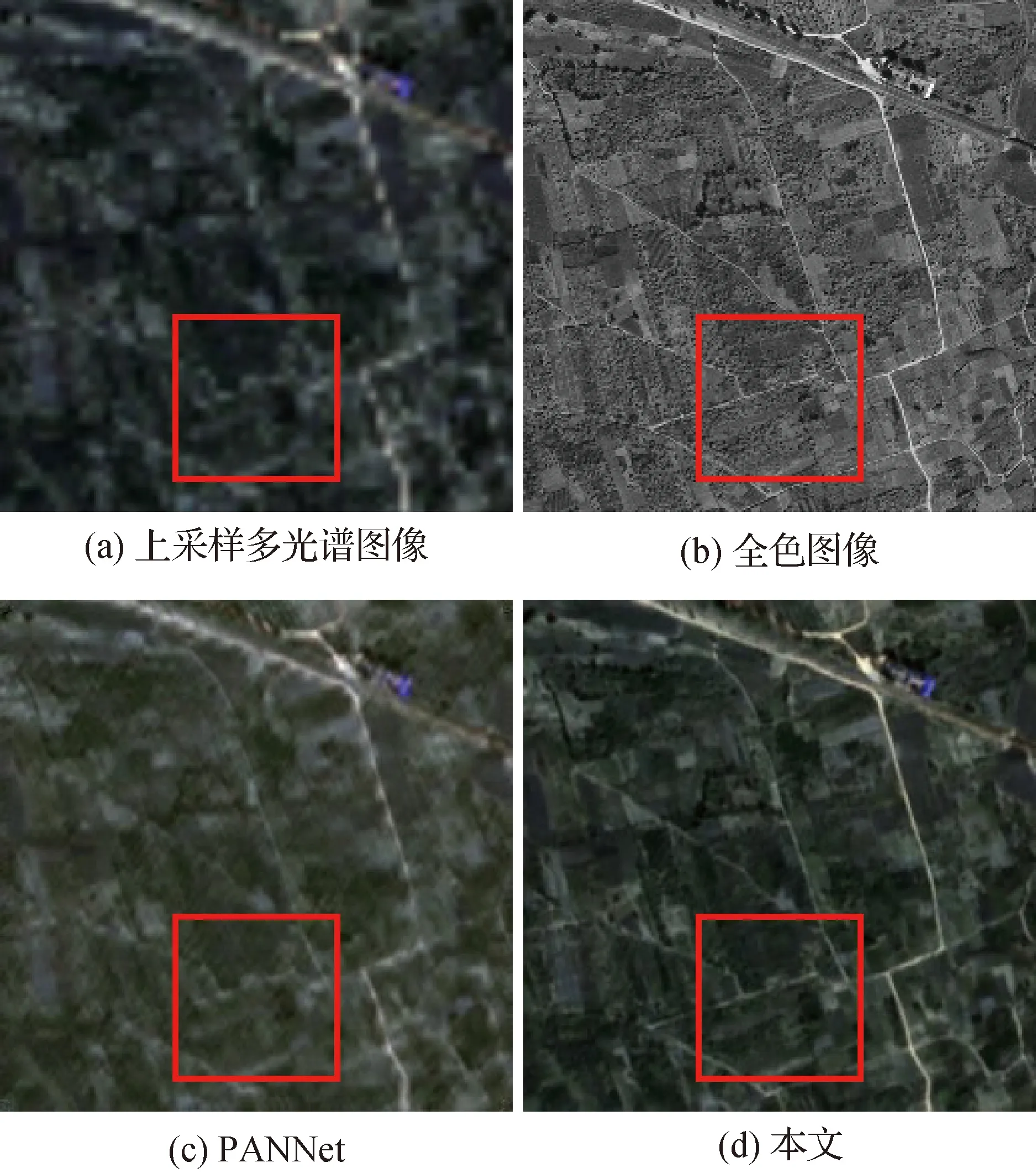

为了更好地从两种模态中获取不同的信息,充分挖掘两种图像在空间和光谱上的特性,很多方法使用多个分支的结构提取不同的特征。例如,Liu等人(2020)提出一个双流融合网络(two-stream fusion network,TFNet),使用两个分支分别提取低分辨率多光谱图像的光谱信息和全色图像的空间信息,随后将两种特征整合起来重构为高分辨率多光谱图像。MPNet(multispectral pan-sharpening network)(Wang等,2021)分别使用2-D和3-D卷积从源图像中提取特征,并添加融合分支将提取到的特征进行融合。FDFNet(full-depth feature fusion network)(Jin等,2022b)使用3个分支进行全色与多光谱图像的融合,并增加了不同分支之间的交互。由于多光谱图像和全色图像分辨率不同,这些方法均采用直接将多光谱图像上采样以保持分辨率的一致性。然而,直接将多光谱图像的分辨率上采样到原来的4倍,导致多光谱图像在空间上存在明显间断的区域,为后续图像的恢复工作增加了难度,甚至一些区域无法完全恢复,如图1(c)所示,选中区域道路不连贯,出现了中断。

图1 GaoFen-2数据集的一个样例

为了减少空间上的不连贯,一些方法尝试不直接对多光谱图像上采样,而是利用深度神经网络学习域之间的变换,得到增强的信息表达。SDPNet(surface and deep-level constraint-based pan-sharpening network)(Xu等,2021a)通过两个不同的编码—解码器结构的网络学习两个模态之间的转化,之后用这两个网络提取不同深度的特征作为增强的信息表示。Jin等人(2022a)利用拉普拉斯金字塔提取不同尺度的特征,在不同尺度上进行图像的恢复,从一定程度上避免了直接上采样带来的图像质量退化的影响。Wang等人(2021)提出了一种从光谱到空间的卷积SSConv(spectral-to-spatial convolution)将光谱特征转换到空间域上,避免了上采样的操作。然而,由于缺少参考图像的监督,这些方法通常遵循Wald协议(Wald等,1997)把下采样的源图像当做训练数据,源图像作为参考图像进行训练,这种处理方式也降低了图像的质量。于是,一些研究者尝试使用基于生成对抗网络的无监督方法直接使用源图像进行训练。如PANGAN(pan-sharpening based on a generative adversarial network)(Ma等,2020)使用两个判别器分别使全色图像和多光谱图像与生成的高分辨率多光谱图像进行对抗学习。HPGAN(hyperspectral pansharpening using 3-D generative adversarial networks)(Xie等,2021)分别在全局、光谱和空间上对融合过程进行约束,提出了一种3D的从光谱到空间的生成器生成高分辨率多光谱图像。此外,李昌洁等人(2021)使用拉普拉斯金字塔结构的生成器提取多个尺度的特征,之后用这些特征构造出最后的结果。然而,这些基于生成对抗网络的方法在训练过程中很容易遭受模型坍塌和梯度消失的问题(Nagarajan和Kolter,2017),难以收敛到一个好的结果。

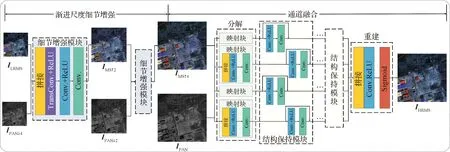

为了解决上述问题,本文提出一种端到端的渐进式细节增强网络,得到增强的多光谱图像后,将多光谱图像和全色图像在通道上拼接进行融合,充分提取两种图像的特征,最后将提取到的特征重构为高分辨率的多光谱图像。如图2所示,整个网络有两个阶段:渐进尺度增强和通道融合。在渐进尺度细节增强阶段,全色图像分别下采样到原来的1/2和1/4,之后与多光谱图像拼接起来通过两个细节增强模块得到多光谱图像的增强表示;在通道融合阶段,增强的多光谱图像在每个通道上与全色图像通过结构保持模块进行融合,之后将各个通道的特征重新整合在一起得到最终的融合结果。如图1所示,本文方法的融合结果在光谱上保持了更多的色彩信息,在空间上也维持了细节的连续性。本文的主要贡献总结如下:

图2 本文算法网络结构图

1)提出了一种端到端的渐进式细节增强和结构保持的网络,可以有效地解决空间上的不连续问题,取得了领先的性能;

2)在通道层面上进行融合,在充分利用全色图像丰富的空间信息的同时,保持了低分辨率多光谱图像的光谱信息,获得更好的融合结果;

3)进行了完备的消融实验,验证了各个模块的有效性,同时大量的对比实验证明本文方法的融合结果无论在视觉效果上还是客观指标评价上都达到了最优。

1 本文算法

在本文中,将低分辩多光谱图像记为ILRMS∈Rmn×C,其中m和n分别代表低分辨率多光谱图像的高度和宽度,C代表图像的通道数(C=4);IPAN∈R(rm)(rn)×c代表全色图像,其空间分辨率是多光谱图像的r倍,c代表全色图像的通道数(c=1);IHRMS∈R(rm)(rn)×C代表理想的高分辨率多光谱图像。如图2所示,在渐进尺度细节增强阶段,通过两个细节增强模块将多光谱图像的分辨率逐步增大4倍;在通道融合阶段,利用提出的结构保持模块将全色图像和分解的增强图像在通道上进行融合,最后将特征重建为高分辨率的多光谱图像。整个网络在多尺度的增强损失和重构损失的约束下进行端到端的训练。

1.1 渐进尺度细节增强

大多数基于深度学习的全色与多光谱融合算法存在的一个问题是直接将多光谱图像上采样以保持与全色图像一致的尺寸。然而这种简单的方式降低了图像质量,缺失了一部分空间细节。如果利用全色图像额外的信息帮助多光谱图像在融合前进行增强,那么多光谱图像缺失的空间信息就能得到一定的恢复。然而,直接将信息注入到多光谱图像中可能会导致出现边缘伪影的现象。为了解决上述问题,本文提出了一种渐进尺度细节增强的策略,利用不同尺度的全色图像的信息逐步得到增强的结果。

首先,多光谱图像ILRMS与下采样4倍的全色图像IPAN↓4在通道维度上拼接,通过细节增强模块得到空间分辨率增大2倍的多光谱图像,可以表示为

IMS↑2=φ(C(ILRMS,IPAN↓4))

(1)

式中,C(·)代表在通道上进行拼接,φ(·)代表用细节增强模块对图像进行处理。之后将得到的放大2倍的多光谱图像IMS↑2与下采样2倍的全色图像IPAN↓2拼接起来,再通过细节增强模块进行增强,得到分辨率与全色图像一致的多光谱图像,表示为

IMS↑4=φ(C(IMS↑2,IPAN↓2))

(2)

式中,IMS↑4代表放大4倍的增强的多光谱图像。

在增强过程中,起到关键性作用的就是细节增强模块,如图2所示,细节增强模块首先使用转置卷积层将图像的尺寸放大至原来的2倍,并使用ReLU(rectified linear unit)作为激活函数。之后再用两个3×3的卷积将两个模态的特征进行整合,得到增强的多光谱信息表示。整体流程可以表示为

F1=ψ(WT*Fin)

(3)

F2=ψ(W1*F1)

(4)

F3=W2*F2

(5)

式中,Fin代表输入细节增强模块的图像,Fi代表第i个卷积层输出的特征,ψ(·)代表ReLU激活函数,*代表卷积操作,WT代表转置卷积的权重,W1和W2分别是两个卷积的权重。

1.2 通道融合

在渐进尺度增强阶段,低分辨率的多光谱图像在全色图像额外信息的帮助下获得了一定的增强,并且使其尺寸与全色图像保持一致,但还未充分利用两种图像的光谱和空间信息。为了充分融合两种模态的互补特征,消除边缘伪影的影响,本文提出了在通道上融合的策略,先将多光谱图像在通道上进行拆分,让全色图像与多光谱图像的每一个通道都进行融合,之后将融合后的特征整合到一起,重构为高分辨率的多光谱图像。如图2所示,通道融合的过程可以概括为3个步骤,分别是分解、融合和重组。

在分解阶段,多光谱的每个通道都与全色图像进行拼接,之后通过两个3×3的卷积投影到特征空间,得到一个浅层的特征表示,可以表示为

FINi=Wd2*ψ(Wd1*C(IMSi,IPAN))

i=1,2,3,4

(6)

式中,IMSi代表多光谱图像的第i通道,Wd1和Wd2是两个卷积核的权重,FINi代表生成的第i个特征。之后的融合阶段使用了一种新的融合策略,用8个结构保持模块在通道上进行融合。如图2所示,每个结构保持模块有4个分支,数量与多光谱图像的通道数相等,每条分支使用卷积提取特征,同时为了信息的有效传递,还在每条分支上添加了残差连接。结构保持模块可以表示为

FFUSEi=Wf2*ψ(Wf1*FINi)),i=1,2,3,4

(7)

FOUTi=FFUSEi+FINi,i=1,2,3,4

(8)

式中,Wf1和Wf2是各个分支上卷积的权重,FOUTi代表结构保持模块输出的第i个特征。前一个模块输出的特征FOUTi当做下一个模块的输入特征FINi,这样随着结构保持模块数量的增加,更多的图像特征被提取出来进行融合,为最后的图像重构做好准备。在重构阶段,首先将得到的各个通道的特征重新整合起来,接着使用卷积层将特征重新映射重构为高分辨率的多光谱图像。这个过程可以表示为

FOUT=C(FOUT1,FOUT2,FOUT3,FOUT4)

(9)

IHRMS=S(Wf2*ψ(Wf1*FOUT))

(10)

式中,S(·)代表Sigmoid激活函数,IHRMS代表生成的高分辨率的多光谱图像。通过以上步骤可以将特征重构为期望的高分辨率多光谱图像。

1.3 训练细节

训练的损失函数分为两个部分,分别是多尺度的增强损失和重构损失。其中重构损失主要为了保证生成的高分辨率多光谱图像与参考图像在结构上保持一致,表示为

(11)

(12)

L=Lrecon+Len

(13)

在这个损失函数的约束下,整个网络可以进行端到端的训练。

本文算法在PyTorch框架下实现,使用SGD(stochastic gradient descent)算法进行优化,共训练150轮,学习率初始值设置为0.000 5,每40轮衰减为原来的0.1,批量大小设置为8。

2 实验结果

2.1 数据集与评价指标

本文使用GaoFen-2(GF-2)和QuickBird(QB)数据集评测算法的性能,由于缺少参考图像作为监督,使用Wald协议(Wald等,1997)将源图像下采样作为训练数据。具体来说,首先分别将全色图像和多光谱图像下采样为源图像的1/4作为全色图像和多光谱图像的低分辨率版本,将原多光谱图像当做参考图像。之后,分别将低分辨率的多光谱图像、全色图像和参考图像裁剪成为64×64×4、256×256×1和256×256×4的图像块。最后,将其中的90%作为训练集进行训练,剩下的10%用于测试。

在测试阶段,为了定量评价各个算法的效果,使用峰值信噪比(peak signal-to-noise ratio,PSNR)(Horé和Ziou,2010)、结构相似度(structural similarity,SSIM)(Wang等,2004)、相关系数(correlation coefficient,CC)(Kaneko等,2003)、光谱角映射(spectral angle mapper,SAM)(Yuhas等,1992)和总体相对误差(erreur relative globale adimensionnelle de synthese,ERGAS)(Wald,2000)评测低分辨率对比实验中算法的性能。使用无参考质量指标(quality-with-no-reference,QNR)、光谱失真指数Dλ和空间失真指数DS(Alparone等,2008)评测全分辨率对比实验中算法的性能。

2.2 与其他算法的对比实验

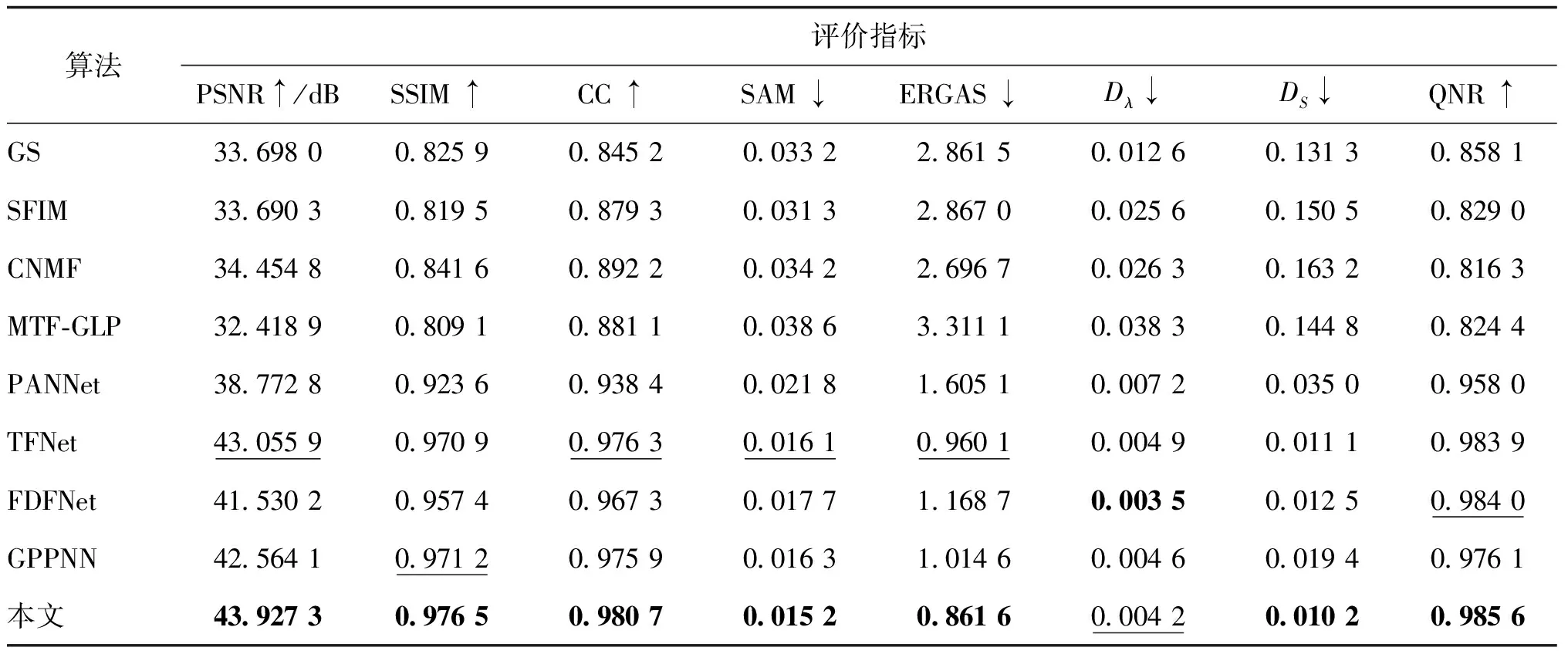

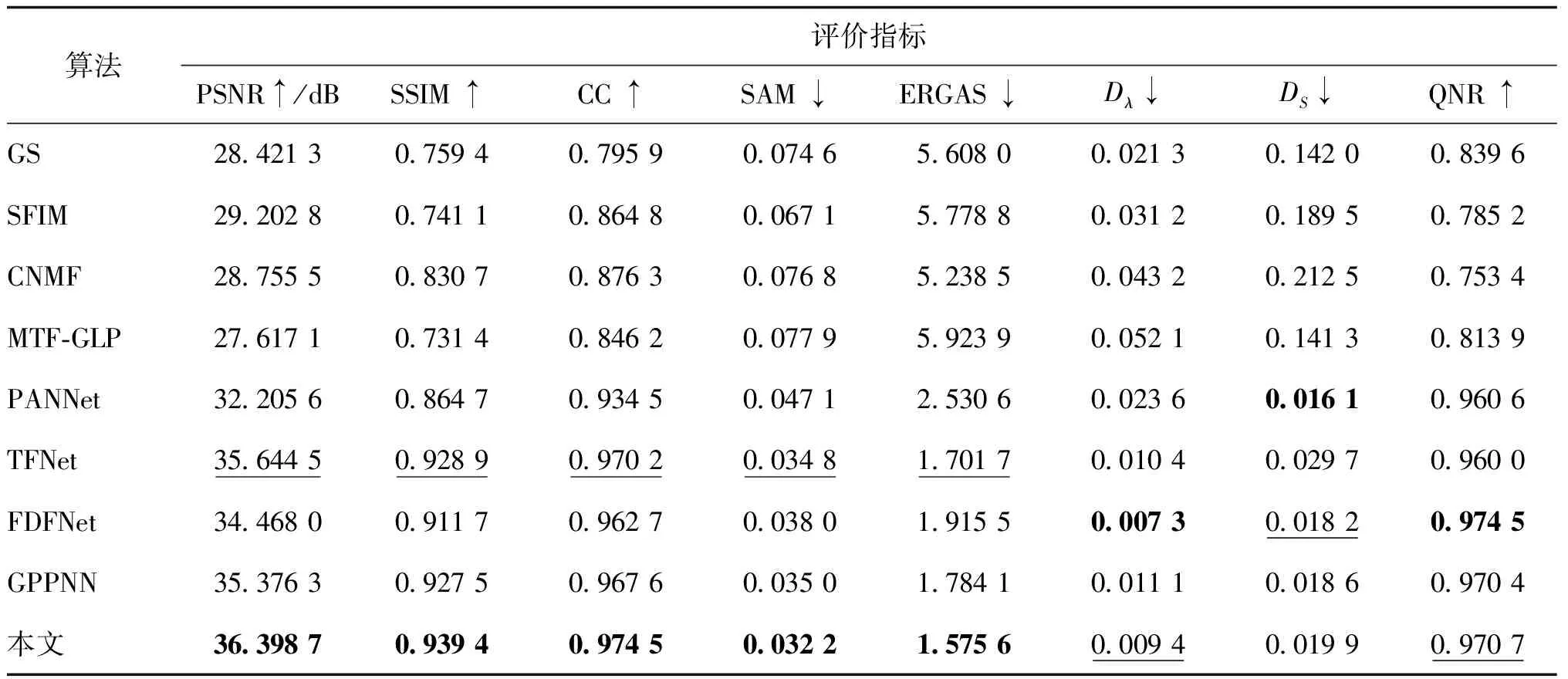

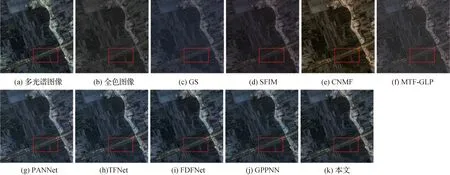

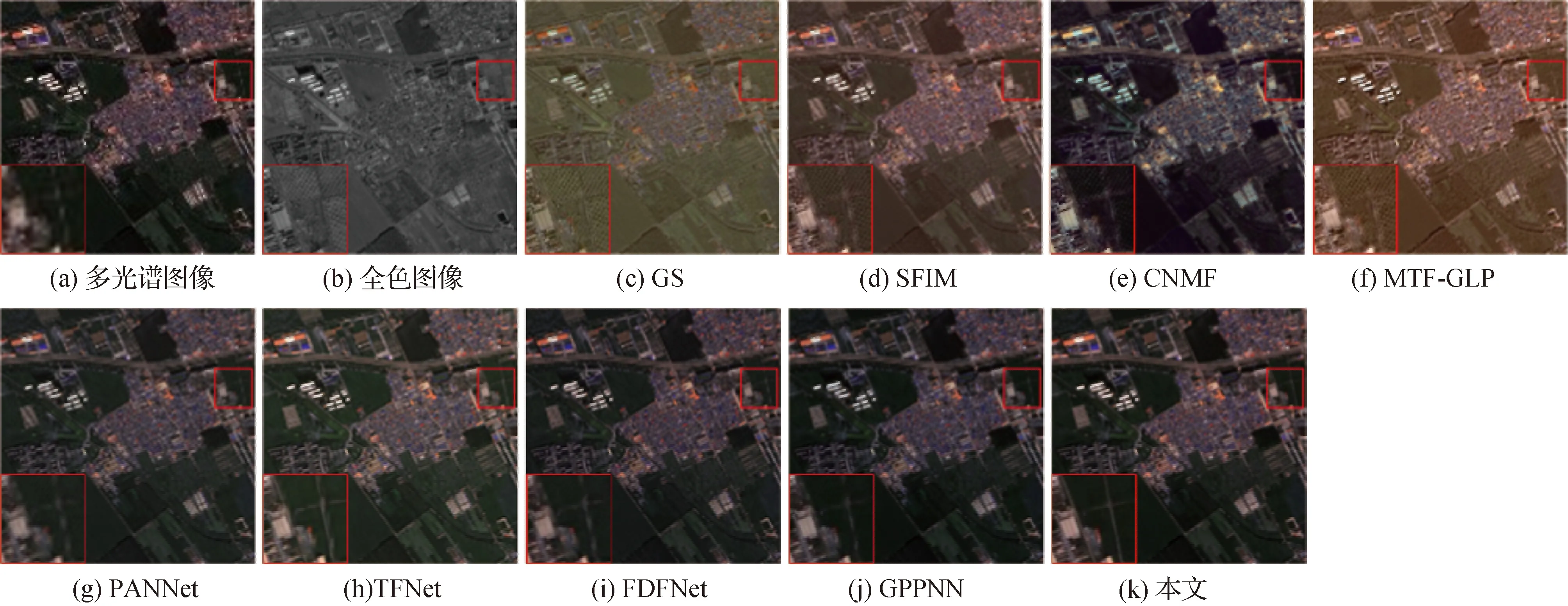

2.2.1 低分辨率对比实验

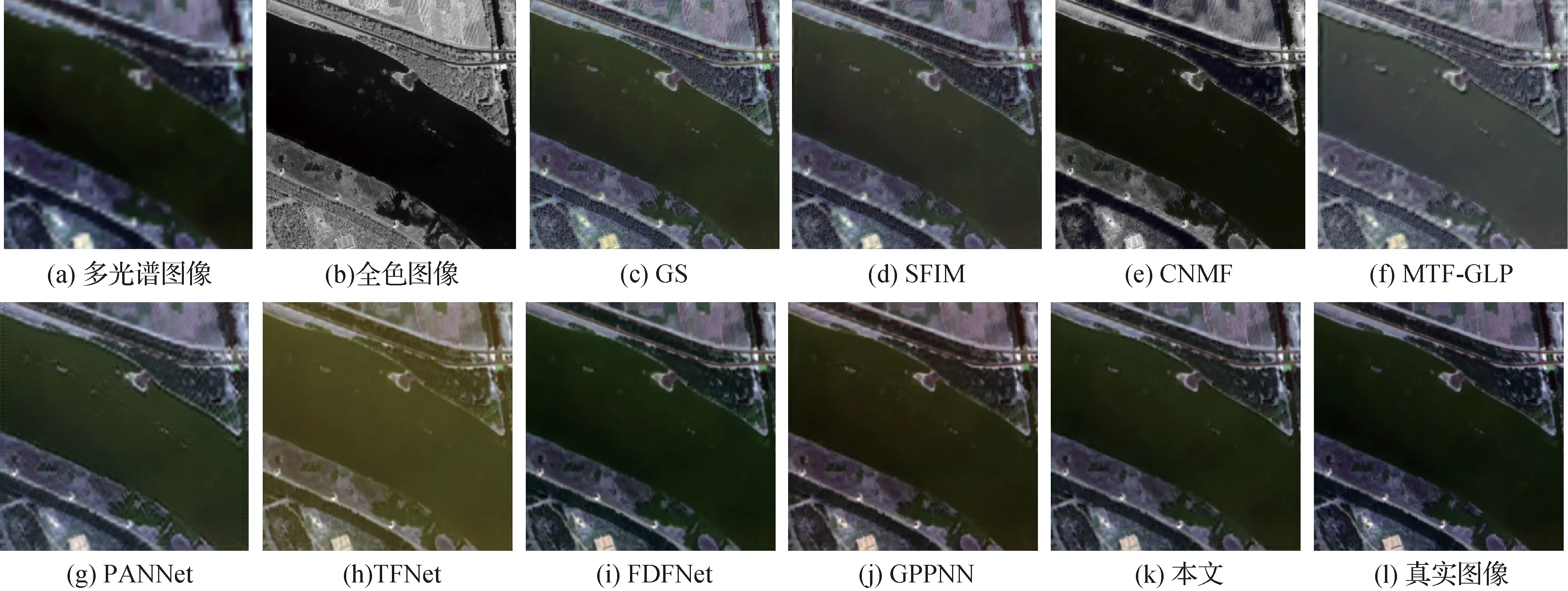

为了验证本文算法的效果,选用4种传统算法和4种基于深度学习的算法作为比较。传统算法分别是GS(Laben和Brower,2000)、SFIM(smoothing filter-based intensity modulation)(Liu,2000)、CNMF(coupled nonnegative matrix factorization)(Yokoya等,2012)和MTF-GLP(modulation transfer function generalized Laplacian pyramid)(Vivone等,2018)。4种基于深度学习的方法分别是PANNet(Yang等,2017)、TFNet(Liu等,2020)、FDFNet(Jin等,2022b)和GPPNN(gradient projection based pan-sharpening neural network)(Xu等,2021b)。所有基于深度学习的方法都使用相同的数据集在配备NVIDIA GeForce RTX 3060的GPU,16 GB RAM的计算机上重新训练,传统方法都在Intel i5-9400F的CPU上运行。图3和图4分别展示了各算法在GF2和QB数据集上的视觉对比效果,为了便于观察,仅展示生成的高分辨率多光谱图像的R、G、B这3个通道。可以看到,基于深度学习的方法在颜色保持上普遍比传统方法做得更好,传统方法整体颜色偏灰暗,没有保持多光谱图像的光谱信息。在图3和图4中,传统方法的融合结果都表现出严重的光谱退化问题,没有保持多光谱图像的颜色信息;而基于深度学习的方法虽然比传统方法保持了更多的光谱信息,但有些方法的融合结果出现了明显的色偏,如TFNet和GPPNN(图3(h)、图4(h)、图3(j)和图4(j));PANNet的结果(图3(g))有明显的边缘伪影。本文算法的融合结果在空间和光谱的保持上都有优异的表现,既没有出现明显的偏色现象,也没有边缘伪影出现,图像的整体质量有显著的提高。客观评价指标对比情况如表1和表2所示,可以看到,本文算法在5个有参考值的指标上均取得了最优的结果,这与视觉效果的表现一致。

图3 GaoFen-2数据集的低分辨率视觉对比

图4 QuickBird数据集的低分辨率视觉对比

表1 GaoFen-2数据集的数值比较

表2 QuickBird数据集的数值比较

2.2.2 全分辨率对比实验

为了验证算法在未下采样图像上的泛化能力,进行全分辨率图像的对比实验。直接将源多光谱图像和全色图像裁剪成为128×128×4和512×512的图像块进行测试。图5和图6分别展示了各算法在GF-2和QuickBird数据集上的视觉对比效果。从图5来看,传统方法中SFIM(图5(d))和CNMF(图5(e))都存在明显的色偏现象;观察红色边框区域可以发现,本文算法产生的融合结果减少了伪影的出现,在图5(k)中,没有出现在低分辨率多光谱图像中的条纹状伪影,在视觉效果上明显优于其他对比方法。同时注意观察图6的放大区域,可以发现本文算法显著保持了图像中道路区域的连续性,而其他的方法显然无法保持,出现了明显的图像内容间断现象,如PANNet(图6(g))、FDFNet(图6(i))和GPPNN(图6(j))等。从表1可以看出,本文算法在QNR(quality-with-no-reference)、Dλ和DS这3个无参考指标上都取得了最优或者次优的成绩,这说明了本文模型对于未下采样图像同样具有较强的泛化能力。在表2中可以看出本文算法在指标上没有达到最优,这是因为Dλ衡量了生成的结果与低分辨率多光谱图像的光谱信息差异,DS代表着融合结果与全色图像的空间信息偏差。本文算法相比于其他方法恢复了更多的细节,并且消除了全色图像的网格伪影,导致在DS指标上表现不够好,从而影响QNR的结果。从图像上可以直观看出本文算法的优越性,如图6(k),本文算法恢复了道路的连续性,并且去除了全色图像中的网格伪影。

图5 GaoFen-2数据集的全分辨率视觉对比

图6 QuickBird数据集的全分辨率视觉对比

2.3 消融实验

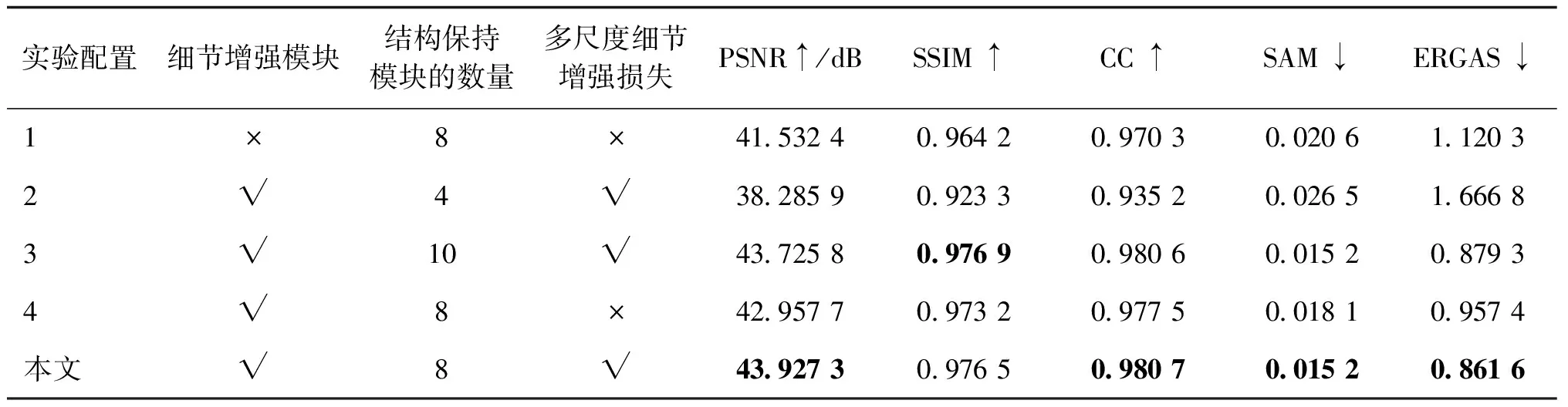

为了探究各个模块的有效性,开展消融实验,如表3所示,进行4种不同设置的实验。

1)渐进尺度细节增强过程中,使用两个细节增强模块将多光谱图像的分辨率逐步增大到与全色图像保持一致。第1个实验中,直接使用上采样的多光谱图像作为下一阶段的输入,以验证细节增强模块的有效性。在去掉细节增强模块的情况下,所有参考指标均出现了明显下降,这表明本文所提出的细节增强模块对于该任务来说是至关重要的。

2)在第2个实验中,旨在减少结构保持模块的数量,以验证其有效性以及合理的堆叠数量。将结构保持模块的数量减少到4个,从表3可以看到,去掉一半的结构保持模块,网络性能下降,说明该模块在网络中发挥了重要的作用。

表3 在GaoFen-2数据集上消融实验的结果

3)将结构保持模块的数量增加到10,其余配置与设置2)一致。可以看到,继续增加该模块性能并不会提高,这可能是因为网络深度和数据规模不匹配。

4)去掉多尺度细节增强损失,探究该损失函数是否有效。可以看到,去掉后网络的数值表现出一定程度的下降,证明了该损失函数对于提升模型表现的价值。因此,为取得网络的最佳表现,该损失函数的设置是必要的。

2.4 模型参数量与时间

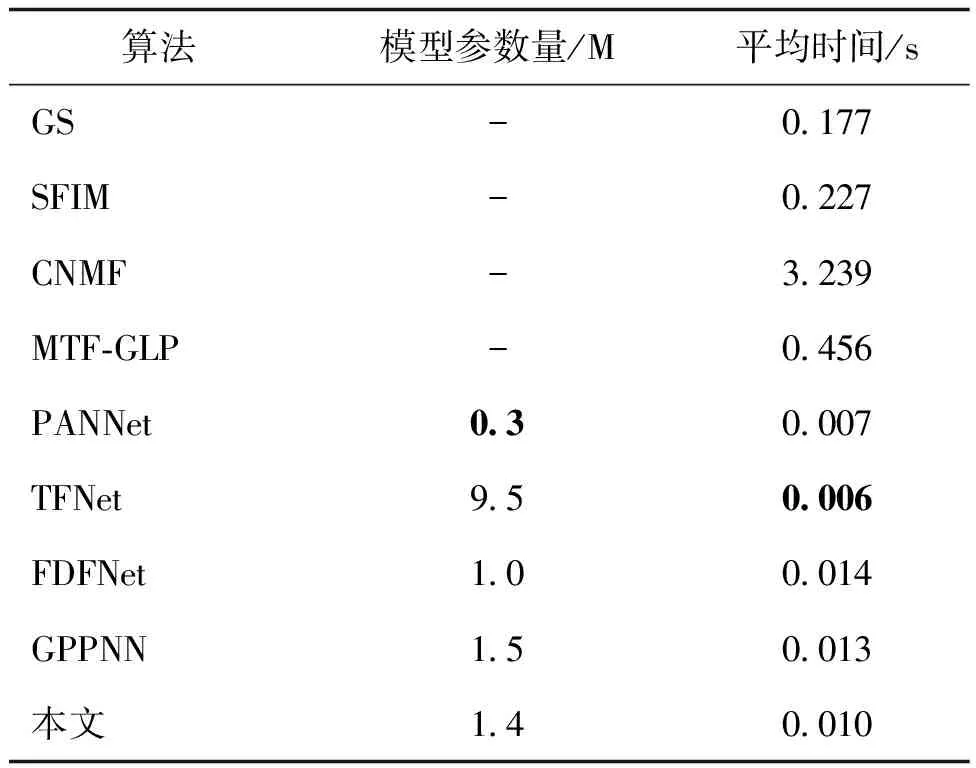

为比较不同模型的大小及平均处理用时,在GaoFen-2全分辨率测试集上进行测试,该测试集共包含180对多光谱/全色图像,其中多光谱图像尺寸为128×128×4,全色图像尺寸为512×512。结果如表4所示。可以看到基于深度学习的方法比传统方法运行速度更快,TFNet的运行速度最快,平均每个图像对只用0.006 s,PANNet的模型参数量最小,只有0.3 M,但本文算法在时间、模型参数量和效果上达到了平衡,以很小的时间和空间代价取得了较大的性能提升。

表4 时间和模型参数比较结果

3 结 论

本文提出了一种端到端的基于通道融合的渐进式细节增强遥感图像融合算法,通过通道融合充分利用两个模态的互补信息生成高分辨率的多光谱图像。同时为了解决之前方法上采样多光谱图像带来的图像质量下降和空间细节缺失的问题,提出了渐进式增强多光谱图像,代替直接上采样的操作。具体来说,算法分为两个阶段:渐进尺度细节增强和通道融合。在渐进尺度细节增强中,多光谱图像与不同尺度的全色图像拼接在一起,利用全色图像中丰富的细节信息增强多光谱图像;在通道融合中,将增强的多光谱图像按通道拆分为4个子图,每个子图都与全色图像进行融合,最后将得到的特征重构为高空间分辨率的多光谱图像。本文开展的所有消融实验验证了各个模块的有效性,同时对比实验的结果表明本文算法在视觉效果和数值表现上均明显超过了此前的算法,表明了本文模型的高效性。目前本文方法仅在4通道的多光谱图像融合上取得了良好的效果,若要扩展到更多通道的数据,如Landsat8等,则需要修改通道融合中各模块的通道数量,不够灵活。所以未来的研究方向应着眼于构建一种自适应多光谱图像通道数的融合结构。