基于全卷积神经网络的肛提肌裂孔智能识别

胡鹏辉,王 娜,王 毅,王慧芳,汪天富,倪 东

1) 深圳大学医学部生物医学工程学院,广东省生物医学信息检测与超声成像重点实验室,医学超声关键技术国家地方联合工程实验室,广东深圳518060;2) 深圳大学第一附属医院,深圳市第二人民医院超声科,广东深圳518035

女性盆底功能障碍性疾病(female pelvic floor dysfunction, FPFD)包括盆腔器官脱垂(pelvic organ prolapse, POP)、 压力性尿失禁(stress urinary incontinence, SUI)和粪失禁(fecal incontinence, FI)等一系列综合征.FPFD致病因素有很多,目前主要原因是由妊娠及分娩引起的肛提肌损伤(levator trauma, LT).临床研究表明,LT与FPFD密切相关[1].DELANCEY等[2]研究发现,LT导致女性泌尿生殖裂孔增大,更易发生POP;SINGH等[3]指出,肛提肌裂孔(levator hiatus, LH)大小的定量测量可用于评价POP;DIETZ等[4]研究发现,LT范围与POP的严重程度呈正相关关系.

盆底超声因具有实时成像、费用低且无辐射的优点,成为盆底疾病主要的影像检查手段[5].LH边缘描记是对其生物参数测量的首要条件.图1中的红线为盆底专家对两种典型病例(即边缘模糊和肛提肌单侧损伤)LH边缘的手动标注结果.临床诊疗中,这种手动描记方式易受医生主观经验影响,误差大、步骤繁琐且耗时长,因此,LH的智能识别对FPFD诊疗至关重要.但是,从盆底超声图像中智能识别LH时面临以下难点:① 临床数据的采集、处理与标注极具挑战性且相当耗时;② 超声图像存在声影、散斑和边缘模糊等特点;③ 采集二维容积数据时,探头的位置或加压不当,都会导致图像质量欠佳,影响后续处理;④ 肛提肌单侧或双侧损伤导致LH边缘不完整.

图1 盆底超声中的肛提肌裂孔手动标注结果(红线为医生手动标注;蓝色和黄色箭头分别为肛提肌边缘模糊和单侧撕裂)Fig.1 The manual labels of levator hiatus in pelvic ultrasound image(The red contour indicates corresponding ground truth. Blue and yellow arrows denote boundary deficiency caused by US characteristic and injury of the levator ani, respectively)

LH的自动分割是智能盆底超声中较创新的研究方向,据检索,目前尚无完全自动的肛提肌裂孔智能识别解决方案.SINDHWAI等[6]利用水平集方法实现半自动LH轮廓的描绘,因其需要手动标记2个解剖位置点——耻骨联合后下缘点和耻骨直肠肌底部前缘点,该方法分割精度受图像质量影响较大.近年来,随着深度学习的蓬勃发展,其在医学超声图像处理领域相比传统的医学超声图像处理方法表现更好.卷积神经网络(convolutional neural network, CNN)[7]虽然在图像前景分类有不错的效果,但基于CNN的分割方法一般采取逐像素取块分类的方法,非常耗时;同时,限于图像块的大小,该方法无法利用上下文信息,令算法性能存在较大瓶颈.端到端的全卷积神经网络(fully convolutional neural network, FCN)[8]利用卷积层代替全连接层,使用编码器-解码器的网络结构,可分割任意尺寸的图像,但FCN中采用的上采样结构会使图像细节信息丢失,降低了分割精度;SegNet[9]也是端到端的编码器-解码器结构网络,相比FCN中仅通过跳跃方式复制编码器特征,SegNet还复制了最大池化指数,使得SegNet更加高效,但此模型仍过于复杂.所以,对LH超声图像分割问题,本研究参考SegNet网络结构设计思想,提出Auto-Net结构,同时考虑到超声图像成像质量差的特点,采用细节信息优化策略[10]——自动上下文(auto-context)模型思想对Auto-Net网络结构进行完善,增强了网络全局特征的学习能力,提高了预测图的局部空间一致性[11].最后,采用全连接条件随机场(conditional random fields, CRF)加强边缘约束,对分割结果实现精细化处理,为后续生物参数的精确测量打下基础.

本研究基于上下文及条件随机场的肛提肌裂孔智能识别方法,提出以下几点创新:① 参考SegNet的网络设计思想,简化VGG16结构,提出分割网络Auto-Net,对LH的分割任务有更好的性能表现,能够更加准确快速地识别LH;② 利用自动上下文模型思想完善网络结构,增强网络捕捉不同尺寸不同层次的特征信息,有效提升LH分割精度;③ 基于卷积神经网络的粗分割结果,采用条件随机场算法增强边缘约束,有效解决了LH分割结果中边缘不完整的问题.

1 方 法

本研究主要目标是从盆底超声图像中精确识别出肛提肌裂孔,通过采用适应临床的数据预处理方法、上下文模型卷积神经网络和迁移学习训练方式,并利用条件随机场的后处理技术完成LH分割任务.图2为本研究提出的基于上下文及条件随机场模型的卷积神经网络(auto-context convolution neural networks with CRF, Auto-Net-CRF)的流程图.下面将部分介绍整个研究所用的方法,包括数据预处理、卷积神经网络原理、上下文模型网络、全连接随机场以及迁移学习策略.

图2 基于上下文及条件随机场模型的卷积神经网络流程图Fig.2 Flowchart of Auto-context convolutional neural network with conditional random fields

1.1 数据预处理

本研究对原始盆底超声图像进行一系列的预处理,以达到神经网络的训练要求,预处理流程如图3.

图3 盆底超声预处理流程图 Fig.3 Flowchart of pretreatmentin pelvic ultrasound image

首先,裁剪出LH所在的图像区域;其次,由3位经验丰富的医生分别对其进行间隔期为1周的2次标注,为降低医生之间因临床经验等不同以及医生自身观察角度各异导致的标注误差,取3位医生6次标注的平均值作为分割的标签;然后,对LH图像进行直方图均衡化处理来增强对比度,以降低超声图像中伪影、噪声和边界模糊等的干扰;最后,由于深度学习往往需要大量的训练样本,而临床数据采集比较困难,因此,本研究采用数据增强技术[7],以随机裁剪、平移、缩放、旋转和镜像等方式增大数据集规模,解决因数据集过小致使网络训练出现过拟合的问题.

1.2 卷积神经网络结构

CNN是近几年发展起来,并引起广泛关注的一种深度学习方法.因其独特的网络结构可以有效地降低反馈神经网络的复杂性,现已成为机器学习领域的研究热点之一.

一般来讲,卷积神经网络主要包括3种基本结构(层):其一是卷积核(层),每个卷积核与前一层的特征图局部相连,并提取该部分的特征.一旦该局部特征被提取后,它与其他特征间的相对位置关系也随之确定下来.此外,由于一个特征图上的卷积核共享权值,因而减少了网络中自由参数的个数,避免了特征提取和分类过程中出现维度灾难(curse of dimensionality)[12].其二是激活函数δ(·), 网络中卷积核提取的特征,经过激活函数抽象为更高阶的特征,使其更具有表达能力.同时常用的激活函数如修正线性单元(rectified linear unit,ReLU[13])等,使得特征抽象具有位移不变性.其三是池化核(层),本质就是采样,对输入的特征图以某种方式进行压缩如均值池化和最大值池化(max-pooling)等,从而减少网络参数,使卷积网络具有一定的抗干扰能力.卷积计算公式为

(1)

1.3 上下文模型网络

TU等[11]提出的自动上下文模型在图像分割[14]和图像识别[15]等任务中具有良好的性能表现.该算法的核心思想是一系列训练模型的级联叠加,第k-1级分类器输出的预测概率图包含感兴趣目标区域的基本形状、前景与背景的轮廓分割等有价值的信息.通过上下文特征与灰度特征的融合,得到比k-1级更有效的特征描述,将其输入到第k级分类器,进而实现预测图的概率精细化.按照这种方式不断迭代,直到取得最优图像分割结果.

但是,传统上下文模型的应用方法是将灰度图与预测概率图通道融合后输入分类器再次学习,在实际应用中这种方法存在以下问题:① 灰度图像和预测概率图是以互相独立的状态输入分类器,分类器无法学习预测概率信息与灰度信息之间的关系;② 小数据集灰度信息直接输入神经网络进行重复学习,可能引起过拟合使分类器性能大大降低;③ 随着迭代次数的增加,网络计算量、训练时间以及占用内存率等都会实时地呈指数增长.

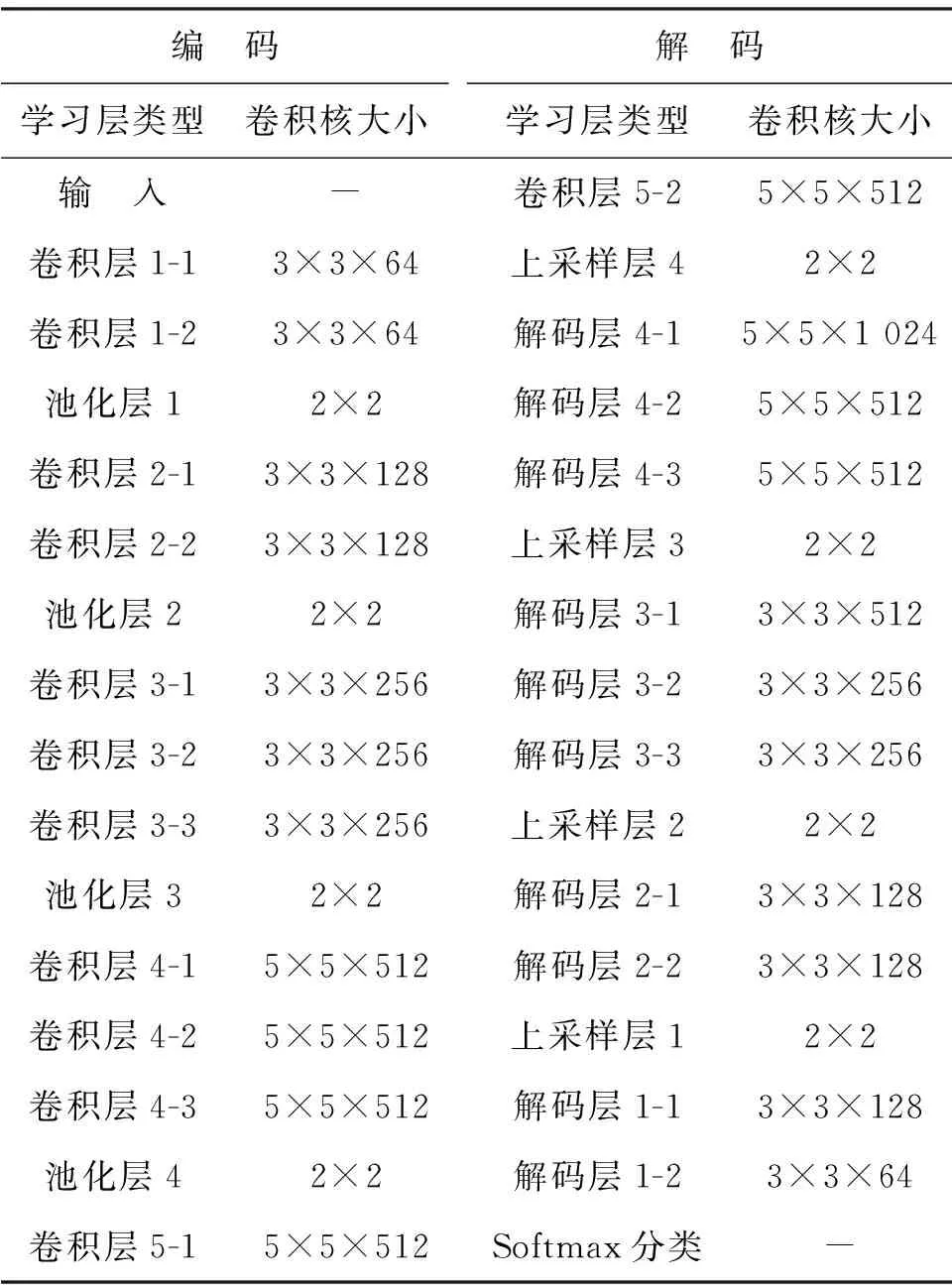

为解决以上问题,本研究提出一种基于上下文及条件随机场模型的卷积神经网络,其网络结构如图2所示,参数设置如表1.

首先,参考SegNet编码-解码[9]的思想构建基本卷积神经网络,并在此基础上进行以下改进:

1)神经网络通过卷积核对图像局部卷积提取局部特征,而卷积核的大小决定了感受野的范围.为提取全局特征,神经网络一般通过增加网络深度,使多层小卷积核实现感受野叠加.但对本研究中小数据集的二分类任务而言,过深的网络结构往往会降低网络性能,出现过拟合等问题,因此本研究简化VGG16结构——设计4层卷积,根据大卷积核的优势[16],将最后一层卷积3×3的卷积核改为5×5,以此扩大感受野达到快速提取全局特征的目的,实验结果也证明了其有效性.

2)将自动上下文思想引入神经网络中,如图2灰色箭头所示.分别将编码过程中输入图和第3及第4层卷积图与对应解码部分融合,强化网络的特征学习,进而实现对LH图像的精细化分割.最后,将完成零均值和归一化处理后的LH图像输入到基于上下文及条件随机场模型的卷积神经网络中,采用反向传播和随机梯度下降算法[19],以端到端的方式训练,得到LH初步分割结果.

表1 Auto-Net模型结构

1.4 全连接条件随机场

文献[17]提出的条件随机场,因其在序列预测和文本分析等方面良好的性能表现,被广泛用于深度神经网络的后处理过程[18-20].该算法根据输入图像学习不同类别标签的后验条件概率分布,再通过最大化后验概率获取图像中对应像素点的最佳标签.本研究为完善LH分割结果,将Auto-Net输出的LH预测概率图输入CRF模型,利用CRF算法对LH概率图中各个像素点及其周围像素对应的概率进行统计分析,以抑制小概率点同时增强大概率点的方式,实现对LH分割结果的精细化处理.

1.5 迁移学习

对小数据集的模型训练,过拟合是一个大问题.近年来的大量研究证明[21-23],先从大规模的自然数据集上预训练一个网络模型,然后将该模型前n层参数复制到对应目标网络层中完成前n层网络初始化,余下层则随机初始化参数,这种方式可有效防止训练过程中出现收敛速度慢和梯度消失等情况[13],同时解决了数据量过小导致的过拟合问题.这种迁移学习网络层参数方法的有效性在于神经网络提取的特征具有层级特性,即浅层网络提取低层特征,该类特征往往具有一般共性、描述的是目标颜色和轮廓等基本特性,从不同数据集获取的低层特征相似度很高;而深层网络一般提取高层特征,这些特征具有很大的特异性,不同数据集对应的高层特征往往差异较大.因此,本研究通过迁移预训练浅层网络学习参数来共享低层特征,进而实现自然图像到医学图像的迁移学习.

按照目前的研究[23],网络训练的方式可将迁移学习分为2种:一种是训练时固定迁移过来的学习层参数,只改变随机初始化的学习层参数;另一种是在训练时微调迁移的学习层参数.LIN 等[24]指出,ImageNet图像与盆底超声LH图像之间有较大差异,不适合利用固定层参数的迁移学习方式.所以,本研究通过微调迁移层参数的方式进行训练.首先,利用数据集ImageNet[25]预训练VGGNet[16]作为Auto-Net-CRF模型的基础网络;然后,复制VGGNet前3层卷积层参数至Auto-Net-CRF对应学习层;最后,设置合理的学习率.学习率调整是训练出良好性能模型的关键要素,学习率过大导致梯度过大或振荡无法收敛;学习率过小则梯度无明显下降,训练极慢.根据网络设计及具体的学习任务,本研究将迁移参数层和随机初始化参数层学习率分别设为0.001和0.01,训练过程中所有参数层学习率均以“step”方式逐渐减小.

2 实验与分析

2.1 实验数据

本实验所有肛提肌裂孔超声数据均采集自深圳市第二人民医院,并由临床医生手动标注,共采集284位患者,在最小裂孔面积平面下静息、缩肛、valsalva状态下LH三维容积图像合计372张.研究对象年龄在22~42岁,平均(31±4)岁,身高150.0~170.0 cm,平均(159.8±4.7) cm,体重39.00~89.00 kg,平均(59.04±8.15) kg,超声检查设备为Mindray Resona7彩色多普勒超声诊断仪配备4D腔内容积探头DE10-3WU,探头频率为3.0~10.0 MHz,最大扫查角度175°.

为全面评估分类器性能,实验采用交叉验证法,先将数据集D随机划分成10个互斥子集,即D=D1∪D2∪…∪D10,Di∩Dj=Ø(i≠j). 依次取1个子集作为测试集,余下的9个子集经数据增强后用于训练,其中300张作为验证集.

2.2 实验环境

本研究采用tensorflow1.2框架进行基于上下文及条件随机场模型的肛提肌裂孔智能识别.实验使用的计算机硬件环境为32核2.9 GHz Intel Xeon E5-2670 CPU和NVIDIA 1080 GPU.训练整个基于上下文及条件随机场模型的卷积神经网络训练耗时约10 h.测试阶段则速度较快,在加载训练好的网络后,单张图像只需0.1 s就能得到分割结果.

2.3 实验结果

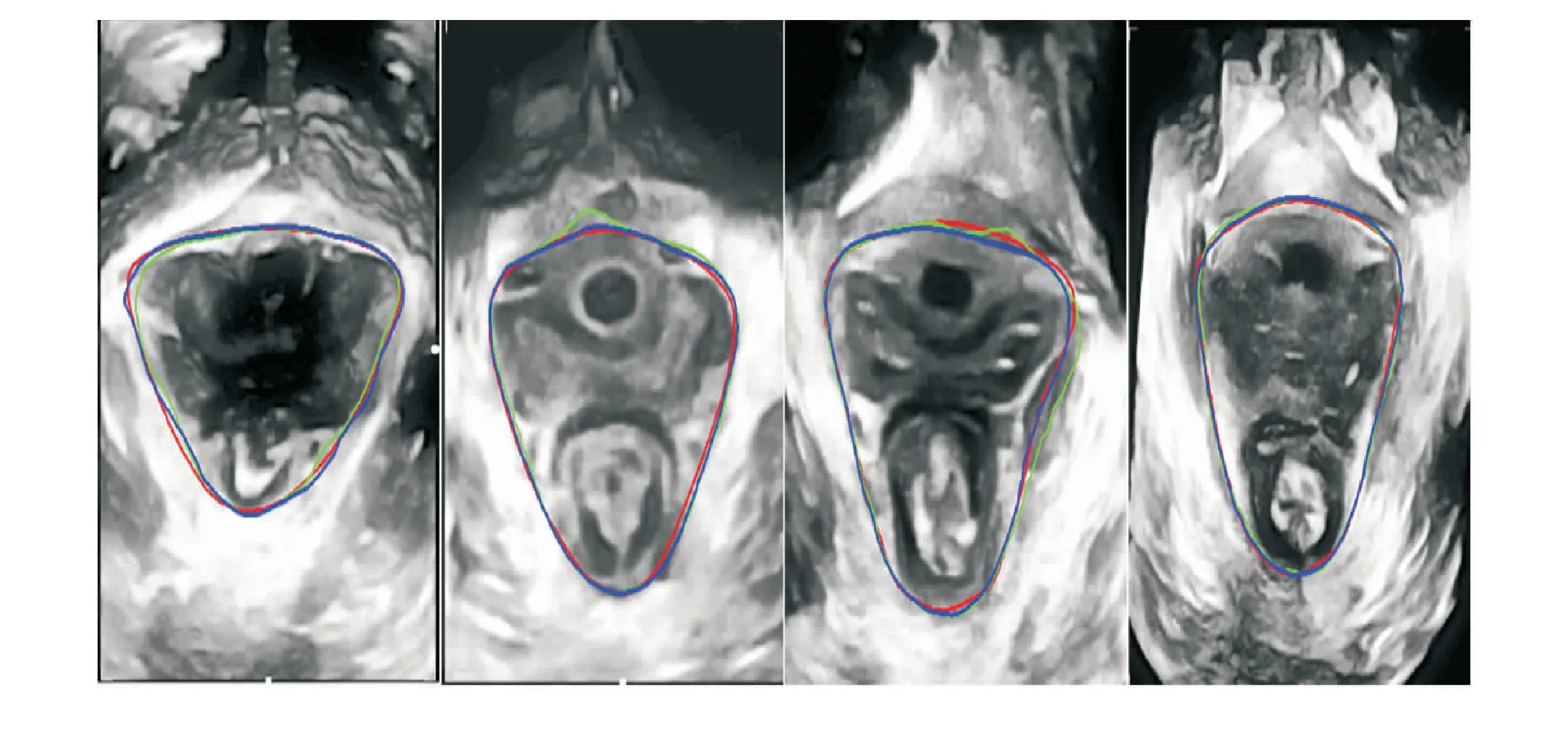

图4展示了LH自动分割结果.其中,红线表示医生手动描记,绿线表示Auto-Net的分割结果,蓝线表示Auto-Net-CRF的分割结果.

图4 肛提肌裂孔分割结果图展示(红线表示医生手动描记,绿线表示上下文网络模型输出结果,蓝线表示加入条件随机场后的输出结果.)Fig.4 The segmentation results of PUS LH images (The red denotes the ground truth, while the green and blue represent output of Auto-Net and result of CRF procession, respectively.)

由图4可见,Auto-Net能够有效分割出LH,表明本研究所设计的卷积网络有效,但与医生标注的结果重合度仍有一定差距,边缘不够平滑,存在分割边界凸起和凹陷等问题;而把CRF加入网络,增强边缘约束后,分割效果的提升较为明显,分割边缘平滑,与医生的标注结果基本吻合.

为更全面准确地评估分割结果,本研究参考文献[25-27],同时采用区域和形状相似度两类评价指标,即重合率(Dice)、相似度(Jaccard)、一致性系数(conformity coefficient,Cc)、Hausdorff距离(Hausdorff distance,HdD)和边界平均距离(average distance of boundaries, Adb) 5种指标评价LH分割结果.其中,Dice、Jaccard和Cc为基于区域的评价指标;HdD及Adb是基于距离的评价指标,单位是像素.设G为医生手动标记的目标区域(ground truth),S为算法自动分割结果(automatic segmentation),3种基于区域的评价指标计算公式分别为

(2)

(3)

(4)

其中,函数S(·)表示面积计算符.

基于区域面积的评价指标侧重于评价医生手动标记与算法自动分割结果在空间维度上的重合度,这就存在一个弊端,当目标区域面积较大时,基于区域面积的评价指标对细节的评价能力有限;相比之下,基于距离的评价指标更侧重于手动标记与自动分割结果轮廓线的吻合度,在图像分割评价指标中较为准确.两种基于距离的评价指标表示为

HdD= max(maxpG⊂Gdmin(pS,S),

maxpG⊂Sdmin(pS,S))

(5)

(6)

其中,dmin(pG,S)为G上的点pG到S上最近点的距离;dmin(pS,G)为S上的点pS到G上最近点的距离;σG为G轮廓上点的个数.

为比较不同数据增强方法的效果,使用Auto-Net在测试数据上进行分割性能的对比.如表2,使用旋转和裁剪的模型性能指标明显优于不使用裁剪(旋转)的模型性;仅使用裁剪(旋转)会使模型性能有一定上升,但仍不及两者均使用.表2充分说明本研究使用数据增强方法的可行性.

依据上述指标,本研究的框架与当前图像分割领域较流行的深度学习模型(CNN、U-net[28]、SegNet和FCN)在测试数据上进行分割性能的评估与比较,如表3.

表2 不同数据增强方法分割性能比较

表3 不同分割方法性能比较

由表3的评估结果可知,Auto-Net模型作为本研究框架的核心算法,Dice、Jaccard、Cc、HdD和Adb 5种指标评价均优于其他传统的神经网络模型,而CRF的使用让Auto-Net的分割性能得到进一步提升.Auto-Net-CRF和原模型SegNet相比,5种指标均有明显提升.

结 语

本研究创新性地将自动上下文思想融入网络设计中,提高了分类器性能;条件随机场的使用加强了LH的边缘约束,有效解决了因LH边缘模糊而分割边缘不完整的问题.基于上下文及条件随机场的肛提肌裂孔智能识别方法能够准确高效地从盆底超声图像中识别出肛提肌裂孔,为后续的参数测量研究提供了理论和技术支持.目前,中国超声界正在组建女性盆底疾病的多中心协作重点实验室,致力于制定出针对亚洲人盆底疾病诊断的标准,更快且更准确地获取研究数据显得尤为重要,尤其是对于测量步骤繁琐的LH而言.因此,基于上下文及条件随机场的肛提肌裂孔智能识别方法有望在未来科研和临床上有更广阔的应用.

基金项目:国家自然科学基金资助项目(61571304, 61701312, 81571758, 81771922)

作者简介:胡鹏辉(1992—),男,深圳大学硕士研究生.研究方向:医学图像分析.E-mail:515102745@qq.com

引文:胡鹏辉,王 娜,王 毅,等.基于全卷积神经网络的肛提肌裂孔智能识别[J]. 深圳大学学报理工版,2018,35(3):316-323.

参考文献/References:

[1] DIETZ H P, SIMPSON J M. Levator trauma is associated with pelvic organ prolapse[J]. Bjog: An International Journal of Obstetrics & Gynaecology, 2008, 115(8): 979-984.

[2] DELANCEY J O, MORGAN D M, FENNER D E, et al. Comparison of levator ani muscle defects and function in women with and without pelvic organ prolapse[J]. Obstetrics & Gynecology, 2007, 109(2 Pt 1): 295-302.

[3] SINGH K, JAKAB M, REID W M N, et al. Three-dimensional magnetic resonance imaging assessment of levator ani morphologic features in different grades of prolapse[J]. American Journal of Obstetrics & Gynecology, 2003, 188(4): 910-915.

[4] DIETZ H P, SHEK C, DE L J, et al. Ballooning of the levator hiatus[J]. Ultrasound in Obstetrics & Gynecology the Official Journal of the International Society of Ultrasound in Obstetrics & Gynecology, 2008, 31(6): 676.

[5] YING Tao, LI Qiu, XU Lian, et al. Three-dimensional ultrasound appearance of pelvic floor in nulliparous women and pelvic organ prolapse women[J]. International Journal of Medical Sciences, 2012, 9(10): 894-900.

[6] SINDHWANI N, BARBOSA D, ALESSANDRINI M, et al. Semi-automatic outlining of levator hiatus[J]. Ultrasound in Obstetrics & Gynecology, 2016, 48(1): 98.

[7] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]// International Conference on Neural Information Processing Systems. North Miami Beach, USA: Curran Associates Inc, 2012: 1097-1105.

[8] SHELHAMER E, LONG J, DARRELL T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2017, 39(4): 640-651.

[9] BADRINARAYANAN V, KENDALL A, CIPOLLA R. SegNet: a deep convolutional encoder-decoder architecture for scene segmentation[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2017, PP(99):1.

[10] CHEN Hao, ZHENG Yefeng, PARK J H, et al. Iterative multi-domain regularized deep learning for anatomical structure detection and segmentation from ultrasound images[C]// Intemational Conference on Medical Jmage Computing and Computer-assisted Jntervention. Athens:[s.n.] 2016: 487-495.

[11] TU Zhuowen. Auto-context and its application to high-level vision tasks[C]// IEEE Conference on Computer Vision and Pattern Recognition.[S.l.]: IEEE, 2008: 1-8.

[12] XU Bing, WANG Naiyan, CHEN Tianqi, et al. Empirical evaluation of rectified activations in convolutional network[EB/OL]. (2015-05-05). https://arxiv.org/abs/1505.00853.

[13] ZHU Jun, CHEN Xianjie, YUILLE A L. DeePM: a deep part-based model for object detection and semantic part localization[EB/OL]. (2015-11-23).[2016-01-26]. https://arxiv.org/abs/1511.07131

[14] GAO Yaozong, WANG Li, SHAO Yeqin, et al. Learning distance transform for boundary detection and deformable in CT prostate images[M]// Machine Learning in Medical Imaging. Heidelber, Germany: Springer International Publishing, 2014, 8679: 93-100.

[15] QIAN Chunjun, WANG Li, YOUSUF A, et al. In vivo MRI based prostate cancer identification with random forests and auto-context model[C]// International Workshop on Machine Learning in Medical Imaging. Heidelber, Germany: Springer International Publishing, 2014: 314-322.

[16] LIU Ziwei, LI Xiaoxiao, LUO Ping, et al. Semantic image segmentation via deep parsing network[C]// IEEE International Conference on Computer Vision. New York, USA: Computer Society, 2015: 1377-1385.

[17] LAFFERTY J D, MCCALLUM A, PEREIRA F C N. Conditional random fields: probabilistic models for segmenting and labeling sequence data[C]// Proceedings of the Eighteenth International Conference on Machine Learning. San Francisco, USA: Morgan Kaufmann Publishers Inc, 2001: 282-289.

[18] CHEN L C, PAPANDREOU G, KOKKINOS I, et al. DeepLab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 40(4): 834-848.

[19] CHEN L C, PAPANDREOU G, KOKKINOS I, et al. Semantic image segmentation with deep convolutional nets and fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848.

[20] CHANDRA S, KOKKINOS I. Fast, exact and multi-scale inference for semantic image segmentation with deep Gaussian CRFs[C]// European Conference on Computer Vision. Heidelber, Germany: Springer International Publishing, 2016: 402-418.

[21] DONAHUE J, JIA Yangqing, VINYALS O, et al. DeCAF: a deep convolutional activation feature for generic visual recognition[C]// Proceedings of the 31st International Conference on Machine Learning. Beijing: JMLR.org, 2014: 32 (1) 1-647

[22] RAZAVIAN A S, AZIZPOUR H, SULLIVAN J, et al. CNN features off-the-shelf: an astounding baseline for recognition[C]// IEEE Conference on Computer Vision and Pattern Recognition Workshops. Columbus, USA: IEEE, 2014: 512-519.

[23] YOSINSKI J,CLUNE J,BENGIO Y,et al.How transferable are features in deep neural networks?[EB/OL].(2014-11-06). https://arxiv.org/abs/1411.1792

[24] LIN T Y, MAIRE M, BELONGIE S, et al. Microsoft COCO: common objects in context[J]. Computer Science,2014, 8693: 740-755.

[25] HUANG Qian, DOM B. Quantitative methods of evaluating image segmentation[C]// Proceedings of the International Conference on Image Processing. Washington DC, USA: IEEE Computer Society, 1995: 3: 3053.

[26] TAHA A A, HANBURY A. Metrics for evaluating 3D medical image segmentation: analysis, selection, and tool[J]. BMC Medical Imaging, 2015, 15(1): 29.

[27] CHANG H H, ZHUANG A H, VALENTINO D J, et al. Performance measure characterization for evaluating neuroimage segmentation algorithms[J]. Neuroimage, 2009, 47(1): 122.

[28] BADRINARAYANAN V, KENDALL A, CIPOLLA R. SegNet: a deep convolutional encoder-decoder architecture for scene segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(12): 2481-2495.