在线学习机制下几何模糊特征目标检测及跟踪

陈 莹,沈宋衍( 江南大学 轻工过程先进控制教育部重点实验室,江苏 无锡 214122 )

在线学习机制下几何模糊特征目标检测及跟踪

陈 莹,沈宋衍

( 江南大学 轻工过程先进控制教育部重点实验室,江苏 无锡 214122 )

摘要:针对目标跟踪中目标框发生偏移、消失等问题,于在线学习机制下提出一种基于几何模糊的跟踪检测学习的目标跟踪方法。以跟踪-检测-学习为框架,利用Lucas-Kanade算法,获得目标的初步跟踪结果。运用几何模糊的匹配思想代替传统检测手法,有效校正跟踪偏移,避免误差累计。整合器比较跟踪、检测结果与上一帧结果的相似度,通过计算正负样本与检测子区域的归一化相关系数比求得置信度,得到目标的精准定位。其结果通过学习器进行在线学习,从而进行下一帧的跟踪。实验结果表明,将该检测思想应用于快速移动目标跟踪时,在背景相似度较高的条件下,表现出了良好的性能,与其他新的方法比较也有较高的定位精度。

关键词:目标跟踪;几何模糊;跟踪-学习-检测;在线学习

0 引 言

视频目标跟踪是计算机视觉的一个重要研究方向,在视频监控、机器人等领域具有广泛的应用前景[1],因此广受研究者的关注,出现许多积极的研究成果。但是,由于明暗变化,目标消失、变形,部分或者全部遮挡的问题,设计一个鲁棒的跟踪系统仍是艰巨的任务。根据目标外观处理方式的不同,跟踪方法可分为基于生成模型[2-6]和基于判别模型两大类[7-15]。

生成模型首先要学习外观模型来描述目标,然后搜索每一帧与目标外观最为相似的进行学习。BLACK等人[2]通过离线的外观模型学习一个子空间。然而,离线学习外观模型对于适应外观变化是十分迟钝的。为了处理这个外观变化的问题,许多在线模型被提出来了,例如WLS跟踪[3]和IVT方法[4]。一般该类方法要求训练得到一个完善的外观模型,这需要大量的样本,而在应用中,已标记的样本很少,只能在跟踪过程中获得,跟踪中获得的样本通常伴随潜在的偏差,会导致跟踪性能下降。

基于判别模型的跟踪算法,将跟踪看作一个二分类问题,通过训练判别分类器将目标从背景中分离。Lichter[9]提出采用交叉bin颜色直方图表示目标特征,可以提高Mean-Shift的鲁棒性;Ning等人[10]指出采用BWH的Mean-Shift,通过迭代得到的结果与传统Mean-Shift算法相同,并不能减少背景的影响;然后对BWH进行改进,提出了CBWH,实现了对背景的有效抑制。在此之后,许多方法中的正样本和负样本也运用到在线更新分类器[11-15]:正样本通过目标定位从目标位置上获取,负样本则是远离定位位置的图片块。但是,当发生定位偏移时,错误的正负样本将混淆分类器,降低其分类效果。文献[14]中,TLD(Tracking-Learning-Detection)利用跟踪检测同时工作的思想,来共同确立跟踪目标框,并且利用二分类的学习机制反馈给检测器和跟踪器,更新分类器得到较高的跟踪效率,但是一旦跟踪器跟踪失败时,无法产生新的正负样本,那么分类器分类效果降低,即使在后续帧中能找到目标,目标框也会引起延后的效果,导致目标框发生了偏移。Martin Danelljan[15]提出了CNT算法,运用颜色名称特征(Color Names)构建目标训练正则化最小二乘分类器,进行目标跟踪。

本文在基于跟踪-学习-检测的目标跟踪框架下,为了解决TLD跟踪发生偏移延后的问题,引入了几何模糊(Geometric Blur, GB)[16]特征匹配的思想,通过随机森林初检测和几何模糊的深度检测来设计TLD检测器,改善检测器精度和有效性,结合Lucas-Kanade (L-K)跟踪与PN学习,通过比较跟踪和检测置信度以及与上一帧的相似度更新学习的正负样本,提高跟踪准确度,并根据跟踪结果更新检测器GB特征点,进而有效克服目标的漂移问题。

1 基于GB的TLD检测机制

视频帧进入检测器后,检测器通过随机森林分类器选出多个最有可能是目标的子区域,跟踪器的结果相结合找到待匹配区域。在此基础上,利用GB特征匹配得到检测结果。

1.1 初级检测

为了找到最接近目标的子区域,与跟踪器结果进行相与确定匹配的区域,运用随机森林分类器[17]中的随机蕨丛(Random Ferns)[18]计算二维二值特征[19],通过后验概率进行分类寻找子区域。

这些子区域与跟踪器BBT的结果TB求覆盖率覆盖率最大的块与BBT(TB)相或,所得区域则为待匹配区域,即目标的初级检测结果,其流程示意如图2所示。

图1 目标初级检测Fig.1 The primary detection of object

在图1(a)中框内为跟踪器的结果;图1(b)中框内为随机蕨丛初始检测器的检测结果,将覆盖率最大的子区域与BBT相或,得到的区域即框内区域(见图1(c))。可以看到跟踪器的结果对于目标来说已经发生缓慢的偏移,而经过初始检测后,可以得到较好的匹配区域。

1.2 基于GB特征的精检测

GB的局部特征点对形变下的目标识别具有较好的效果,通过图像边缘能量特征点,利用几何描述,得到相对应的匹配点,这些匹配点个数不会因为图像变化而减少,且这些匹配特征点都位于目标边缘,通过匹配点的坐标可以得到目标检测区域。

1.2.1 GB特征点提取及匹配

通常,目标在发生形变的情况下,很难进行精确匹配。Berg等[20]提出了一种形变状态下的形状匹配方法,即先对原信号进行几何模糊,通过对比不同物体形状几何模糊后的差别来判定两个目标是否相似。

图像几何模糊特征提取的具体步骤如下:

步骤1:通过对图像进行梯度计算得到4个方向(0°,45°,90°,135°)的边缘能量稀疏信号;

步骤2:各稀疏通道通过卷积一个标准差为d的高斯核Gd,得到模糊模板Sd=Si* Gd。

步骤3:计算基准位置x0周围的几何模糊描述子:

其中:α,β决定了模糊程度,x为x0周围不同的点。

对于每个基准点,在4个通道中根据不同的距离均采样,然后拼接4个通道的采样点值从而得到最终的几何模糊描述符。采样一定的数量的边缘点作为基准点,然后提取几何模糊描述符用于匹配。

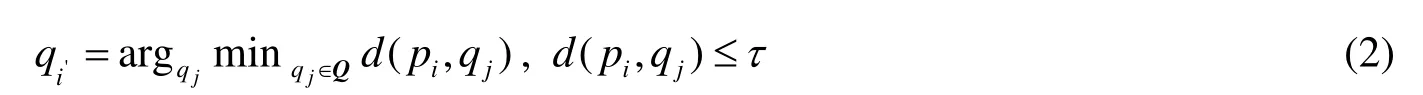

否则,pi在目标图像中不存在匹配点。其中d为相似度衡量函数。

1.2.2 精确目标检测

由于目标快速移动或外界环境的影响,跟踪器可能无法返回跟踪结果,导致无法得到目标初级检测结果。为此,基于GB特征设计两套精检测方案。

1) 当跟踪器返回跟踪结果时:采用1.1中的初级目标检测方法得到待匹配区域后,通过计算目标图像的GB特征点,提取几何模糊描述符,并且与模板图像进行匹配。

如图2所示,跟踪器有结果时,通过初检测器,得到待匹配区域(图中实线边框)。并且初检测区域与模板图像通过式(2)进行匹配,得到匹配结果,通过计算匹配点的最大最小的坐标值,得到精检测的结果(点画线)边框区域)。由此可以通过精检测的结果更加贴近目标外界矩形,减少了背景对目标的干扰。

图2 跟踪器成功时的检测结果Fig.2 The detection results of the tracker successfully

2) 当跟踪器无法返回跟踪结果时,模板图像与待检测全图进行匹配,其操作流程如图3所示,得到的GB匹配特征点,将特征点位置的像素灰度置1得到的二值图进行膨胀得到Idilate(x, y ),同时计算原图的梯度图像,采用中值滤波和腐蚀操作方法消除背景噪声得到图像Ig(x, y),通过得到图像Idect(x, y),可以通过Idect(x, y)膨胀填充等运算找到面积最大的区域,得到检测目标区域。

图3 跟踪器失败时检测流程Fig.3 Detection process when tracker failure

2 在线学习整合器

根据前文所述,无论跟踪器是否成功,都能得到检测结果,计算它的置信度。置信度的高低决定了跟踪器和检测器的效果。首先计算正负样本与检测结果的相似度,公式如下:

其中:p+,p-为正负样本,pBBd为检测器的结果区域,CNCC为归一化相关系数。

利用正负样本的相似度计算置信度:

通过式(5)计算跟踪器和检测器的置信度,取置信度较高的作为跟踪的最终结果。

3 实验分析

3.1 检测器分析

为检验本文方法中检测器有效性,将方法与基于SIFT匹配的检测[21]以及原始TLD[14]检测做分析比较。各方法的检测结果如图4所示,其中左侧为检测过程,右侧为检测结果。从图中可以看出,通过SIFT匹配检测,匹配点通过与模板图像的比例得到目标框(红色目标框),由于发生了错误匹配,目标框发生严重偏移。而原始TLD的检测器得到多个待选目标框(图中显示为黄色框),从若干个大小不一的区域中选取最为合适的目标区域,因为这些区域大小不一,导致检测出来的结果可能只是目标的一小部分,使得检测结果发生偏移,跟踪误差增大。而本文的GB检测机制可以在目标图像上找到比较多的匹配点,从这些匹配点中得到检测器的结果,并且效果对于前两种算法来说更好,能够更好的约束跟踪器结果。

此外,检测器的效率也影响着跟踪结果,当检测器长期处于没有状态的时候,那么相当于TLD只有跟踪器在工作,因此代码的利用率也会降低。三种不同检测方法的效率如表1。

图4 不同检测方式对比Fig.4 Comparison of different detection methods

从表1可以看出,本文的检测器效率很高,TLD根据不同图像检测效率也不同,说明TLD的检测器并不是很稳定,因此对于约束跟踪器的结果也是时好时坏。SIFT特征匹配的检测效果更差,很少能够匹配成功,即使匹配成功,检测到的目标框对跟踪器的约束也不是特别高,因此其效果不理想,没有把目标检测全甚至没有检测到。本文的GB特征检测器效率高,在多种复杂条件下能够把目标全检测到,对跟踪器的约束力也大大增加。

表1 不同检测器的检测效率Table 1 The detection efficiency of different detectors

3.2 跟踪结果分析

为验证本文跟踪方法的有效性和先进性,将本文方法与TLD且与较新的算法CT(Compressive Tracking)[22]和CNT(Color Names Tracker)[15]进行效果对比,CT通过一定的宽松规则,生成一个稀疏的投影矩阵,然后直接将压缩后的数据作为特征来使用。该跟踪结果的分析采用两种方式度量跟踪性能,首先,利用跟踪成功率对跟踪性能进行评价:

其中:Tв是跟踪的边界框,TG是真实的目标框,当csr>0.5时认为跟踪成功。

表2显示了不同算法的跟踪成功率。从该表中可以看出,本文算法在3个视频序列中的成功率相比较其他两种算法均是最高的。TLD算法对运动的人以及目标变化比较明暗,CT,CNT和TLD在目标剧烈运动时,会出现跟踪丢失。而本文算法无论光照还是运动、形变等情况下,都有较好的成功率。

其次,采用目标中心的定位误差δdist=|ctrack(x,y )-ctrue(x,y )|评价跟踪性能,其中ctrack是跟踪的中心点坐标,ctrue是真实的中心点坐标。

图5显示了跟踪结果中心位置误差的曲线,从图中可以看出Moto以及Pedestrian序列中本文算法的误差率相对与其他两种算法低,TLD算法在Pedestrian中产生严重起伏状态,表明跟踪不稳定,并且相比其他两种方法,误差大。CT在Moto中30~40帧之间产生剧烈起伏,CNT在30帧后发生严重漂移并且无法得到修正,误差也越来越大,同样产生漂移现象。David序列中,本文算法与其他算法曲线误差不大,在80~110帧时,目标由暗往明亮的地方出现时,光照明暗的快速变化,此时没有TLD和CNT处理很好,但是随着帧数的增加,本文算法慢慢修正补偿,从160帧后误差在快速下降。由此可见,相比前两种算法,本文算法对于漂移现象有很好的抑制作用。具体平均误差如表3所示。

表2 不同算法的成功率比较Table 2 Comparison of different algorithm success rate %

表3 中心位置误差Table 3 The center position error pixel

从表3可以看出,本文算法在3组视频上均是优秀的。其他算法都有局限性,比如TLD算法的检测器检测效果无法对跟踪器进行约束,当跟踪器失败的时候,检测器的结果也不能保证检测到或者检测正确,导致跟踪失败。其检测机制可能无法正确定位目标,这也导致错误学习,跟踪效果大大降低,并且对于行走以及形变较大情况下,跟踪有严重滞后现象。CT算法能很好面对遮挡,以及光照变化等问题,但是目标长时间消失重现以后也无法跟踪。CNT和CT面对剧烈运动,摄像机运动等情况会出现严重偏离目标现象,对于快速行走偶尔也会出现滞后现象。综合来看,本文算法面对行走等形变的视频序列跟踪效果好于其他三种方法。对于剧烈运动、目标遮挡、明暗变化也有较好的效果。

图5 中心位置误差曲线Fig.5 The center position error curve

图6给出了4种方法在不同视频的跟踪结果,在Moto中,本文算法能更加准确的处理一系列问题,对于摄像机运动,目标剧烈运动等问题相比于另外两种方法更为出色。TLD在剧烈运动中,目标范围缩小的情况下,认为不是目标,这样白白丢失了目标。CT和CNT在跟踪时,并没有很好的跟踪在目标上,发生了跟踪偏移,并且相当严重,这也是因为对于目标背景相对于模糊的情况下,正负样本在分类时发生了错误,导致了跟踪失败。

在Pedestrain中,本文算法主要处理目标走动产生形变以及快速行走跟踪滞后的问题,CT、CNT与本文算法都能很好的跟踪目标,成功率也相当高。但是随着帧数增加,CT、CNT会相对于真实目标框稍微滞后一点,而TLD由于目标快速移动并且形变较大,学习器并没有很好的学习,导致跟踪严重滞后。

综上所述,原来的TLD检测器对于变化较大的块则认为非目标,这样就会降低检测器的效率,对跟踪器的约束也大大降低,因此降低了整体跟踪精度。相较于原始的检测器,基于GB的检测方法可以避免因为形变大而丢失的目标,并且增加了检测精度以及效率,提高了对跟踪器的约束,对正负样本的修正也起到积极作用,对于目标框偏移、消失有很好的抑制作用。

4 结 论

TLD跟踪框架下,跟踪器和检测器通过在线学习机制不断提升,能够学习目标诸多变化,但由于误差累积或当目标发生较大偏移或形变时可能导致跟踪失败。论文基于几何模糊匹配思想进行检测器设计,当跟踪器发生偏移或丢失目标时,通过基于几何模糊的目标检测机制定位目标。在此基础上进行在线学习,重新初始化跟踪器,增加了检测器以及学习的效率,有效解决跟踪过程中目标偏移和消失的问题。

参考文献:

[1] Yilmaz A,Javed O,Shah M. Object tracking:A survey [J]. ACM Computing Surveys(S0360-0300),2006,38(4):13.

[2] Black M J,Jepson A D. Eigentracking:Robust matching and tracking of articulated objects using a view-based representation[J].International Journal of Computer Vision(S0302-9743),1998,26(1):63-84.

[3] Jepson A D,Fleet D J,El-Maraghi T F. Robust online appearance models for visual tracking [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence(S1063-6919),2003,25(10):1296-1311.

[4] Ross D A,Lim J,Lin R S,et al. Incremental learning for robust visual tracking [J]. International Journal of Computer Vision(S0920-5691),2008,77(1/3):125-141.

[5] Adam A,Rivlin E,Shimshoni I. Robust fragments-based tracking using the integral histogram [C]// IEEE Conference on Computer Vision and Pattern Recognition,New York,2006,1:798-805.

[6] MEI Xue,LING Haibin. Robust visual tracking using e1minimization [C]// IEEE 12th International Conference on Computer Vision,Kyoto,2009:1436-1443.

[7] Collins R T,LIU Yanxi,Leordeanu M. Online selection of discriminative tracking features [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence(S0162-8828),2005,27(10):1631-1643.

[8] Babenko B,YANG Ming-Hsuan,Belongie S. Robust object tracking with online multiple instance learning [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence(S0162-8828),2011,33(8):1619-1632.M Yang

[9] Leichter I. Mean Shift Trackers with Cross-Bin Metrics [J]. IEEE Transactions on Pattern Analysis & Machine Intelligence (S0162-8828),2012,34(4):695-706.

[10] NING Jifeng,ZHANG Lei,ZHANG David,et al. Robust mean-shift tracking with corrected background-weighted histogram [J]. IET Computer Vision(S1751-9632),2012,6(1):62-69.

[11] Babenko B,YANG Ming-Hsuan,Belongie S. Robust object tracking with online multiple instance learning [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence(S0162-8828),2011,33(8):1619-1632.

[12] Kalal Z,Matas J,Mikolajczyk K. P-N learning:Bootstrapping binary classifiers by structural constraints [C]// IEEE Conference on Computer Vision and Pattern Recognition(CVPR),San Francisco,IEEE,2010:49-56.

[13] ZHOU Qiuhong,LU Huchuan,YANG Ming-Hsuan. Online multiple support instance tracking [C]// IEEE International Conference on Automatic Face & Gesture Recognition and Workshops (FG 2011),Santa Barbara,IEEE,2011:545-552.

[14] Kalal Z,Mikolajczyk K,Matas J. Tracking-learning-detection [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence(S0162-8828),2012,34(7):1409-1422.

[15] Danelljan M,Khan F S,Felsberg M,et al. Adaptive color attributes for real-time visual tracking [C]// IEEE Conference on Computer Vision and Pattern Recognition (CVPR),Columbus,OH,June 23-28,2014:1090-1097.

[16] Berg A C,Malik J. Geometric blur for template matching [C]// Proceedings of the 2001 IEEE Computer Society Conference on Computer Vision and Pattern Recognition,Kauai,Hawaii,December 8-14,2001,1:I-607-I-614 .

[17] Breiman L. Random forests [J]. Machine Learning(S0885-6125),2001,45(1):5-32.

[18] Ozuysal M,Calonder M,Lepetit V,et al. Fast keypoint recognition using random ferns [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence(S0162-8828),2010,32(3):448-461.

[19] Kalal Z,Matas J,Mikolajczyk K. Online learning of robust object detectors during unstable tracking [C]// IEEE 12th International Conference on Computer Vision Workshops (ICCV Workshops),Kyoto,Sept. 27-Oct. 4,2009:1417-1424.

[20] Berg A C,Berg T L,Malik J. Shape matching and object recognition using low distortion correspondences [C]// IEEE Computer Society Conference on Computer Vision and Pattern Recognition,Berkeley,2005,1:26-33.

[21] Lowe D G. Distinctive image features from scale-invariant keypoints [J]. International Journal of Computer Vision(S0920-5691),2004,60(2):91-110.

[22] ZHANG Kaihua,ZHANG Lei,YANG Ming-Hsuan. Real-time compressive tracking [C]// Computer Vision–ECCV,Florence,Italy,October 7-13,2012:866-879.

Target Detection and Tracking Based on Geometric Blur with Online Learning Mechanism

CHEN Ying,SHEN Songyan

( Key Laboratory of Advanced Process Control for Light Industry, Ministry of Education, Jiangnan University, Wuxi 214122, Jiangsu Province, China )

Abstract:To solve the problem of tracking drifts or fail, a robust objects tracking algorithm based on geometric blur is proposed within the framework of online learning. Under the tracking-detection-learning mechanism, Lucas-Kanade algorithm is used to obtain the rough tracking estimation of the target. Based on the idea of geometric blur matching instead of traditional detection methods, the tracking drift is efficiently corrected. Then integrator is designed to compare the similarities between the previous frame and the results of the tracker and the detector. Their confidences are obtained by calculating normalized correlative coefficients between positive and negative samples and the detected region. An online learning is then developed to use the current result to update the tracker and the detector. Experimental results show that when applied to the fact moving target tracking under the condition of high background similarity, the proposed method performs well and outperforms other state-of-the-art methods with higher position accuracy.

Key words:object tracking; geometric blur; tracking-detection-learning; online learning

作者简介:陈莹(1976-),女(汉族),浙江丽水人。副教授,博士,主要从事计算机视觉与模式识别的研究。E-mail: chengxx1991jn@163.com。

基金项目:国家自然科学基金(61104213);江苏省自然科学基金(BK2011146)

收稿日期:2015-03-10; 收到修改稿日期:2015-06-08

文章编号:1003-501X(2016)02-0001-07

中图分类号:TP391

文献标志码:A

doi:10.3969/j.issn.1003-501X.2016.02.001