基于中央凹图像显著性和扫视倾向的注视点转移预测模型

王宜修,吴晓峰,王 斌

(1. 复旦大学 信息科学与工程学院 智慧网络与系统研究中心,上海 200433;2. 复旦大学 电磁波信息科学教育部重点实验室,上海 200433)

基于中央凹图像显著性和扫视倾向的注视点转移预测模型

王宜修1,2,吴晓峰1,王斌1,2

(1. 复旦大学 信息科学与工程学院 智慧网络与系统研究中心,上海 200433;2. 复旦大学 电磁波信息科学教育部重点实验室,上海 200433)

注视点转移预测是图像显著性建模中的一个重要研究领域.现有算法大多过于繁琐,并且局限于利用单张静态显著图来预测,很少能考虑到注视点转移是一个动态的过程.针对以上问题,我们提出一种具有生物依据的注视点转移的预测方法,利用了3大因素: 视网膜中央凹在显著目标选取中的动态预测作用、注视点移动在距离和方向上的倾向以及短期记忆对注视点返回的抑制机制.通过三者得到的联合转移概率随机产生候选点,从而逐点生成扫视轨迹.相比于其他模型,所提议方法在客观的衡量标准下,在多个数据库中能更准确、更高效地预测扫视路径.

注意力选择; 显著性; 眼动; 扫视路径

众所周知,每秒钟有数以亿计的信息进入人眼,一般认为这样海量的数据超过了人脑可以进行实时处理的极限.人类视觉系统(Human Visual System)可以自动地从大量冗余的视觉输入中提取最重要的部分以供大脑皮层进行高层次的处理,如记忆、目标识别、跟踪等.选择性视觉注意就是人类视觉中这样的一种机制.

人的视觉注意力转移揭示了人对场景中的物体感兴趣程度的变化,这些注视位置变化的记录通常包括两个部分: 注视点和扫视路径,前者表明了场景中哪些部分能引起人的注意,后者则体现了这些使人感兴趣的部分之间的顺序性.视觉注意力转移的研究不止关注场景中哪些区域能够引起人的兴趣,更能进一步揭示人是如何选择感兴趣区域的.

在显著性的可计算模型中,基于空间的模型[1]这一类别的主要研究目标是注视点密度和序列.除了在生物心理学机制验证上能够帮助解释人的视觉注意行为,在广告设计、机器人视觉等方面也有较多的应用,在未来的图像智能领域则有更深远的应用前景.在近年的显著性机制的研究中,已经有较多的基于空间的可计算模型被提出.根据研究对象的不同,这些模型可以被进一步细分为静态的注视点密度估计和动态的扫视路径估计两类.

Itti等[2]在特征综合理论[3]的基础上,最早提出了选择性视觉注意的静态模型.该模型模仿了视网膜感知域神经节细胞(Ganglion cells)的处理过程,在颜色、亮度、方向3个通道上计算中心周围差,结合胜者全取的仿生机制获得显著图作为注视点密度估计.该方法不但具有较强的生物依据,也成为后面许多方法的基础和比较标准.在Itti模型的基础上,一种利用图论模型的方法[4]被提出.这种方法以每个像素点作为节点,构造全连接的图来描述输入图像,利用马尔科夫平衡分布定义显著性.这两个经典模型的一个共同问题是计算复杂度高,速度不够快.因此,一种基于谱剩余的方法[5]被提出,该方法认为图像空间显著性信息主要集中在其幅度谱的残差中.然而后来的研究者认为相位谱才是显著性计算的关键.Guo等[6]在这一相位谱的概念上提出了基于四元数相位谱的显著性检测算法(Phase spectrum of Quaternion Fourier Transform, PQFT),计算速度更快,对于局部显著性的检测更加准确.

静态注视点密度估计算法通常只关注图像各区域被注视到的概率,忽略关注区域(常用注视点描述)的先后顺序,而对扫视路径的估计算法则可以同时兼顾两者.但是注视点转移策略的生物学研究还不够成熟,计算模型效果的衡量指标也不够完善,因此动态扫视路径估计还未得到很大的发展.Lee等[7]于2009年较早地提出了基于信息最大化的模型来理解扫视路径.该模型利用互信息表示了基于长期视觉的先验知识(视觉的长期记忆)和基于短期扫视的工作记忆(视觉的短期记忆),两者融合来引导注视点的转移.在文献[7]的基础上,Renninger等[8]同时利用了局部和全局的信息,将注视点的转移看成一种对形状进行不断学习和匹配的过程.实验证明了扫视路径是以信息最大化为导向的,目的是消除局部的不确定性.这两篇文献虽然都没有给出实际的工程可计算模型,但是给注视点的转移提供了不可或缺的理论基础.

另一方面,一些可用于实际图像处理的注视点扫视路径计算模型也渐渐出现,这些方法从计算方式上各有特点.基于Itti静态模型的拓展算法(Saliency Toolbox, STB)[9]根据显著点在各通道、各尺度间回溯,找到对显著性贡献最大的特征图,并通过区域划分的方式得到原型对象,同时结合返回抑制和胜者全取的仿生机制,确定下一个注视区域.这种方法的计算复杂度也相对较高,而且所有的注视点估计都是基于原始显著图,未能考虑显著性随注视点转移而动态改变的特性.随后,文献[10]提出了一种最大化残差感知信息来估计扫视路径和注视点的方法,该方法将参考感知响应和通过视觉短期记忆修正的注视图响应相减,得到残差响应,通过最大化残差响应信息得到下一注视点位置.该方法由于依赖于独立元分析(Independent Component Analysis, ICA)滤波响应,需要大量的自然图像块来训练ICA滤波器,而滤波器尺寸的选取依赖于图像的尺度,因此模型实际操作性较差,同时ICA多滤波器组也给计算增加了负担.最近的文献[11]则提出了一种在已有的显著图或者人眼注视密度图基础上的扫视动态生成模型,该方法利用高斯包,将显著图和返回抑制进行结合,通过用网格简化图像的方式极大地降低了计算量.该文献使用了数据库真实观测者的注视密度图,以验证人眼注视的空间统计规律,因此在严格意义上,该模型并不算一个完整的可计算模型.还有一些基于其他计算方式的模型,例如,利用独立元分析提取超高斯分量的方法[12]、使用隐马尔科夫模型的方法[13]等,由于实现机制复杂,在此不详细介绍.

纵观这些模型,它们对于显著图的计算过于繁琐或者没有考虑注视点转移过程中显著性的动态变化,模型的参数依赖性也较强,不适宜实时应用.针对上述问题,我们提出一种高效的具有生物依据的扫视路径预测方法.所提议算法充分考虑到人眼观测过程中的一些生理特性: 视觉中央凹区域对图像显著性的动态影响、注视点转移在距离和方向上的规律倾向以及具有遗忘特性的线性返回抑制机制.通过融合从这三个因素得到的结果,得到了注视点转移的总概率图,并且从概率的角度选择下一注视点的候选点.此外,实验部分除了沿用部分最典型的图像显著性指标之外,还引入了更加客观的注视点扫描路径匹配衡量标准,排除了注视序列长度、分布广度的影响.在这些评价指标下,所提议方法相比其他现有模型,在多个人眼观测数据库上能更加高效、准确地预测注视点转移路径.

1 计算模型

生理学研究[14]表明: 人在观察环境时注视的焦点往往落在视网膜的中央凹区域,这是视网膜中具有最高视觉分辨率的一小块中心区域,而周围视觉区的分辨率则远低于中央凹视觉区,并且距离中央凹越远分辨率越低.当注视点进行转移时,应按照上一个注视点在视网膜上成像的结果来计算显著性.显然,即使是在静态显著图上具有很高显著性的位置,如果它远离上一个注视点,在视网膜上处于分辨率很低的区域,人很难感知到足够的信息,那么这个位置理应只有很小的概率被选中为下一个注视点.很多现有方法仅利用单张静态显著图来计算扫视路径,忽视了注视点转移中显著性的动态变化问题,这种有缺陷的计算方式会造成结果的偏差.针对这个问题,我们提出利用中央凹图像显著性来估计扫视路径的方法.中央凹图像能够模拟人眼在注视某一位置的视网膜成像结果,在注视点位置不同的情况下由中央凹图像得到的显著图是明显不同的,这是因为显著的范围受到了视网膜成像分辨率的限制.我们利用中央凹图像,可以动态地计算每个注视点情况下的显著图,和利用单一静态显著图相比更加符合人的扫视过程.这是预测下一个注视点的第一个因素.

除此以外,研究发现人类长期进化过程中注视点的移动距离和方向具有一定的统计学规律[15-16].我们在两个眼动扫视记录数据库上进行了注视点转移的统计和核密度建模,以这个概率模型为依据,得到预测下一个注视点的第二个因素.

研究证明在注视点的转移中存在短期记忆[17],即过去的注视点在短期内不会被重新访问,这就是很多已有计算模型所用到的返回抑制机制,我们把它作为预测的第三个因素.

所提出的框架将上述的3个因素用概率的方式表示,得到注视点转移的概率图,以概率为依据进行了多点抽样,在诸多样点中选出显著性最大的点作为对下一注视点的预测.下面将仔细介绍每一部分的计算方法,以及模型的计算步骤和框图.

1.1中央凹图像的显著图

人眼视网膜的中央凹是视觉最敏锐的区域,在注视的焦点区具有最高的分辨率,从中心到外围空间分辨率会急剧下降,其随视角离心的变化呈现出类似于指数下降的形状,中央凹图像[18]正是模拟了人眼在注视时的这一生物学特性.

基于这一原理,我们利用了多分辨率金字塔的方法,以及注视点外围部分的分辨率下降的函数,对输入图像进行处理,得到中央凹图像.假设原图表示为Iorigin,我们对原图进行不同尺度的高斯低通滤波器模糊处理,构造L层金字塔,Gl为第l层的高斯低通卷积算子,得到不同分辨率的图像

(1)

其中*符号表示卷积操作.假设当前t时刻的注视点坐标为xt=(xt,yt),设图中任意坐标(x,y)和注视点xt之间的距离为e,每一层的权重wl可表示为

(2)

其中σl的不同表示了每层所对应的半径的不同.在最终得到的中央凹图像Ifoveal中,每个像素点的值由金字塔中各层Pl乘以不同的权重wl再相加得到(如图1(a)所示),中央凹图像每个像素点的值可以表示为

(3)

得到的中央凹图像(图1(c))充分模拟了在当前注视点xt时人眼视网膜的真实感知,图中标记的点代表了当前注视的位置.

理论上,计算中央凹图像的显著图可以使用任何一种静态显著图的计算模型,但在所提议的方法中,每张图像的每个注视点的都需要计算中央凹图像的显著图.为了减少其计算复杂性,使用了简单快速的PQFT方法[6].该算法认为图像中大部分的信息存在于频率域的相位谱中,因此利用归一化幅度谱的方式获取图像显著性.

PQFT方法将图像表示成四元数的形式q(x),在进行傅里叶变换之后,在频率域将幅度谱置为全1,即丢弃幅度谱的信息,只保留相位谱进行傅里叶反变换.对反变换之后的结果q′(x)取模,经过高斯模糊以及归一化的处理,即可得到中央凹图像的显著图

pBU=G(‖q′(x)‖),

(4)

其中G(·)表示高斯滤波.由于存在快速傅里叶变换,因此PQFT算法可以达到实时应用的要求,并且对于小的、结构性突出的显著目标极其有效.通过上述的计算,得到了中央凹图像显著性这一因素的概率分布图pBU.

1.2扫视倾向分布

对于真实眼动记录数据的统计表明,注视点的转移并不是无规律的运动.通过对数据的分析,可以得到注视点移动的距离和方向的分布特性.已有的生物学研究[15]发现了以下的注视点移动规律:

(1) 注视点的短距离移动的情况远多于长距离的移动;

(2) 注视点水平方向移动多于垂直方向移动;

(3) 注视点有很强的中心偏置性.

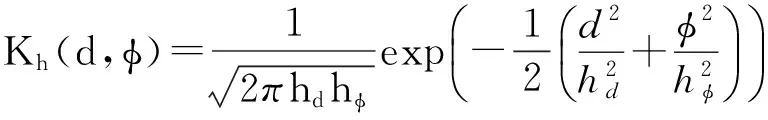

我们对于Bruce[19]和Judd[20]数据库的多个测试者的实际注视点转移数据进行了统计,从t时刻的注视点xt转移到t+1时刻的注视点xt+1,以扫视向量xt+1-xt的模作为注视点移动距离d(在生物上为视角变化),与水平轴正方向夹角为移动角度φ,采用核密度估计算法工具包[21]对每个数据库进行了高斯核密度估计,相关公式为

(5)

(6)

其中: pk(d,φ)表示d和φ的联合概率分布;n表示一个库中注视点移动的样本总数;di和φi表示第i个样本的移动距离和角度;Kh表示二维高斯核;hd和hφ为二维高斯核的带宽.极坐标的半径表示注视点移动距离(视角),与水平方向的角度表示角度,结果如图2所示.注意: 这里的移动距离用人眼的视角来表示,视角越大移动距离越远,图中越亮的地方表示移动概率越大.可以看到,由于不同的数据库的测试条件有所不同,其分布的形状有所不同,但其分布都符合文献[15]中得到的规律.注视点转移的距离集中分布在10°以内,在5°左右有明显的峰值;注视点转移方向集中分布在水平方向,垂直方向分布相对较少,其他方向的扫视概率更低.由高斯核密度估计得到下一注视点基于扫视倾向信息的概率分布为:

pS(xt+1|xt)=p(amp(xt+1-xt),arg(xt+1-xt)),

(7)

其中amp(·)和arg(·)表示对向量取模和角度运算.上述的计算给出了扫视倾向信息的概率分布pS.图2中给出了扫视向量在Bruce和Judd数据库上的核密度估计结果.

1.3注视点返回抑制

视觉注视点的位置并不是无记忆的.研究表明视觉短期记忆会综合之前的眼动信息[17],访问过的注视点会对下一注视点的选择产生影响,阻止人眼反复访问同一区域,并且这种影响会随着时间的推移而减弱,一般这种机制称之为注视点的返回抑制.该机制一方面可以让大脑对于视觉的感知具有较强稳定性,另一方面,又使得视觉系统能够不断获取新的外界信息.

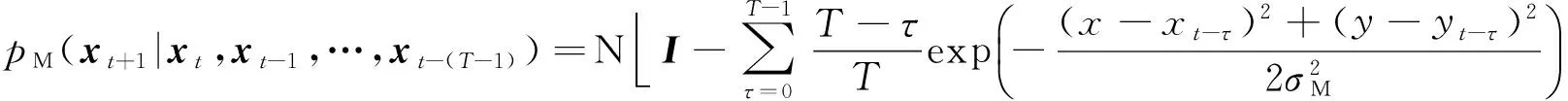

基于注视点返回抑制的机制,我们在选择下一注视点时,也将其作为一个重要的因素进行考虑,用一种具有线性遗忘特性的转移概率分布模拟人眼的返回抑制功能.公式(8)给出了线性遗忘特性的转移概率实现的公式,它考虑了当前注视点和过去的T个注视点的影响,并且先前注视点的影响会逐渐恢复:

(8)

1.4候选点选取策略

结合上述要素可以产生转移概率:

p(x,y)=pBU(x,y)×pS(x,y)×pM(x,y).

(9)

根据转移概率来选取下一注视点,一般来说在选取注视点的时候有两种策略.一种是直接选择转移概率最高的点作为下一注视点;另一种则是根据转移概率进行随机采样,产生若干个候选点,再从候选点中选择显著性最大的作为下一注视点.

由于人的视觉系统具有随机性,根据3个因素得到的转移概率只能代表在多次注视点移动中的趋势,而并不能决定在一次移动中下一注视点的确定位置.如果使用前一种方法,计算出的扫视路径会趋向于在某几个具有局部显著性极大值的点中进行周期性的往返.后一种方法即考虑到了视觉系统的随机性,又兼顾了显著性在注视点移动中的决定性作用.因此,我们采用后一种方法.

1.5算法步骤

通过以上的细节介绍,整个模型可以总结为3条因素(中央凹显著性、扫视倾向、返回抑制),其实现步骤如下:

(1) 对于输入图像,选择图像的中心位置作为初始的注视点;

(2) 计算中央凹图像,由中央凹图像生成显著图作为第一个因素;

(3) 将扫视路径在距离和方向上的倾向信息作为第二个因素;

(4) 将当前和过去的注视点的视觉短期记忆对注视点的返回抑制机制作为第三个因素;

(5) 综合3个因素,得到当前注视点到下一注视点的转移概率图;

(6) 根据转移概率,随机采样若干个下一注视点的候选点,并从中选取显著性最大的位置作为下一注视点;

(7) 以新的注视点为中心,重复进行步骤(2)至步骤(6),直到得到整条扫描路径.

图3给出了模型框架每一步骤所对应的概率图,(e)为最终计算出的下一个注视点的转移概率图,并在其中标注了当前注视点(用三角形表示)、候选点(用方框表示)以及下一注视点(用圆圈表示)的位置.可以看到本文所提议方法在3种因素的协同作用下有效地选取了下一注视点,并成功实现了返回抑制.

图4给出了所提出方法的主要框架.

2 方 法

2.1实验设计与参数选择

本节给出了一些实验中的具体实现细节和参数选择.在计算中央凹图像的时候,使用了4层多分辨率金字塔.层数过多会增加计算量,对于显著图的计算来说也没有太大的必要.在扫视倾向的计算中,采用了Botev等[21]提出的核密度估计算法工具包,该算法利用代入法最小化平均积分方差,从而自适应地得到高斯核带宽.在返回抑制机制上,所提议算法考虑了当前注视点以及过去3个注视点的影响.返回抑制的区域大小σM参考了STB模型[9]所使用的参数.最后在利用注视点转移概率分布图的时候,通过随机抽样的方式获得10个候选点,概率分布图中值较大的点更有可能被抽到.候选点的数量对于估计的结果具有一定的影响.由于所提议方法选择显著性最高的候选点作为下一注视点,当候选点过多时总是趋向于选择某几个显著点,整体的随机性就降低了;候选点较少时随机性较大,有可能在候选点中没有比较显著的点.经过实验比较,选择了10作为候选点数量比较合适.

2.2注视点扫视路径的评价指标

如上文所述,注视点扫视路径的研究内容不仅包含了一般的图像显著性,即注视点在图像中的位置分布,而且还包含了注视点的先后顺序,因此衡量注视点扫视路径的指标仅仅沿用原有的图像显著性指标是远远不够的.为此,不考虑顺序的注视点位置分布和考虑顺序的注视点转移序列都是需要比较的对象.

在实验中,对于每一幅输入图像,计算得到的扫视路径是由8个注视点构成的1条扫视序列,每个注视点用其在图像中的位置(x,y)进行表示.

如果不考虑点之间的顺序,仅把扫视路径视为注视点的集合,为了计算估计的结果和眼动真实数据在位置上的相似程度,本文采用sAUC(shuffled Area Under roc Curve)方法[22]进行衡量比较.曲线下面积(Area Under roc Curve, AUC)是常用的注视点评价指标,计算的是阈值变化得到的ROC(Receiver Operating Characteristics)曲线下面积,面积越大其结果与真实数据越相似.在当前被考察的图像中,将当前注视点图像中的注视点作为正类,图像中没有被注视的区域则作为负类.由于注视点大多处于图像中心区域,因此负类中的点很有可能是周边区域的像素.sAUC方法是AUC方法的一种改进,对于正类和负类的选取不局限于当前图像.以当前图像的注视点作为正类,而数据库中所有其他图像的注视点作为负类.这样一来,负类的点和正类的点都是分布在图像的中心区域,就能够消除中心偏置带来的影响.

另一方面,在考虑注视点之间先后顺序的情况下,实验结果是每幅图像对应1条扫视序列,眼动真实数据一般为多个测试者对同一幅图像进行自由观察的注视点记录,对于不同测试者来说记录下来的眼动数据可能会有一定的差别.在对序列进行比较的时候,同一幅图像中,与不同测试者的扫视序列进行比较,对比较的结果取平均值,以代表该图像上的评价分数.

(10)

(11)

文献[23]对现有的扫视序列相似性衡量标准进行了综合分析和对比.在视觉注视的研究中,注视点的位置、注视点移动的方向和距离、注视持续时间、扫视的顺序等等方面,根据研究课题的不同,研究者可能会有不同的关注面.针对这些不同的侧重方面,该文献对于多种现有方法进行了实验和比较,给出了评价指标选择上的建议.在本文中,我们对扫视路径的研究更注重注视点的位置、注视点移动的方向和距离及扫视的顺序.基于这一需要与文献[23]的综合对比结果及推荐,我们采用评价方法ScanMatch[24],它是由Needleman-Wunsch算法(利用动态规划的原理对两条序列进行局部对齐和评分)改进而来的扫视路径比较方法.ScanMatch的评分是归一化的,处于0到1之间,而且和序列的长度是无关的.如果值越接近1,则序列的相似程度越高.由于在时间上进行了重采样,假设有2条路径相同而持续时间不同的路径,由ScanMatch方法得到的结果是完全匹配的.因此,它具有很好的鲁棒性,能够给出客观的比较结果.更进一步,文献[24]提供了工具包,使用比较简便.

3种评价指标关注点不同: sAUC评价指标主要考察产生的注视点是否符合人眼的注视点密度数据;Hausdorff距离和Mean Minimal距离则从子序列的角度上对两条扫视序列进行对比;ScanMatch评价指标能够在整体上衡量两条扫视序列的相似度.本文采用的3种指标各有所长,能够更加客观、更加准确地对实验的结果进行分析和比较.

2.3实验数据库

在实验中我们使用了公开的眼动追踪数据库Bruce[19]和Judd[20]来评价所提出方法的效果.在Bruce数据库中,有120幅自然图像,并且有眼动记录数据作为地面真实.对于每张图像,20个测试者的扫视路径被记录下来,路径的长度为3到8个点.在Judd数据库中,有1003幅图像,其中有一部分是包含人物的图像.对于每张图像,15个测试者的扫视路径被记录下来,路径的长度为6到12个点.

3 结果分析和讨论

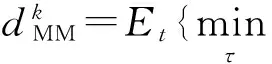

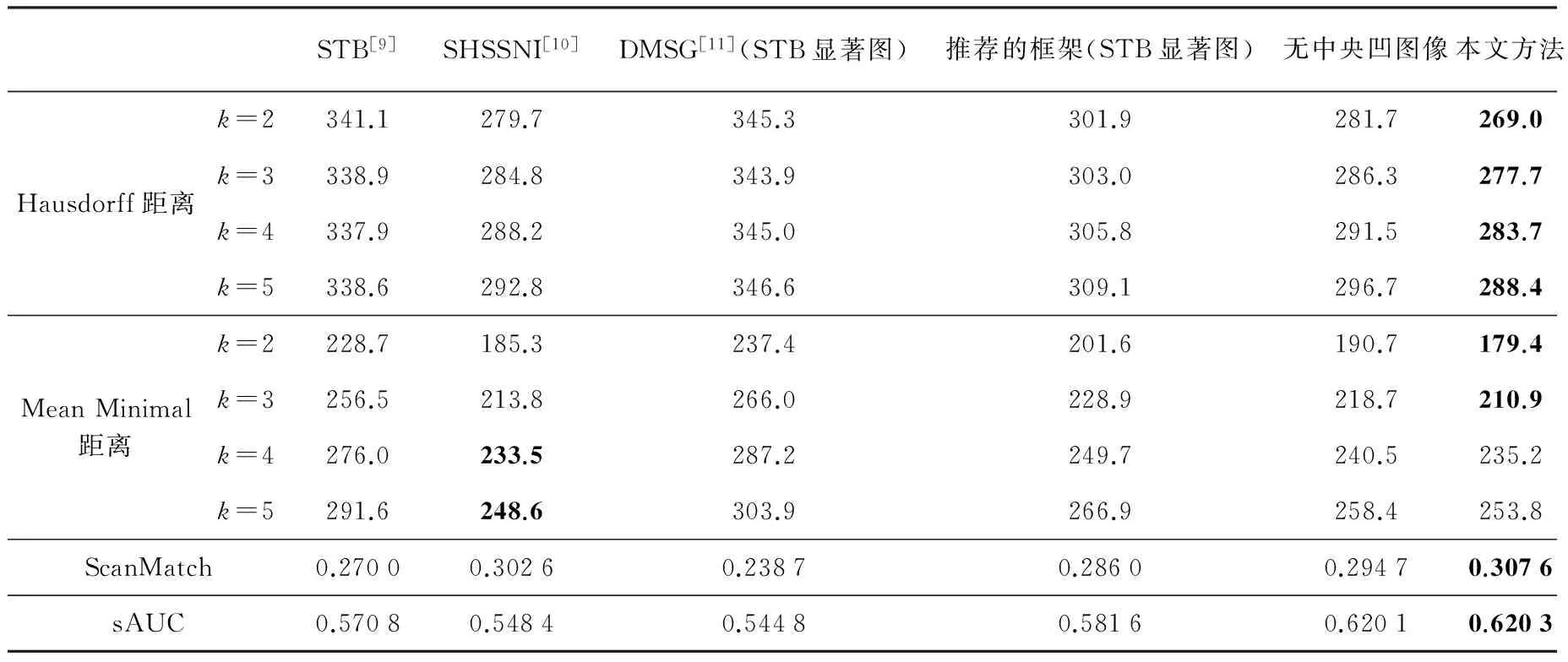

估计的扫视路径与真实数据的相似程度衡量结果如表1、表2(见第438页)所示,Hausdorff距离和Mean Minimal距离越小、ScanMatch和sAUC结果越大,表示相似的程度越高,两条注视点扫视路径越相似.

实验中比较的方法有STB[9]、SHSSNI[10]、DMSG[11](采用了STB的显著图),在第1节中对这些方法进行了简单的介绍.其中,由于DMSG需要在已有的显著图上计算扫视路径,这里采用了STB的显著图.除此以外,为了验证框架中各环节在估计效果提升上所起的作用,还对于以下两种情况进行了比较: 一种是在所提议方法框架中显著图的部分不使用PQFT,而是采用STB计算显著图的方法;另一种是不使用中央凹图像,在计算扫视路径的时候显著图不随注视点移动而改变的情况.

表1 在Bruce库上相似程度衡量结果比较

注: 每种评价指标的最优效果由粗体标出.

表2 在Judd库上相似程度衡量结果比较

注: 每种评价指标的最优效果由粗体标出.

由表1、表2的数据可以看到,所提出的方法在综合性能指标上优于被比较的方法,尤其在Bruce数据库上取得了较好的效果.由于Judd数据库中不仅包含了自然图像,还有人物图像以及部分心理图像,所以记录的眼动追踪数据容易受到高层次因素的影响.这可能是所提出方法在部分评价指标略逊于其他方法的原因.

实验中的显著图计算方法采用了简单高效的PQFT算法,该算法计算得到的显著图本身在效果上优于STB的静态显著图.为了验证我们所提出的框架是否对比STB方法具有优势,将我们的框架结合该方法的显著图算法进行试验,与其结果相比较.从数据中可以看到,不论是估计的注视点还是扫视路径的评价结果都得到了有效的提升.

所提议方法使用的中央凹图像模拟了人眼的分辨率,对于这一部分在整个框架中所起的作用,比较结果如表1、表2所示.可以明显看到在sAUC指标上两者的结果相近,说明估计的注视点都较为符合人的实际注视密度图;但是在ScanMatch、Hausdorff距离和Mean Minimal距离这些针对扫视路径的评价指标上,使用了中央凹图像以后效果得到了明显的提高.

另外,部分估计的扫视路径的结果如图5、图6所示.图5中的结果具有较好的视觉效果,并且与真实的眼动数据较为接近,数据库中的绝大部分结果具有如图5所示的视觉效果.图6则是多次实验中有一定概率会出现的个例,估计效果在视觉上较为集中.图6(a)这一类图像中存在这样的情况: 多个显著区域在图中的分布比较零散,区域之间距离比较长.由于候选点是根据转移概率随机抽样得到的,而概率上人眼更倾向于短距离的移动,所以会出现不能跨越相距较远的显著区域的扫视路径估计结果.图6(b)是在图像中可能存在较多垂直注视点移动的情况.由于实验采用的扫视倾向信息在统计上具有1.3节所述的特征,比起垂直移动,人眼对于注视点水平移动具有更强的偏向性,所以得到的结果存在一定的偏差.总的来说,由于产生候选点机制中的随机性,所以在多次实验中,有时会得到类似图6的结果.

4 结 论

在扫视路径计算这一研究领域,已有的方法计算过于繁琐,或者没有考虑注视点转移过程中显著性的变化.针对上述问题,本文提出了一种具有生物依据的注视点扫视路径估计方法.所提出方法从概率的角度出发,融合了3大因素: 模仿视网膜成像的中央凹图像、注视点移动距离和方向的倾向、注视点返回抑制的机制.在综合得到的概率图中,随机抽样产生候选点,再从候选点中根据显著性挑选最适合的下一注视点.实验结果表明: 本文提出的计算模型估计得到扫视路径在绝大多数情况下具有较好的结果,并且符合真实数据的分布.在客观全面的衡量标准下,对比其他现有方法,所提出的方法在两个数据库上的各种测试指标都接近或优于其他方法.

[1]BORJI A, ITTI L. State-of-the-art in visual attention modeling [J].IEEETransonPatternAnalysisandMachineIntelligence, 2013,35(1): 185-207.

[2]ITTI L, KOCH C, NIEBUR E. A model of saliency-based visual attention for rapid scene analysis [J].IEEETransonPatternAnalysisandMachineIntelligence, 1998,20(11): 1254-1259.

[3]TREISMAN A M, GELADE G. A feature-integration theory of attention [J].CognitivePsychology, 1980,12(1): 97-136.

[4]HAREL J, KOCH C, PERONA P. Graph-based visual saliency[C]∥Advances in Neural Information Processing Systems 20. Vancouver, BC, Canada: MIT Press, 2007: 545-552.

[5]HOU X, ZHANG L. Saliency detection: A spectral residual approach[C]∥Proc of the IEEE Conference on Computer Vision and Pattern Recognition. Minneapolis, MN, USA: IEEE Press, 2007: 1-8.

[6]GUO C, MA Q, ZHANG L. Spatio-temporal saliency detection using phase spectrum of quaternion fourier transform[C]∥Proc of the IEEE Conference on Computer Vision and Pattern Recognition. Anchorage, AK, USA: IEEE Press, 2008: 1-8.

[7]LEE T S, STELLA X Y. An information-theoretic framework for understanding saccadic eye movements[C]∥Advances in Neural Information Processing Systems 12. Denver, CO, USA: MIT Press, 1999: 834-840.

[8]RENNINGER L W, VERGHESE P, COUGHLAN J. Where to look next? Eye movements reduce local uncertainty [J].JournalofVision, 2007,7(3): 6.

[9]WALTHER D, KOCH C. Modeling attention to salient proto-objects [J].NeuralNetworks, 2006,19(9): 1395-1407.

[10]WANG W, CHEN C, WANG Y,etal. Simulating human saccadic scanpaths on natural images[C]∥Proc of the IEEE Conference on Computer Vision and Pattern Recognition. Providence, RI, USA: IEEE Press, 2011: 441-448.

[11]ENGBERT R, TRUKENBROD H A, BARTHELMÉ S,etal. Spatial statistics and attentional dynamics in scene viewing [J].JournalofVision, 2015,15(1): 14.

[12]SUN X, YAO H, JI R,etal. Toward statistical modeling of saccadic eye-movement and visual saliency [J].IEEETransonImageProcessing, 2014,23(11): 4649-4662.

[13]LIU H, XU D, HUANG Q,etal. Semantically-based human scanpath estimation with HMMs[C]∥Proc of the IEEE International Conference on Computer Vision. Sydney, NSW, Australia: IEEE Press, 2013: 3232-3239.

[14]LARSON A M, LOSCHKY L C. The contributions of central versus peripheral vision to scene gist recognition [J].JournalofVision, 2009,9(10): 6.

[15]BAYS P M, HUSAIN M. Active inhibition and memory promote exploration and search of natural scenes [J].JournalofVision, 2012,12(8): 8.

[16]LEMEUR O, LIU Z. Saccadic model of eye movements for free-viewing condition[J/OL].VisionResearch, 2015.http:∥www.sciencedirect.com/science/article/pii/S0042698915000504.

[17]BLEDOWSKI C, RAHM B, ROWE J B. What “works” in working memory? Separate systems for selection and updating of critical information [J].TheJournalofNeuroscience, 2009,29(43): 13735-13741.

[18]GEISLER W S, PERRY J S. Real-time simulation of arbitrary visual fields[C]∥Proc of the 2002 symposium on Eye tracking research & applications. New Orleans, LA, USA: ACM Press, 2002: 83-87.

[19]BRUCE N, TSOTSOS J. Saliency based on information maximization[C]∥Advances in Neural Information Processing Systems 18. Vancouver, BC, Canada: MIT Press, 2005: 155-162.

[20]JUDD T, EHINGER K, DURAND F,etal. Learning to predict where humans look[C]∥Proc of the IEEE International Conference on Computer Vision. Kyoto, Japan: IEEE Press, 2009: 2106-2113.

[21]BOTEV Z I, GROTOWSKI J F, KROESE D P. Kernel density estimation via diffusion [J].TheAnnalsofStatistics, 2010,38(5): 2916-2957.

[22]BORJI A, SIHITE D N, ITTI L. Quantitative analysis of human-model agreement in visual saliency modeling: A comparative study [J].IEEETransonImageProcessing, 2013,22(1): 55-69.

[23]ANDERSON N C, AANDERSON F, KINGSTONE A,etal. A comparison of scanpath comparison methods[J/OL]. Behavior Research Methods, 2014.http:∥www.ncbi.nlm.nih.gov/pubmed/25540126.

[24]CRISTINO F, MATHT S, THEEUWES J,etal. ScanMatch: A novel method for comparing fixation sequences [J].BehaviorResearchMethods, 2010,42(3): 692-700.

Scanpath Estimation Based on Foveal Image Saliency and Saccadic Bias

WANG Yixiu1,2, WU Xiaofeng1, WANG Bin1,2

(1.ResearchCenterofSmartNetworksandSystems,SchoolofInformationScienceandTechnology,FudanUniversity,Shanghai200433,China; 2.KeyLaboratoryforInformationScienceofElectromagneticWaves(MinistryofEducation),FudanUniversity,Shanghai200433,China)

The estimation of gaze shifting has been an important research area in saliency modeling. Most of the existing methods tend to be complex in computation and are limited to estimating scanpaths within only one saliency map, while the gaze movement is a dynamic progress. To solve the above problems, a novel bio-inspired method for predicting eye movements is proposed. There are three principal factors: the effect of foveal images in finding salient regions dynamically, the saccadic bias in the distance and direction of gaze shifts, and the mechanism of IoR(Inhibition of Return) in short-term memory. Based on the probability map from the three factors, we can randomly generate candidates of the next fixation and get the final scanpath point by point. Compared to existing models, our method performs more accurately and efficiently in several datasets under the evaluation of objective comparison measures.

selective attention; saliency; eye movement; scanpath

0427-7104(2016)04-0431-11

2015-07-23

国家自然科学基金(61572133)

王宜修(1991—),女,硕士研究生;王斌,男,教授,通讯联系人,E-mail: wangbin@fudan.edu.cn.

TN 911.73

A