融合图片主题信息的图片描述翻译

唐 建,洪 宇,刘梦眙,姚 亮,姚建民

(苏州大学 计算机科学与技术学院,江苏 苏州 215006)

0 引言

图片描述翻译是多模态机器翻译(multimodal machine translation)评测的一个子任务,该任务旨在根据图片以及图片对应的某一种语言的描述,借助翻译技术获取图片在其他语言上的文本描述。图片描述的翻译技术在很多翻译任务中有广泛的应用,例如新闻翻译、文献翻译等,目的在于使图像处理和自然语言处理相结合,从而探究图像信息在机器翻译中的有效性。目前,在这一任务的研究中,前沿的神经机器翻译和注意力机制已被广泛应用,在评测的官方数据集上最好性能达到了约38%的BLEU值。

不同于普通文本的翻译任务,在图片描述翻译任务中,我们可以充分利用图片中蕴含的丰富信息。通常,拍摄于不同场景的图片表达不同的主题,其描述也具有一定的主题偏向性。例如,拍摄于体育场的图片,其描述中会出现较多关于体育运动的词汇,如运动员(player)、进球(shot)、场地(filed)等;拍摄于音乐会的图片,其描述中会出现较多关于音乐会的词汇,如音乐(music)、粉丝(fan)、吉他(guitar)等;拍摄于伊拉克战争的图片,其描述中会出现较多关于战争的词汇,如战争(war)、步枪(rifle)、坦克(tank)、飞机(aircraft)等。因此,图片描述的翻译也具有主题适应的问题。

将主题信息引入机器翻译系统,会极大提高目标短语选择的准确性。同一单词在不同主题下的翻译不同,因此利用主题信息能够辅助判定单词在当前句子中最佳的译文。例如,对于待翻译句子“他有很多粉丝”而言,其中的“粉丝”一词可以译为“fans”或“vermicelli”。若待翻译句子与音乐主题比较相关,则粉丝倾向于翻译为“fans”,若待翻译句子与饮食主题比较相关,则粉丝应该翻译为“vermicelli”。然而,面向图片描述翻译任务时,由于图片描述通常是对图片内容的凝练与概括,其文本内容通常较短,含有极少甚至缺乏上下文,从而难以检测和建模其主题,即难以有效挖掘其主题分布。

本文提出了一种融合图片主题信息的翻译模型优化方法。该方法利用图片作为媒介,挖掘图片描述的主题分布,进而获取适应主题的翻译模型。具体地,本文首先爬取维基百科中的图片和文档资源,以搭建本地资源库。其次,对于训练语料中任意的图片及其文字描述的对子(以下简称图片描述对),以图片作为查询,在本地资源库中检索与该图片相似的图片集。在此基础上,本文采用相似图片所在的文档学习源图片描述的主题表示。最终,基于图片描述的主题表示对训练集中短语对共现频率进行加权,获取主题相关的短语翻译模型。在测试解码时,本文借助测试图片对应描述的主题分布,动态地优化短语翻译概率,并根据当前描述的主题信息,选择最佳的翻译结果。在WMT16图片描述翻译任务上的实验表明,本文提出的融入图片主题信息的图片描述翻译,相比于基准系统,BLEU值提升了0.74个百分点。

本文接下来的内容组织如下: 第1节介绍相关工作;第2节介绍融入图片主题信息的图片描述翻译方法;第3节给出实验结果,并进行实验分析;第4节总结本文工作,并给出展望。

1 相关工作

Iacer[1]等提出了双重心的多模态机器翻译模型,该模型在文字和图片上分别加入了注意力机制,试图将源语言特征信息以及局部图像卷积特征融入神经机器翻译模型,局部图像的特征可以更好地辅助相关短语的翻译。Huang[2]等提出了注意力机制多模态神经机器翻译,利用基于文本的注意力机制模型在每一步解码时依赖于上一个LSTM隐藏层状态以及文本的向量。注意力机制下解码器可以实时刷新“记忆”,帮助获得更好的翻译以及语序。但该方法没有对图像加入注意力机制,没有充分利用局部图像信息对翻译的优化作用。Sergio[3]等提出基于具有双嵌入的双向循环神经网络的多模态翻译系统描述,有效地对源语言进行编码,并且融合从VGG模型中提取出的图像向量表示。但该方法直接抽取整个图像的向量表示,容易丢失图像的边缘信息。

Zhao等[4]利用双语主题模型,获取不同级别语言单元中所蕴含的主题共现信息,有效提升统计机器翻译中单词对齐的质量。Tam等[5]利用双语主题模型,在源语言端和目标语言端建立映射,用以跨语言建模和短语级别的翻译模型适应性研究。Gong等[6]将主题模型应用于特定领域机器翻译研究,该方法通过在短语表中构建新特征,将待翻译单元中隐含的主题信息予以表示;并在解码阶段动态选择与源语言端语义一致的目标语言端候选翻译单元,从而有效提升了特定领域机器翻译系统的性能。Su等[7]利用目标领域单语资源学习源端短语的主题分布,借助主题加权的方式重新估计通用领域短语规则互译概率。

上述图片描述翻译工作大多是对图片特征信息以及图片描述信息训练一个基于神经网络的翻译模型(neural network-based translation model)。本文则基于统计机器翻译系统,借用上述工作中图片处理方式以及本地资源库获取图片的主题信息,将其融入翻译模型。融入图片的主题信息主要是为了解决传统的机器翻译系统在翻译歧义词时对候选结果选择不当的问题。

2 融入图片主题信息

2.1 系统框架

本文提出了一种融入图片主题信息的翻译模型优化方法,整体流程如图1所示。

图1 系统流程图

首先,我们获取并且自动解析维基百科dump文件得到大量图片与文档,根据编号的唯一性获得图片与文档一一对应的本地资源库。然后,抽取部分文档进行主题模型训练,使用训练好的主题模型推测得到本地资源库中其余文档的主题分布;继而,在实际翻译某一目标图片(即源图片)的描述文字时,我们借助图像匹配技术在资源库中检索与源图片相似的参考图片集;利用参考图片所在文档的主题分布表征源图片的主题分布(即图片描述的主题分布)。最后,在统计机器翻译的解码过程中,将得到的源图片描述的主题分布以特征形式融入翻译模型,通过增加短语翻译表中短语对的概率特征来提高翻译系统对短语翻译的准确性,以提升机器翻译对于图片描述翻译的性能。

翻译模型在翻译短语时,根据短语对的特征对候选目标短语进行选择。为了优化翻译模型,我们通过图片描述主题分布获取主题相关的短语特征,将其融入翻译特征表,从而优化翻译系统的短语翻译。

本文实验中,翻译系统结合了传统的短语特征(翻译概率值)和基于主题信息的短语特征。传统短语特征包括短语对正向翻译概率(positive translation probability,PTP)、反向翻译概率(negative translation probability,NTP)[8]、词汇化正向翻译概率(lexical positive translation probability,LPTP)、词汇化反向翻译概率(lexical negative translation probability,LNTP)[8]等。本文所提出的基于主题信息的短语特征有三种,分别是主题相关的正向翻译概率(topic-based positive translation probability,TB-PTP)、主题相关的反向翻译概率(topic-based negative translation probability,TB-NTP)以及主题敏感度(topic sensitivity,TS)。其中,TB-PTP和TB-NTP通过主题信息对传统正向和反向翻译概率(即PTP和NTP)进行改进(见2.4节)。此外,TS也是一种结合主题信息的翻译特征,其对翻译消歧的贡献[9]已经获得验证。本文在使用TS的时候,利用了相似图片所在文本的主题信息,与传统方法的区别仅在于获取主题的渠道发生了变化(非本地正文,而是借助图像处理的外部数据)。

我们借助表1和表2,对传统的短语特征(翻译概率值)和基于主题信息的短语特征进行对比,用于直观地展示两类特征对歧义短语翻译的辅助作用。假设给定短语对{man,Manndie},其中,“man”为源语言(英文)的“男人”一词(词为最小单位的短语),“Manndie”为目标语言(德语)的“男人”一词。针对两个互译短语,表1首先给出了传统的翻译特征表及其翻译概率值,表2给出了基于主题信息的翻译特征表及翻译概率值(该例中所有翻译概率值均抽选自翻译器训练过程中的中间结果)。

表1 传统短语特征

表2 融入主题信息的短语特征

通过对比发现,增加主题信息后,PTP和NTP的翻译概率得以提升,并且所有包含主题信息的短语特征的翻译概率均远高于传统短语特征。

2.2 本地资源库构建

本节内容旨在利用维基百科构造本地资源库,用以支持相似图片搜索技术。

构建过程中,我们利用了网络爬虫爬取维基百科页面的图片,得到约88万[注]图片总数: 886,818张图片,同时获取这些图片所在文档的编号。对爬取的图片进行过滤,若图片不能被caffe[10]打开则过滤掉此图片,经过此步骤后,剩余约86万[注]无损图片数: 862,837张图片。然后,利用Giuseppe Attardi提供的工具[注]https://github.com/bwbaugh/wikipedia-extractor,从维基百科dump数据库中抽取所有页面的文档内容,共获取约420万[注]文档数: 4 262 120个英文文档。本文从上述文档中随机抽取约20万[注]LDA训练文档数: 213 280篇文档,借助Latent Dirichlet Allocation(LDA)[11]主题模型工具学习主题模型,并利用学习的主题模型推理全部文档的主题分布。

在此基础上,我们通过编号的唯一性得到约80万[注]本地资源库文档和图片数: 800 160个图片和文档对应关系,并根据上述文档的主题分布信息,形成图片与主题信息映射表。

2.3 图片主题分布估计

本文旨在通过图像匹配技术,从本地资源库获取与源图片相似的参考图片集,并利用参考图片在资源库中对应的主题分布信息,间接地指定源图片的主题分布信息,从而对源图片文字描述的翻译过程提供可参考的主题信息。

图2与图3分别呈现了两张图片以及图片对应的描述。通过观察发现,两张图片都是描绘关于橄榄球运动的,它们的文字描述也很相似。

图2 一位年轻人想要投掷橄榄球

图3 橄榄球运动员奔跑着去抢球

基于上述发现,本文试图采用图片检索的方式进行文字描述的特征化。利用数据集中图片搜索本地资源库,得到相似的图片集,利用该图片集所在文档的主题分布表征图片描述的主题分布。本文的主要工作集中在将文本描述的主题分布融入翻译模型,进而提高机器翻译系统性能。

在实际系统化的过程中,对于本地资源库和测试语料集中的所有图片,我们利用Visual Geometry Group-16(VGG-16)[12]模型提取图像特征,在使用VGG-16神经网络模型时,我们应用softmax函数之前的完全连接层(fc7)提取特征,从而得到其4 096维向量,并且将其存入数据库,由于本地资源库的图片数量过大不利于之后的计算,因此将图片形成的矩阵分块存储。

在此基础上,给定某一源图片,本文执行如下图像匹配和参考图片的获取过程: 对所有本地资源库中的图片,利用图像向量矩阵的欧氏距离计算其与源图片的相似度,并按欧氏距离从小到大进行排序,取与之欧氏距离最小即相似度最高的10张图片作为源图片的参考图片,并利用这10张参考图片预先获取的主题分布表征源图片的单一主题分布。这一过程可认为是一种利用参考图片的众筹化信息表示过程,众筹采用了主题分布向量的求和取均值给予计算,如式(1)所示。

(1)

其中,Pi(T)表示第i张相似图片所在文档属于主题T的概率。针对主题分布向量的每一个维度,都采用式(1)予以计算。

2.4 融合图像主题的翻译模型

本节旨在利用主题信息优化短语翻译表中的概率。修改翻译系统在短语抽取时的部分源码,使得训练时输出的短语表中带有该短语对所在的行信息,从而得到带有行信息的正向短语翻译表和反向短语翻译表。对于两个短语翻译表,利用短语对完全匹配的方式分别去重,并且对两个短语翻译表中每一个短语对统计两种信息: ①该短语翻译表中出现该短语对的所有行信息以及每行内出现此短语对的次数; ②该短语对源语言端短语所在源语言句子的主题分布。

基于上述两种信息,对于正向短语翻译表,单独统计其每个短语对中的源语言端短语所出现的行信息以及该行中出现该短语的次数;对于反向短语翻译表,单独统计其每个短语对中的目标语言端短语所出现的行信息以及该行中出现该短语的次数。利用上述各种统计信息,可以计算得出一张新的正向短语翻译表,其中含有每个主题下短语对的正向翻译概率;同时得到一张新的反向短语翻译表,其中包含每个主题下短语对的反向翻译概率。将这两张表合并,得到一张新的短语翻译表。利用式(2)和式(3)得到每个短语对在50个主题下的正向翻译概率及反向翻译概率。假设训练语料中包含短语对(s,t)的句对有n个,集合为N;包含源语言端短语s的句对有m个,集合为M;包含目标语言端短语t的句对有k个,集合为K。则计算不同主题下正向和反向翻译概率的公式如式(2~3)所示。

其中,P(t|s,T)和P(s|t,T)分别为(s,t)在主题T下源语言短语s翻译成目标语言短语t的概率和在主题T下目标语言短语t翻译成源语言短语s的概率;Counti(s,t)为短语对(s,t)在N中第i个句对中出现的次数;Countj(s,t′)求和是包含源语言端短语s的短语对(s,t′)在短语翻译表中属于集合M中第j个句对的短语对集合中出现的次数;Countj(s′,t)是包含目标语言端短语t的短语对(s′,t)在短语翻译表中属于集合K中第j个句子的短语对集合中出现的次数;Pi(T)指的是第i个句子在主题T下的概率分布。

在调参阶段,由于上述过程产生的翻译表较大(约有99万短语对),直接使用开发集中每个源语句进行主题融合容易因文件过大而降低运算速度,而且并不是每个短语对都有利于开发集中句子的翻译。换言之,不存在于开发集源语言端某一个句子中的短语,对于该句的翻译起不到正面作用。因此,我们利用开发集中每个源语句对短语表进行过滤,形成多个过滤之后的短语表,对这些短语表进行合并,并且标记每个短语对来自哪个过滤之后的短语表。合并过程中同时计算每个短语对在该源语句主题分布下的翻译概率,利用式(4~5)计算每个短语对的翻译概率。

其中,T表示主题,本文实验设置的主题数量为50,P(Ti) 表示当前句对属于第i个主题的概率。对于传统的MSD调序模型产生的调序表做与上述相同的过滤标记,然后合并多个调序表。利用新的短语翻译表、调序表和开发集进行模型参数最优化。

在测试阶段,测试集中每一个源语句将其主题分布以与上述开发集中相同的式(4)和式(5)融入带有短语对主题分布短语翻译表,从而形成1 000张新的短语翻译表。然后,利用某一句源语句所得到的短语翻译表对该句进行解码,将解码的结果进行合并得到所有的翻译结果。

2.5 基于主题交叉熵的短语译文优化

Xiao[9]等认为可以根据短语对的主题分布将其分为主题敏感短语对和主题不敏感短语对。一般而言,主题不敏感短语对有着比较均匀的主题分布,主题敏感短语对在某个主题下有着较高的分布。一个短语对如果集中出现在某些主题上,就会有突出的主题分布;反之,该短语对的主题分布就会较为均匀。因此,主题敏感短语对总是蕴含着比主题不敏感短语对更多的主题信息,在计算短语对翻译概率时,需要加入惩罚机制,从而降低主题不敏感短语对的影响,提高主题敏感短语对的影响。本文在优化短语对互译概率的基础之上,将交叉熵作为一种惩罚机制融入翻译模型,从而进一步提高翻译系统的性能。

在短语翻译表中,利用式(6~7)添加短语对(s,t)的熵信息Entropy(s,t),用以表示该短语对的主题敏感度。如式(6~7)所示。

其中,Pi(Tj)表示集合N中第i句对中源语言语句在第j个主题下的概率;C是由C(Tj)组成的经过归一化的向量,其中,j=(1,2,3,……,50);Ci表示向量C中第i个值。

3 实验与结果分析

3.1 语料配置

本文实验使用NiuTrans[13]机器翻译引擎搭建英德短语翻译系统。在系统所包含的语料中,本地资源库中的语料均来自维基百科,包含约80万张图片及其对应的英文文档,训练集、开发集、测试集来自WMT2016多模态机器翻译评测中图片描述翻译任务包含图片及其英文、德文描述。表3为实验数据分布:

表3 机器翻译系统语料

3.2 系统设置

本文以NiuTrans开源统计机器翻译系统为架构设计参评系统,该架构融合GIZA++[14]工具[注]https://github.com/alexey-osipenko/giza-pp实现双语句对词对齐,并从词对齐的平行句对中抽取短语翻译规则。本文采用SRILM[15]工具[注]https://github.com/ayuxianguo/srilm训练三元(Tri-gram)语言模型,并以传统MSD调序模型作为基线系统的调序模型,翻译系统模型权重采用最小错误率[16]训练方法获得,系统输出结果采用大小写不敏感的BLEU-4[17]值进行评价。本文搭建基于短语的翻译系统,包含翻译模型[18],语言模型[15],调序模型[19],词、短语惩罚[20]等特征的基准系统(Baseline)。

在以下实验中,我们使用了VGG-16模型,以图搜图技术和LDA主题模型。其中,预训练的VGG-16模型将图片转为4 096维向量;以图搜图技术将资源库中图片排序,根据其与源图片的欧氏距离从小到大排序,并且取排序前10(top10)相似图片所在的文档作为预测源描述主题分布的参考文档集; GibbsLDA++开源工具[注]https://github.com/mrquincle/gibbs-lda对文档集进行主题的估计和推断,主题模型工具采用以下经验性参数设置,主题数目取50,超参数均设为0.05,迭代次数设为1 000。

① LDA_PT: 利用以图搜图技术所得的主题信息,仅优化短语翻译表中短语对的正向翻译概率。

② LDA_NT: 利用以图搜图技术所得的主题信息,仅优化短语翻译表中短语对的反向翻译概率。

③ LDA_BT: 利用以图搜图技术所得的主题信息,优化短语表中短语对的正向翻译概率和反向翻译概率。

④ LDA_BT_Entr: 在LDA_BT的基础上加入了短语对的交叉熵信息, 将此信息作为一维新的特征融入翻译模型。

此外,我们选择LDA_Text,LDA_Union和GDMM三个模型作为本文方法的对比对象。这三个模型都被嵌入了NiuTrans系统架构,跟本文方法具有一致的系统环境,评测也因此具有较高的可比性。

在LDA_Text中,我们使用了doc2vec[21]推测句子的分布向量、文本匹配技术和LDA模型。其中,doc2vec将源图片描述和资源库中图片描述转为100维向量;以文本匹配技术将资源库中图片排序,根据其描述与源图片描述的欧氏距离从小到大排列,并且取排序前10(top10)的相似图片所在文档作为预测源描述主题分布的文档集;LDA模型使用了GibbsLDA++工具,具体参数设置与上述实验一致。LDA_Union和LDA_Text的不同在于我们将以图搜图技术和文本匹配技术获得的文档集取并集作为本实验的文档集。GDMM和LDA_Text的不同在于我们直接利用GPUDMM工具[注]https://github.com/NobodyWHU/GPUDMM推测源描述的主题分布。Parallel_RCNNS在文本上加入了注意力机制,并且,在编码层不仅加入了整个图片的信息,而且也抽取了图片中的不同实体。

① LDA_Text: 利用文本检索得到的主题信息优化短语翻译表的正向及反向翻译概率,同时将交叉熵信息融入短语翻译表。

② LDA_Union: 将利用文本检索得到的相似文档和以图片检索方式获取的相似文档取并集,利用该文档集合的主题信息优化短语翻译表的正向及反向翻译概率,同时将交叉熵信息融入短语翻译表。

③ GDMM: 直接利用GPUDMM抽取短文本主题分布,利用此主题分布优化短语翻译表的正向及反向翻译概率,同时将交叉熵信息融入短语翻译表。

④ Parallel_RCNNS: 基于注意力机制的多模态神经机器翻译系统。

3.3 实验结果及分析

本节首先分析测试结果,然后再根据实验和观测,分析主题信息在翻译过程中解决领域适应性问题的有效性。

3.3.1 实验结果与分析

本文搭建英德机器翻译系统,并基于最小错误率训练方法调节特征权重。本文总共构建了9个翻译系统、8个系统作为本文所提方法的对比系统。

如表4所示,优化翻译模型的翻译系统相比于原始的翻译系统(Baseline_SMT),在测试集上性能均有提升。其中优化短语翻译表中正向和反向翻译概率并且融入短语对主题敏感度的翻译系统(LDA_BT_Entr)性能达到最优,相比于基准系统,BLEU值提升了0.74个百分点。融入短语对主题相关的正向或反向翻译概率的系统性能均比Baseline高,这说明这两种特征都对翻译系统起到一定的促进作用。在此基础上,将两种特征同时融入翻译模型时,发现性能比只融入一种特征提高更多,说明这两种特征相辅相成共同促进系统性能的提高。之后再融入短语对的敏感度,性能又进一步提高。总体而言,本文融入的三种主题相关的特征都对翻译系统性能提高起到了促进作用。

表4 特征有效性

在LDA_Text方法中,我们利用源图片描述通过字符串相似度匹配方式获得若干相似的目标图片描述,从而获得包含目标图片的文档作为相似文档集合,其中_cb表示使用切比雪夫距离进行搜索,其余是用欧氏距离进行距离度量。表5显示,LDA_Text的性能比LDA_BT_Entr降低了0.58个百分点,LDA_Text_cb的性能比LDA_BT_Entr_cb降低了0.56个百分点。该部分实验结果表明,在某些距离度量方式下,以图片作为媒介查找文档比直接利用文本检索查找的文档更加准确。原因在于,图片描述短文本所含信息非常有限,而且文本表达具有歧义,但是图片包含丰富的信息,且图片内容清晰明确,利用图片信息搜索得到的相似文档表达的主题信息符合图片描述,用这些相似文档的主题分布表示图片描述的主题分布更加贴切。实验设置中的LDA_Union将图片搜索得到的相似文档和基于文本检索得到的相似文档取并集,利用这些相似文档集合的主题向量表示图片描述的主题分布向量。

表5 搜索方式有效性

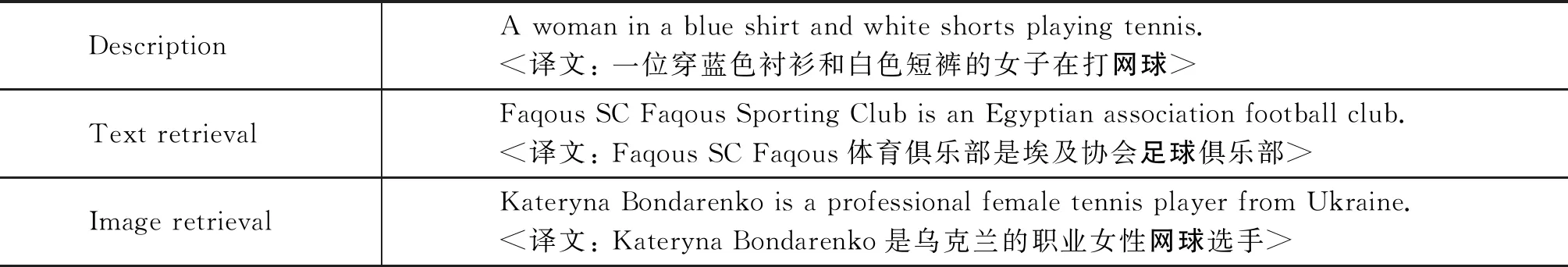

表6展示了一个图片描述以及使用字符串匹配方式和以图搜图方式得到的相似文档摘要。由表中数据可以发现,图片描述是关于网球的主题,以图搜图方式得到的相似文档是描述网球的,然而字符串匹配方式得到的相似文档是描述足球俱乐部的。上述例子表明以图搜图方式在获取文档集方面能够取得更好的结果,这主要是由于图片信息相比较于短文本信息量丰富并且出现歧义的可能性小。

表6 图片描述和相似文档摘要

GDMM和LDA_BT_Entr两者都是将短语对正向、反向主题相关的翻译概率和短语对的主题敏感度融入翻译模型,主要的区别在于两者利用不同的方式估计图片描述的主题分布。GDMM直接利用GPUDMM工具抽取图片描述的主题分布,将其融入翻译模型。LDA_BT_Entr利用本地资源库获取文档集,通过主题模型利用文档集估计图片描述的主题分布。表7显示LDA_BT_Entr和Baseline性能比GDMM分别高了2.11和1.37个百分点。由于GPUDMM在抽取短文主题时很多内容都需要用户提供,比如分词结果、单词的语义向量及不同单词之间的相似度值等。这种情况下容易造成错误传递,从而导致抽取出较差的主题分布信息,使实验性能降低。

表7 不同方式估计主题分布

Huang[2]等提出了基于注意力机制的多模态神经机器翻译方法Parallel_ RCNNS。从表8中可以发现,其性能远高于本文所提出的方法LDA_BT_Entr。原因在于,神经网络的方法中参数众多,对参数的不断细化可以对系统性能有明显的提高,但是估计众多参数的复杂度非常高。该注意力机制方法不仅将整个图片信息融入神经机器翻译系统,而且还提取图片中的实体等内容优化翻译性能。本文提出的融入图片主题信息的图片描述翻译方法基于统计机器翻译进行实验,参数较少,复杂度较低,而且我们在进行主题分布估计时对于参数只是进行了经验性设置,并没有对参数进行细化调整。本文所提出的方法虽然在性能上不如Parallel_RCNNS,但是我们着重解决了短语翻译时歧义词的问题。实验结果表明,在加入额外的图片信息之后,多模态神经机器翻译提高了0.55个百分点,而我们提出的方法性能比Baseline_SMT提高了0.74个百分点。

表8 不同翻译系统的翻译比较

3.3.2 主题信息的领域适应性分析

部分英文单词存在领域性,即在不同领域下会被译为不同的意思。领域性通常通过主题信息来反映,主题分布的不同往往体现出领域的差异性,比如,军事领域的主题往往集中在“战争”“军火”等。在图片描述翻译的任务中,图片描述一般以短文本的方式出现,仅依靠描述文本中有限的信息,统计机器翻译系统难以正确翻译具有歧义性的短语。

目前,主题信息被广泛使用以解决机器翻译的领域适应性问题。由于图片描述是短文本类型,难以有效地抽取其主题信息。相反,图片本身含有丰富的内容,其主题信息也更加清晰。在本地资源库中,图片与文档共同出现。由于文档的主题信息更容易获得,从而可以利用文档的主题信息表征图片的主题信息。图片的内容和图片的描述也是共同表达了同样的主题,描述是对图片的概括性表达,图片是对内容的形象化表示,因而可以通过图片的主题分布表征图片描述的主题分布。总而言之,本文利用相似图片所在文档的主题信息表示源图片的主题信息,然后通过该图片的主题信息表示图片描述的主题信息,图片描述的主题信息被融入翻译系统以提高翻译系统在短语翻译方面的准确性。

图4、图5以及表9展示了图片源语言端和目标语言端的描述,两个图片描述中都存在这“fan”这个单词,但该词在对应的目标语言端的翻译却不相同,在图4的描述中它被翻译为“Fan”,而在图片5的描述中它被翻译为“Faltfächer”。“Fan”在中文里是“粉丝”的意思,“Faltfächer”的中文含义是“折扇”。

图4 乐队在粉丝面前表演

单纯地从文字描述的内容来讲,统计机器翻译系统很难将这个词“fan”在两个句子中都翻译正确,因为翻译系统在进行短文本翻译时除了统计信息之外,没有更多的信息进行翻译选项的取舍。但是根据图片中的内容可以清晰地发现,图4的内容讲的是“粉丝”,然而图5中的含义是“折扇”,该结果体现了两张图片的主题分布不同。由此可见,图片本身的主题场景可以作为额外的信息,进而辅助图片描述的翻译。因此,融入图片主题信息的翻译系统能使文本翻译取得更好的性能。

图5 一个男人正在设计折扇

表9 “fan”的不同翻译结果

4 总结与展望

本文验证了短语翻译在不同领域下存在差异,并提出了一种融合主题信息的翻译模型领域自适应方法,利用图片的主题信息完善短语对的翻译概率分布,相比于基准系统,BLEU值提升了0.74个百分点。

本文利用图片所在的文档获得图片的主题信息,融入机器翻译系统中的翻译模型,从而在图片描述翻译方面提高了性能,然而图片的很多细节信息并没有被提取以优化翻译系统。因此在未来的工作中,本文将从以下两个方面进行尝试: 一是利用神经网络提取与描述紧密相关的局部图片信息,去除图片中的干扰信息;二是在神经机器翻译中对图片使用注意力机制进行处理。