基于深度聚类的无监督特征嵌入学习

杨建伟,严振华,王彩玲

摘 要: 为了提高无监督嵌入学习对图像特征的判别能力,提出一种基于深度聚类的无监督学习方法。通过对图像的嵌入特征进行聚类,获得图像之间的伪类别信息,然后最小化聚类损失来优化网络模型,使得模型能够学习到图像的高判别性特征。在三个标准数据集上的图像检索性能表明了该方法的有效性,并且优于目前大多数方法。

关键词: 无监督学习; 嵌入学习; 深度聚类

中图分类号:TP391 文献标识码:A 文章编号:1006-8228(2022)01-19-03

Unsupervised feature embedding learning via deep clustering

Yang Jianwei1, Yan Zhenhua2, Wang Cailing1

(1. School of Automation of Nanjing University of Posts and Telecommunications, Nanjing, Jiangsu, 210023, China;

2. Wuerth Electronic Tianjin Co,.ltd.)

Abstract: In order to improve the ability of unsupervised embedding learning to distinguish image features, an unsupervised method based on deep clustering is proposed. By clustering the embedded features of images, the pseudo category information between images is obtained, and then the clustering loss is minimized to optimize the network model, so that the model can learn the high discriminant features of images. The performance of image retrieval on three standard data sets shows that the proposed method is effective and better than most of the current methods.

Key words: unsupervised learning; embedding learning; deep clustering

0 引言

深度嵌入學习旨在利用深度神经网络从图像中学习一种具有判别性的低维嵌入特征,这种嵌入特征具有两种属性。①正集中:属于同一类别的样本的嵌入特征应当彼此靠近。②负分离:属于不同类别的样本的嵌入特征应当尽可能的彼此远离[1-5]。随着深度学习的快速发展,监督嵌入学习在许多计算机视觉任务上展现出了优异的表现,如图像检索[6-8],人脸识别[9],目标跟踪[10]以及行人重识别[11-12]等。为了获得更好的性能表现,监督嵌入学习需要依赖于大规模标记数据。然而,为不同的视觉任务收集和标注大规模数据集耗费了大量的人力物力,尤其对于细粒度图像数据集的标注,更是需要领域内的专家才能完成。因此,以无监督的方式直接、自动地对图像进行特征学习是一项非常重要而又富有挑战性的任务,且已经成为机器学习和计算机视觉领域的研究热点。

无监督嵌入学习要求学习到的嵌入特征之间的相似性与输入样本的视觉相似性或类别关系保持一致。MOM[13]是最早被提出的用于无监督嵌入学习的方法,它以完全无监督的形式在流形空间中挖掘正负样本。然而,这种方法严重依赖于网络的初始化表征。AND[14]通过挖掘最近邻样本来改善样本之间的相似性,但是,最近邻挖掘会不可避免的引入错误样本。最近,基于实例监督的方法在无监督嵌入学习中流行起来。例如,ISIF[15]和PSLR[16]把每个样本实例及其增强之后的样本看成是一个单独的类,不同的实例看成是负样本,在Softmax函数上直接优化实例特征。然而,这类方法只能提供有限的监督信号,并且容易使模型发生过拟合现象。

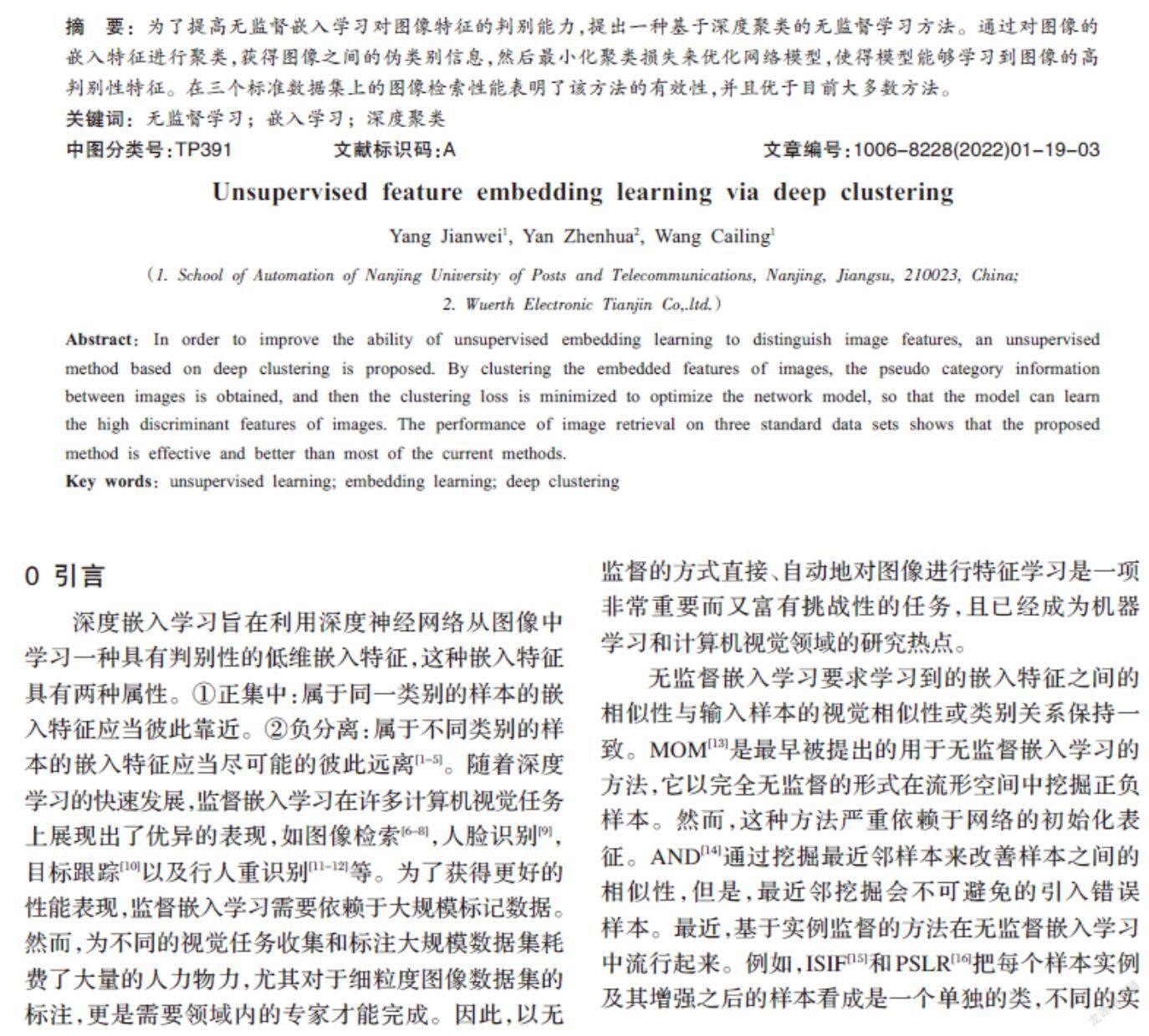

本文为无监督嵌入学习提出了一种深度聚类框架,通过对图像嵌入特征进行聚类,从而获得图像之间的伪类别信息,然后最小化聚类损失来优化网络模型,从而达到正集中和负分离的目的。在三个标准数据集上做了大量的实验,结果表明本文提出的方法提高了模型对图像的判别能力,性能优于目前大多数方法。

1 深度聚类

给定一个无标注的图像集合[X={x1,x2,…,xn}],我们的目标是训练一个特征提取网络[fθ(∙)],该网络将输入图像[xi]映射成一个具有高判别性的嵌入特征[fθ(xi)∈Rl],其中[θ]是网络参数,[l]是特征维度。所有的特征都被[l2]规范化,即[||fθ(xi)||=1]。良好的嵌入特征需要满足正集中和负分离两个特点。

在监督嵌入学习中,通常采用在ImageNet[17]上预训练的网络作为特征提取网络,原因在于它能提供良好的监督信号。我们的思想是利用这种信号将嵌入空间的特征聚成[k]个类。第一步,从嵌入空间[Rl]中任选一个特征[fθ(xi)]作为第一个初始化中心。第二步,为了避免空类,尽量选择与已有的[m]个中心距离较远的特征作为下一个中心,采用欧式距离表示为:

[D(i)=minfθ(xi)-cj2, j=1, 2, …, m] ⑴

因此,一个特征被选为下一个中心的概率为:

[P(i)=D(i)2i=1nD(i)2] ⑵

第三步,重复第二个步骤直到选择出[k]个中心[C=c1,c2,…,ck]。通过解决以下问题来共同学习一个[l×k]的中心矩阵[C]和图像的伪标签[yi]:

[minC∈Rl×k1ni=1nminyi∈{0,1}kfθ(xi)-Cyi22]

[s.t. yΤi1k=1] ⑶

從而,得到了一组最优的类中心[C*]和伪标签[y*i]。

在嵌入特征空间中,我们希望类内样本特征是紧凑的,并且类和类之间有很大的间隔。因此,对于任一特征[fθ(xi)],找到与之距离最近的类中心,记为[c+],它们之间的距离记为[d+=fθ(xi)-c+2],接着找到与之距离第二近的类中心,记为[c-],它们之间的距离记为[d-=fθ(xi)-c-2]。如果比值[d+/d-]越小,则特征更具有判别力。因此,聚类损失定义为:

[Lc=1Ni=1nfθ(xi)-c+2fθ(xi)-c-2] ⑷

在训练过程中,网络和图像特征逐步更新,聚类中心每20 Epochs 更新一次。

2 实验

2.1 数据集介绍

本文采用CUB200[18],Cars196[19]和SOP[20]三个标准数据集来评估所提出的方法。CUB200是一个包含200个类别的鸟类图像数据集,其中前100个类用来训练,剩余100个类用来测试。Cars196是一个包含196个类别的汽车类图像数据集。其中前98个类用来训练,其余98个类用来测试。SOP是一个包含22634个类别的大规模产品数据集,其中前11318个类别用来训练,其余11316个类别用来测试。

2.2 实验设置

实验采用在ImageNet上预训练后的GoogLeNet[21]作为特征提取网络,并对网络进行微调。在网络的全局池化层之后加上一个512维的全连接层作为输出层。在训练阶段,所有图像被裁剪为227*227大小;在测试阶段,每个图像被中心裁剪之后作为测试输入。使用0.9动量的Adma优化器[22]并将权重衰减设置为0.0005。对于聚类模块,为CUB200和Cars196设置100个聚类中心,为SOP设置10000个聚类中心。整个网络在NVIDIA GeForce RTX 2080Ti GPUs上训练,采用图像检索表现R@K作为标准的评估度量。

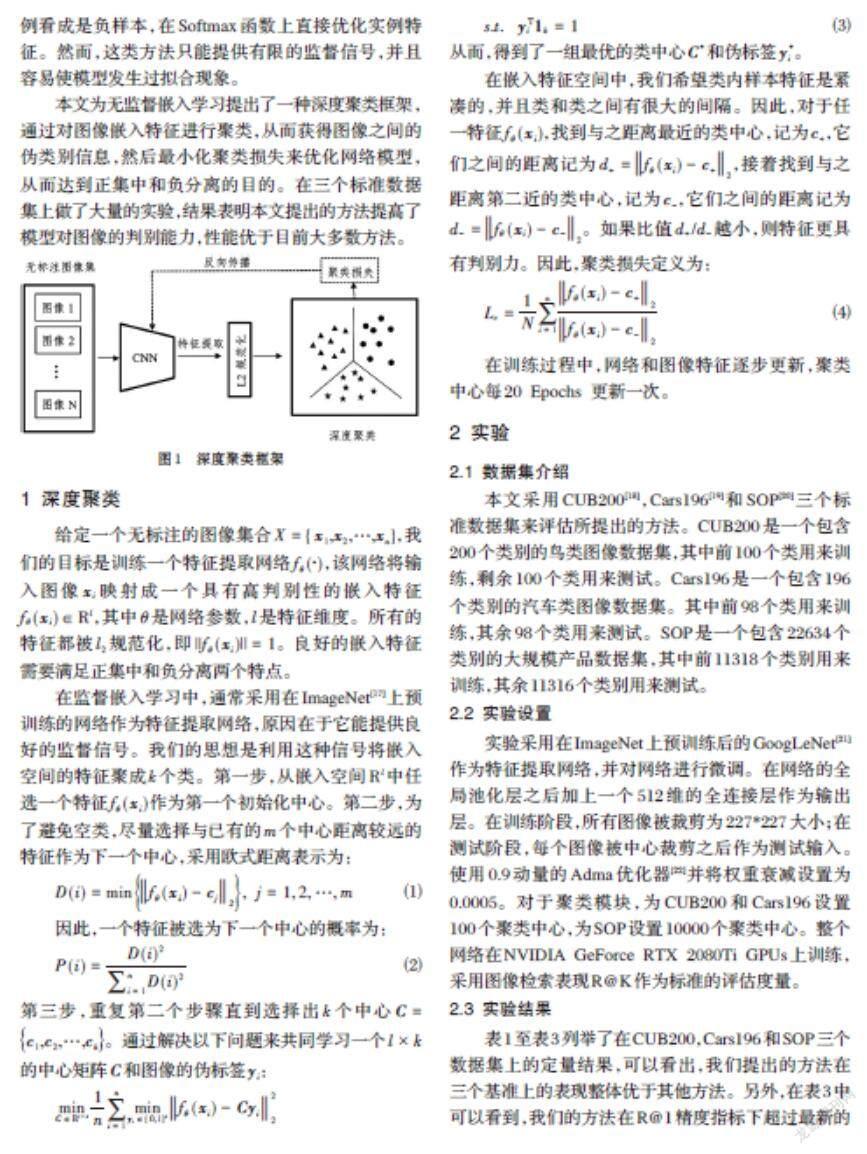

2.3 实验结果

表1至表3列举了在CUB200,Cars196和SOP三个数据集上的定量结果,可以看出,我们提出的方法在三个基准上的表现整体优于其他方法。另外,在表3中可以看到,我们的方法在R@1精度指标下超过最新的方法7.2%,进一步说明了所提方法在大规模数据集上的有效性。

3 结束语

本文提出了一种基于深度聚类的无监督嵌入学习方法,该方法通过对图像特征进行聚类,从而获得图像间的伪类别信息,然后最小化聚类损失函数,使得网络模型输出具有高判别性的图像特征。在三个标准数据集上的实验结果表明,本文提出的方法有效地改善了无监督嵌入学习能力,并且其性能优于目前大多数方法。

参考文献(References):

[1] Manmatha R, Wu C, Smola A, et, al. Sampling matters in deep embedding learning[C] // IEEE International Conference on Computer Vision (ICCV),2017:2859-2867

[2] Song H, Xiang Y, Jegelka S, and Savarese S, et, al. Deep metric learning via lifted structured feature embedding [C] //IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2016:4004-4012

[3] Wang X, Han X, Huang W, et, al. Multi-similarity loss with general pair weighting for deep metric learning [C] // IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2019:5022-5030

[4] Zhou T, Fu H, Gong C, et, al. Multi-mutual consistency induced transfer subspace learning for human motion segmentation[C] //IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR),2020:10277-10286

[5] Li T, Liang Z, Zhao S, et, al. Self-learning with rectification strategy for human parsing [C] // IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR),2020

[6] Woo S, Park J, Lee J, et, al. Learning descriptors for object recognition and 3d pose estimation [C] // IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2015:3109-3118

[7] He X, Zhou Y, Zhou Z, et, al. Triplet-center loss for multi-view 3d object retrieval [C] // IEEE Conference on Computer Vision and Pattern Recognition(CVPR),2018:1945-1954

[8] Grabner A, Roth P, Lepetit V. 3d pose estimation and 3d model retrieval for objects in the wild [C] // IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2018:3022-3031

[9] Wen Y, Zhang K, Li Z, et, al. A discriminative feature learning approach for deep face recognition [C] // European Conference on Computer Vision (ECCV),2016:499-515

[10] Tao R, Gavves E, Smeulders A. Siamese instance search for tracking [C] // IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2016:1420-1429

[11] Yu R, Dou Z, Bai S, et, al. Hard-aware point-to-set deep metric for person re-identification [C] // European Conference on Computer Vision (ECCV),2018:188-204

[12] Hermans A, Beyer L Leibe B. In defense of the triplet loss for person re-identification[EB/OL].arXiv preprint arXiv:1703.07737,2017

[13] Iscen A, ToliaS G, Avrithis Y, et, al. Mining on manifolds: metric learning without labels [C] // IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2018:7642-7651

[14] Huang J, Dong Q, Gong S, et, al. Unsupervised deep learning by neighbourhood discovery [C] // ACM International Conference on Machine Learning (ICML),2018:7642-7651

[15] Ye M, Zhang X, Yuen P, et, al. Unsupervised embedding learning via invariant and spreading instance feature [C] // IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2019:6210-6219

[16] Ye M, Shen J. Probabilistic structural latent representa-tion for unsupervised embedding [C] // IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2020:5457-5466

[17] Deng J, Dong W, Socher R, et, al. A large-scale hierarchical image database [C] // IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2009:248-255

[18] Wah C, Branson S, Welinder P, et, al. Caltech-UCSD birds 200[R]. California Institute of Technology,2010

[19] Krause J, Stark M, Deng J, et, al. 3D object representations for fine-grained categorization [C] // IEEE International Conference on Computer Vision Workshops (ICCVW),2013:554-561

[20] Khosla A, Jayadevaprakash N, Yao B, et, al. Novel dataset for fine-grained image categorization[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2011

[21] Szegedy C, Liu W, Jia Y, et al. Going deeper with convolutions [C] // IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2015

[22] Kingma D P, Ba J. Adam: a method for stochastic optimization[EB/OL]. arXiv preprint arXiv:1412.6980,2015