基于融合神经网络的飞机蒙皮缺陷检测的研究

张德银 黄少晗 赵志恒 李俊佟 张裕尧

摘 要:飞机蒙皮受大气环境侵蚀及飞鸟撞击等影响而出现各种缺陷,将严重威胁飞行安全.为解决飞机蒙皮人工检查耗时长及检测不充分等问题,提出基于融合神经网络的飞机蒙皮缺陷检测方法.在YOLOv5网络基础上,将Xception架构融入其中,同时在Backbone中加入全局通道注意力机制,在Neck和Output中加入通道空间注意力机制,形成新的融合神经网络.将采集到的飞机表面缺陷8 503幅图像分为训练集和测试集.新融合神经网络经训练后,用测试集验证,铆钉腐蚀、铆钉脱落、蒙皮裂痕、蒙皮脱落及蒙皮撞击5种缺陷检测平均精确度分别为0.960、0.928、0.931、0.934、0.948.融合神经网络准确率为0.950,召回率为0.964,平均精确度为0.957,说明新融合神经网络对飞机蒙皮缺陷识别是有效的.

关键词:飞机蒙皮缺陷;注意力机制;深度学习;融合神经网络;目标检测

中图分类号:V241.07

文献标志码:A

0 引 言

飞行安全最重要的保障就是绕机检查.从飞机机头处的3个探头到14个放电刷,从雷达罩到起落架,总共13个步骤56项内容,均需要人工进行仔细无差别检测.检查飞机是每次航班必做的环节,也是飞机在起飞之前和降落之后不可缺少的重要防线.如果在起飞之前和降落之后检查出飞机蒙皮所出现的问题,就可以避免很多危险事故的发生[1-2].

飞机蒙皮表面会受到大气环境的侵蚀、飞鸟撞击、闪电冲击及飞行中蒙皮相互拉扯的应力作用,会出现蒙皮裂纹、撞击坑和蒙皮腐蚀等缺陷[3].这些飞机表面缺陷不仅影响飞机表面美观,更会影响飞机的整体使用寿命.如果继续飞行将会因为拉扯应力,使得缺陷裂口进一步被撕裂,从而导致飞行事故的发生[4].传统的飞机蒙皮检测方法是通过人工绕机检查,需要人工细致地观察飞机的每寸蒙皮.但是由于飞机表面太大,人工检测存在耗时长、检测不充分且会忽略致命蒙皮缺陷等问题[5].在智慧民航背景下,如何快速地对蒙皮进行精确检测是研究的重点之一,而机器视觉技术则是一种十分可靠的方法[6],其利用图像采集设备对航空器蒙皮进行采集,并建立大量飞机蒙皮数据集,再利用诸如神经网络的目标检测方法对蒙皮数据集进行检测.随着计算机视觉算法的不断改进,基于神经网络的视觉蒙皮检测方法就可以进一步缩短检测的周期,并提高智能化[7].

本研究探讨关于飞机蒙皮缺陷快速巡检的人工智能系统,适用于所有民用航空飞机蒙皮缺陷巡检[8].本研究设计并实现基于机器视觉的神经网络便携式民航航空器蒙皮检测仪,通过训练飞机蒙皮缺陷,提高神经网络对飞机蒙皮的检测效果,以实现对蒙皮的安全状况智能检测评估.由于航空安全要求高标准无差别,传统的神经网络无法满足现有需求,因此需要通过融合来提升检测效果精度[9].该检测仪能够对航空器的表面蒙皮进行损伤检测,对其损伤类型进行评估,其检测精度与速度极大优于现有人工检测方法,满足日常巡检的基本保障[10].

1 图像数据集的建立

由于图像数据集是人工智能最重要的因素之一,神经网络识别的准确率和效果的差异很大程度上由数据集的质量确定[11].如何收集到大量优质数据集及如何标注识别对象的目标特征,都将直接或间接影响神经网络对飞机蒙皮缺陷的识别效果[12].为了获得高质量蒙皮缺陷数据集,本研究在得到许可后,在国内航空机场使用专用相机进行飞机蒙皮缺陷图像数据集的采集[13].

为采集飞机蒙皮图像数据集,本研究选用对焦好且焦距足够的数码单反相机dSLR.为了避免在拍摄过程中相机发生抖动造成缺陷数据集的情况,因此要选用具有快速快门的相机,且拍摄时间控制在0.002 s左右,从而避免因抖動造成拍摄不清晰的情况[14].此外相机过滤器也相当重要,由于采集飞机蒙皮缺陷时均在户外可见光的情况下,因此要选用带有偏光滤镜的相机,以减少偏振光,达到增强颜色的效果[15].为达到以上效果,综合经济性、实用性及重量等因素,本研究最终选取尼康D7100中端专业单反数码照相机.

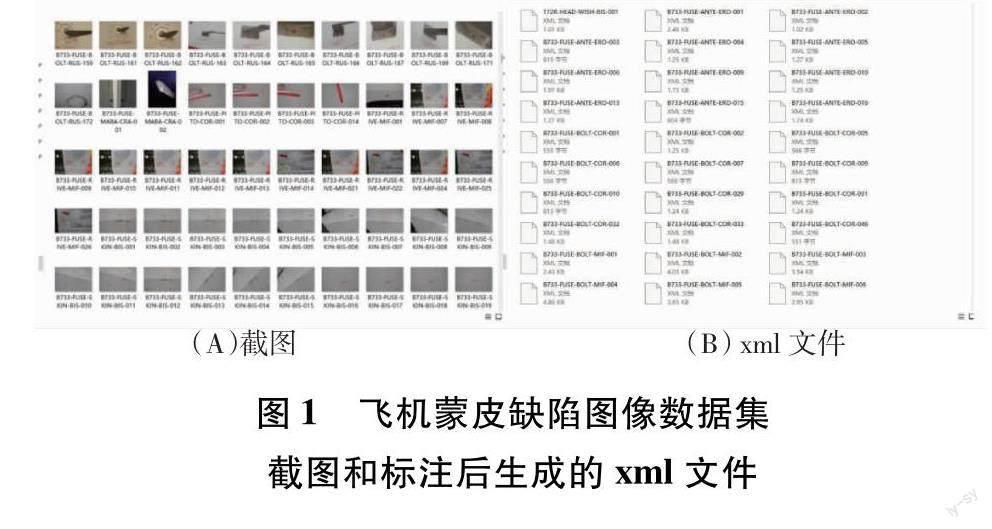

本研究在广汉机场、新津机场、天府国际机场、双流国际机场及平顶山飞机场等机场采集A319、A320、B733、B737、PA44、TB200、B747及B777等带有缺陷的飞机蒙皮图像共计8 503张,如图1所示.图1(A)为已采集到的飞机蒙皮缺陷图像数据集截图.将采集到的飞机表面缺陷分为5类,即铆钉脱落、铆钉腐蚀、蒙皮脱落、蒙皮裂痕及蒙皮撞击,并使用labellmg标注软件,对采集到的数据集进行标注,标注后生成与之相对应的xml文件,如图1(B)所示.首先将多缺陷图像通过pycharm剪切程序裁剪,得到10 437幅图像数据集,接着使用添加噪声、对比度变换及亮度调节等方法生成新图像数据集,以截图和标注后生成的xml文件实现对飞机蒙皮缺陷样本的扩增,最后获得12 440幅图像.

2 融合神经网络的构建

由于通道注意力模块(channel attention module,CAM)[16]的缺点是不易提取到小目标特征,从而导致小目标易漏检,因此,本研究采用全局池化代替CAM中最大池化操作,因为全局池化可以缓解网络对于小目标信息的过滤,最大程度保留小目标信息,以提高神经网络对小目标的检测.相比于CAM,改进的全局通道注意力(global channel attention,GCA)使用4层特征共享感知机(multi-layer perceptron,MLP),可以更充分获取小目标特征信息.改进后的CAM注意力机制命名为全局通道注意力机制GCA,其流程图如图2所示.

挤压与激励网络( squeeze-and-excitation networks,SENet)的缺点在于忽略了空间信息,因此提出由SENet改进而来的通道空间注意力(channel space attention,CPA)机制,可以通过赋予空间信息更大的权重,显示出目标的位置信息.为了获取图像宽度和高度上的注意力并对精确位置信息进行编码,将输入特征图分为宽度与长度2个方向进行全局平均池化,分别获得在宽度和长度方向的特征图,如式(1)和式(2)所示[17-18].

将获得的全局池化的宽度与长度方向上的特征图进行合并,送入共享卷积核为1×1的卷积模块,将维度降低为原来的C/r,并将经过批量处理归一化的特征图F1送入Sigmoid 激活函数,得到特征图f,如式(3)所示[19].

f=βF1Dh,Dw(3)

将得到的特征图f根据原来的长度与宽度开始卷积核为 1×1的卷积,获得通道数目与原来相同数目的特征图Fh和Fw,经过Sigmoid激活函数得到特征图在长度上的注意力权重gh和在宽度上的注意力权重gw,如式(4)和式(5)所示[20-21].

gh=?Fhfh(4)

gw=?Fwfw(5)

通过式(1)~式(5)计算之后将得到输入特征图高度注意力权重gh和长度注意力权重gw,最后在原始特征图上经过乘法加权计算,获得最终在宽度和高度方向上带有注意力权重的特征图.改进后的CPA机制如图3所示.

图3 改进后的CPA机制图

本研究采用YOLOv5神经网络模型与Xception网络模型融合,通过训练结果反复调整网络模型参数进行飞机蒙皮缺陷的检测.YOLOv5与Xception融合的神经网络框架图如图4所示.Xception网络模型相比CBS拥有更多卷积层,可以使模型在进入Upsample前进行进一步深入卷积,使原有神经网络具有更快的收敛效果,从而提升检测效果的快速性和准确度.Xception网络模型也具有轻量化且计算小的优点[22].在Backbone中加入GCA机制模块,在Neck和Output中加入CPA机制,对飞机蒙皮缺陷小目标进行检测精度提升.融合后的神经网络算法进一步提高了检测精度,能够有效检测到复杂飞机蒙皮背景中缺陷的具体位置[23].本研究將所提出的YOLOv5和Xception融合神经网络对飞机蒙皮缺陷检测方法进行了训练和测试,与原始YOLOv5神经网络进行了实验对比,其中,采用Precision、Recall及mAP等评价指标[24].

损失函数CIOU_Loss是一种监督神经网络的学习过程,通过自动调节权重的方式帮助神经网络模型对飞机蒙皮缺陷的学习,而且通过对比标注和神经网络学习后的预测,计算出神经网络模型的损失,并绘制出神经网络的损失函数曲线.损失函数CIOU_Loss可以防止神经网络模型过大,减小了神经网络模型参数,此种方式称为防止过拟合,也称为正则化[25].损失函数CIOU_Loss综合考虑了边框比、宽高比及中心距离等问题,极大提高了飞机蒙皮缺陷检测的准确性[26],其计算式如下:

式(6)和式(7)中,IoU为交互比,v为衡量长宽比一致性的参数[27-28].

式(8)中,α是衡量权值的参数[29].

3 实验过程和分析

3.1 实验平台的建立

实验平台的建立和运行是保证实验能否成功的关键.本研究需要对神经网络的实验平台完成搭建,并且在更换不同融合神经网络的同时需要对moudle(模型)不断调整,以确保神经网络正常运行.神经网络正常运行后,还需要对飞机蒙皮缺陷数据集进行合适分类,设置合适的参数.设置参数运行时,需要控制相关定量,即200轮、统一运行大小为16、统一输入图像为640×640,以确保实验效果的准确性和真实对比性[30].实验后,若实验效果未达到预期效果,需要调整神经网络中的融合框架位置或对神经网络中的代码与参数进行调整,以确保获得最佳效果[31].

本研究的实验在Pytorch深度学习框架下进行,利用YOLOv5与Xception融合神经网络对飞机蒙皮中的铆钉腐蚀、铆钉脱落、蒙皮裂痕、蒙皮脱落、蒙皮撞击5种主要缺陷进行检测.具体配置环境参数如表1所示.

本研究最终获得12 440幅图像的数据集,其中铆钉腐蚀2 637幅、铆钉脱落2 309幅、蒙皮裂痕2 406幅、蒙皮脱落2 523幅、蒙皮撞击2 565幅,并利用标注软件进行标注,分别标注为rivet corrosion(铆钉腐蚀)、rivet falling off(铆钉脱落)、skin crack(蒙皮裂痕)、skin paint falling off(蒙皮脱落)、external impact(蒙皮撞击).将增强后的数据集按7:3的结构划分为训练集8 708幅、测试集3 732幅.训练的超参数设置如表2所示.

3.2 评价指标

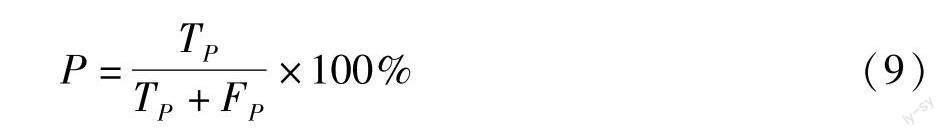

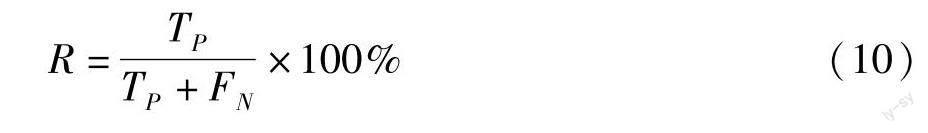

目标检测常见的评价方式有P(准确率)、R(召回率)及mAP(平均精确度).P与R可用于评价此检测模型的优劣,而mAP综合考虑了P与R的相关性,更准确地反映目标检测的能力.本研究选取P、R及mAP 3种方式来综合评价检测指标[34-35],从而全面评估检测性能.

式(9)中,TP表示检测正确的数量,FP表示检测错误的数量[32].

式(10)中,FN表示将某种检测目标当作其他目标的数量[33].

式(11)中,mAP是平均精确度[34-35].

3.3 实验结果与分析

单独YOLOv5神经网络对于飞机蒙皮缺陷的检测输出数据效果如表3所示.YOLOv5神经网络对于飞机蒙皮缺陷检测中重要的5种检测物为rivet corrosion(铆钉腐蚀)、rivet falling off(铆钉脱落)、skin crack(蒙皮裂痕)、skin paint falling off(蒙皮脱落)、external impact(蒙皮撞击).单独YOLOv5神经网络目标检测效果图如图5所示,其中,图5(A)为铆钉腐蚀检测效果图,图5(B)为蒙皮裂痕检测效果图,图5(C)为蒙皮裂痕检测效果图,图5(D)为蒙皮脱落检测效果图,图5(E)为蒙皮撞击检测效果图,图5(F)为铆钉脱落检测效果图.

YOLOv5和Xception融合神经网络对于飞机蒙皮缺陷检测中重要的5种检测物,得到相应的被检测物数据效果,如表4所示.YOLOv5与Xception融合神经网络目标检测效果如图6所示,其中,图6(A)为铆钉腐蚀检测效果图,图6(B)为蒙皮撞击检测效果图,图6(C)为蒙皮裂痕检测效果图,图6(D)为蒙皮脱落检测效果图,图6(E)为蒙皮裂痕检测效果图,图6(F)为铆钉脱落检测效果图.

为验证YOLOv5与Xception融合神经网络的有效性,本研究将单独YOLOv5神经网络和YOLOv5与Xception融合神经网络对验证数据集进行对比检测,对比效果如表5所示.由对比实验结果可知,YOLOv5与Xception融合神经网络算法在识别准确率与识别用时等方面都强于单独YOLOv5算法.YOLOv5与Xception融合神经网络的检测准确率、召回率、平均精确度都达到了更高水平,且融合神经网络平均检测用时为30 ms,比单独YOLOv5神经网络巡检提高了9.10%,进一步说明了YOLOv5与Xception融合神经网络对飞机表面缺陷检测的快速性与高效性.

4 结论与展望

本研究探讨了适用于民航飞机蒙皮缺陷检测的智能检测系统,将Xception网络架构融入到YOLOv5神经网络的Backbone中,对飞机蒙皮缺陷进行检测,同时在YOLOv5的Backbone中加入GCA机制,在YOLOv5的Neck和Output中加入CPA机制,提高检测平均精确度.经实验验证,YOLOv5与Xception融合神经网络准确率0.950、召回率0.964、平均精确度0.957,相比单独YOLOv5神经网络,分别提升了0.068、0.056、0.058.YOLOv5与Xception融合神经网络平均检测时间为30 ms,相比选择单独YOLOv5方式进行巡检的检测速度提高了3 ms.实验结果表示,基于YOLOv5与Xception融合神经网络对飞机蒙皮缺陷具有高效率、高精度、智能化的检测,具有较强的实用价值.

针对本研究搭建的融合神经网络对飞机蒙皮缺陷检测可以进行快速有效识别,能够在实时检测实验中实时传输检测后的效果[36].本研究的方法可以帮助民航从业人员在对飞机蒙皮检测时节约大量时间[37],同时通过对YOLOv5神经网络的不断融合和改进,增加了对飞机蒙皮缺陷检测5种识别对象的有效性[38].

本研究在样本集的建立过程中,由于考虑样本集数量和质量的问题,使用了传统图像处理方式对样本数据进行了扩增,但是该方法对样本的扩增能力有限[39].若想要进一步提升样本集的全面性,可以利用生成对抗神经网络对飞机蒙皮缺陷样本进行学习和重构,得到全新的飞机蒙皮缺陷样本,实现对样本的扩增[40].

由于神经网络实验平台的软硬件限制,越深度的网络模型对硬件计算力的要求越高,所以下一步的研究将对硬件平台进行升级,提供更强大的计算力,给更加深度的网络训练提供支持,以得到最好的飞机蒙皮识别神经网络模型.

参考文献:

[1]王得道,王森荣,林超,等.基于CNN-LSTM融合神经网络的CRTSⅡ型轨道板温度预测方法[J].铁道学报,2023,45(2):108-115.

[2]朱淑暢,李文辉.基于卷积和Transformer融合的服装分类算法[J].吉林大学学报(理学版),2023,61(5):1195-1201.

[3]丁华彬,丁麒文.基于语义损失的红外与可见光图像融合算法[J].红外技术,2023,45(9):941-947.

[4]钱白云,吕朝阳,张维宁,等.基于多传感器信息融合与混合感受野残差卷积神经网络的调相机转子故障诊断[J].计算机测量与控制,2023,31(9):29-35.

[5]吴怀诚,刘家强,岳蕾,等.基于多特征融合的卷积神经网络的电能质量扰动识别方法[J].电网与清洁能源,2023,39(9):19-23.

[6]周哲,欧阳勇.融合神经网络GRU和RRT算法的机械臂路径规划[J].组合机床与自动化加工技术,2023,65(9):7-10.

[7]刘霞,冯文晖,连峰,等.基于物理信息神经网络的气动数据融合方法[J].空气动力学学报,2023,41(8):87-96.

[8]韩永成,张闻文,何伟基,等.基于自适应截断模拟曝光和无监督融合的低照度真彩色图像增强算法[J].光子学报,2023,52(9):245-259.

[9]陆应越,罗昊,吴朴艳,等.融合BP神经网络和知识图谱的微博热搜研究与分析[J].电脑编程技巧与维护,2023,30(9):127-130.

[10]吴军,石改琴,卢帅员,等.采用无人机视觉的飞机蒙皮损伤智能检测方法[J].中国测试,2021,47(11):119-126.

[11]王建兵,杨超,刘方方,等.基于图卷积神经网络和RoBERTa的物流订单分类[J].计算机技术与发展,2023,33(10):195-201.

[12]张欢,程洪,葛美伶,等.机器学习辅助高熵合金相结构预测[J].成都大学学报(自然科学版),2022,41(3):280-286.

[13]闫政伟,王晨,黄秋波,等.云数据共享中一种轻量级的数据确定性删除算法[J].成都大學学报(自然科学版),2023,42(3):255-261.

[14]冷志鹏,孙文瑞,朱立伟,等.基于YOLO-UNet算法的路面病害定量分析方法[J].物联网技术,2023,13(8):141-143.

[15]徐仵博,刘立群.GLHMS算法的PCNN参数优化及其在图像融合中的应用[J].软件导刊,2023,22(8):187-195.

[16]杨灿,王重熙,章隆兵.基于层间融合的神经网络访存密集型层加速[J].高技术通讯,2023,33(8):823-835.

[17]李东泽,齐咏生,刘利强.基于LSTM-ATTENTION融合神经网络的光伏功率预测[J].内蒙古工业大学学报(自然科学版),2023,42(4):350-354.

[18]闫婧,武林伟,刘伟杰,等.基于统一网络架构的多模态航空影像质量评价研究[J].现代电子技术,2023,46(17):43-47.

[19]马孝威.基于多源信息融合的托辊故障检测系统[J].煤矿机械,2023,44(9):168-170.

[20]代婷婷.基于改进智能算法的机器人路径规划问题研究[J].成都大学学报(自然科学版),2021,40(4):379-383.

[21]杜航,张涛,陈岩,等.基于遗传算法的BP神经网络预测石油单井产量[J].成都大学学报(自然科学版),2021,40(1):57-61.

[22]淡文慧,毛鹏军,苏坤,等.基于改进YOLOv4的移动机器人障碍物检测[J].组合机床与自动化加工技术,2023,65(10):73-76.

[23]许若波,李平,张梓楚,等.基于多源融合的人脸图像超分辨率算法[J].电脑知识与技术,2023,19(24):107-109.

[24]王浏洋,徐彦伟,颉潭成,等.基于优化CNN与信息融合的地铁牵引电机轴承故障诊断[J].机械与电子,2023,41(8):39-44.

[25]闫冰,余枭,王帅,等.IMRT QA中基于后融合卷积神经网络的MLC误差分类预测[J].中国医学物理学杂志,2023,40(8):925-932.

[26]曹轲,谭冲,刘洪,等.基于改进灰狼算法优化BP神经网络的无线传感器网络数据融合算法[J].中国科学院大学学报,2022,39(2):232-239.

[27]祁宏宇.基于注意力U-Net网络的红外夜视质量增强研究[J].光学技术,2023,49(5):623-630.

[28]张亚加,邱啟蒙,刘恒,等.基于多尺度分解和改进稀疏表示的脑部图像融合[J].陕西理工大学学报(自然科学版),2023,39(4):52-61.

[29]李扬,胡学钢,王磊,等.基于图神经网络的环状RNA生物标志物筛选预测算法[J].中国科学:信息科学,2023,53(11):2214-2229.

[30]路琨婷,费蓉蓉,张选德.融合卷积神经网络的遥感图像全色锐化[J].计算机应用,2023,43(9):2963-2969.

[31]裴红蕾.基于综合信息融合神经网络的轴承故障诊断[J].机电工程,2022,39(4):495-500.

[32]王治学.融合实体信息的图卷积神经网络的短文本分类模型分析[J].信息系统工程,2023,36(9):122-125.

[33]杨佳攀,陈为,艾渤.基于深度展开神经网络的融合感知通信场景信道估计[J].移动通信,2023,47(9):64-70.

[34]叶文超,罗水洋,李金豪,等.近红外光谱与图像融合的杂交水稻种子分类方法研究[J].光谱学与光谱分析,2023,43(9):2935-2941.

[35]冯江,李涛,朱哲,等.絮体性状实时图像检测系统的开发与应用[J].环境污染与防治,2008,191(10):40-43.

[36]宋小飞,晁永生.基于改进YOLOv5s网络的机械零件目标检测[J].组合机床与自动化加工技术,2023,65(8):84-88.

[37]赵卫东,施实伟,周婵.基于ImageNet预训练卷积神经网络的图像风格迁移[J].成都大学学报(自然科学版),2021,40(4):367-373.

[38]Zhao Z,Wang P,Lu W.Multi-layer fusion neural network for deepfake detection[J].IJDCF,2021,13(4):26-39.

[39]王冠博,楊俊东,李波,等.改进YOLO v4的火焰图像实时检测[J].计算机工程与设计,2022,43(5):1358-1365.

[40]梁秀满,安金铭,曹晓华,等.基于CNN-Transformer双流网络的烧结火焰燃烧状态分类[J].应用光学,2023,44(5):1030-1036.

(实习编辑:黄爱明)

Investigation of Aircraft Skin Defect Detection Based on Fusion Neural Network

ZHANG Deyin,HUANG Shaohan,ZHAO Zhiheng,LI Juntong,ZHANG Yuyao

(Institute of Electronic and Electrical Engineering,Civil Aviation Flight University of China,Guanghan 618307,China)

Abstract:The aircraft skin is damaged by multiple factors,such as atmospheric environment erosion,bird strike and so on.Flight safety is threatened by those factors.A skin defect detection method based on fusion neural network is proposed to solve the problems,such as time-consuming and insufficient manual inspection in aircraft skin in this paper.The Xception architecture is integrated into the YOLOv5 network,and the global channel attention mechanism is added to Backbone,and the channel space attention mechanism is added in Neck and Output so as to form a new fusion neural network based on the YOLOv5 network.The 8 503 images of aircraft surface defects collected are divided into training sets and test sets.After training,the new fusion neural network is verified by the test set,and the average accuracy of the five kinds of defects detection,including rivet peeling,rivet corrosion,skin peeling,skin crack and skin impact,are 0.960,0.928,0.931,0.934,0.948 respectively.And the overall recognition accuracy of the whole aircraft skin defects to the new fusion neural network is 0.950,the recall rate is 0.964,and the average accuracy rate is 0.957.The experimental results show that the new fusion neural network is effective for aircraft skin defect recognition.

Key words:aircraft skin defects;attention mechanism;deep learning;fusion neural network;object detection