面向白内障识别的临床特征校准注意力网络

章晓庆,肖尊杰,赵宇航,巫 晓,东田理沙,3,刘 江,4

1.南方科技大学 计算机科学与工程系,广东 深圳 518055

2.南方科技大学 斯发基斯可信自主系统研究院,广东 深圳 518055

3.Tomey公司,日本 名古屋4 510051

4.南方科技大学 广东省类脑智能计算重点实验室,广东 深圳 518055

白内障是中国乃至全球排名首位的致盲性眼病[1],也是一种年龄相关性眼病。根据2018年屈光性白内障手术新进展国际会议报告数据显示,中国白内障患者人数接近2亿。随着社会人口结构的老龄化进程加快,白内障患者人数将会显著增长。在临床上,白内障表现为眼睛的晶状体区域出现混浊症状,从而导致视力受损甚至失明。根据混浊症状在眼睛晶状体区域中出现的位置,白内障又可分为三种类型:核性白内障(nuclear cataract,NC)、皮质性白内障(cortical cataract,CC)、后囊性白内障(posterior subcapsular cataract,PSC)[2]。核性白内障是一种最常见的白内障类型,其临床症状表现为晶状体核性区域出现混浊。根据临床诊断实际需求和晶状体混浊分类系统(lens opacities classification system III,LOCS III)[3-5],核性白内障的发展可分为三个阶段:正常(normal)、轻度(mild)和重度(severe)。在实际诊断过程中,眼科医生通常基于自身经验诊断患者的核性白内障严重程度,但这种诊断方式具有较强的主观性且与医生自身经验、接受的临床训练以及领域知识有关,容易出现误诊。因此,有必要开发智能计算机辅助诊断技术提高眼科医生诊断结果的精准性。

近年来,深度神经网络模型已经被广泛用于眼科疾病辅助诊断包括白内障疾病。国内学者李建强等基于眼底图像提出了一个深度神经网络模型用于白内障自动筛查[6]。Xu 等[7]在眼底图像下构建了一个总体-局部集成卷积神经网络模型用于白内障分类。刘振宇等[8]在裂隙灯图像下提出了一个神经网络用于核性白内障分级。然而,现有用于白内障筛查与分级的神经网络模型设计主要出发点是提升白内障筛查与分级性能,鲜有研究工作关注神经网络模型的可解释性。

相较于其他常用于白内障临床诊断的眼科影像模态如裂隙灯图像和眼底图像,眼前节光学相干断层成像(anterior segment optical coherence tomography,ASOCT)是一种新型的眼科影像,其能清楚地获取晶状体核性区域。近年来,研究人员已经在AS-OCT影像下分析了核性白内障严重级别与临床特征之间相关关系,比如像素均值和最大值,临床统计结果表明它们与核性白内障严重级别之间存在强相关性[9]且相关性系数大小不同。这两个临床特征及其相关系数大小是眼科医生诊断白内障严重级别的重要参考,可以当作一种临床先验知识。

注意力机制(attention mechanism)[10-12]已经在计算机视觉任务中证明其能提升卷积神经网络(convolutional neural network,CNN)的性能。挤压激励注意力机制(squeeze-and-excitation attention mechanism,SE)[12]是一个具有代表性的注意力机制方法,它由挤压和激励操作符组成。在挤压操作符中,SE 采用全局平均池化方法(global average pooling,GAP)从每个通道中提取特征图(feature map)的全局均值特征表示信息,可以认为AS-OCT 影像下白内障的像素均值的另一种特征表示方式。类似的,其他特征图的全局特征表示(最大值)也可以通过其他的池化方法(最大池化方法)提取[13]。

鉴于特征图的全局特征表示和白内障的临床特征如像素均值和最大值之间联系,本文提出是否可以将这两种临床特征及其相关性系数转化为特征图的全局特征表示和特征表示权重,再将它们融入到注意力机制网络模型设计中,以此来提升核性白内障分类结果和增强神经网络模型决策过程的可解释性。为此,本文基于AS-OCT 影像提出了一个基于临床特征校准注意力网络(clinical feature recalibration attention network,CFANet)模型自动地识别核性白内障严重级别,如图1所示。在提出的CFANet 中,本文构造了一个临床特征校准注意力模块(clinical feature recalibration attention block,CFA),它对两种特征图的全局特征表示类型:均值和最大值进行动态地加权融合;随后采用softmax函数作为门控操作符来突出了重要的通道,从而实现对每个特征图的重要性校准。为了更好地了解CFANet的决策过程,本文采用可视化技术来分析临床特征的权重分布和通道的权重分布。另外,本文还探索了其他影响CFANet 分类性能的因素,比如门控操作符种类和临床特征表示的加权方式。本文的主要贡献为以下三个方面:

图1 基于CFANet的自动白内障分类框架Fig.1 Automatic cataract classification framework based on CFANet

(1)本文提出了一个临床特征校准注意力网络框架自动地识别核性白内障严重级别。在提出的CFANet中,本文引入了一个临床特征校准注意力模块对临床特征表示:均值和最大值进行自适应地加权融合,并应用门控操作符来突出重要的通道和抑制不重要的通道,以此来提高核性白内障严重级别预测结果的准确性。

(2)在一个临床AS-OCT数据集和公开OCT数据集上进行实验,实验结果表明CFANet 的性能明显优于先进的注意力机制网络和已发表的研究工作。

(3)本文不仅分析了CFA中临床特征表示权重和通道权重的相对分布,同时还对比了CFA、SE、ECA、SRM的权重分布,以此来增强模型决策过程的可解释性。同时也设计了有关消融实验探索影响模型性能的因素。

1 相关工作

1.1 基于AS-OCT影像的眼科疾病诊断研究现状

AS-OCT 是一种OCT 成像技术,它具有速度快、用户友好、非侵入、高分辨率、定量化测量等特点。近年来,眼科医生和研究人员已经基于AS-OCT影像对多种眼科疾病进行临床诊断和科学研究如角膜疾病、青光眼和白内障。文献[14-15]在AS-OCT 影像下利用深度分割神经网络对角膜结构进行分割,并得到不错的分割结果。Fu等[16-17]在AS-OCT影像下设计了一个多尺度神经网络对开闭角青光眼进行自动筛查,并在一个临床AS-OCT 数据集上取得了超过92%的准确率。在白内障诊断方面,AS-OCT影像与其他眼科影像相比例如裂隙灯影像,它能获取完整的晶状体结构信息,如囊性区域、皮质性区域和核性区域,这是诊断不同类型白内障的重要基础,这也引起了研究人员的关注和兴趣。Chen等[18]在LOCS III 分级系统上研究核性白内障级别与AS-OCT影像中均值特征的相关关系,临床统计结果分析显示两者存在较强相关性。

文献[19-21]在AS-OCT 影像下利用斯皮尔曼等级相关系数方法分析了像素均值和最大值与核性白内障严重程度之间相关性,统计分析结果显示这两种像素特征均与核性白内障级别存在较强相关性但它们的相关系数大小不同。以上基于AS-OCT 影像的核性白内障临床研究工作为核性白内障的自动分类工作提供了临床支持和依据。文献[22]使用深度分割网络模型对ASOCT影像的晶状体结构进行自动分割,得到晶状体的核性区域、皮质性区域和囊性区域,可用于辅助医生基于AS-OCT 影像诊断不同类型白内障。Zhang 等[23]基于AS-OCT 影像提出了一个GraNet 网络模型用于核性白内障自动分类,但准确率没有达到60%。章晓庆等[24]设计了一个AS-OCT影像下的核性白内障自动分类框架,它包括三个阶段:核性区域提取、像素特征提取、特征重要性分析和分类,取得了75.53%的准确率。Xiao等[25]提出了一个门控通道注意力网络(gated channel attention network,GCANet)用于白内障的分类并取得了不错的分类结果。

1.2 注意力机制

注意力机制已经证明其能作为卷积神经网络重要组成部分且能有效地提升卷积神经网络模型在各种学习任务中的性能[26-29]。挤压激励注意力(SE)是一个被广泛应用的通道注意力机制方法,它通过压缩和激励操作符来重构不同通道之间关系并输出通道权重值。Wang 等[30]提出了一个高效通道注意力方法(efficient channel attention,ECA)来构建通道之间的邻近关系以此来提升卷积神经网络性能。Lee等[31]构造了一个风格校准模块(style-based recalibration module,SRM)通过融合风格迁移先验知识来提高计算机视觉分类任务性能。卷积块注意力组件(convolutional block attention module,CBAM)[26]和瓶颈注意力组件(bottleneck attention module,BAM)[32]将通道注意力和空域注意力结合进一步增强神经网络的特征表示。

从现有有关研究工作调研可知,已有不少基于ASOCT 影像的核性白内障研究工作和注意力机制模块设计研究工作。然而,缺乏相关研究工作将白内障的临床特征及其相关系数作为临床先验知识融入到注意力机制方法模块设计中。为此,本文提出了一个新颖的临床特征校准注意力模块,其中将核性白内障的临床诊断特征及其相关系数作为临床先验知识注入到注意力机制模块设计中,用以提升核性白内障严重级别的分类结果和改进神经网络模型决策过程的可解释性。

2 临床特征校准注意力网络框架

2.1 临床特征校准注意力模块

本文提出的临床特征注意力模块(clinical feature attention block,CFA)由Avg-Max 操作符和特征融合(feature fusion)操作符构成,如图2(a)所示。在Avg-Max 操作符中,本文使用全局平均池化(global average pooling,GAP)和全局最大池化(global maximum pooling,GMP)两种池化方法分去别提取每个通道的全局均值特征表示和全局最大值特征表示当作临床特征表示。对于任一个卷积层输出的特征图张量表达X=[x1,x2,…,xc]∈RN×C×H×W(其中,N代表批量大小,C代表通道数量,H和W代表特征图的高和宽),提取到的临床特征表示T∈RN×C×2可通过以下公式得到:

其中,Rij、Avgc、Maxc,和tc∈R2分别表示特征图的区域大小、第c个特征图中提取得到的全局均值特征表示、全局最大特征表示以及两个临床特征表示的集合。

紧随Avg-Max操作符之后是特征融合操作符,它由通道全连接(channel fully connected,CFC)操作符和门控操作符组成。CFC 操作符作用是将临床特征表示进行自适应加权融合并转化为临床特征编码表示。CFC操作符首先对两个临床特征表示的集合进行动态加权融合,得到融合的临床特征表示;随后构建通道之间的依懒性,以上两个步骤可通过以下公式得到:

其中,wc∈RC×2表示每个通道的可学习的权重参数,可以认为是临床特征的相关系数另一种表达;vc∈RC×1表示临床特征编码表示。

在门控操作符选择方面,为了更好突出通道之间的差异性以此实现对特征图的重要性校准。本文采用softmax函数作为门控单元来输出每个通道的注意力权重,其定义为:

gc表示每个通道注意力权重。在消融实验中,本文将会对比Softmax 作为门控单元与其他函数如Sigmoid 和Tanh作为门控单元对CFA性能的影响。

最后将每个原始特征图与通道分配权重相乘,得到加权校准后的特征图Y=[y1,y2,…,yc]∈RN×C×H×W可用以下公式表达:

其中,yc表示第c个加权特征图,∙表示矩阵相乘运算。

为了验证批量归一化层(batch normalization layer,BN)[33]是否能提升本文CFA 模块的性能。在CFA 模块中,本文加了一个BN 层在CFC 操作符后面并命名为CFA-Variant,如图2(b)所示。

讨论:CBAM[26]已经从每个通道中提取了全局均值和最大特征表示来构建通道注意力机制和采用共享多层感知机(shared multilayer perception,S-MLP)来构建不同通道之间的关系,但忽略了不同特征表示类型的相对重要程度。Lee 等[31]提出的SRM 模块考虑了不同特征表示类型的相对重要程度,但没有重构通道之间的相关性。不同于已发表的注意力机制模块设计工作,本文提出的通道全连接操作符既考虑了两个特征表示类型的相对重要程度,也重构了通道之间的相关关系。另外本文还采用Softmax函数作为门控单元突出重要通道和抑制不重要的通道。

2.2 网络框架

本文主要目的是将白内障的临床特征及其相关系数作为先验知识注入到注意力机制模块设计中,以此来提高核性白内障的分类结果和改善神经网络模型的可解释性。本文采用ResNet[34]作为网络骨架(Backbone),因为现有很多注意力机制方法都采用它作为Backbone,可以全面地验证本文提出的方法性能。本文将提出的CFA 模块插入到残差模块中构成残差临床先验特征注意力组件(Residual-CFA module),如图1 下半部分所示。本文的网络框架是由多个残差临床特征注意力组件堆叠而成并命名为CFANet,如图1 上半部分所示。本文选择Softmax 作为分类器,因为其已经被广泛地应用在深度神经网络模型作为分类器;另外本文还选择经典的交叉熵损失函数(cross entropy loss function,CE)为损失函数。

3 数据集介绍

在实验中,本文使用了两个眼科图像数据集来比较:一个核性白内障的临床AS-OCT影像数据集和一个公开OCT影像数据集。

(1)临床AS-OCT 影像数据集。AS-OCT 影像数据集来自一本地三甲医院,数据采集眼科设备是日本Tomey公司的眼前节OCT 仪器CASIA2。所有受试者知情数据用途并对受试者个人信息进行脱敏处理。数据集包含543名受试者(左右眼的数量分别为422和440),平均年龄为61.30±18.65。每个受试者采集了24 张影像,在经验丰富的眼科医生帮助下剔除了4 487张受眼睑干扰影像,本文最终得到16 201张可用的AS-OCT影像。由于没有基于AS-OCT影像的白内障分类标准,所有受试者的AS-OCT 影像的核性白内障标签是通过裂隙灯图像映射得到的。即每一名受试者都拍摄了AS-OCT 影像和裂隙灯图像,并由三名眼科医生基于LOCS III 给出每个受试者的裂隙灯图像下核性白内障严重程度,保证核性白内障严重级别标签的质量和可靠性。

考虑到同一个受试者两只眼的白内障严重程度相近,本文以受试者为基本单位将数据集拆分为训练集(training dataset)、验证集(validation dataset)和测试集(testing dataset)。表1 为训练集、验证集和测试集的三种严重程度的核性白内障的AS-OCT影像数量分布。

表1 三种核性白内障严重级别分布Table 1 Distribution of three NC severity levels

(2)公开OCT数据集[35]。公开OCT数据集也称作加利福尼亚大学圣地亚哥分校数据集(University of California San Diego dataset,UCSD),它是由加利福尼亚大学圣地亚哥分校眼科中心采集并公开的。数据集包含5 319个病人,由训练集和测试集组成。其中,训练集包含4种不同标记的OCT图像:11 348张糖尿病黄斑水肿疾病(diabetic macular edema,DME)影像、37 205张脉络膜新生血管性疾病(choroidal neovascularization,CNV)影像、8 617 张黄斑玻璃疣疾病(drusen)影像,以及26 315 正常人影像。在测试集中,四种类别的OCT 图像都为250 张,详细数据集介绍见文献[35]。在实验中,本文采用与已发表的文献中相同的数据预处理方法,保证实验结果对比的公平性[35-36]。

4 评价标准与实验设置

4.1 评价标准

参考文献[37-38],本文选择准确率(accuracy,ACC)、敏感度(sensitivity,Sen)、精确率(precision,PR)、F1 指标),以及kappa系数五种评价指标来评估方法的总体性能。准确率是用来衡量算法预测正确的样本数目占总样本数的比例,敏感度是算法预测正确的正例样本的比例;精确率是算法预测为正例的样本中实际为正例的比例;F1指标是精确率和召回率的调和均值。准确率、敏感度、精确率和F1 等评价指标可以通过公式(7)~(10)来表示:

其中,TP表示真阳性,TN为真阴性,FP为假阳性,FN为假阴性。

4.2 基准模型

本文通过以下对比实验全面验证提出模型的性能:

(1)先进的通道注意力机制方法。本文采用挤压激励注意力(SE)、高效通道注意力(ECA)、风格校准模块(SRM)作为基准注意力模块来验证CFA 模块的有效性,因为本文提出的方法和三种对比注意力机制方法都属于通道注意力机制。

(2)基准方法。本文采用机器学习方法和卷积神经网络模型验证本文模型的优越性。机器学习方法:参考文献[21],本文也从晶状体核性区域提取17个像素特征并借助机器学习方法进行自动分类,如支持向量机(support vector machine,SVM)、决策树(decision tree,DT)、随机森林(random forest,RF)[24]、GradientBoost 和Adaboost。卷积神经网络模型:ResNet、GraNet[23]、VGG[39]、ECANet、SRM、GCANet[25]、CBAM等先进的卷积神经网络模型和注意力机制网络模型被选择作为对比方法。

4.3 实验设置

本文使用Pytorch、Python、Pandas、scikit-learn 和OpenCV等软件包来实现本文模型和基准模型。所有深度学习模型使用随机梯度下降优化器(stochastic gradient descent,SGD)作为优化器,训练周期(epoch)设置为150,批量大小(batch size)设置为32、初始化学习率(learning rate,lr)设置为0.035,每30 epochs 学习率减小5 倍。原始晶状体核性区域的AS-OCT 影像高和宽分别864±50和386±30,本文将所有影像的高和宽都缩放为224×224,作为神经网络模型的输入。机器学习的提取特征来自原始晶状体核性区域的AS-OCT 影像。实验硬件环境配置为1 张Nvidia Titan GPU,DDR 12 GB 内存,操作系统为Ubuntu。

5 实验结果与分析

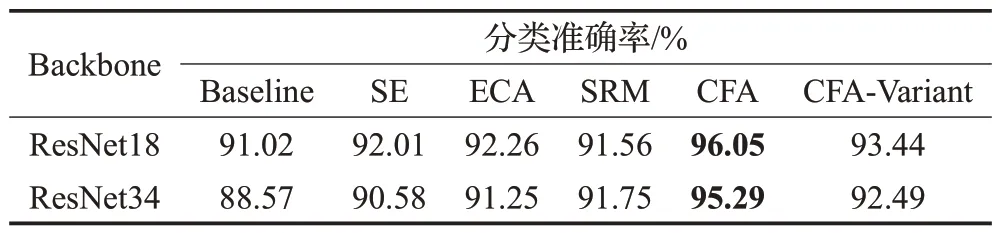

5.1 不同通道注意力机制方法结果对比

表2为本文的CFA与其他三种先进的通道注意力机制方法和基准模型(baseline是指ResNet18和ResNet34)在AS-OCT影像数据集上的分类准确率结果对比。从实验结果对比分析可见,本文提出的CFA 和CFA-Variant优于其他三种注意力机制和基准模型。其中,CFA基于两个网络骨架都取得了最高的分类准确率,分别达到96.05%和95.29%,比其他三种通道注意力方法和基准模型至少提高了3.54个百分点。

表2 不同注意力机制方法在AS-OCT数据集上结果对比Table 2 Result comparison of different attention methods on AS-OCT dataset

相较于CFA-Variant,CFA的分类准确率提升了2.61个百分点以上,因为Softmax可以当作一种归一化方法,其作用与BN 冲突,从而导致网络模型的分类性能下降。除了SRM 以外,其他注意力机制方法ResNet18 的分类结果优于它们基于ResNet34 的分类结果。因此,在下文消融实验中,选用ResNet18 作为CFA 和其他三种注意力机制方法的骨架网络模型。

5.2 与基准方法结果对比

表3 为CFANet 与基准方法在AS-OCT 影像数据集上的核性白内障分类结果对比。可以看出,本文模型在五个评价指标都取得了最好性能,分别为96.05%、95.82%、95.97%、95.81%和92.64%。它比先进的卷积神经网络模型(已发表的文献中GraNet)和具有代表性的注意力机制方法(SENet)在五个评价指标上至少分别提升了3 和2 个百分点;与经典的机器学习方法的分类结果相比,本文模型提升了5个百分点以上。

表3 本文方法与基准方法AS-OCT数据集上结果对比Table 3 Result comparison of proposed method and baselines on AS-OCT dataset 单位:%

相比于CBAM和SRM,CFANet的核性白内障总体分类性能有着显著提升,其中准确率至少提高了2.4 个百分点,这也验证了本文模型考虑不同特征表示的相对重要作用和重构通道之间的依赖关系的有效性。深度神经网络模型的总体核性白内障分类结果优于机器学习方法,说明了深度神经网络模型能够更有效地提取有用的特征表示信息。

表4 列出了CFANet、对比方法、已发表的工作在UCSD数据集上的实验结果对比。实验结果表明,CFANet在三个评价指标上都优于对比方法和已发表的工作并至少提升了1个百分点,证明了本文模型的泛化能力。

表4 本文方法与基准方法在UCSD数据集上结果对比Table 4 Result comparison of proposed method and baseline on UCSD dataset 单位:%

5.3 消融实验

5.3.1 讨论不同池化方式对分类结果的影响

为了验证本文提出的Avg-Max池化方式对CFANet分类结果的影响,本文基于CFA模块单独采用全局平均池化(GAP)方式和全局最大池化(GMP)方式与Avg-Max 操作符进行比较,实验结果如图3 所示。可以看出,Avg-Max 操作符的分类结果优于GAP 和GMP 池化方法。由此说明,全局均值和最大值特征表示在CFA模块中扮演不同角色,且两者组合能提高核性白内障分类结果。在下文将会详细地讨论这两种特征表示的权重分布来解释它们的相对重要作用。

图3 三种池化方法结果对比Fig.3 Result comparison of three pooling methods

5.3.2 讨论不同临床特征融合方式对分类结果的影响

为了验证通道全连接(CFC)方法在本文的CFA 模块中有效性,本文将已发表的文献中多层感知机(multilayer perception,MLP)、共享多层感知机(shared multilayer perception,S-MLP)、通道独立连接(independent channel connection,ICC)[26]与本文的CFC 方法做作对比,Backbone 是ResNet18。实验结果如表5 所示,可以看出,CFC的分类结果优于MLP、S-MLP以及ICC,它的准确率、F1 和Kappa 分别达到了96.05%、95.81%和92.64%,比其他三种连接对比方法在三个评价指标上最小提升和最高提升分别为1.1 和8.09 个百分点。因为MLP 和S-MLP 仅重构了通道之间的依懒关系,但忽略了不同特征表示在同一个通道中具有不同的重要性。ICC 考虑了不同特征表示类型在单个通道中起着不同的作用,但没有重构通道之间的依赖关系。本文的CFC方法不仅考虑到了通道依赖关系的构建,也考虑了在一个通道中不同特征表示类型的重要性不同,从而证明了CFC方法的有效性。

表5 不同特征表示融合方式的结果对比Table 5 Result comparison of different feature representation fusion methods 单位:%

5.3.3 讨论不同门控操作符对分类结果的影响

为了探究门控操作符对本文的CFA 模块性能的影响,本文对比了四种不同的门控操作符在CFA模块上的分类结果:ReLU、Sigmoid、Tanh、和Softmax,Backbone是ResNet18。根据表6 的实验结果分析可见,Softmax取得了最好的分类结果,在三个评价指标上都比其他三种门控操作符至少提高了1.36个百分点。Sigmoid、Tanh以及ReLU只考虑到单个通道的权重没有其他通道的权重影响,而Softmax 不仅考虑到单个通道的权重还考虑了不同通道权重的相互影响。这也解释了为什么采用Softmax作为门控操作符的CFA模块的分类结果最好。

表6 不同门控操作符的结果对比Table 6 Result comparison of different gated operators 单位:%

5.4 可视化结果分析

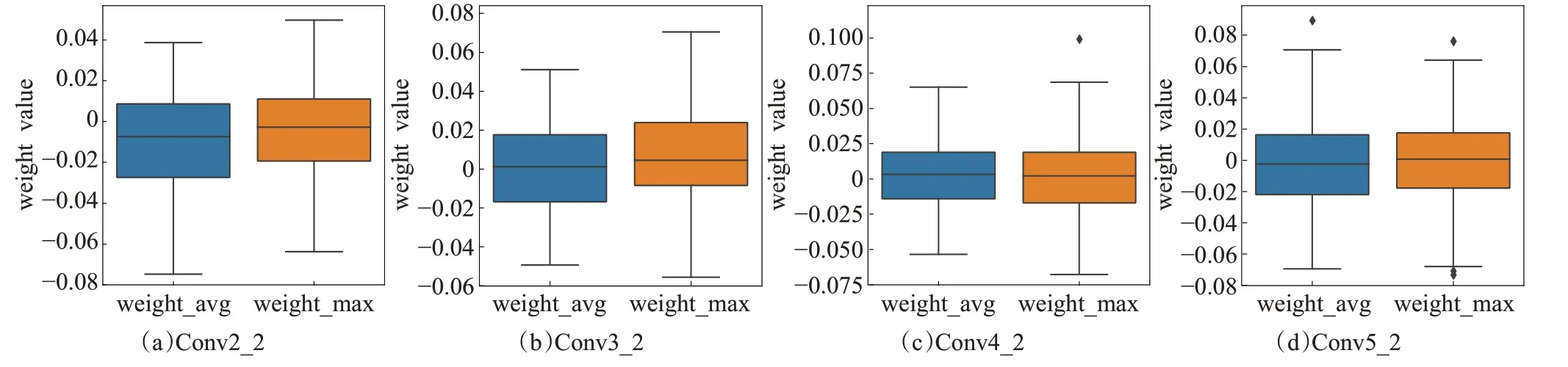

5.4.1 特征权重可视化

为了探索Avg 和Max 这两个临床特征表示在CFA模块中的相对重要作用,本文分析了不同深度残差CFA模块中这两个临床特征表示的相对权重分布(可以当作是临床特征相关系数的另一种表示),Backbone 是ResNet18。本文将神经网络模型基于深度可分为三个阶段:浅层、中间层以及深层。参考文献[34],本文将Conv_2_2 当作浅层,Conv_3_2 和Conv_4_2 当作中间层、Conv_5_2当作深层。图4为在AS-OCT影像数据集上不同阶段的Avg 和Max 两个特征表示的权重分布箱型图。可以看出,在不同深度的卷积层,与Avg 相比,CFA 模块倾向赋予Max 相对较大的权重值。这表明在核性白内障分类任务中Avg 和Max 这两种特征表示类型的作用不同,对应这两种临床特征与白内障严重程度具有不同的相关系数。其中,Max主要突出特征图的显著特征表示;而Avg倾向于强调特征图的全局均值特征表示。以上结果证明了本文提出的CFA 模块能动态地调整这两个特征表示类型的相对权重,以此来提高分类性能和增强模型的决策过程的可解释性。

图4 临床特征表示在三个不同阶段的权重可视化Fig.4 Clinical feature representation weight visualization in three stage levels

5.4.2 通道权重可视化

图5 为本文的CFA 与其他三种通道注意力机制方法的通道权重分布图,与其他注意力方法相比:SE、ECA、SRM 和CFA 的相对较大权重值主要集中在少数通道上。因为不同通道对应的特征图代表着不同特征表示,但在同一个卷积层的不是所有特征图的特征都起着相同的作用,只有一部分特征图的特征表示信息有用。因此,图5的通道权重分布结果说明CFA能较好地突出重要的通道和抑制不重要的通道,从而提高网络模型的分类性能。

图5 CFA与其他注意力机制方法的通道权重分布Fig.5 Channel weight distributions of CFA and other attention methods

5.4.3 基于类激活映射方法的可视化结果

本文采用类激活映射(class activation mapping,CAM)[41]方法对AS-OCT图像的核性白内障分类结果进行可视化,它能突出神经网络模型在推理过程中关注图像哪些区域,以此来增强预测结果的可解释性。图6为本文的SENet、ECANet、SRM、CFANet 的具有代表性的三种核性白内障严重级别的类激活图。其中,第一列是三种核性白内障严重级别的AS-OCT影像;第二列到第五列分别是SENet、ECANet、SRM 和本文的CFANet 的类激活图。第一行是正常的AS-OCT 影像及各种方法的类激活图;以此类推,第二行是轻度核性白内障的AS-OCT影像及各种方法的类激活图;第三行是重度核性白内障的AS-OCT 影像及各种方法的类激活图。可以看出,在正常的AS-OCT 影像上,三种对比注意力机制模型与CFANet 都关注整个核性区域,因为正常人的核性区域没有出现混浊症状,像素分布十分均匀;对于轻度和重度核性白内障的AS-OCT影像,本文的模型更关注核性区域的中间与下半部分与对比注意力方法模型相比,临床研究发现也指出这两个部分混浊程度比上半部分更明显[42],它们是临床诊断核性白内障严重程度的重要参考,也解释了本文模型的核性白内障性能优于其他对比模型的主要原因。

6 结束语

本文提出了一种基于临床特征校准注意力网络(CFANet)模型,实现AS-OCT 影像下核性白内障严重级别自动精准预测。在CFANet 中,本文设计了一个临床特征校准注意力模块通过引入白内障临床先验知识对不同特征表示进行动态加权融合并突出通道权重的差异性。消融实验验证了本文模型对基于AS-OCT 影像的核性白内障严重程度识别任务的有效性。模型的可视化结果分析表明,不同特征表示在本文模型具有不同重要的作用且本文模型采用softmax函数更能突出重要的通道;模型结果的可视化结果还显示,与其他先进的注意力机制模型先比,本文模型更关注白内障的病理区域,与临床研究发现保持一致性。

然而,如何从理论上来证明本文模型的可解释性有待进一步研究;能否引入更多的临床特征作为临床先验知识注入到神经网络模型设计中来提高模型的分类结果,以及如何基于通道权重对模型进行剪枝来构建轻量级网络并部署到眼科医疗设备中,是需要进一步探索和解决的问题。