结合先验知识与深度强化学习的机械臂抓取研究

缪刘洋,朱其新,丁正凯,王 旭

(1.苏州科技大学 电子与信息工程学院,江苏 苏州 215009; 2.苏州科技大学 机械工程学院/建筑智慧节能江苏省重点实验室/苏州市共融机器人技术重点实验室,江苏 苏州 215009; 3.苏州科技大学 电子与信息工程学院/建筑智慧节能江苏省重点实验室,江苏 苏州 215009)

0 引 言

在机器人领域中,机械臂的应用最为广泛[1],是自动化应用中不可或缺的一部分,特别是在搬运、分拣、装配、医疗等工作场景中扮演着重要的角色。机械臂不仅提高了作业安全和产品质量,而且降低了生产成本与工作强度[2]。然而,机械臂通常面向特定的生产线,按照设定程序完成重复且技术含量低的工作[3]。在复杂的非标准环境下,如何保证机械臂准确高效地完成特定工作依然存在巨大的挑战,虽然国内外学者已经提出了使用智能算法对机械臂进行路径规划[4-5],但是传统的控制方法在面对陌生环境时仍然存在一定缺陷,例如缺乏自适应能力等[6]。

20世纪五六十年代人工智能兴起,为机械臂的控制策略提供了新思路[7]。不同于传统的固定命令控制方法[8],强化学习与机械臂技术相结合,使机械臂借助强化学习的试错机制与环境交互获取信息[9],从而具有强大的学习能力,极大地提高了机械臂对陌生环境和新任务的适应能力。强化学习主要用来解决决策问题[10],通过最大化累计奖赏方式找到最优策略[11]。但在机械臂行为决策能力的研究中还存在机械臂数据特征提取困难、任务空间大等问题,DRL为此提供了良好的解决方案。DRL是深度学习(deep learning,DL)和强化学习(reinforcement learning,RL)的交叉领域,不仅具有DL的线性拟合和特征提取能力[12],还具有RL的决策能力,且在机械臂控制领域已有大量的研究与应用。文献[13]设计了一种具有卷积神经网络(convolutional neural networks,CNN)的深度Q网络(deep Q-network,DQN),以图片作为输入学习策略,机械臂在自身环境与位置未知的情况下,可将小球推入球网。文献[14]使用深度确定性策略梯度(deep deterministic policy gradient,DDPG)训练机械臂到达三维空间内的目标点,同时设计了多种奖赏函数对机械臂进行训练,验证了合理的奖赏函数可以加快算法的收敛。文献[15]使用DDPG训练机械臂实现推、抓、扔小球等任务,文中使用事后经验回放(hindsight experience replay,HER)算法与DDPG相结合的方式来处理学习过程中奖赏稀疏的问题。实验结果表明,使用HER可以提高简单实验的成功率,但在复杂任务中HER的能力有所下降。文献[16]提出一种位姿最佳算法以降低稀疏奖赏对机械臂训练的影响。文献[17]对DDPG做出2点改进以加快学习速度和提高性能:一是使用非对称输入,其中Actor网络使用通过CNN网络处理图像数据输入,而Critic网络使用仿真环境反馈的状态(例如物体的位置、机械臂的关节角度等)作为输入;二是通过增加一组状态预测网络与CNN网络并行一起输入进Actor网络。

上述内容通过DRL方法实现了机械臂的自主规划与学习,能够在未知环境下完成任务;但是部分研究通过减少机械臂的关节数量来降低训练难度。因此,在机械臂使用DRL的学习过程中仍存在数据采样效率低、经验样本质量低、高维连续的状态-动作空间等问题,进而导致DRL的奖赏函数收敛速度慢、学习效率低,直接影响机械臂的训练效果。目前机械臂与强化学习的结合主要集中于路径自主规划、目标物体抓取等方面。现有研究的抓取目标多为球体,机械臂末端仅需保证夹爪与物体的中心点重合即可,无须考虑抓取时的姿态。而在抓取的研究中,多数仅针对同一位姿物体分析机械臂的任务完成情况,未考虑训练完成后DRL算法在新任务中的泛化能力。

针对上述问题,本文以DDPG和Softmax深度双确定性策略梯度(简称SD3)[18]为原始模型,在原始模型中引入先验知识,并将模型与机械臂逆运动学相结合对机械臂自主抓取的行为决策进行训练,以奖赏函数的收敛速度和任务的成功率为指标对原始及引入先验知识的4种模型性能进行比较分析。同时,将训练所得的网络参数进行迁移,分析比较引入先验知识前后算法的泛化能力。为符合实际,本文使用长方体作为机械臂自主抓取对象,同时要求夹爪以特定的姿态执行抓取动作。

1 相关知识

1.1 强化学习(RL)

RL算法可依据有无模型进行分类。其中有模型算法需要对环境进行建模,但模型往往无法充分考虑到现实环境中的各种因素总是存在误差,导致在现实应用中达不到仿真训练的效果[20],且无法适应动态环境;而无模型RL算法无须对环境进行精确建模,从而避免上述问题。此外,RL算法还可以按照基于值函数和基于策略进行分类。基于值函数的RL计算量大、存在震荡不收敛的现象[21],在高维连续动作空间中的交互过程难以学习最优策略。而策略函数可以针对连续动作空间直接产生动作值,很好地解决连续动作空间问题。针对上述问题,本文选择无模型DRL方法进行机械臂自主抓取训练。

1.2 深度确定性策略梯度(DDPG)

文献[22]基于Actor-Critic(A-C)和DQN的理念架构提出DDPG算法解决连续空间问题。DDPG是一种基于策略的DRL算法,策略π可以描述为一个包含参数θ的函数:πθ(s,a)=P[a|s,θ]。对应策略目标函数为:J(θ)=Eπθ[G]。策略目标函数可以通过梯度上升或下降的方法实现Agent与环境互动过程中的累计奖赏最大化。文献[23]提出策略目标函数的随机策略梯度:

∇θJ(θ)=Eπθ[∇θlnπθ(s,a)Qπθ(s,a)]

(1)

式中:πθ(s,a)为策略函数;Qπθ(s,a)为状态价值函数。

DDPG包含了Actor和Critic网络,Actor由在线Actor网络μ(s|θμ)和目标Actor网络μ′(s|θμ′)组成,Critic由在线Critic网络Q(s,a|θQ)和目标Critic网络Q′(s,a|θQ′)组成。其中Actor负责与环境互动和生成动作,Critic负责评价Actor并指导后续动作。DDPG中具有经验回放机制,在Agent学习过程中通过批量采样经验样本来更新网络参数。其中在线Actor网络根据在线Critic网络输出的Q值进行更新。随机策略梯度存在计算量大等问题,文献[24]提出了确定性策略梯度,使用确定性策略梯度(deterministic policy gradient,DPG)进行网络更新,更新梯度为

∇θμμ(s|θμ)|s=si

(2)

其中Q(s,a|θQ)|s=si,a=μi为在线Critic网络在s=si,a=μi状态下输出的Q值,μ(s|θμ)|s=si为在线Actor网络在s=si状态下输出的动作。

在线Critic网络则利用最小化在线Critic网络的目标与输出的Q值误差进行更新。定义误差为损失函数:

式中:yi=ri+1+γQ′(si+1,μ′(si+1|θμ′)|θQ′);Q′(si+1,μ′(si+1|θμ′)|θQ′)为目标Critic网络输出的Q值。更新梯度为

∇θQQ(s,a|θQ)|s=si,a=μi

(4)

而目标Actor网络和目标Critic网络通过滑动平均方式进行更新,方式如下:

(5)

式中:θQ、θQ′、θμ、θμ′分别为在线Actor、目标Actor、在线Critic和目标Critic网络参数;τ(τ∈(0,1))为学习率。

1.3 Softmax深度双确定性策略梯度

SD3算法在双延迟DDPG (简称TD3)基础上使用了双重Actor网络和Critic网络,同时引入了Softmax函数来更新值函数,有效地改善高估和低估偏差对性能的影响[25]。学习过程中,从2组目标Critic网络选取较小的Q′值并通过Softmax函数更新在线Critic网络参数。其中连续动作空间的Softmax通过对Q′值采样进行无偏估计:

2 算法改进及实施

本节将深入研究算法改进和实施的关键步骤。首先着眼于算法改进来提高算法的性能,随后转向算法实施,详细说明如何将改进后的算法应用在机械臂自主行为决策中。

2.1 算法改进

在机械臂自主行为决策过程中,原始DRL模型难以处理高维连续的状态-动作空间引起的数据采样效率低及经验样本质量低等问题,本文对算法的改进具体如下。

2.1.1 先验知识

DRL与机械臂结合的本质是DRL指导机械臂自主探索和学习行为策略。诸多研究表明,机械臂使用DRL方法解决行为决策问题时,面临的最大问题为机械臂高维连续的动作空间导致数据采样效率低和经验样本质量低。该问题直接导致训练数据不足,使得DRL无法发挥在特征提取和拟合方面的强大能力[26],最终导致前期学习效率低和训练时间过长。如果通过增加经验池和采样大小来提高前期学习效率,则将导致算力成本增加以及单步学习时间增长。

针对上述问题,本文在DRL算法中引入先验知识,即通过专家指导的方式以达到加快奖赏函数收敛速度和减少训练时长的目的。本文主要在采样阶段引入先验知识,先验知识的本质为专家经验。在原始模型中,使用完全随机的方式进行采样,收集的经验样本随机性强。虽然该方式可以完全发挥Agent的探索能力,但是直接导致样本质量不够好,无法采集到十分有效的样本,导致数据采样效率低,Agent难以在有限的样本中学到好的效果,如此情况下,想要得到良好的训练效果,则需要庞大的样本数量,浪费大量的算力及时间成本。在引入先验知识后,本文在一定概率下使用专家经验指导代替完全随机进行采样。引入先验知识的DRL模型如图1所示。

图1 引入先验知识的DRL模型Fig.1 DRL model with the introduction of prior knowledge

图1中,(s,a)表示当前状态及当前动作,(s,a,r,s′)表示当前状态、当前动作、奖赏和下一状态。在采样阶段,Agent以一定概率选择通过先验知识或随机方式作为动作输出,经验池溢出后,由Actor网络输出动作。采样前期,以随机采样为主并以低概率伴随实施专家指导采样,随着采样数量增加逐步提高概率直至完成采样工作。在该方式下,前期大量的随机采样在保证Agent的探索能力同时避免其陷入局部最优;后期的专家指导采样确保经验样本质量的同时保证数据的采样效率。

本文假设被抓物体相对于参考坐标系的位姿信息T已知,并将T作为先验知识用于指导Agent采样。具体实施如下:在随机采样阶段,以概率P进行采样。剩余1-P则通过T对机械臂的末端运动方向以及RG2夹爪的横滚角、俯仰角、偏航角(roll、pitch、yaw,简称RPY)旋转方向进行指导,运动和旋转的幅度在动作空间A中随机选取。为避免先验知识限制Agent的探索能力和采样数据的多样性,同时保证先验知识对Agent的有效指导,设定Pi+1=0.99Pi,P0=0.9,其中i为回合数。

2.1.2 状态-动作空间优化

为降低状态空间和动作空间的空间复杂度,减少计算量,降低神经网络的拟合难度,本文将DRL与机械臂逆运动学相结合。在该方式下,Agent无须同时观察机械臂的关节信息并进独立控制;只需观察和控制夹爪的位姿,降低状态与动作空间的维度。Agent在输出动作时,仅需要根据当前状态输出夹爪的位姿,以机械臂逆向运动学(inverse kinematics,IK)的方式,将夹爪的位姿转换为关节角度。本文使用六自由度机械臂作为实验对象,其雅克比矩阵存在不可逆的情况,使用伪逆进行求解时在奇异点处难以求解。因此本文使用阻尼最小二乘法进行IK求解,在奇异点处仍能稳定求解。

2.2 算法实施

本节主要介绍引入先验知识的DRL模型与机械臂结合实现自主行为决策的具体实施方法。

2.2.1 MDP建模

使用DRL解决机械臂的自主抓取问题,首先需要将问题建模为MDP。状态空间、动作空间和奖赏函数的定义如下所示。

1) 状态空间S。本文设定Agent在机械臂每步动作上观测的状态向量st为[px,py,pz,α,β,γ]。其中,[px,py,pz]为夹爪的夹持点相对于参考坐标系的空间位置信息,[α,β,γ]为夹爪相对于参考坐标系的RPY角信息。

在市场经济中,市场自发性的市场失灵现象仍然会不定期的产生,而且本身金融财务风险本身就处于较高的位置,而互联网金融更是会加剧财务风险暴露的几率,通过互联网,金融扩张速度同样大幅增长,而且加上互联网具有极强的分散性,能够十分迅速的将财务风险进行传播以及扩散,最终给互联网金融带来极大的损失,同时对资源配置效率有着极大的影响。所以对于市场来说,融资交易成本也会有所降低,另外也将金融市场进行完善。但是同样也增加了财务风险诞生的几率,加强财务风险的防范,是互联网金融市场稳健发展的重要保障。

2) 动作空间A。Agent根据观察到的状态输出动作向量at=[dx,dy,dz,dα,dβ,dγ],其中,[dx,dy,dz]为RG2夹持点相对于基坐标系在[x,y,z]3个方向上位移的偏移值,[dα,dβ,dγ]为RG2的RPY角相对于基坐标系在[x,y,z]3个方向上转动的偏移角度,转动顺序为x—y—z。限定夹持点在3个方向上每次动作范围为[-200 mm,200 mm],夹爪的RPY角转动范围为[-20°,20°]。

3) 奖赏函数R。RL的基本思想就是通过最大化奖赏寻找最优策略,奖赏函数对训练速度和学习结果有着非常重要的作用。在机械臂的自主行为决策训练过程中,易出现奖赏稀疏问题,该问题会直接影响奖赏函数的收敛和机械臂的训练效果。合理的奖赏函数,在一定程度上可以解决奖赏稀疏的问题。因此本文在机械臂每进行一个动作后给予一个适当的立即奖赏,具体奖励函数包含6个部分。

a) 若机械臂或夹爪与被抓物体、地面、本身发生碰撞,则给予r1=-100的负奖励。

b) 若Agent给定的动作超出机械臂的运动范围,则给予r2=-100的负奖励。

c) 若机械臂正确完成抓取任务,则给予r3=200的正奖励。

d) 若夹爪夹持点与上一步相比,靠近被抓物体则给予正奖励,相反则给予负奖励。奖赏函数r4=ln(dt-dt+1-1),其中dt为第t步夹爪夹持点与被抓物体中心的距离,dt+1为第t+1步时的距离。

e) 为让Agent每个回合使用较少的步数完成目标,每个回合内Agent每执行一次动作给予-1的负奖励,限定每回合最大步数为50步,超过则立即终止该回合,并给予r5=-50的负奖励。

f) 抓取时,夹爪在目标物体一定范围内时,根据RPY角的偏差给予一定的负奖赏。奖赏函数r6=-e|RT-R|-e|PT-P|-e|YT-Y|+3,其中Rt、Pt、Yt分别为第t步夹爪的RPY角,R、P、Y为目标物体的RPY角。

综上,奖赏函数为R=r1+r2+r3+r4+r5+r6-1。

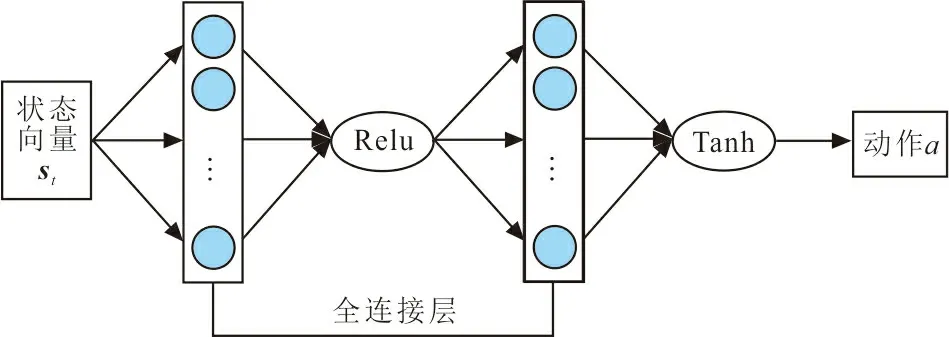

神经网络在DRL中用来拟合值函数和特征提取,实现端到端的学习。为保证2种算法对比的有效性,SD3采用与DDPG一致的网络结构与激活函数。Actor和Critic网络结构如图2所示。

(a) Actor网络结构

图2中,2种网络均由2层全连接层组成,Actor的激活函数采用了Relu和Tanh,而Critic的激活函数则为Relu。所有在线网络和目标网络结构完全一致。Actor网络第1层有128个神经元,第2层有64个神经元。Actor网络由状态向量st经过全连接输入第1层神经元,再经过Relu函数输入到第2层神经元,最后通过Tanh函数输出动作a。Critic网络第1层由2组数量为128的神经元组成,第2层由64个神经元组成。Critic网络由状态向量st和动作向量at经过全连接输入第1层的一组神经元,然后,将第1层的2组神经元进行拼接,再经过Relu函数输入到第2层神经元,最后输出Q值。

2.2.3 超参数

超参数在DRL的学习过程中也起着至关重要的作用,合理的参数设置可以加快学习速度同时避免Agent陷入局部最优。为确保对比实验的有效性,SD3与DDPG相同类型参数设置同样的参数值,通过对各参数不断地测试与调整,最终奖赏折扣因子γ、软更新学习率τ、Actor网络学习率、Critic网络学习率、经验池大小、采样大小分别设置为0.9、0.005、0.001、0.001、50 000、1 024;SD3算法的Q值采样数量k设置为50。

2.2.4 算法流程

DDPG和SD3算法流程主要分为采样和学习两个阶段。整体算法流程具体如图3所示。

图3 算法实施流程Fig. 3 Algorithm implementation process

图3中,在采样阶段:首先初始化Actor和Critic网络参数,获取初始状态;然后根据概率,从先验知识或随机方式选择一种输出动作,并获取下一状态;最后计算即时奖励并存储经验。学习阶段:Actor网络根据状态输出动作,同时获取下一状态;然后计算计时奖励并存储经验;最后从经验池随机选取样本更新Actor和Critic网络参数。

3 仿真实验与结果分析

本文使用CoppeliaSim软件进行仿真实验。CoppeliaSim是一款专业的机器人仿真软件,具有强大的动力学和运动学仿真能力,支持多种物理引擎仿真,同时还支持C、Matlab、Python等多种编程语言远程连接。本文在CoppeliaSim中搭建机械臂模型,物理引擎为Bullte。使用Python编写DRL机械臂控制程序,Actor和Critic神经网络基于Pytorch框架搭建,通过远程应用程序编程接口实现Python与CoppeliaSim通信连接,完成DRL训练CoppeliaSim中机械臂的自主抓取任务。

3.1 仿真实验

本文以一款型号为“UR5”的六自由度协作机械臂作为仿真实验对象,机械臂末端执行器为RG2夹爪,UR5的基坐标系作为参考坐标系,UR5+RG2的D-H参数如表1所示。

表1 UR5+RG2 D-H参数表Tab.1 D-H parameter table of UR5+RG2

表1中θi为关节转角,di为连杆偏距,ai-1为连杆长度,αi-1为连杆转角。

为符合实际工程应用情况,将抓取对象设置为150 mm×50 mm×30 mm的长方体。本文使用2种位姿的长方体进行实验,一种用于自主抓取训练,一种用于迁移网络参数后检验模型的泛化能力。其中,用于训练的长方体对于参考坐标系的中心坐标为[0 mm,800 mm,15 mm],参考坐标系的RPY角为[0°,0°,90°]。检验泛化能力的长方体中心坐标为[10 mm,750 mm,60 mm],RPY角为[45°,0°,90°]。

实验流程:首先,训练机械臂对平放在地面的长方体抓取;然后,使用本次训练的神经网络参数对不同位姿的同一长方体进行抓取,检验2种算法的泛化能力;最后,从2次实验的奖赏函数收敛情况和抓取成功率对2种算法进行比较。

3.2 结果分析

奖赏函数收敛情况是评价DRL算法有效性的重要指标之一。机械臂自主抓取本质上来说是一种行为决策问题,仅从奖赏函数的收敛状况进行分析评价不具有客观性。为符合实际应用场景,本文从奖赏函数、抓取成功率以及迁移训练所得网络参数对不同位姿的同一物体抓取情况进行对比分析。抓取成功判断指标:夹爪的夹持点与被抓物体的中心点重合(位置误差≤1 cm),夹爪与物体的RPY角一致,且横滚角α、俯仰角β、偏航角γ的误差均小于0.5°。

3.2.1 先验知识与原始模型比较分析

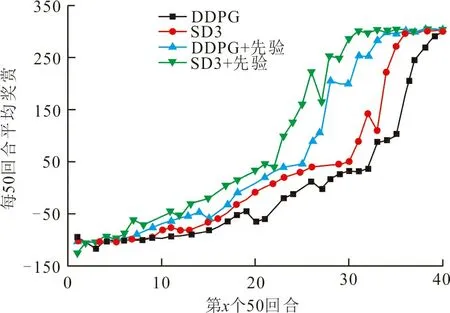

DDPG、SD3算法引入先验知识前后4种模型的训练结果如图4所示,图4(a)为4种模型奖赏图,图4(b)为4种模型抓取成功率。

(a) 训练奖赏

从图4可以看出,所有模型在起始学习阶段获得的奖赏和成功率都很低,但随着训练回合数的增加均逐步提高并收敛。根据本文奖赏函数设定,机械臂成功完成抓取任务Agent就会获得很大奖赏,相反任务失败或训练步数超过限制奖赏则会很低。比较各模型,引入先验知识的SD3模型和DDPG模型奖赏收敛速度较快,分别在1 550和1 700回合时趋于稳定,而SD3和DDPG原始模型分别在1 800和1 950回合左右逐步稳定,比原始模型的学习效率提升了13.89%、12.82%。在抓取成功率上,引入先验知识的SD3模型和DDPG模型在2 000回合的成功率达到27.91%、22.35%,相比原始模型成功率分别提高了16.92%、13.25%。其中引入先验知识的SD3模型最先成功完成抓取任务,且成功率增长最快。数据趋势显示,随着训练回合数的进一步增大,成功率同步上升并最终收敛。

从奖赏的收敛状况和抓取成功率可以看出DRL算法在引入先验知识后,可以明显提升算法性能。这是因为在使用DRL解决机械臂的行为决策问题时,Agent面临高维连续的动作空间,在采样阶段,如果使用完全随机的方式采样,Agent无法采集到足够多且有效的数据来支撑学习阶段较好地更新网络参数,使得训练时间漫长。而在引入先验知识后,Agent以一定概率通过专家经验指导采样,其余则使用随机方式采样。在这种模式下,Agent不仅可以通过专家经验获得足够多且有效的数据,而且随机的方式不会限制Agent的探索能力,以免陷入局部最优。所以,引入先验知识的DRL模型比原始模型的奖赏和成功率的收敛更快。

3.2.2 迁移模型性能比较分析

抓取不同位姿的物体是机械臂实现智能化控制必须解决的难题之一。为验证模型的泛化能力,对被抓物体更换位姿后,将训练好的网络参数进行迁移验证,DDPG、SD3算法引入先验知识前后4种模型迁移的仿真结果如图5所示。

(a) 迁移奖赏

在学习初期,Agent获得的奖赏虽然很低,但相比于图4没有迁移的模型,图5的4种模型的奖赏收敛速度均有明显提升。图5中,引入先验知识后的DRL模型在迁移后仍然保持了训练过程中的优势,在1 000和1 150回合左右已经趋于稳定,原始模型则在1 300和1 500回合左右开始稳定。收敛速度比未进行网络迁参数移的模型分别提升了35.48%、32.35%、27.78%和23.08%。引入先验知识的模型比原始模型学习率提升了23.08%、23.33%。同时,从开始到首次成功完成任务的过程大大缩短,且成功率增长相对较快。在2 000回合时,4种模型的成功率达到49.55%、43.85%、38.85%和32.28%,成功率比未进行网络参数迁移的模型分别提升了21.64%、21.5%、27.8%和23.18%。引入先验知识的模型比原始模型成功率提高了10.7%、11.57%。

本文通过迁移网络参数的方式来抓取不同位姿的物体以验证DRL的泛化能力。从图4、图5可以看出,将网络参数迁移后,大大缩减了Agent学习的时间,并且成功率也大幅提升。虽然Agent仍需要一定的学习过程,无法直接完成抓取任务,但是学习的过程大幅度缩减,而且任务完成的成功率上升更快。这是因为在网络参数迁移前奖赏已经收敛,新任务虽然改变了物体的位姿,但是环境并没有太大的变化,网络参数迁移之后,神经网络已具较强的特征提取和拟合能力。数据显示,与原始模型相比,引入先验知识的模型泛化能力更强。因为在前一个任务中,引入先验知识的模型收敛较快,在训练后期,神经网络已经趋于稳定;而原始模型虽然也已经收敛,但是神经网络的性能相较于引入先验知识的模型略差,可能陷入局部最优。所以在新任务中,原始模型的收敛速度较慢,成功率较低。同时,引入先验知识的模型能够获得更好的学习样本,在神经网络有一定拟合能力的情况下,使得该模型的学习效率更快,成功率更高,更易达到最优解。

通过引入先验知识,DRL算法表现出明显的性能提升,与原始模型相比,改进后的算法在学习效率和成功率方面都表现出显著提高。尤其是在学习效率方面,算法的改进加快了深度强化学习的训练速度。这不仅有效地降低强化学习算法训练所需的时间和硬件成本,还可以提高算法的应用效果。而在成功率方面,成功率的提升也为算法的鲁棒性和可靠性提供了有力支撑,改进后的算法在执行任务时具有更好的适应性和泛化能力,可以在复杂多变的环境下表现出出色的性能,能够更好地应对各种任务和环境的挑战。因此,引入先验知识是提高DRL算法性能的一种有效手段,其优势主要体现在增强了算法的学习方式和决策能力,这种优势不仅延伸了算法的应用范围,也为算法实现更高的目标提供了有力支撑。

4 结 语

针对机械臂与DRL结合过程中出现的奖赏函数收敛速度慢、学习时间长等问题,提出一种引入先验知识的DRL模型,以解决Agent采样过程中的数据采样效率低、经验样本质量低的问题,加快奖赏函数的收敛速度。将DRL与机械臂逆运动学结合,处理机械臂训练过程中高维连续的状态-动作空间,降低神经网络的拟合难度,加快Agent的学习速度。经过网络迁移的实验验证,先验知识可提高DRL在实际应用中的鲁棒性和可靠性,增强其泛化能力。

实验结果表明,与原始模型相比,在DRL算法中引入先验知识后,新模型在学习效率、任务成功率和泛化能力上有明显的提升,一定程度上有效地解决了上述问题。本次研究所提出的方案在DRL训练机械臂的自主行为决策上取得了良好效果,并在UR5机械臂上得到了较好的验证。